目录

- 1、前言

- 2、相关方案推荐

-

- [本博已有的 SDI 编解码方案](#本博已有的 SDI 编解码方案)

- 多路视频融合叠加应用

- 3、详细设计方案

-

- 设计原理框图

- [SDI 输入设备](#SDI 输入设备)

- [Gv8601a 均衡器](#Gv8601a 均衡器)

- [GTX 解串与串化](#GTX 解串与串化)

- [SMPTE SD/HD/3G SDI IP核](#SMPTE SD/HD/3G SDI IP核)

- BT1120转RGB

- VDMA图像缓存

- HLS多路视频融合叠加

- HDMI视频输出架构

- SDI视频输出架构之-->RGB转BT1120

- [SDI视频输出架构之-->SMPTE SD/HD/3G SDI + GTX](#SDI视频输出架构之-->SMPTE SD/HD/3G SDI + GTX)

- [SDI视频输出架构之-->Gv8500 驱动器](#SDI视频输出架构之-->Gv8500 驱动器)

- SDI视频输出架构之-->SDI转HDMI盒子

- 工程源码架构之-->逻辑设计

- 工程源码架构之-->SDK软件设计

- 4、工程源码1详解-->2路视频融合叠加,HDMI输出版本

- 5、工程源码2详解-->2路视频融合叠加,3G-SDI输出版本

- 6、工程移植说明

- 7、上板调试验证

- 8、福利:工程代码的获取

Zynq系列FPGA实现SDI视频编解码+多路视频融合叠加,基于GTX高速接口,提供2套工程源码和技术支持

1、前言

目前FPGA实现SDI视频编解码有两种方案:一是使用专用编解码芯片,比如典型的接收器GS2971,发送器GS2972,优点是简单,比如GS2971接收器直接将SDI解码为并行的YCrCb422,GS2972发送器直接将并行的YCrCb422编码为SDI视频,缺点是成本较高,可以百度一下GS2971和GS2972的价格;另一种方案是使用FPGA逻辑资源部实现SDI编解码,利用Xilinx系列FPGA的GTP/GTX资源实现解串,利用Xilinx系列FPGA的SMPTE SDI资源实现SDI编解码,优点是合理利用了FPGA资源,GTP/GTX资源不用白不用,缺点是操作难度大一些,对FPGA开发者的技术水平要求较高。有意思的是,这两种方案在本博这里都有对应的解决方案,包括硬件的FPGA开发板、工程源码等等。

工程概述

本设计基于Zynq系列的Zynq7100 FPGA开发板实现SDI视频编解码+图像缩放+多路视频拼接,输入源有两个,一个是3G-SDI相机,分辨率为1920x1080@60Hz,也可以使用HD-SDI或者SD-SDI相机,因为本设计是三种SDI视频自适应的;另一个HDMI转3G-SDI盒子,盒子外接笔记本电脑以模拟SDI相机;两路输入SDI视频通过同轴线连接到FPGA开发板的BNC座子,然后同轴视频经过板载的Gv8601a芯片实现单端转差分和均衡EQ的功能;然后差分SDI视频信号进入FPGA内部的GTX高速资源,实现数据高速串行到并行的转换,本博称之为解串;解串后的并行视频再送入Xilinx系列FPGA特有的SMPTE SD/HD/3G SDI IP核,进行SDI视频解码操作并输出BT1120视频,至此,SDI视频解码操作已经完成,可以进行常规的图像处理操作了;

本设计的目的是做图像缩放+多路视频融合叠加后输出解码的SDI视频,针对目前市面上的主流项目需求,本博设计了两种输出方式,一种是HDMI输出,另一种是3G-SDI输出,这两种方式都需要对解码BT1120视频进行转RGB和图像缓存操作操作;本设计使用BT1120转RGB模块实现视频格式转换;使用2路Xilinx官方的VDMA图像缓存架构实现图像缓存,缓存介质为板载的PS端DDR3;第1路SDI视频通过VDMA写入DDR后再读出送视频融合叠加模块,第2路SDI视频通过VDMA写入DDR后不读出,而是通过视频融合叠加模块从DDR3中读出,至此,2路视频均已进入视频融合叠加模块,再做融合叠加处理;然后进入HDMI发送模块输出HDMI显示器,这是HDMI输出方式;或者经过RGB转BT1120模块实现视频格式转换,然后视频进入SMPTE SD/HD/3G SDI IP核,进行SDI视频编码操作并输出SDI视频,再经过FPGA内部的GTX高速资源,实现并行数据到高速串行的转换,本博称之为串化,差分高速信号再进入板载的Gv8500芯片实现差分转单端和驱动增强的功能,SDI视频通过FPGA开发板的BNC座子输出,通过同轴线连接到SDI转HDMI盒子连接到HDMI显示器,这是SDI输出方式;本博客提供2套工程源码,具体如下:

现对上述2套工程源码做如下解释,方便读者理解:

工程源码1

开发板FPGA型号为Xilinx-->Xilinx-Zynq7100--xc7z100ffg900-2;输入源有两个,一个是3G-SDI相机,分辨率为1920x1080@60Hz,另一个HDMI转3G-SDI盒子,盒子外接笔记本电脑以模拟SDI相机,分辨率为1920x1080@60Hz;两路输入视频经过板载的2个Gv8601a芯片实现单端转差分和均衡EQ后送入FPGA;再经过2路GTX将SDI视频解串为并行数据;再经过2路SMPTE SDI IP核将SDI解码为2路BT1120数据;再经过2路BT1120转RGB模块将BT1120转换为RGB888视频;再经过2路Xilinx官方的Video In To AXI4-Stream IP核实现RGB888数据到AXI4-Stream数据流转换;再经过2路Xilinx官方的VDMA图像缓存方案将视频写入PS侧DDR3缓存;然后自研的基于HLS实现的多路视频融合叠加 IP核实现2路视频融合叠加操作;再进入Xilinx官方的AXI4-Stream To Video Out IP核实现AXI4-Stream视频流到Native视频流的转换;然后将融合叠加视频送入RGB转HDMI模块,将RGB888视频转换为HDMI视频,输出分辨率为1920x1080@60Hz,详细显示效果请看文章末尾的输出演示视频;最后通过HDMI显示器显示图像;该工程需要运行Zynq软核;适用于SDI视频拼接转HDMI场景;

工程源码2

开发板FPGA型号为Xilinx-->Xilinx-Zynq7100--xc7z100ffg900-2;输入源有两个,一个是3G-SDI相机,分辨率为1920x1080@60Hz,另一个HDMI转3G-SDI盒子,盒子外接笔记本电脑以模拟SDI相机,分辨率为1920x1080@60Hz;两路输入视频经过板载的2个Gv8601a芯片实现单端转差分和均衡EQ后送入FPGA;再经过2路GTX将SDI视频解串为并行数据;再经过2路SMPTE SDI IP核将SDI解码为2路BT1120数据;再经过2路BT1120转RGB模块将BT1120转换为RGB888视频;再经过2路Xilinx官方的Video In To AXI4-Stream IP核实现RGB888数据到AXI4-Stream数据流转换;再经过2路Xilinx官方的VDMA图像缓存方案将视频写入PS侧DDR3缓存;然后自研的基于HLS实现的多路视频融合叠加 IP核实现2路视频融合叠加操作;再进入Xilinx官方的AXI4-Stream To Video Out IP核实现AXI4-Stream视频流到Native视频流的转换;然后将融合叠加视频送RGB转BT1120模块,将RGB888视频转换为BT1120视频;再经过SMPTE SD/HD/3G SDI IP核,将BT1120视频编码为SDI视频;再经过FPGA内部的GTX高速资源,将SDI并行数据转换为高速串行信号;再经过板载的Gv8500芯片实现差分转单端和驱动增强后输出,输出分辨率为1920x1080@60Hz;最后使用SDI转HDMI盒子连接到HDMI显示器显示;该工程需要运行Zynq软核;适用于SDI转SDI场景;

免责声明

本工程及其源码即有自己写的一部分,也有网络公开渠道获取的一部分(包括CSDN、Xilinx官网、Altera官网等等),若大佬们觉得有所冒犯,请私信批评教育;基于此,本工程及其源码仅限于读者或粉丝个人学习和研究,禁止用于商业用途,若由于读者或粉丝自身原因用于商业用途所导致的法律问题,与本博客及博主无关,请谨慎使用。。。

2、相关方案推荐

本博已有的 SDI 编解码方案

我的博客主页开设有SDI视频专栏,里面全是FPGA编解码SDI的工程源码及博客介绍;既有基于GS2971/GS2972的SDI编解码,也有基于GTP/GTX资源的SDI编解码;既有HD-SDI、3G-SDI,也有6G-SDI、12G-SDI等;专栏地址链接如下:

点击直接前往

多路视频融合叠加应用

本博自研了多路视频融合叠加应用,之前专门写过一篇博客,博客地址链接如下:

点击直接前往

3、详细设计方案

设计原理框图

设计原理框图如下:

注意!!!!

注意!!!!

紫色箭头:3G-SDI输出路径

红色箭头:HDMI输出路径

SDI 输入设备

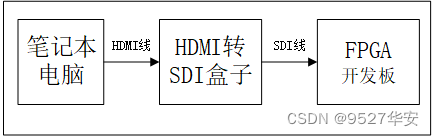

SDI 输入设备有两个,分别接入FPGA开发板的2路SDI视频输入接口;一个是3G-SDI相机,分辨率为1920x1080@60Hz,也可以使用HD-SDI或者SD-SDI相机,因为本设计是三种SDI视频自适应的;另一个HDMI转3G-SDI盒子,盒子外接笔记本电脑以模拟SDI相机;SDI相机相对比较贵,预算有限的朋友可以考虑用HDMI转SDI盒子模拟SDI相机,这种盒子某宝一百块左右;当使用HDMI转SDI盒子时,输入源可以用笔记本电脑,即用笔记本电脑通过HDMI线连接到HDMI转SDI盒子的HDMI输入接口,再用SDI线连接HDMI转SDI盒子的SDI输出接口到FPGA开发板,如下:

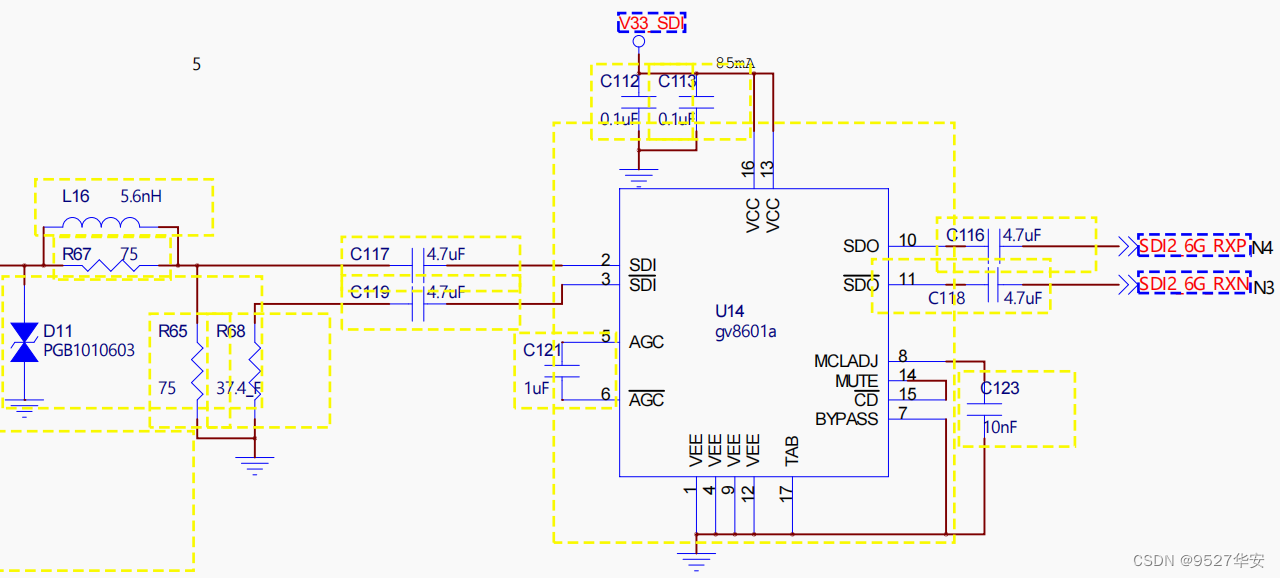

Gv8601a 均衡器

Gv8601a芯片实现单端转差分和均衡EQ的功能,这里选用Gv8601a是因为借鉴了了Xilinx官方的方案,当然也可以用其他型号器件。Gv8601a均衡器原理图如下:

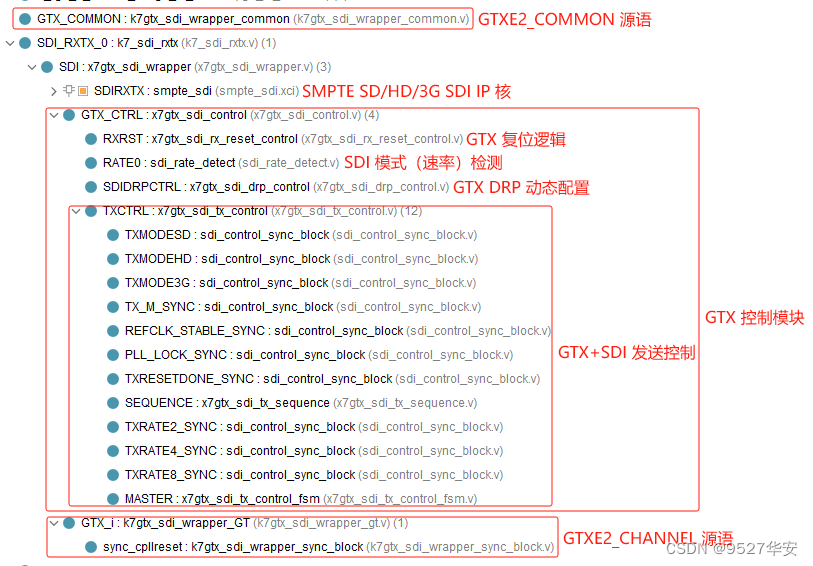

GTX 解串与串化

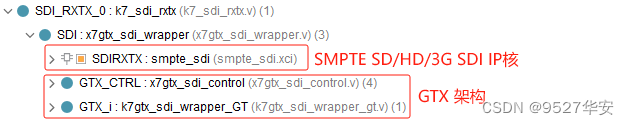

本设计使用Xilinx特有的GTX高速信号处理资源实现SDI差分视频信号的解串与串化,对于SDI视频接收而言,GTX起到解串的作用,即将输入的高速串行的差分信号解为并行的数字信号;对于SDI视频发送而言,GTX起到串化的作用,即将输入的并行的数字信号串化为高速串行的差分信号;GTX的使用一般需要例化GTX IP核,通过vivado的UI界面进行配置,但本设计需要对SD-SDI、HD-SDI、3G-SDI视频进行自动识别和自适应处理,所以需要使得GTX具有动态改变线速率的功能,该功能可通过DRP接口配置,也可通过GTX的rate接口配置,所以不能使用vivado的UI界面进行配置,而是直接例化GTX的GTXE2_CHANNEL和GTXE2_COMMON源语直接使用GTX资源;此外,为了动态配置GTX线速率,还需要GTX控制模块,该模块参考了Xilinx的官方设计方案,具有动态监测SDI模式,动态配置DRP等功能;该方案参考了Xilinx官方的设计;GTX 解串与串化模块代码架构如下:

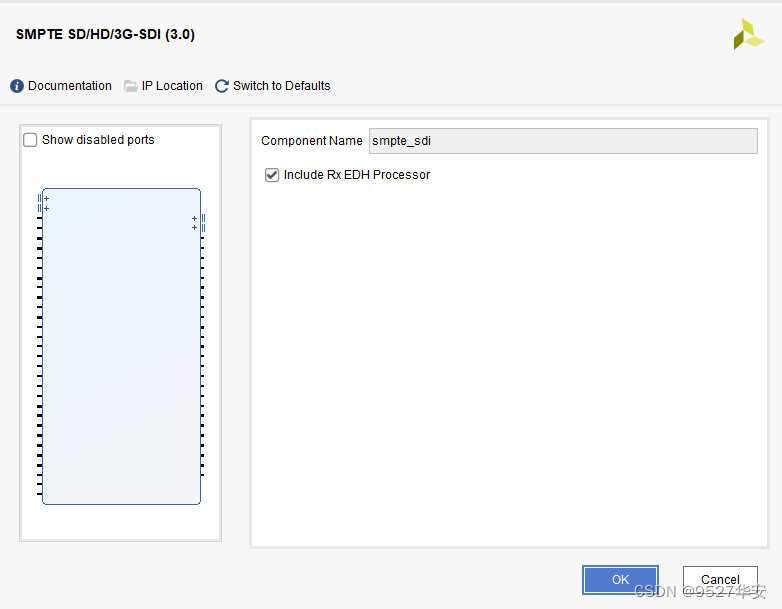

SMPTE SD/HD/3G SDI IP核

SMPTE SD/HD/3G SDI IP核是Xilinx系列FPGA特有的用于SDI视频编解码的IP,该IP配置使用非常简单,vivado的UI界面如下:

SMPTE SD/HD/3G SDI IP核必须与GTX配合才能使用,对于SDI视频接收而言,该IP接收来自于GTX的数据,然后将SDI视频解码为BT1120视频输出,对于SDI视频发送而言,该IP接收来自于用户侧的的BT1120视频数据,然后将BT1120视频编码为SDI视频输出;该方案参考了Xilinx官方的设计;SMPTE SD/HD/3G SDI IP核代码架构如下:

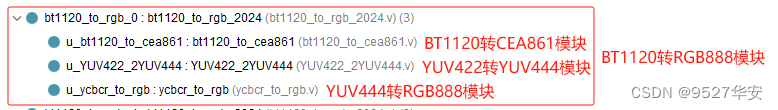

BT1120转RGB

BT1120转RGB模块的作用是将SMPTE SD/HD/3G SDI IP核解码输出的BT1120视频转换为RGB888视频,它由BT1120转CEA861模块、YUV422转YUV444模块、YUV444转RGB888三个模块组成,该方案参考了Xilinx官方的设计;BT1120转RGB模块代码架构如下:

VDMA图像缓存

本设计的视频缓存方案采用2路Xilinx官方的的VDMA图像缓存架构;缓存介质为PS端DDR3;第1路SDI视频通过VDMA写入DDR后再读出送视频融合叠加模块,第2路SDI视频通过VDMA写入DDR后不读出,而是通过视频融合叠加模块从DDR3中读出,以工程源码1为例,VDMA使用Xilinx vivado的Block Design设计,如下图:

为了降低延时,VDMA设置为缓存1帧,如下:

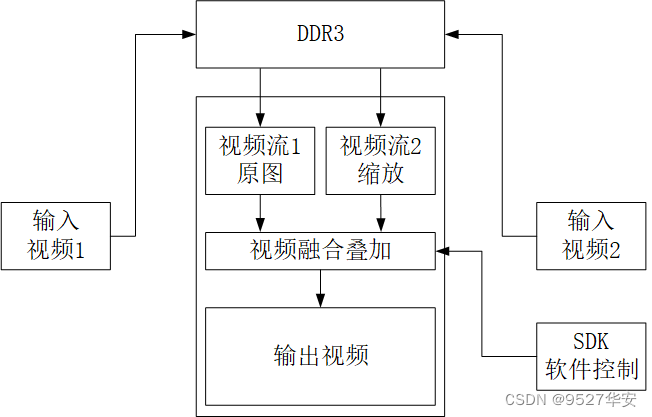

HLS多路视频融合叠加

多路视频融合叠加设计框图如下如所示:

多路视频融合叠加由底层视频和叠加层视频融合叠加而成,底层视频为输入的第1路视频,叠加层视频为第2路视频经过缩放后得到,两路视频融合在一起输出,可通过SDK软件动态配置2路视频融合的透明度、叠加层视频的缩放大小、叠加层视频的显示位置等信息;;设计加采用HLS方案C++代码实现,并综合成RTL后封装为IP,可在vivado中调用该IP,关于这个方案详情,请参考我之前的博客,博客链接如下:

点击直接前往

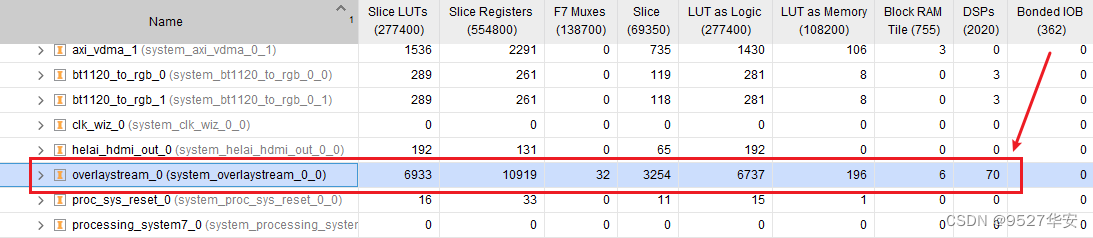

该IP在vivado中的综合资源占用情况如下:

HLS多路视频融合叠加需要在SDK中运行驱动和用户程序才能正常工作,我在工程中给出了C语言程序,具体参考工程源码;HLS多路视频融合叠加调用截图如下:

HDMI视频输出架构

HDMI视频输出架构如下:

参考Xilinx官方设计,使用VTC+AXI4-Stream To Video Out架构实现输出视频从AXI4-Stream到Native格式的转换;然后使用纯verilog代码实现的RGB888转HDMI模块实现RGB888到HDMI的转换,最后通过显示器显示,RGB888转HDMI模块代码架构如下:

关于RGB888转HDMI模块,请参考我之前的博客,博客地址:点击直接前往

SDI视频输出架构之-->RGB转BT1120

SDI视频输出架构首先要实现VDMA读出的AXI4-Stream到Native格式的转换,得到RGB888视频后再通过RGB转BT1120实现到BT1120视频的转换,其架构如下:

在SDI输出方式下VGA时序模块的像素时钟由SMPTE SD/HD/3G SDI IP核的发送用户时钟提供,在不同的SDI模式下像素时钟不同,比如在3G-SDI模式下像素时钟为148.5M,在HD-SDI的720P@60Hz模式下像素时钟为74.25M;

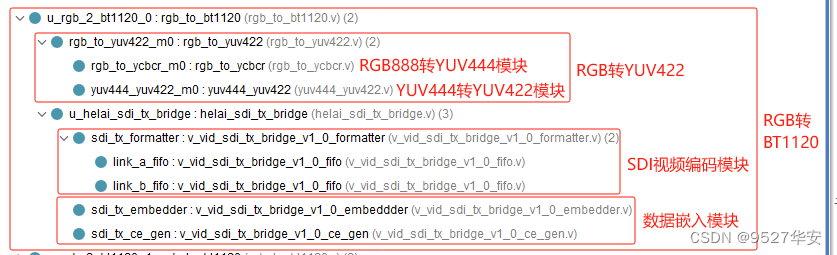

在SDI输出方式下需要使用RGB转BT1120模块;RGB转BT1200模块的作用是将用户侧的RGB视频转换为BT1200视频输出给SMPTE SD/HD/3G SDI IP核;RGB转BT1120模块由RGB888转YUV444模块、YUV444转YUV422模块、SDI视频编码模块、数据嵌入模块组成,该方案参考了Xilinx官方的设计;BT1120转RGB模块代码架构如下:

SDI视频输出架构之-->SMPTE SD/HD/3G SDI + GTX

这两部分与接收过程公用相应模块,功能上是接收过程的逆过程,不再赘述;

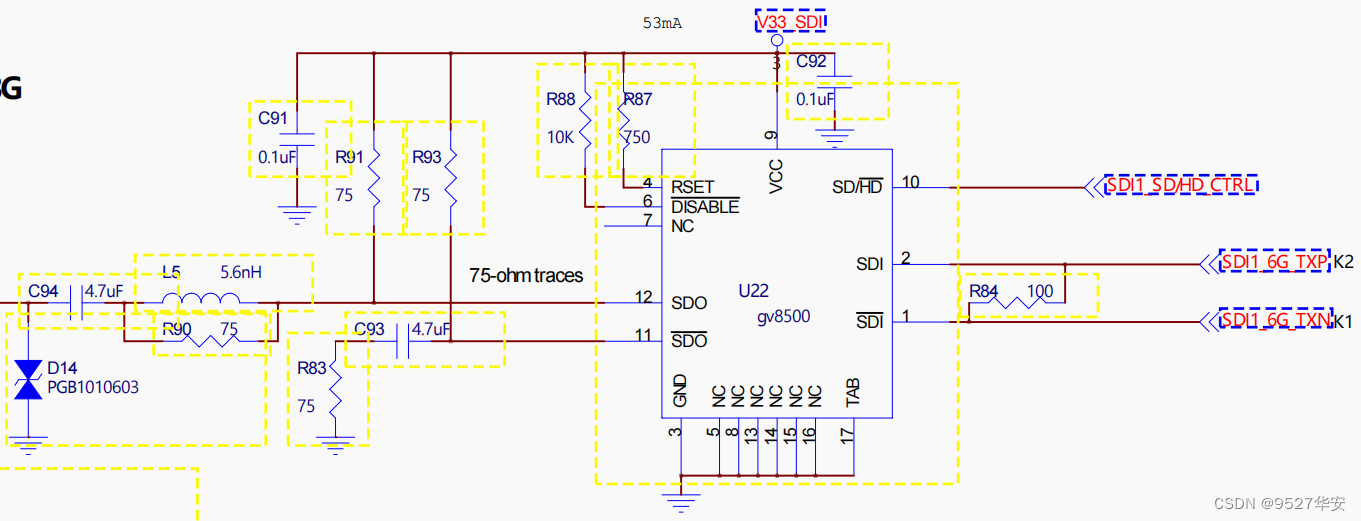

SDI视频输出架构之-->Gv8500 驱动器

Gv8500芯片实现差分转单端和增强驱动的功能,这里选用Gv8500是因为借鉴了了Xilinx官方的方案,当然也可以用其他型号器件。Gv8500驱动器原理图如下:

SDI视频输出架构之-->SDI转HDMI盒子

在SDI输出方式下需要使用到SDI转HDMI盒子,因为我手里的显示器没有SDI接口,只有HDMI接口,为了显示SDI视频,只能这么做,当然,如果你的显示器有SDI接口,则可直接连接显示,我的SDI转HDMI盒子在某宝购买,不到100块;

工程源码架构之-->逻辑设计

本博客提供2套工程源码,以工程源码1为例,vivado Block Design设计如下,其他工程与之类似,Block Design设计为图像缓存架构的部分:

以工程源码1为例,使工程源码架构如下,其他工程与之类似:

工程源码架构之-->SDK软件设计

工程源码PL端时钟由Zynq软核提供,所以需要运行运行SDK以启动Zynq,此外,视频融合叠加、VDMA等IP核都需要运行软件驱动才能正常工作,SDK软件代码架构如下:

SDK代码中配置如下,用户可根据自己的需求任意修改;

第1路视频为底层视频,分辨率为1920x1080;

第2路视频为叠加层视频,分辨率为1920x1080,从叠加层视频坐标(400,200)处为原点取一块1000x800的区域作为叠加融合视频;

将上一步取到的600x600的叠加融合视频进行图像缩放,缩放为960x540;

将上一步960x540的叠加融合视频从底层视频的(0,0)坐标开始叠加,底层与叠加层的透明度设置为80;

4、工程源码1详解-->2路视频融合叠加,HDMI输出版本

开发板FPGA型号:Xilinx-Zynq7100--xc7z100ffg900-2;

开发环境:Vivado2019.1;

输入:3G-SDI相机或HDMI转SDI盒子,分辨率1920x1080@60Hz;

输出:HDMI ,分辨率1920x1080@60Hz;

缓存方案:Xilinx官方VDMA方案;

缓存介质:PS端DDR3;

视频融合叠加方案:自研基于HLS实现的多路视频融合叠加;

工程作用:此工程目的是让读者掌握Zynq系列FPGA实现SDI转HDMI的设计能力,以便能够移植和设计自己的项目;

工程Block Design和工程代码架构请参考第3章节的《工程源码架构》小节内容;

工程的资源消耗和功耗如下:

5、工程源码2详解-->2路视频融合叠加,3G-SDI输出版本

开发板FPGA型号:Xilinx-Zynq7100--xc7z100ffg900-2;

开发环境:Vivado2019.1;

输入:3G-SDI相机或HDMI转SDI盒子,分辨率1920x1080@60Hz;

输出:3G-SDI,分辨率1920x1080@60Hz;

缓存方案:Xilinx官方VDMA方案;

缓存介质:PS端DDR3;

视频融合叠加方案:自研基于HLS实现的多路视频融合叠加;

工程作用:此工程目的是让读者掌握Zynq系列FPGA实现SDI转HDMI的设计能力,以便能够移植和设计自己的项目;

工程Block Design和工程代码架构请参考第3章节的《工程源码架构》小节内容;

工程的资源消耗和功耗如下:

6、工程移植说明

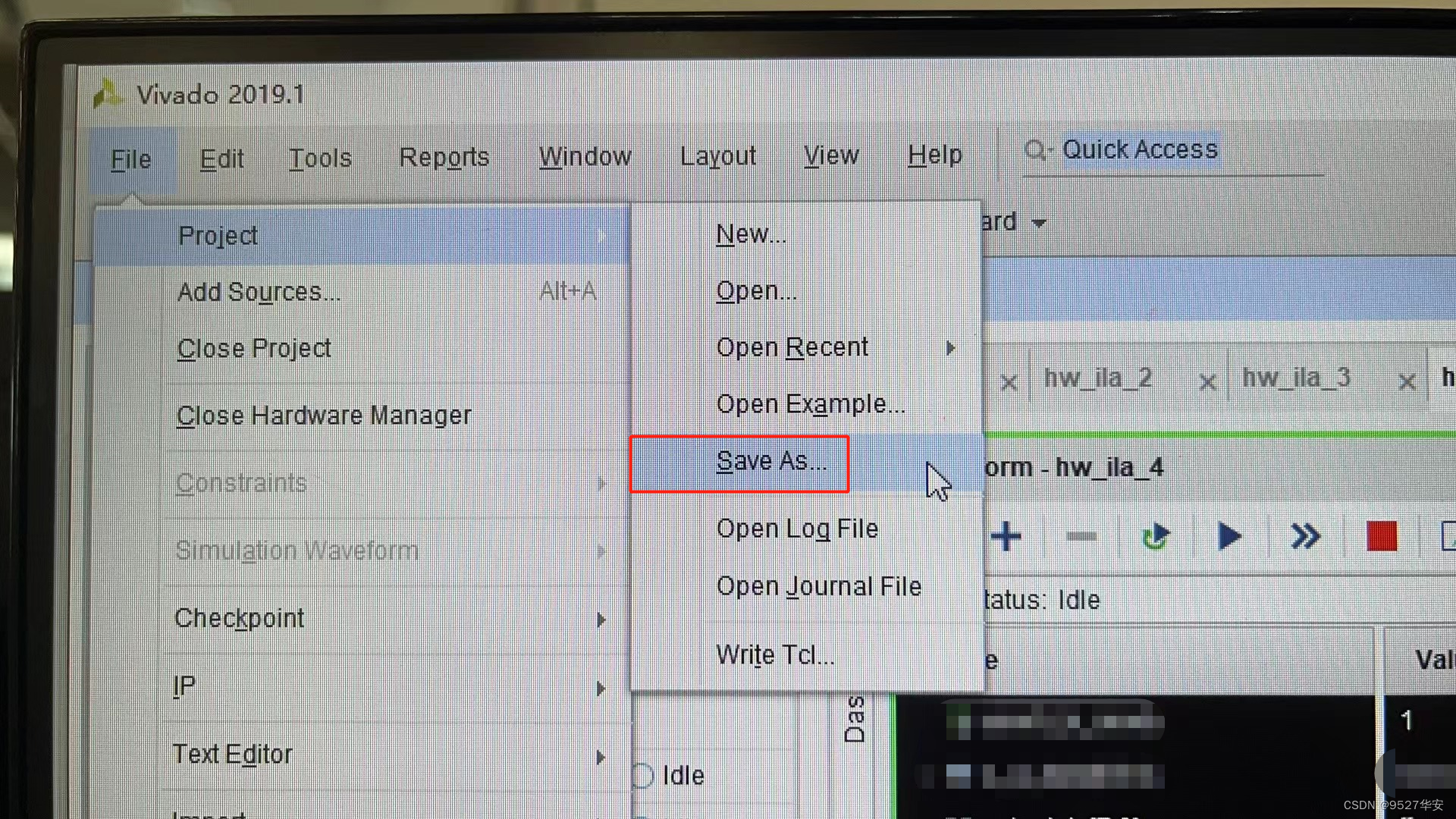

vivado版本不一致处理

1:如果你的vivado版本与本工程vivado版本一致,则直接打开工程;

2:如果你的vivado版本低于本工程vivado版本,则需要打开工程后,点击文件-->另存为;但此方法并不保险,最保险的方法是将你的vivado版本升级到本工程vivado的版本或者更高版本;

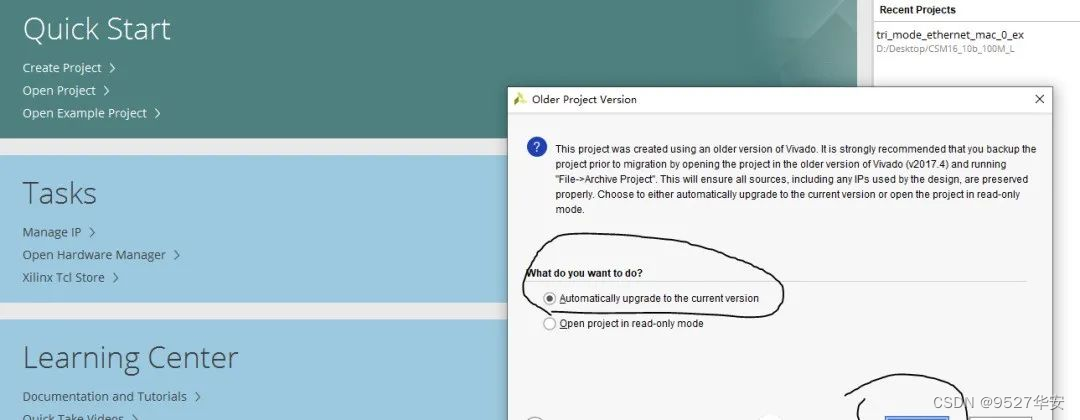

3:如果你的vivado版本高于本工程vivado版本,解决如下:

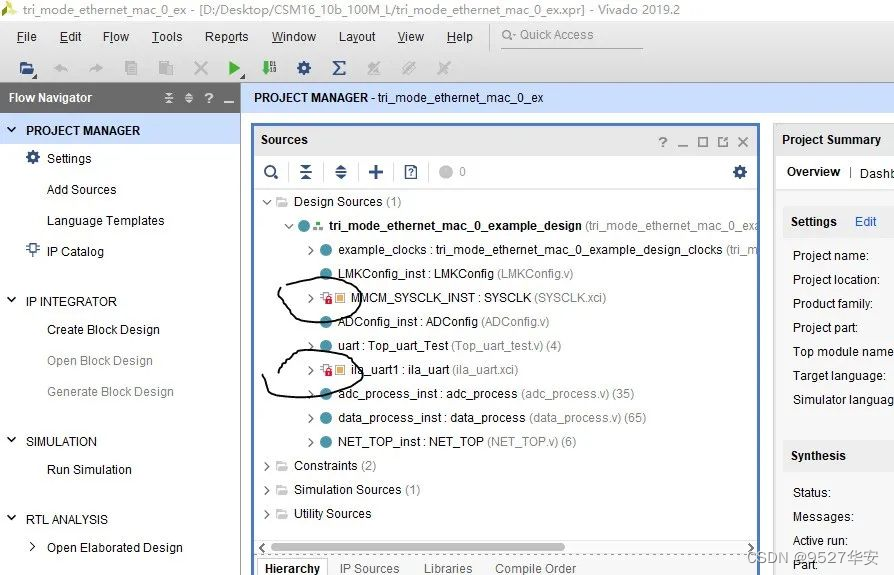

打开工程后会发现IP都被锁住了,如下:

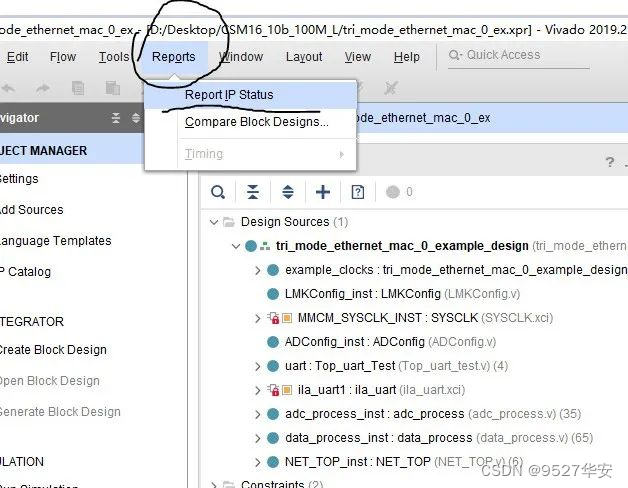

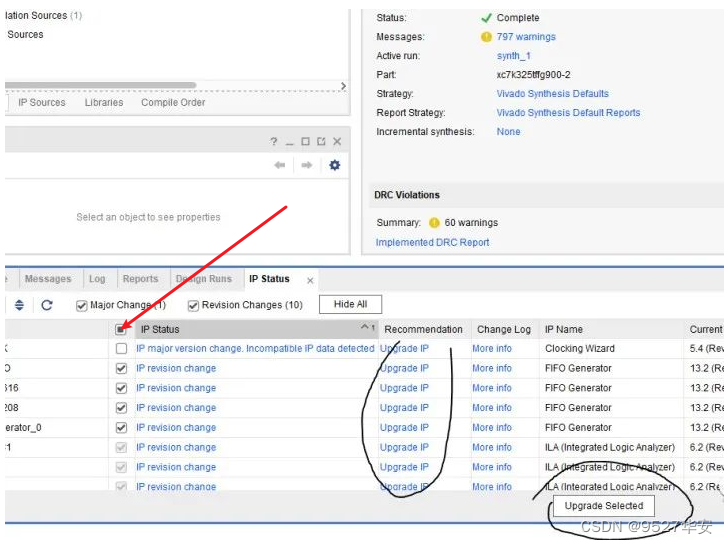

此时需要升级IP,操作如下:

FPGA型号不一致处理

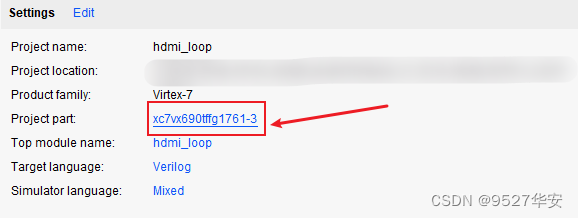

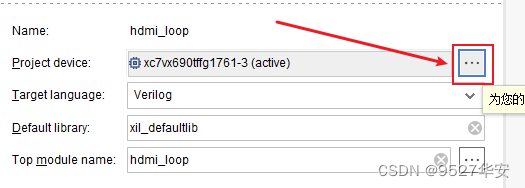

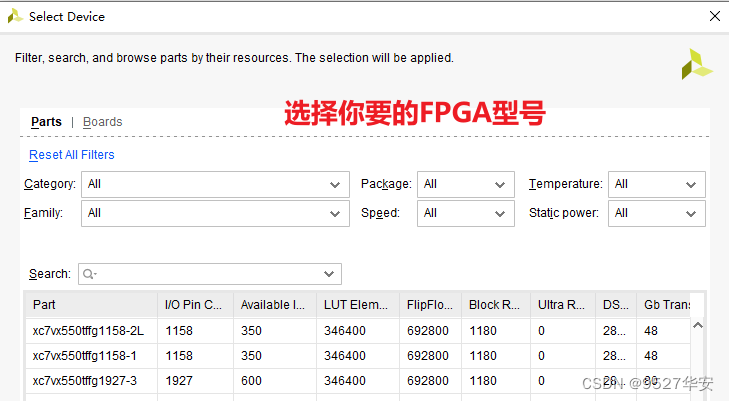

如果你的FPGA型号与我的不一致,则需要更改FPGA型号,操作如下:

更改FPGA型号后还需要升级IP,升级IP的方法前面已经讲述了;

其他注意事项

1:由于每个板子的DDR不一定完全一样,所以MIG IP需要根据你自己的原理图进行配置,甚至可以直接删掉我这里原工程的MIG并重新添加IP,重新配置;

2:根据你自己的原理图修改引脚约束,在xdc文件中修改即可;

3:纯FPGA移植到Zynq需要在工程中添加zynq软核;

7、上板调试验证

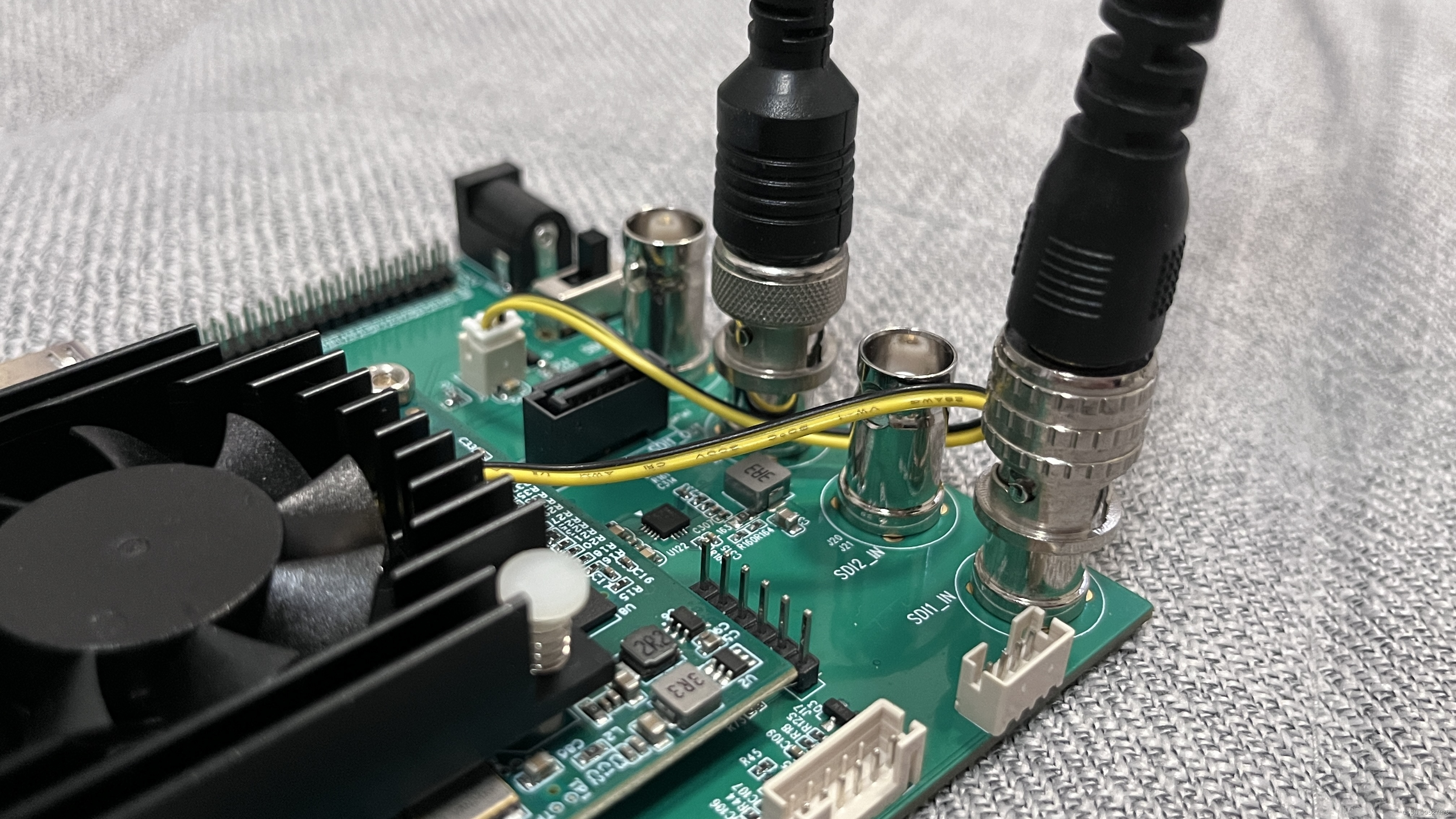

准备工作

需要准备的器材如下:

FPGA开发板;

SDI摄像头或HDMI转SDI盒子;

SDI转HDMI盒子;

HDMI显示器;

我的开发板了连接如下:

输出视频演示

以工程源码1为例,输出如下:

Zynq-SDI-视频融合叠加

8、福利:工程代码的获取

福利:工程代码的获取

代码太大,无法邮箱发送,以某度网盘链接方式发送,

资料获取方式:私,或者文章末尾的V名片。

网盘资料如下:

此外,有很多朋友给本博主提了很多意见和建议,希望能丰富服务内容和选项,因为不同朋友的需求不一样,所以本博主还提供以下服务: