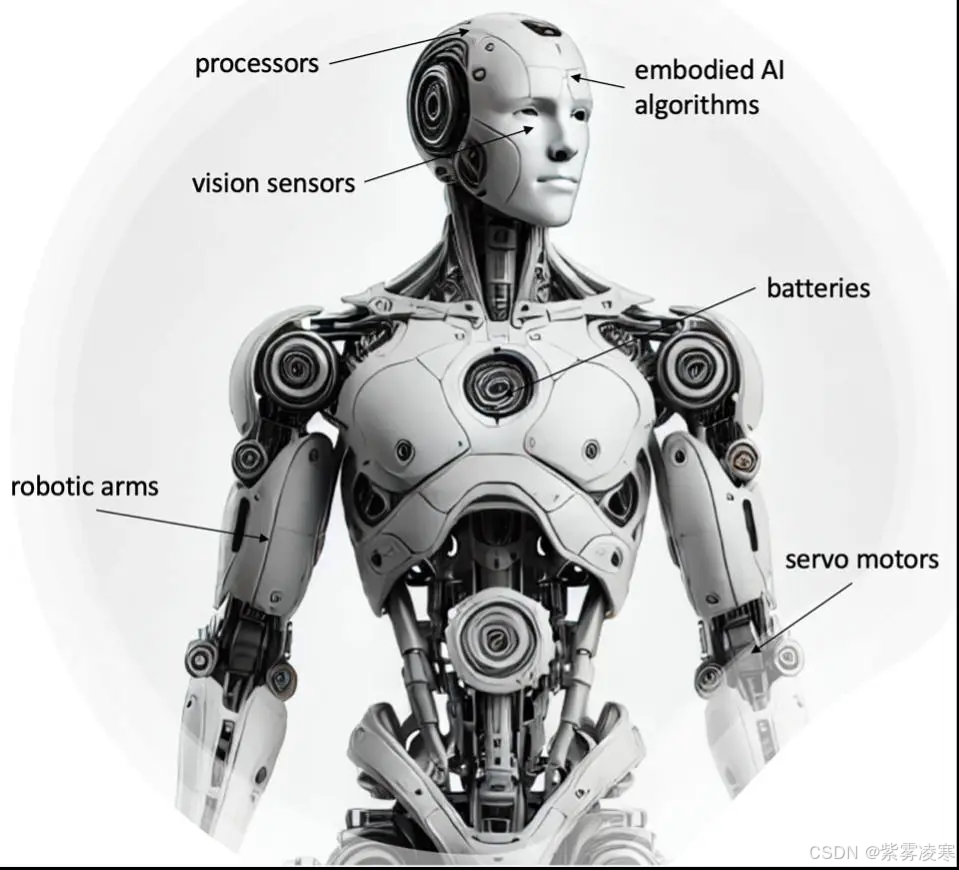

一、具身智能与视觉-动作联合建模简介

具身智能(Embodied Intelligence) 是人工智能领域的关键研究方向,强调智能体通过物理实体与环境交互实现认知和智能行为。与传统人工智能基于静态数据和符号推理不同,具身智能依赖动态感知与动作的协同作用。智能体通过传感器(如摄像头、激光雷达、触觉传感器)采集环境信息,经过内部决策生成动作,并在执行中实时调整,形成 "感知-思考-行动" 的闭环。例如,人形机器人在室内导航时,利用摄像头捕捉墙壁和家具布局,结合激光雷达测量距离,决策移动方向并避开障碍物。这一过程模拟了人类通过视觉、听觉和肢体协作完成任务的能力。

具身智能的应用场景广泛且具有深远影响。在 工业制造 中,智能机器人完成高精度装配,如汽车引擎安装;在 家庭服务 中,机器人执行清洁、物品搬运或协助老人护理;在 医疗领域 ,手术机器人通过精准操作提升成功率;在 智能交通 中,自动驾驶汽车和无人机实现自主导航。这些应用依赖智能体对环境的实时理解和灵活反应,而 视觉-动作联合建模 是实现这一能力的核心技术。

视觉-动作联合建模将 视觉感知 与 动作执行 紧密结合,使智能体根据视觉输入生成合理动作。例如,在抓取任务中,机器人通过摄像头识别目标物体的位置、形状和姿态,联合建模算法计算机械臂的运动轨迹,确保抓取成功。这种技术不仅连接了感知与执行,还提升了智能体在复杂、多变环境中的适应性。随着深度学习、传感器技术和计算能力的进步,视觉-动作联合建模已成为具身智能研究与应用的关键驱动力。

具身智能的概念起源于认知科学和机器人学。20世纪90年代,Rodney Brooks 提出"无表征智能"理论,认为智能无需复杂内部模型,而是通过与环境的直接交互产生。这一思想奠定了具身智能的基础。如今,视觉-动作联合建模通过先进的神经网络和多模态数据处理,推动智能体从静态任务处理走向动态环境适应。例如,在工业流水线中,机器人不仅需识别零件,还需根据生产线速度调整动作节奏,这一能力正是联合建模的体现。

二、技术原理深入剖析

(一)视觉感知技术

视觉感知 是视觉-动作联合建模的基础,为智能体提供环境信息。其核心是从图像数据中提取特征,支持后续决策。以下是主要技术及其细节:

-

CNN 是视觉感知的经典工具,通过多层结构提取图像特征。卷积层 使用卷积核滑动提取局部特征,如边缘、角点和纹理;池化层 通过降采样(如最大池化)减少计算量,保留关键信息。以 AlexNet 为例,其包含 5 个卷积层和 3 个池化层,首次在大规模图像分类任务(ImageNet)中取得突破。卷积核大小通常为 3 × 3 3 \times 3 3×3 或 5 × 5 5 \times 5 5×5,步幅和填充参数调节特征图尺寸。例如,输入图像为 224 × 224 × 3 224 \times 224 \times 3 224×224×3,第一层卷积(核大小 11 × 11 11 \times 11 11×11,步幅 4,填充 0)输出为 55 × 55 × 96 55 \times 55 \times 96 55×55×96,计算公式为:

H out = H in − K + 2 P S + 1 H_{\text{out}} = \frac{H_{\text{in}} - K + 2P}{S} + 1 Hout=SHin−K+2P+1其中 H in = 224 H_{\text{in}} = 224 Hin=224, K = 11 K = 11 K=11, P = 0 P = 0 P=0, S = 4 S = 4 S=4,得 H out = 55 H_{\text{out}} = 55 Hout=55。这种层级设计使 CNN 从低级特征(如边缘)逐步过渡到高级语义特征(如物体类别),适用于物体识别、场景理解等任务。此外,残差网络(ResNet)通过跳跃连接解决深层网络退化问题,进一步提升特征提取能力。

-

Transformer 引入自注意力机制,近年在视觉领域表现突出。Vision Transformer(ViT)将图像划分为固定大小的块(如 16 × 16 16 \times 16 16×16),将其视为序列输入,通过自注意力计算块间关系。自注意力公式为:

Attention ( Q , K , V ) = softmax ( Q K T d k ) V \text{Attention}(Q, K, V) = \text{softmax}\left(\frac{Q K^T}{\sqrt{d_k}}\right) V Attention(Q,K,V)=softmax(dk QKT)V其中 Q Q Q、 K K K、 V V V 为查询、键、值矩阵, d k d_k dk 为维度归一化因子。例如,输入 224 × 224 224 \times 224 224×224 图像,分成 196 个 16 × 16 16 \times 16 16×16 块,每块嵌入为 768 维向量,加上位置编码后输入 Transformer。相比 CNN 的局部感受野,Transformer 捕捉全局依赖,提升了对复杂场景的理解能力。在 ImageNet 上,ViT 在大规模预训练后(数据量超 1 0 7 10^7 107 张)性能超越传统 CNN,成为新趋势。

-

鲁棒性与实时性优化

视觉感知需应对动态环境中的光照变化、遮挡等问题。可通过预训练模型(如 ResNet-50)和数据增强(如随机裁剪、颜色抖动)提升鲁棒性。实时性方面,边缘计算设备(如 NVIDIA Jetson)通过硬件加速降低延迟,例如处理 30 fps 30 \, \text{fps} 30fps 视频时延迟小于 50 ms 50 \, \text{ms} 50ms。

(二)动作生成机制

动作生成 是具身智能的任务执行环节,根据视觉信息和目标生成动作序列。主要方法包括:

-

强化学习

强化学习通过智能体与环境交互优化动作策略。其核心是马尔可夫决策过程(MDP),定义为 ( S , A , P , R , γ ) (S, A, P, R, \gamma) (S,A,P,R,γ),其中 S S S 为状态空间, A A A 为动作空间, P P P 为状态转移概率, R R R 为奖励函数, γ \gamma γ 为折扣因子。智能体目标是最大化累积奖励: G t = ∑ k = 0 ∞ γ k R t + k + 1 G_t = \sum_{k=0}^\infty \gamma^k R_{t+k+1} Gt=k=0∑∞γkRt+k+1例如 ,机器人导航中,状态为视觉输入和位置,动作包括前进、转向,奖励基于目标距离和避障效果。深度 Q 网络(DQN) 使用神经网络逼近 Q 值函数 Q ( s , a ) Q(s, a) Q(s,a),通过经验回放(容量 1 0 5 10^5 105)和目标网络(更新频率 1 0 4 10^4 104 步)稳定训练。在连续动作空间中,DDPG(Deep Deterministic Policy Gradient) 通过演员-批评家框架优化动作,例如机械臂关节角度调整,动作维度可达 6 + 6+ 6+。强化学习无需专家数据,但收敛慢,需 1 0 6 10^6 106 次交互。

-

模仿学习

模仿学习通过专家示范加速学习。行为克隆(Behavior Cloning) 从状态-动作对 ( s , a ) (s, a) (s,a) 学习映射 π ( s ) → a \pi(s) \rightarrow a π(s)→a。假设专家数据为 { s i , a i } i = 1 N \{s_i, a_i\}{i=1}^N {si,ai}i=1N,模型最小化损失:

L = 1 N ∑ i = 1 N ∣ ∣ π ( s i ) − a i ∣ ∣ 2 L = \frac{1}{N} \sum{i=1}^N ||\pi(s_i) - a_i||^2 L=N1i=1∑N∣∣π(si)−ai∣∣2例如,记录人类抓取动作(关节角度序列)训练机器人。生成对抗模仿学习(GAIL) 引入判别器 D D D 区分专家和生成动作,生成器优化策略 π \pi π 使 D D D 难以区分,损失为:

L GAIL = E π [ log D ( s , a ) ] + E π E [ log ( 1 − D ( s , a ) ) ] L_{\text{GAIL}} = \mathbb{E}\pi[\log D(s, a)] + \mathbb{E}{\pi_E}[\log(1 - D(s, a))] LGAIL=Eπ[logD(s,a)]+EπE[log(1−D(s,a))]GAIL 在机器人操作中生成自然动作,但依赖高质量专家数据(需 1 0 3 10^3 103 次示范)。

-

分层控制优化

在高维动作空间(如多关节机械臂),分层控制分解任务为粗略规划(如路径选择)和精细调整(如抓取角度),降低计算复杂度。例如,抓取任务中,上层规划路径 10 m 10 \, \text{m} 10m,下层调整精度至 0.1 mm 0.1 \, \text{mm} 0.1mm。

Imitation Learning (IL) - 模仿学习 Reinforcement Learning (RL) - 强化学习 构建训练数据集 收集专家示范 训练模仿模型 部署模型到智能体 智能体在环境中执行任务 评估和微调 智能体选择动作 a_t 智能体观察环境状态 s_t 环境响应动作 返回奖励 r_t 和状态 s_t+1 智能体接收反馈并更新策略

(三)联合建模框架

联合建模 整合视觉与动作信息,实现任务执行。主流框架包括:

-

编码器-解码器结构

视觉编码器(如 CNN 或 ViT)将图像编码为特征向量 z v ∈ R d v z_v \in \mathbb{R}^{d_v} zv∈Rdv,动作解码器(如全连接网络或 RNN)根据 z v z_v zv 和任务指令生成动作序列 a ∈ R d a a \in \mathbb{R}^{d_a} a∈Rda。例如,抓取任务中,编码器提取物体特征(维度 512),解码器输出机械臂轨迹(维度 6)。注意力机制 增强相关性,通过权重:

w i = softmax ( Q K T d k ) w_i = \text{softmax}\left(\frac{Q K^T}{\sqrt{d_k}}\right) wi=softmax(dk QKT)聚焦关键特征(如物体边缘),提升动作精度。训练时,端到端损失为:

L = L action + λ L perception L = L_{\text{action}} + \lambda L_{\text{perception}} L=Laction+λLperception其中 λ \lambda λ 平衡感知与动作精度。 -

多模态融合

融合视觉、语音、触觉等信息。例如,机器人根据语音"拿杯子"和视觉定位,生成抓取动作。多模态模型可采用共享表示(如 Transformer,输入拼接 z = [ z v ; z s ] z = [z_v; z_s] z=[zv;zs])或独立编码后拼接(如 MLP, z = W v z v + W s z s z = W_v z_v + W_s z_s z=Wvzv+Wszs)。触觉反馈(如力传感器 F = k x F = kx F=kx)进一步优化抓取力度。融合提升任务理解,例如语音识别错误率从 15% 降至 5%。

-

动态调整机制

在动态环境中,联合建模需实时更新。例如,物体移动时,视觉编码器每 100 ms 100 \, \text{ms} 100ms 刷新特征,动作解码器同步调整轨迹,延迟小于 50 ms 50 \, \text{ms} 50ms。

三、实际应用场景展示

(一)工业制造领域

在汽车制造中,视觉-动作联合建模提升装配效率。机器人通过摄像头(分辨率 1280 × 720 1280 \times 720 1280×720)识别零部件(如螺栓、车门),联合建模计算抓取位姿。特斯拉 Gigafactory 使用机器人装配电池模块,视觉系统定位电极(误差 0.05 mm 0.05 \, \text{mm} 0.05mm),机械臂以 0.1 mm 0.1 \, \text{mm} 0.1mm 精度安装,效率提升 35%,次品率降至 1% 以下。在电子制造中,贴片机通过视觉检测芯片位置(检测时间 10 ms 10 \, \text{ms} 10ms),动作系统以微秒级响应完成贴装,确保手机主板质量,年产量超 1 0 8 10^8 108 片。

(二)服务机器人领域

科沃斯扫地机器人通过视觉和激光传感器构建 2 m × 2 m 2 \, \text{m} \times 2 \, \text{m} 2m×2m 地图,联合建模规划清扫路径,避开障碍物(识别率 98%)。高端型号支持物体识别(如拖鞋、电源线),动态调整吸力(范围 1000 − 3000 Pa 1000-3000 \, \text{Pa} 1000−3000Pa)。医疗领域,达芬奇手术机器人通过三维视觉系统放大视野 10 倍,动作精度达 0.01 mm 0.01 \, \text{mm} 0.01mm,完成复杂手术(如心脏瓣膜修复),成功率提升 20%。

(三)智能交通领域

特斯拉 Autopilot 通过 8 个摄像头获取 36 0 ∘ 360^\circ 360∘ 视野,联合建模处理车道线、行人信息,控制车辆行驶。系统响应时间小于 100 ms 100 \, \text{ms} 100ms,雨天检测率仍达 95%。无人机在物流中通过视觉识别配送点,规划 10 km 10 \, \text{km} 10km 路径,误差小于 0.5 m 0.5 \, \text{m} 0.5m,日配送量超 1 0 3 10^3 103 次。

四、发展现状与挑战探讨

(一)发展现状

学术界在 CVPR 等会议上提出新模型,如 EfficientViT(参数量减少 50%)优化视觉编码效率。产业界,特斯拉、科沃斯部署联合建模技术,市场规模预计 2025 年达 500 亿美元,年增长率 15%。

(二)面临挑战

-

数据获取与标注

标注抓取数据需 1 0 4 10^4 104 小时,分布差异(如室内外光照)影响性能。例如,工业场景需标注 1 0 5 10^5 105 张图像,人工成本超 1 0 6 10^6 106 元。解决方案包括半监督学习,结合少量标注数据和大量无标注数据训练。

-

模型泛化能力

雨天自动驾驶误判率达 20%,需更多场景数据( 1 0 7 10^7 107 帧)。领域自适应技术(如迁移学习)可通过预训练模型适配新环境,降低数据需求 30%。

-

计算资源需求

训练需 1 0 3 10^3 103 GPU 小时(成本 1 0 4 10^4 104 元),边缘设备运行受限。模型压缩(如蒸馏)可减少 60% 计算量。

五、未来发展趋势展望

-

多模态融合

结合视觉、触觉(如力反馈 F = k x F = kx F=kx, k = 10 N/m k = 10 \, \text{N/m} k=10N/m)、语音(识别率 95%),提升抓取鲁棒性。例如,机器人通过触觉调整力度,成功率从 85% 升至 98%。

-

强化学习与深度学习结合

深度特征驱动策略优化,收敛时间缩短 50%(从 1 0 6 10^6 106 步降至 5 × 1 0 5 5 \times 10^5 5×105 步)。混合模型(如 DQN+ViT)在导航任务中路径效率提升 25%。

-

模型轻量化

剪枝减少 70% 参数(从 1 0 8 10^8 108 降至 3 × 1 0 7 3 \times 10^7 3×107),量化至 8 位精度,适配边缘设备(功耗降至 5 W 5 \, \text{W} 5W)。例如,Jetson Nano 上运行速度从 2 fps 2 \, \text{fps} 2fps 提升至 15 fps 15 \, \text{fps} 15fps。

六、总结

视觉-动作联合建模 推动具身智能发展,融合感知与动作,赋能工业、服务、交通等领域。面临数据、泛化、资源挑战,未来通过多模态融合、学习结合及轻量化突破瓶颈,助力智能社会建设。

延伸阅读