Spring AI聊天模型API:轻松构建智能聊天交互

前言

在当今数字化时代,智能聊天功能已成为众多应用程序提升用户体验、增强交互性的关键要素。Spring AI的聊天模型API为开发者提供了一条便捷通道,能够将强大的AI驱动的聊天完成功能无缝集成到各类应用中。借助预先训练的语言模型,如广为人知的GPT,它能够依据用户输入生成自然流畅、类人化的回复。这一API不仅工作机制高效,而且设计理念极为先进,旨在实现简单易用与高度可移植性,让开发者能以极少的代码改动在不同AI模型间自由切换,充分契合Spring框架一贯秉持的模块化与可互换性原则。接下来,让我们深入探索Spring AI聊天模型API的精妙之处。

一、核心接口与类解析

(一)ChatModel接口

ChatModel接口作为核心,定义了与AI模型交互的基本方法。它继承自Model<Prompt, ChatResponse>,提供了两个重载的call方法:

java

public interface ChatModel extends Model<Prompt, ChatResponse> {

default String call(String message) {...}

@Override

ChatResponse call(Prompt prompt);

}call(String message)方法简化了初始使用流程,开发者无需深入了解复杂的Prompt和ChatResponse类即可快速上手,直接传入简单字符串消息就能获得初步响应。然而,在实际开发中,call(Prompt prompt)方法更为常用,它接收封装好的Prompt实例,返回包含丰富信息的ChatResponse,为复杂业务场景提供了更强大的支持。

(二)StreamingChatModel接口

针对需要实时响应、提升交互即时性的场景,StreamingChatModel接口应运而生。它继承自StreamingModel<Prompt, ChatResponse>,同样有两个stream方法重载:

java

public interface StreamingChatModel extends StreamingModel<Prompt, ChatResponse> {

default Flux<String> stream(String message) {...}

@Override

Flux<ChatResponse> stream(Prompt prompt);

}与ChatModel类似,stream(String message)简化了使用,而stream(Prompt prompt)更适用于实际业务。该接口利用响应式编程的Flux API,将AI模型的响应以流的形式逐步返回,让用户在输入后能快速看到部分结果,极大提升了交互体验,尤其适用于长文本生成或实时聊天场景。

(三)Prompt类

Prompt类承担着封装输入信息的重任,它实现了ModelRequest<List<Message>>接口。其内部包含一个messages列表,用于存储多条消息,还可以有ChatOptions类型的模型请求选项。主要方法包括获取选项的getOptions和获取指令列表的getInstructions。

java

public class Prompt implements ModelRequest<List<Message>> {

private final List<Message> messages;

private ChatOptions modelOptions;

@Override

public ChatOptions getOptions() {...}

@Override

public List<Message> getInstructions() {...}

// constructors and utility methods omitted

}通过Prompt类,开发者可以灵活组织输入内容,将不同类型的消息以及对应的模型选项整合在一起,为AI模型提供精准的输入指令。

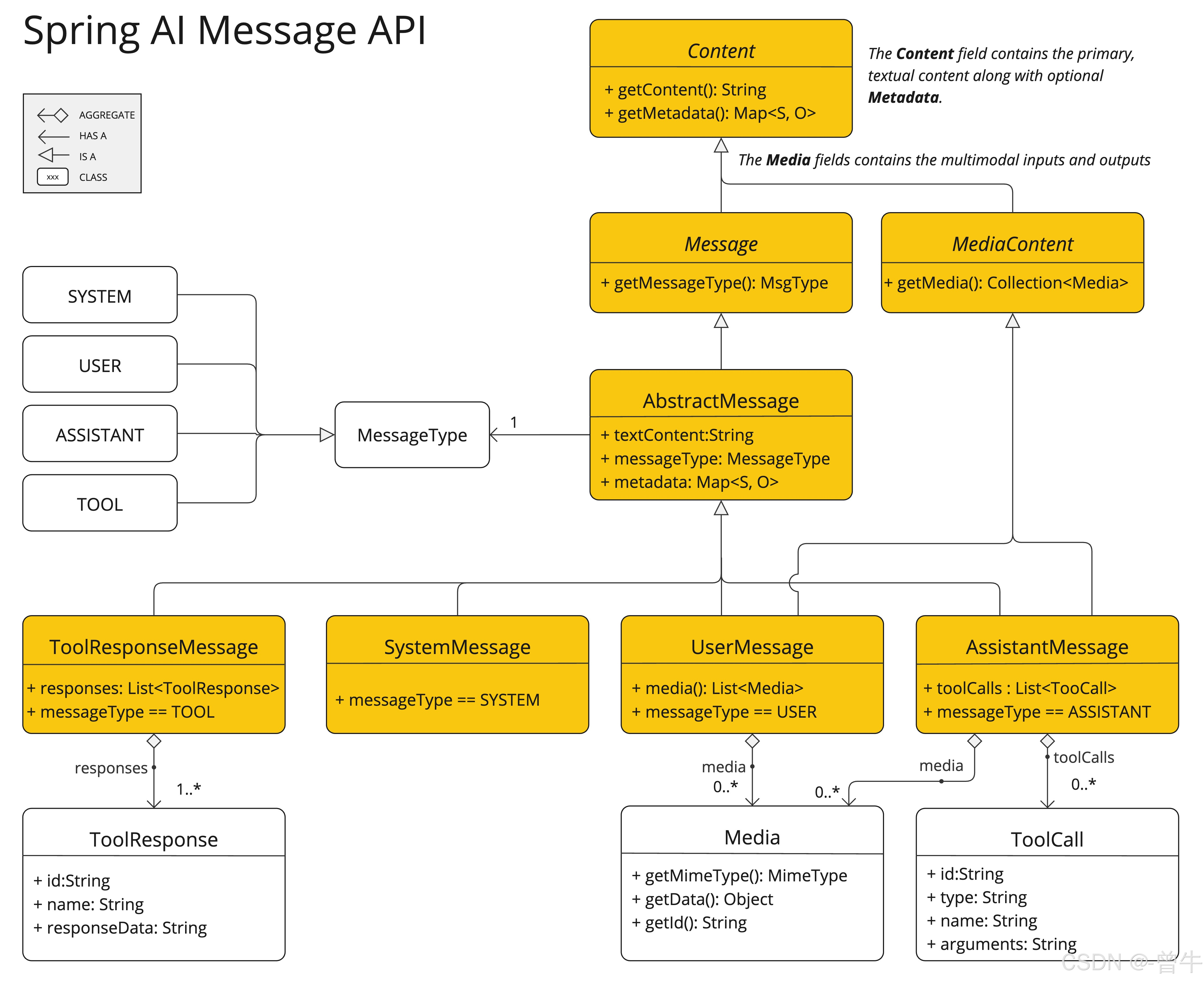

(四)Message接口及相关实现

Message接口用于封装消息内容、元数据以及消息类型MessageType。它继承自Content接口,Content接口又定义了获取文本内容的getText方法和获取元数据的getMetadata方法。

java

public interface Content {

String getText();

Map<String, Object> getMetadata();

}

public interface Message extends Content {

MessageType getMessageType();

}此外,多模态消息类型还实现了MediaContent接口,用于提供媒体内容对象。在实际应用中,不同的AI模型对消息类别有不同的识别方式,例如OpenAI能识别system、user、function、assistant等不同对话角色的消息类别。而对于一些不区分特定角色的AI模型,UserMessage实现类常作为标准类别,代表用户生成的查询或指令。这种设计使得Spring AI能够适配多种类型的AI模型,满足不同场景下的消息处理需求。

(五)ChatOptions接口

ChatOptions接口继承自ModelOptions,用于定义可传递给AI模型的可移植选项。它包含了诸如获取模型名称的getModel、频率惩罚系数的getFrequencyPenalty、最大生成令牌数的getMaxTokens等一系列方法,还提供了复制选项的copy方法。

java

public interface ChatOptions extends ModelOptions {

String getModel();

Float getFrequencyPenalty();

Integer getMaxTokens();

Float getPresencePenalty();

List<String> getStopSequences();

Float getTemperature();

Integer getTopK();

Float getTopP();

ChatOptions copy();

}每个特定的ChatModel或StreamingChatModel实现都可以有自身特有的选项,例如OpenAI聊天完成模型的logitBias、seed和user等选项。Spring AI通过这种设计,允许开发者在启动应用时设置默认配置,又能在运行时根据每个Prompt请求灵活覆盖这些设置,极大地提高了配置的灵活性。

(六)ChatResponse类与Generation类

ChatResponse类用于保存AI模型的输出结果。它包含一个ChatResponseMetadata对象用于存储模型响应的元数据,以及一个generations列表,每个Generation实例代表单个提示可能产生的多个输出之一。

java

public class ChatResponse implements ModelResponse<Generation> {

private final ChatResponseMetadata chatResponseMetadata;

private final List<Generation> generations;

@Override

public ChatResponseMetadata getMetadata() {...}

@Override

public List<Generation> getResults() {...}

// other methods omitted

}Generation类则继承自ModelResult<AssistantMessage>,它包含一个assistantMessage用于表示模型输出的内容,以及ChatGenerationMetadata类型的元数据。

java

public class Generation implements ModelResult<AssistantMessage> {

private final AssistantMessage assistantMessage;

private ChatGenerationMetadata chatGenerationMetadata;

@Override

public AssistantMessage getOutput() {...}

@Override

public ChatGenerationMetadata getMetadata() {...}

// other methods omitted

}这两个类相互配合,完整地将AI模型的输出结果结构化,方便开发者获取和处理模型生成的内容及相关信息。

这Messageinterface 具有各种实现,这些实现对应于 AI 模型可以处理的消息类别:

二、可用实现与框架优势

Spring AI聊天模型API支持多种来自不同提供商的AI聊天模型,如OpenAI聊天完成(具备流媒体、多模式和函数调用支持)、Microsoft Azure Open AI Chat Completion(支持直播和函数调用)、Ollama聊天完成(支持流媒体、多模态和函数调用)、Hugging Face Chat完成(不支持流式传输)、Google Vertex AI Gemini聊天完成功能(支持流式、多模态和函数调用)、Amazon Bedrock、Mistral AI聊天完成(支持流媒体和函数调用)、Anthropic Chat Completion(支持流媒体和函数调用)等。这种广泛的支持使得开发者能够根据项目需求、预算以及对功能特性的要求,灵活选择最适合的AI模型。同时,Spring AI提供了一套复杂而灵活的系统来配置和使用聊天模型。在启动时,开发者可以设置默认配置,而在运行时,又能依据每个请求动态覆盖这些设置,所有操作都在Spring AI框架提供的统一接口中完成,极大地提高了开发效率和系统的可维护性。

三、配置与执行流程

Spring AI处理聊天模型的配置和执行流程设计精妙。在启动阶段,ChatModel或StreamingChatModel会使用"启动"聊天选项进行初始化,这些选项为模型提供了默认配置。在运行时,每个请求的Prompt可以包含运行时聊天选项,这些选项能够覆盖启动时设置的默认选项。在实际执行过程中,会先进行"合并选项"操作,将启动选项和运行时选项结合起来,若有运行时选项,则其优先级高于启动选项。接着,"转换输入"步骤会将输入指令转换为特定模型的原生格式,以便模型能够理解和处理。模型处理完成后,"Convert Output"步骤会将模型的响应转换为标准化的ChatResponse格式,方便应用程序后续使用。这种启动和运行时选项分离的设计,既保证了全局配置的稳定性,又提供了针对特定请求的灵活调整能力。

以程图说明了 Spring AI 如何处理聊天模型的配置和执行,并结合了启动和运行时选项:

四、基于Spring AI通用模型API构建

Spring AI聊天模型API构建在Spring AI的通用模型API之上,它充分利用了通用模型API的基础能力,在此之上提供了特定于聊天场景的抽象和实现。这种设计使得不同AI服务之间的集成和切换变得轻松自如,同时为客户端应用程序始终保持一致的API,极大地降低了开发者在不同AI模型间切换的成本,提高了代码的可复用性和可维护性。

此图说明了统一接口ChatModel和StreamingChatModel用于与来自不同提供商的各种 AI 聊天模型进行交互,从而允许在不同的 AI 服务之间轻松集成和切换,同时为客户端应用程序保持一致的 API。

总结

Spring AI的聊天模型API无疑是开发者在构建智能聊天应用时的得力助手。它凭借丰富且灵活的接口设计,支持多种主流AI模型,为开发者提供了广阔的选择空间;独特的配置与执行流程,兼顾了全局配置的稳定性与请求级别的灵活性;构建于通用模型API之上的架构,又确保了不同AI服务集成与切换的便捷性。通过使用Spring AI聊天模型API,开发者能够高效地将智能聊天功能融入应用程序,为用户带来更加自然、流畅的交互体验。无论是开发智能客服系统、在线教育辅导工具,还是社交聊天应用,Spring AI聊天模型API都能助力开发者快速实现创新想法,在智能交互领域迈出坚实步伐。期待开发者们在这一强大API的支持下,创造出更多令人惊艳的智能聊天应用。