概述

在当今数字化时代,人工智能(AI)技术在诸多领域展现出了强大的能力,但在处理历史语言这一特定任务时,却遭遇了不小的挑战。美国和加拿大的研究人员通过合作发现,像 ChatGPT 这样的大型语言模型(LLMs),在没有经过广泛且深入的 预训练 的情况下,很难精准地重现历史时期的习语和语言风格。预训练是一个既耗时又耗费资源的过程,对于大多数学术研究和娱乐项目来说,都是一道难以跨越的门槛。这使得一些颇具创意的想法,例如利用 AI 来 完成查尔斯·狄更斯的最后一部未完成的小说,在实际操作中变得不太可行。

为了探索 AI 在生成具有历史准确性文本方面的潜力,研究人员尝试了多种方法。他们从使用 20 世纪早期的散文对模型进行简单提示入手,逐步深入到对商业模型在该时期的少量书籍上进行 微调。此外,他们还将这些结果与一个完全在 1880 年至 1914 年间出版的书籍上训练的独立模型进行了对比分析。

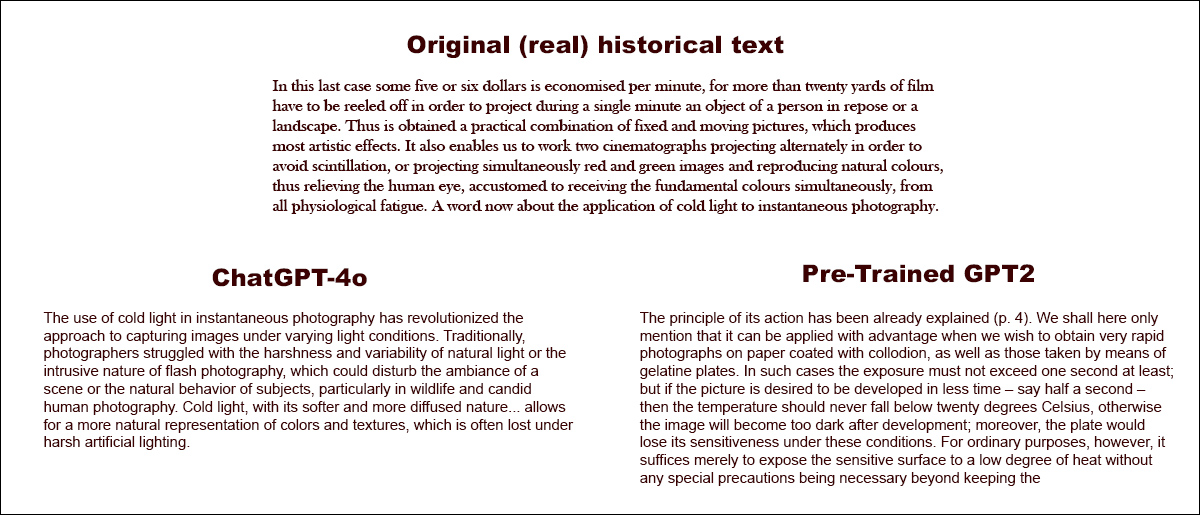

在第一次测试中,研究人员要求 ChatGPT-4o 模仿 _fin‑_de‑siècle(世纪末)的语言风格,其结果与经过该时期文学微调的小型 GPT2 模型的结果形成了鲜明对比:

当被要求完成一段真实的历史文本(顶部中心)时,即使是经过充分准备的 ChatGPT-4o(左下)也难以避免地回到了 "博客" 模式,未能准确地代表所请求的历史习语。相比之下,经过微调的 GPT2 模型(右下)虽然在其他方面的准确性有所欠缺,但却很好地捕捉到了那个时期的语言风格。来源:https://arxiv.org/pdf/2505.00030

尽管微调过程使模型的输出在一定程度上更接近原始的历史风格,但人类读者依然能够频繁地从中检测出现代语言或思想的痕迹。这表明,即使是经过精心调整的模型,仍然不可避免地会反映出其当代训练数据的影响。研究人员最终得出了一个令人沮丧的结论:目前并没有一种经济实惠的捷径可以生成机器生产的、在习语上正确的历史文本或对话。他们还推测,这一挑战本身可能从一开始就被错误地提出了:

"[我们] 还应该考虑,时代错误在某种意义上可能是不可避免的。无论我们是通过指令微调历史模型,使它们能够进行对话,还是通过教授当代模型模仿较早时期的语言,真实性与对话流畅性之间可能都需要某种妥协。

"毕竟,不存在'真实'的 21 世纪提问者与 1914 年受访者之间的对话。尝试创建这种对话的研究人员需要反思 [前提],即解释总是涉及现在和 [过去] 之间的协商。"

这项 新研究 的标题是 语言模型能否在不出现时代错误的情况下代表过去?,由来自伊利诺伊大学、不列颠哥伦比亚大学和康奈尔大学的三位研究人员共同完成。

研究现状

最初,研究人员采用了一个三部分的研究方法,首先测试了现代语言模型是否可以通过简单的提示被引导去模仿历史语言。他们选取了 1905 年至 1914 年间出版的书籍中的真实节选,然后要求 ChatGPT‑4o 用相同的习语继续这些段落。

以下是他们选取的一段原始时期的文本示例:

"在最后一种情况下,每分钟可以节省大约五到六美元,因为为了在单分钟内投影静止的人物或风景,需要卷动超过二十码的胶片。因此,获得了固定和移动图像的实际组合,产生了最具艺术效果的效果。

"它还使我们能够交替使用两台电影摄影机进行投影,以避免闪烁,或者同时投影红色和绿色图像并再现自然色彩,从而减轻人眼的生理疲劳,因为人眼习惯于同时接收基本色彩。现在谈谈冷光在瞬间摄影中的应用。"

为了评估生成的文本是否符合预期的历史风格,同时考虑到人们通常并不擅长猜测文本的写作日期,研究人员对 RoBERTa 模型进行了微调,使其能够估计出版日期。他们使用了 美国历史英语语料库 的一个子集,该语料库涵盖了从 1810 年至 2009 年的材料。

随后,研究人员利用经过微调的 RoBERTa 分类器来评估 ChatGPT‑4o 生成的续写。这些续写是基于 1905 年至 1914 年间出版的书籍中的真实段落提示生成的。

系统提示(即关于如何处理任务的上下文指令)如下:

"你的任务是完成 20 世纪早期书籍中的段落。你将获得 1913 年出版的一本书中的一个段落。用相同的风格继续这个段落,至少 200 字。只提供这个续写;不要做任何框架性评论,如'这是续写:'。"

尽管研究人员尝试了 单次提示和 20 次提示,但 ChatGPT-4o 的输出始终倾向于 21 世纪的风格。

以下是论文中给出的一个例子,展示了 ChatGPT-4o 对关于摄影的真实时期文本的类似博客的续写尝试:

"冷光在瞬间摄影中的应用彻底改变了在不同光照条件下捕捉图像的方法。传统上,摄影师在自然光的严酷性和变化性或闪光摄影的侵入性方面挣扎,这可能会破坏场景的氛围或拍摄对象的自然行为,特别是在野生动物和抓拍人像摄影中。

"冷光以其更柔和、更弥散的特性......允许更自然地呈现色彩和纹理,这在强烈的自然光下往往会丢失。"

正如我们很容易看到的,这种通用的、维基风格的文本并不符合原始时期文本的冗长和华丽的风格。此外,它并没有真正从原始内容结束的地方继续,而是开始对其中一个子主题进行旁征博引的、抽象的思考。

该团队还测试了 GPT‑1914,这是一个较小的 GPT‑2 类模型,从头开始在 1880 年至 1914 年间的 265 亿个文学标记上进行训练。

尽管其输出不如 ChatGPT‑4o 那样连贯,但更符合源时期的风格。以下是论文中提供的唯一例子,同样是作为对关于摄影的真实世界时期文本的续写:

"其作用原理已在第 4 页中解释过。我们这里仅提及,当我们要在涂有火棉胶的纸上获得非常快速的摄影,以及通过明胶板拍摄的照片时,可以有利地应用这种方法。

"在这种情况下,曝光时间至少不应超过一秒钟;但如果希望在更短的时间内------比如半秒钟------完成拍摄,则温度不应低于 20°C,否则图像在显影后会变得太暗;此外,在这些条件下,感光板会失去其灵敏度。

"然而,对于普通用途,通常只需将感光表面暴露在较低的温度下,无需采取任何特殊预防措施,只需保持......" [原文如此]

由于即使是真实和原始的材料也是晦涩难懂且难以理解的,因此很难判断 GPT-1914 在多大程度上准确地从原始内容中延续下来;但输出肯定听起来更符合时期风格。

然而,作者从这个实验中得出结论,简单提示几乎无法克服像 ChatGPT-4o 这样的大型预训练模型的当代偏见。

实现方法

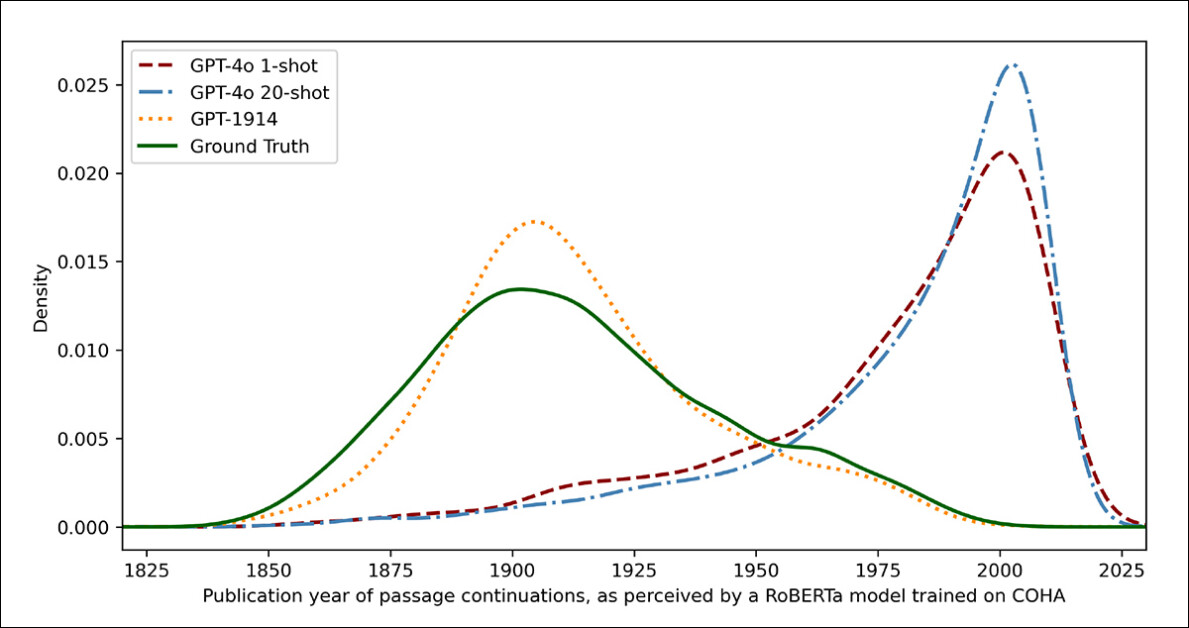

为了衡量模型输出与真实历史写作的相似程度,研究人员使用统计分类器估计每个文本样本的可能出版日期。然后,他们使用 核密度图 可视化结果,该图显示模型认为每个段落在历史时间线上的位置。

基于训练有素的分类器估计的真实和生成文本的出版日期(1905--1914 年的源文本与 GPT‑4o 使用单次提示和 20 次提示的续写,以及仅在 1880--1914 年的文学作品上训练的 GPT‑1914 进行比较)。

作者指出,用于此任务的微调 RoBERTa 模型并非完美无缺,但仍然能够突出显示一般风格趋势。由完全在时期文学上训练的 GPT‑1914 生成的段落聚集在 20 世纪早期------类似于原始源材料。

相比之下,即使在多个历史示例的提示下,ChatGPT-4o 的输出也倾向于类似于 21 世纪的写作,反映了其最初训练的数据。

研究人员使用 Jensen-Shannon 散度量化了这种不匹配,这是一种衡量两个概率分布差异的方法。GPT‑1914 与真实历史文本的得分接近 0.006,而 ChatGPT‑4o 的单次提示和 20 次提示输出显示出更大的差距,分别为 0.310 和 0.350。

作者认为,这些发现表明,即使有多个示例,仅凭提示也无法可靠地产生令人信服地模拟历史风格的文本。

模型微调

论文接着调查了微调是否会产生更好的结果,因为这个过程涉及通过在用户指定的数据上 "继续" 训练来直接影响模型的可用 权重------这个过程可能会影响模型的原始核心功能,但在微调过程中被 "推入" 或强调的领域中,可以显著提高其性能。

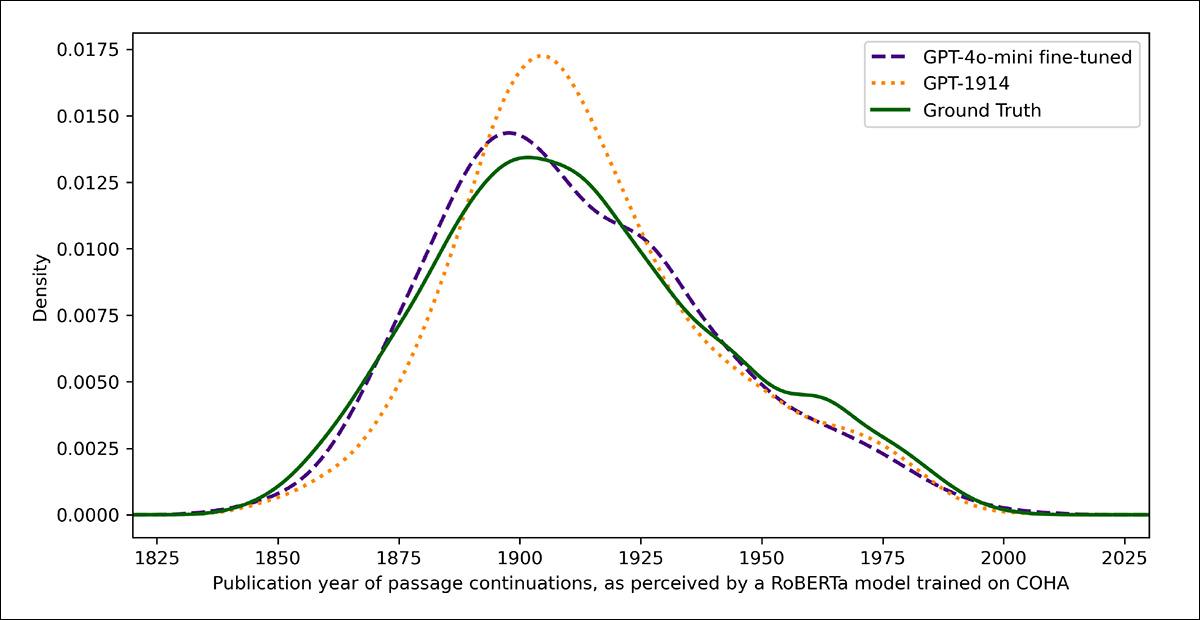

在第一次微调实验中,团队在 1905 年至 1914 年间出版的书籍中抽取了大约两千对段落完成对,对 GPT‑4o‑mini 进行训练,目的是看看小规模的微调是否能够将模型的输出转向更符合历史准确性的风格。

使用在早期测试中作为评判的相同基于 RoBERTa 的分类器来估计每个输出的风格 "日期",研究人员发现,在新的实验中,微调后的模型生成的文本与真实情况紧密对齐。

其与原始文本的风格差异,通过 Jensen-Shannon 散度衡量,降至 0.002,与 GPT‑1914 基本一致:

真实和生成文本的估计出版日期,显示 GPT‑1914 和微调版 GPT‑4o‑mini 如何与 20 世纪早期的写作风格相匹配(基于 1905 年至 1914 年间出版的书籍)。

然而,研究人员警告说,这种指标可能只能捕捉到历史风格的表面特征,而不是更深层的概念或事实性时代错误。

"[这个测试] 并不非常敏感。这里用作评判的 RoBERTa 模型只是被训练来预测日期,而不是区分真实段落和时代错误的段落。它可能使用粗糙的风格证据来进行预测。人类读者或更大的模型可能仍然能够在听起来'符合时期'的段落中检测出时代错误的内容。"

评估测试

最后,研究人员进行了人类评估测试,使用 250 个手工挑选的 1905 年至 1914 年间出版的书籍中的段落。他们观察到,其中许多文本可能与当时写作时的解释有很大不同:

"我们的列表中包括,例如,关于阿尔萨斯(当时属于德国)的百科全书条目,以及关于脚气病(当时通常被解释为真菌疾病,而不是营养缺乏)的条目。虽然这些都是事实差异,我们还挑选了一些会显示出更微妙的态度、修辞或想象力差异的段落。

"例如,20 世纪早期对非欧洲地方的描述往往滑向种族概括。1913 年对月球日出的描述想象了丰富的色彩现象,因为当时还没有人看到过没有 [大气层] 的世界的照片。"

研究人员为每个历史段落创建了简短的问题,这些问题可以合理地回答,然后在这些问答对上对 GPT‑4o‑mini 进行微调。为了加强评估,他们训练了五个单独的模型版本,每次 留出 不同部分的数据用于测试。

然后,他们使用默认版本的 GPT-4o 和 GPT-4o‑mini 以及微调后的变体生成响应,每个变体都在其在训练期间未见过的部分上进行评估。

总结

为了评估模型在多大程度上能够令人信服地模仿历史语言,研究人员要求三位专家标注者审查 120 个 AI 生成的续写,并判断每一个是否对 1914 年的作者来说是合理的。

这种直接评估方法比预期更具挑战性:尽管标注者在近 80% 的时间里对评估结果达成一致,但他们的判断不平衡("合理" 的选择频率是 "不合理" 的两倍),这意味着他们实际的一致性水平只有中等,通过 Cohen's kappa 分数 测量为 0.554。

标注者自己描述这项任务为 困难,通常需要额外的研究来评估一个陈述是否与 1914 年已知或相信的内容一致。

一些段落提出了关于语气和视角的难题------例如,一个回应是否适当地限制了其世界观,以反映 1914 年典型的水平。这种判断通常取决于 种族中心主义 的程度(即,倾向于通过自己文化的假设或偏见来看待其他文化)。

在这种情况下,挑战在于判断一个段落是否表达了足够的文化偏见,使其看起来具有历史合理性,同时又不显得过于现代,或者按照当今的标准过于明显地冒犯性。作者指出,即使对于熟悉该时期的研究人员来说,也很难在感觉符合历史准确性的语言和反映当今思想的