本文来源公众号**"Coggle数据科学"**,仅用于学术分享,侵权删,干货满满。

原文链接:https://mp.weixin.qq.com/s/rA0sYUHEtX2miew_xO3kZw

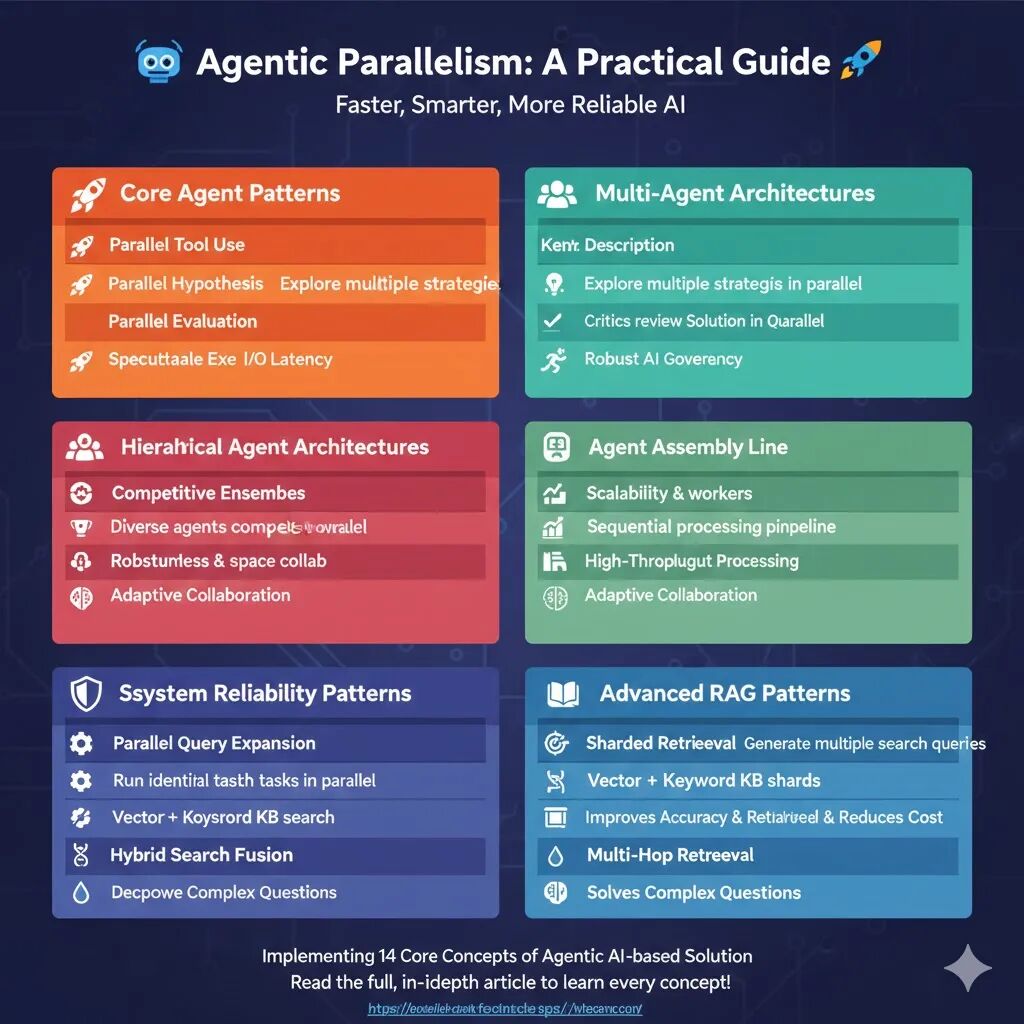

在 AI 智能体的世界中,速度、质量和可靠性 不仅仅是特性,它们是必备条件。一个单一、顺序执行的智能体可能速度慢、容易出错,并且解决问题的能力有限。解决方案是采用并行思维:设计一个系统,让多个智能体、流程或任务可以同时执行,以实现共同的目标。

大规模的智能体系统通常受到两个主要因素的瓶颈:

-

I/O 延迟: 等待网络、数据库和外部 API 调用。

-

质量与可靠性: 单一的推理路径可能导致次优或错误的输出。

智能体并行化通过重叠等待时间 、探索多种解决方案路径 和创建弹性、自校正系统来正面应对这些挑战。

核心能力1: 并行工具使用

并行工具使用是构建高性能、低延迟 智能体系统的核心模式之一。它解决的主要问题是 I/O 延迟,这是大多数依赖外部服务的 AI 应用的性能瓶颈。

该模式的核心在于允许 大型语言模型 (LLM) 在单次调用中识别并规划多个独立的工具调用,然后由执行器同时启动这些调用。

-

传统(顺序)模式: LLM 规划工具 A 等待 A 执行完毕 LLM 规划工具 B 等待 B 执行完毕。

-

并行模式: LLM 规划 工具 A 和 工具 B 同时执行 A 和 B 收集所有结果。

LLM 通过 工具绑定(Tool Binding) 机制,接收到所有可用工具的 Schema(即函数签名和 Docstring)。当用户查询(例如:"告诉我苹果的股价和最近的新闻")需要多个工具时,LLM 会在一次 AIMessage 响应中生成一个包含多个 tool_calls 对象的列表。这是并行执行的信号。

并行执行带来的性能提升主要体现在 I/O 耗时的重叠上。如果两个工具调用都需要 3 秒的网络等待时间,顺序执行的总耗时为 6 秒(忽略中间 LLM 的思考时间),而并行执行的总耗时将接近 3 秒。

核心能力2: 并行假设生成

并行假设生成(或称"分支思维")是一种高级的智能体并行模式,旨在通过探索多条推理路径 来提高 AI 系统的决策质量、鲁棒性和创造力。它将单一、线性的思维过程转化为多维度、并发的战略探索。

此模式的价值在于从执行层面转向战略层面的优化:

-

策略探索: 智能体首先充当"规划者"(Planner),根据初始问题生成 N 个不同的、独立的潜在解决方案或视角(即假设)。

-

并行深化:N 个独立的"工作者"(Worker)智能体同时被激活,每个工作者负责深化其中一个假设,独立生成一个完整的输出(例如,基于某一营销角度生成口号)。

-

收敛与优化: 所有并行结果被收集,然后由一个"裁判"(Judge)智能体进行批判性评估和综合,最终选出或合成最优解。

核心能力3: 并行评估与反思

并行评估与多批评家反思是一种高级智能体架构模式,专注于在高风险、高标准 的生产环境中实现稳健、全面和高效的质量保证(QA)和 AI 治理。

此模式的核心在于用一组专业化智能体 取代单一、通用的评估器,并让它们同时工作。

-

专业化 (Specialization): 每个"批评家"(Critic Agent)都被赋予一个特定的专业领域和一套严格的评估标准。例如:

-

事实核查员(Fact-Checker): 专注于验证内容中陈述的客观准确性,可调用外部搜索工具。

-

品牌声音分析师(Brand Voice Analyst): 专注于评估内容的语气、风格和对品牌指南的遵循情况。

-

风险评估员(Risk Assessor): 专注于识别潜在的法律、伦理或声誉风险。

-

-

并行化 (Parallelism): 通过 LangGraph 的 Fan-Out (分散) 机制,将同一份内容同时发送给所有批评家。所有批评家同时独立运行,以墙钟时间(Wall-Clock Time) 最长的任务为准完成评估阶段。

-

聚合与反思 (Aggregation & Reflection): 最后,一个中心化的 总编辑(Chief Editor) 智能体接收所有批评家提供的结构化反馈(通过 Pydantic 模型确保格式统一),进行综合判断、制定最终决策,并输出清晰的修订指令。

核心能力4: 推测性执行与预取

推测性执行与预取是一种旨在隐藏延迟 (Latency Hiding)、优化用户体验 的高级并行模式。其核心目标是让 AI 智能体的交互感更加即时和主动,将系统的响应性提升至超响应级别。

该模式利用了智能体工作流中固有的时间差,通过提前行动来抵消耗时的 I/O 操作。

-

时序分析: 典型的智能体工作流包含两个连续的耗时阶段:

-

思考 (Thinking): LLM 推理时间(例如 3-5 秒)。

-

行动 (Acting): 工具调用(I/O 延迟,例如数据库查询 3 秒)。

-

顺序总耗时: 思考时间 + 行动时间。

-

-

推测与并行: 系统在接收到用户输入后,无需等待 LLM 完成推理,即可基于上下文(例如,在客服场景中是用户 ID)推测 智能体最可能需要的工具调用(例如,

get_order_history(user_id))。

核心能力5: 分层智能体团队

分层智能体团队,即**"指挥官-工作者"(Orchestrator-Worker)** 模型,是构建能够处理复杂、多领域任务的可扩展 智能体系统的基石。它模仿了人类组织中管理层分解任务、专家团队并行执行 的模式,以同时优化系统的质量、准确性 和速度。

-

指挥官 (Orchestrator):

-

职责: 接收复杂的初始请求(例如,"撰写投资报告")。其核心价值在于任务分解 ,即将复杂请求拆解为一组简单、清晰、可并行执行的子任务(例如,"获取财务数据" 和 "分析市场新闻")。

-

工具: 通常不直接使用 I/O 工具,而是使用 Pydantic 结构化输出来定义和传递任务。

-

-

工作者 (Worker):

-

职责: 每个工作者都是一个高度专业化 的智能体,只负责一个子任务(例如,

Financial Analyst只负责财务数据)。它们被赋予专用的工具 和聚焦的提示词。 -

工具: 直接使用 I/O 工具(如

yfinance或Tavily)高效执行其专业任务。

-

-

合成 (Synthesis):

- 工作者并行完成后,指挥官(或另一个专门的合成节点)将所有结构化结果 汇集,并将其整合为一个连贯、统一的最终产品。

分层团队带来的优势是复合的,尤其在质量方面超越了单体智能体。单体智能体(Monolithic Agent)在面对多步骤任务时,容易在工具调用、数据处理和最终合成 之间产生认知负荷,导致输出质量不稳定。专业工作者(Specialist Worker)由于提示词和工具的限制,任务焦点更集中 ,其输出(如结构化的 FinancialData)更准确可靠。

核心能力6: 竞争性智能体集成

竞争性智能体集成模式通过多样化生成 和裁判评估 来解决复杂或高风险任务的鲁棒性 和质量问题。它模仿了人类组织中的"竞争设计"或"评审委员会"流程。

该模式旨在通过多样性来克服单一 LLM 的固有偏差和局限性。

-

多样性 (Diversity): 团队由多个智能体组成,它们具有不同的模型(如 Llama 3 vs. Claude Sonnet)、视角(如创意 vs. 直率)或提示词。这种差异确保了对同一问题产生多维度的解决方案。

-

并行生成 (Parallel Generation): 利用 LangGraph 的 Fan-Out (分散) 机制,所有竞争者同时独立工作,生成各自的完整解决方案。

- 效率提升: 如示例所示,串行执行可能需要 19 秒以上 ,而并行执行的总耗时仅为 7.33 秒(由最慢的 Agent 决定),大大提高了效率。

-

裁判仲裁 (Judge Arbitration): 一个专门的裁判(Judge) 智能体接收所有并行输出。裁判被赋予一个客观的评估标准(如清晰度、创造力、影响力),并负责:

-

批判 (Critique): 对每个解决方案进行详细、公正的评估。

-

选择 (Selection): 选出最符合标准的最终赢家,并提供结构化、可追溯的理由。

-

核心能力7: 智能体流水线

智能体流水线(或称高吞吐量管道化 Pipelining )是一种专注于最大化系统吞吐量 的并行模式。它将复杂的任务处理流程分解为一系列连续、专业化的处理阶段 ,使得不同阶段的智能体可以同时处理不同的任务项,从而实现高效的批量数据处理。

该模式模仿了现实世界中的工厂流水线,其中每个工作站都有一个特定、重复的任务。

核心能力8: 分散式协作

分散式黑板协作是一种灵活、强大的多智能体架构模式,它通过一个共享数据空间(黑板) 和一个中央路由器 ,实现了智能体之间的解耦(Decoupling) 和事件驱动(Event-Driven) 的协作。该模式适用于解决方案路径不确定或需要多方专家贡献知识、共同构建复杂解决方案的场景。

黑板系统的核心在于智能体之间不直接通信,而是通过修改和读取共享的中央状态来协作。

-

黑板 (The Blackboard):

-

在 LangGraph 中,黑板就是Graph State (例如

BlackboardState)。它存储了问题的原始信息和所有智能体贡献的中间成果(结构化数据)。 -

智能体通过写入 黑板来共享信息,通过读取黑板来获取所需的输入。

-

-

专业化知识源 (Knowledge Sources):

- 每个智能体(例如

Analyzer、Retriever、Draftsman)都是一个独立、专业的知识源,只关注黑板上的特定信息变化。

- 每个智能体(例如

-

中央路由器 (The Central Router):

-

路由器是系统的决策大脑 。它在每个步骤后检查黑板的当前状态,并根据"当前需要什么信息"来机会主义地激活最相关的智能体。

-

例如: 如果黑板上有

analysis但没有solution,路由器就激活Retriever。

-

核心能力9: 冗余执行与容错

冗余执行是一种高可靠性架构模式,旨在通过并行运行多个相同任务 来消除单点故障 和长尾延迟 的影响。其核心原则是,对于关键步骤,系统不依赖于任何单个实例,而是选择最快 且成功的结果。

该模式利用并行计算的优势,将潜在的不可靠因素转化为确定性的高成功率和低延迟。

-

容错性 (Fault Tolerance):

-

当一个任务被并行提交给 个相同的智能体或工具实例时,只要其中一个实例成功,整个任务就成功。

-

即使其中 个实例因网络错误、资源竞争或其他随机故障而失败,只要剩下一个成功,系统即可继续运行。

-

示例: 简单 Agent 的 5 次尝试中失败了 2 次(40% 失败率)。冗余 Agent 仅失败了 1 次(20% 失败率),在实际环境中,两个独立故障同时发生的概率极低,成功率会更高。

-

-

延迟一致性 (Latency Consistency):

-

长尾延迟(Long-Tail Latency) 是指少数任务因网络抖动或服务过载而耗时过长。

-

冗余执行确保任务完成时间取决于最快完成的实例,而不是最慢的实例。

-

示例: 在尝试 3 中,慢速实例耗时 ****,导致简单 Agent 总耗时 ****。但在 Redundant Agent 的尝试 3 中,快速实例率先完成,总耗时仅 ****,成功隐藏了慢速实例的延迟。

-

核心能力10: RAG 并行查询扩展

并行查询扩展是一种预检索(Pre-retrieval) 策略,用于解决 RAG 系统中最常见的故障模式之一:词汇不匹配问题(Vocabulary Mismatch) 。该模式通过利用 LLM 的生成能力,将用户的原始查询转化为多个多样化的搜索视角,从而最大限度地提高检索召回率(Recall)。

该模式的核心在于不依赖用户的单一、原始查询,而是同时使用 LLM 生成的多种查询类型进行并行搜索。

-

查询转换 (Query Transformation): * 在一个结构化输出步骤中,LLM 根据用户查询生成以下多个搜索项:

-

假设文档 (HyDE - Hypothetical Document): 生成一个貌似真实的、直接回答问题的长文本段落。由于向量嵌入基于语义相似性,搜索这个"假设答案"可以更好地匹配知识库中真正答案的语义空间。

-

子问题 (Sub-Questions): 将一个复杂的、多方面的查询分解成几个更简单、更具体的问题。

-

关键词与实体 (Keywords & Entities): 提取核心名词和技术术语,用于精确的关键词搜索(尤其适用于稀有实体)。

-

-

并行检索 (Parallel Retrieval):

-

使用

ThreadPoolExecutor等并发机制,同时将所有生成的查询(HyDE、子问题、关键词等)提交给向量检索器。 -

召回率 (Recall) 提升: 任何一个查询命中了相关文档,该文档就会被收集。这种多重搜索机制确保了系统能从知识库中找到所有相关的文档。

-

-

最终合成 (Synthesis): * 将所有并行检索到的(并去重后的)文档集合提供给最后的生成智能体,从而产出更全面、准确的答案。

核心能力11: RAG 分片与分散式检索

分片与分散式检索(Sharded & Scattered Retrieval)是一种关键的基础设施 模式,用于解决企业级 RAG 系统中知识库达到数百万或数十亿文档 时的低延迟 和高可扩展性挑战。该模式通过将庞大的知识库拆分为多个独立、可并行检索的子索引,来保证系统的性能和准确性。

该模式将检索系统的瓶颈------单一巨大索引的检索延迟------转化为多个小索引的并行检索。

-

知识库分片 (Sharding):

-

将一个巨大的单体(Monolithic) 向量存储库按逻辑维度(如主题、数据源、产品线、时间)分割成多个更小、更易于管理的**分片 (Shards)**。

-

优势: 检索延迟主要与索引大小相关。在小型索引上搜索总是比在大型索引上快得多。

-

-

分散式查询 (Scattered Query):

- 当用户查询到来时,一个元检索器 (Meta-Retriever) 或中央编排器将相同的查询同时发送给所有分片进行并行搜索。

-

结果汇聚与重排序 (Gather & Re-rank):

-

所有分片并行返回它们认为最相关的文档。

-

系统汇聚 (Gather) 这些结果,并执行一个最终的重排序(Re-ranking) 步骤(本例中为去重),以确定全局最相关的文档集合。

-

核心能力12: RAG 并行混合搜索融合

并行混合搜索融合是一种先进的 RAG 检索模式,旨在通过同时结合词汇(Keyword)和语义(Vector)搜索的优势 来最大化检索的准确性(Accuracy) 和精确性(Precision)。它解决了单一搜索方法在复杂、多样化知识库中普遍存在的盲点问题。

该模式通过在检索阶段的并行执行,确保系统能找到所有类型的相关信息,无论用户使用的是描述性语言还是精确的标识符。

-

语义搜索 (Semantic Search / Vector):

-

能力: 捕捉查询的概念和意图 。即使文档和查询使用的词汇完全不同,只要它们含义相似,也能被找到。

-

优势: 适用于描述性问题,例如"我们公司在节能方面做了哪些努力?"(与文档中的"绿色计算战略"匹配)。

-

-

词汇搜索 (Lexical Search / Keyword):

-

能力: 擅长精确匹配查询中的特定术语、数字、代码和专有名词。

-

优势: 适用于查找特定标识符,例如"

ERR_THROTTLE_900"或产品型号。

-

-

并行与融合 (Parallel & Fusion):

-

并行执行: 两种搜索方法同时独立运行,互不干扰,保证了效率。

-

结果融合: 将两种搜索方法找到的所有文档汇集起来,进行去重。最终的上下文集合既具有语义的广度,又具备词汇的精确度。

-

核心能力13: RAG 并行上下文预处理

并行上下文预处理是一种后检索(Post-retrieval) RAG 模式,旨在解决高召回率检索带来的问题:将大量原始、嘈杂的文档直接输入给最终的生成 LLM 会导致成本高、延迟长,并易引发 LLM 的**"迷失在中间"(Lost in the Middle)** 认知偏差。

该模式的核心思想是:**先精炼,后合成 (Distill Before You Synthesize)**。

该模式在检索和最终生成之间插入了一个关键的并行蒸馏(Parallel Distillation) 步骤,用于将大量的原始上下文(高召回)压缩为少量但信息密集的精炼上下文(Distilled Context)。

-

高召回检索 (High Recall Retrieval): 第一步是故意检索一个大的文档集(例如 或更高),以确保包含答案的文档被找到。

-

并行蒸馏 (Parallel Distillation):

-

相关性过滤 (Relevance Check): 判断文档是否真正相关。

-

摘要提炼 (Summarization): 将长文档压缩成关键要点。

-

将原始文档集分成多个子集(本例中是将每个文档视为一个任务)。

-

使用多个并行、轻量级的 LLM 调用,对每个子集执行高度集中的任务,如:

-

优势: 多个轻量级 LLM 并行执行,总耗时远小于用一个 LLM 顺序处理。

-

-

最终生成 (Final Generation): 只 将精炼后的、高质量的上下文(

distilled_docs)传递给最终的生成 LLM。

核心能力14: 并行多跳检索

并行多跳检索是一种高度复杂的 RAG 架构,它将 RAG 系统从简单的问答工具提升为具备多步骤推理和信息综合能力的 AI 研究助理 。该模式专为解决需要综合多个非关联事实 才能回答的复杂、比较或多步问题而设计。

多跳检索的流程完美模仿了人类专家面对复杂问题时的解决思路:分解、并行探索、最终综合。

-

问题分解 (Decomposition / First Hop):

-

一个高级的元智能体(Meta-Agent) 首先分析复杂的原始查询,并将其分解成 个简单、相互独立的子问题。

-

结构化输出: LLM 被要求以结构化的方式(例如 Pydantic 模型)输出这些子问题列表。

-

-

并行检索与回答 (Parallel Retrieval / Second Hop):

-

利用

ThreadPoolExecutor等并发机制,为每个子问题启动一个独立的 RAG 流程(Retrieval Agent)。 -

每个 Retrieval Agent 专注于回答自己的简单子问题,进行独立的检索(找到其所需的事实 A、事实 B 等)。

-

优势: 确保即使单个检索无法找到所有信息,并行检索也能从知识库的不同角落获取所需的证据。

-

-

最终综合 (Synthesis / Final Hop):

-

元智能体收集所有子问题得到的答案,而不是原始文档。

-

它使用这些高质量的、已回答的子问题作为上下文,执行一个最终的推理和综合步骤,生成对原始复杂查询的全面、有洞察力的回答。

-

原文链接:https://github.com/FareedKhan-dev/agentic-parallelism

THE END !

文章结束,感谢阅读。您的点赞,收藏,评论是我继续更新的动力。大家有推荐的公众号可以评论区留言,共同学习,一起进步。