目录

1.程序功能描述

LSTM网络的性能高度依赖于超参数配置,其中隐含层个数是影响模型性能的关键超参数之一。传统的超参数优化方法如网格搜索、随机搜索存在效率低、易陷入局部最优等问题。跳蛛优化是一种新型元启发式优化算法,模拟跳蛛在捕食过程中的搜索行为,具有收敛速度快、全局搜索能力强等优点。

2.测试软件版本以及运行结果展示

MATLAB2022A/MATLAB2024B版本运行

3.部分程序

。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。

% 将优化得到的最佳参数转换为整数,作为LSTM隐藏层神经元数量

% 加1是为了确保至少有1个神经元

NN=floor(theWorstVct)+1;

% 定义LSTM神经网络结构

layers = [ ...

sequenceInputLayer(indim) % 序列输入层,输入维度为indim

lstmLayer(NN) % LSTM层,神经元数量为优化得到的NN

reluLayer % ReLU激活函数层,增加非线性能力

fullyConnectedLayer(outdim) % 全连接层,输出维度为outdim

regressionLayer]; % 回归层,用于回归任务(输出连续值)

% 设置网络训练参数

options = trainingOptions('adam', ... % 使用Adam优化器,适合深度学习训练

'MaxEpochs', 240, ... % 最大训练轮数为240

'GradientThreshold', 1, ... % 梯度阈值为1,防止梯度爆炸

'InitialLearnRate', 0.004, ... % 初始学习率为0.004

'LearnRateSchedule', 'piecewise', ...% 学习率调度方式为分段衰减

'LearnRateDropPeriod', 60, ... % 每60轮衰减一次学习率

'LearnRateDropFactor',0.2, ... % 学习率衰减因子为0.2(变为原来的20%)

'L2Regularization', 0.01, ... % L2正则化系数为0.01,防止过拟合

'ExecutionEnvironment', 'gpu',... % 使用GPU加速训练(需配置GPU支持)

'Verbose', 0, ... % 不显示训练过程细节

'Plots', 'training-progress'); % 显示训练进度图表(损失变化等)

% 训练LSTM网络

[net,INFO] = trainNetwork(Pxtrain, Txtrain, layers, options);

% 使用训练好的网络进行预测

Dat_yc1 = predict(net, Pxtrain); % 对训练数据进行预测(归一化尺度)

Dat_yc2 = predict(net, Pxtest); % 对测试数据进行预测(归一化尺度)

% 将预测结果反归一化,恢复到原始数据范围

Datn_yc1 = mapminmax('reverse', Dat_yc1, Norm_O);

Datn_yc2 = mapminmax('reverse', Dat_yc2, Norm_O);

% 将细胞数组转换为矩阵(方便后续处理和分析)

Datn_yc1 = cell2mat(Datn_yc1);

Datn_yc2 = cell2mat(Datn_yc2);

% 保存训练信息、预测结果和收敛曲线到MAT文件,便于后续分析

save R2.mat INFO Datn_yc1 Datn_yc2 T_train T_test Convergence_curve

1334.算法理论概述

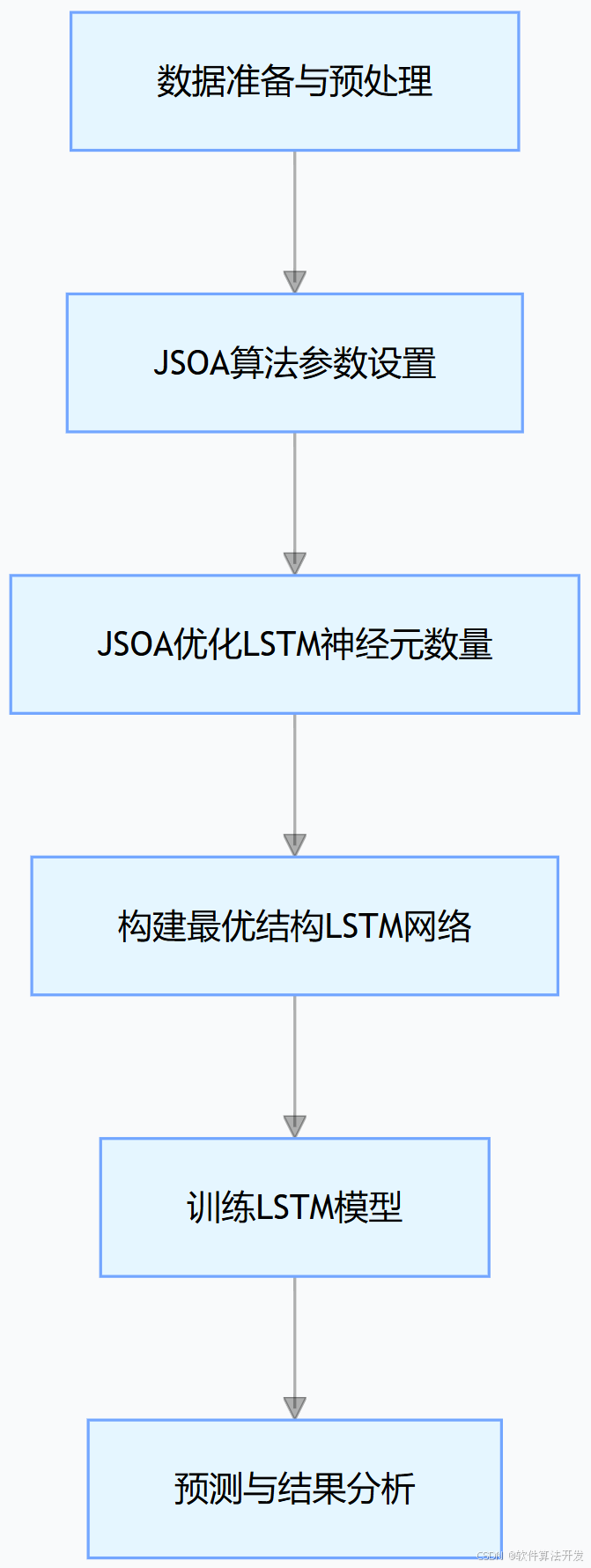

整个程序的原理图如下:

JSOA算法参数设置

定义跳蛛优化的核心参数:

LSTM隐藏层神经元数量的搜索范围(5~40)。

dim=1:优化维度(仅优化神经元数量1个参数)。

Tmax=15:最大迭代次数(算法搜索15轮)。

Npop=10:种群大小(每轮搜索10个候选神经元数量)。

其他参数:重力加速度gravity=9.80665、初始速度vo=100(用于跳蛛的 "捕食" 行为模拟)。

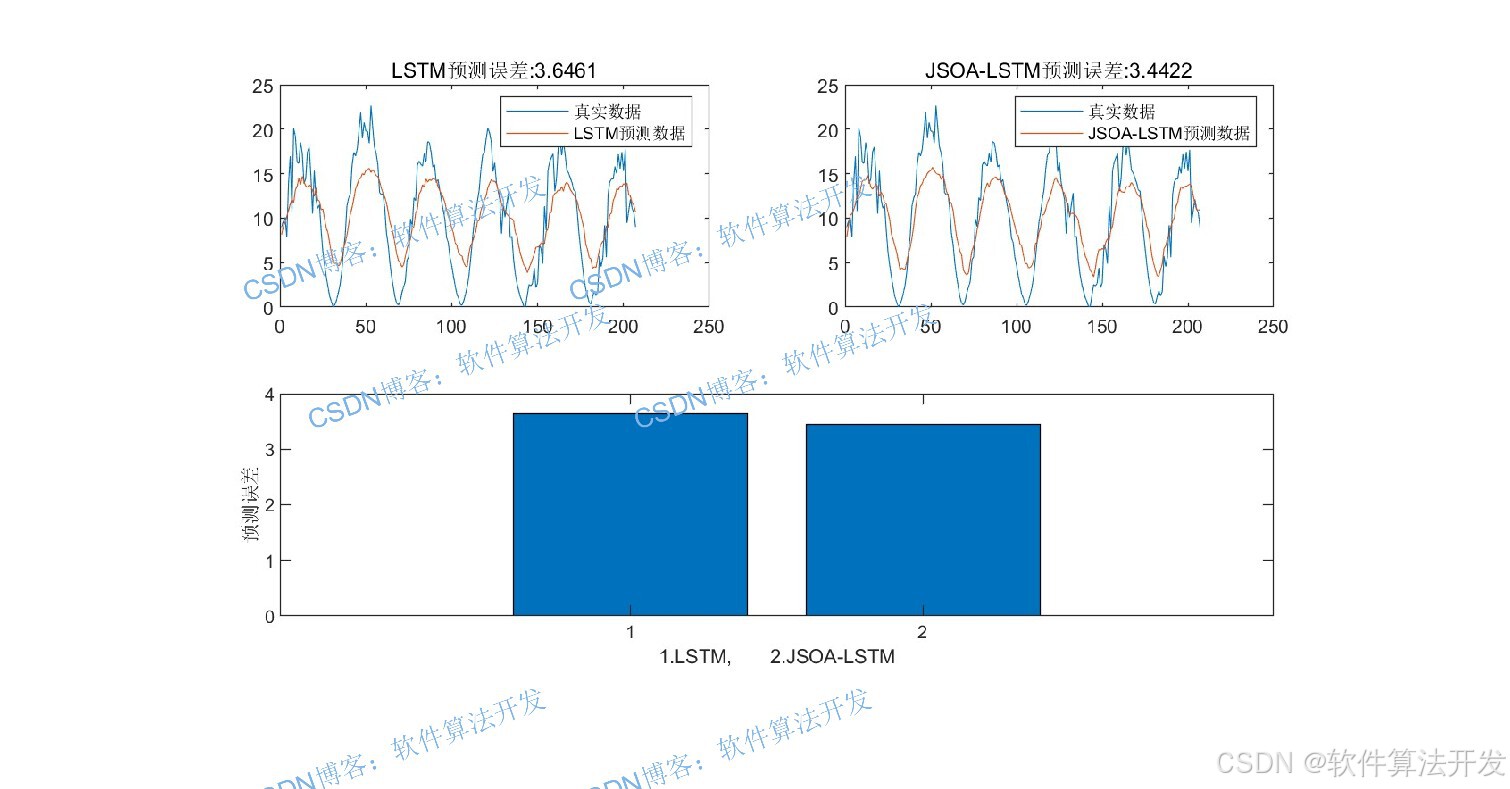

JSOA优化LSTM过程

JSOA算法模拟跳蛛的捕食行为(攻击、追击、跳跃)和搜索行为(全局搜索、局部搜索),以LSTM模型的预测误差(如MSE)为适应度函数,搜索最优神经元数量。每轮迭代中,每个"跳蛛个体"(候选神经元数量)按以下规则更新位置:

1.行为选择(模拟跳蛛捕食 / 搜索):

攻击/追击/跳跃(50%概率):

跳跃(25%概率):基于抛射运动方程更新位置(模拟跳蛛跳跃捕食)。

追击(25%概率):基于匀加速直线运动方程更新位置(模拟跳蛛追击猎物)。

搜索(50%概率):

全局搜索(25%概率):结合最优/最差个体位置和柯西随机数,扩大搜索范围。

局部搜索(25%概率):围绕最优个体位置,用均匀分布随机数微调,精细搜索。

2.信息素更新:

计算每个个体的信息素pheromone(与适应度相关,适应度越好,信息素越高)。

若信息素低于阈值(0.3),触发 "群体协作搜索",结合两个随机个体的位置更新,避免局部最优。

3.边界处理:

确保更新后的位置(神经元数量)在[5,40]范围内。

4.适应度更新:

计算新位置的适应度,若优于旧位置则替换,同时更新全局最优位置theBestVct(最优神经元数量)。

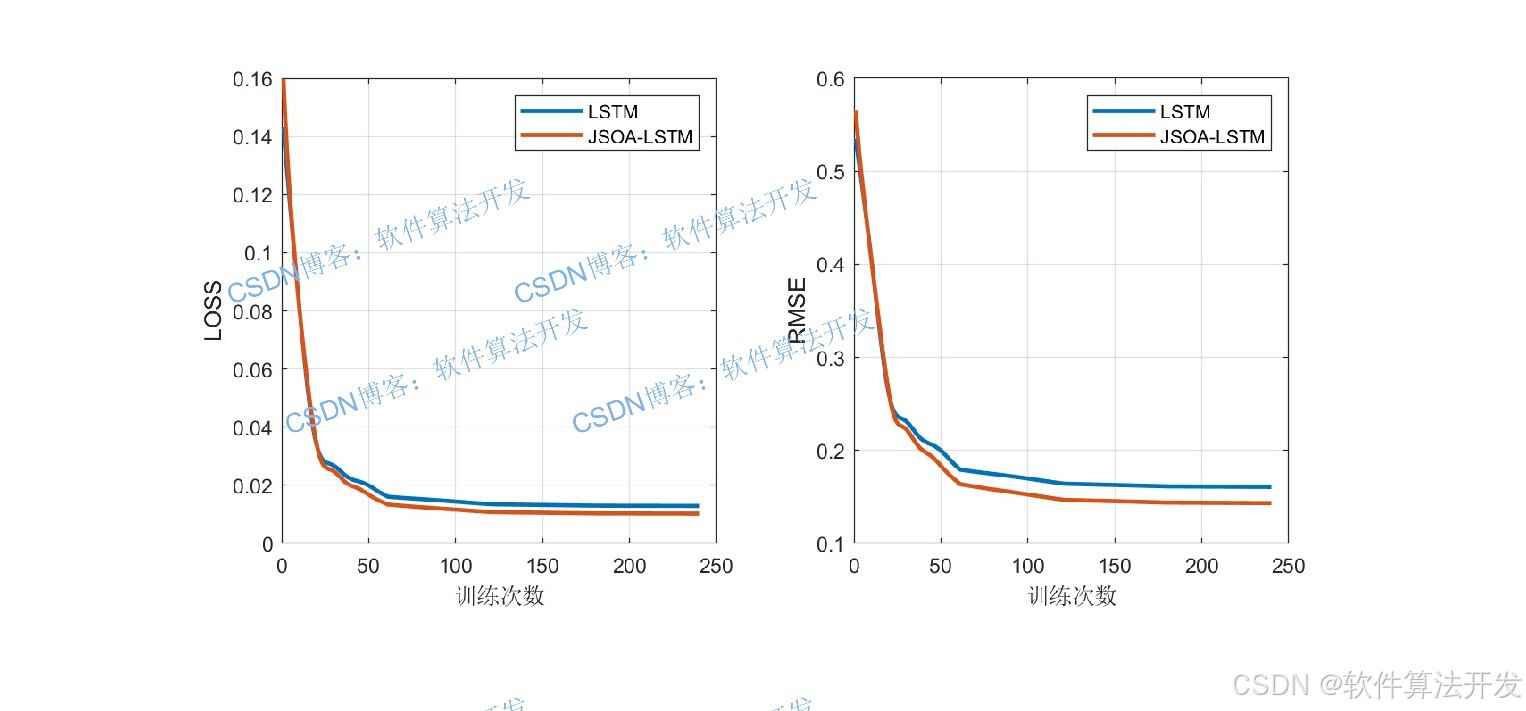

5.训练LSTM模型

设置训练参数并训练网络:

优化器:Adam(深度学习常用,收敛快、稳定性好)。

最大轮数:240(确保网络充分训练)。

梯度阈值:1(防止梯度爆炸)。

学习率调度:分段衰减(每 60 轮学习率 ×0.2,后期精细调整)。

正则化:L2 正则化(系数 0.01,防止过拟合)。

硬件加速:GPU。

训练过程:用Pxtrain(归一化输入)和Txtrain(归一化目标)训练网络,得到训练好的模型net。

5.完整程序

VVV

关注后手机上输入程序码: 126