引言:微服务架构的挑战与Nacos的诞生

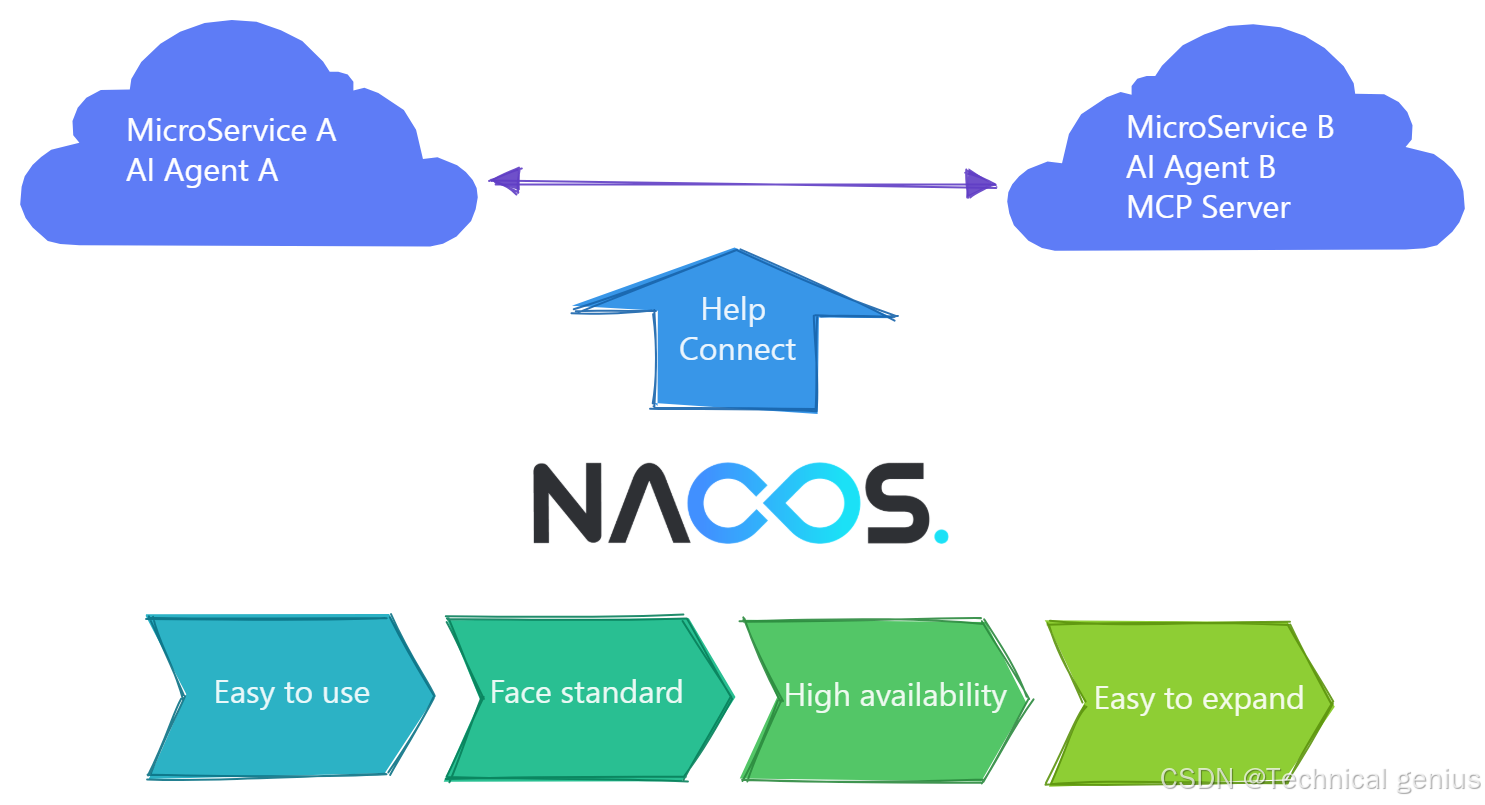

在云计算和容器化技术推动下,微服务架构已成为现代应用开发的主流范式。然而,随着服务数量呈指数级增长,传统服务治理模式面临三大核心挑战:服务发现机制效率低下、配置管理缺乏统一平台、服务健康监测手段单一。阿里巴巴在2018年开源Nacos(Naming and Configuration Service),正是为解决这些痛点而生。作为云原生基础设施的关键组件,Nacos通过服务发现、配置管理、动态DNS三大核心能力,构建起连接微服务生态的"神经系统"。

一:Nacos的核心架构设计

1.1 模块化分层架构

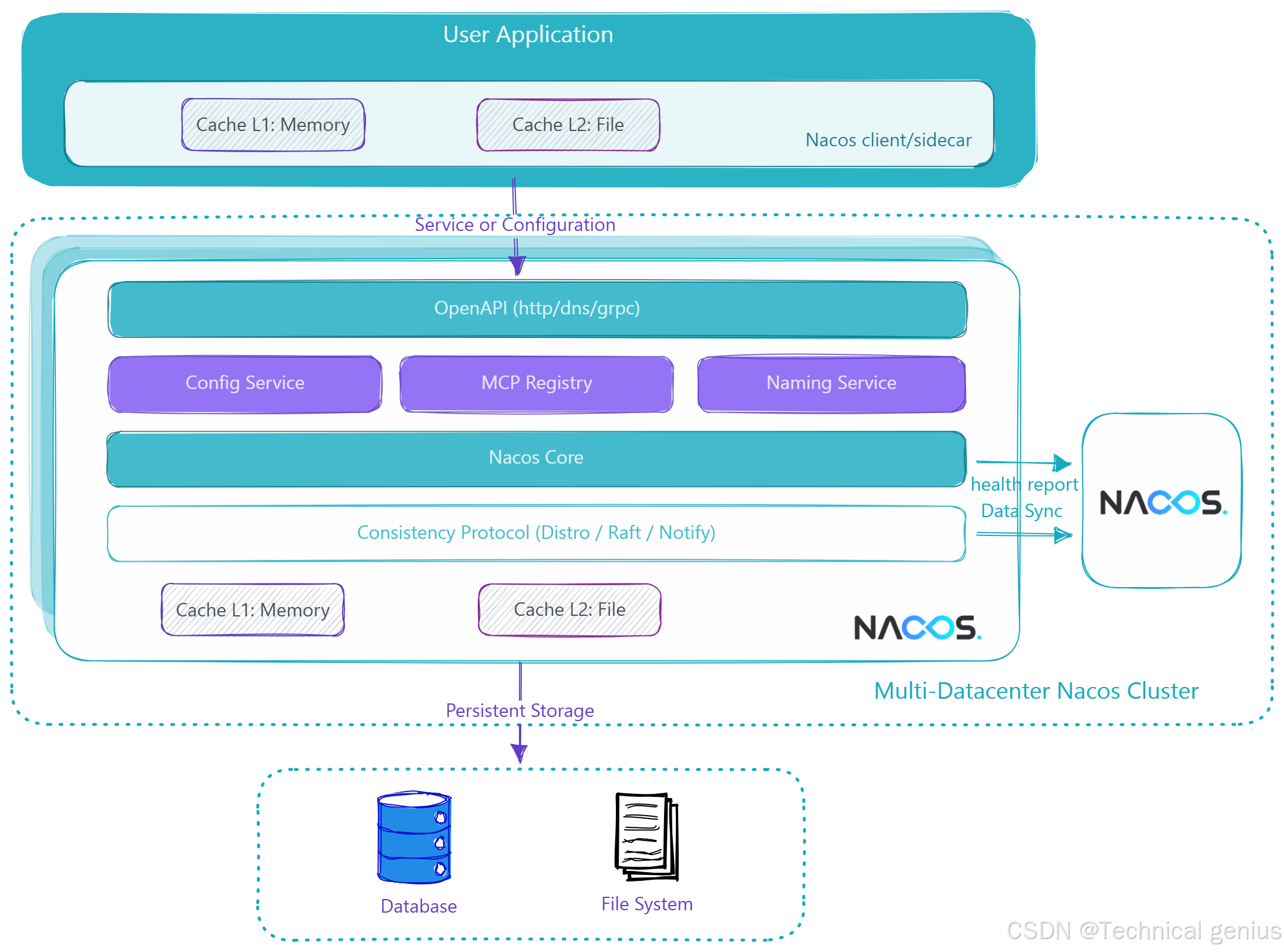

Nacos采用四层架构设计,实现高内聚低耦合:

-

接入层:通过负载均衡器处理客户端请求,支持HTTP/2协议提升传输效率

-

服务层:包含注册中心、配置中心、元数据管理三大核心模块

-

持久化层:支持MySQL、PostgreSQL等关系型数据库,以及嵌入式Derby数据库

-

缓存层:采用多级缓存机制,本地缓存+分布式Redis缓存,确保高并发访问性能

1.2 一致性协议创新

Nacos创造性地提出AP/CP模式动态切换机制:

-

临时实例场景:采用AP模式(最终一致性),通过健康检查实现服务可用性优先

-

持久化实例场景:切换为CP模式(强一致性),确保配置数据的绝对准确

-

元数据同步:基于Raft协议实现跨节点数据同步,保障集群状态一致性^^2^^

1.3 健康检查机制

-

客户端主动上报:服务实例通过心跳包(默认5秒间隔)向Nacos Server上报状态

-

服务端主动探测:对TCP/HTTP接口进行健康检查,支持自定义探测路径

-

异常处理机制:连续3次检查失败触发服务降级,自动从服务列表剔除异常实例

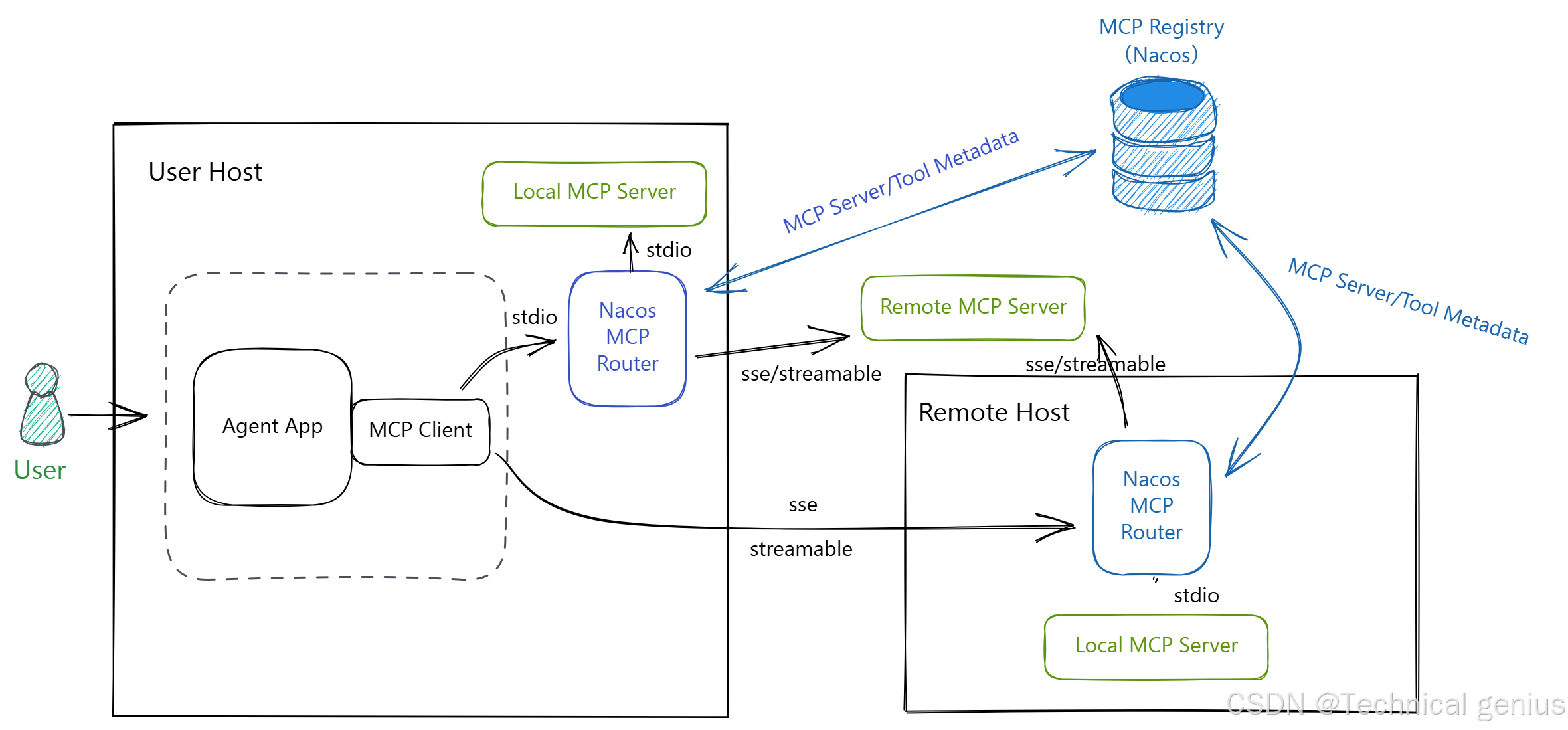

二:服务发现与治理的深度实践

2.1 服务注册全流程解析

-

服务启动阶段:

-

客户端加载Nacos SDK,初始化服务实例信息(IP、端口、元数据等)

-

建立与Nacos Server的长连接,开启心跳线程

-

首次注册时,Nacos Server分配唯一服务ID(格式:{服务名}-{集群名}-${实例ID})

-

-

服务运行阶段:

-

客户端每5秒发送心跳包,更新最后活跃时间戳

-

服务端维护服务实例列表,自动清理30秒未更新的实例

-

支持权重配置(0-100),实现流量按比例分配

-

-

服务下线阶段:

-

客户端主动调用注销接口,Nacos Server立即更新服务状态

-

优雅下线机制:保留实例信息15秒,供新请求完成处理

-

2.2 服务发现的高级特性

-

环境隔离:通过Namespace实现多环境(开发/测试/生产)隔离

-

集群路由:支持基于权重的蓝绿部署、金丝雀发布等流量管理策略

-

元数据扩展:自定义标签(如版本号、区域信息)支持精细化路由

-

DNS发现:将服务名解析为域名,兼容传统DNS查询方式

2.3 服务治理的最佳实践

-

熔断降级:集成Hystrix/Sentinel,根据服务健康状态自动熔断

-

流量控制:通过权重调整实现A/B测试,逐步切换流量

-

服务网格集成:与Istio/Linkerd配合,实现透明流量劫持

-

多语言支持:提供Java、Go、Python等主流语言的SDK

三:配置管理的技术实现

3.1 配置发布与订阅机制

-

配置发布流程:

-

客户端通过Restful API提交配置变更请求

-

Nacos Server执行合法性校验(如JSON格式验证)

-

配置持久化到数据库,并触发版本号递增

-

将变更通知推送给所有订阅该配置的客户端

-

-

配置订阅实现:

-

客户端建立长连接,监听配置变更事件

-

采用增量更新机制,仅传输变更部分

-

支持本地缓存配置,断网时仍可使用旧配置

-

3.2 配置版本控制与回滚

-

版本链管理:每个配置变更生成唯一版本号,支持历史版本查询

-

灰度发布:通过环境变量控制配置生效范围,逐步扩大发布

-

回滚机制:一键回滚到指定版本,自动修复异常配置

3.3 配置安全策略

-

权限控制:基于角色的访问控制(RBAC),支持读/写权限分离

-

数据加密:支持AES-256加密存储敏感配置

-

审计日志:记录所有配置变更操作,满足合规要求

四:Nacos的高可用与性能优化

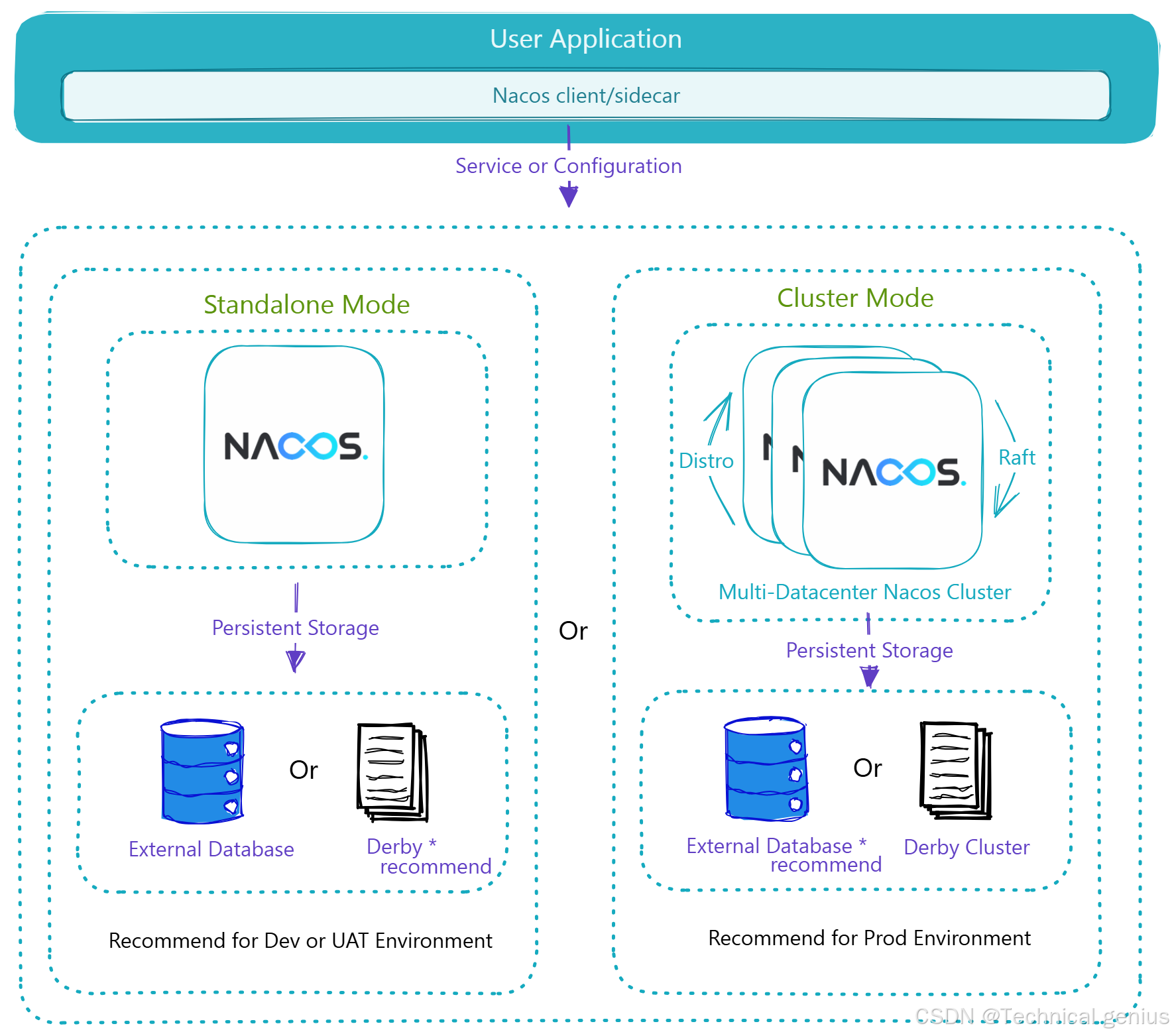

4.1 集群部署架构

-

主备模式:单节点部署,适合测试环境

-

集群模式:3节点起部署,采用Raft协议保证数据一致性

-

多数据中心:通过同步复制实现跨地域容灾

4.2 性能调优实践

-

JVM参数优化:

-

堆内存设置:根据数据量调整-Xms和-Xmx(建议4G起步)

-

GC策略:使用G1垃圾收集器,设置最大停顿时间目标

-

-

数据库优化:

-

索引优化:为服务名、集群名等高频查询字段建立复合索引

-

分表策略:按Namespace分表,控制单表数据量在百万级以下

-

-

网络优化:

-

客户端连接池:设置合理的最大连接数(建议50-100)

-

心跳间隔:根据网络状况调整(默认5秒,可缩短至3秒)

-

4.3 监控与告警体系

-

核心指标监控:

-

服务注册成功率

-

配置变更延迟

-

客户端连接数

-

数据库查询耗时

-

-

告警阈值设置:

-

服务注册失败率超过5%触发告警

-

配置变更延迟超过1秒触发告警

-

客户端连接数超过阈值触发扩容建议

-

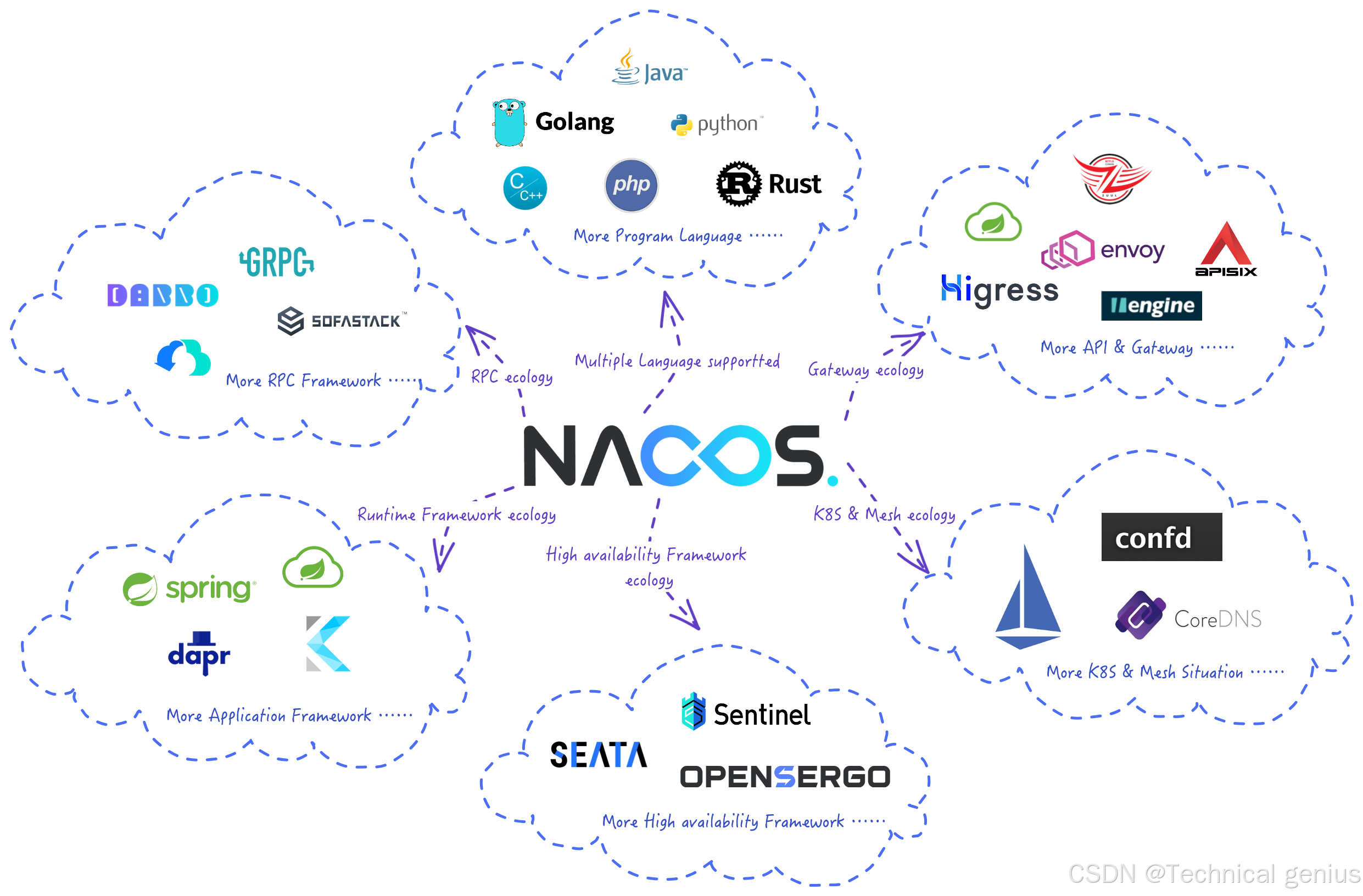

五:Nacos的生态集成与扩展

5.1 与Spring Cloud的深度集成

-

服务发现集成:

-

通过spring-cloud-starter-alibaba-nacos-discovery实现自动注册

-

支持@LoadBalanced注解的RestTemplate实现客户端负载均衡

-

-

配置管理集成:

-

使用spring-cloud-starter-alibaba-nacos-config实现动态配置

-

支持bootstrap.yml中的多环境配置(spring.profiles.active)

-

-

健康检查集成:

-

与Actuator配合,提供/health端点监控服务状态

-

支持自定义健康检查规则

-

5.2 与Kubernetes的协同

-

服务发现对接:

-

通过Nacos-K8s Operator实现服务自动注册

-

支持Kubernetes Service的DNS解析

-

-

配置管理对接:

-

将ConfigMap映射为Nacos配置

-

支持Secret的自动加密存储

-

5.3 自定义扩展开发

-

SPI扩展机制:

-

实现Nacos的SPI接口,扩展认证方式

-

支持自定义健康检查逻辑

-

-

插件开发:

-

开发配置加密插件,集成国密算法

-

创建服务治理插件,实现自定义路由规则

-

六:生产环境中的挑战与解决方案

6.1 大规模集群的性能瓶颈

-

问题现象:万级服务实例时,服务发现延迟增加

-

解决方案:

-

采用分片策略,按Namespace划分数据存储

-

引入本地缓存,减少数据库查询

-

优化Raft日志复制机制,提升选举效率

-

6.2 配置变更的雪崩效应

-

问题现象:高频配置变更导致客户端频繁重启

-

解决方案:

-

实现配置变更批处理,合并多次变更

-

添加变更频率限制,防止恶意攻击

-

支持配置变更的灰度发布

-

6.3 多语言客户端的兼容性问题

-

问题现象:不同语言SDK实现差异导致行为不一致

-

解决方案:

-

制定统一的客户端API规范

-

建立跨语言测试套件

-

提供兼容性检查工具

-

七:未来演进方向

7.1 服务网格深度集成

-

与Istio的深度融合,实现透明流量管理

-

支持mTLS双向认证,增强服务间通信安全

7.2 智能化治理能力

-

基于机器学习的流量预测,自动调整权重

-

异常检测与自愈能力,实现故障自动恢复

7.3 边缘计算支持

-

轻量级Nacos Edge版本,适应边缘节点部署

-

支持离线模式,在网络中断时保持基本功能

结语:Nacos的生态价值

作为云原生时代的"服务连接器",Nacos不仅解决了微服务架构的核心痛点,更通过开放的设计理念和强大的扩展能力,构建起连接开发、测试、运维全流程的桥梁。从阿里巴巴内部到开源社区,Nacos已成长为支撑百万级服务规模的基础设施,其设计思想和技术实现,为构建弹性、可靠的云原生应用提供了重要参考。随着云原生技术的持续演进,Nacos必将在服务治理领域发挥更加关键的作用。