目录

[一、 理想主义的蓝图:当Google试图用算法定义"优质"信息](#一、 理想主义的蓝图:当Google试图用算法定义“优质”信息)

[二、 表象的成功与本质的回避:当"优质"成为一个黑箱](#二、 表象的成功与本质的回避:当“优质”成为一个黑箱)

[三、 从算法治理到"人类评估":一场注定失败的"打地鼠"游戏](#三、 从算法治理到“人类评估”:一场注定失败的“打地鼠”游戏)

[四、 反思与出路:超越解决方案主义,拥抱负责任的创新](#四、 反思与出路:超越解决方案主义,拥抱负责任的创新)

你是否曾有这样的经历?一个复杂的团队协作问题,最终被简化成选择哪款协同办公软件;一个深层次的产品设计争议,被寄希望于一次用户A/B测试来裁决;一个棘手的商业伦理困境,期待通过一套"不作恶"的算法准则来规避。

在技术驱动的世界里,我们有一种强大的冲动:将错综复杂、充满人性纠葛的现实问题,重构为清晰、可定义、并且最关键的------可通过技术方案解决 的"技术问题"。这种思维模式,称之为 "技术解决方案主义"。它诱人而危险,它承诺效率与清明,却往往掩盖了问题的本质,甚至在我们试图"修复"的过程中,制造出新的、更棘手的难题。

让我们以科技巨头Google 在其核心业务------搜索引擎的公正性与内容治理------领域所进行的一系列探索为例,深入剖析技术解决方案主义的运作逻辑、内在局限及其潜在危害。

一、 理想主义的蓝图:当Google试图用算法定义"优质"信息

2018年,Google推出了其搜索算法的重大更新之一,名为 "BERT"。BERT是一种基于Transformer架构的自然语言处理模型,其核心突破在于能更好地理解词语在句子中的上下文语境,从而更精准地解读用户的搜索意图。

技术目标:减少对简单关键词的匹配依赖,提升对复杂、口语化、长尾搜索查询的理解能力,最终为用户提供"更相关、更优质"的搜索结果。

解决方案主义愿景:信息质量的问题,可以被转化为一个自然语言理解问题。通过投入更强大的计算资源、更先进的神经网络模型,我们可以训练出一个"超级大脑",它不仅能理解字面意思,更能洞察语义的微妙差别,从而像一位全知全能的图书馆员,总是能从信息的海洋中捞出最璀璨的珍珠。

从纯技术角度看,BERT是成功的。Google宣称,BERT影响了几乎所有英语搜索查询,并且在理解"to"、"for"等介词如何完全改变句子含义方面表现出色。例如,对于搜索"2019 brazil traveler to usa need a visa",BERT能理解用户是巴西人想去美国,而不是反过来,从而提供更相关的结果。

架构简图:BERT在搜索中的工作流程

用户搜索查询 (自然语言)

↓

[查询处理与分词]

↓

[BERT模型语境化编码] ---> 理解"to USA"与"from USA"的本质区别

↓

[与索引网页的语义匹配] ---> 不再仅仅是关键词"Brazil"、"traveler"、"USA"、"visa"的匹配

↓

[相关性重排序]

↓

返回"更优质"的搜索结果代码层面,BERT的核心是Self-Attention机制,它允许模型在处理一个单词时,关注到句子中所有其他单词的重要性。以下是一段极度简化的伪代码,用于说明Attention的计算思想:

python

# 伪代码:简化的Self-Attention计算逻辑

def self_attention(query, key, value):

# 1. 计算注意力分数:查询(query)和键(key)的相似度

attention_scores = dot_product(query, key.transpose())

# 2. 应用缩放和Softmax归一化,得到注意力权重

attention_weights = softmax(attention_scores / sqrt(key_dim))

# 3. 将权重应用于值(value),得到加权的上下文向量

context_vector = dot_product(attention_weights, value)

return context_vector

# 在BERT中,输入的句子中的每个词都会生成自己的Q, K, V向量,

# 通过上述计算,每个词都能获得一个融合了句子中所有其他词信息的新表示。正是这种技术上的巨大成功,掩盖了解决方案主义的第一个陷阱。

二、 表象的成功与本质的回避:当"优质"成为一个黑箱

BERT模型的确提供了更"相关"的结果。但"相关"和"优质"能划等号吗?技术解决方案主义在此完成了一次巧妙的"偷换概念"。

1."优质"的定义权被让渡给算法 :什么是优质信息?是权威媒体发布的、事实核查严谨的长文?还是互动量极高、通俗易懂的短视频?是观点平衡、四平八稳的综述?还是立场鲜明、引发深度思考的评论?Google的算法团队必须将这些模糊的社会价值判断,转化为可量化的、可供模型优化的工程指标。这些指标可能包括:页面的停留时长、点击率、二次点击率、被权威网站引用的次数、用户的直接满意度反馈等。

2.优化指标而非优化本质 :一旦"优质"被操作化定义为"高点击率+高停留时长+高权威引用",算法的优化目标就变得非常清晰:最大化这些指标的预测值。结果就是,算法可能会倾向于推荐那些"吸引人点击且能让人停留"的内容,而这恰恰是煽动性标题、情绪化表达、阴谋论或简单化叙事的温床。因为复杂、深刻、需要耐心咀嚼的内容,其数据指标可能反而不如前者。

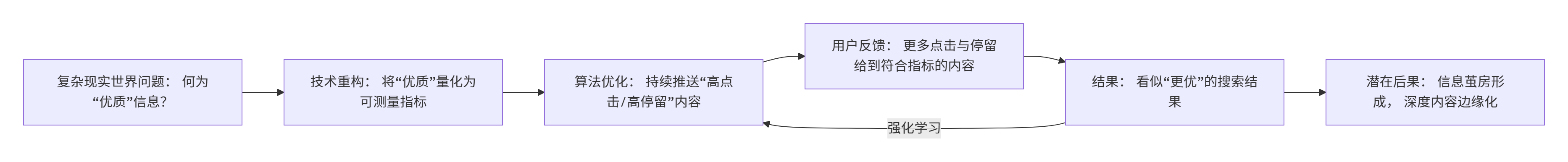

流程图:算法"优质"信息筛选的潜在偏差循环

我们看到了一个悖论:一个旨在提升信息质量的技术方案,由于其内在的简化逻辑,可能反而助长了信息生态的某些浮躁倾向。它解决了"理解查询意图"这个技术问题,却无力应对,甚至可能加剧了"公共领域信息质量下滑"这个社会性问题。

三、 从算法治理到"人类评估":一场注定失败的"打地鼠"游戏

Google显然意识到了单纯算法的不足。为了应对虚假信息、仇恨言论、低质量内容,它建立了一套复杂的内容政策,并辅以**"质量评估员"** 体系。

解决方案:雇佣全球成千上万的评估员,按照一套详细的《搜索质量评估指南》(这本指南本身长达数百页),对搜索结果进行人工评分。这些评分数据并不直接改变特定网站的排名,而是作为"地面实况",用于训练和评估搜索算法的好坏。

解决方案主义的再次升级:既然纯算法有偏差,我们就引入"人类智能"。我们将内容治理这个需要深刻社会共识、法律界定、文化敏感度的难题,拆解为成千上万个可以被评估员依据指南判断的"微观任务"。

流程与架构图:Google搜索质量评估系统

python

+-----------------------+

| 《搜索质量评估指南》 | (定义"E-A-T":专业性、权威性、可信度)

+-------------+---------+

|

v

+----------------+ +------------v-------+ +--------------------------------+

| 搜索查询 & 结果页| --> | 质量评估员 (全球) | --> | 人工评分 (如: 低质/中质/高质量) |

+----------------+ +------------+-------+ +----------+---------------------+

| |

v v

+------------v---------+ +-----------------------+

| 算法训练与评估反馈回路 | <-- | 算法排名模型 |

+----------------------+ +-----------------------+这看起来更完善了,对吗?但陷阱更深了:

1.指南的无限膨胀与内在矛盾:为了应对无穷无尽的内容边界案例,《评估指南》不得不变得越来越复杂、越来越具体。如何界定"误导"与"观点不同"?如何判断一个非主流医学网站是"前沿探索"还是"伪科学"?指南试图通过规则来固化判断,但现实总是能产生规则无法覆盖的例外。评估员成了流水线上的判官,遵循的是僵化的条款,而非流动的社会共识。

2.规模化与一致性的不可能三角 :要处理全球海量信息,评估必须规模化。但成千上万的评估员,拥有不同的文化背景、知识结构和主观判断,如何保证评估的一致性?最终,系统倾向于鼓励"安全"的判断,避免争议。这可能导致算法被训练得过度保守,使得一些边缘但有价值的声音更难被看见。

3.核心矛盾的转移而非解决 :内容治理中最根本的"谁有权力定义善恶对错"的政治问题,被巧妙地转化为一个"如何提升评估指南准确性和评估员工作效率"的工程管理问题。我们不再争论"什么是真理",而是争论"这条指南是否应该修订为第3.2.5.C条"。

Google的实践表明,即使在算法之上叠加了庞大的人力评估系统,我们依然像是在玩一场永无止境的"打地鼠"游戏。一个新的内容滥用模式出现,我们紧急修订指南、调整算法;然后,新的模式又会在别处冒出来。解决方案主义者忙于制造更精密的地鼠锤,却很少反思这个游戏本身是否是我们真正想参与的。

四、 反思与出路:超越解决方案主义,拥抱负责任的创新

Google的案例并非个例,它只是技术解决方案主义在当今时代最集中的体现。从试图用社交网络"修复"民主政治,到用大数据预测犯罪,其背后的逻辑一脉相承。我们迷恋于技术的威力,却低估了社会问题的复杂性、历史性和价值负载性。

那么,我们该如何超越技术解决方案主义?

1.从"解决问题"到"界定问题":在启动任何技术方案前,必须进行深刻的"问题考古"。我们面对的究竟是一个技术问题,还是一个社会、经济、政治或伦理问题?强行将后者技术化,是灾难的开端。对于搜索引擎,首要问题或许不是"如何排名更优",而是"我们期望一个怎样的公共信息环境",以及"搜索引擎在这个环境中应扮演何种角色"。

2.拥抱透明与谦逊,放弃"终极算法"的幻想:必须公开承认算法的局限性和内在偏见。Google可以更透明地公开其排名原则的主要考量因素(而非核心机密),并建立更有效的公众质疑和申诉渠道。技术专家需要从"解决方案提供者"的神坛上走下来,成为与伦理学家、社会学家、法律专家以及公众合作的"协作者"。

3.设计为"对话"而非"判决"的技术:技术系统不应被设计成发布最终判决的"黑箱",而应成为促进人类批判性思考和公共对话的"白箱"或"灰箱"。例如,搜索引擎是否可以提供"为何显示此结果"的简要解释?是否可以允许用户在一定范围内自定义排序的权重(如更看重时效性还是权威性)?这将技术重新定位为辅助工具,而非终极权威。

4.建立多方治理与问责机制:像搜索引擎这样具有公共基础设施属性的技术系统,其治理不能完全由私营公司关起门来决定。需要探索建立包括政府、学界、公民社会代表在内的多方治理模式,对平台的核心规则和重大决策进行监督与审议。

结论

技术解决方案主义是一种诱人的思维捷径,它许诺用清晰的代码取代人性的混沌。但正如我们在Google搜索的案例中看到的,当我们将定义"优质信息"这类深刻的价值判断问题,草率地托付给算法优化和人工评估流水线时,我们非但没有解决问题,反而可能制造了新的、更系统性的偏见和僵化。

技术的真正力量,不在于它能否为我们提供一个一劳永逸的"解决方案",而在于它能否帮助我们更好地理解 问题的复杂性,促进 更广泛的对话与协商,以及增强我们作为人类共同应对挑战的能力。下一次,当你听到又一个用某种技术"修复"某个宏大社会问题的炫目宣言时,不妨多一分警惕:这究竟是通往未来的灯塔,还是另一个技术解决方案主义精心包装的海市蜃楼?

放弃"解决一切"的幻想,或许才是我们利用技术创造更美好世界的真正起点。