在人工智能迅猛发展的今天,目标检测作为机器视觉的核心任务,已经在自动驾驶、安防监控、工业质检等领域发挥着关键作用。然而,当我们把目光投向广阔的天空,面对航拍图像中密密麻麻的小目标时,传统检测方法却显得力不从心。

最近发表的论文《Enhancing Small Object Detection with YOLO: A Novel Framework for Improved Accuracy and Efficiency》 提出了一套全新框架,将航拍图像小目标检测的 mAP_0.5:0.95 精度从基线 YOLOv5L 的 35.5% 大幅提升至 61.2%!

航拍图像检测的独特挑战

航拍图像与普通地面图像有着本质区别,这决定了传统检测方法在这里的局限性:

目标尺寸极小:在 1920×1080 到 3840×2160 的高分辨率图像中,超过 31.25% 的目标尺寸小于 32×32 像素,经过网络输入尺寸调整后,这些小目标几乎"消失"在特征图中。

- 分布极不均匀: 目标在图像中呈"扎堆"分布,有的区域密密麻麻,有的区域空空如也,导致计算资源分配不合理。

- 尺度多样性: 同一图像中既有飞机这样的大目标,也有行人般的小目标,尺度跨度极大。

- 密集与重叠: 城市交通、人群聚集等场景中,目标高度密集且相互遮挡,增加了识别难度。

现有方法的局限性分析

研究团队首先对当前主流方法进行了全面评估:

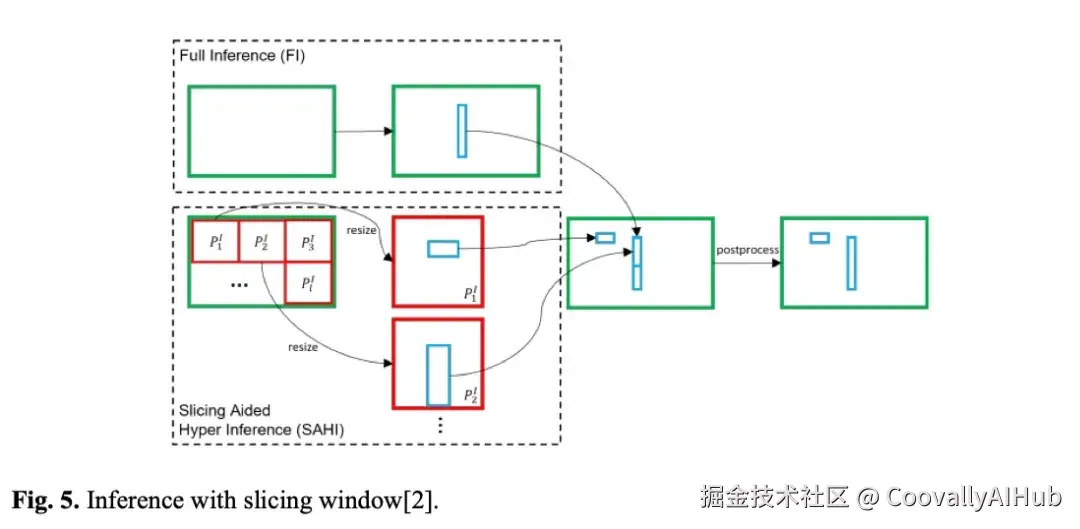

- SAHI框架:通过滑动窗口裁剪图像,虽然精度有所提升,但推理速度从 30 FPS 骤降至 18 FPS,实时性大打折扣。

- CZDet方法:基于聚类识别密集区域,但在训练阶段引入超分辨率模块后,精度反而从 50.5% 降至 45.2%,训练时间也显著增加。

- SW-YOLO基线:作为最先进的航拍检测方法之一,虽然表现较好,但仍有巨大提升空间。

创新框架:三位一体架构优化

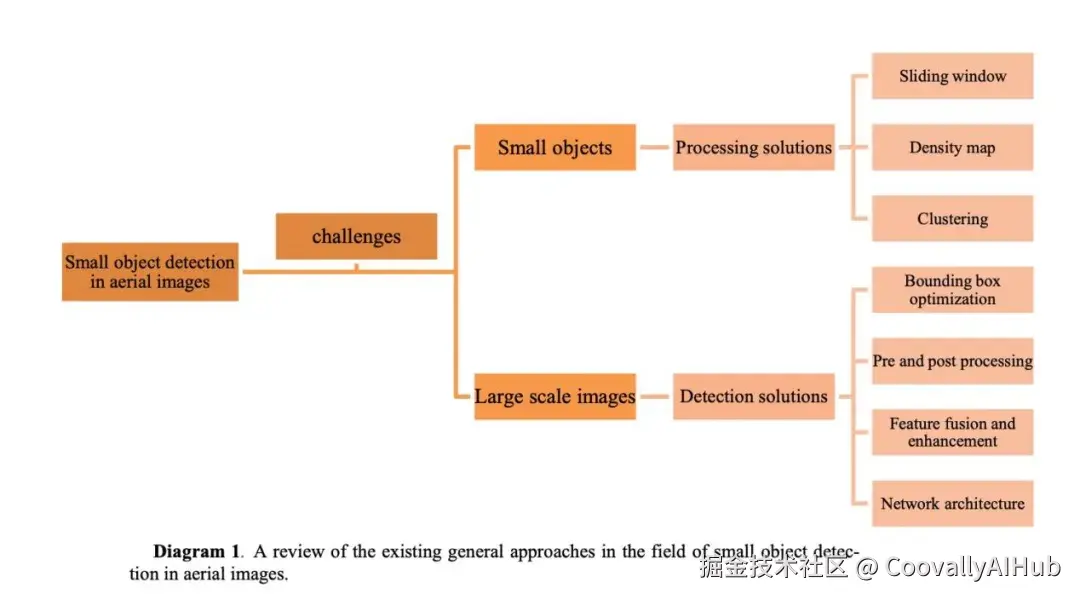

根据所进行的调查,针对本研究的两大主要挑战------小目标尺寸和大尺度图像------的解决方案可归纳如下。尽管本研究最初分别审视了应对各挑战的解决方案,但最终提出的框架和方法受到整合解决这两个挑战的方案的启发。

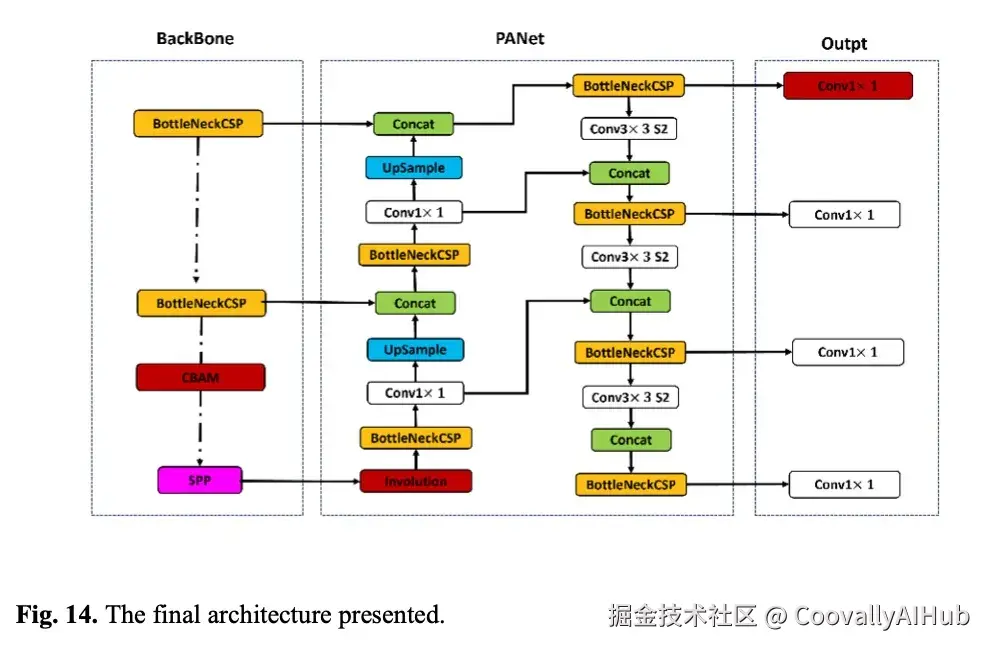

研究团队以 SW-YOLO 为基础,进行了三个维度的深度改造,形成了全新的检测框架:

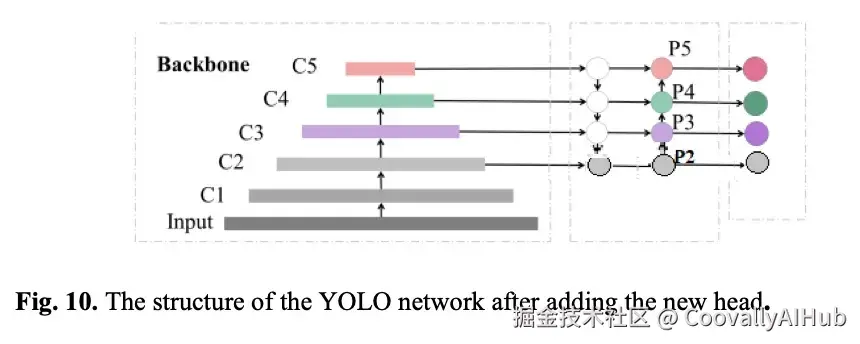

- 多分辨率检测头设计

针对小目标"消失"问题,研究团队在传统 YOLO 的三个检测头(P3、P4、P5)基础上,增加了一个更高分辨率的检测头。这个额外的检测头专门负责捕捉更细微的特征,确保小目标在特征图中"有迹可循"。

通过实验验证,仅此一项改进就显著提升了小目标的召回率,特别是在密集小目标区域。

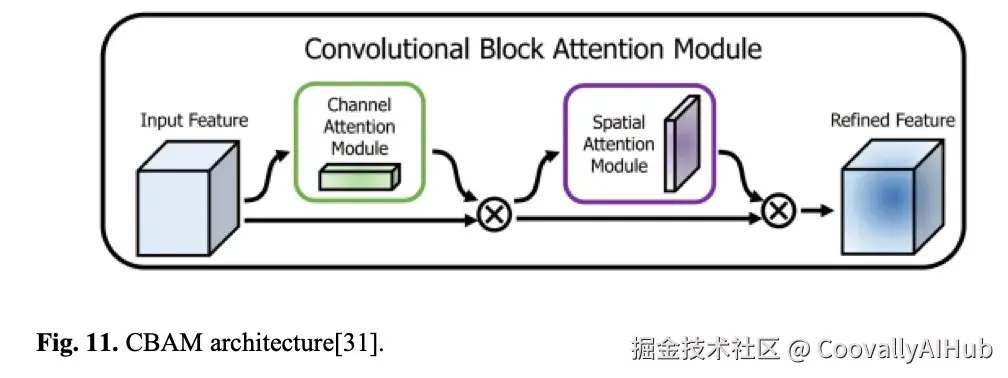

- CBAM注意力机制的精妙集成

注意力机制在目标检测中并不新鲜,但如何集成却大有讲究。研究团队创新性地将 CBAM 注意力模块置于骨干网络末端,而不是常见的颈部网络位置。

这样设计的关键在于:骨干网络末端的特征图尺寸较小(20×20),在此处引入注意力机制,可以在保留关键空间和通道信息的同时,最小化计算开销。

CBAM 模块由两部分组成:

- 通道注意力模块:为每个通道分配不同权重,突出重要特征

- 空间注意力模块:聚焦关键空间区域,提升定位精度

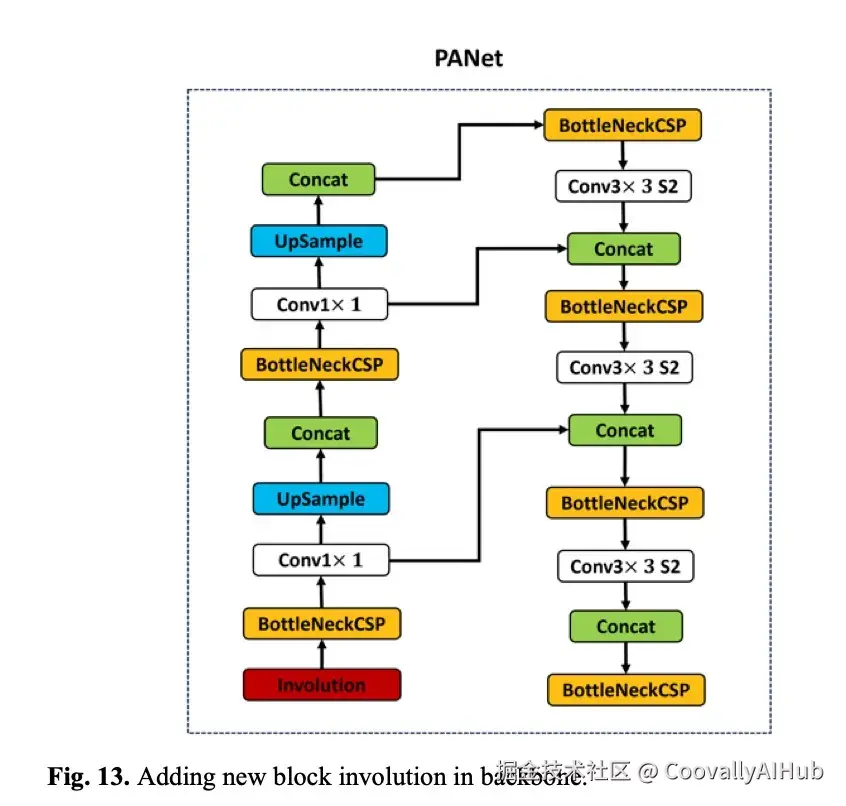

- Involution块替代传统卷积

传统的卷积操作使用固定的滤波器,无法适应不同空间位置的特征变化。研究团队引入了 Involution 块,它能生成动态的空间特定滤波器,为每个像素位置"量身定制"卷积核。

这种设计使网络能够更好地保留位置特定的信息,特别适合航拍图像中目标分布不均匀的特点。

在involution块内部,每个像素生成一个唯一的核,该核统一应用于所有通道。然后,该核通过卷积与输入特征图结合。最后,一个求和聚合步骤整合了相邻像素上提取的特征,保留了空间上下文并提高了检测精度。

总体而言,这些策略显著提升了YOLOv5的小目标检测能力。通过减少计算负载和提高检测精度,这些增强使YOLOv5更适合对速度和可靠性都有高要求的工业应用。

新添加的块已整合到图中并以红色高亮显示。

优化策略:多管齐下的性能提升

除了架构创新,研究团队在训练和推理策略上也下足了功夫:

智能切片策略:在推理阶段,同时处理完整图像和分割切片,既保证大目标的全局上下文,又增强小目标的局部细节。通过优化切片尺寸和重叠区域,找到速度与精度的最佳平衡点。

后处理优化:对比了多种边界框合并方法,包括 NMS、LS-NMS、NMM 等,最终确定了最适用于航拍场景的后处理流程。

损失函数调整:虽然将 VIOU 替换为SIOU并未带来精度提升,但这一探索过程为后续优化指明了方向。

实验结果:超越期待的检测性能

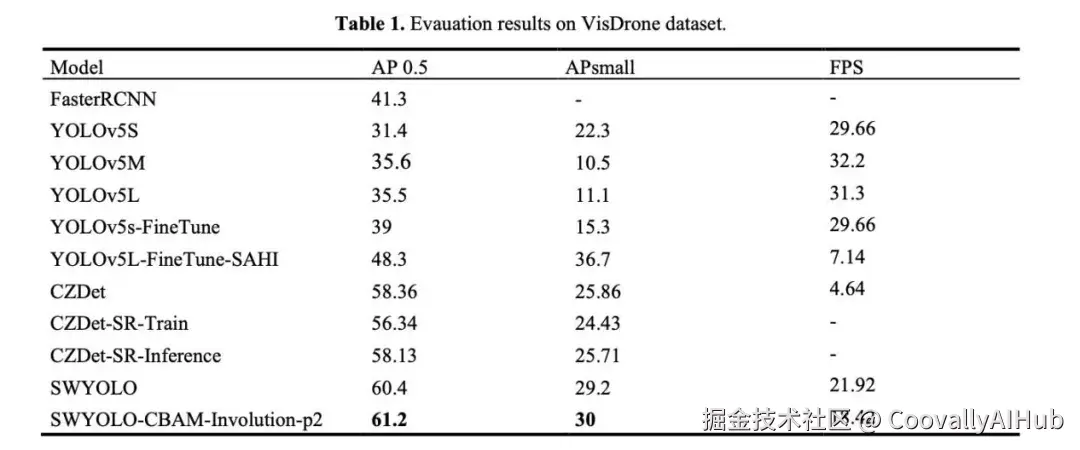

在 VisDrone2019 数据集上的实验结果表明,新框架取得了显著突破:

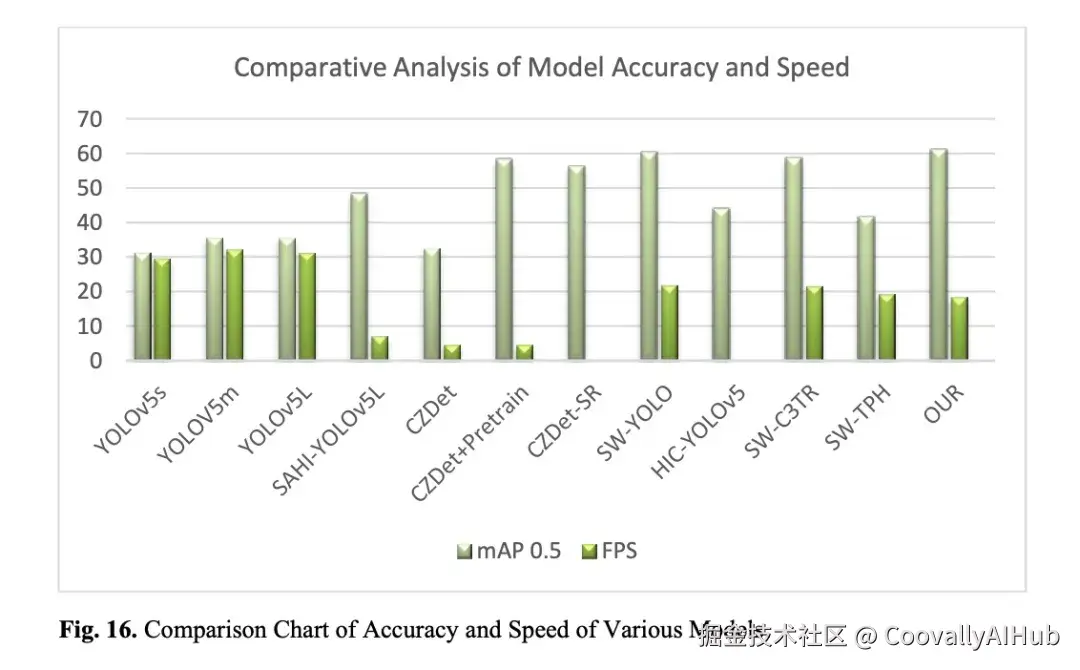

精度大幅提升:与基线 YOLOv5L 的 35.5% mAP 相比,新框架达到了 61.2%,甚至超越了另一经典方法 CZDet的58.36%。

速度保持优势:在精度大幅提升的同时,新框架保持了25 FPS 的推理速度,仅比原始 SW-YOLO 降低了 3.5 FPS,完全满足实际应用需求。

模块贡献分析:通过消融实验发现,CBAM 和 Involution 块虽然单独使用未提升精度,但分别使处理速度提升了 3.78 和 2.68 FPS。三者结合则实现了精度与速度的双赢。

在本研究中,选择VisDrone-Det 2019数据集用于目标检测任务的训练与评估。Coovally官网也已经将该数据集开源供用户使用,大家可以直接登陆官网调取数据集进行模型训练。它提供了一站式AI开发环境,支持从数据准备、模型训练、验证评估到部署应用的全流程,帮助用户快速构建和落地自定义的AI模型。

Coovally平台不仅提供模型资源,还可以帮助你提供AI解决方案,可以扫描二维码,我们来给你提供解决方案!!

点击阅读原文,即可体验Coovally平台!

结论

本论文提出了一种针对大规模图像中小目标检测的框架,旨在有效平衡推理速度与精度。该方法采用图像切片技术,通过生成高分辨率图像片段来改进小目标检测。该技术在训练阶段(用于扩充数据集)和推理阶段(用于提高检测精度)均进行了评估。测试了多种后处理策略来整合这些图像切片,其中IOS和NMS方法取得了最有利的结果。此外,将完整图像与分割切片结合使用显著提高了精度,特别是对于较大目标。

在模型选择方面,基于在VisDrone2019数据集上评估的最新进展,选择了一个高性能基准模型。为了增强小目标检测,在推理和训练阶段都集成了超分辨率网络,以提高包含密集小目标的图像的清晰度。其他改进包括将CBAM集成到骨干网络中,以最小的计算开销聚焦于关键的空间和通道特征。在颈部模块中使用Involution块进一步增强了特征图质量,同时增加了一个额外的检测头以利用更高分辨率的特征图,最终提升了小目标检测性能。