一、PTQ 模型量化问题

1.1、模型问题

基于公版模型训练,没有对模型做范围做约束,weight_decay=1e-6, 训练出的 float 模型数值分布很大,如图 2,可以看到模型的后面几层数据分布范围很广,最大阈值超过了 8000,对我们量化来说并不友好。

1.2、算子问题

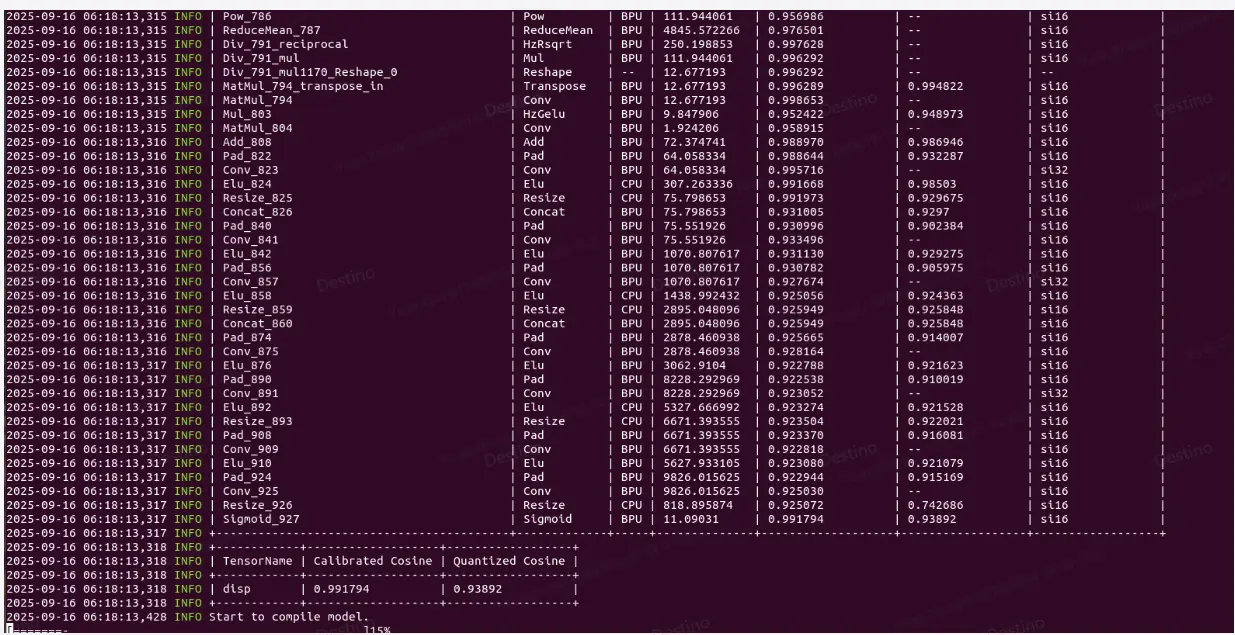

如图 2,基于全 int16 算子配置量化,当前版本 resize 算子有约束(请查阅工具链算子支持情况),只能支持 int8 量化,即使配置了 int16,但算子依旧退化到 int8,因此算子的 cosine 相似度也比较低,基于此阈值,max_qscale=6653/127=52.385,此 scale 过于大,并不能精细化量化模型,所以全 BPU 算子的整体精度都不高。

图 1 公版训练 float 模型

二、精度优化

2.1、cpu 高精度定位

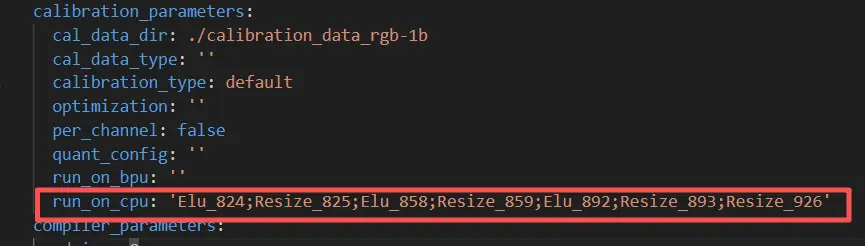

resize 算子有限制,但对于回退 cpu 算子,就能实现 float 精度推理,配置如图 2,

图 2 配置 cpu 算子

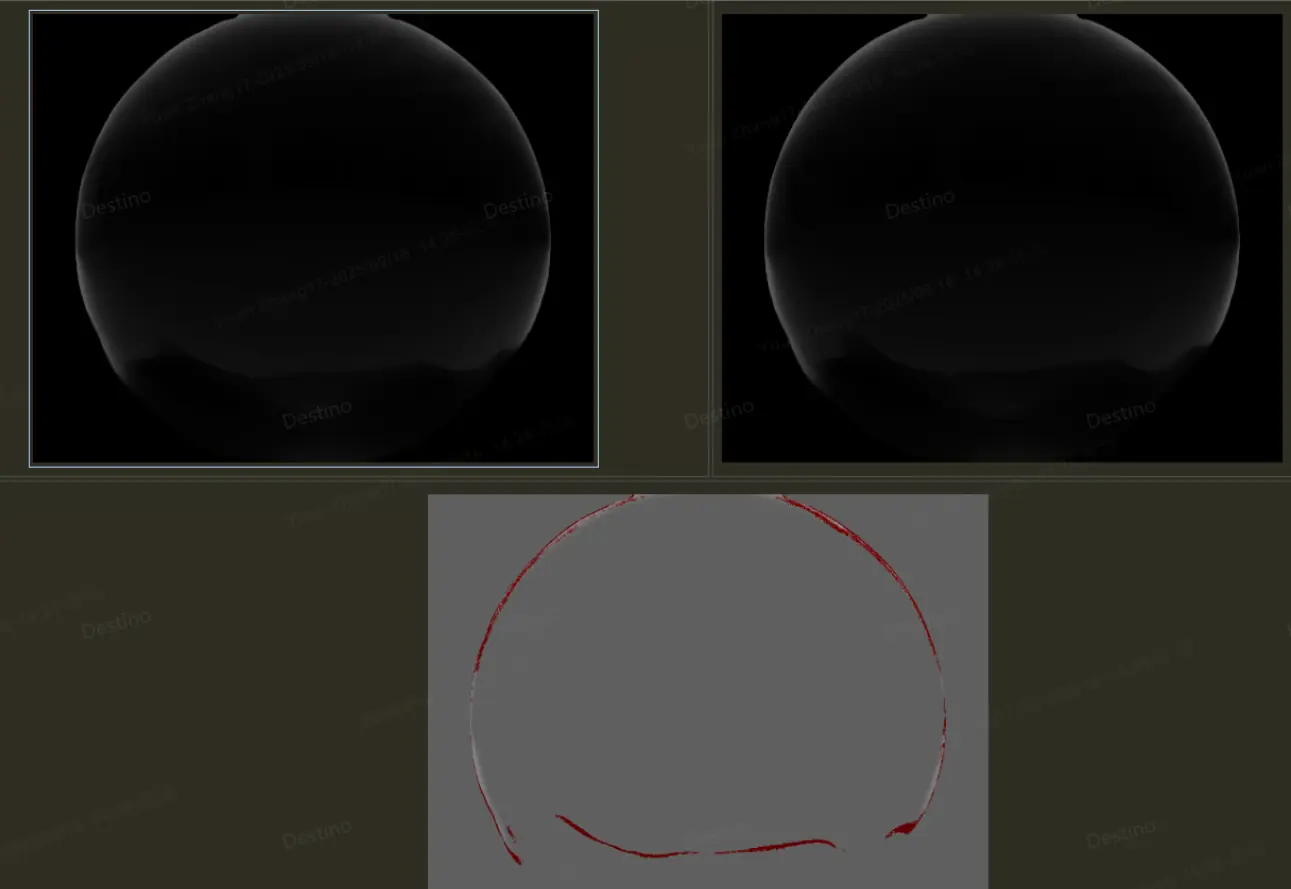

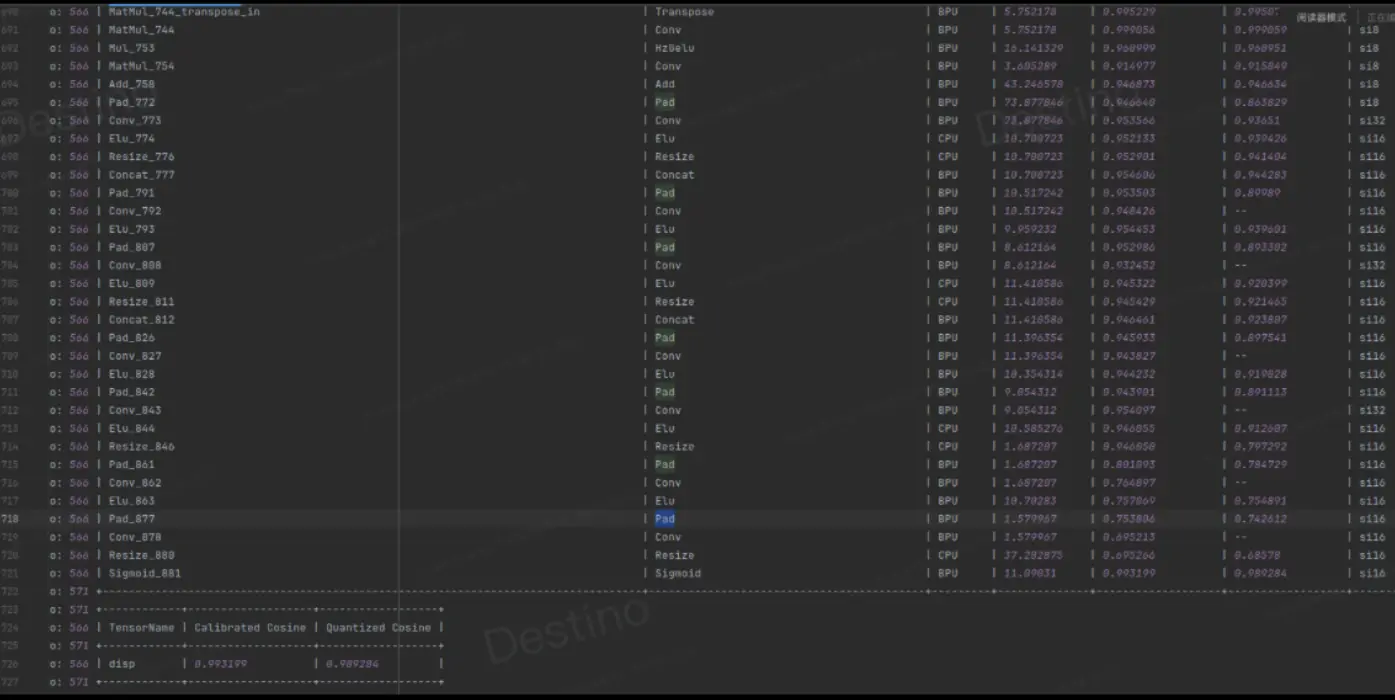

配置了算子后,精度提升了,如图 3,可视化效果对比如图 4,整体量化精度可对齐,定位到了具体问题就是 resize 算子限制导致。

图 3 cpu 算子精度

图 4 cpu 算子可视化精度

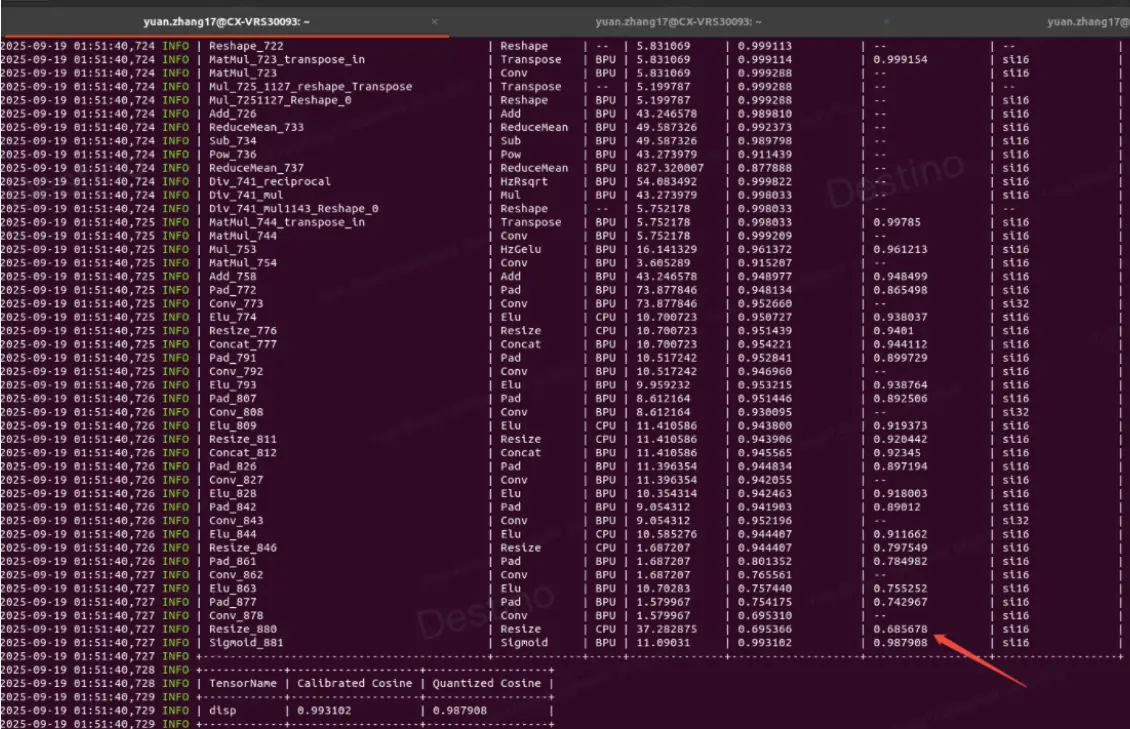

2.2、添加 bn,加大 weight_decay

在最后的 conv 层后加上 bn 算子限制特征数据分布,同时 weight_decay 从 1e-6 调整到 1e-3,整体数据范围如图 5、图 6,模型的数据分布变小了,最后的 cosine 相似度精度也很高,非常利于 int8 量化,后期配置了 int8 量化,模型也可实现高精度量化。

图 5 全 int16 量化

图 6 部分 int16 量化