Windows + WSL2 + Docker + CudaToolkit:深度学习环境配置

在Windows系统上解锁GPU加速的深度学习开发

在人工智能与深度学习领域,GPU加速已成为模型训练与推理的必备条件。然而,对于许多开发者而言,Windows系统下的环境配置却是一大挑战。本文将详细介绍如何通过Windows + WSL2 + Docker + CudaToolkit的组合,搭建一个高效、可移植的GPU加速开发环境。

为什么选择Windows + WSL2 + Docker + CudaToolkit?

方案优势对比

对于使用Windows系统的AI开发者,通常面临一个困境:主力显卡在Windows环境下,但深度学习框架和工具链在Linux环境中更为成熟和稳定。传统的双系统方案需要频繁重启,而虚拟机方案则无法有效调用GPU进行CUDA计算。

随着微软推出WSL2并携手NVIDIA实现GPU透传支持,现在我们可以在不离开Windows环境的情况下,获得接近原生Linux的深度学习开发体验。其核心调用链路为:

Windows NVIDIA驱动 → WSL2 GPU透传 → Docker Desktop资源分配 → 容器内CUDA/cuDNN调用GPU。

| 案 | GPU支持 | CUDA兼容性 | 性能表现 | 易用性 | 是否需要重启 |

|---|---|---|---|---|---|

| 原生Ubuntu(双系统) | ✅ 完整 | ✅ 优秀 | ⭐⭐⭐⭐⭐ | ⭐⭐ 一般 | ✅ 是 |

| WSL2 + Docker (本方案) | ✅ 完整 | ✅ 优秀 | ⭐⭐⭐⭐☆ (90%-95%) | ⭐⭐⭐⭐⭐ 优秀 | ❌ 否 |

| 传统虚拟机 | ⚠️ 有限(需直通) | ⚠️ 一般 | ⭐⭐ 较差 | ⭐⭐ 一般 | ✅ 是 |

环境准备与前提条件

在开始配置前,请确保你的系统满足以下要求:

硬件与系统要求

- GPU硬件:必须是NVIDIA显卡(CUDA是NVIDIA专属技术),支持CUDA Compute Capability 3.5+(主流显卡均满足)。

- Windows系统:Windows 10 21H2及以上或Windows 11(旧版本WSL2不支持GPU透传)。

- 内存建议:至少8GB,推荐16GB或以上,以供WSL2和Docker容器顺畅运行。

软件组件

- WSL2:Windows Subsystem for Linux 2

- Docker Desktop:用于管理容器化应用

- NVIDIA驱动:支持WSL2 GPU透传的Windows版驱动

- NVIDIA Container Toolkit:使Docker容器能够使用GPU

分步配置指南

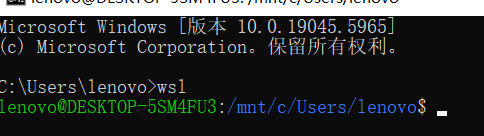

1.WSL激活、离线升级

dism.exe /online /enable-feature /featurename:Microsoft-Windows-Subsystem-Linux /all /norestart

dism.exe /online /enable-feature /featurename:VirtualMachinePlatform /all /norestart

重启设备

先下载这个,把wsl初步升级一下 https://wslstorestorage.blob.core.windows.net/wslblob/wsl_update_x64.msi

wsl --set-default-version 2

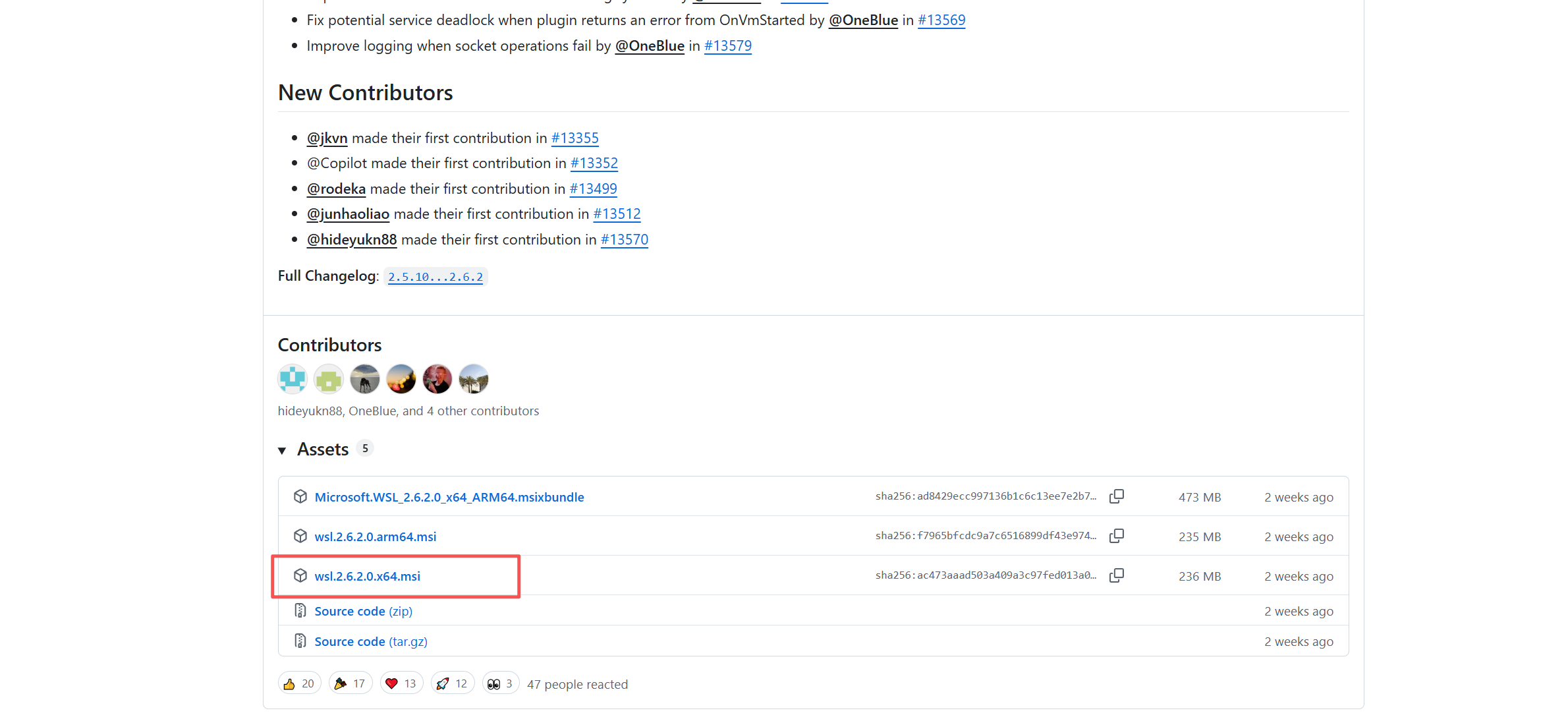

然后 升级wsl至最新版本 https://github.com/microsoft/WSL/releases/tag/2.6.2

2.WSL挂载Ubuntu系统

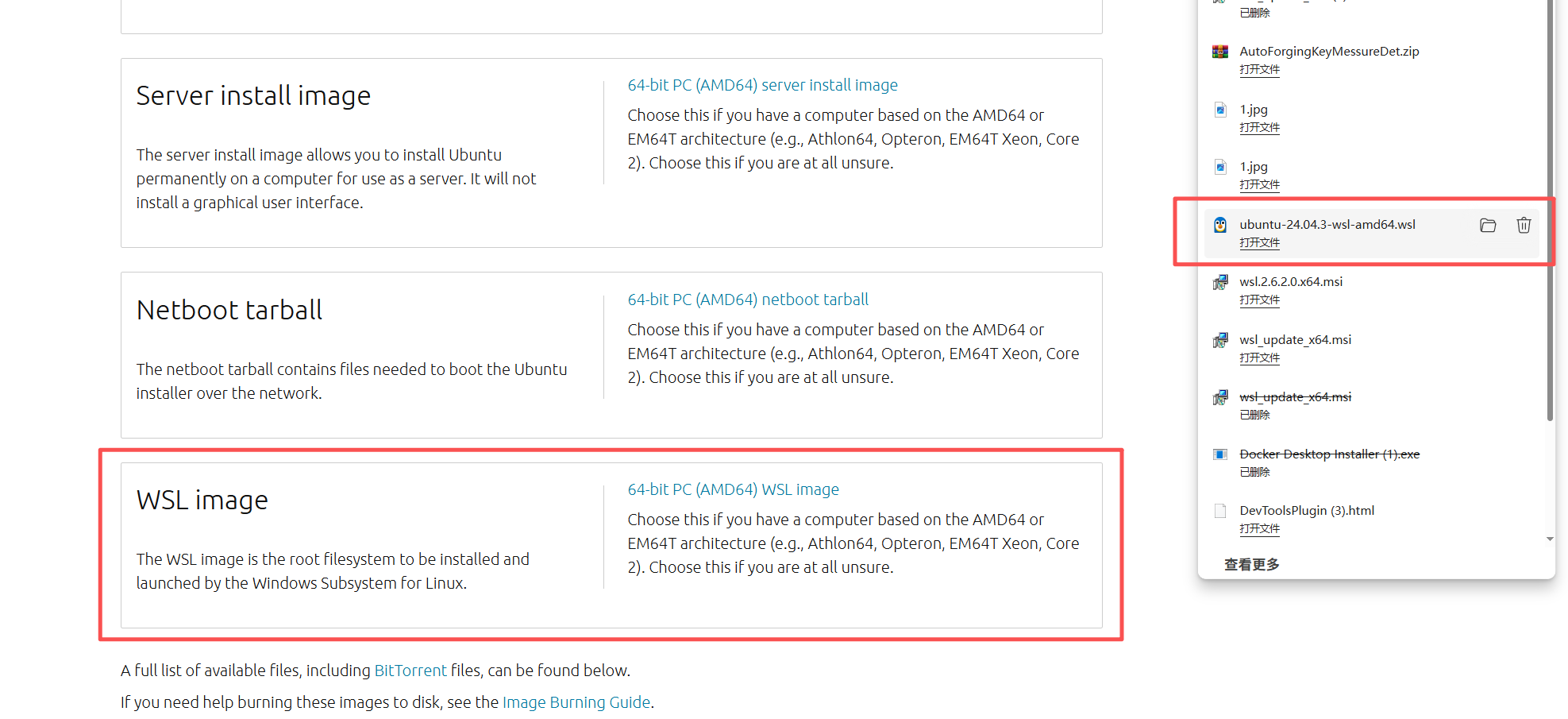

下载这个 https://releases.ubuntu.com/noble/ 然后运行安装就行

中间需要手动配置用户名和密码

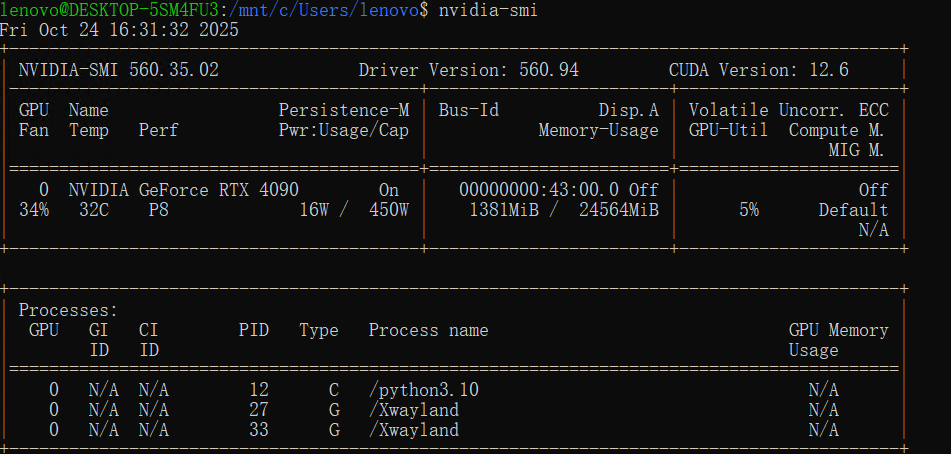

查看GPU驱动穿透是否正常

nvidia-smi

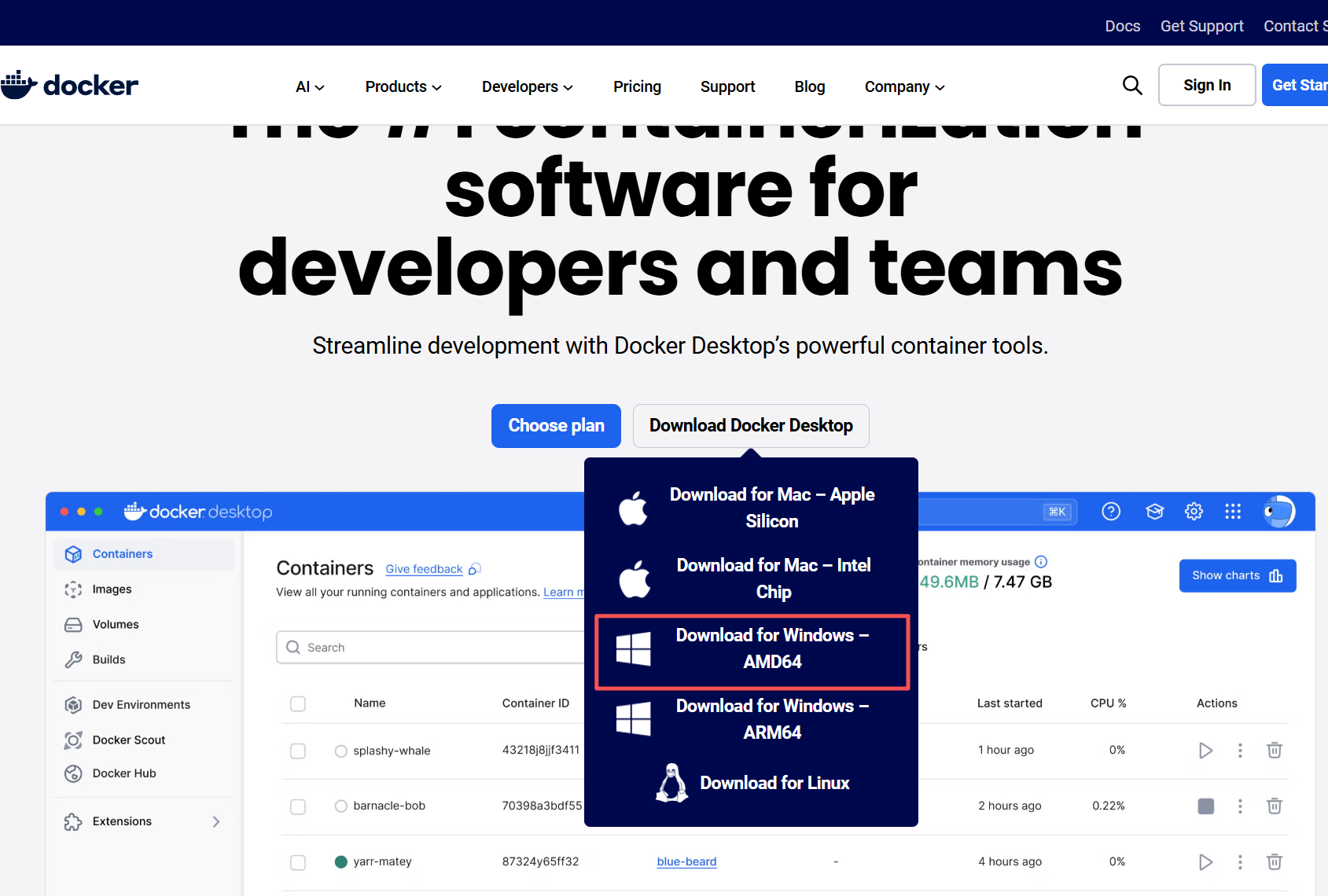

3. Docker Desktop安装

https://www.docker.com/products/docker-desktop/

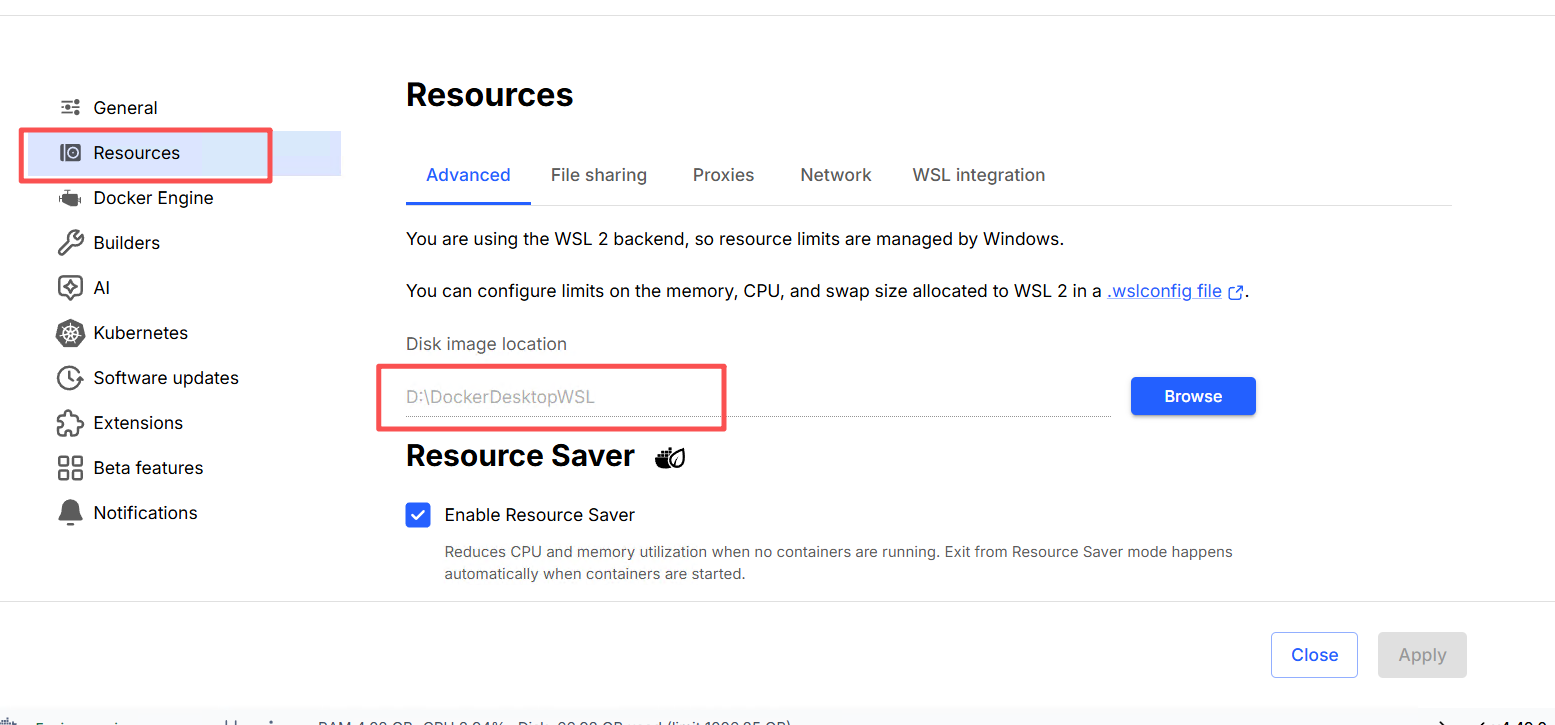

配置一下存储

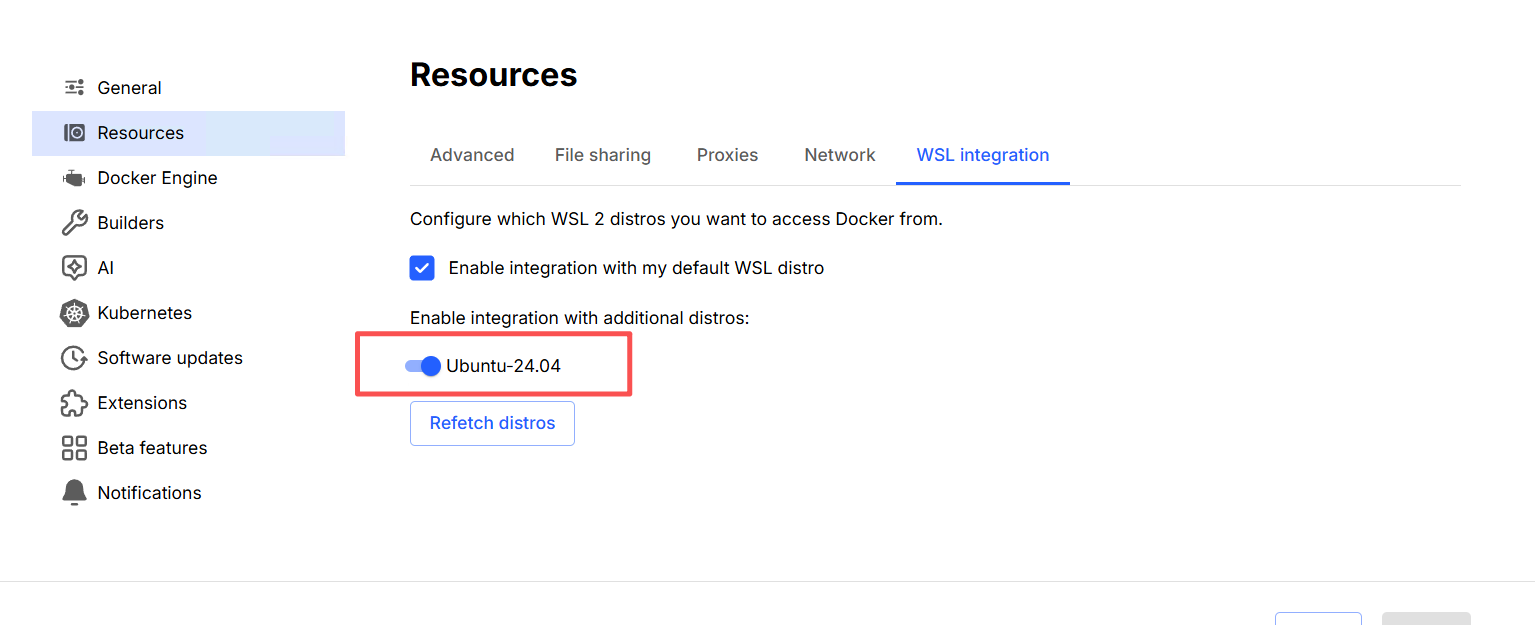

配置WSL Ubuntu系统集成

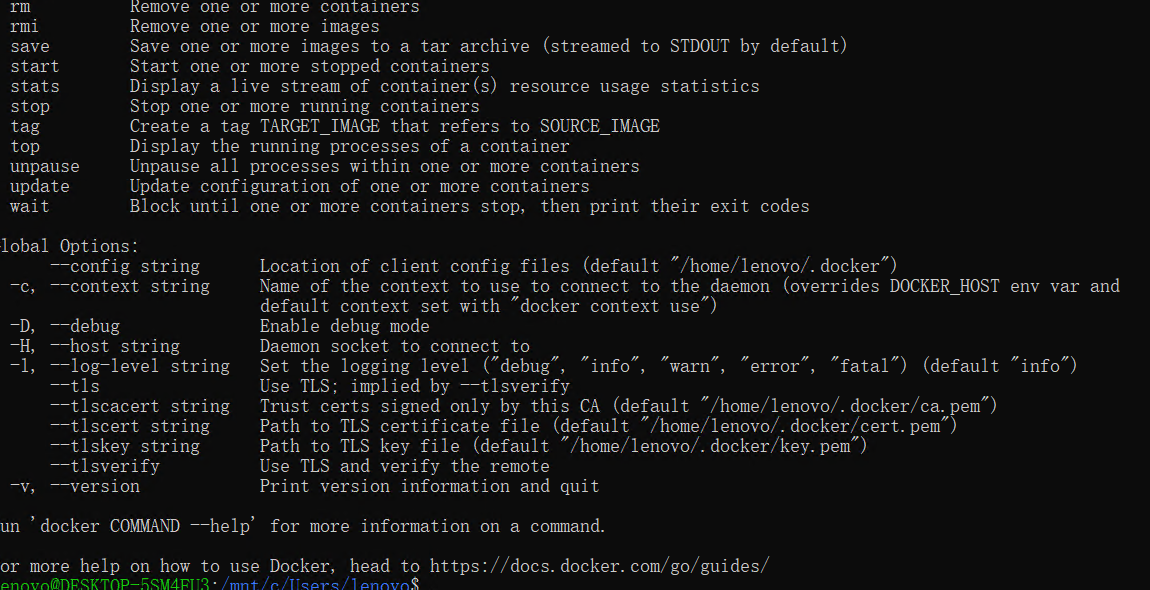

4. Nvidia-Cuda-Toolkit 安装

wsl

下载nvidia-container-toolkit 文件包 【https://pan.quark.cn/s/7c204585e76c】

cd ./nvidia-container-toolkit

sudo dpkg -i ./nvidia-container-toolkit/*

nvidia-docker

5. 测试案例

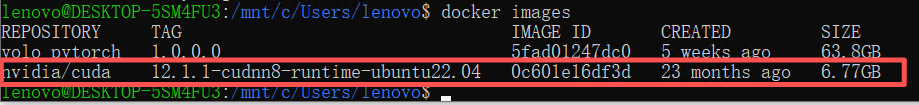

docker pull nvidia/cuda:12.1.1-cudnn8-runtime-ubuntu22.04

docker images

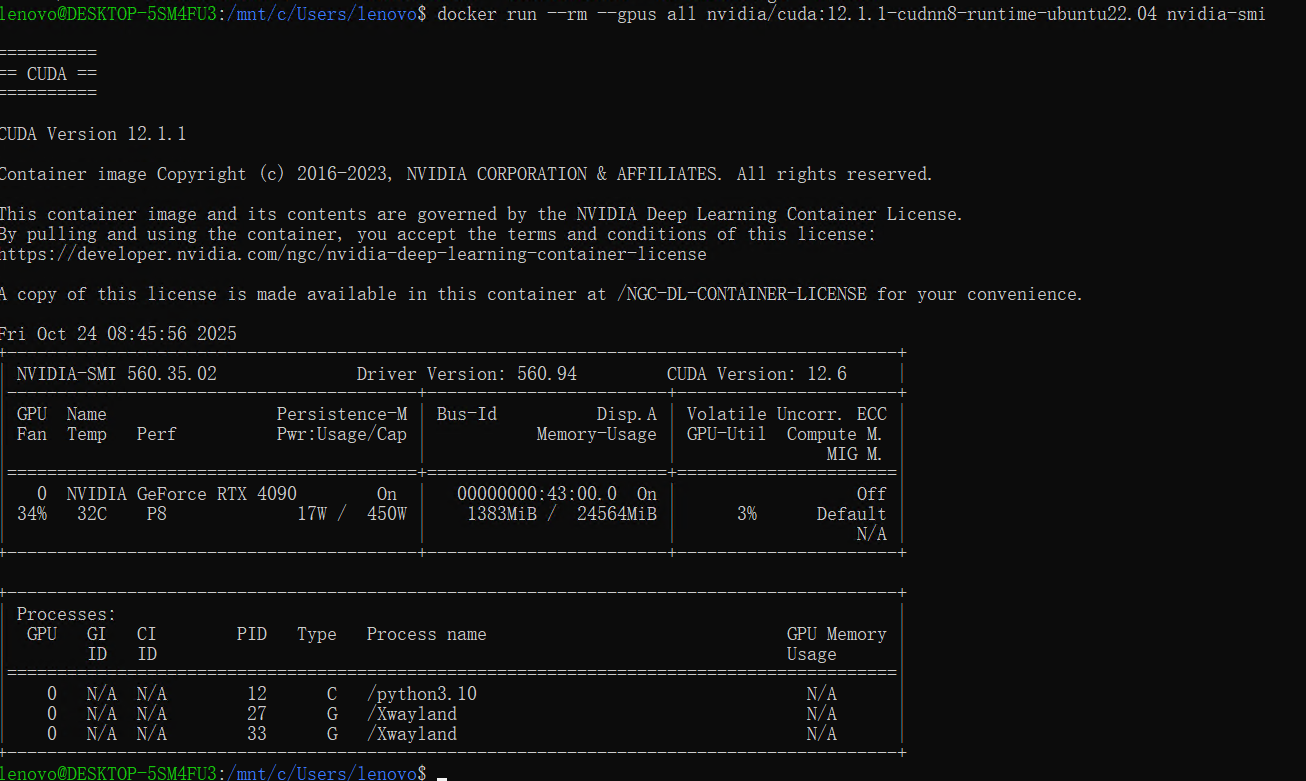

docker run --rm --gpus all nvidia/cuda:12.1.1-cudnn8-runtime-ubuntu22.04 nvidia-smi

这样就成功了