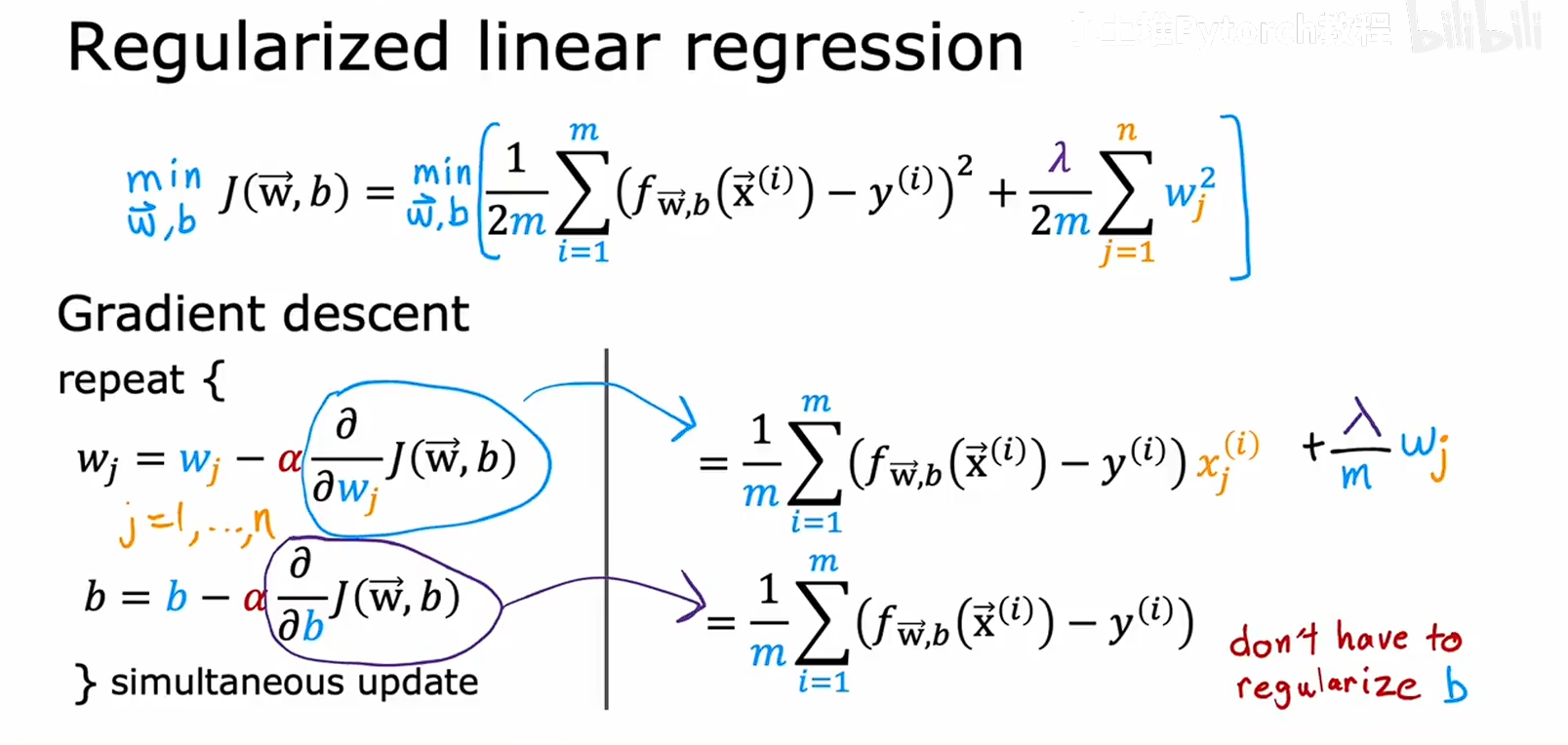

如上图我们不需要对b进行正则化,w控制着特征的影响强度,W太大会容易让模型对训练数据过于敏感,造成过拟合,而B是偏置项,相当于对所有样本添加了一个固定值,,他的大小对模型的影响很小,不会导致过拟合额,他只影响模型的整体平移

如上图我们不需要对b进行正则化,w控制着特征的影响强度,W太大会容易让模型对训练数据过于敏感,造成过拟合,而B是偏置项,相当于对所有样本添加了一个固定值,,他的大小对模型的影响很小,不会导致过拟合额,他只影响模型的整体平移

我么看一下正则化是做了什么

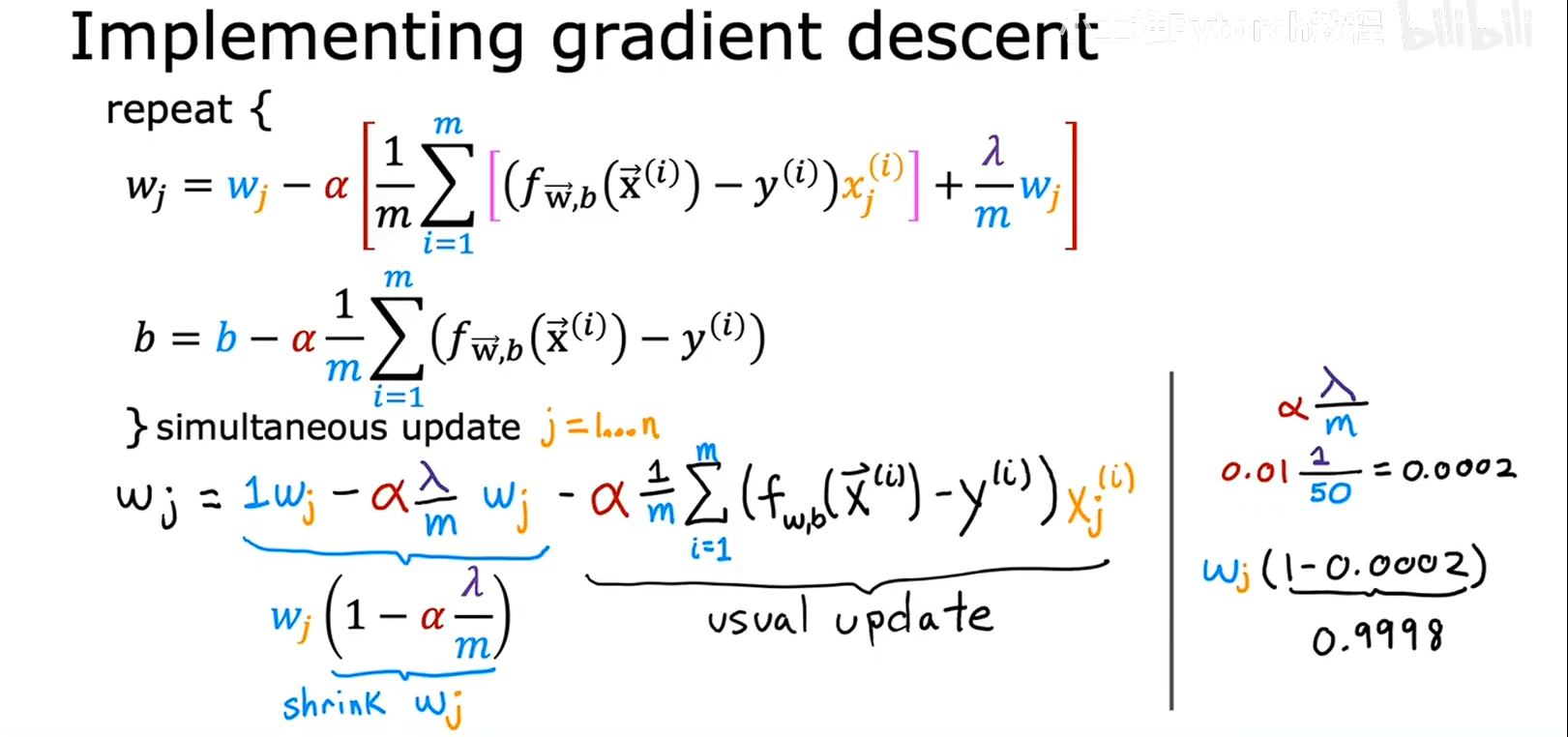

我们对正则化的式子展开并且重新排列,会发现 后面的一项其实就是 没有正则化线性回归时候的梯度下降方程,我们看前一项, w和一个东西想成,如果我们找到一些数据带入到这一块中,如右图,我们可以发现 相当于是将W乘以了一个参数,这个参数的大小和 lamdba 有关,在右边的数据可以看出,相当于每次都对W乘以了一个小于1 但是近似与1的数进行变化,相当于每次都对W进行了一次小缩放,以防止过拟合

实际上 学习率是一个很小的数字,样本数据也是足够多的,lamdba 也是最够小的,这会导致 W会乘以一个小于1的但是很接近于1的数字,对W进行 打折每次都会打折,进行迭代

我们从式子可以看出,

lamdba 是和这个w相乘的系数是成反比的,

这个系数和模型的拟合能力是成反比的,

所以lamdba和模型的拟合能力是成正比的

lamdba 越大,系数越小 ,对W的惩罚越大,w就会越小,模型就越简单,模型就会欠拟合

lamdba 越小,对w的约束就会越小,模型就会过拟合,

lamdba 就是W的调节器,是反相关的

w的大小决定了模型的拟合深度,w大过拟合,W小欠拟合

lamdba 越大 模型就会欠拟合

lamdba 越小 模型就会过拟合

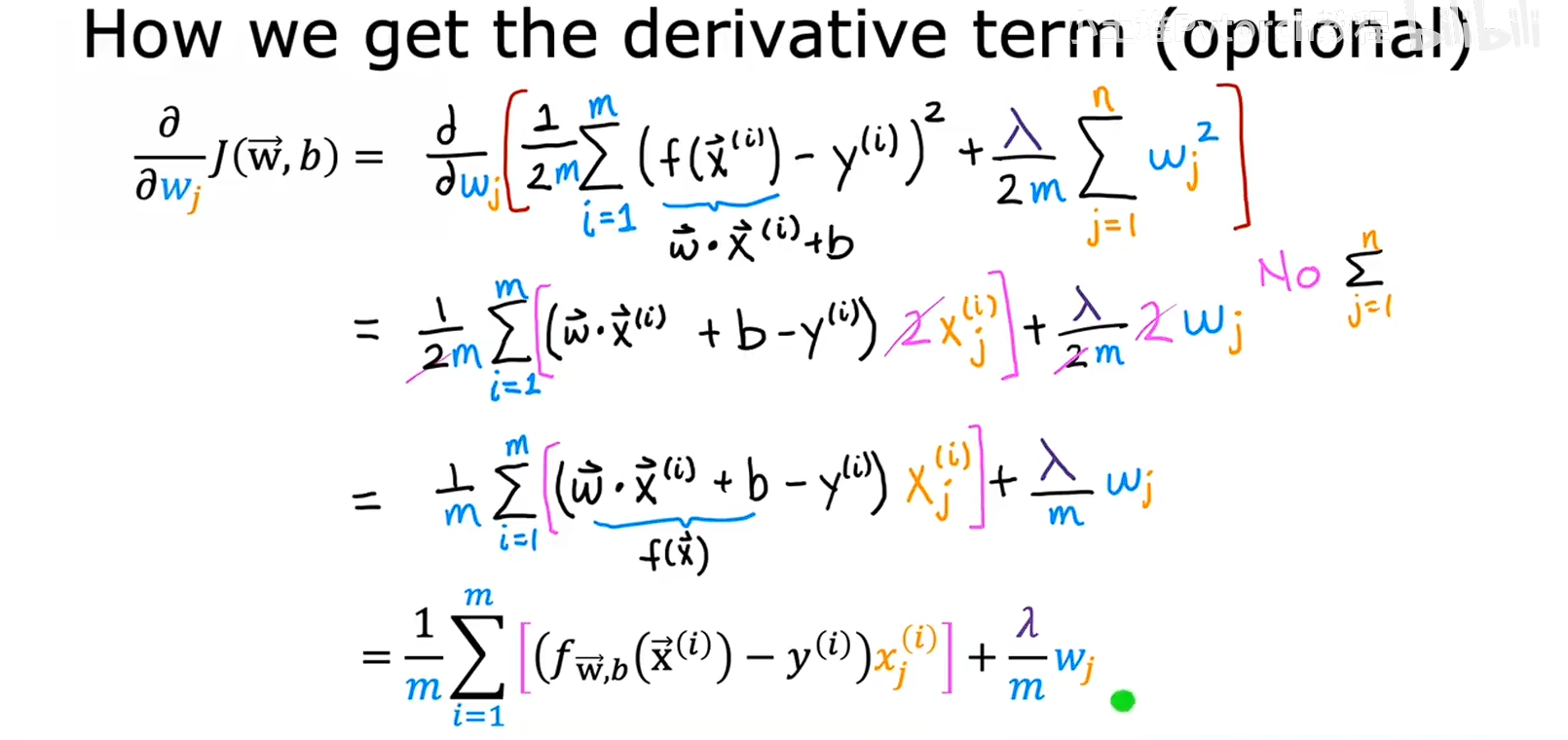

推导过程如小图