人机协同模式是AI Agent设计与部署中的核心战略框架。它旨在将人类特有的认知能力------包括复杂判断、创造性思维与情境化理解------与人工智能的高速计算和自动化优势相结合。这种协同并非简单互补,而是在关键决策场景中的必要设计,尤其在AI系统承担的责任日益重大的背景下。

该模式的核心在于,通过人类介入确保AI系统的运作合乎伦理、保障安全,并有效达成目标。在那些高度复杂、信息模糊或容错率极低的领域,AI的失误可能产生显著后果,人类监督的价值更为凸显。完全自主的AI系统在此类场景中往往不够可靠,因此人机协同模式强调,无论技术如何进步,人类的战略指导、实时监督与协同参与始终不可或缺。

本质上,人机协同建立在"增强智能"的理念之上:AI不是取代人类,而是拓展和提升人的能力。其形式多样,既可自动化处理常规任务,也能通过数据洞察辅助人类决策。最终目标是构建一个协作系统,使人类与AI能够各展所长,共同完成任何一方都难以独立实现的目标。

在实践中,该模式有多种实现路径:常见的一种是让人扮演"验证者"角色,审核AI输出以确保准确并修正错误;另一种是让人作为"引导者",实时提供反馈以调整AI行为;更深入的形态则是人与AI成为"合作伙伴",通过交互对话共同解决问题或制定策略。无论具体形式如何,该模式始终强调保持人类监督与最终控制权的重要性,以此确保AI系统的行为与人类的伦理准则、价值取向及社会期许保持一致。

人机协同模式概述

人机协同(HITL)模式通过在 AI Agent 运行过程中融合人类判断与干预,显著提升了系统的整体能力与可靠性。该模式认识到,在复杂、高风险或涉及伦理判断的场景中,完全依赖自动化既不现实也不安全。因此,HITL 的核心并非替代人类,而是借助人机互补,确保关键决策始终处于人类的理解与监督之下。

HITL 的实施通常涵盖以下关键维度:

| 维度 | 说明 |

|---|---|

| 人类监督 | 通过日志审查、实时看板等途径监控 Agent 的行为与输出,确保其符合规范、避免有害结果。 |

| 干预与纠正 | 当 Agent 遇到错误或不确定情境时,可由人类操作员直接介入,修正错误、补充信息或调整执行路径,这些反馈也可用于优化后续的 Agent 行为。 |

| 人类反馈学习 | 收集并利用人类评价、偏好或修正结果来持续训练 AI 模型,常见于基于人类反馈的强化学习(RLHF)等方法。 |

| 决策增强 | AI 提供数据分析与建议,人类基于此作出最终判断,形成"AI 辅助,人类决策"的协作范式。 |

| 人机协作 | 人与 AI 在任务中各展所长------如由 Agent 处理重复性数据处理,人类则负责创造性构思与复杂协商。 |

| 升级机制 | 设定明确的规则,当任务超出 Agent 能力范围时,自动将其移交至人工处理,从而控制系统风险。 |

该模式使得 AI Agent 得以应用于那些完全自主不被允许或风险较高的领域,如金融与司法行业,同时也为系统提供了通过持续反馈实现自我优化的机制。例如,在企业贷款审批中,AI 可完成财务数据分析,但最终是否放贷仍需由人类信贷员综合评估企业负责人信誉等定性因素;在司法领域,尽管 AI 可辅助法律检索与文书生成,但涉及重大法理与伦理的判决仍必须由人类法官作出。

通过这样的人机协同架构,AI 不仅能够更安全、更可靠地运行,也得以在保持伦理对齐与社会可接受的前提下,持续扩展其应用边界。

注意事项:

尽管 HITL 模式具有诸多优势,但也存在重要注意事项,其中最主要的是可扩展性不足。虽然人类监督提供了高精度,但操作员无法管理数百万个任务,这造成了基本权衡,通常需要采用混合方法,结合自动化实现规模化和 HITL 实现准确性。此外,此模式的有效性在很大程度上依赖于人类操作员的专业知识;例如虽然 AI 可以生成软件代码, 但只有熟练的开发人员才能准确识别细微错误并提供正确修复指导。这种对专业知识的需求同样适用于使用 HITL 生成训练数据时,人类标注员可能需要特殊培训才能学会如何以产生高质量数据的方式纠正AI。最后,实施 HITL 会引发重大隐私问题,因为敏感信息在暴露给人类操作员之前通常必须严格匿名化,这增加了流程复杂性。

实际应用和用例

人机协同(HITL)模式广泛应用于诸多对精确性、安全性、伦理判断或情境理解有高要求的领域,它通过人机分工与协作,在提升效率的同时确保关键环节的人类把控。

以下是该模式在具体场景中的应用体现:

| 应用领域 | AI 的角色与能力 | 人类的角色与价值 | 协同的核心 |

|---|---|---|---|

| 内容审核 | 快速初筛海量内容,识别明显违规(如仇恨言论)。 | 对模糊、边界案例进行最终裁定,执行复杂政策与 nuanced 判断。 | 效率与精准的平衡:AI 处理规模,人类处理例外与复杂判断。 |

| 自动驾驶 | 在常规路况下完成感知、决策与控制等主要驾驶任务。 | 在极端天气、突发道路状况等系统无法处理的场景下接管控制。 | 安全兜底:AI 负责常态运行,人类作为最终的安全保障。 |

| 金融欺诈检测 | 基于模式与算法实时标记可疑交易。 | 对高风险或存疑警报进行深入调查、客户沟通并做出最终判定。 | 风险控制:AI 扩大监控范围,人类聚焦于高价值、高风险的决策。 |

| 法律文件审阅 | 高速扫描、分类文件,提取潜在相关条款与证据。 | 复核 AI 提取结果,确保其准确性、上下文恰当性与法律意义。 | 质量保证:AI 提升检索效率,人类确保专业精度与法律严谨性。 |

| 客户支持 | 处理常见、标准化的查询与业务流程。 | 接手复杂、情绪化或需要深度共情与创造性的用户问题。 | 体验优化:AI 分流常规请求,人类提供有温度的高阶服务。 |

| 数据标注 | 可进行初步预标注或处理简单明确的标注任务。 | 提供高质量、准确的标注结果,为 AI 训练提供可靠的"标准答案"。 | 基础供给:人类为 AI 的进化提供持续、高质量的"燃料"。 |

| 生成式AI完善 | 生成文案、设计草图、代码等初稿内容。 | 基于品牌调性、受众感受与专业标准,对初稿进行审核、调整与优化。 | 创意落地:AI 激发灵感、拓展可能,人类确保产出符合实际要求与审美。 |

| 自主运维 | 监控网络指标、分析日志、预测故障并生成修复预案。 | 审批高风险变更、处理复杂根因分析,并对重大决策负最终责任。 | 责任界定:AI 实现预警与提效,人类保留对关键系统变更的审批权。 |

此模式代表了一种务实的AI应用哲学:利用 AI 实现规模化与效率的提升,同时依托人类监督来保障质量、安全与伦理合规。

"人在循环外"(Human‐on‐the‐loop)是该模式的一种重要变体,其核心思想是 "监督前置" :由人类专家预先定义策略、规则与边界,AI 系统则在设定的框架内自主执行实时操作。例如,在量化交易中,人类设定投资组合规则与风险参数,AI 负责执行符合规则的高频交易;在现代客服系统中,管理员预设路由策略(如"提及投诉即转人工"),AI 则根据对话内容自动执行该策略。这种方式实现了 "人类制定战略,AI 执行战术" 的高效协同。

核心问题:为何不能完全依赖AI?

尽管AI在计算与数据处理方面表现卓越,但在需要深层情境理解、伦理权衡和创造性判断的任务中仍存在明显短板。完全自主的AI系统若部署于高风险场景(如医疗诊断、金融风控、司法辅助等),其误判可能引发严重的安全、财务或道德后果。此外,AI缺乏人类所具备的常识推理与灵活应变能力,因此在关键决策环节中纯粹依赖自动化,不仅不明智,也可能损害系统的整体可靠性与社会信任。

解决方案:人机协同如何应对?

HITL模式通过将人类监督机制结构化地嵌入AI工作流程,建立起一种互补协同关系:

-

1、AI承担可自动化、高并发的任务,如数据清洗、实时监控、信息初筛;

-

2、人类则负责提供关键验证、伦理审视、模糊决策与创造性输入。

该模式不仅确保了AI系统的行为与人类价值观、安全规范保持一致,还通过持续的人类反馈形成学习闭环,不断提升系统的适应性与准确性。最终达成"1+1>2"的协同效果,实现任何一方单独难以完成的复杂任务。

何时应采用此模式?

在以下情形中,应优先引入人机协同设计:

-

1、高风险领域:错误会导致重大安全、伦理或财务影响的场景,如自动驾驶、医疗辅助决策、金融交易等;

-

2、高模糊性任务:需要理解语境、意图或处理多重解释的情况,如内容审核、复杂客诉处理、法律条文解释;

-

3、模型持续优化:需借助人类标注、反馈或修正来迭代训练AI模型的场景;

-

4、生成结果把关:当AI生成内容(如文案、设计、代码)必须符合特定质量标准、品牌要求或伦理指南时。

该模式已成为在关键领域中部署AI系统的一种负责任且务实的选择,既发挥了AI的效率优势,也确保了人类在关键环节的监督与最终责任。

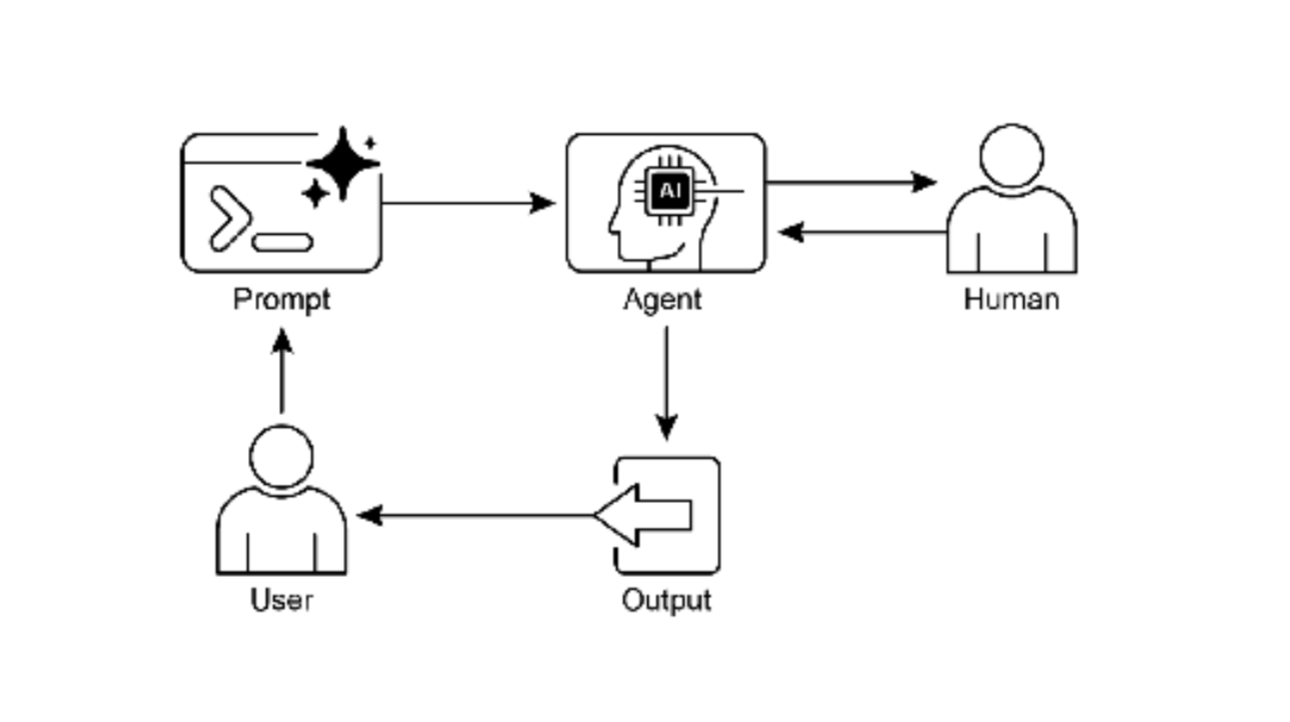

图 1:人机协同设计模式

关键要点

1、核心价值

-

风险控制:在安全、伦理或实效性要求高的领域(如医疗、金融、自动驾驶),HITL 是确保AI系统可靠运作的必要设计。

-

责任归属:通过明确人类在关键决策中的监督与最终裁定权,使AI的部署更具可信度与可问责性。

-

持续进化:借助人类反馈持续优化AI模型,形成"使用‑改进"的良性循环。

2、关键实施维度

| 维度 | 说明 |

|---|---|

| 人类监督 | 对AI的输出与行为进行实时或事后审查,确保符合规范与预期。 |

| 干预与纠正 | 在AI不确定、错误或遇到边界情况时,由人类直接介入调整或接管。 |

| 人类反馈学习 | 将人类的评价、修正与标注作为训练数据,持续提升模型表现。 |

| 决策增强 | AI提供信息与分析支持,人类作出最终判断,形成辅助型决策闭环。 |

| 升级机制 | 明确规则,使AI能在超出能力范围时自动将任务移交人类处理。 |

3、局限与挑战

-

可扩展性瓶颈:人类介入的深度与响应速度,限制了系统整体吞吐量,需要在"精度"与"规模"间权衡。

-

专家依赖:高效干预往往依赖领域专业知识,人力成本较高,且专家资源可能稀缺。

-

运营复杂度:需对参与协同的人员进行系统培训,并建立相应的质量管理流程。

-

隐私与安全:处理涉及敏感信息的数据时,需设计隐私保护机制(如数据脱敏、权限控制等),以满足合规要求。

人机协同模式并非旨在追求全自动化的"无人"效率,而是在关键决策中保留人类智慧 ,在日常执行中发挥AI效能的务实路径。它既是当前AI技术局限下的负责任选择,也是构建可信、可靠、可持续智能系统的重要方法论。

用例DEMO

以下是基于LangChain4j框架的人机协同模式实现示例,展示了在不同应用场景中如何集成人类判断与AI自动化:

1. 通用人机协同框架设计

java

import dev.langchain4j.agent.tool.Tool;

import dev.langchain4j.memory.chat.MessageWindowChatMemory;

import dev.langchain4j.model.openai.OpenAiChatModel;

import dev.langchain4j.service.AiServices;

import dev.langchain4j.service.SystemMessage;

import dev.langchain4j.service.UserMessage;

import lombok.extern.slf4j.Slf4j;

import java.time.Duration;

import java.util.Map;

import java.util.concurrent.BlockingQueue;

import java.util.concurrent.LinkedBlockingQueue;

@Slf4j

public class HumanInTheLoopFramework {

// 人类任务队列

private final BlockingQueue<HumanTask> humanTaskQueue = new LinkedBlockingQueue<>();

private final HumanOperatorService humanOperatorService;

public HumanInTheLoopFramework() {

this.humanOperatorService = new HumanOperatorService(humanTaskQueue);

}

/**

* 基础人机协同接口

*/

interface HumanAIAssistant {

@SystemMessage("你是一个AI助手,需要与人类操作员协同工作。对于不确定的情况,请向人类操作员寻求帮助。")

String processWithHumanFallback(String input);

}

/**

* 向人类操作员提交任务的工具

*/

@Tool("提交任务给人类操作员审核")

public HumanTask submitToHuman(String taskType, String content,

Map<String, Object> metadata) {

HumanTask task = HumanTask.builder()

.taskId(generateTaskId())

.taskType(taskType)

.content(content)

.metadata(metadata)

.status(TaskStatus.PENDING)

.timestamp(System.currentTimeMillis())

.build();

try {

humanTaskQueue.put(task);

log.info("已提交任务给人类操作员: {}", task.getTaskId());

// 等待人类响应

return waitForHumanResponse(task.getTaskId());

} catch (InterruptedException e) {

Thread.currentThread().interrupt();

throw new RuntimeException("提交任务给人类操作员时被中断", e);

}

}

/**

* 检查是否需要人工干预

*/

@Tool("检查任务是否需要人工干预")

public boolean needsHumanIntervention(String content,

double confidenceScore,

String riskLevel) {

// 基于置信度和风险级别的决策逻辑

return confidenceScore < 0.7 ||

"HIGH".equalsIgnoreCase(riskLevel) ||

"CRITICAL".equalsIgnoreCase(riskLevel);

}

private String generateTaskId() {

return "TASK_" + System.currentTimeMillis() + "_" +

Thread.currentThread().getId();

}

private HumanTask waitForHumanResponse(String taskId) {

// 在实际应用中,这里会实现等待逻辑

// 简化版本:返回模拟响应

return HumanTask.builder()

.taskId(taskId)

.status(TaskStatus.COMPLETED)

.humanDecision("APPROVED")

.comments("人工审核通过")

.build();

}

// 任务状态枚举

enum TaskStatus {

PENDING, IN_PROGRESS, COMPLETED, ESCALATED, FAILED

}

// 人类任务类

@Builder

@Data

static class HumanTask {

private String taskId;

private String taskType;

private String content;

private Map<String, Object> metadata;

private TaskStatus status;

private Long timestamp;

private String humanDecision;

private String comments;

private Double processingTime;

}

}2. 内容审核场景实现

java

import dev.langchain4j.agent.tool.Tool;

import dev.langchain4j.data.message.AiMessage;

import dev.langchain4j.data.message.UserMessage;

import dev.langchain4j.model.output.Response;

import lombok.extern.slf4j.Slf4j;

import java.util.Arrays;

import java.util.HashMap;

import java.util.List;

import java.util.Map;

@Slf4j

public class ContentModerationAgent {

interface ContentModerator {

@UserMessage("审核内容: {{content}}")

ModerationResult moderateContent(String content);

}

private final ContentModerator moderator;

private final HumanInTheLoopFramework hitlFramework;

// 敏感词列表

private final List<String> sensitiveKeywords = Arrays.asList(

"仇恨", "暴力", "欺诈", "垃圾", "spam", "hate"

);

public ContentModerationAgent() {

this.hitlFramework = new HumanInTheLoopFramework();

this.moderator = AiServices.builder(ContentModerator.class)

.chatLanguageModel(OpenAiChatModel.builder()

.apiKey(System.getenv("OPENAI_API_KEY"))

.temperature(0.1) // 低温度,更确定性

.build())

.tools(new ModerationTools())

.build();

}

class ModerationTools {

@Tool("自动内容审核")

public ModerationResult autoModerate(String content) {

// 1. 初步关键词检测

boolean containsSensitive = sensitiveKeywords.stream()

.anyMatch(content::contains);

// 2. AI模型审核

double aiConfidence = assessContentWithAI(content);

// 3. 决策逻辑

if (aiConfidence > 0.9 && !containsSensitive) {

// 明确安全内容

return ModerationResult.builder()

.decision("SAFE")

.confidence(aiConfidence)

.automated(true)

.build();

} else if (aiConfidence < 0.7 || containsSensitive) {

// 明确违规或低置信度内容

if (aiConfidence < 0.5) {

// 需要人工审核

return escalateToHuman(content, aiConfidence);

} else {

// AI可确定违规

return ModerationResult.builder()

.decision("VIOLATION")

.confidence(aiConfidence)

.reason("检测到敏感内容或违反规则")

.automated(true)

.build();

}

} else {

// 边界案例,需要人工审核

return escalateToHuman(content, aiConfidence);

}

}

private double assessContentWithAI(String content) {

try {

// 使用AI模型评估内容

Response<AiMessage> response = moderator.moderateContent(content);

// 解析响应,获取置信度

// 这里简化处理,实际需要解析模型输出

String responseText = response.content().text();

if (responseText.contains("安全") || responseText.contains("合规")) {

return 0.9;

} else if (responseText.contains("模糊") || responseText.contains("需要审核")) {

return 0.6;

} else {

return 0.3;

}

} catch (Exception e) {

log.error("AI审核失败", e);

return 0.5; // 出错时默认需要人工审核

}

}

private ModerationResult escalateToHuman(String content, double aiConfidence) {

log.info("边界内容,提交人工审核: {}", content.substring(0, Math.min(50, content.length())));

// 创建人工审核任务

Map<String, Object> metadata = new HashMap<>();

metadata.put("ai_confidence", aiConfidence);

metadata.put("content_length", content.length());

metadata.put("detected_keywords", findSensitiveKeywords(content));

HumanTask task = hitlFramework.submitToHuman(

"CONTENT_MODERATION",

content,

metadata

);

// 等待人类决策

return ModerationResult.builder()

.decision(task.getHumanDecision())

.confidence(aiConfidence)

.humanReviewed(true)

.comments(task.getComments())

.taskId(task.getTaskId())

.build();

}

private List<String> findSensitiveKeywords(String content) {

return sensitiveKeywords.stream()

.filter(content::contains)

.toList();

}

@Tool("批量内容审核")

public BatchModerationResult batchModerate(List<String> contents) {

List<ModerationResult> results = contents.stream()

.map(this::autoModerate)

.toList();

long humanReviewNeeded = results.stream()

.filter(r -> r.isHumanReviewed() || "PENDING".equals(r.getDecision()))

.count();

return BatchModerationResult.builder()

.results(results)

.totalCount(contents.size())

.automatedCount(contents.size() - humanReviewNeeded)

.humanReviewCount(humanReviewNeeded)

.build();

}

}

// 审核结果类

@Builder

@Data

static class ModerationResult {

private String decision; // SAFE, VIOLATION, PENDING, ESCALATED

private double confidence;

private String reason;

private boolean automated;

private boolean humanReviewed;

private String comments;

private String taskId;

}

@Builder

@Data

static class BatchModerationResult {

private List<ModerationResult> results;

private int totalCount;

private long automatedCount;

private long humanReviewCount;

private String summary;

}

}3. 金融欺诈检测场景

java

import dev.langchain4j.agent.tool.Tool;

import dev.langchain4j.service.AiServices;

import lombok.extern.slf4j.Slf4j;

import java.math.BigDecimal;

import java.time.LocalDateTime;

import java.util.*;

@Slf4j

public class FraudDetectionAgent {

interface FraudAnalyzer {

String analyzeTransaction(Transaction transaction);

}

private final FraudAnalyzer analyzer;

private final HumanInTheLoopFramework hitlFramework;

private final AlertService alertService;

// 风险规则配置

private final Map<String, Double> riskRules = Map.of(

"LARGE_AMOUNT", 10000.0,

"UNUSUAL_TIME", 2.0, // 凌晨2-5点

"NEW_COUNTRY", 7.0, // 7天内首次出现的国家

"VELOCITY", 10.0 // 10分钟内多次交易

);

public FraudDetectionAgent() {

this.hitlFramework = new HumanInTheLoopFramework();

this.alertService = new AlertService();

this.analyzer = AiServices.builder(FraudAnalyzer.class)

.tools(new FraudDetectionTools())

.build();

}

class FraudDetectionTools {

@Tool("检测交易欺诈风险")

public FraudDetectionResult detectFraud(Transaction transaction) {

// 1. 规则引擎检查

RuleCheckResult ruleCheck = checkTransactionRules(transaction);

// 2. AI模型风险评估

AIRiskAssessment aiAssessment = assessWithAI(transaction);

// 3. 综合风险评估

double totalRiskScore = calculateTotalRiskScore(ruleCheck, aiAssessment);

// 4. 决策逻辑

if (totalRiskScore < 30) {

// 低风险,自动批准

return FraudDetectionResult.builder()

.decision("APPROVED")

.riskScore(totalRiskScore)

.automated(true)

.confidence(1 - totalRiskScore / 100)

.build();

} else if (totalRiskScore >= 30 && totalRiskScore < 70) {

// 中等风险,需要人工审核

return escalateToAnalyst(transaction, totalRiskScore,

"MEDIUM_RISK", ruleCheck, aiAssessment);

} else {

// 高风险,立即预警并人工审核

alertService.sendImmediateAlert(transaction);

return escalateToAnalyst(transaction, totalRiskScore,

"HIGH_RISK", ruleCheck, aiAssessment);

}

}

private RuleCheckResult checkTransactionRules(Transaction tx) {

List<String> triggeredRules = new ArrayList<>();

double ruleScore = 0;

// 大额交易检查

if (tx.getAmount().compareTo(BigDecimal.valueOf(riskRules.get("LARGE_AMOUNT"))) > 0) {

triggeredRules.add("LARGE_AMOUNT");

ruleScore += 40;

}

// 异常时间检查(凌晨2-5点)

int hour = tx.getTimestamp().getHour();

if (hour >= 2 && hour <= 5) {

triggeredRules.add("UNUSUAL_TIME");

ruleScore += 30;

}

// 交易速度检查(需要历史数据)

if (checkTransactionVelocity(tx)) {

triggeredRules.add("HIGH_VELOCITY");

ruleScore += 50;

}

return RuleCheckResult.builder()

.triggeredRules(triggeredRules)

.riskScore(ruleScore)

.build();

}

private AIRiskAssessment assessWithAI(Transaction transaction) {

try {

// 使用AI分析交易

String analysis = analyzer.analyzeTransaction(transaction);

// 解析AI输出

return parseAIRiskAssessment(analysis);

} catch (Exception e) {

log.error("AI风险评估失败", e);

return AIRiskAssessment.builder()

.riskScore(50.0) // 出错时默认中等风险

.confidence(0.5)

.build();

}

}

private double calculateTotalRiskScore(RuleCheckResult ruleCheck,

AIRiskAssessment aiAssessment) {

// 加权计算总分

double ruleWeight = 0.4;

double aiWeight = 0.6;

return ruleCheck.getRiskScore() * ruleWeight +

aiAssessment.getRiskScore() * aiWeight;

}

private FraudDetectionResult escalateToAnalyst(Transaction transaction,

double riskScore,

String riskLevel,

RuleCheckResult ruleCheck,

AIRiskAssessment aiAssessment) {

log.info("交易需要人工审核: {}", transaction.getTransactionId());

// 准备审核数据

Map<String, Object> metadata = new HashMap<>();

metadata.put("risk_score", riskScore);

metadata.put("risk_level", riskLevel);

metadata.put("triggered_rules", ruleCheck.getTriggeredRules());

metadata.put("ai_confidence", aiAssessment.getConfidence());

metadata.put("customer_id", transaction.getCustomerId());

metadata.put("amount", transaction.getAmount());

metadata.put("merchant", transaction.getMerchant());

// 提交给人类分析师

HumanTask task = hitlFramework.submitToHuman(

"FRAUD_REVIEW",

transaction.toString(),

metadata

);

// 记录审核轨迹

AuditTrail trail = AuditTrail.builder()

.transactionId(transaction.getTransactionId())

.riskScore(riskScore)

.escalationTime(LocalDateTime.now())

.analystTaskId(task.getTaskId())

.build();

auditTrailRepository.save(trail);

return FraudDetectionResult.builder()

.decision(task.getHumanDecision())

.riskScore(riskScore)

.humanReviewed(true)

.analystComments(task.getComments())

.taskId(task.getTaskId())

.escalationReason("风险评分超过阈值: " + riskScore)

.build();

}

@Tool("批量交易审核")

public BatchFraudResult batchDetect(List<Transaction> transactions) {

List<FraudDetectionResult> results = new ArrayList<>();

List<Transaction> escalatedTransactions = new ArrayList<>();

for (Transaction tx : transactions) {

FraudDetectionResult result = detectFraud(tx);

results.add(result);

if (result.isHumanReviewed()) {

escalatedTransactions.add(tx);

}

}

// 生成摘要报告

String summary = generateBatchSummary(results);

return BatchFraudResult.builder()

.results(results)

.totalTransactions(transactions.size())

.escalatedCount(escalatedTransactions.size())

.escalatedTransactions(escalatedTransactions)

.summary(summary)

.build();

}

private boolean checkTransactionVelocity(Transaction tx) {

// 简化实现:检查近期交易频率

// 实际实现会查询历史交易数据

return false;

}

}

// 数据类

@Builder

@Data

static class Transaction {

private String transactionId;

private String customerId;

private BigDecimal amount;

private String merchant;

private String country;

private LocalDateTime timestamp;

private String paymentMethod;

}

@Builder

@Data

static class FraudDetectionResult {

private String decision; // APPROVED, REJECTED, PENDING, ESCALATED

private double riskScore;

private boolean automated;

private boolean humanReviewed;

private String analystComments;

private String taskId;

private String escalationReason;

private double confidence;

}

@Builder

@Data

static class RuleCheckResult {

private List<String> triggeredRules;

private double riskScore;

}

@Builder

@Data

static class AIRiskAssessment {

private double riskScore;

private double confidence;

private String rationale;

}

}4. 客户支持场景实现

java

import dev.langchain4j.agent.tool.Tool;

import dev.langchain4j.service.AiServices;

import dev.langchain4j.service.SystemMessage;

import lombok.extern.slf4j.Slf4j;

import java.util.*;

import java.util.concurrent.ConcurrentHashMap;

@Slf4j

public class CustomerSupportAgent {

interface SupportAssistant {

@SystemMessage("你是一个客户支持助手,处理常规问题。如果遇到复杂问题,请转接给人工客服。")

String handleCustomerQuery(String query, String customerId);

}

private final SupportAssistant assistant;

private final HumanInTheLoopFramework hitlFramework;

private final SentimentAnalyzer sentimentAnalyzer;

// 复杂问题关键词

private final Set<String> complexKeywords = Set.of(

"投诉", "退款", "赔偿", "法律", "合同", "起诉",

"complain", "refund", "compensation", "legal", "sue"

);

// 客户情绪跟踪

private final Map<String, CustomerSentiment> customerSentiments =

new ConcurrentHashMap<>();

public CustomerSupportAgent() {

this.hitlFramework = new HumanInTheLoopFramework();

this.sentimentAnalyzer = new SentimentAnalyzer();

this.assistant = AiServices.builder(SupportAssistant.class)

.chatLanguageModel(OpenAiChatModel.builder()

.apiKey(System.getenv("OPENAI_API_KEY"))

.build())

.chatMemoryProvider(customerId -> MessageWindowChatMemory.withMaxMessages(20))

.tools(new SupportTools())

.build();

}

class SupportTools {

@Tool("处理客户查询")

public SupportResponse handleQuery(String query, String customerId) {

// 1. 情绪分析

SentimentResult sentiment = analyzeSentiment(query, customerId);

// 2. 复杂性判断

ComplexityAssessment complexity = assessComplexity(query);

// 3. AI初步响应

String aiResponse = generateAIResponse(query, customerId);

// 4. 决定是否转人工

if (shouldEscalateToHuman(sentiment, complexity, aiResponse)) {

return escalateToHumanAgent(query, customerId,

sentiment, complexity, aiResponse);

} else {

// AI可以处理

return SupportResponse.builder()

.response(aiResponse)

.automated(true)

.escalated(false)

.confidence(complexity.getConfidence())

.sentimentLevel(sentiment.getLevel())

.build();

}

}

private SentimentResult analyzeSentiment(String query, String customerId) {

// 使用情感分析模型

double sentimentScore = sentimentAnalyzer.analyze(query);

String level = getSentimentLevel(sentimentScore);

// 更新客户情绪历史

CustomerSentiment history = customerSentiments

.computeIfAbsent(customerId, k -> new CustomerSentiment(customerId));

history.addSentimentScore(sentimentScore);

return SentimentResult.builder()

.score(sentimentScore)

.level(level)

.trend(history.getTrend())

.build();

}

private ComplexityAssessment assessComplexity(String query) {

// 关键词检测

boolean hasComplexKeyword = complexKeywords.stream()

.anyMatch(query::contains);

// 查询长度和结构

int wordCount = query.split("\\s+").length;

boolean isComplexQuery = wordCount > 50 || hasComplexKeyword;

// AI置信度评估

double confidence = estimateConfidence(query);

return ComplexityAssessment.builder()

.complex(isComplexQuery)

.hasComplexKeyword(hasComplexKeyword)

.wordCount(wordCount)

.confidence(confidence)

.build();

}

private String generateAIResponse(String query, String customerId) {

try {

return assistant.handleCustomerQuery(query, customerId);

} catch (Exception e) {

log.error("AI响应生成失败", e);

return "我遇到了技术问题,正在为您转接人工客服...";

}

}

private boolean shouldEscalateToHuman(SentimentResult sentiment,

ComplexityAssessment complexity,

String aiResponse) {

// 转人工条件判断

return

// 负面情绪

"NEGATIVE".equals(sentiment.getLevel()) ||

"VERY_NEGATIVE".equals(sentiment.getLevel()) ||

// 复杂问题

complexity.isComplex() ||

// AI低置信度

complexity.getConfidence() < 0.6 ||

// AI响应包含不确定性

aiResponse.contains("抱歉") ||

aiResponse.contains("不确定") ||

aiResponse.contains("需要人工") ||

// 情绪趋势恶化

"WORSENING".equals(sentiment.getTrend());

}

private SupportResponse escalateToHumanAgent(String query,

String customerId,

SentimentResult sentiment,

ComplexityAssessment complexity,

String aiResponse) {

log.info("转接人工客服: 客户 {}, 情绪 {}", customerId, sentiment.getLevel());

// 准备转接数据

Map<String, Object> metadata = new HashMap<>();

metadata.put("customer_id", customerId);

metadata.put("sentiment_score", sentiment.getScore());

metadata.put("sentiment_level", sentiment.getLevel());

metadata.put("complexity_score", complexity.getConfidence());

metadata.put("ai_pre_response", aiResponse);

metadata.put("query_complexity", complexity.isComplex());

// 创建人工客服任务

HumanTask task = hitlFramework.submitToHuman(

"CUSTOMER_SUPPORT",

query,

metadata

);

// 记录转接信息

SupportHandoff handoff = SupportHandoff.builder()

.customerId(customerId)

.originalQuery(query)

.aiResponse(aiResponse)

.escalationReason("自动转接: " + getEscalationReason(sentiment, complexity))

.humanAgentId(task.getTaskId())

.timestamp(System.currentTimeMillis())

.build();

handoffRepository.save(handoff);

// 返回转接响应

String transferMessage = String.format(

"我注意到您的问题可能需要人工客服帮助。正在为您转接,请稍候。\n" +

"(转接原因:%s)",

getEscalationReason(sentiment, complexity)

);

return SupportResponse.builder()

.response(transferMessage)

.automated(false)

.escalated(true)

.humanTaskId(task.getTaskId())

.sentimentLevel(sentiment.getLevel())

.escalationReason(getEscalationReason(sentiment, complexity))

.build();

}

@Tool("处理对话流")

public ConversationResult handleConversation(ConversationSession session) {

List<SupportResponse> responses = new ArrayList<>();

boolean escalated = false;

String humanTaskId = null;

for (CustomerMessage message : session.getMessages()) {

SupportResponse response = handleQuery(

message.getContent(),

session.getCustomerId()

);

responses.add(response);

if (response.isEscalated()) {

escalated = true;

humanTaskId = response.getHumanTaskId();

break; // 已转人工,结束对话

}

}

return ConversationResult.builder()

.responses(responses)

.escalated(escalated)

.humanTaskId(humanTaskId)

.customerId(session.getCustomerId())

.conversationId(session.getSessionId())

.build();

}

}

// 辅助方法

private String getSentimentLevel(double score) {

if (score >= 0.7) return "POSITIVE";

if (score >= 0.3) return "NEUTRAL";

if (score >= 0.1) return "SLIGHTLY_NEGATIVE";

if (score >= -0.3) return "NEGATIVE";

return "VERY_NEGATIVE";

}

private double estimateConfidence(String query) {

// 简化实现:基于查询长度和关键词

if (query.length() < 20) return 0.9;

if (query.length() < 50) return 0.7;

if (query.length() < 100) return 0.5;

return 0.3;

}

private String getEscalationReason(SentimentResult sentiment,

ComplexityAssessment complexity) {

List<String> reasons = new ArrayList<>();

if ("NEGATIVE".equals(sentiment.getLevel()) ||

"VERY_NEGATIVE".equals(sentiment.getLevel())) {

reasons.add("客户情绪负面");

}

if (complexity.isComplex()) {

reasons.add("问题复杂");

}

if (complexity.getConfidence() < 0.6) {

reasons.add("AI置信度低");

}

return String.join(",", reasons);

}

// 数据类

@Builder

@Data

static class SupportResponse {

private String response;

private boolean automated;

private boolean escalated;

private String humanTaskId;

private double confidence;

private String sentimentLevel;

private String escalationReason;

}

@Builder

@Data

static class SentimentResult {

private double score;

private String level;

private String trend;

}

@Builder

@Data

static class ComplexityAssessment {

private boolean complex;

private boolean hasComplexKeyword;

private int wordCount;

private double confidence;

}

@Builder

@Data

static class ConversationSession {

private String sessionId;

private String customerId;

private List<CustomerMessage> messages;

private LocalDateTime startTime;

}

}5. 人类操作员服务实现

java

import lombok.extern.slf4j.Slf4j;

import org.springframework.boot.SpringApplication;

import org.springframework.boot.autoconfigure.SpringBootApplication;

import org.springframework.web.bind.annotation.*;

import java.util.List;

import java.util.Map;

import java.util.concurrent.BlockingQueue;

@Slf4j

@SpringBootApplication

@RestController

@RequestMapping("/api/human-operator")

public class HumanOperatorService {

private final BlockingQueue<HumanTask> taskQueue;

private final TaskAssignmentService assignmentService;

public HumanOperatorService(BlockingQueue<HumanTask> taskQueue) {

this.taskQueue = taskQueue;

this.assignmentService = new TaskAssignmentService();

}

/**

* 人类操作员API接口

*/

@GetMapping("/tasks/pending")

public List<HumanTask> getPendingTasks(

@RequestParam(defaultValue = "10") int limit,

@RequestParam(required = false) String taskType) {

return assignmentService.getPendingTasks(limit, taskType);

}

@GetMapping("/tasks/{taskId}")

public HumanTask getTaskDetails(@PathVariable String taskId) {

return assignmentService.getTask(taskId);

}

@PostMapping("/tasks/{taskId}/claim")

public HumanTask claimTask(@PathVariable String taskId,

@RequestBody OperatorClaimRequest request) {

String operatorId = request.getOperatorId();

log.info("操作员 {} 认领任务 {}", operatorId, taskId);

return assignmentService.claimTask(taskId, operatorId);

}

@PostMapping("/tasks/{taskId}/complete")

public HumanTask completeTask(@PathVariable String taskId,

@RequestBody TaskCompletionRequest request) {

log.info("完成任务 {},决策: {}", taskId, request.getDecision());

HumanTask task = assignmentService.completeTask(

taskId,

request.getDecision(),

request.getComments(),

request.getMetadata()

);

// 通知AI系统任务完成

notifyAISystem(task);

return task;

}

@PostMapping("/tasks/{taskId}/escalate")

public HumanTask escalateTask(@PathVariable String taskId,

@RequestBody EscalationRequest request) {

log.info("任务 {} 升级给专家: {}", taskId, request.getExpertType());

return assignmentService.escalateTask(

taskId,

request.getExpertType(),

request.getReason()

);

}

/**

* 人类操作员控制台界面(简化示例)

*/

@GetMapping("/console")

public String getOperatorConsole() {

return """

<!DOCTYPE html>

<html>

<head>

<title>人机协同操作台</title>

<style>

body { font-family: Arial, sans-serif; margin: 20px; }

.task-card { border: 1px solid #ddd; padding: 15px; margin: 10px 0; }

.high-priority { border-left: 5px solid #ff6b6b; }

.medium-priority { border-left: 5px solid #ffd93d; }

.low-priority { border-left: 5px solid #6bcf7f; }

.btn { padding: 8px 16px; margin: 5px; cursor: pointer; }

</style>

</head>

<body>

<h1>人机协同操作台</h1>

<div id="tasks-container">

<h3>待处理任务</h3>

<div id="pending-tasks"></div>

</div>

<script>

async function loadTasks() {

const response = await fetch('/api/human-operator/tasks/pending?limit=20');

const tasks = await response.json();

const container = document.getElementById('pending-tasks');

container.innerHTML = '';

tasks.forEach(task => {

const taskElement = document.createElement('div');

taskElement.className = 'task-card ' + getPriorityClass(task.priority);

taskElement.innerHTML = `

<h4>${task.taskType} - ${task.taskId}</h4>

<p>${task.content.substring(0, 100)}...</p>

<p><small>创建时间: ${new Date(task.timestamp).toLocaleString()}</small></p>

<button class="btn" onclick="claimTask('${task.taskId}')">认领</button>

<button class="btn" onclick="viewDetails('${task.taskId}')">查看详情</button>

`;

container.appendChild(taskElement);

});

}

function getPriorityClass(priority) {

switch(priority) {

case 'HIGH': return 'high-priority';

case 'MEDIUM': return 'medium-priority';

default: return 'low-priority';

}

}

async function claimTask(taskId) {

const response = await fetch(`/api/human-operator/tasks/\${taskId}/claim`, {

method: 'POST',

headers: {'Content-Type': 'application/json'},

body: JSON.stringify({operatorId: 'operator_123'})

});

if (response.ok) {

alert('任务认领成功');

loadTasks();

}

}

// 每30秒刷新一次

setInterval(loadTasks, 30000);

window.onload = loadTasks;

</script>

</body>

</html>

""";

}

private void notifyAISystem(HumanTask completedTask) {

// 通知等待该任务的AI Agent

// 实际实现会使用消息队列或回调机制

log.info("任务完成通知: {}", completedTask.getTaskId());

}

// 请求/响应类

@Data

static class OperatorClaimRequest {

private String operatorId;

private String operatorName;

private String department;

}

@Data

static class TaskCompletionRequest {

private String decision;

private String comments;

private Map<String, Object> metadata;

private Double processingTime;

}

@Data

static class EscalationRequest {

private String expertType;

private String reason;

private String targetDepartment;

}

public static void main(String[] args) {

SpringApplication.run(HumanOperatorService.class, args);

}

}6. 监控与仪表板

java

import lombok.extern.slf4j.Slf4j;

import org.springframework.web.bind.annotation.*;

import java.time.LocalDateTime;

import java.util.*;

import java.util.concurrent.ConcurrentHashMap;

import java.util.concurrent.atomic.AtomicLong;

@Slf4j

@RestController

@RequestMapping("/api/monitoring")

public class HITLMonitoringService {

private final Map<String, PerformanceMetrics> agentMetrics =

new ConcurrentHashMap<>();

private final Map<String, TaskMetrics> taskTypeMetrics =

new ConcurrentHashMap<>();

private final AtomicLong totalTasks = new AtomicLong(0);

@GetMapping("/dashboard")

public DashboardData getDashboard() {

return DashboardData.builder()

.timestamp(LocalDateTime.now())

.totalTasksProcessed(totalTasks.get())

.activeAgents(agentMetrics.size())

.performanceMetrics(calculateOverallMetrics())

.taskDistribution(getTaskDistribution())

.escalationRate(calculateEscalationRate())

.averageProcessingTime(calculateAverageProcessingTime())

.build();

}

@GetMapping("/agent/{agentId}/metrics")

public AgentMetrics getAgentMetrics(@PathVariable String agentId) {

PerformanceMetrics metrics = agentMetrics.get(agentId);

if (metrics == null) {

return AgentMetrics.empty(agentId);

}

return AgentMetrics.builder()

.agentId(agentId)

.totalTasks(metrics.getTotalTasks())

.automatedTasks(metrics.getAutomatedTasks())

.escalatedTasks(metrics.getEscalatedTasks())

.successRate(metrics.getSuccessRate())

.averageConfidence(metrics.getAverageConfidence())

.build();

}

@PostMapping("/record")

public void recordTaskCompletion(@RequestBody TaskRecord record) {

totalTasks.incrementAndGet();

// 更新Agent指标

PerformanceMetrics agentMetric = agentMetrics.computeIfAbsent(

record.getAgentId(),

k -> new PerformanceMetrics()

);

agentMetric.recordTask(record);

// 更新任务类型指标

TaskMetrics taskMetric = taskTypeMetrics.computeIfAbsent(

record.getTaskType(),

k -> new TaskMetrics()

);

taskMetric.recordTask(record);

log.info("任务记录: {} - {} - {}",

record.getTaskType(),

record.getDecision(),

record.getProcessingTime());

}

private OverallMetrics calculateOverallMetrics() {

long total = totalTasks.get();

long automated = agentMetrics.values().stream()

.mapToLong(PerformanceMetrics::getAutomatedTasks)

.sum();

long escalated = agentMetrics.values().stream()

.mapToLong(PerformanceMetrics::getEscalatedTasks)

.sum();

return OverallMetrics.builder()

.totalTasks(total)

.automatedTasks(automated)

.humanReviewedTasks(total - automated)

.escalatedTasks(escalated)

.automationRate(total > 0 ? (double) automated / total : 0)

.escalationRate(total > 0 ? (double) escalated / total : 0)

.build();

}

// 数据类

@Data

@Builder

static class DashboardData {

private LocalDateTime timestamp;

private long totalTasksProcessed;

private int activeAgents;

private OverallMetrics performanceMetrics;

private Map<String, Long> taskDistribution;

private double escalationRate;

private double averageProcessingTime;

private List<Alert> activeAlerts;

}

@Data

@Builder

static class OverallMetrics {

private long totalTasks;

private long automatedTasks;

private long humanReviewedTasks;

private long escalatedTasks;

private double automationRate;

private double escalationRate;

}

@Data

static class TaskRecord {

private String taskId;

private String agentId;

private String taskType;

private String decision;

private boolean automated;

private boolean escalated;

private double confidence;

private Long processingTime; // 毫秒

private LocalDateTime completionTime;

}

}7. 配置示例

XML

# application-hitel.yml

hitl:

# 人工任务配置

human-tasks:

queue-capacity: 1000

max-wait-time: 300000 # 5分钟

priority-levels:

- CRITICAL

- HIGH

- MEDIUM

- LOW

# 转人工阈值配置

escalation-thresholds:

confidence: 0.6

sentiment-negative: 0.3

risk-score: 30.0

query-complexity: 50 # 字数

# 人类操作员配置

operators:

min-online: 3

max-tasks-per-operator: 10

shift-schedule:

- start: "09:00"

end: "18:00"

operators: 5

- start: "18:00"

end: "09:00"

operators: 2

# 监控配置

monitoring:

metrics-collection-interval: 60 # 秒

alert-thresholds:

escalation-rate: 0.3

automation-rate: 0.7

avg-processing-time: 300000 # 5分钟

# 隐私与安全

privacy:

data-masking-enabled: true

retention-days: 90

anonymization-fields:

- customerId

- phone

- email

- address使用示例

java

public class HITLDemo {

public static void main(String[] args) {

// 1. 初始化内容审核Agent

ContentModerationAgent moderationAgent = new ContentModerationAgent();

// 模拟内容审核

List<String> contents = Arrays.asList(

"这是一篇正常的文章。",

"这篇文章包含一些敏感词汇,需要审核。",

"明显的垃圾广告内容,请立即删除!"

);

BatchModerationResult result = moderationAgent.batchModerate(contents);

System.out.println("审核结果:");

System.out.println("自动处理: " + result.getAutomatedCount());

System.out.println("需要人工审核: " + result.getHumanReviewCount());

// 2. 金融欺诈检测

FraudDetectionAgent fraudAgent = new FraudDetectionAgent();

Transaction transaction = Transaction.builder()

.transactionId("TX123456")

.customerId("CUST001")

.amount(new BigDecimal("15000.00"))

.merchant("Unknown Merchant")

.country("New Country")

.timestamp(LocalDateTime.now())

.build();

FraudDetectionResult fraudResult = fraudAgent.detectFraud(transaction);

System.out.println("\n欺诈检测结果:");

System.out.println("决策: " + fraudResult.getDecision());

System.out.println("风险评分: " + fraudResult.getRiskScore());

System.out.println("人工审核: " + fraudResult.isHumanReviewed());

// 3. 客户支持

CustomerSupportAgent supportAgent = new CustomerSupportAgent();

SupportResponse supportResponse = supportAgent.handleQuery(

"我对你们的服务非常不满意,要求立即退款并赔偿损失!",

"CUST002"

);

System.out.println("\n客户支持结果:");

System.out.println("响应: " + supportResponse.getResponse());

System.out.println("是否转人工: " + supportResponse.isEscalated());

System.out.println("转接原因: " + supportResponse.getEscalationReason());

}

}关键实现特性总结

-

分层决策架构:

-

AI自主决策层(高置信度场景)

-

规则引擎层(基于业务规则)

-

人工审核层(边界案例和风险场景)

-

-

智能任务路由:

-

基于风险、置信度、情绪等多维度评分

-

优先级队列管理

-

负载均衡分配

-

-

实时监控与反馈:

-

全面的指标收集

-

可视化仪表板

-

自动化预警机制

-

-

隐私与安全:

-

数据脱敏处理

-

访问控制

-

审计日志

-

-

LangChain4j集成:

-

利用工具调用实现人机切换

-

内存管理维护对话上下文

-

模型抽象支持多AI后端

-

这个实现展示了如何在实际业务系统中构建人机协同机制,既充分利用AI的效率优势,又确保关键决策的人类监督与最终控制权。

结论

本文探讨了至关重要的人机协同(HITL)模式,强调了其在创建强大、安全和道德的 AI 系统中的作用。我们讨论了如何将人类监督、干预和反馈整合到 Agent 工作流中可以显著增强其性能和可信度,特别是在复杂和 敏感的领域中。实际应用展示了 HITL 的广泛实用性,从内容审核到自动驾驶和客户支持。随着 AI 能力不断进步,HITL 仍然是负 责任的 AI 开发的基石,确保人类价值观和专业知识在智能系统设计中保持核心地位。