引言

在工业 4.0 的浪潮下,视觉检测(Visual Inspection)已成为智能制造的标配。然而,传统的云端推理方案在工厂环境下往往面临网络带宽昂贵、延迟不可控、数据隐私泄露等重重阻碍。

我们发现越来越多的客户开始寻求"云边协同"的解法。本文将深度拆解如何利用 AWS IoT Greengrass 2.0,将强大的 AI 能力部署到产线边缘,实现毫秒级的缺陷检测。

视觉检测的基本原理

一套典型的边缘视觉检测流程包括:

- 图像采集: 通过工业相机捕获帧。

- 预处理: 利用 OpenCV 进行去噪、对比度调整和尺寸缩放。

- 深度推理: 通过 目标检测(Object Detection) 识别缺陷位置,再通过 图像分类(Classification) 判定缺陷类型。

- 业务后处理: 根据置信度分数触发 PLC 执行物理剔除。

1. 核心引擎:什么是 AWS IoT Greengrass?

AWS IoT Greengrass 是一款开源的物联网边缘运行时(Runtime)和云服务。简单来说,它把 AWS 的计算、消息传递、数据缓存和机器学习推理能力,从云端"延伸"到了工厂现场的物理设备上。

1.1 关键组件:

- Nucleus(内核): 边缘侧的"大脑",管理组件生命周期、安全认证及本地通信。

- Stream Manager(流管理器): 工业数据的"缓冲池",支持在断网情况下本地缓存数据,并根据带宽自动同步至 S3。

- ML Inference Components: 集成了 DLR 或 ONNX Runtime 的推理环境,负责加载并运行 AI 模型。

- Local Resource Access: 允许组件安全地访问硬件资源(如 GPU、工业相机 /dev/video0、PLC 接口等)。

1.2 关键功能与技术

- 组件化架构 (Components): Greengrass v2 引入了模块化设计。你可以像搭积木一样,将 Python 脚本、Docker 容器或 Lambda 函数打包成组件,一键分发到成百上千台边缘网关。

- 本地推理 (Local Inference): 支持在本地运行由 SageMaker 训练的模型(如 TensorFlow, PyTorch, MXNet),通过 DLR 或 TVM 优化,直接调用边缘硬件(如 NVIDIA Jetson, Intel OpenVINO)的 GPU/TPU 加速。

- 本地交互与流管理: 即使断网,边缘设备也能通过本地 MQTT 协议进行通信,并通过 Stream Manager 自动处理数据的临时存储和断点续传。

2. 行业透视:智能工厂的转型之痛

2.1 发展趋势

2026 年的工厂正从"自动化"转向"自主化"。AI 代理(AI Agents)开始介入实时决策,生产线要求检测系统具备亚秒级的响应能力。

2.2 面临的挑战

- 低延迟需求: 高速生产线(如每秒检测 10 个零件)要求判定延迟在毫秒级,云端往返(Round-trip)无法满足。

- 带宽压力: 24 小时监控产生的 4K 视频流全量上云,月度带宽费用可能超过生产成本。

- 离线生存: 工厂网络一旦中断,生产线不能停工,系统必须具备本地自主决策能力。

3. 落地方案:云边协同 AI 检测架构设计

3.1 方案设计原理

采用 "云端训练 (Training) + 边缘推理 (Inference)" 的双环逻辑。云端负责算力密集型的模型迭代,边缘负责低延迟的实时判定。

3.2 方案介绍

关键服务技术链路

- 数据采集: 工业相机通过 RTSP 或 SDK 将视频流推送到边缘网关。

- 模型优化(SageMaker Neo): 在云端完成模型训练后,使用 SageMaker Neo 将模型编译为针对特定硬件(如 ARM 或 x86)优化的版本,体积更小,速度快 25 倍。

- 边缘部署(Greengrass):

- Nucleus: 负责核心调度。

- ML Installer & Inference Component: 自动下载模型并启动推理引擎。

- Lambda Component: 负责逻辑预处理(如裁剪图片、格式转换)。

- 闭环反馈: 推理结果通过 IoT Core 上报看板,而那些"不确定"的边界案例(Edge Cases)会被自动上传至 S3,触发云端的自动重训练(Active Learning)。

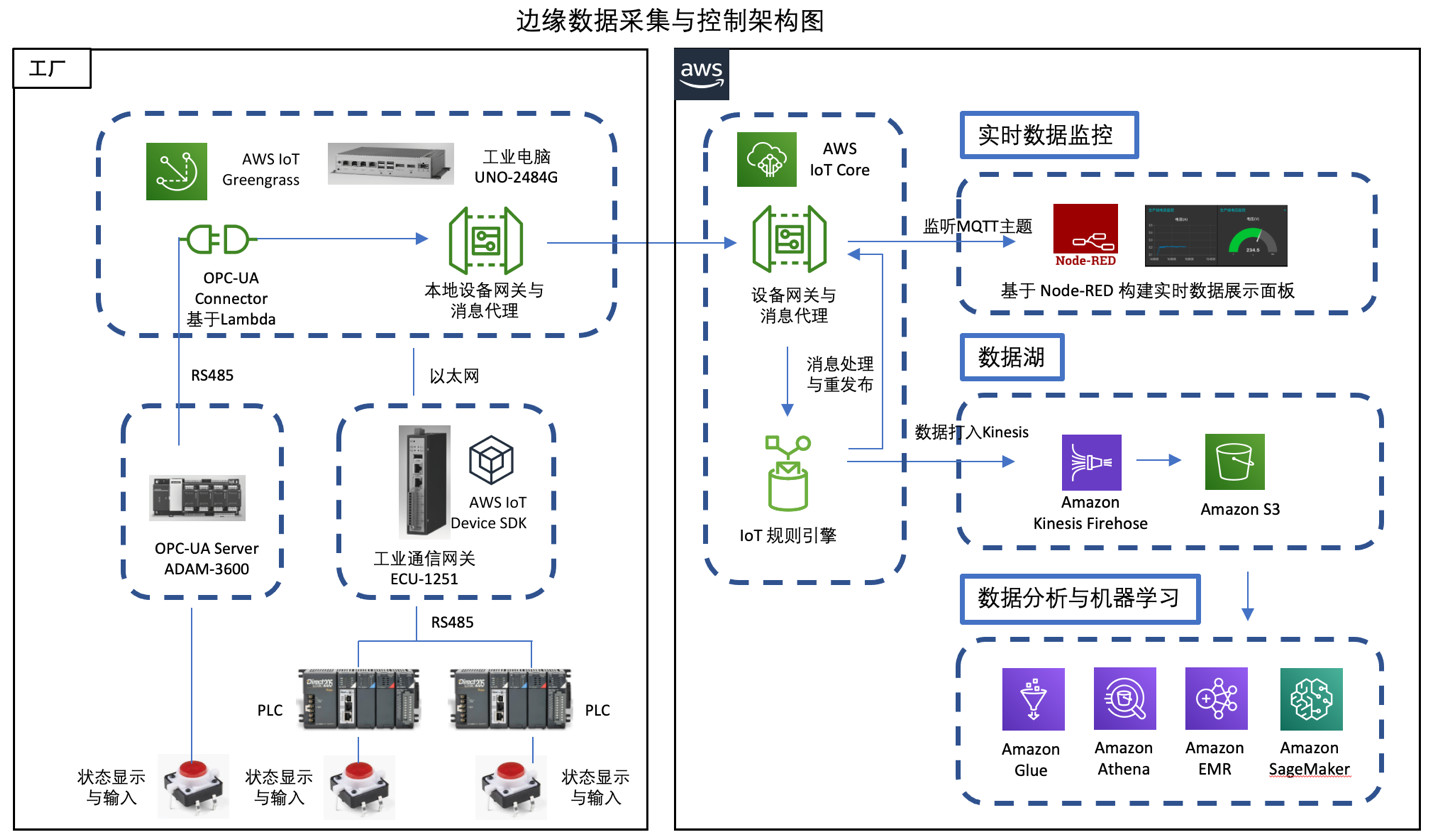

架构示例

图片来自:快速落地AWS智能工厂解决方案

SageMaker Neo (边缘侧的"性能倍增器")是一款模型编译器。它的核心使命是:让 AI 模型在不损失精度的前提下,在各种边缘硬件上跑得更快、占内存更小。

1)工作原理:

- 模型编译 (Compilation): 传统的模型包含大量通用的、冗余的计算逻辑。Neo 会自动优化这些算子,将其转换为特定硬件(如 ARM、NVIDIA GPU、Intel CPU)能直接执行的高效机器码。

- 运行时优化 (Runtime): 它提供了一个体积极其精简的运行时(只有几 MB),取代了动辄数百 MB 的原生深度学习框架(如完整的 TensorFlow 或 PyTorch)。

2)在智能工厂的优势

- 极致速度: 在同等硬件下,经过 Neo 编译的模型推理速度通常可提升 10-25 倍,这是满足产线"毫秒级"检测要求的关键。

- 节省成本: 它可以让你在更廉价、功耗更低的网关设备上运行复杂的模型,降低了企业的大规模部署成本。

- 跨平台兼容: 你只需训练一次模型,Neo 就能帮你适配 NVIDIA Jetson、树莓派或各类工业网关,避免了为不同硬件重复开发。

4. 方案价值与客户收益

- 极低延迟: 检测逻辑在本地网关运行,响应时间从秒级降至 20ms - 100ms ,匹配高速产线节拍。

- 降本增效: 仅上传结构化结果(如:{status: "defect", type: "scratch"})和少量异常图片,节省 90% 以上的带宽成本。

- 业务连续性: 具备"离线生存"能力。即使外网中断,AI 检测依然正常工作,数据在本地排队,联网后自动同步。

- 安全性: 核心生产数据不出厂,仅在本地处理,符合数据合规与安全要求。

5. 未来展望:2026 之后的工业边缘

随着 生成式 AI (GenAI) 的普及,未来的边缘侧将不再仅仅是"检测缺陷",而是"理解场景"。

- 多模态融合: 结合声音(振动传感器)与视觉,提前预测设备寿命。

- 边缘大模型(Small LLMs): 现场工人可以通过自然语言与 Greengrass 设备对话,询问"为什么最近 1 小时良率下降?"

- 更强的自主性: 设备将具备更强的自我修复和参数自动调整能力。