目录

1.程序功能描述

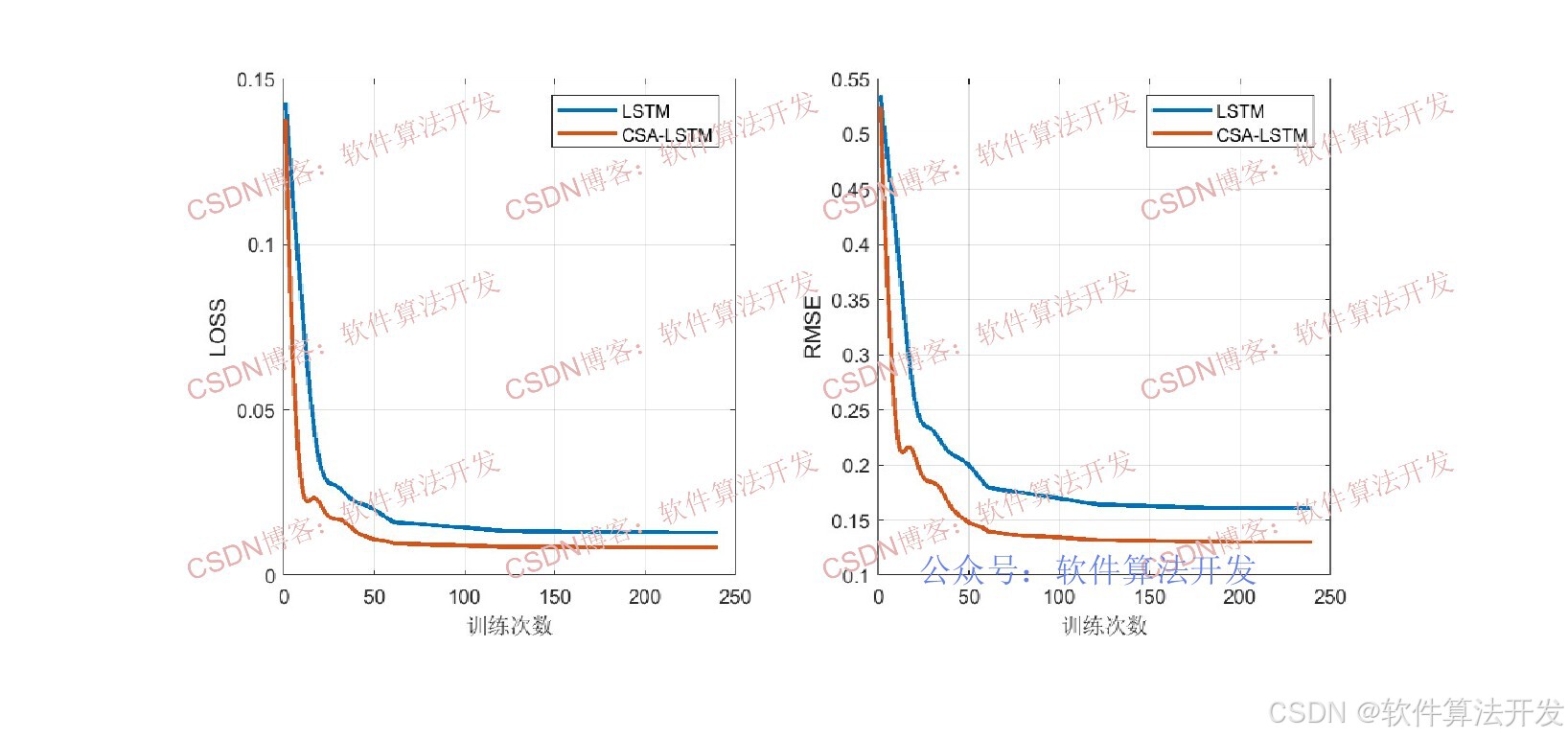

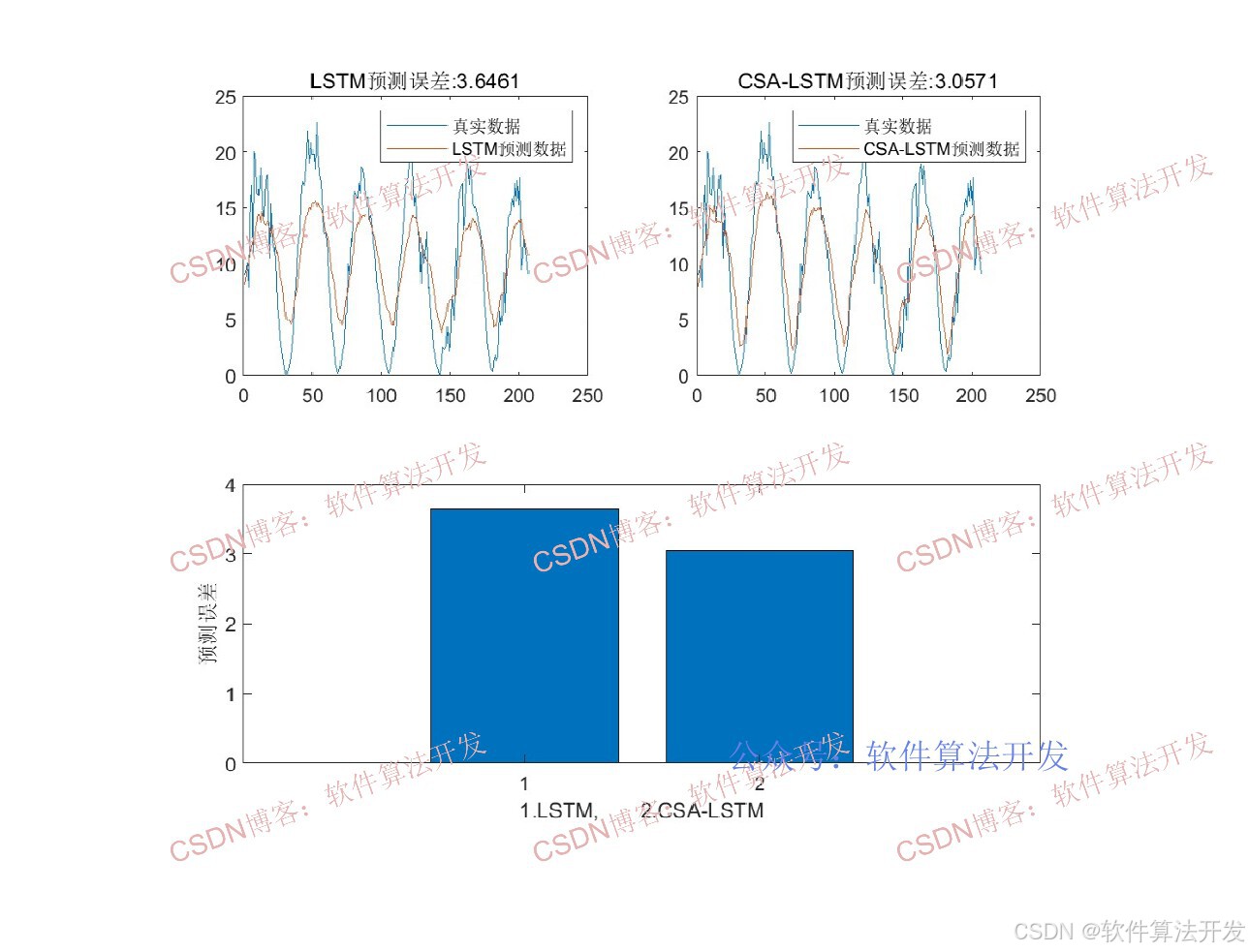

CSA-LSTM算法是将卷尾猴优化算法(Capuchin Search Algorithm, CSA)与长短期记忆网络(Long Short-Term Memory, LSTM)相结合的时间序列预测模型,核心是利用CSA优化LSTM的隐藏层神经元数量,解决LSTM超参数凭经验设定导致的预测精度不足问题,适用于一维连续时间序列的回归预测。

2.测试软件版本以及运行结果展示

MATLAB2022A/MATLAB2024B版本运行

3.部分程序

...............................................................................

% 将优化得到的最佳参数转换为整数,作为LSTM隐藏层神经元数量

% 加1是为了确保至少有1个神经元

NN=floor(gFoodPos)+1

% 定义LSTM神经网络结构

% 设置网络训练参数

options = trainingOptions('adam', ... % 使用Adam优化器,适合深度学习训练

'MaxEpochs', 240, ... % 最大训练轮数为240

'GradientThreshold', 1, ... % 梯度阈值为1,防止梯度爆炸

'InitialLearnRate', 0.004, ... % 初始学习率为0.004

'LearnRateSchedule', 'piecewise', ...% 学习率调度方式为分段衰减

'LearnRateDropPeriod', 60, ... % 每60轮衰减一次学习率

'LearnRateDropFactor',0.2, ... % 学习率衰减因子为0.2(变为原来的20%)

'L2Regularization', 0.01, ... % L2正则化系数为0.01,防止过拟合

'ExecutionEnvironment', 'gpu',... % 使用GPU加速训练(需配置GPU支持)

'Verbose', 0, ... % 不显示训练过程细节

'Plots', 'training-progress'); % 显示训练进度图表(损失变化等)

% 训练LSTM网络

[net,INFO] = trainNetwork(Pxtrain, Txtrain, layers, options);

% 使用训练好的网络进行预测

Dat_yc1 = predict(net, Pxtrain); % 对训练数据进行预测(归一化尺度)

Dat_yc2 = predict(net, Pxtest); % 对测试数据进行预测(归一化尺度)

% 将预测结果反归一化,恢复到原始数据范围

Datn_yc1 = mapminmax('reverse', Dat_yc1, Norm_O);

Datn_yc2 = mapminmax('reverse', Dat_yc2, Norm_O);

% 将细胞数组转换为矩阵(方便后续处理和分析)

Datn_yc1 = cell2mat(Datn_yc1);

Datn_yc2 = cell2mat(Datn_yc2);

% 保存训练信息、预测结果和收敛曲线到MAT文件,便于后续分析

save R2.mat INFO Datn_yc1 Datn_yc2 T_train T_test cg_curve

1314.算法理论概述

CSA优化原理

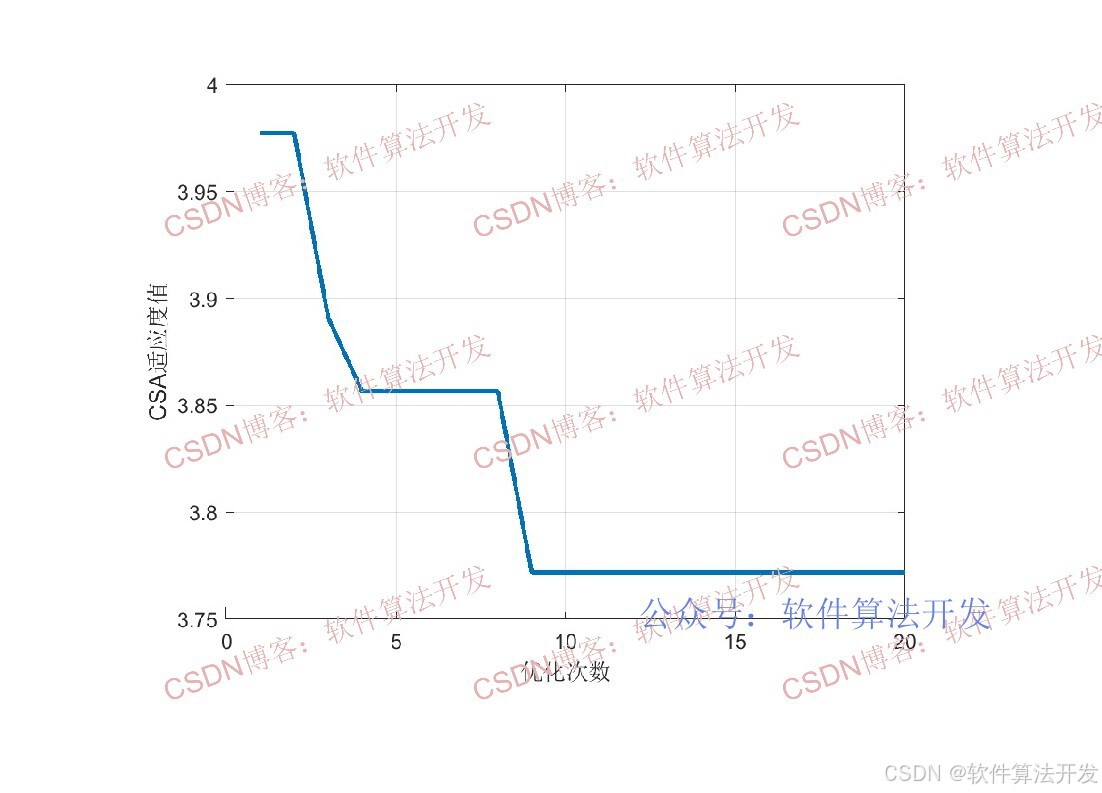

卷尾猴优化算法是模拟卷尾猴自然行为(跳跃、地面移动、摆动、攀爬)的群智能优化算法,通过种群迭代搜索最优解,具有收敛速度快、寻优精度高的特点。此处利用CSA在预设范围内搜索LSTM隐藏层神经元的最优数量,最大化提升LSTM的预测性能。通过多轮迭代更新卷尾猴种群的速度与位置,搜索最优适应度值对应的个体(即LSTM最优隐藏层神经元数量),核心步骤包括速度更新、位置更新、边界约束与适应度更新、全局最优更新。

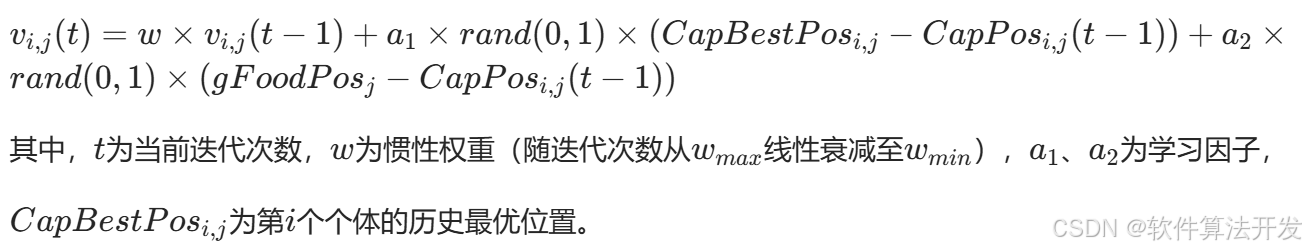

速度更新

速度更新:引入惯性权重w ,结合个体最优位置与全局最优位置更新速度,公式如下:

位置更新

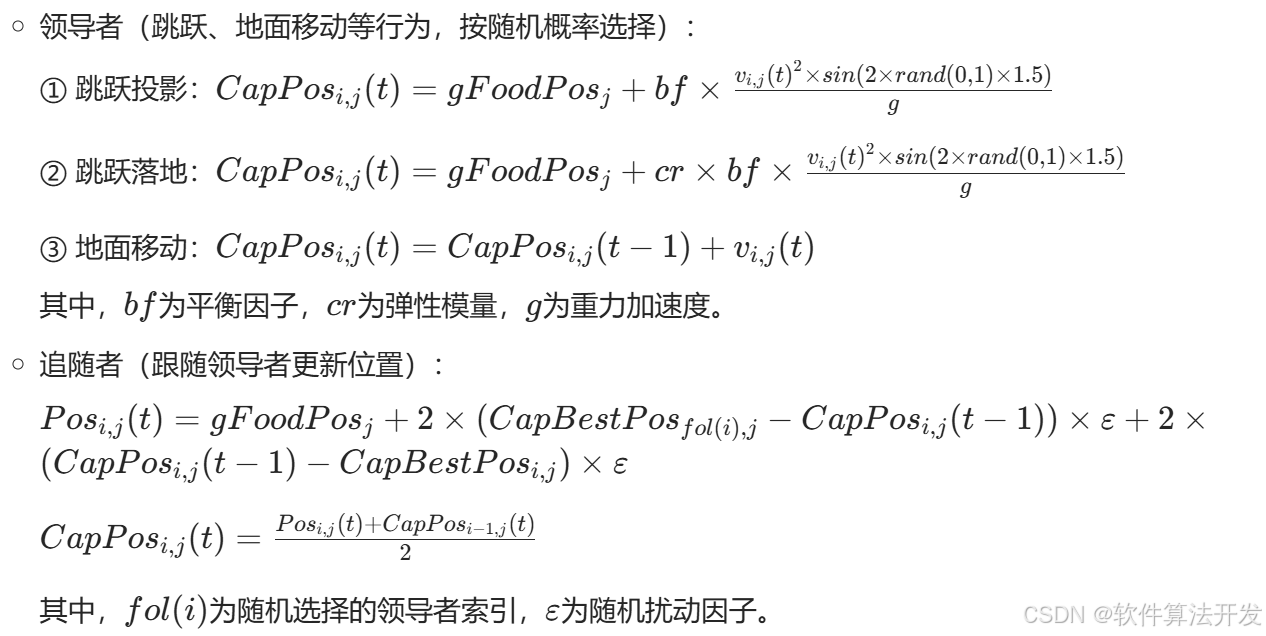

位置更新:模拟卷尾猴的5种行为,分领导者(前Npop/2个个体)与追随者(后Npop/2个个体)分别更新,核心公式如下:

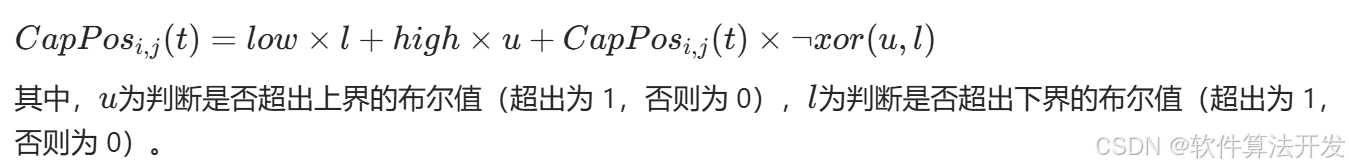

边界约束与适应度更新

边界约束:确保更新后的位置在[low,high]范围内,避免超出寻优空间:

全局最优更新

计算每个个体的适应度值(此处为LSTM的预测误差,如MSE),若当前个体适应度优于历史最优,则更新个体最优位置;若种群最优适应度优于全局最优,则更新全局最优位置。

LSTM网络原理

LSTM是循环神经网络的改进型,通过输入门、遗忘门、输出门和细胞状态解决RNN的长期依赖问题,能够有效提取一维时间序列的时序特征,是时间序列预测的经典深度学习模型。但LSTM的隐藏层神经元数量直接影响模型拟合能力与泛化能力,过多易过拟合、过少易欠拟合。

CSA-LSTM原理

以LSTM的预测误差(如均方误差MSE)作为CSA的适应度函数,通过CSA迭代搜索得到最优神经元数量,再将该参数代入LSTM进行训练与预测,形成"超参数优化→模型训练→时序预测"的闭环。

5.完整程序

VVV

关注后手机上输入程序码:134