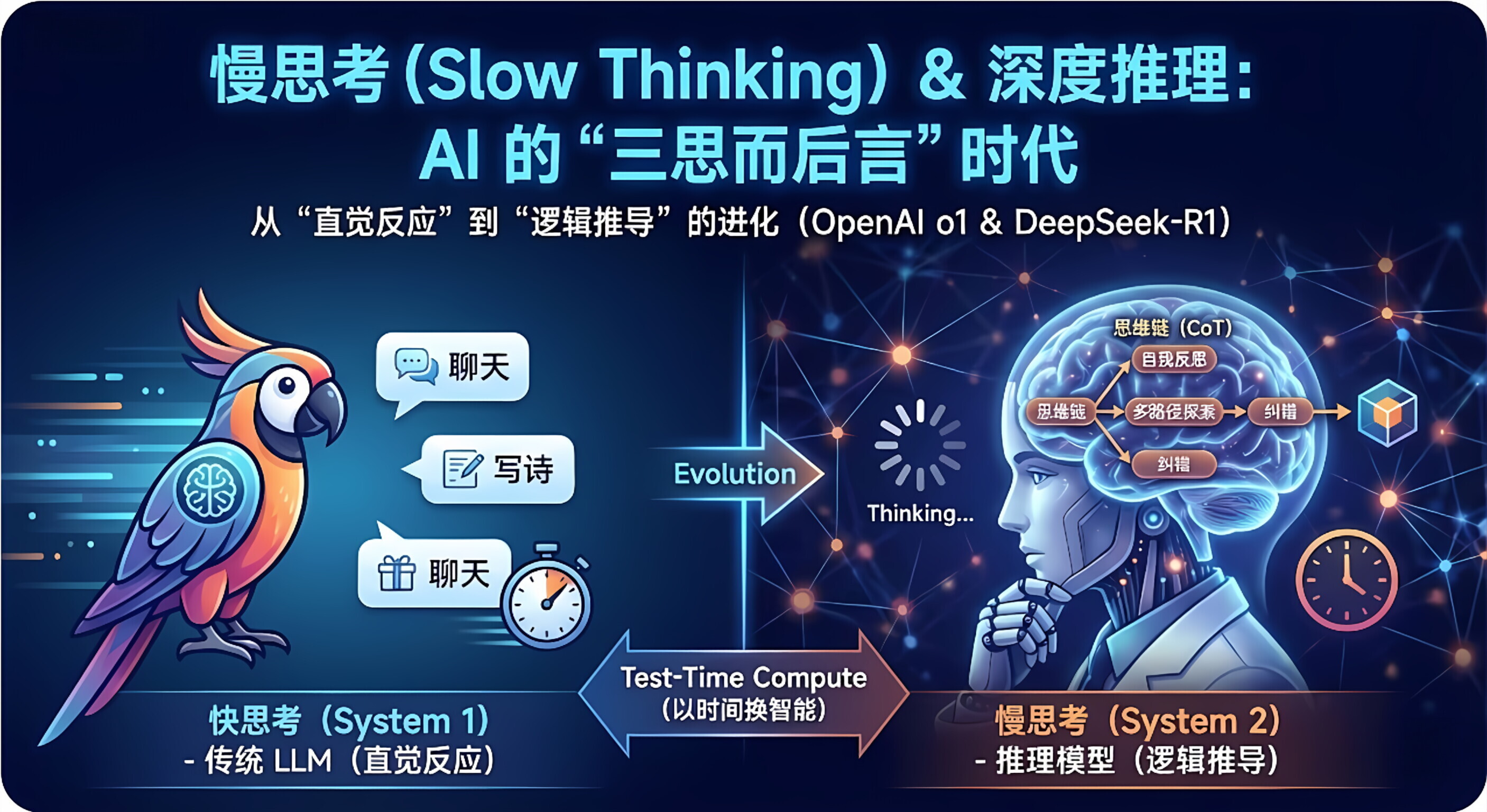

慢思考 (Slow Thinking) 和 深度推理 (Deep Reasoning) 是 2024 年以 OpenAI o1 和 DeepSeek-R1 为代表的新一代大模型所引入的核心概念。

这一概念标志着 AI 从**"靠直觉反应"** 的时代,进入了**"靠逻辑推导"** 的时代。

简单来说:以前的模型是"脱口而出",现在的推理模型是"三思而后言"。

1.🧠 核心比喻:系统 1 vs. 系统 2

为了理解这个概念,我们可以引用诺贝尔奖得主丹尼尔·卡尼曼在《思考,快与慢》中提出的心理学模型:

-

快思考 (System 1) ------ 传统 LLM (如 GPT-4o, Claude 3.5)

-

特点:直觉、快速、下意识。

-

表现:你问"1+1等于几"或者"写首关于春天的诗",它瞬间就能回答。

-

缺陷:容易产生幻觉,遇到复杂的逻辑陷阱容易凭感觉瞎蒙。

-

-

慢思考 (System 2) ------ 推理模型 (Reasoning Models)

-

特点 :逻辑、耗时、深思熟虑、计算。

-

表现 :你问"证明费马大定理"或者"编写一个贪吃蛇游戏",它不会立刻回答。它会先在"脑子"里(你看不到的地方)进行漫长的推演、试错、反思,几十秒后才给出最终答案。

-

2.⚙️ 技术原理:用"时间"换"智能"

所谓的"慢",并不是因为网速卡,而是模型在后台进行了大量的隐式计算 。这一过程被称为 Test-Time Compute (推理侧 算力 )。

深度推理包含以下几个关键步骤:

-

思维链 (Chain of Thought, CoT):

-

模型不再直接预测最终答案,而是强迫自己生成一段长长的"内心独白"。

-

自我反思与纠错 (Self-Correction):

-

这是最关键的一点。普通模型一旦开头错了,就会一条路走到黑。而具备慢思考能力的模型会说:"等等,这个步骤好像推导出矛盾了,我需要回溯,换一种方法试试。"

-

多路径探索 (Search):

-

模型可能会在思维空间中尝试多种解题路径(类似于下围棋的 AlphaGo),然后评估哪条路径最靠谱。

这一过程产生的 Token(思维 Token),通常对用户是不可见的,但正是这些"隐形思考"消耗了时间,换来了准确率。

3.⚖️ 对比:快思考 vs. 慢思考

|------|------------------------------|-------------------------|

| 特性 | 快思考 (标准 LLM) | 慢思考 (推理 LLM) |

| 响应速度 | 极快 (秒回) | 较慢 (可能思考 10-60 秒) |

| 工作模式 | 概率预测 (Next Token Prediction) | 强化学习搜索 (RL Search) + 验证 |

| 擅长任务 | 创意写作、聊天、摘要、翻译 | 数学竞赛、复杂代码、科学研究、逻辑谜题 |

| 用户体验 | 像一个博学的文科生 | 像一个严谨的理科教授 |

| 成本 | 较低 | 较高 (后台生成了大量看不见的 Token) |

4.📈 为什么这很重要?(Scaling Laws 的新篇章)

在"慢思考"出现之前,我们提升模型能力的唯一办法是 Training-Time Compute(训练时算力):花更多的钱,用更多的数据,训练更大的模型。

"慢思考"开启了 Inference-Time Compute (推理时算力)的新篇章:我们可以不改变模型大小,仅仅通过让它"多想一会儿",就能让一个小模型表现得比 大模型 更聪明。

这意味着:智力不仅仅取决于" 脑容量 "(参数量),还取决于"思考时间"。

总结

慢思考与深度推理 是 AI 能够处理高难度、严谨逻辑任务的关键。

它让 AI 摆脱了"只会模仿人类说话"的标签,开始真正具备了"像人类科学家一样解决问题"的能力。当你在使用 OpenAI o1 或 DeepSeek-R1 看到**"Thinking..."** 的状态栏在转圈时,请耐心等待,因为那个 AI 正在为你绞尽脑汁。