2023简直被人工智能相关话题席卷的一年。关于机器学习算法的热度,也再次飙升,网络上一些分享已经比较老了。那么今天借着查询和学习的机会,我也来浅浅分享下目前各种机器学习算法及其应用场景。

为了方便非专业的朋友阅读,我会从算法分类到主流算法举例来展开,预计20分钟的阅读,你会大概对众多繁复的机器学习算法有一个基础认识,了解当下流行的算法应用场景。对于想要入门机器学习的朋友,是一个参考。

算法大解密

究竟算法有哪些?初学者该怎么去理解这些呢?

基于新的教材和理论,算法模型根据学习类型可以分为几个主要类别,每个类别都有其特定的应用场景和优缺点。

监督学习算法:

- 包括线性回归、逻辑回归、支持向量机(SVM)、决策树、随机森林等。

- 优点:在有明确标签的数据上效果好,适用于分类和回归任务。

- 缺点:需要大量标记数据,对未见过的数据可能过拟合。

无监督学习算法:

半监督学习算法:

- 结合了监督学习和无监督学习的特点。比如自训练模型、半监督支持向量机、图基算法、标签传播、生成对抗网络(GANs)等。

- 优点:能够利用未标记数据提高学习效率。

- 缺点:算法复杂,需要精心设计以充分利用未标记数据。

强化学习算法:

深度学习算法:

- 包括卷积神经网络(CNN)、递归神经网络(RNN)、长短期记忆网络(LSTM)、变换器(Transformer)等。

- 优点:在图像处理、语音识别和自然语言处理等领域表现出色。

- 缺点:需要大量数据和计算资源,模型解释性差。

集成学习算法:

- 包括提升法(Boosting)、自助聚合法(Bagging)、堆叠法(Stacking)等方法。

- 优点:通过组合多个模型提高预测性能。

- 缺点:模型复杂度高,训练和调优成本增加。

当然还有基于功能、实现方式、处理数据方式等的分类方法。这些分类并不是绝对严格的,在实际应用中,特定算法可能跨越多个类别或在不同类别之间有重叠。例如,大家耳熟能详的神经网络也可以用于监督学习、无监督学习、半监督学习,甚至强化学习。

这里我再特别介绍下如今火爆全网的人工智能大模型里一个核心的技术领域。

自然语言处理(Natural Language Processing,简称NLP)

在这个领域,使用了多种机器学习算法来实现具体的NLP任务,如分类(例如情感分析)、序列生成(例如机器翻译)、模式识别(例如命名实体识别)等。这些算法可以是线性模型,也可以是复杂的深度学习模型,如卷积神经网络(CNNs)、循环神经网络(RNNs)和变换器(Transformers)。

NLP的应用主要包括:对话系统和聊天机器人(如GPT-3),内容推荐和个性化,自然语言理解(NLU),机器翻译,文本生成,情感分析和社交媒体监控,语音识别和处理,知识图谱和信息检索等。

这些应用展示了NLP在人工智能大模型中的广泛应用,利用其强大的语言理解和生成能力,在提高用户体验、信息获取和内容创作方面起到关键作用。

先进随着科技的越发进步,算法也没有绝对的哪个最好。选择适合的算法取决于具体的问题、数据的特性和性能要求,通常需要根据问题的具体情况来选择和调整适合的算法。现在更多的应用都是算法的集合和重组。另外,个人的习惯也会影响对算法的选择。

主流盘点,科技潮流与应用

拿现在学习中的一些主流的算法举例来看:

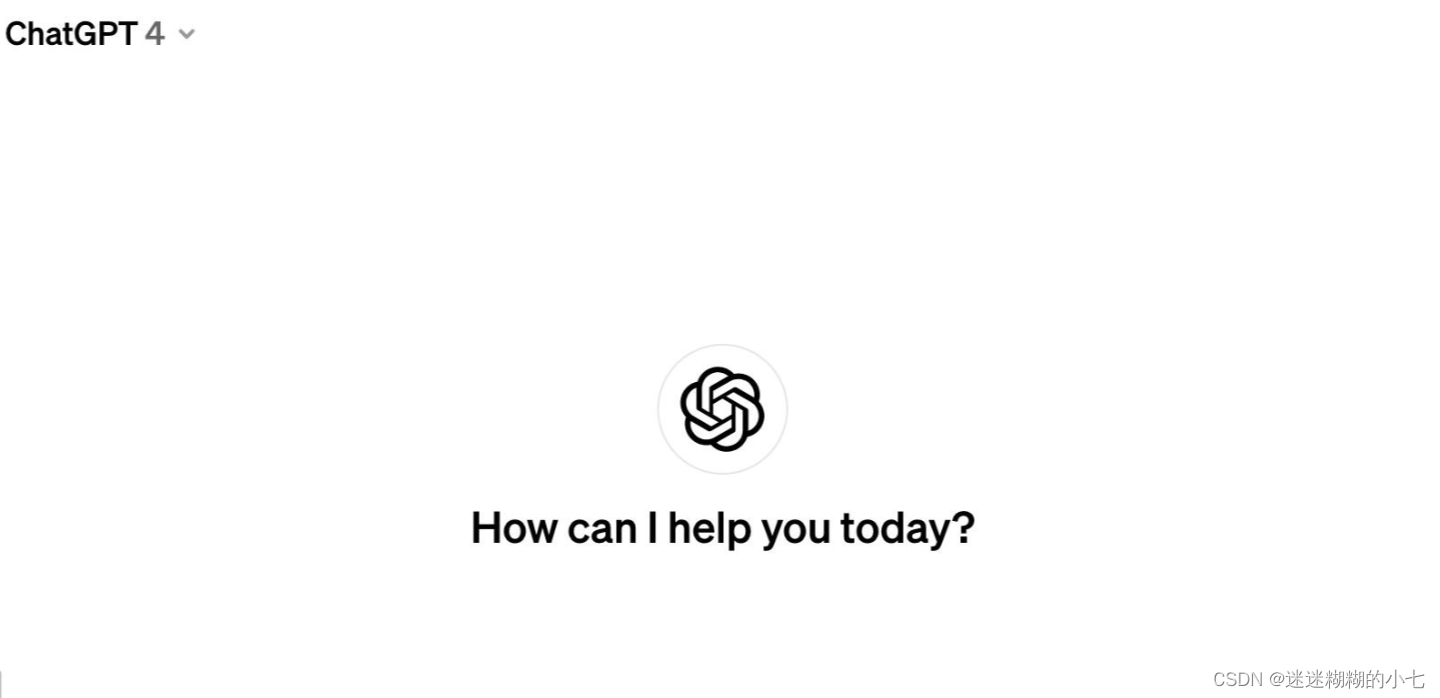

K-均值聚类(K-Means Clustering)

这是一种常用于客户分析的算法技术,能将大量商业记录转化为人口洞察和潜在客户。除此之外,它还用于滑坡预测、医学图像分割、图像合成(与生成对抗网络结合使用)、文档分类和城市规划等领域。

比如说,一家大型购物中心,需要将成千上万的顾客分成不同的群体,以便为他们提供定制化的购物体验。那么你使用K-均值聚类,你可以根据购物习惯、年龄、收入等因素将顾客分成不同的群组。这种方法不仅帮助理解顾客行为,还能有效地针对不同群体制定营销策略。

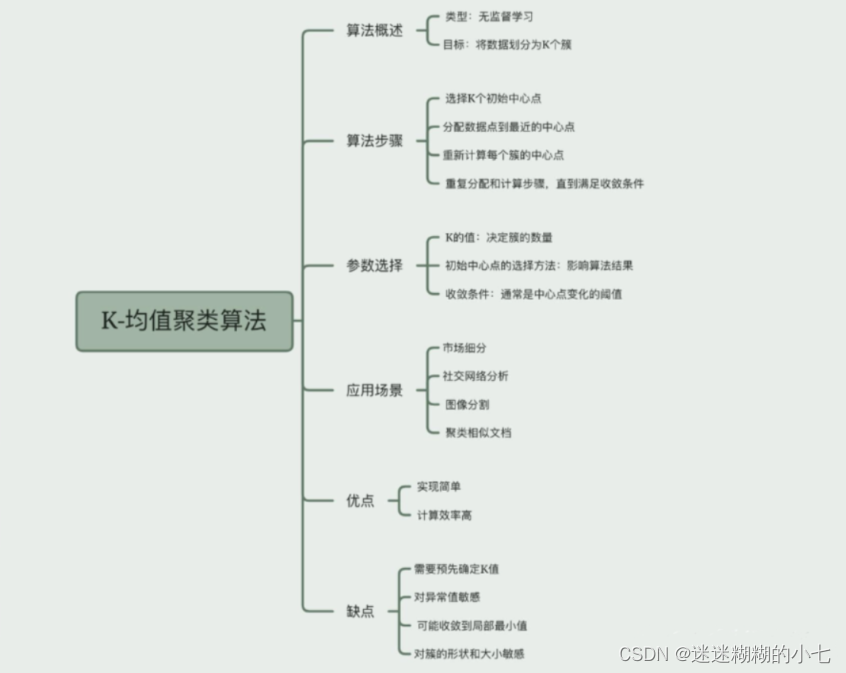

随机森林(Random Forest)

这是一种集成学习方法,通过汇总一系列决策树的结果来建立总体预测。随机森林因考虑多种因素而可能比决策树更难以转化为有意义的图形,但往往更为高效。它被广泛应用于磁共振成像合成、比特币价格预测、人口普查细分、文本分类和信用卡欺诈检测等领域。

设想你正在研究一种新的癌症检测方法。你有成百上千的患者数据,包含各种生物标志物的信息。使用随机森林算法,你可以从这些复杂的数据中识别出癌症的关键预测因素,并建立一个强大的预测模型来帮助早期诊断。随机森林之所以强大,是因为它通过结合多个决策树的结果来提高预测的准确性和稳定性。

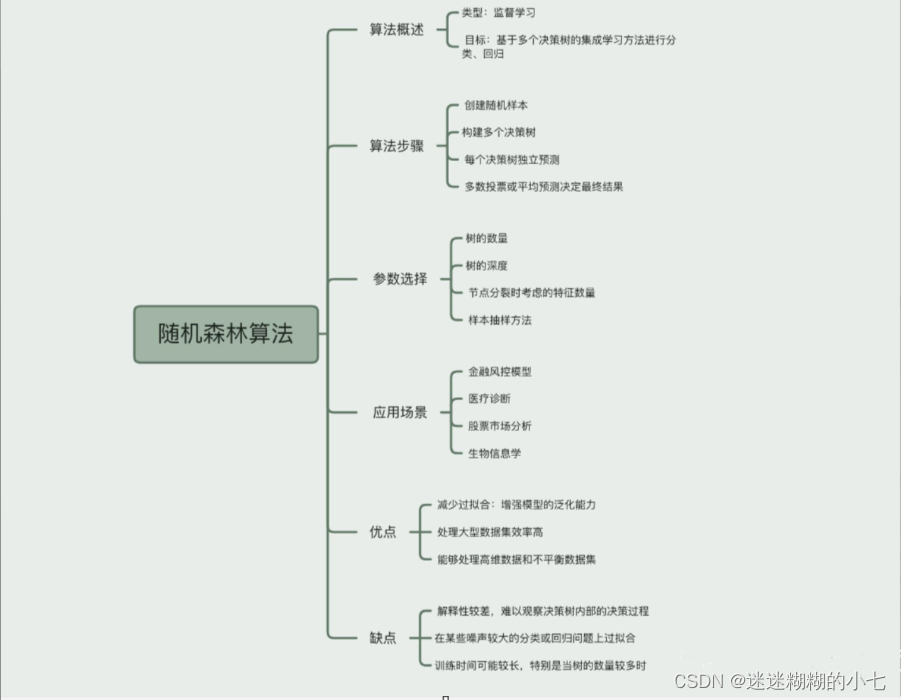

朴素贝叶斯(Naiive Bayes)

这是一种能够基于数据的计算特征估计概率的算法。它假设特征之间是相互独立的,并使用贝叶斯定理来计算给定对象的概率。朴素贝叶斯过滤器在疾病预测、文档分类、垃圾邮件过滤、情感分类、推荐系统和欺诈检测等领域有广泛应用。

相信不少专业的朋友在上学的时候并不陌生。如果你要开发一个电子邮件分类系统,需要区分垃圾邮件和正常邮件。使用朴素贝叶斯算法,你可以根据邮件中的词汇和其他特征来计算邮件是垃圾邮件的概率。这个算法简单而高效,非常适合处理有大量特征的数据集,如文本数据。

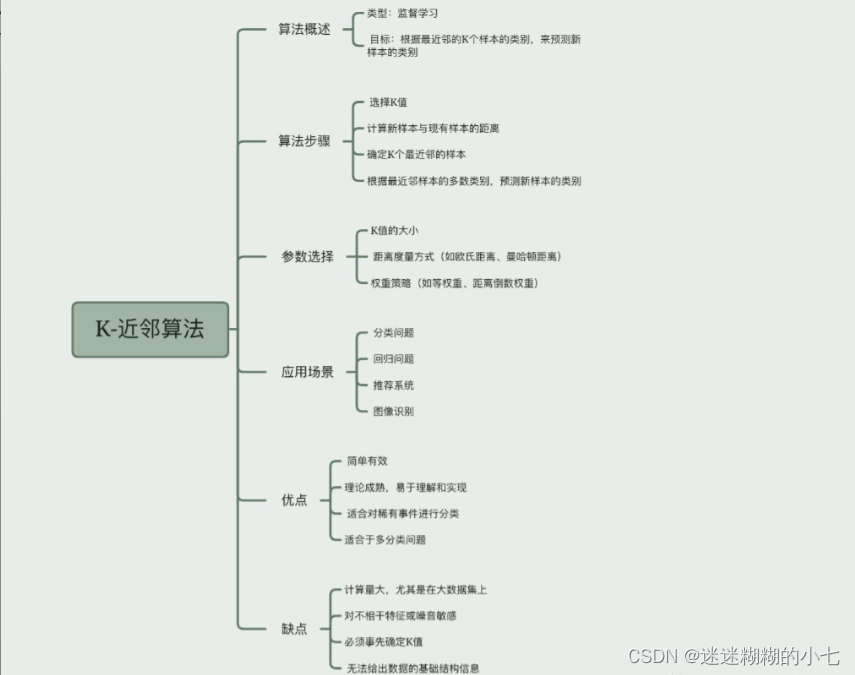

K-近邻(K-Nearest Neighbors,KNN)

这是一种简单但仍在机器学习研究中占有重要地位的算法。它被称为"懒惰学习者",因为它会详尽地扫描数据集以评估数据点之间的关系,而不需要训练完整的机器学习模型。KNN已经被应用于在线签名验证、图像分类、文本挖掘、作物预测和面部识别等多个领域。

比如推荐系统,电影,音乐或好物推荐。使用KNN算法,你可以找到与特定用户口味最相似的其他用户,并根据这些"邻居"的喜好向该用户推荐内容。KNN的优势在于它的直观性和简单性,尤其是在推荐系统这样的应用场景中。

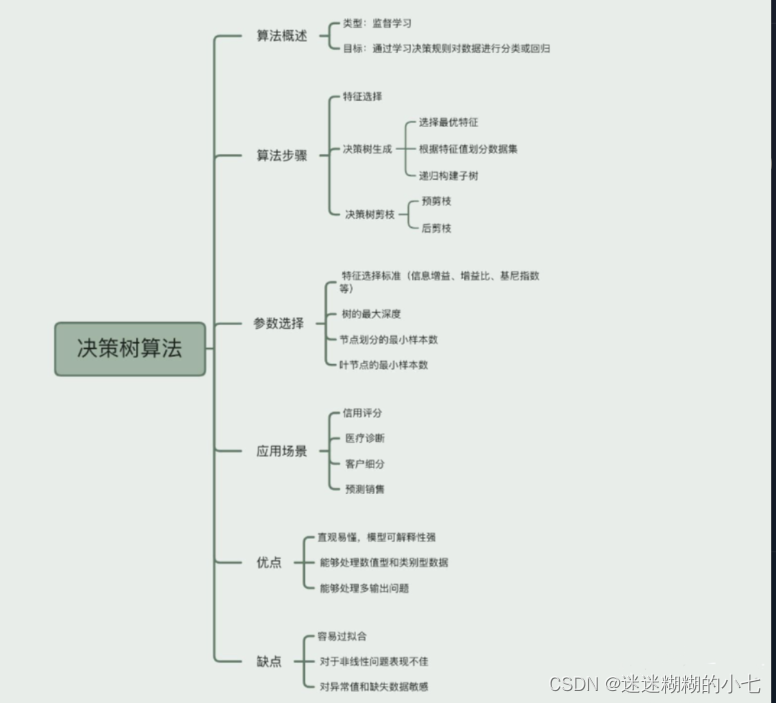

决策树(Decision Tree)

决策树是一种监督学习算法,主要用于分类和回归任务。它的工作原理类似于流程图,通过一系列的问题来对数据进行分割,最终得到决策结果。每个内部节点代表一个属性或特征,每个分支代表这个特征的一种可能值,每个叶节点(树的末端)代表最终的决策结果。决策树广泛应用于医疗诊断、信用评分、市场分析等领域。

比如银行的风险管理专家,需要决定是否批准客户的贷款申请,会考虑许多因素,比如客户的信用历史、收入水平、职业类型等。决策树就像是一个"流程图",帮助你根据这些信息做出决定。每一个"分支"都代表一个选择(比如收入高于某个数额),而每一个"叶子节点"则代表最终的决策(批准或拒绝贷款)。

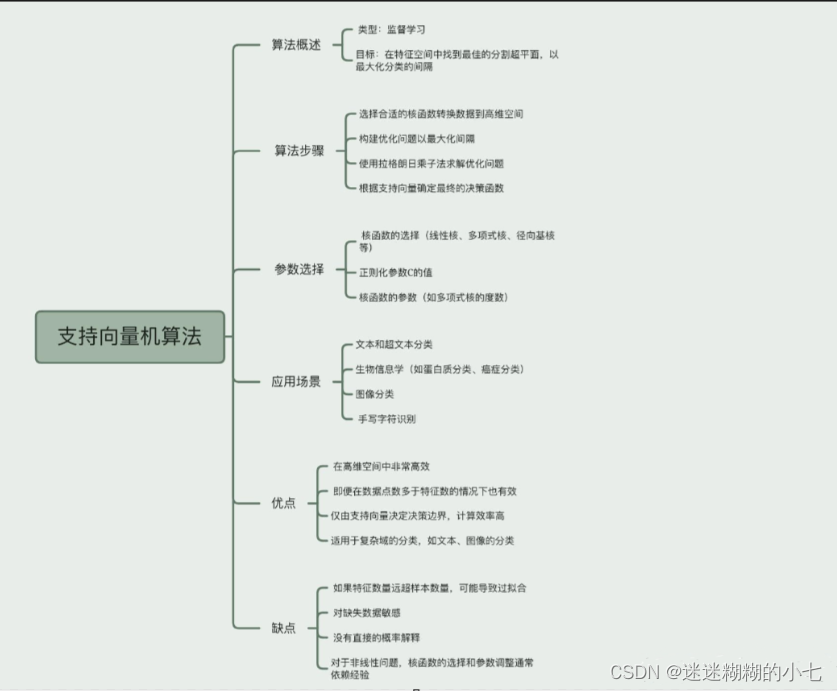

支持向量机(SVM)

支持向量机是一种强大的监督学习模型,主要用于分类问题,也可以用于回归。SVM的目标是找到一个超平面(在二维空间中是一条线,在三维空间中是一个平面,以此类推),以此来最大化不同类别数据点之间的间隔。SVM广泛用于图像识别、生物信息学、文本和超文本分类等领域。

比如时尚快消品零售商,想要根据顾客的购物历史将他们分类为"高价值"或"低价值"客户。这里的挑战是如何在这两类客户之间划出一条清晰的界线。SVM就像是一个聪明的"分界线划定者",它不仅找到了两类客户之间的界限,而且确保这条界线尽可能地远离两边的客户,以便于区分。

这些算法不仅流行经久不哀,而且还构成了许多现代机器学习应用的基础,对于希望加深对机器学习理解的朋友来说,了解这些关键算法非常有价值。随着机器学习领域的不断发展,跟上这些关键算法的最新动态对于实际应用和学术研究都至关重要。

大模型魔法,算法的神奇实践

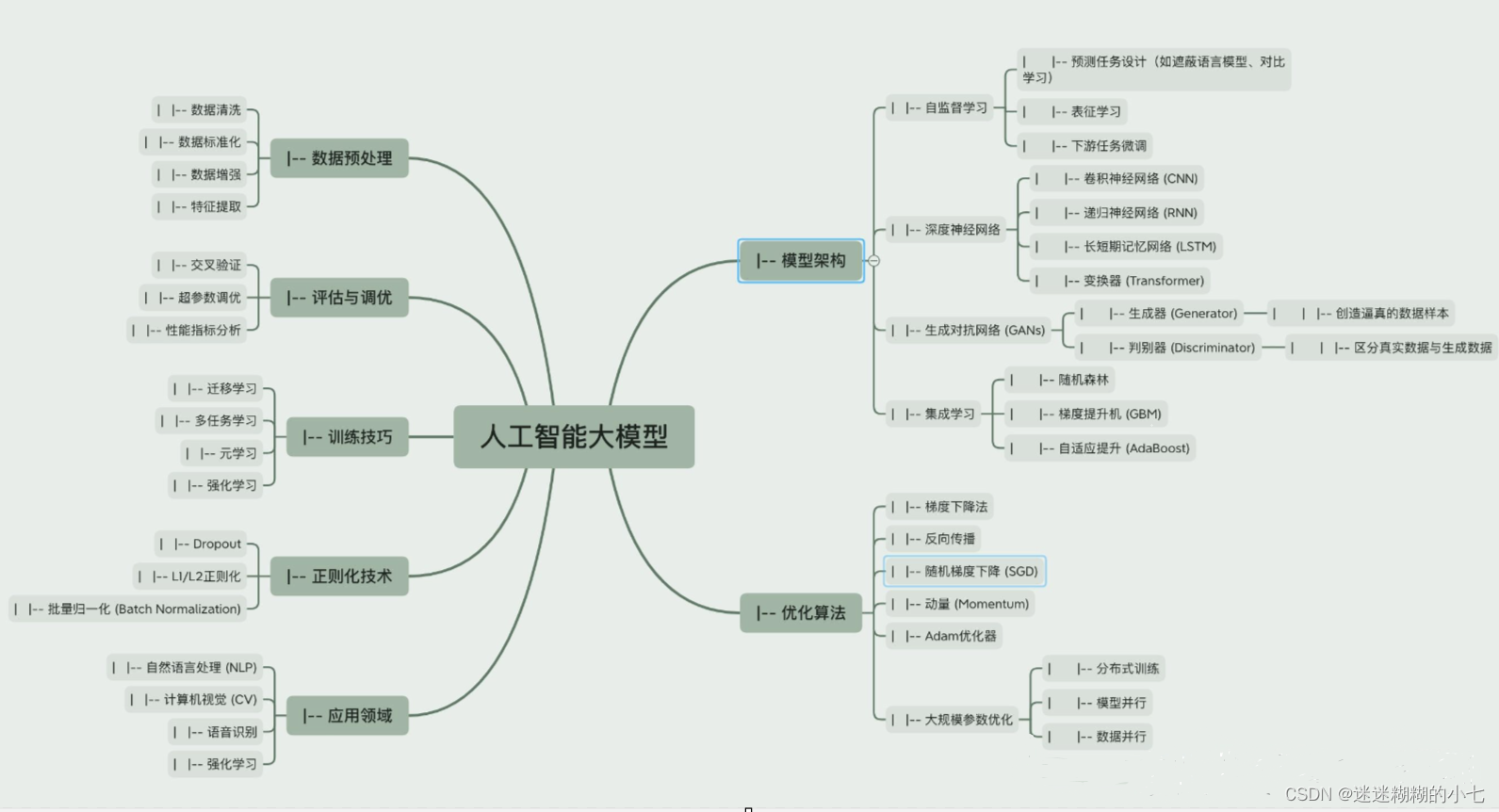

另外我拿最火的人工智能大模型举例聊聊。

人工智能大模型通常指的是大规模的深度学习模型,如GPT(Generative Pre-trained Transformer)系列、BERT(Bidirectional Encoder Representations from Transformers)或者像OpenAI的DALL-E这样的模型。这些模型都是建立在自然语言处理(NLP)的基础之上,NLP是构成人工智能大模型不可或缺的部分,它既是一个技术领域,也是一套包含多种算法的集合。今天我们主要选出其中的一些关键算法来说下。

变换器(Transformers)

Transformers是这些大模型的核心,它们通过注意力机制(attention mechanisms)能有效处理序列数据,如文本或时间序列数据。

其优势就在于能够捕捉长距离依赖关系,对输入序列中的所有元素进行全面的加权,这使得模型在处理自然语言任务时更加准确。

自监督学习(Self-supervised Learning)

自监督学习是训练过程中的一种方法,模型学习预测输入数据中的任何部分,而无需传统意义上的标签。例如,BERT通过预测文本中被遮蔽的单词来训练。

**利用自监督学习,**可以从未标注的数据中学习到丰富的特征表示,大幅降低了依赖标记数据的成本。

迁移学习(Transfer Learning)

在一个大型数据集上训练一个基础模型,然后将学到的特征和知识迁移到其他任务上。例如,GPT-3通过在大量文本上预训练,然后迁移到特定的下游任务,如翻译、摘要等。

这个算法允许模型在特定任务上快速适应,提高了模型的灵活性和效率。

强化学习(Reinforcement Learning)

在某些大模型的训练过程中,如用于游戏或特定应用的模型,可能会使用强化学习来优化决策过程。

这么做使模型能够在复杂环境中进行自我改进,通过与环境的交互学习最优策略。

生成对抗网络(GANs)

用于生成新的数据实例,如图像、音乐或文本。DALL-E就是一个例子,它使用了变体的GAN来生成图像。

利用GANs能够生成高质量和多样性的数据,可用于数据增强、艺术创作等。

大规模参数优化

处理大量参数并优化它们以获得最佳性能。

虽然计算成本高,但能够显著提升模型的预测能力和适应性。

这些大模型通常结合了多种最先进的技术和算法,从而在多个任务上表现出色。它们的主要优势在于能够理解和生成复杂的数据模式,所以,算法的好坏或者选择,已经不是一个单选的过程。一个复杂的模型往往需要多种算法结合达到最优效果。