Ollama 部署 DeepSeek-R1 及Open-WebUI

文章目录

- [Ollama 部署 DeepSeek-R1 及Open-WebUI](#Ollama 部署 DeepSeek-R1 及Open-WebUI)

-

- 〇、说明

- [一、 安装Ollama](#一、 安装Ollama)

- [二、Ollama 部署 DeepSeek](#二、Ollama 部署 DeepSeek)

-

- 1、部署

- 2、模型选用

- [3、Ollama 常用命令](#3、Ollama 常用命令)

- 4、Ollama模型默认存储路径

- 安装open-webui

-

- [1、通过Python pip 安装](#1、通过Python pip 安装)

- [2、通过Docker 安装](#2、通过Docker 安装)

-

- 安装Docker(如已安装请忽略)

- [使用Docker 部署 open-webui](#使用Docker 部署 open-webui)

- 3、可能遇到的问题

〇、说明

为什么使用本方案

-

部署环境与资源

- 本地部署需要用户自建硬件(如 GPU 集群)和配置环境,适合对数据隐私要求较高或离线处理场景;

- 线上 API 则由服务商托管,用户通过网络调用,无需自行投资硬件资源。

-

数据安全与控制

- 本地部署数据完全由用户掌握,更安全;

- 线上 API 涉及数据传输和第三方服务器,存在一定隐患。

-

更新维护与扩展性

- 线上 API 由提供商持续更新和维护,用户总能使用最新版本;

- 本地部署需要用户自行管理更新和维护,工作量较大。

-

成本结构

- 线上 API 通常按调用计费,初期投入较低;

- 本地部署前期硬件投入较高,但对于大规模、长期应用可能更具成本优势。

-

最重要的

- DeepSeek服务经常500

一、 安装Ollama

Ollama 是一个开源的 AI 模型,主要用于生成和理解图像。它由 Anthropic 开发并发布,这是一个专注于 AI 研究的公司。Ollama 的核心功能包括图像生成、图像分割和图像分类等任务。

1、主要特点:

- 开源:Ollama 的代码和模型都是公开的,允许研究人员和开发者自由使用和修改。

- 高质量的图像生成:模型能够生成逼真且多样化的图像,适用于游戏、艺术创作等领域。

- 实时性:Ollama 模型通常运行在本地设备上,可以快速生成结果,无需依赖云端服务。

- 多语言支持:模型能够理解和生成多种语言,适合自然语言处理任务。

2、安装

进入Ollama 官网 下载对应系统进行安装

3、验证

安装完成后,打开命令行工具,输入以下命令验证是否安装成功:

ollama --version

如果显示版本号,说明安装成功。

二、Ollama 部署 DeepSeek

1、部署

进入 Ollama 的 DeepSeek-R1 的官方下载地址 选择模型,点击复制按钮

打开终端,输入刚复制的命令

ollama run deepseek-r1:1.5b

下载时间取决于网络速度和模型大小

下载完成后运行

ollama run deepseek-r1:1.5b # 启动指定的 DeepSeek-R1 模型

2、模型选用

根据自己的显存选择对应的模型,2G显卡推荐选1.5b的。

我的电脑是21款 MacBookPro M1 Pro,运行内存16G,显卡是集成显卡,与内存共用同一内存,下载的模型是DeepSeek-R1 8B,后面内存开销很多,导致电脑变卡,可能需要重启,后面下载1.5b 版本,会好很多

3、Ollama 常用命令

bash

ollama pull 模型名字 # 拉取模型

ollama run 模型名字 # 启动指定的 DeepSeek-R1 模型

ollama chat 模型名字 # 使用run 命令启动聊天模式

ollama stop # 停止正在运行的模型与服务

ollama list # 查看已下载的模型

ollama help # 可用命令及简要说明

ollama version # ollama版本号

ollama logs # 查看模型运行时的日志输出

ollama update # 更新 Ollama 工具到最新版本

ollama config #查看或设置 Ollama 的配置信息(例如 API 密钥、缓存路径等)4、Ollama模型默认存储路径

bash

~/.ollama/models/安装open-webui

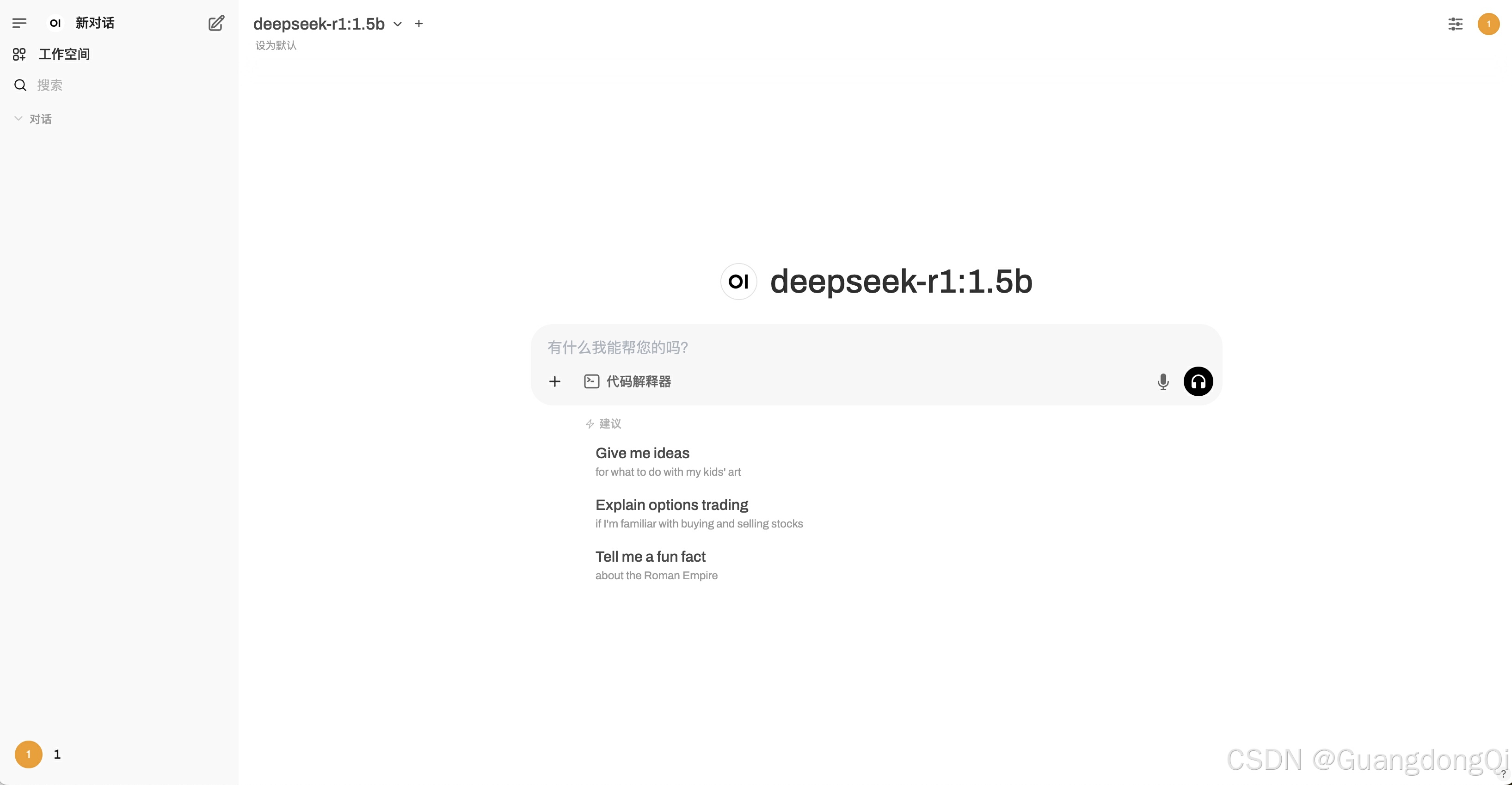

进入open-webui GitHub 页面

可以看到 open-webui 有两种安装方式

1、通过Python pip 安装

要求

确保您使用的是Python 3.11

安装命令

pip install open-webui # 安装 Open WebUI

open-webui serve #运行 Open WebUI启动后 通过 http://localhost:8080 来访问

2、通过Docker 安装

安装Docker(如已安装请忽略)

以下是 Mac OS 下安装 Docker 的简明步骤:

-

下载安装包

访问 Docker 官网(https://www.docker.com/products/docker-desktop/)下载适用于 Mac 的 Docker Desktop 安装包。 -

安装 Docker Desktop

双击下载的 .dmg 文件,将 Docker Desktop 拖拽到 Applications 文件夹中。 -

启动与初始配置

从 Applications 中启动 Docker Desktop。首次启动时可能需要授权系统权限,按提示操作即可。等待 Docker 图标出现在菜单栏,表示 Docker Desktop 已启动并初始化完成。 -

验证安装

打开终端,输入以下命令确认 Docker 版本:bashdocker --version若显示版本信息,则表示安装成功。

使用Docker 部署 open-webui

因为本地已经安装了Ollama 所以可以使用以下命令安装

bash

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main3、可能遇到的问题

如果您遇到连接问题,通常是由于 WebUI docker 容器无法访问容器内 127.0.0.1:11434 (host.docker.internal:11434) 处的 Ollama 服务器。使用--network=hostdocker 命令中的标志来解决此问题。请注意,端口从 3000 更改为 8080,从而导致链接:http://localhost:8080。

Docker 命令示例:

bash

docker run -d --network=host -v open-webui:/app/backend/data -e OLLAMA_BASE_URL=http://127.0.0.1:11434 --name open-webui --restart always ghcr.io/open-webui/open-webui:main