一、前言

DeepSeek(深度求索)是一家中国人工智能企业,其在人工智能领域取得了显著成果,特别是其发布的新一代大模型DeepSeek-R1和DeepSeek-V3,受到了广泛关注。

DeepSeek官网:https://www.deepseek.com/

二、使用现状

使用现状,以及本地部署有什么好处。

默认的时候使用的是DeepSeek-V3。

点击深度思考的时候使用的是DeepSeek-R1。

** 但是我们在使用DeepSeek-R1的时候,经常的出现网络繁忙。如下图所示,所以我们本地部署的话,就不会出现这样的问题。同时DeepSeek R1的本地部署方案为用户提供了更加私密、灵活和高效的AI体验。**

三、DeepSeek-R1 和 DeepSeek-V3是什么

3.1 DeepSeek-R1

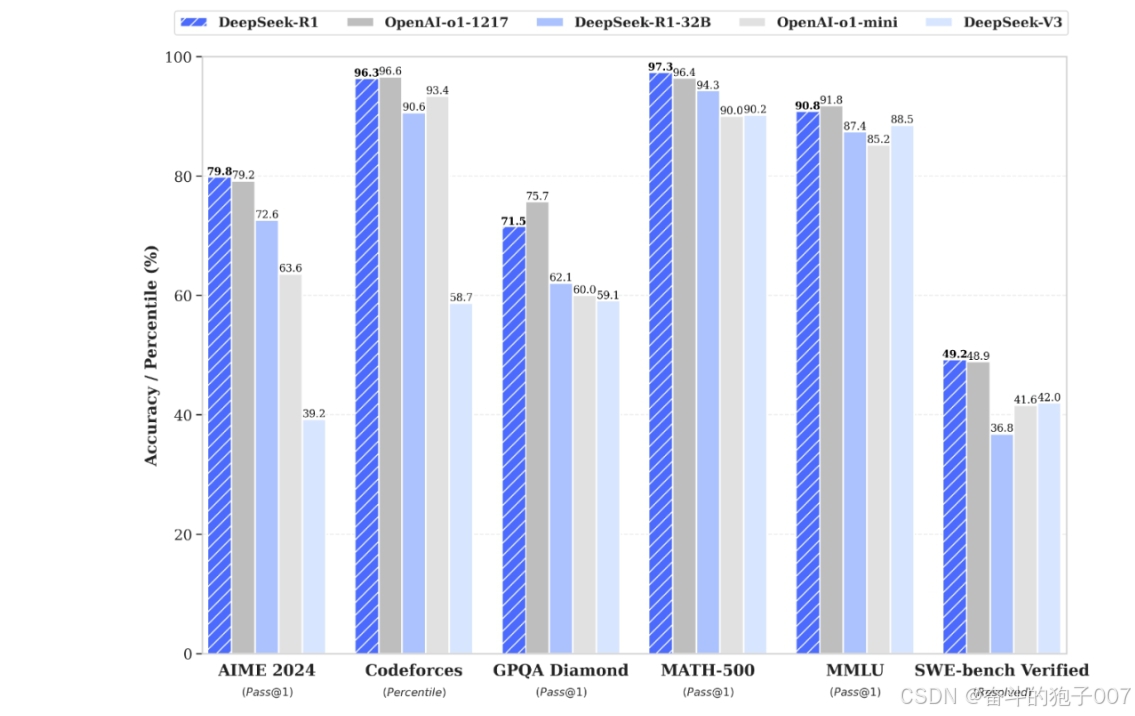

DeepSeek-R1 在后训练阶段大规模使用了强化学习技术,在仅有极少标注数据的情况下,极大提升了模型推理能力。在数学、代码、自然语言推理等任务上,性能比肩 OpenAI o1 正式版。

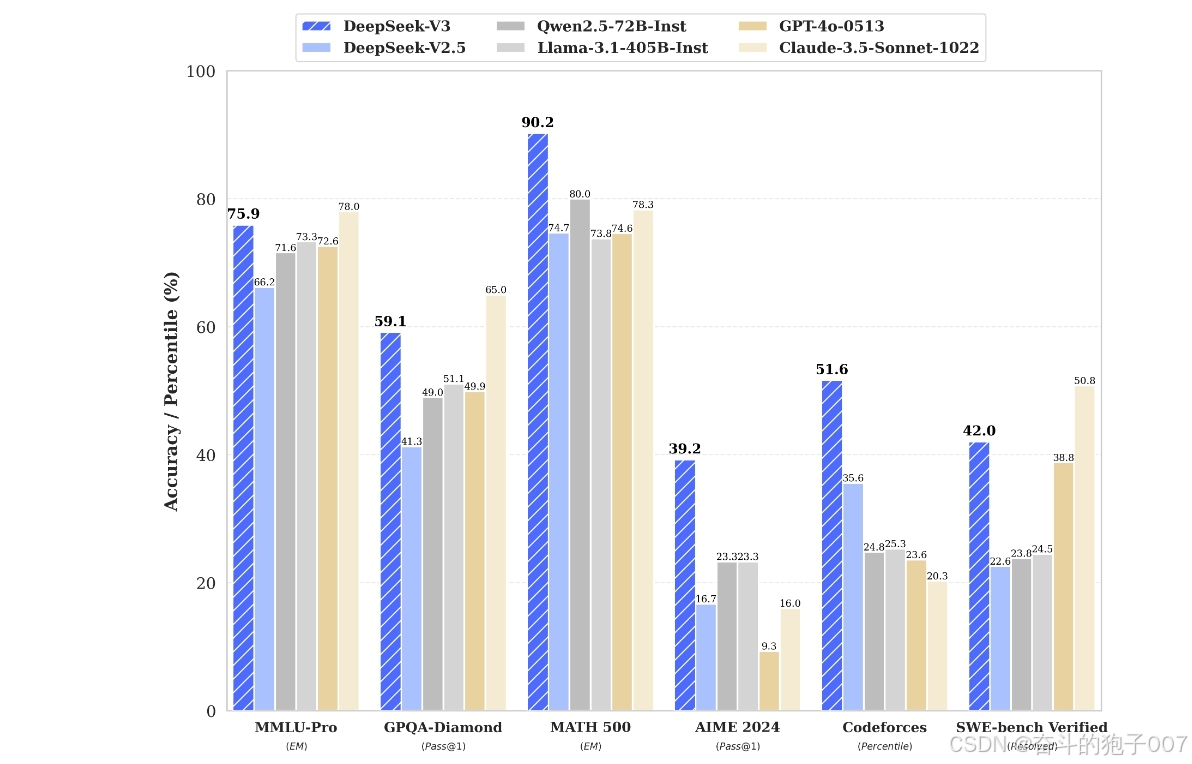

3.2 DeepSeek-V3

V3基于改进的Transformer架构,引入动态注意力机制(Dynamic Attention Mechanism),通过实时调整注意力权重优化文本生成质量。其混合专家(MoE)架构包含6710亿总参数,但每个Token仅激活370亿参数,显著降低计算成本。该模型在内容创作、客服对话等场景中表现出色,训练成本仅为同类闭源模型的1/20。

总结:

当不启用"深度思考"时,我们使用的是V3模型,它就像一个多面手,能够高效地处理各种语言任务,比如快速生成文章、翻译、聊天等,适合那些需要快速得到答案或者处理多种任务的场景。

而当我们启用"深度思考"时,就切换到了R1模型,它更像是一个逻辑专家,擅长解决复杂的逻辑问题、进行深度推理,比如数学建模、编程代码生成等。

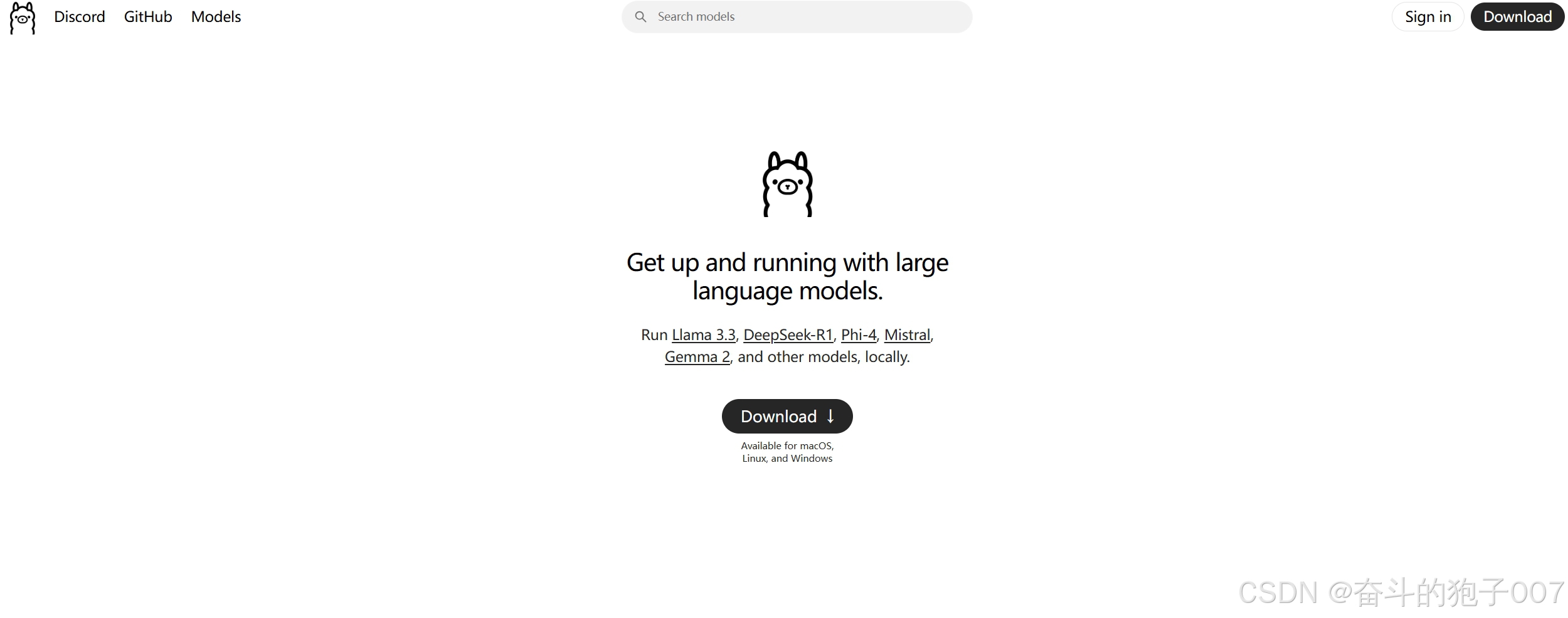

四、使用Ollama本地部署

Ollama 是一个开源工具,旨在简化在本地计算机上运行和操作大型语言模型(LLMs)的过程。它专注于让用户能够轻松部署、管理和实验各种开源的LLM(如Meta的Llama系列、Mistral、Gemma等),而无需依赖云端服务或复杂的配置。使得用户能够灵活地管理和使用不同的语言模型。

4.1 下载 Ollama

java

Ollama官网 https://ollama.com/

4.2 安装Ollama

安装完成之后是没有什么提示的。所以我们 WIN+R,输入cmd进入命令行模式

然后输入

java

ollama -v

出现以上提示,就表示安装成功了。

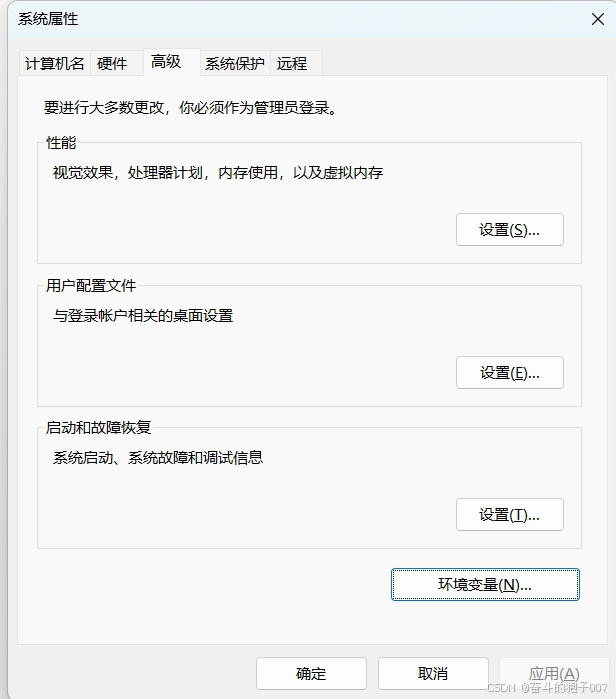

4.3 安装注意事项

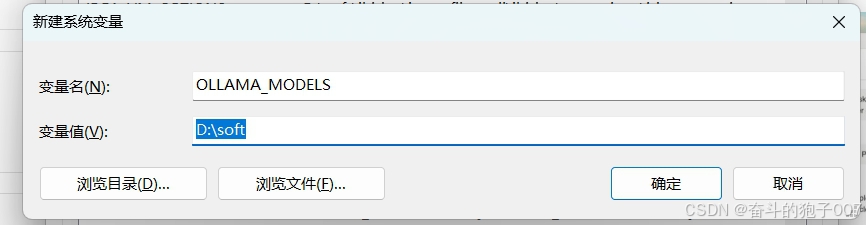

因为我的C盘比较大,ollama默认安装到C盘了,要是你的C盘空间比较小,可以通过配置环境变量的方式,修改ollama的安装路径

点击环境变量,在系统变量中添加

java

OLLAMA_MODELS,变量值选择到你需要安装的目录

4.3 下载运行 DeepSeek-R1 模型

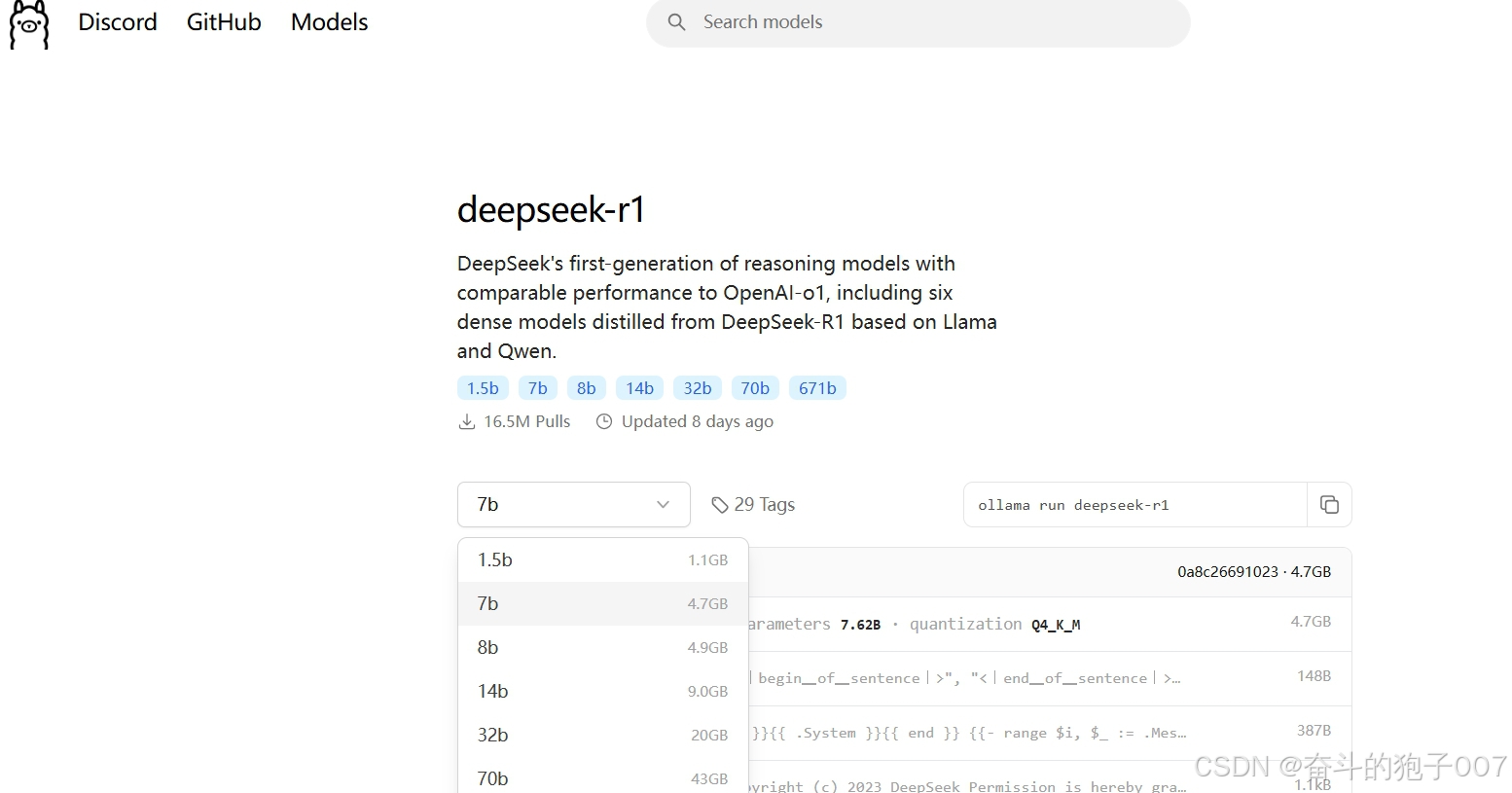

安装ollama之后,我们下载并运行DeepSeek-R1 模型。

在ollama官网,我们可以看到

具体安装什么版本,根据自己的电脑配置来,大概的配置对应关系如下:

相关的安装命令

java

ollama run deepseek-r1:1.5b

ollama run deepseek-r1:7b

ollama run deepseek-r1:14b

ollama run deepseek-r1:32b

ollama run deepseek-r1:70b我们使用ollama run deepseek-r1:14b

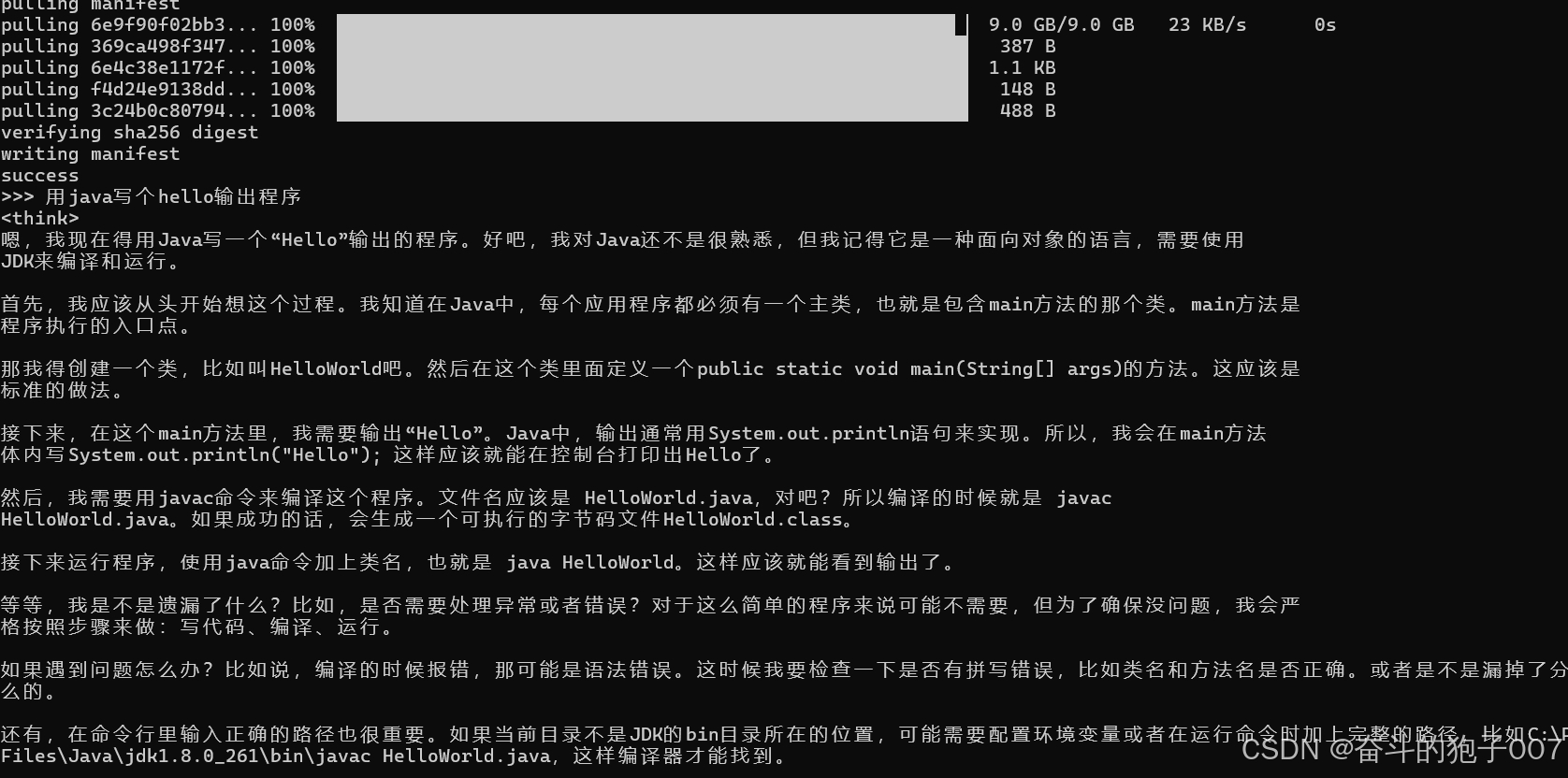

文件有点大,等待下载完成后。

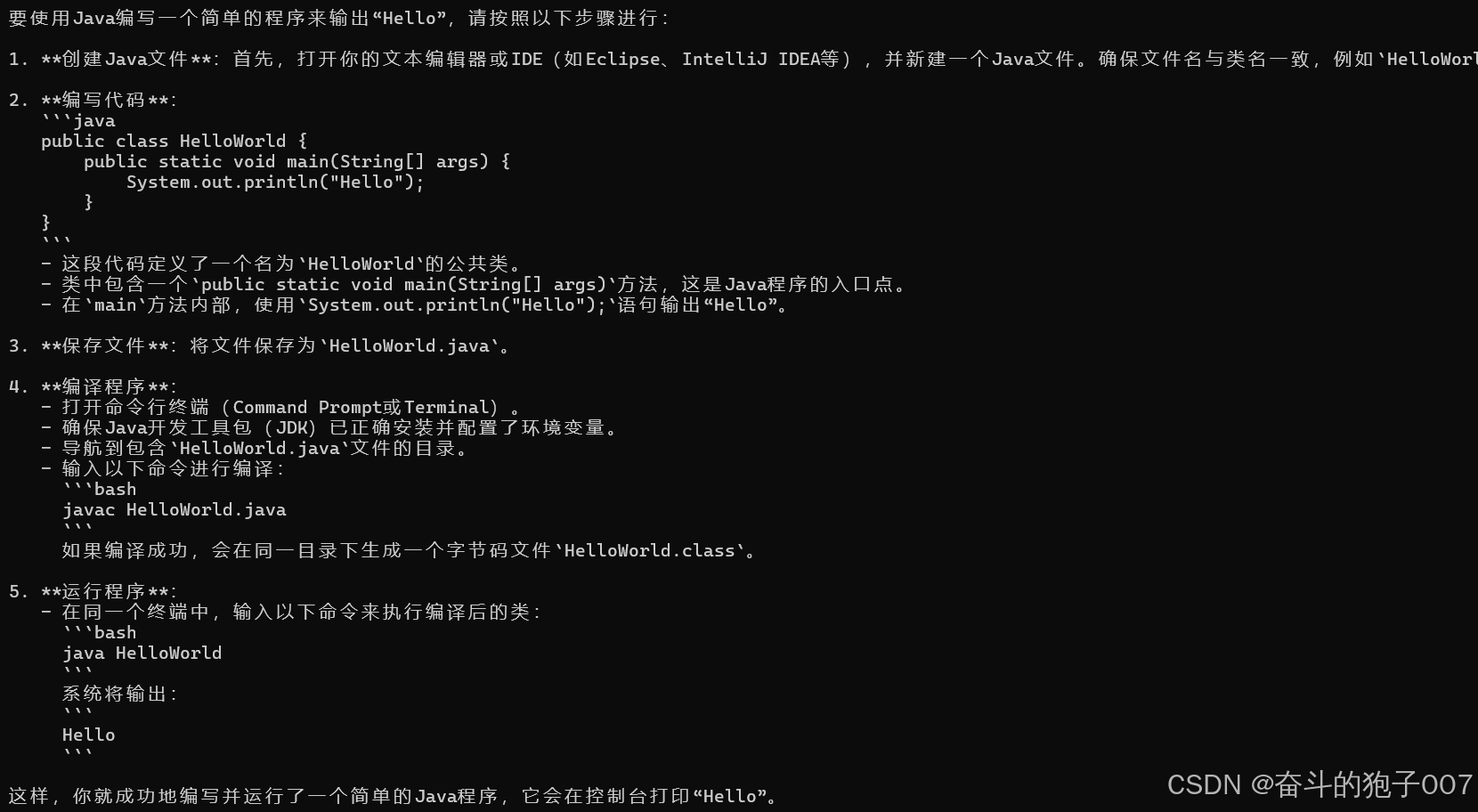

就可以直接使用啦,我们问一个问题。

可以看到已经输出答案了。

4.4 ollama 中常用命令

java

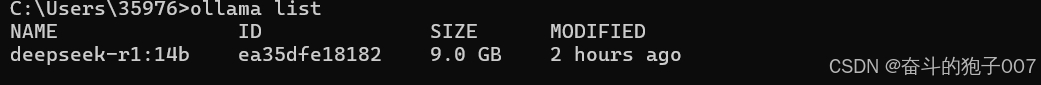

1.查看安装了哪些模型版本

ollama list

java

2.启动模型

ollama run deepseek-r1:14b

3.停止模型

ollama stop

java

4.查看相关帮助

/?

java

5.退出模型命令

/bye** 这个是在CMD命令行下面操作的,总感觉不太方便。我们肯定是习惯在图形化界面中操作方便,接下来我们来安装图形化界面。**

五、Chatbox AI接入DeepSeek R1模型

Chatbox AI 是一款开源的桌面应用程序,旨在为用户提供便捷的界面来管理和交互多种大型语言模型(LLMs)。它支持云端模型(如OpenAI GPT、Claude、Gemini等)和本地模型(如通过Ollama、LM Studio部署的模型),适合开发者、研究人员和普通用户快速测试、调试或日常使用AI对话功能。

5.1 下载Chatbox AI

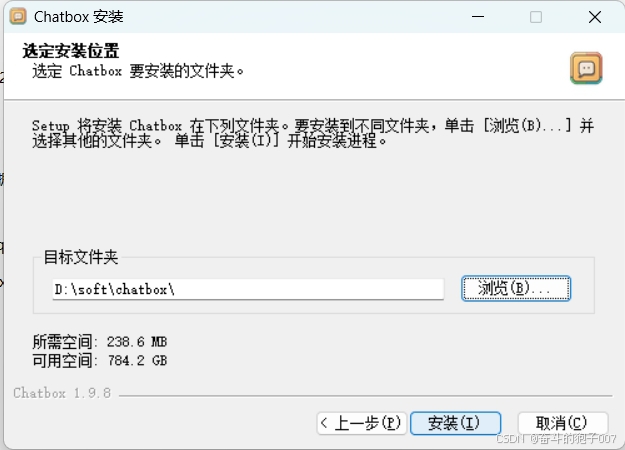

5.2 安装Chatbox AI

下载完成之后,我们直接安装。

5.3 设置DeepSeek R1模型

安装完成之后,点击设置,选择我们之前本地安装的DeepSeek R1:14b模型

5.4 在Chatbox AI 中验证

这样子我们就可以在界面中使用了,不仅方便许多,界面也非常好看。

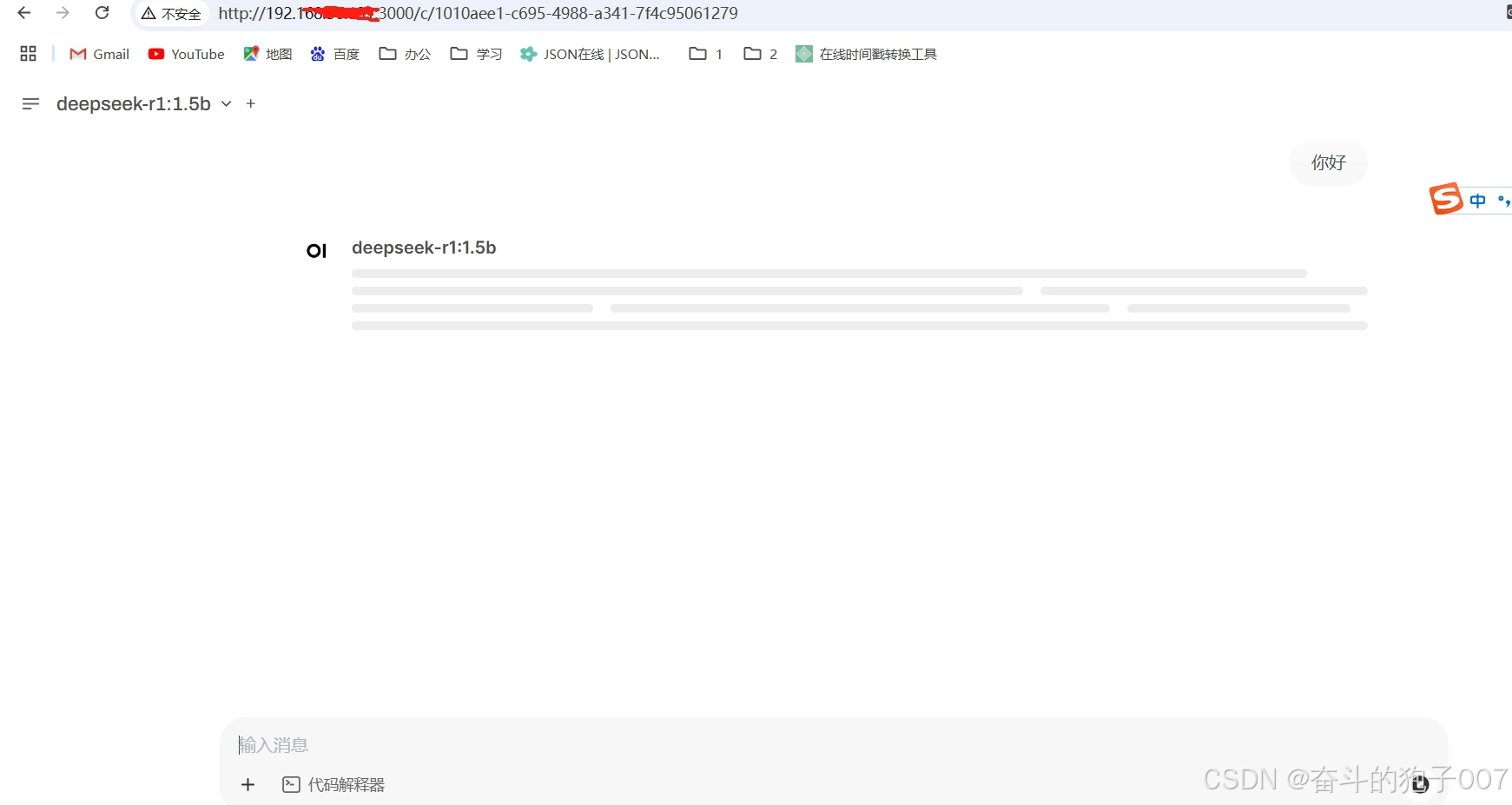

六、Open-WebUI接入DeepSeek R1模型

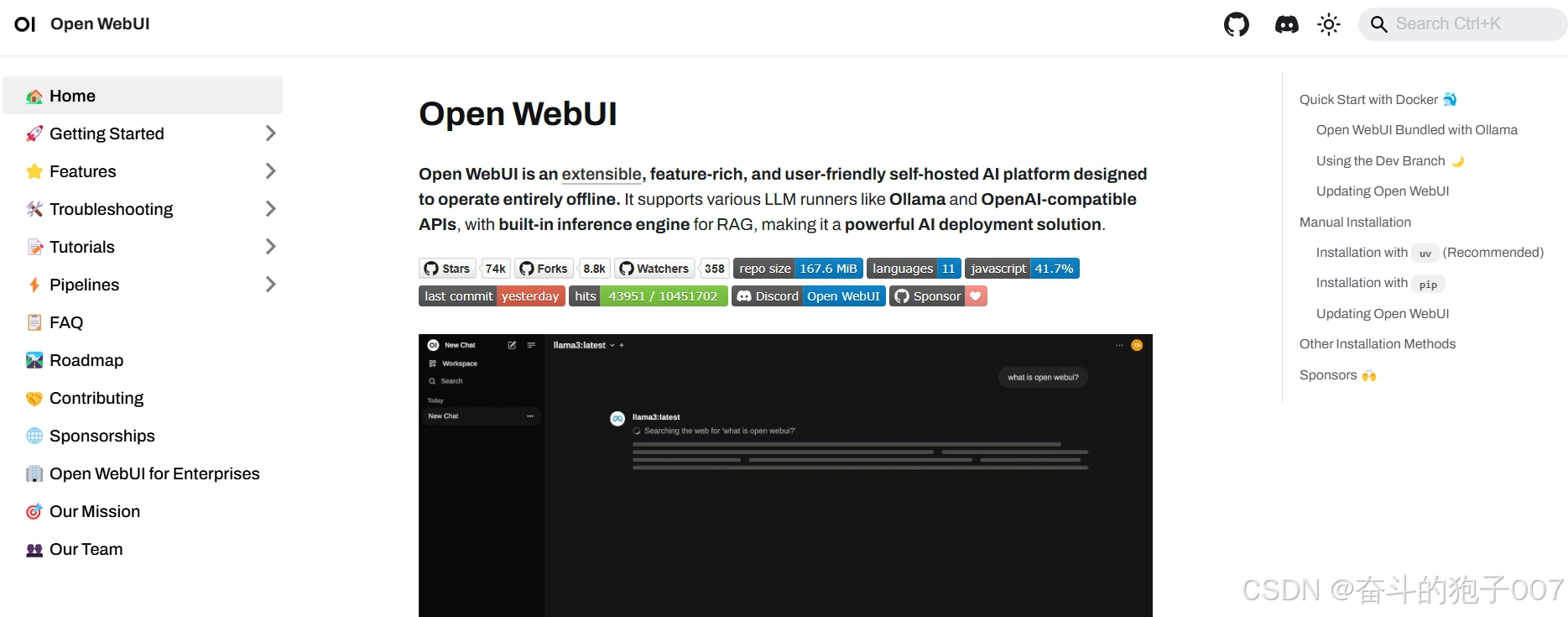

Open-WebUI(原名Ollama WebUI)是一个开源的、基于Web的用户界面工具,专为本地运行的大型语言模型(LLMs)设计,尤其与Ollama工具深度集成。它提供了一个类似ChatGPT的直观交互界面,允许用户通过浏览器轻松管理和对话本地部署的LLM(如Llama 3、Mistral、Phi-3等),无需编写代码或依赖云端服务。

1 安装Open-WebUI

官方文档:https://docs.openwebui.com/

首先访问Docker官网(https://www.docker.com),下载并安装Docker。

然后在docker的命令行中输入安装Open-WebUI的命令:

java

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

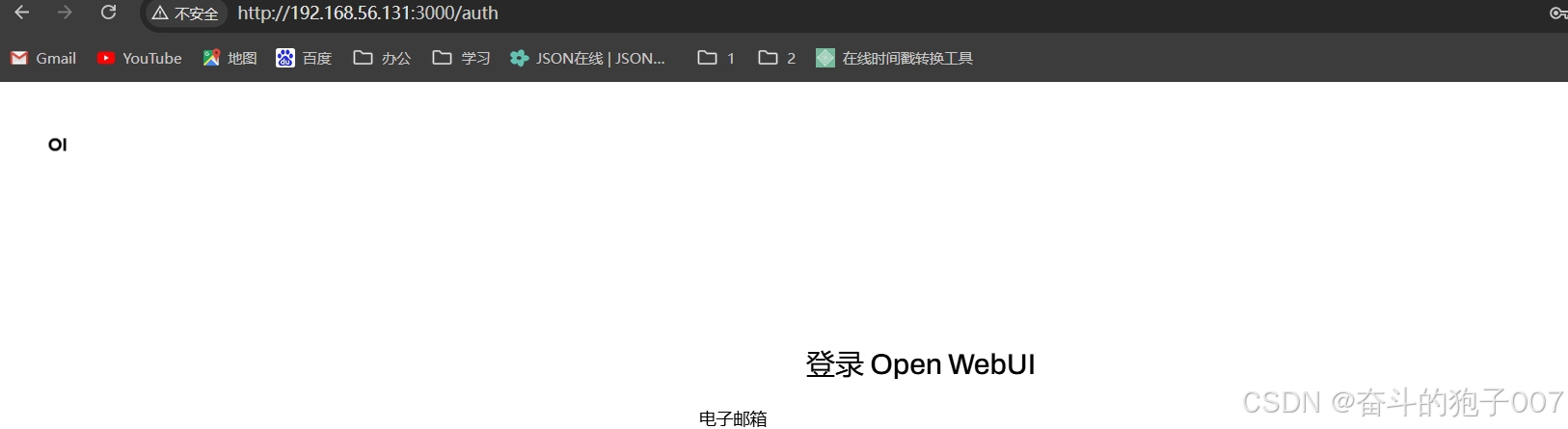

2. 安装完成后,你可以通过访问 http://localhost:3000 使用 Open WebUI。

3. 在Open-WebUI的设置中,选择"Ollama"作为模型提供方。在模型列表中,选择已安装的DeepSeek R1模型(如deepseek-r1:14b)。

这里可能会有个报错,就是选不到deepseek-r1,因为Open WebUI 访问不到 Ollama,调整一下配置

java

vi /etc/systemd/system/ollama.service

增加

Environment="OLLAMA_HOST=0.0.0.0"

Environment="OLLAMA_ORIGINS=*"

重启Ollama

java

systemctl daemon-reload

systemctl restart ollama4. 验证

以上是使用Open WebUI接入DeepSeek R1模型,实现图形化界面。

七、总结

DeepSeek R1作为一款专注于高性能AI推理的模型,其本地部署方案确实为用户带来了多重优势,包括增强的数据隐私保护、操作的灵活性以及更高的处理效率。这种部署方式使得用户能够在自己的环境中充分利用AI模型的能力,而不必依赖于外部的云服务或数据中心。

结合Ollama、Chatbox AI以及Open-WebUI等工具,DeepSeek R1的部署和交互变得更加便捷。这些工具不仅简化了模型的下载和安装过程,还提供了直观易用的界面,使得用户能够轻松地与模型进行交互。特别是Chatbox AI和Open-WebUI,它们不仅支持大模型的接入,还能够展示丰富的界面元素,进一步提升了用户体验。

展望未来,DeepSeek R1有望在更多领域发挥重要作用。随着人工智能技术的不断进步和应用场景的不断拓展,DeepSeek R1的本地部署方案将能够满足更多用户对于高性能、私密性和灵活性的需求。例如,在医疗、教育、金融等领域,DeepSeek R1可以为用户提供更加精准、高效的AI服务,帮助解决各种复杂问题。