一、引言

自动驾驶的终极目标是实现比人类驾驶更安全、更高效的交通系统。其核心挑战在于如何让机器像人类一样感知和理解复杂环境。然而,人类驾驶员依赖视觉、听觉和触觉的多模态信息,而自动驾驶系统则需要通过传感器和算法模拟这一过程。当前,多传感器融合(Multi-Sensor Fusion, MSF) 已成为解决这一问题的关键技术路径。

单传感器的局限性:

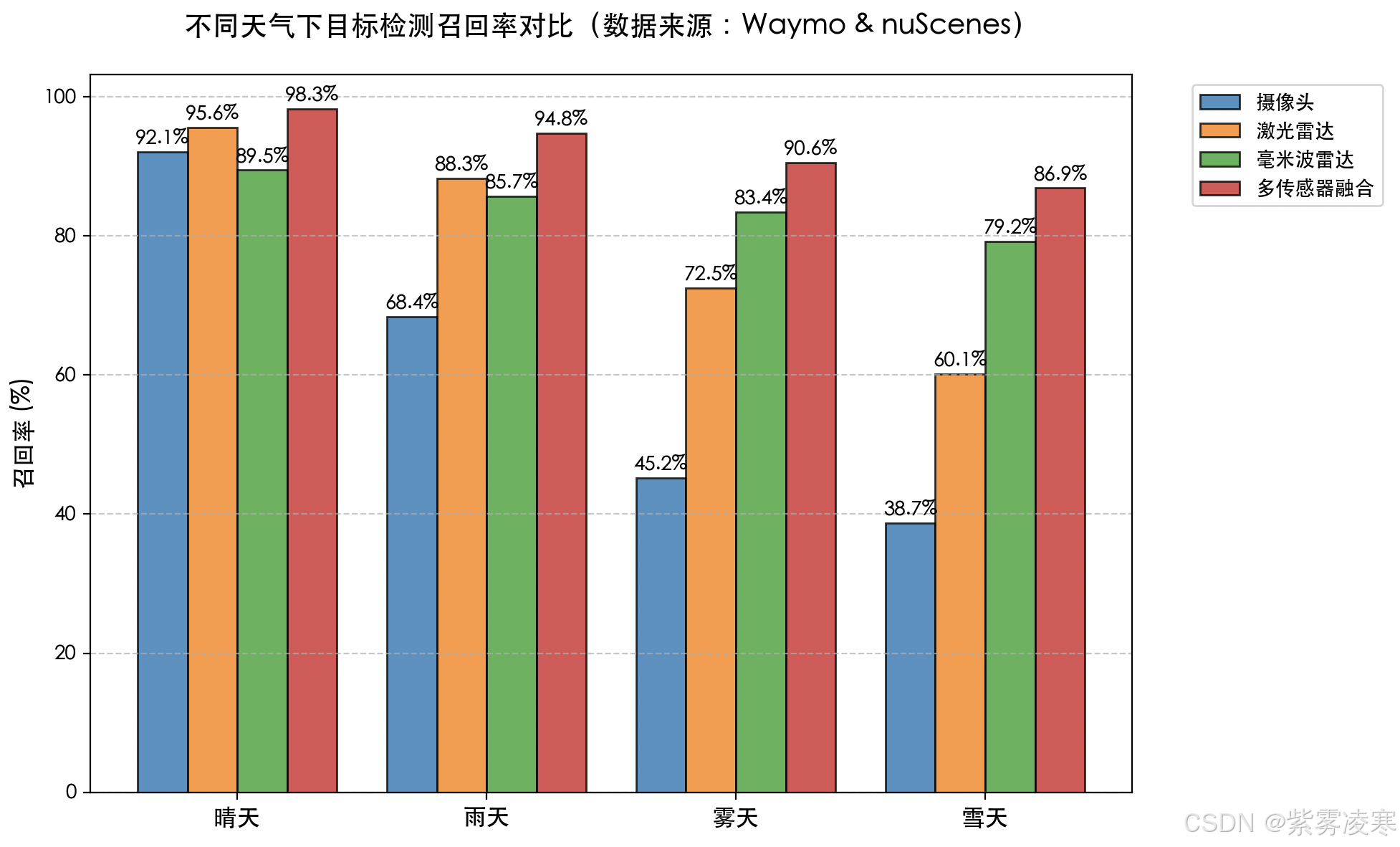

- 摄像头:尽管能捕捉丰富的纹理和颜色信息,但在强光、逆光或雨雾天气中性能骤降,且缺乏深度感知能力。

- 激光雷达(LiDAR):提供厘米级精度的3D点云,但成本高昂(早期单价超万美元),且在雨雪天气中易受散射干扰。

- 毫米波雷达:可全天候工作并精确测量目标速度,但对静态物体(如路牌)的识别能力弱,分辨率不足。

多传感器融合的价值:

- 数据互补性:激光雷达的3D结构数据与摄像头的语义信息结合,可提升目标分类的准确性。

- 冗余设计:当某一传感器失效时(如摄像头被强光致盲),系统仍可通过其他传感器维持基本功能。

- 全天候适应:毫米波雷达在雨雾中的稳定表现,弥补了激光雷达和摄像头的短板。

行业路线之争:

- 特斯拉的"纯视觉派":依赖8颗摄像头和神经网络算法,通过BEV(鸟瞰图)模型实现环境感知,硬件成本低至300美元。

- Waymo的"多传感器派":采用5颗激光雷达、29颗摄像头和6颗毫米波雷达,硬件成本超4万美元,但冗余性更高。

两者的选择折射出自动驾驶在性能、成本与可靠性之间的权衡。

二、多传感器融合的技术基础

1. 主流传感器特性与局限

| 传感器类型 | 探测距离 | 分辨率 | 抗干扰性 | 成本(美元) |

|---|---|---|---|---|

| 摄像头 | 50-150m | 1920×1080 | 弱(光照敏感) | 50-200 |

| 激光雷达 | 100-300m | 0.1°角分辨率 | 中(雨雾散射) | 500-5000 |

| 毫米波雷达 | 200-300m | 1°角分辨率 | 强 | 100-500 |

| 超声波雷达 | 0.1-5m | 低 | 弱(空气扰动) | 10-50 |

典型传感器配置方案:

- L2级辅助驾驶:1颗前视摄像头 + 1颗前向毫米波雷达 + 12颗超声波雷达(如特斯拉Autopilot)。

- L4级Robotaxi:5颗激光雷达 + 8颗摄像头 + 6颗毫米波雷达(如Waymo第五代系统)。

2. 融合层级与架构

2.1 数据级融合(早融合):

- 原理:在原始数据层面进行对齐与融合。例如,将激光雷达点云投影到摄像头图像,生成RGB-D数据。

- 优势:信息损失最小,适合低层特征提取。

- 挑战:时空同步要求高,需精确标定与硬件同步(如PTP协议)。

2.2 特征级融合(中融合):

- 原理:提取各传感器的特征后融合。例如,摄像头检测2D边界框,激光雷达生成3D检测框,通过卡尔曼滤波关联目标。

- 典型算法:

- PointPainting:将摄像头的语义分割结果映射到点云,增强点云语义信息。

- BEVFormer:将多视角图像转换为鸟瞰图,与激光雷达点云在BEV空间融合。

- 优势:平衡计算效率与信息完整性。

2.3 决策级融合(晚融合):

- 原理:各传感器独立输出结果后融合。例如,摄像头、激光雷达和毫米波雷达分别检测目标,通过投票机制确定最终结果。

- 应用场景:目标跟踪与路径规划阶段。

- 劣势:信息损失较大,可能因传感器误报导致冲突。

三、核心算法与关键技术

1. 传感器标定与同步

1.1 标定技术:

- 激光雷达-摄像头标定:使用棋盘格或特定标定板,通过最小化重投影误差优化外参矩阵。典型工具包括Autoware的LiDAR-Camera Calibrator,标定精度可达0.1°。

- 在线标定:基于SLAM(如LOAM算法)实时优化传感器外参,适应车辆振动和温度变化导致的参数漂移。

1.2 时间同步:

- 硬件同步:采用PTP(精确时间协议)实现微秒级同步,依赖GPS或原子钟。

- 软件插值:通过时间戳对齐和运动补偿(如IMU数据)修正异步误差。

2. 多模态数据融合算法

2.1 传统方法:

- 卡尔曼滤波:用于多传感器目标跟踪,假设线性运动模型。

- 扩展卡尔曼滤波(EKF):处理非线性系统(如车辆转弯时的运动方程),但计算复杂度高。

2.2 深度学习方法:

-

BEVFormer:

- 输入:多视角图像 + 激光雷达点云。

- 过程:通过Transformer提取图像特征,转换为BEV空间后与点云特征融合。

- 输出:3D目标检测与语义分割结果。

- 性能:在nuScenes数据集上,mAP达61.6%,较纯激光雷达方案提升12%。

-

TransFuser:

- 原理:使用跨模态注意力机制对齐图像和点云特征。

- 优势:在遮挡场景下(如被卡车部分遮挡的行人)召回率提升25%。

3. 实时性与算力优化

3.1 边缘计算平台:

- NVIDIA DRIVE Orin:算力254 TOPS,支持16路摄像头、5颗激光雷达和12颗雷达的并行处理。

- 华为MDC 810:算力400 TOPS,支持L4级自动驾驶的复杂融合算法。

3.2 模型轻量化技术:

- 知识蒸馏:将ResNet-101教师模型的知识迁移至MobileNet学生模型,计算量减少80%。

- 量化与剪枝:将FP32模型转换为INT8格式,模型体积压缩4倍,推理速度提升2倍。

四、挑战与解决方案

1. 极端环境下的可靠性

1.1 雨雾干扰:

- 激光雷达改进:采用1550nm波长(如禾赛AT128),穿透雨雾能力较905nm提升3倍。

- 算法补偿:基于深度学习的点云去噪模型(如PointCleanNet),在暴雨中误检率降低40%。

1.2 强光与暗光:

- HDR摄像头:动态范围达140dB(如索尼IMX490),在隧道出入口保持清晰成像。

- 热成像摄像头:用于夜间行人检测,与可见光摄像头融合提升召回率。

2. 传感器成本与量产平衡

2.1 低成本方案:

- 4D毫米波雷达:通过MIMO技术提升分辨率至0.5°,可部分替代激光雷达(如Arbe Phoenix单价300美元)。

- 固态激光雷达:速腾聚创M1价格降至500美元,体积缩小至信用卡大小。

2.2 纯视觉路线:

- 特斯拉FSD Beta:通过8颗摄像头和HydraNet算法实现纯视觉BEV感知,节省数万美元硬件成本。

3. 数据融合的不确定性

概率融合模型:

- Dempster-Shafer理论:处理冲突传感器数据,例如摄像头判定为行人而雷达判定为噪声时,通过置信度分配降低误判概率。

- 贝叶斯神经网络:输出预测结果的置信度区间,供决策模块参考。

五、行业应用与案例分析

1. 乘用车自动驾驶

1.1 Waymo第五代系统:

- 传感器配置:5颗激光雷达(360°覆盖)+ 29颗摄像头(包括远距和环视)+ 6颗毫米波雷达。

- 融合策略:

- 数据级融合:点云与图像对齐生成RGB-D数据。

- 决策级融合:多传感器投票机制过滤误检目标。

- 成效:在旧金山复杂路况中,目标检测召回率达99.9%。

- 官网地址 :https://waymo.com/

1.2 小鹏XNGP:

- 技术亮点:BEV + 激光雷达融合模型,支持无高精地图的城市NOA(导航辅助驾驶)。

- 数据:城市路口通过率提升35%,接管次数降至0.1次/千公里。

2. 商用车与Robotaxi

2.1 图森未来L4卡车:

- 冗余设计:双激光雷达 + 双摄像头 + 双计算单元,MTBF(平均无故障时间)超2000小时。

- 运营数据:在美国亚利桑那州实现全程无人化货运,油耗降低10%。

2.2 Cruise Origin:

- 无方向盘设计:依赖360°融合感知系统,夜间运营占比达60%。

- 安全记录:累计500万英里零责任事故。

3. 开源平台

3.1 Apollo Cyber RT:

- 功能:支持多传感器数据流调度,延迟低于10ms。

- 应用案例:极狐阿尔法S Hi版搭载Apollo系统,实现城区自动驾驶。

3.2 Autoware.Auto:

- 贡献:提供开源标定工具链和融合参考实现,降低开发门槛。

六、未来趋势

1、传感器技术的融合演进:

- 4D毫米波雷达 + 摄像头模组:Mobileye EyeQ6集成4D雷达与12颗摄像头,成本控制在1000美元以内。

- FMCW激光雷达:通过调频连续波技术同时测量距离与速度,探测距离达500m(如Aeva Aeries II)。

2、AI算法的突破方向:

- 神经辐射场(NeRF):从多视角图像重建高精度3D场景,替代传统SLAM。

- 多任务联合训练:检测、跟踪、预测端到端优化,减少模块间信息损失。

3、车路协同与云融合:

- 路侧单元(RSU):通过5G传输全局交通信息,弥补车载传感器盲区。

- 边缘云平台:实时更新高精地图,降低车载计算负载。

七、结语

多传感器融合并非传感器的简单堆砌,而是通过算法与工程化实现"1+1>2"的感知跃迁。随着固态激光雷达和4D毫米波雷达的普及,硬件成本正以每年20%的速度下降。与此同时,BEVFormer、TransFuser等算法的成熟,正推动融合架构从实验室走向量产车。未来,自动驾驶将不再是冰冷的技术堆叠,而是人、车、路协同的智能生态。在这一进程中,多传感器融合将始终扮演核心角色,驱动汽车从"移动工具"向"智慧伙伴"进化。

附录

-

术语表:

- FOV(视场角):传感器有效探测角度。

- ROI(感兴趣区域):算法重点处理的图像或点云区域。

-

性能指标:

- mAP(平均精度):目标检测算法综合性能指标。

- FPS(帧率):每秒处理帧数,衡量实时性。

-

参考文献:

- 《Multiple View Geometry in Computer Vision》(Richard Hartley, 2003)。

- Waymo技术报告《The Waymo Driver: A Fully-Integrated Autonomous System》(2023)。

延伸阅读