在深度学习领域,PyTorch 和 TensorFlow 就像 "倚天剑与屠龙刀"------ 前者以灵活著称,后者靠工程落地强势,却常让开发者陷入 "选哪个" 的困境。本文将从实际使用场景出发,用通俗解释 + 代码示例,拆解两者的核心差异,帮你快速找到适配工具。

一、核心差异:从 "设计理念" 看本质

框架的差异根源在设计理念,最直观的就是动态图 vs 静态图(可理解为 "边做边改" vs "先画菜谱再做饭")。

1.1 动态图:PyTorch 的 "灵活基因"

PyTorch 采用动态计算图,代码执行逻辑和 Python 原生逻辑完全一致 ------ 写一行执行一行,支持实时调试和动态修改模型结构。

代码示例:动态图的 "即时反馈"

python

import torch

import torch.nn as nn

# 1. 定义简单线性回归模型(类继承+前向传播,纯Python逻辑)

class LinearModel(nn.Module):

def __init__(self):

super().__init__()

self.linear = nn.Linear(1, 1) # 输入1维→输出1维

def forward(self, x):

# 动态调试:随时打印中间结果(静态图做不到)

print(f"输入张量形状:{x.shape}")

return self.linear(x)

# 2. 初始化组件

model = LinearModel()

loss_fn = nn.MSELoss()

optimizer = torch.optim.SGD(model.parameters(), lr=0.01)

# 3. 模拟数据+训练(每一步都可实时查看)

x = torch.tensor([[1.0], [2.0], [3.0]], dtype=torch.float32)

y = torch.tensor([[2.0], [4.0], [6.0]], dtype=torch.float32)

for epoch in range(50):

y_pred = model(x) # 前向传播:即时执行,可打断点调试

loss = loss_fn(y_pred, y)

optimizer.zero_grad()

loss.backward() # 反向传播:动态计算梯度

optimizer.step()

# 实时打印损失(动态图的核心优势:无需等待完整图构建)

if epoch % 10 == 0:

print(f"Epoch {epoch} | Loss: {loss.item():.4f}")

# 测试:即时预测(无需额外"执行图"步骤)

test_x = torch.tensor([[4.0]], dtype=torch.float32)

print(f"预测4.0的结果:{model(test_x).item():.2f}") # 输出≈8.0核心优势:

-

调试友好:像写 Python 脚本一样加

print、断点,适合快速验证想法; -

灵活性高:支持条件判断(如

if x.shape[0]>10: ...)、循环等动态逻辑,适配复杂模型(如 GNN、强化学习)。

1.2 静态图:TensorFlow 的 "工程底子"

TensorFlow 早期(1.x 版本)采用静态计算图 :需先定义完整的 "计算流程"(画好菜谱),再传入数据执行(按菜谱做饭)。2.x 版本后引入Eager Execution(默认开启),兼容动态图,但静态图的 "优化基因" 仍保留在核心功能中。

代码示例 1:TensorFlow 2.x 动态模式(贴近 PyTorch)

python

# 静态图:先定义计算流程,再执行(适合大规模优化)

@tf.function # 装饰器:将函数转为静态图

def train_step(x, y, model, loss_fn, optimizer):

with tf.GradientTape() as tape:

y_pred = model(x)

loss = loss_fn(y_pred, y)

grads = tape.gradient(loss, model.trainable_variables)

optimizer.apply_gradients(zip(grads, model.trainable_variables))

return loss

# 执行静态图(一次编译,多次执行,速度更快)

loss_fn = tf.keras.losses.MeanSquaredError()

optimizer = tf.keras.optimizers.SGD(learning_rate=0.01)

for epoch in range(50):

loss = train_step(x, y, model, loss_fn, optimizer)

if epoch % 10 == 0:

print(f"Epoch {epoch} | Loss: {loss:.4f}")代码示例 2:TensorFlow 静态图模式(适合生产优化)

python

# 静态图:先定义计算流程,再执行(适合大规模优化)

@tf.function # 装饰器:将函数转为静态图

def train_step(x, y, model, loss_fn, optimizer):

with tf.GradientTape() as tape:

y_pred = model(x)

loss = loss_fn(y_pred, y)

grads = tape.gradient(loss, model.trainable_variables)

optimizer.apply_gradients(zip(grads, model.trainable_variables))

return loss

# 执行静态图(一次编译,多次执行,速度更快)

loss_fn = tf.keras.losses.MeanSquaredError()

optimizer = tf.keras.optimizers.SGD(learning_rate=0.01)

for epoch in range(50):

loss = train_step(x, y, model, loss_fn, optimizer)

if epoch % 10 == 0:

print(f"Epoch {epoch} | Loss: {loss:.4f}")核心优势:

-

性能优化:静态图可提前做 "算子融合""内存优化",大规模数据训练时速度比动态图快 20%-50%;

-

部署友好:静态图结构固定,便于跨平台导出(如转 ONNX、TensorRT)。

二、全方位对比:从入门到落地

除了计算图,两者在易用性、生态、部署等维度差异也很明显,直接影响开发效率。

2.1 易用性:谁更适合新手?

| 维度 | PyTorch | TensorFlow |

|---|---|---|

| API 风格 | 纯 Pythonic,类 / 函数设计直观(如nn.Module) |

混合风格:Keras 封装简洁,但底层 API 较复杂(如tf.Tensor操作) |

| 调试体验 | 支持 Python 原生调试(pdb、断点),即时打印中间结果 | 动态模式支持调试,但静态图需用tf.print或 TensorBoard 查看 |

| 模型构建 | 需手动写forward方法,灵活性高 |

Keras 提供Sequential(简单模型)和Functional(复杂模型),快速搭建 |

结论:新手若熟悉 Python,优先选 PyTorch;若侧重 "快速搭模型不关心细节",可选 TensorFlow Keras。

2.2 生态系统:工具链谁更全?

框架的生态直接决定 "能做什么场景",两者各有侧重:

| 框架 | 核心工具链 | 领域扩展库 |

|---|---|---|

| PyTorch | - PyTorch Lightning :简化训练流程(自动处理 GPU / 分布式)- TorchScript :动态图转静态图- ONNX:跨框架部署 | - TorchVision :CV 领域(数据集、模型如 ResNet)- Hugging Face Transformers :NLP 领域(BERT、GPT)- TorchGeo:地理数据处理 |

| TensorFlow | - TensorBoard :可视化训练(损失、梯度、模型结构)- TF Serving :生产环境模型服务- TF Lite:移动 / 嵌入式部署 | - TensorFlow Hub :预训练模型库(可直接微调)- TF.js :网页端 AI(如浏览器端人脸识别)- TensorFlow Probability:概率模型(如贝叶斯网络) |

亮点场景:

-

NLP / 科研:PyTorch + Hugging Face 是绝对主流(90% 以上的最新论文用 PyTorch 复现);

-

可视化:TensorBoard 功能碾压 PyTorch 的 TensorBoardX(支持实时查看梯度分布、模型计算图)。

2.3 部署能力:生产环境谁更稳?

部署是从 "实验" 到 "产品" 的关键,两者差距主要在跨平台支持 和企业级工具:

| 部署场景 | PyTorch 解决方案 | TensorFlow 解决方案 |

|---|---|---|

| 服务器端生产 | - TorchServe:轻量级模型服务- ONNX Runtime:跨框架推理 | - TF Serving:工业级服务(支持负载均衡、版本管理)- TensorRT:GPU 加速推理(比 PyTorch 快 30%+) |

| 移动 / 嵌入式 | - PyTorch Mobile:轻量化部署(支持量化)- ONNX Mobile | - TF Lite:专用轻量化引擎(支持剪枝、量化、硬件加速,适配 iOS/Android/MCU) |

| 网页端 | - ONNX.js(间接支持,性能一般) | - TF.js:专用网页引擎(支持 WebGL 加速,无需后端) |

| 云服务集成 | 需手动适配(如 AWS SageMaker) | 深度集成 Google Cloud、AWS、Azure(如 GCP 的 TPU 直接支持) |

结论:企业级生产(尤其是跨平台)优先选 TensorFlow;科研原型转小规模服务,PyTorch + TorchServe 足够。

2.4 社区与资源:谁的 "靠山" 硬?

| 维度 | PyTorch | TensorFlow |

|---|---|---|

| 背后公司 | Meta(原 Facebook),开源社区主导 | Google,企业级支持(有专职团队维护) |

| 学术领域 | 论文复现率第一(CVPR、NeurIPS 论文 80% 附 PyTorch 代码) | 早期学术主流,现逐步被 PyTorch 超越,但企业级研究仍常用 |

| 企业应用 | 中小企业、创业公司(如 OpenAI、Stability AI)、Meta 内部 | 大型企业首选(Google、Netflix、Uber、阿里、腾讯)、政府项目常用 |

| 学习资源 | 教程偏实战(如 PyTorch 官方教程、李沐《动手学深度学习》) | 文档最详尽(覆盖所有场景)、官方教程体系完善(如 TensorFlow Developer Certificate) |

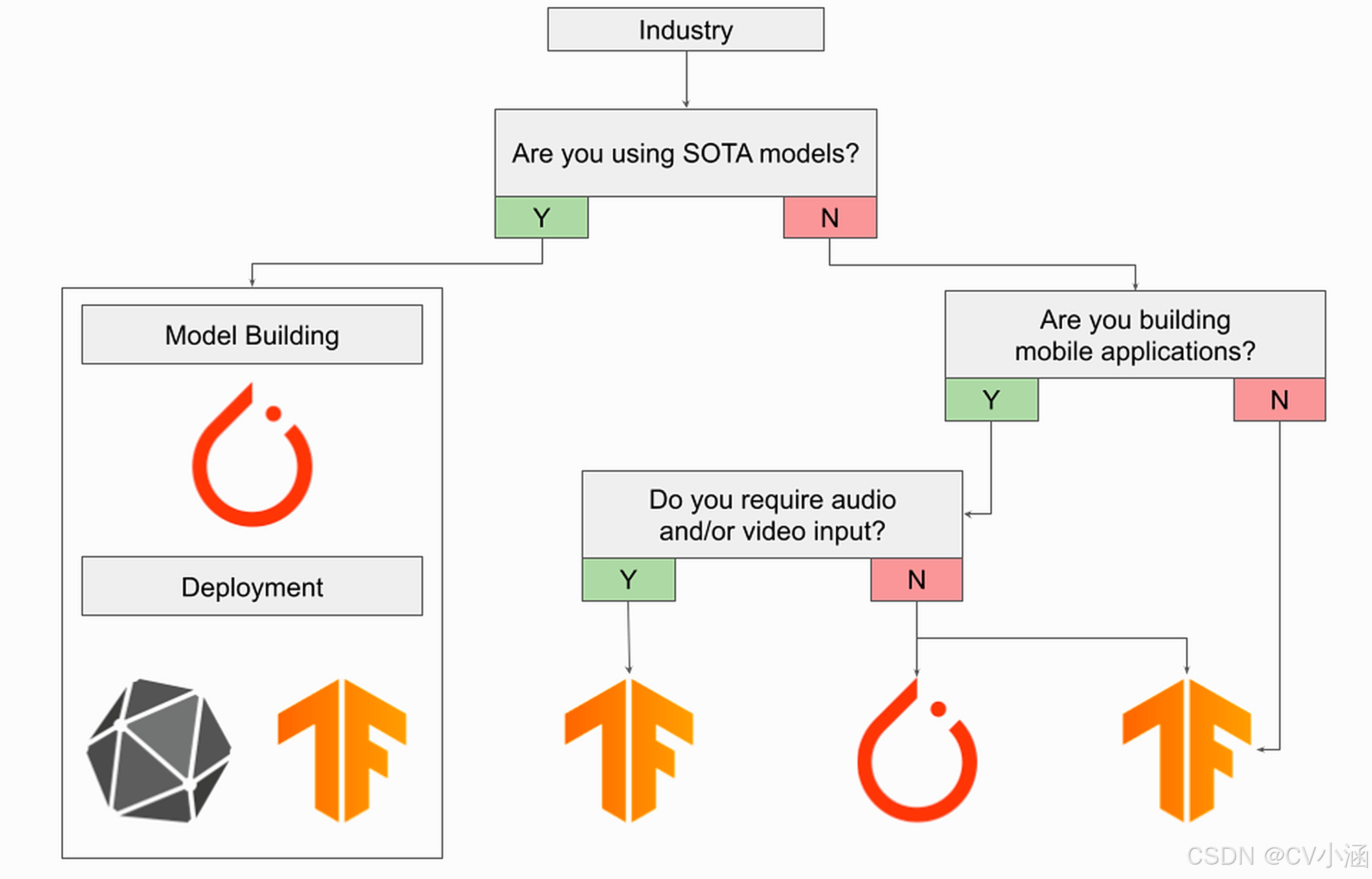

三、场景选型:该选谁?

不用纠结 "谁更好",而是看 "你要做什么":

| 需求场景 | 推荐框架 | 核心原因 |

|---|---|---|

| 科研探索 / 论文复现 | PyTorch | 动态图调试快,支持复杂模型结构,Hugging Face/TorchVision 生态完善 |

| 企业级生产部署(多平台) | TensorFlow | TF Serving/TF Lite 成熟,支持大规模集群、移动 / 网页端,与云服务集成好 |

| 新手入门学习 | PyTorch | API 更直观,调试体验好,能快速理解深度学习原理 |

| 移动 / 嵌入式开发 | TensorFlow | TF Lite 轻量化优化彻底,支持硬件加速,适配多设备 |

| 大规模数据训练(TB 级) | TensorFlow | 静态图性能优化好,支持 TPU/GPU 集群,内存管理更高效 |

四、总结:未来趋势与建议

-

趋同是必然:PyTorch 在加强部署能力(如 PyTorch Mobile、TorchServe),TensorFlow 在简化 API(如 Keras 默认化),未来两者差异会进一步缩小。

-

一主一辅:建议主攻一个框架(科研选 PyTorch,工程选 TensorFlow),了解另一个的基本用法 ------ 比如用 PyTorch 做实验,转 TensorFlow 部署。

-

动手优先:无论选哪个,先做一个小项目(如 MNIST 手写识别、房价预测),用代码感受差异,比看 10 篇对比文更有效。

最后,框架只是工具,核心还是你的深度学习能力 ------ 但选对工具,能让你少走 80% 的弯路。