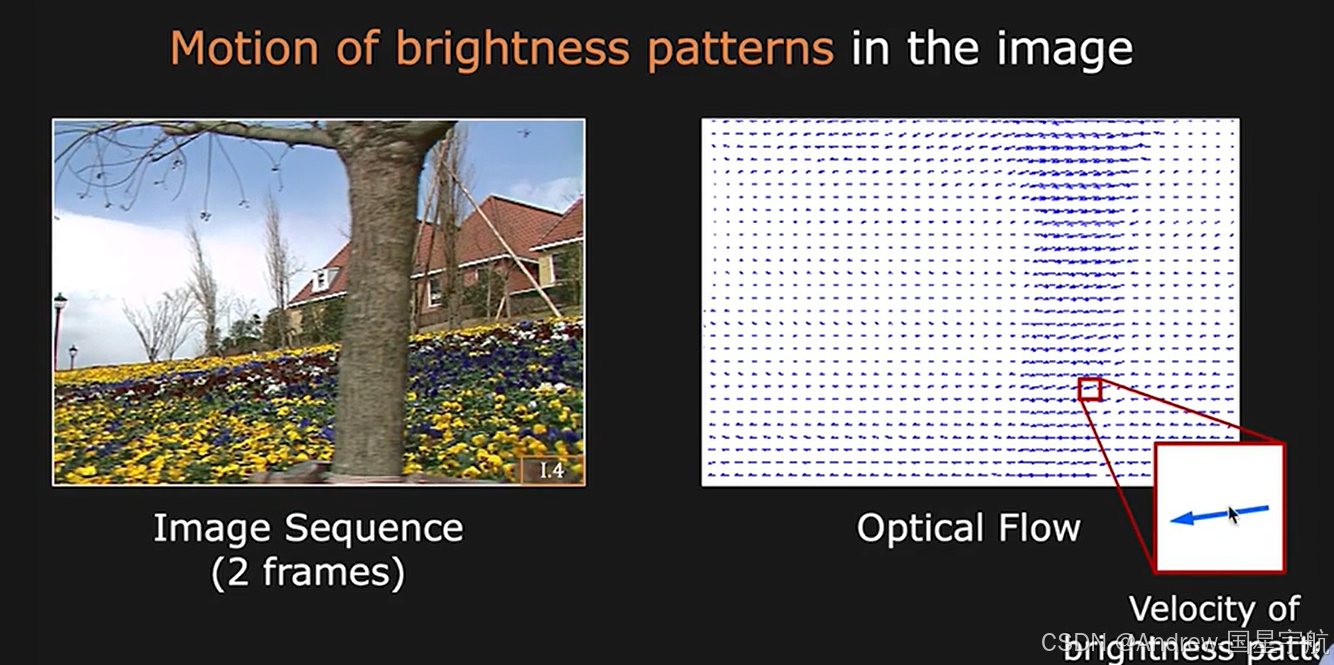

在计算机视觉领域,运动目标分析是核心任务之一,而光流法作为一种无标记运动估计技术,通过捕捉图像序列中像素的灰度变化,能够精准描述目标的运动轨迹和速度信息。它广泛应用于目标跟踪、行为识别、自动驾驶等场景,是AI算法工程师必须掌握的关键技术之一。本文将从光流法的核心原理出发,结合OpenCV实现Python实战,带你快速掌握光流法的应用技巧。

一、光流法核心原理

光流法的本质是通过分析连续帧图像中像素的灰度变化,计算像素在二维平面上的运动向量(即光流)。其实现基于两个关键假设:

- 亮度恒定假设:同一目标在连续帧中的灰度值保持不变,这是光流计算的基础前提。

- 空间一致性假设:相邻像素属于同一运动目标,因此它们的运动向量具有相似性。

根据这两个假设,可推导得到光流法的基本方程。设连续两帧图像中某像素的坐标分别为(x, y)和(x+u, y+v),其中(u, v)为该像素的光流向量,灰度值分别为I(x, y, t)和I(x+u, y+v, t+1)。根据亮度恒定假设,两帧灰度值满足I(x+u, y+v, t+1) = I(x, y, t)。对等式左侧进行泰勒展开并忽略高阶无穷小量,可得到光流基本方程:Iₓu + Iᵧv + Iₜ = 0,其中Iₓ、Iᵧ分别为像素在x、y方向的灰度梯度,Iₜ为灰度值随时间的变化率。

由于单个方程无法求解两个未知数u和v,需要引入额外约束条件。常用的方法包括Lucas-Kanade算法(基于局部窗口的最小二乘解)和Farneback算法(全局稠密光流估计),前者适用于稀疏光流计算,后者适用于稠密光流计算,本文将重点实现这两种算法的Python实战。

二、Python实战:基于OpenCV的光流法实现

OpenCV提供了成熟的光流法API,支持稀疏光流(Lucas-Kanade算法)和稠密光流(Farneback算法)的快速实现。下面将通过两个实战案例,分别演示两种光流法的应用。

1. 环境准备

首先确保安装OpenCV库,若未安装可通过以下命令安装:

bash

pip install opencv-python2. 实战一:稀疏光流(Lucas-Kanade算法)

稀疏光流仅计算图像中关键像素(如角点)的光流向量,计算速度快,适用于实时目标跟踪场景。步骤如下:

- 读取视频序列,提取第一帧并检测角点(使用Shi-Tomasi角点检测)。

- 对后续帧,使用Lucas-Kanade算法计算角点的光流向量。

- 绘制光流轨迹,可视化目标运动情况。

代码实现

python

import cv2

import numpy as np

# 读取视频

cap = cv2.VideoCapture('test_video.mp4')

# 定义Shi-Tomasi角点检测参数

feature_params = dict(maxCorners=100, qualityLevel=0.3, minDistance=7, blockSize=7)

# 定义Lucas-Kanade光流参数

lk_params = dict(winSize=(15, 15), maxLevel=2, criteria=(cv2.TERM_CRITERIA_EPS | cv2.TERM_CRITERIA_COUNT, 10, 0.03))

# 生成随机颜色用于绘制轨迹

color = np.random.randint(0, 255, (100, 3))

# 读取第一帧并转为灰度图

ret, old_frame = cap.read()

old_gray = cv2.cvtColor(old_frame, cv2.COLOR_BGR2GRAY)

# 检测第一帧的角点

p0 = cv2.goodFeaturesToTrack(old_gray, mask=None, **feature_params)

# 创建掩码用于绘制轨迹

mask = np.zeros_like(old_frame)

while True:

# 读取当前帧

ret, frame = cap.read()

if not ret:

break

frame_gray = cv2.cvtColor(frame, cv2.COLOR_BGR2GRAY)

# 计算稀疏光流

p1, st, err = cv2.calcOpticalFlowPyrLK(old_gray, frame_gray, p0, None, **lk_params)

# 筛选跟踪成功的角点

good_new = p1[st == 1]

good_old = p0[st == 1]

# 绘制光流轨迹

for i, (new, old) in enumerate(zip(good_new, good_old)):

a, b = new.ravel()

c, d = old.ravel()

mask = cv2.line(mask, (int(a), int(b)), (int(c), int(d)), color[i].tolist(), 2)

frame = cv2.circle(frame, (int(a), int(b)), 5, color[i].tolist(), -1)

# 合并图像与轨迹掩码

img = cv2.add(frame, mask)

# 显示结果

cv2.imshow('Sparse Optical Flow (Lucas-Kanade)', img)

# 按键退出

if cv2.waitKey(30) & 0xFF == 27:

break

# 更新前一帧和前一角点

old_gray = frame_gray.copy()

p0 = good_new.reshape(-1, 1, 2)

# 释放资源

cap.release()

cv2.destroyAllWindows()代码诠释

- 视频读取:使用

cv2.VideoCapture读取测试视频,若需使用摄像头实时处理,可将参数改为0。 - 角点检测:

cv2.goodFeaturesToTrack通过Shi-Tomasi算法检测第一帧的角点,这些角点具有灰度变化明显、稳定性高的特点,适合作为跟踪目标。 - 光流计算:

cv2.calcOpticalFlowPyrLK实现Lucas-Kanade算法,通过金字塔分层策略提高光流估计的鲁棒性,支持大位移目标跟踪。 - 轨迹绘制:通过掩码图层记录角点的运动轨迹,使用不同颜色区分不同角点,最终与当前帧合并显示,直观呈现目标运动情况。

3. 实战二:稠密光流(Farneback算法)

稠密光流计算图像中所有像素的光流向量,能够完整描述整个图像的运动场,适用于运动分割、全景拼接等场景。步骤如下:

- 读取视频序列,将连续两帧转为灰度图。

- 使用Farneback算法计算稠密光流向量。

- 将光流向量转换为颜色和幅值图像,可视化运动场。

代码实现

python

import cv2

import numpy as np

# 读取视频

cap = cv2.VideoCapture('test_video.mp4')

# 读取第一帧并转为灰度图

ret, prev_frame = cap.read()

prev_gray = cv2.cvtColor(prev_frame, cv2.COLOR_BGR2GRAY)

# 定义颜色映射表用于可视化

hsv = np.zeros_like(prev_frame)

hsv[..., 1] = 255 # 饱和度设为255,保证颜色鲜艳

while True:

# 读取当前帧

ret, curr_frame = cap.read()

if not ret:

break

curr_gray = cv2.cvtColor(curr_frame, cv2.COLOR_BGR2GRAY)

# 计算稠密光流(Farneback算法)

flow = cv2.calcOpticalFlowFarneback(prev_gray, curr_gray, None, 0.5, 3, 15, 3, 5, 1.2, 0)

# 将光流向量转换为极坐标(幅值和角度)

mag, ang = cv2.cartToPolar(flow[..., 0], flow[..., 1])

# 根据角度设置色相(H通道),根据幅值设置亮度(V通道)

hsv[..., 0] = ang * 180 / np.pi / 2 # 角度转为0-180范围

hsv[..., 2] = cv2.normalize(mag, None, 0, 255, cv2.NORM_MINMAX) # 幅值归一化到0-255

# 将HSV图像转为BGR图像,用于显示

flow_img = cv2.cvtColor(hsv, cv2.COLOR_HSV2BGR)

# 合并原始帧和光流图像

result = cv2.hconcat([curr_frame, flow_img])

# 显示结果

cv2.imshow('Dense Optical Flow (Farneback)', result)

# 按键退出

if cv2.waitKey(30) & 0xFF == 27:

break

# 更新前一帧

prev_gray = curr_gray.copy()

# 释放资源

cap.release()

cv2.destroyAllWindows()代码诠释

- 稠密光流计算:

cv2.calcOpticalFlowFarneback实现Farneback算法,通过多项式展开近似像素的运动,能够处理多尺度、大位移的运动场景,输出所有像素的光流向量(shape为[H, W, 2],分别对应x、y方向的速度)。 - 可视化处理:将光流向量转换为极坐标形式,角度对应运动方向(映射为色相H),幅值对应运动速度(映射为亮度V),通过HSV颜色空间直观呈现运动场的分布情况。

- 结果合并:将原始帧与光流图像横向拼接,方便对比观察目标运动与光流的对应关系。

三、结果分析与应用场景

1. 结果解读

- 稀疏光流:仅跟踪角点等关键像素,轨迹清晰,计算速度快(可达实时),但无法反映图像中所有像素的运动情况,适用于目标跟踪、运动参数估计等场景。

- 稠密光流:覆盖所有像素,能够完整描述运动场,适合运动分割、背景建模等场景,但计算量较大,对硬件性能有一定要求。

2. 实际应用场景

- 目标跟踪:在监控视频中跟踪行人、车辆等目标,无需预先标记目标,适应复杂背景下的运动跟踪。

- 行为识别:通过分析人体关节点的光流向量,识别跑步、跳跃等行为动作,应用于智能监控、体育分析等领域。

- 自动驾驶:检测道路上车辆、行人的运动速度和方向,为决策系统提供环境感知信息,保障行驶安全。

- 图像稳定:通过计算图像的光流向量,补偿相机的抖动,实现视频防抖效果。

四、技术优化与进阶方向

- 光流法局限性:传统光流法依赖亮度恒定假设,当目标存在遮挡、光照变化或快速运动时,估计精度会下降。可通过融合深度学习方法(如FlowNet)提升鲁棒性。

- 性能优化:稠密光流计算量较大,可通过GPU加速(如OpenCV的CUDA版本)或图像下采样减少计算开销,满足实时性需求。

- 多目标跟踪:结合目标检测算法(如YOLO),先检测目标区域,再在区域内计算光流,实现精准的多目标跟踪。

- 3D运动估计:结合相机内参,将2D光流向量转换为3D运动信息,应用于三维重建、机器人导航等场景。

五、总结

本文详细介绍了光流法的核心原理,通过Python+OpenCV实现了稀疏光流和稠密光流的实战案例,并分析了其应用场景和优化方向。光流法作为一种经典的运动估计技术,在计算机视觉领域具有广泛的应用价值,尤其在目标跟踪、行为识别等任务中发挥着重要作用。

对于AI算法工程师而言,掌握光流法不仅能够提升运动目标分析的技术能力,还能为业务场景提供高效的解决方案。后续可进一步探索深度学习与光流法的结合,提升复杂场景下的运动估计精度,推动技术在实际业务中的落地应用。