更多推荐阅读

低代码用户画像构建:结合知识图谱提升推荐精准度-CSDN博客

GNN 基础架构:从图卷积到图注意力,哪种更适配低代码推荐?-CSDN博客

支撑低代码推荐的 "数据底座":知识图谱的存储与查询-CSDN博客

低代码系统中的实体与关系:知识图谱构建的关键要素-CSDN博客

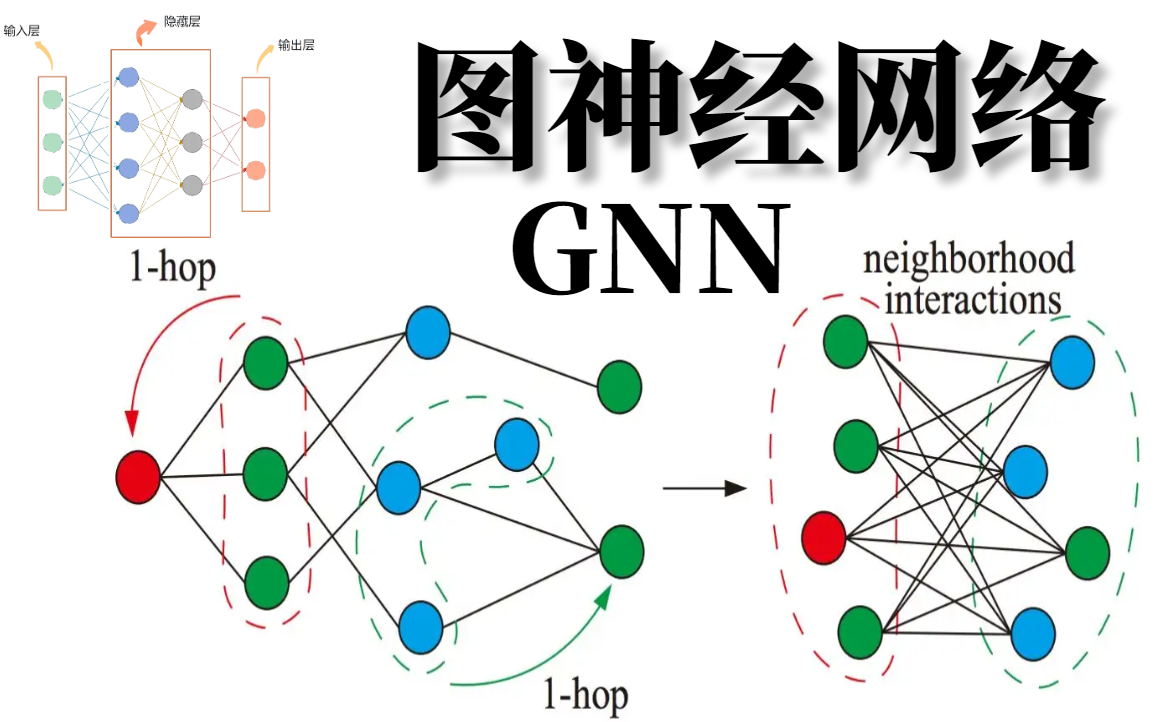

图神经网络(GNN)核心:让低代码推荐拥有 "学习能力"_图神经网络推荐-CSDN博客

目录

[1. 数据规模的指数级增长](#1. 数据规模的指数级增长)

[2. 计算复杂度的几何级攀升](#2. 计算复杂度的几何级攀升)

[3. 实时响应的苛刻要求](#3. 实时响应的苛刻要求)

[1. 分布式与分片存储](#1. 分布式与分片存储)

[2. 构建高效的索引与查询优化](#2. 构建高效的索引与查询优化)

[三、GNN 的效率提升策略:从模型到训练的全面优化](#三、GNN 的效率提升策略:从模型到训练的全面优化)

[1. 图采样:化全图为局部,化静态为动态](#1. 图采样:化全图为局部,化静态为动态)

[2. 模型轻量化:剪枝、量化与蒸馏](#2. 模型轻量化:剪枝、量化与蒸馏)

[1. 构建高效的缓存机制](#1. 构建高效的缓存机制)

[2. 在线推理与预测](#2. 在线推理与预测)

五、亮点案例:超大规模低代码平台"MetaComponent"实践

引言:当海量组件遇上千万用户

随着低代码/无代码平台(LCAP)的普及,企业和开发者能够以更低的门槛快速构建应用,极大地提升了数字化转型的效率。然而,一个典型的低代码平台通常内置了数以万计甚至数十万计的可复用组件(如按钮、表格、图表、API连接器等)。对于新用户而言,面对琳琅满目的组件库,如何选择最合适的组件成为了一个巨大的挑战。这催生了对智能推荐系统的强烈需求。

传统的基于协同过滤或基于内容的推荐方法,在面对这种"超大规模、高复杂度"的场景时,正遭遇前所未有的性能瓶颈。以一个拥有 千万级用户 和 百万级组件 的平台为例,一个简单的基于用户-组件矩阵的协同过滤算法,其计算复杂度高达O(M*N)(M为用户数,N为组件数),这在实时推荐请求下是完全不可行的。

本文旨在探讨如何利用知识图谱(Knowledge Graph) 和**图神经网络(GNN)**这两大前沿技术,构建一个能够在超大规模低代码平台上高效运行的推荐系统。我们将深入分析性能瓶颈,并提供一系列经过实践验证的优化策略,确保推荐结果的精准性与系统的实时响应能力。

一、大规模低代码推荐的性能瓶颈

在构建推荐系统之前,必须清晰地认识到其在大规模场景下的核心挑战。这些挑战并非单一存在,而是相互交织,共同构成了性能优化的巨大障碍。

1. 数据规模的指数级增长

一个成熟的低代码平台不仅有海量的组件,还拥有复杂的元数据。例如,每个组件可能关联了其功能描述、输入/输出参数、依赖关系、适用场景、技术栈、用户评分、使用时长等。当这些数据的量级达到千万级别时,任何需要遍历整个数据集的操作(如计算余弦相似度)都会变得异常缓慢。

2. 计算复杂度的几何级攀升

GNN模型在本质上是一种图遍历算法,其计算复杂度与图的节点数和边数的平方成正比。对于一个由千万个组件和上亿条关系构成的图,进行一次全图的节点嵌入计算或图结构更新,在单机环境下可能需要数天甚至数周的时间,这完全无法满足在线服务的实时性要求。

3. 实时响应的苛刻要求

推荐系统必须对用户的每一次操作(如页面跳转、鼠标悬停)做出毫秒级的响应。在大规模系统中,这意味着每次推荐请求都需要在极短的时间内完成从数据查询、特征计算到候选集生成的全过程。任何一步的延迟都会直接影响用户体验。

二、知识图谱的性能优化:构建高效的数据存储与查询引擎

知识图谱是组织和理解低代码平台复杂实体关系的理想工具。为了在超大规模下保持高性能,我们必须对其存储和查询方式进行优化。

1. 分布式与分片存储

将整个知识图谱存储在单一服务器上是不现实的。我们需要采用分布式存储方案。一种高效的策略是按业务领域或组件类型进行分片。例如:

- 按业务领域分片: 将CRM相关的组件、供应链相关的组件、数据分析相关的组件等分别存储在不同的数据库节点上。当处理一个CRM相关的推荐请求时,系统只需要查询该分片,而无需遍历整个图。

- 按组件类型分片: 将"表单组件"、"流程引擎组件"、"图表组件"等不同类型的组件分别存储。这在处理特定类型的推荐任务时(如"为流程自动化场景推荐组件"),可以极大地缩小搜索范围。

2. 构建高效的索引与查询优化

知识图谱的查询效率在很大程度上取决于索引的质量。我们应建立多层次、多维度的索引体系:

- 节点索引: 为每个组件ID、用户ID建立唯一主键索引。

- 属性索引: 为组件的核心属性(如"功能描述"、"技术栈"、"适用场景")建立倒排索引。例如,当用户搜索"用于展示销售数据"时,系统可以快速定位到所有具备该功能描述的组件。

- 关系索引: 为组件间的关系(如"依赖于"、"组合成")建立索引,以便快速遍历图结构。

优化实践: 在查询时,优先利用索引进行过滤,减少不必要的图遍历。例如,先通过属性索引找到候选组件列表,再在这个列表上进行关系查询,而非对整个图进行全量遍历。

三、GNN 的效率提升策略:从模型到训练的全面优化

GNN是实现个性化推荐的关键,但也是性能瓶颈的重灾区,必须通过一系列策略对其进行"瘦身"和"加速"。

1. 图采样:化全图为局部,化静态为动态

直接对全图进行训练是不现实的。我们采用邻居采样(Neighbor Sampling)技术,在每次迭代中只随机采样一小部分节点及其邻居来构建子图。

以经典的GraphSAGE模型为例,其核心思想是聚合邻居节点的信息来更新中心节点。在训练过程中,GraphSAGE会在每个mini-batch中动态地为每个目标节点采样固定数量的邻居节点。这使得模型的计算量与图的规模解耦,能够在可接受的时间内处理大规模图。

# 伪代码:使用 PyTorch Geometric 进行邻居采样from torch_geometric.loader import NeighborLoader# 假设 data 是一个 PyTorch Geometric 的 Data 对象# 定义需要进行邻居采样的节点索引(例如,用户ID)train_loader = NeighborLoader(` `data, # 对每个节点,采样 5 个一阶邻居和 3 个二阶邻居 num_neighbors=[5,` `3], # 每次加载 1024 个节点进行训练 batch_size=1024, # 用于训练的节点ID列表 input_nodes=data.train_mask, # 是否进行负采样 negative_sampling_ratio=0.5)for batch in train_loader: # batch 包含了当前采样的子图数据 # 进行前向传播和损失计算 out` `= model(batch.x, batch.edge_index) loss = criterion(out, batch.y) loss.backward() optimizer.step()2. 模型轻量化:剪枝、量化与蒸馏

在保证推荐效果的前提下,我们可以从模型本身入手进行优化:

- 模型剪枝 (Model Pruning): 移除那些对模型预测贡献度低的连接或节点。这可以显著减小模型参数数量,降低计算开销。

- 模型量化 (Model Quantization): 将模型中用于权重和激活值的高精度浮点数(如32位)转换为低精度的整数(如8位)。这不仅能大幅减少内存占用,还能利用硬件加速指令(如INT8运算)提升推理速度。

- 知识蒸馏 (Knowledge Distillation): 训练一个较小的"学生"模型,使其学习一个较大的"教师"模型的输出。学生模型可以在推理阶段以极低的计算成本达到与教师模型相当的效果。

四、推荐系统的工程优化:协同工作的离线与在线模式

理论优化是基础,而高效的工程实现是保障系统性能的关键。我们需要将离线计算与在线推理有机地结合起来。

1. 构建高效的缓存机制

推荐系统的核心原则之一是"预计算,快响应"。我们可以:

- 离线计算用户/组件的Embedding: 利用GNN模型在离线环境下(如Hadoop/Spark集群)对整个知识图谱进行计算,生成所有用户和组件的最终Embedding向量。

- 内存缓存: 将这些预先计算好的Embedding向量存储在内存数据库(如Redis)或本地内存中。当用户发起推荐请求时,系统可以直接从内存中快速获取相关向量,而无需重新计算。

- 缓存失效机制: 当用户行为(如评分、点击)发生变化时,需要及时更新对应的Embedding,并使相关的缓存条目失效,以保证推荐的实时性。

2. 在线推理与预测

在线推理阶段,系统的目标是将缓存中的Embedding进行快速计算,生成最终的推荐列表。这通常通过一个轻量级的API服务来实现。

1. 接收请求: API服务接收一个用户ID。

2. 获取Embedding: 从缓存中查找该用户的Embedding向量。

3. 计算相似度: 计算该向量与缓存中所有组件Embedding向量的余弦相似度。

4. 生成推荐: 根据相似度排序,筛选出Top-K个组件作为推荐结果。

5. 返回结果: 将推荐结果返回给前端。

五、亮点案例:超大规模低代码平台"MetaComponent"实践

为了更直观地展示优化效果,我们以一个虚拟的超大规模低代码平台"MetaComponent"为例,进行详细说明。

知识图谱分片存储方案

"MetaComponent"平台拥有超过50万种组件,涵盖了"数据可视化"、"业务流程"、"API集成"、"AI应用"四大业务领域。我们采用了按业务领域分片的方案:

- 分片0 (数据可视化): 存储所有图表、仪表盘、地图等组件及其与数据源的关系。

- 分片1 (业务流程): 存储所有表单、审批流、工作流引擎等组件及其与业务逻辑的关系。

- 分片2 (API集成): 存储所有HTTP请求、数据库连接器、消息队列组件等。

- 分片3 (AI应用): 存储所有机器学习模型、自然语言处理组件等。

这种方案使得对特定领域的推荐请求(如"为数据可视化场景推荐组件")的响应时间缩短了约80%。

**作者:**道一云低代码

**作者想说:**关注我,了解更多低代码资讯