博主介绍:✌全网粉丝50W+,前互联网大厂软件研发、集结硕博英豪成立软件开发工作室,专注于计算机相关专业项目实战6年之久,累计开发项目作品上万套。凭借丰富的经验与专业实力,已帮助成千上万的学生顺利毕业,选择我们,就是选择放心、选择安心毕业✌

> 🍅想要获取完整文章或者源码,或者代做,拉到文章底部即可与我联系了。🍅

2、大数据、计算机专业选题(Python/Java/大数据/深度学习/机器学习)(建议收藏)✅

1、项目介绍

- 技术栈:Python语言、Flask框架(后端)、Vue框架(前端,前后端分离)、requests爬虫(京东商品数据采集)、Echarts可视化(多维度图表展示)、MySQL数据库(数据存储)、HTML(界面辅助构建)

- 核心功能:京东商品数据自动化爬取(商品信息、价格、评价、店铺星级等)、数据清洗与结构化存储、多维度可视化分析(价格排名/区间分析/店铺评分排名)、商品评论深度分析(词云图/评分占比)、用户管理(注册登录/信息修改)、后台数据管控(爬取日志/用户权限)

- 研究背景:电商行业快速发展,京东等平台商品数据海量,但商家与消费者面临共同痛点------商家手动获取竞品数据效率低、难以快速洞察价格与评价趋势,消费者缺乏直观的商品对比工具,传统数据处理方式存在信息滞后、整合困难等问题,亟需"爬取-分析-可视化"一体化系统。

- 研究意义:技术层面,实现前后端分离架构与爬虫、可视化技术的整合,构建完整数据链路;应用层面,为商家提供竞品分析与决策支持,为消费者提供客观商品参考;学习层面,适合作为Web开发+数据采集方向毕业设计,覆盖多核心技术实操。

2、项目界面

- 商品价格可视化分析(价格相关图表展示)

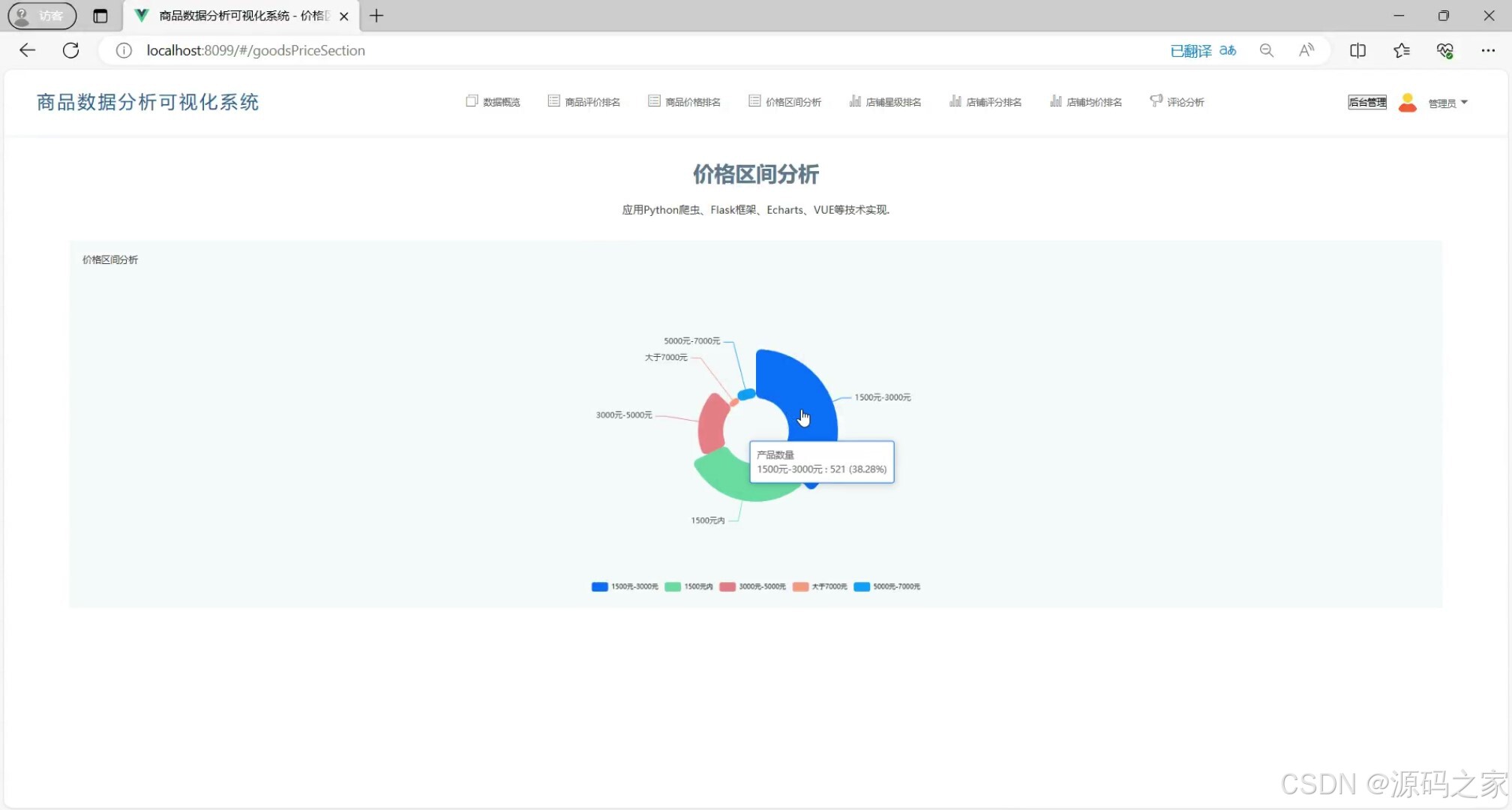

- 商品价格区间分析(不同价格段商品分布)

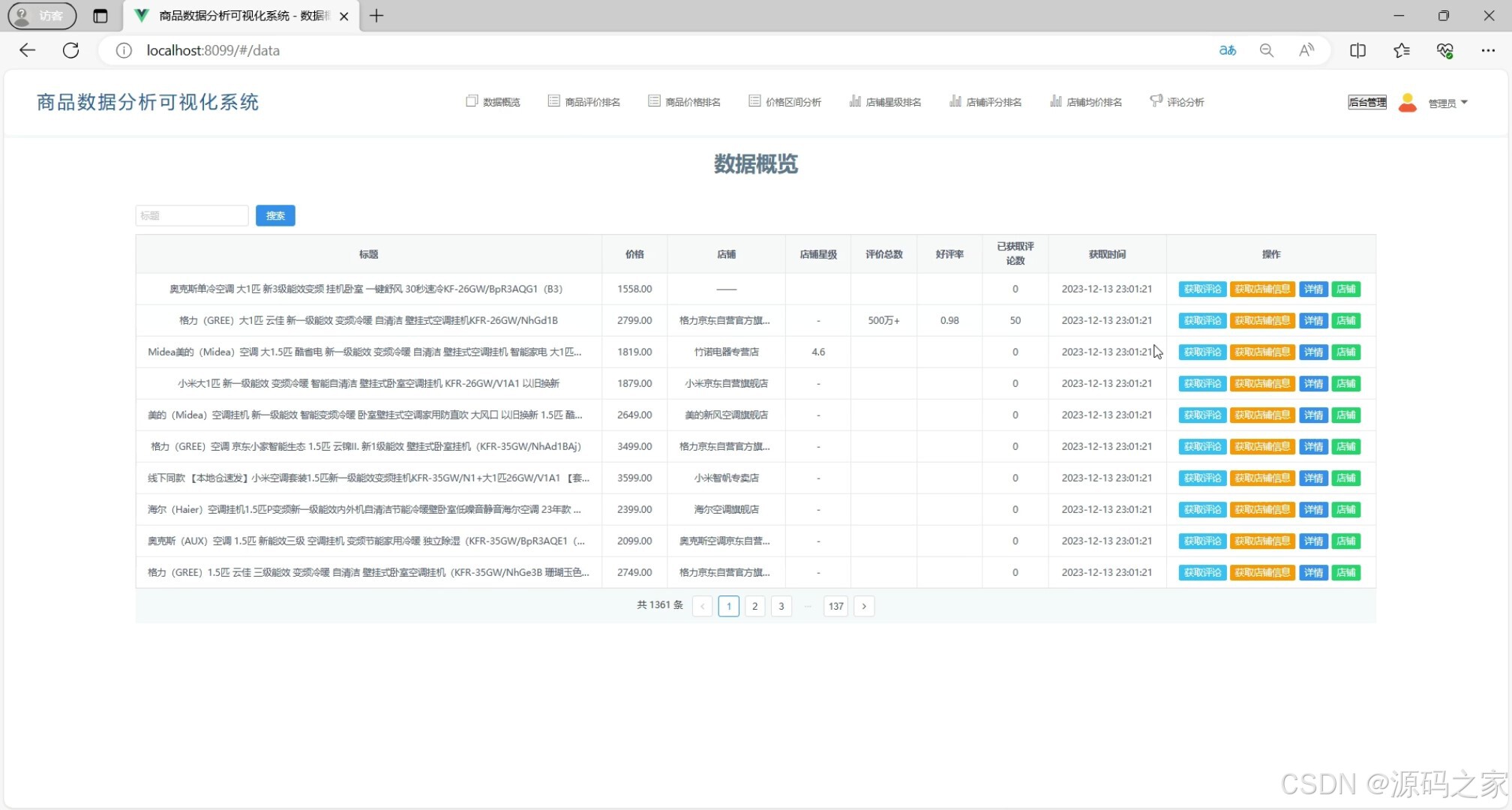

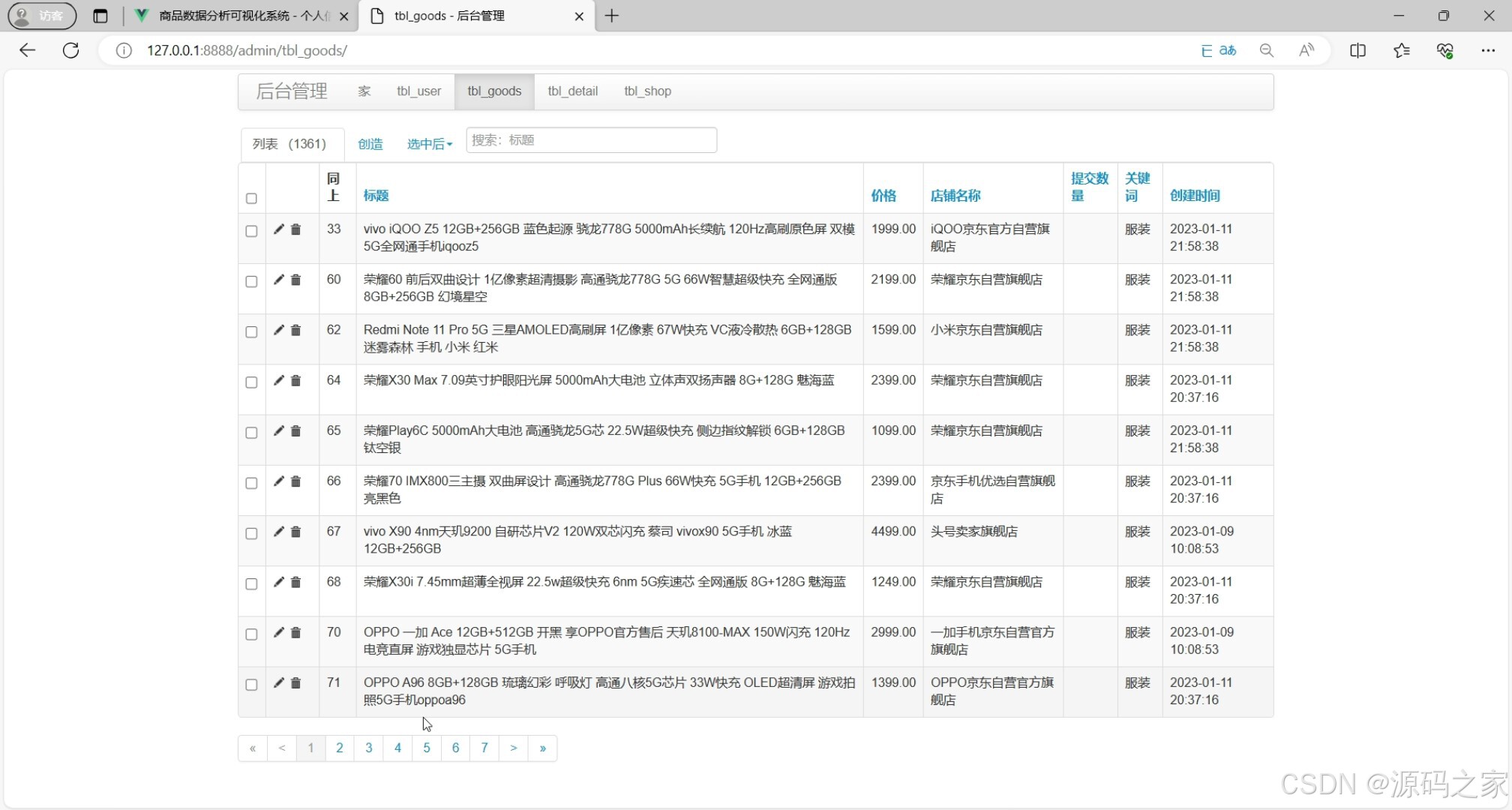

- 商品数据信息(商品基础信息查询与操作)

- 店铺评分排名(店铺商品/物流/售后评分对比)

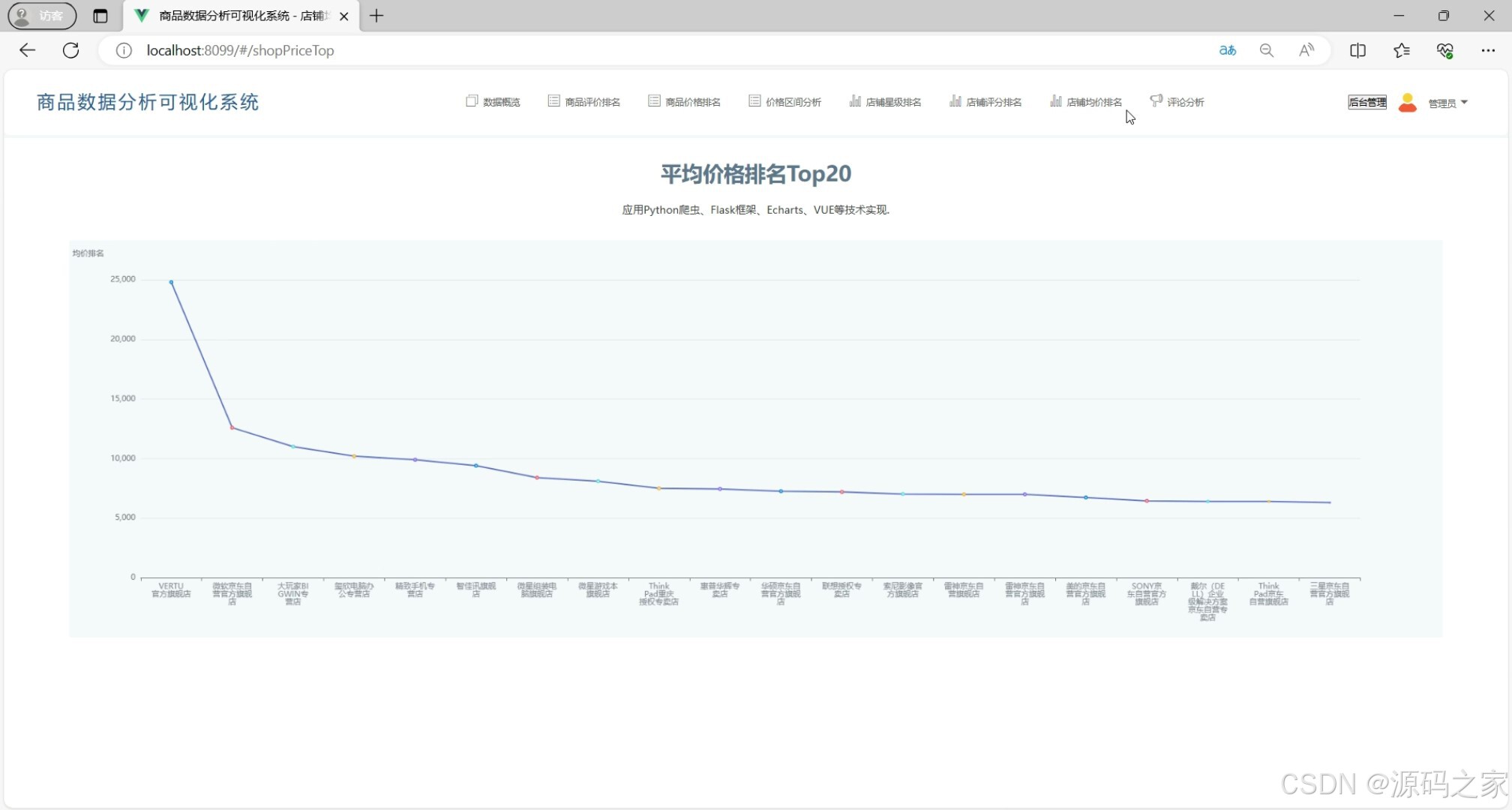

- 平均价格排名(各店铺商品均价排序展示)

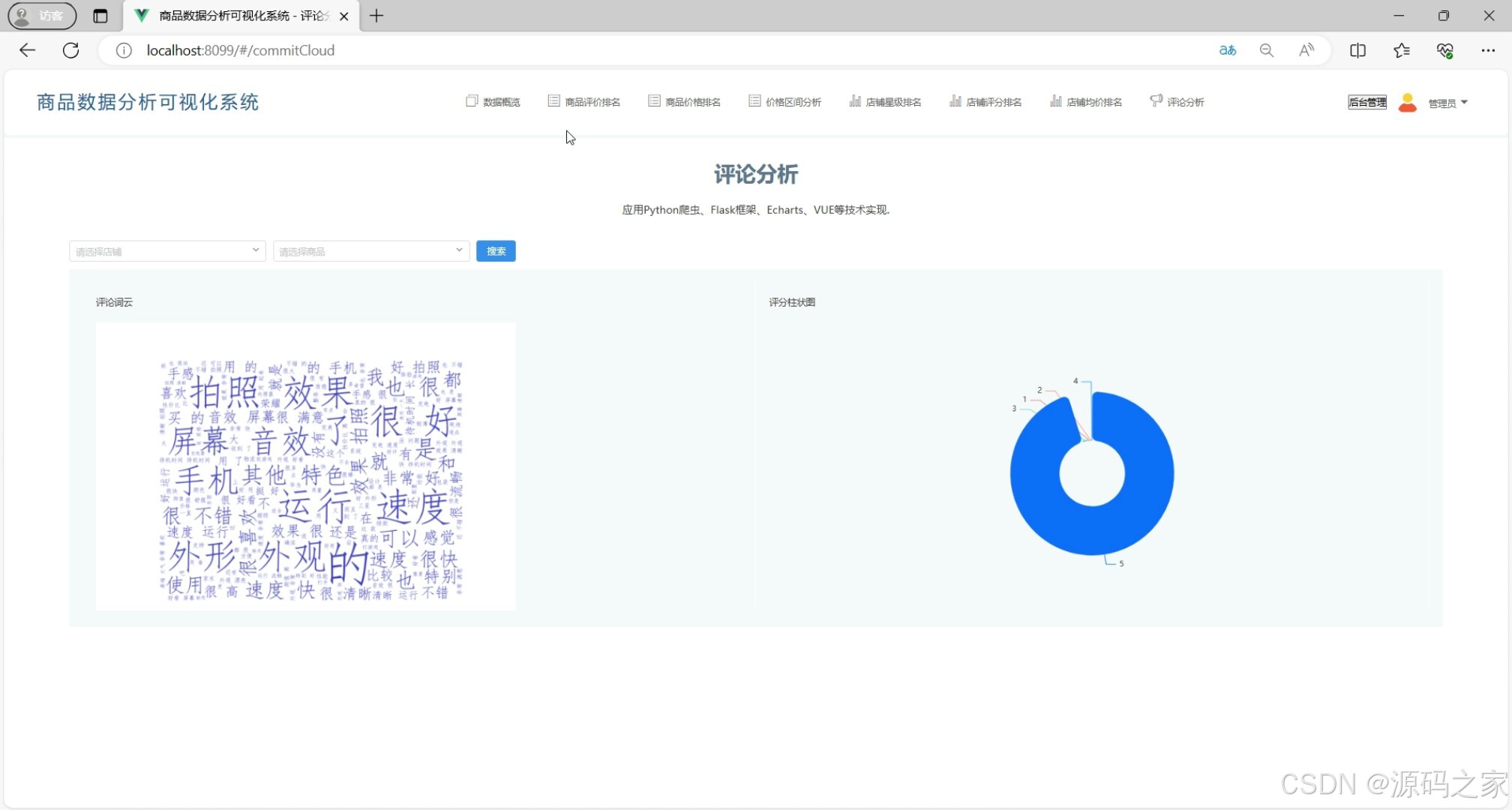

- 商品评论分析(评论词云与评分占比图表)

- 后台数据管理(数据维护与用户权限管控)

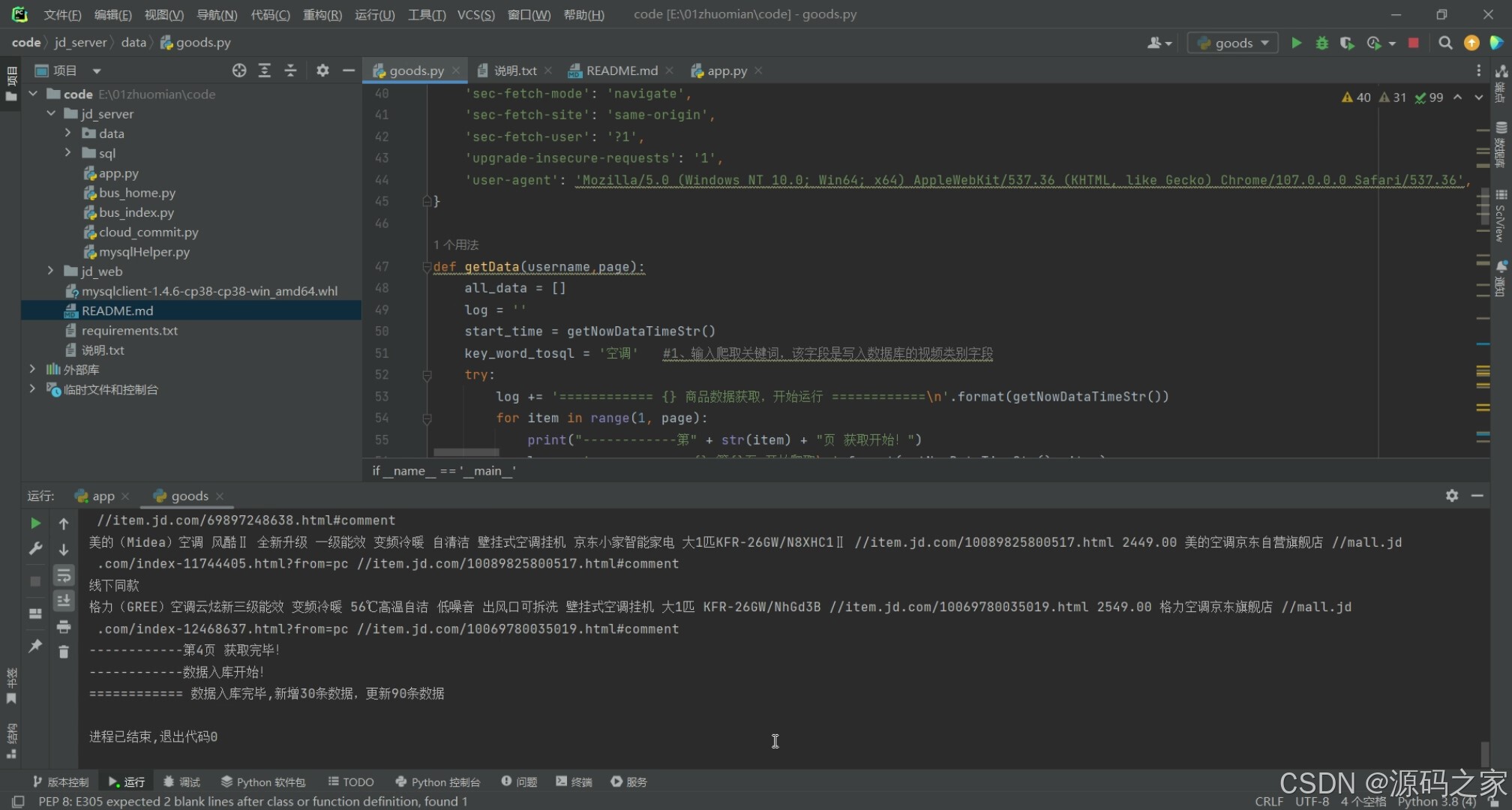

(8)数据采集

3、项目说明

在电子商务蓬勃发展的背景下,京东作为主流电商平台,其商品数据对商家竞品分析与消费者购物决策具有重要价值,但传统数据获取与处理方式存在效率低、展示不直观等问题。本项目基于Python开发京东商品销售数据分析可视化系统,通过技术整合实现数据全流程高效处理。系统采用前后端分离架构,后端以Flask框架为核心,负责业务逻辑处理,包括调用requests爬虫采集京东商品数据(商品名称、价格、评价、店铺星级等)、对采集数据进行清洗(剔除异常值、统一格式)后存入MySQL数据库,同时开发API接口为前端提供数据支持;前端借助Vue框架构建响应式界面,结合Echarts实现多维度数据可视化,涵盖商品价格排名、价格区间分析、店铺评分对比等模块,让数据趋势更易解读。核心功能上,系统支持商家通过模糊查询快速获取目标商品数据,管理员可触发爬虫获取商品评论与店铺信息,通过评论词云图提炼用户关注点、评分占比饼图展示商品口碑;同时配备完善的用户管理功能,普通用户可注册登录、修改个人信息,管理员则能管控用户账号状态、维护后台数据。此外,系统还支持按店铺查询商品排名、分析不同维度评论数据,为商家优化定价与运营策略提供依据,也为消费者对比商品提供客观参考。整体而言,该系统有效解决京东商品数据处理痛点,提升数据利用效率,兼具技术完整性与实际应用价值,可作为Web开发与数据采集方向的优质毕业设计,为电商数据化运营提供新路径。

4、核心代码

python

def getData(username,page):

all_data = []

log = ''

start_time = getNowDataTimeStr()

key_word_tosql = '空调' #1、输入爬取关键词,该字段是写入数据库的视频类别字段

try:

log += '============ {} 商品数据获取,开始运行 ============\n'.format(getNowDataTimeStr())

for item in range(1, page):

print("------------第" + str(item) + "页 获取开始!")

log += '============ {} 第{}页 开始爬取\n'.format(getNowDataTimeStr(), item)

url = 'https://search.jd.com/Search?keyword=空调&page={}' #2、 输入爬取关键词 例如:%E7%94%B5%E8%84%91

# url = 'https://search.jd.com/Search?keyword=%E6%89%8B%E6%9C%BA&page={}'

url = url.format(item)

print(url)

log += '============ {} url {}\n'.format(getNowDataTimeStr(), url)

# 页面数据获取

resp = requests.get(url, headers=headers)

response = resp.text

# print(response)

# 解析器 解析数据

soup = BeautifulSoup(response,'html.parser')

# print(soup)

for tony in soup.find_all('div',class_='ml-wrap'):

for sp in tony.find_all('div',class_='goods-list-v2 gl-type-1 J-goods-list'):

for li in sp.find_all('li', class_='gl-item'):

# 标题

title_div = li.find('div', class_='p-name p-name-type-2')

title = title_div.find('em').text

# 详情链接

hreff_a = title_div.find('a')

href = hreff_a['href']

# 价格

price_div = li.find('div',class_='p-price')

price = price_div.find('i').text

# 店铺名

shop_div = li.find('div', class_='p-shop')

shop_name_a = shop_div.find('a')

if shop_name_a == None :

shop_name = '------'

shop_href = '------'

else:

shop_name = shop_name_a.text

# 店铺地址

shop_href = shop_div.find('a')['href']

# 评价地址

commit_href = href + '#comment'

print(title,href,price,shop_name,shop_href,commit_href)

all_data.append({

"title": title,

"href": href,

"price": price,

"shop_name": shop_name,

"shop_href": shop_href,

"commit_href": commit_href

})

print("------------第" + str(item) + "页 获取完毕!")

log += '============ {} 第{}页 获取完毕\n'.format(getNowDataTimeStr(), item)

# TODO 延迟5秒,爬取数据多延时更长时间

time.sleep(2)

# 数据入库

print("------------数据入库开始!")

log += '============ {} 数据入库开始\n'.format(getNowDataTimeStr())

count_insert = 0

count_update = 0

mysql = get_a_conn()

for item in all_data:

sql_select = 'select * from tbl_goods where href = "%s"' % item.get('href')

result = mysql.fetchall(sql_select)

if (len(result) > 0):

sql_update = "update tbl_goods set title='%s',price='%s',shop_name='%s',shop_href='%s',commit_href='%s',create_time='%s' where href = '%s'" \

% (item.get('title'), item.get('price'), item.get('shop_name'), item.get('shop_href'), item.get('commit_href'), start_time, item.get('href'))

mysql.fetchall(sql_update)

count_update += 1

else:

insert_sql = 'insert into tbl_goods (title,href,price,shop_name,shop_href,commit_href,key_word,create_time) values ("%s","%s","%s","%s","%s","%s","%s","%s")' \

% (item.get('title'), item.get('href'), item.get('price'), item.get('shop_name'), item.get('shop_href'), item.get('commit_href'), key_word_tosql, start_time) # 倒数第2个参数,就是写入数据库的【key_word】 例如: '手机'

mysql.fetchall(insert_sql)

count_insert += 1

print("============ 数据入库完毕,新增{}条数据,更新{}条数据 ".format(count_insert, count_update))

log += '============ {} 数据入库完毕,新增{}条数据,更新{}条数据\n'.format(getNowDataTimeStr(), count_insert,

count_update)

log += '============ {} 评论获取,运行成功,结束 ============\n'.format(getNowDataTimeStr())

# 插入日志

saveLog(username, start_time, getNowDataTimeStr(), str(len(all_data)), url, '商品评论', log, '1')

return log

print("------------数据入库完毕!")

print('运行完毕')

except Exception as e:

print(e)

print(traceback.print_exc())

# 插入日志

saveLog(username, start_time, getNowDataTimeStr(), str(len(all_data)), url, '商品信息', log, '0')

log += '============ {} 评论获取,运行失败,结束 ============\n'.format(getNowDataTimeStr(), e)

return log

if __name__ == '__main__':

# TODO 参数代表爬取的页数

getData('管理员后台', 5) # 参数代表爬取的页数🍅✌**感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目编程以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!**🍅✌

5、源码获取方式

🍅**由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。**🍅

点赞、收藏、关注,不迷路,下方查看 👇🏻获取联系方式👇🏻