基本信息

ICCV 2025

博客贡献人

田心

作者

Hai Jiang, Binhao Guan, Zhen Liu, Xiaohong Liu, Jian Yu, Zheng Liu, Songchen Han, Shuaicheng Liu

摘要

学习型方法在低光照RAW图像增强领域已经取得了显著进展,但由于缺乏相应的数据集,其在极度黑暗场景(环境照度低至0.0001 lux)下的能力尚待探索。为此,我们提出了一种"配对到配对"的数据合成流程,可在三个精确的照度范围(0.01--0.1 lux、0.001--0.01 lux、0.0001--0.001 lux)生成校准良好的极低光照RAW图像,并配以高质量的sRGB参考图像,构建了一个大规模配对数据集"SIED"(See-in-the-Extremely-Dark),用于评测低光照RAW图像增强方法。此外,我们提出了一个基于扩散模型的增强框架,利用扩散模型的生成能力和内在去噪特性,从超低信噪比的RAW输入中恢复视觉上令人满意的结果。其中,我们引入自适应照明校正模块 (Adaptive Illumination Correction Module, AICM )和颜色一致性损失(color consistency loss),以确保准确的曝光校正和颜色还原。在所提出的SIED数据集和公开可用的基准数据集上进行的大量实验表明,我们的方法是有效的。

1 引言

从低光照观测中恢复出高质量、清晰的图像是一项具有挑战性的任务,因为它需要同时提升全局和局部对比度、抑制放大的噪声并保留细节。这对于夜间摄影和监控等现实应用至关重要。近年来,深度学习驱动的低光照图像增强(LLIE)取得了重大进展,推动了该领域的发展。总体而言,学习型方法按照输入格式可分为两类:基于sRGB的方法和基于RAW的方法。与研究广泛的sRGB增强方法相比,RAW增强方法因其能够利用更具信息量的低强度RAW信号和更好的噪声建模能力而受到越来越多关注。

目前为止,许多研究都集中于将低光照有噪RAW图像转换为正常光照下的干净sRGB图像,采用单阶段或多阶段训练策略。单阶段方法 试图用单一网络内同时完成"去噪"与"RAW→sRGB"两种映射。然而,这种跨两个不同域的混合映射会在增强过程中引入域歧义问题。此外,RAW到sRGB转换包含多个非线性过程,进一步加剧了困难,常导致颜色失真和细节模糊。为克服这些限制,多阶段方法通过在不同域引入中间监督来解耦任务,充分利用RAW和sRGB格式各自的特点,从而取得更好的效果。

另一方面,高质量的数据集 对于推动低光照RAW增强方法的发展是不可或缺的。现有数据集通常通过改变相机参数在黑暗环境下采集配对图像,其中正常光照参考图像通过延长曝光获得。但受限于环境光源的影响和采集时亮度波动,这些数据集仅能提供粗略的照度水平 (例如SID中室内0.2--5 lux,室外0.03--0.3 lux),而无法涵盖更黑暗场景。在真正极端黑暗的条件下(如照度低至0.0001 lux),通过延长曝光获得良好曝光的参考图像几乎不可能,因为这样会引入残留噪声和运动模糊。

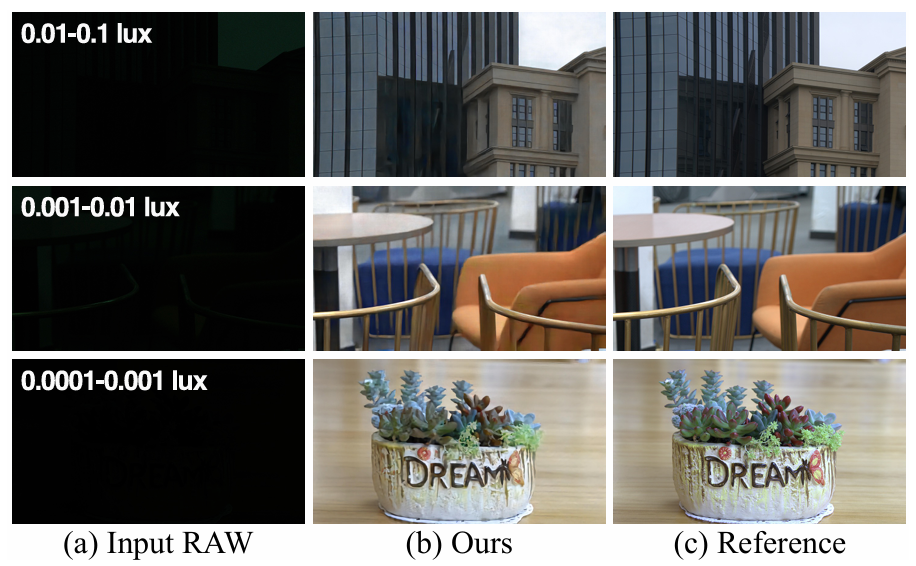

为此,我们提出了一种配对到配对的数据合成管线 ,专门用于准备极暗RAW增强的数据集,称为SIED (See-in-the-Extremely-Dark)。该数据集通过以下三方面生成三个精确校准的极低照度 RAW 图像及其清晰 sRGB 参考: (1) 在专业光学实验室中使用可控光源和精密照度计,获取照度范围精确为0.01--0.1 lux、0.001--0.01 lux和0.0001--0.001 lux的高质量低光照RAW图像;(2) 参考先前的数据采集策略,在各种真实场景中,通过调整相机参数采集配对的低光照RAW和正常光照下的清晰sRGB图像,其中正常光照图像作为高质量参考;(3) 将实际采集的低光照图像的照度映射到上述三个目标照度范围,以与实验室标准数据对齐,并针对每个照度范围添加校准的传感器噪声,从而模拟真实的极暗环境。通过实验室专业校准和上述配对合成策略,我们确保为极暗场景提供真实的低照度 RAW 输入及对应高质量 sRGB 参考(如图1所示,(a)为不同照度下的输入RAW,(c)为对应参考sRGB)。

Figure1:在图(a)中展示了我们合成的低光RAW图像在极低亮度下的三种水平:0.01-0.1勒克斯、0.001-0.01勒克斯以及0.0001-0.001勒克斯;图(b)展示了我们方法的恢复结果,图(c)为参考的高质量sRGB图像。输入的低光RAW图像是通过简单的解马赛克处理进行可视化的。

除数据集外,我们还提出了一种以多阶段策略训练的基于扩散模型的增强框架 ,利用扩散模型强大的生成能力和内在去噪特性来应对极低照度RAW图像增强。具体而言,我们首先将配对的低光照RAW图像和正常光照参考sRGB图像分别送入RAW编码器和sRGB编码器,映射到各自的潜空间表示。然后,编码后的 RAW 特征被送入设计的自适应照度校正模块(AICM)进行曝光校正,以纠正其照明不足。与以往利用参考图像曝光信息预放大输入的做法不同,AICM仅依赖低光照RAW自身来估计所需的增益系数,从而实现更好的恢复效果,并避免后续扩散过程中的曝光偏差。接着,编码后的参考sRGB特征作为扩散模型的输入,在AICM增强后的RAW特征引导下进行图像重建。此外,我们引入了颜色一致性损失,促使扩散模型生成的重建sRGB特征具有准确的颜色映射关系。如图1(b)所示,我们的方法在极暗环境下有效提升了全局和局部对比度,呈现出鲜艳的色彩,并避免了噪声放大,最终产生视觉上令人满意的图像。

总的来说,主要贡献如下:

- 提出了新颖的配对-配对数据合成流程,可生成三个不同照度级别的低光照RAW图像及其高质量sRGB参考图像,构成了用于极低光照RAW图像增强的大规模数据集SIED。

- 提出了一个基于扩散模型的增强框架,利用扩散模型的生成能力和内在去噪特性,从极低光照RAW输入恢复出视觉上令人满意的清晰图像。

- 在提出的 SIED 及公开数据集上的大量实验验证了我们方法的有效性。

2 相关工作

2.1 低光照RAW图像增强方法

RAW图像相较于sRGB图像包含更多信息,因此被广泛用于低光照条件下的图像增强研究。伴随着深度学习的发展,大量工作尝试用神经网络将低光照RAW域转换为正常光照下的清晰sRGB域。单阶段方法 通常直接端到端训练一个网络,从输入RAW生成高质量sRGB,往往通过精心设计的损失函数来优化。然而,单个网络同时学习去噪(RAW有噪到RAW干净)和颜色空间变换(RAW到sRGB)的复合映射 较为困难,导致细节重建和颜色映射往往不够准确。相比之下,多阶段方法将任务解耦以降低难度:例如,第一阶段在RAW域去噪/提升亮度,第二阶段在sRGB域调整颜色/提高质量。这种划分能够减少不同域之间的模糊,提高增强结果的保真度。

2.2 低光照RAW图像数据集

高质量的成对数据集对于学习型方法至关重要。SID 数据集 (CVPR 2018)是开创性的RAW低光照增强数据集,包含由Sony和Fuji相机拍摄的低/正常光照图像对。在SID中,室内场景环境照度约为0.2--5.0 lux,室外约为0.03--0.3 lux。SDSD 数据集 提供了动态场景下空间对齐的视频对(照度约0.8--2.0 lux)用于RAW视频增强;SMID 数据集包含静态视频(有真值)和动态视频(无真值),大部分场景照度在0.5--5.0 lux之间。由于环境复杂性和采集策略差异,上述数据集的低光照范围较粗略,而且缺少更暗场景的数据。针对这一空缺,本文设计了一种新的配对-配对的数据合成流程,生成精确照度低至0.0001 lux的低光照RAW图像及其参考,从而提供了更具挑战性的基准数据。

3 SIED数据集构建 (See-in-the-Extremely-Dark Dataset)

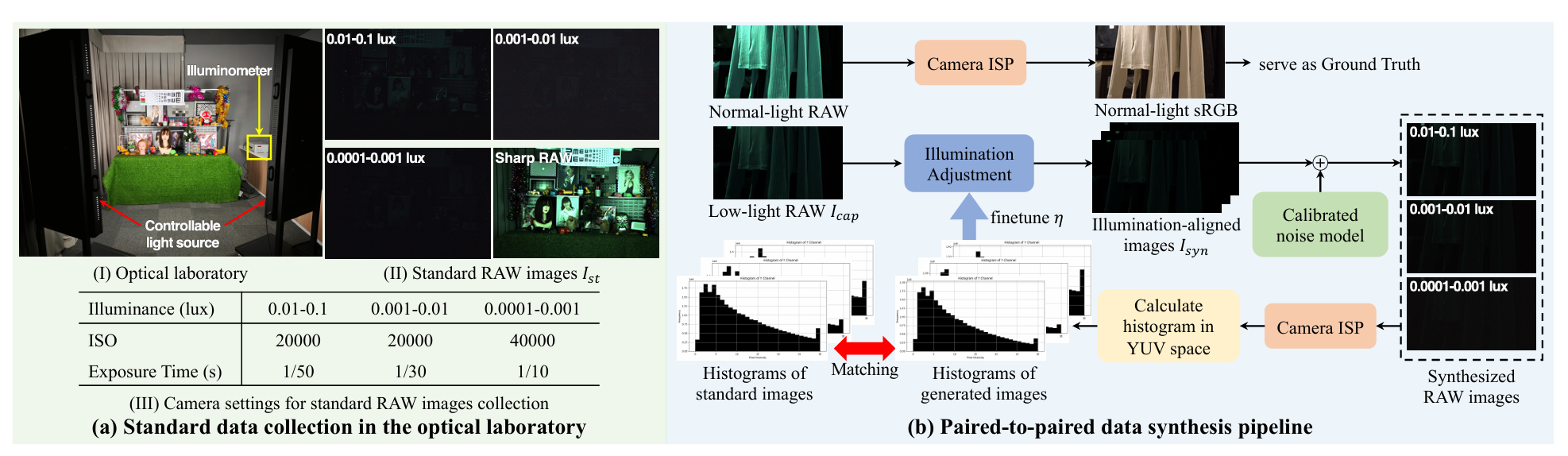

Figure2:(a) 展示了光学实验室、收集的标准 RAW 图像以及用于图像拍摄的相机设置。(b) 展示了我们提出的成对到成对数据合成策略。RAW 图像通过简单的去马赛克处理进行可视化。

为了生成具有精确定标照度范围的低光照RAW图像,我们首先在专业光学实验室中使用Sony α7R III和Canon EOS R相机采集低光照RAW图像,照度分别控制在0.01--0.1 lux、0.001--0.01 lux和0.0001--0.001 lux三个范围。实验室采用可控光源和专业测光计(如PHOTO-2000)确保照度精确,如图2(a)所示。接下来,我们并非简单地从明亮图像合成黑暗图像(以往方法多采取这种思路),而是提出了一种**"配对到配对"的合成策略**来生成更逼真的极暗图像,如图2(b)所示。该策略包括三个步骤:1)使用上述两台相机在多种场景下采集配对低照度 RAW 图像与清晰 sRGB 图像;2)手动调整低照度图像的亮度,以生成与实验室标准数据照度级别一致的特定照度图像;3)加入标定噪声模型,以满足真实暗环境特性。

**真实配对数据采集:**在各种真实静态场景下,用两台相机拍摄配对的低光照RAW和正常光照下的清晰sRGB图像。参考之前的方法,我们通过调整相机参数获取这对图像,其中参考图像的曝光时间比低光照图像长20到200倍(约1/10秒到1/200秒不等),以确保参考图像足够明亮且高质量。在每个场景中,我们根据需要调整光圈、ISO和焦距等设置来优化参考图像质量,并在拍摄低光照图像时固定这些设置。为保证内容一致性,我们使用三脚架固定相机,并通过远程控制同时拍摄长短曝光图像。为提高场景多样性,我们将原始全分辨率图像(Sony: 7952×5304,Canon: 6720×4480)裁剪为3840×2160的图像,用于后续合成,最终每个相机子集各得到1680对图像。

照度对齐(Illumination Alignment): 由于 RAW 图像中的照度信息与光子强度呈线性关系,我们利用实验室标准数据的曝光量对采集的低照度图像

进行适配,类似于先前方法的放大策略,以模拟真实照度退化,公式如下:

其中为与三个照度区间标准数据对齐的合成图像;

计算Bayer 通道均值以表征照度信息;

为手动定义的因子。

噪声添加(Noise Addition): 在真实的黑暗场景中,噪声是无法避免的退化因素。为生成更真实的低照度 RAW 图像,我们首先在光学实验室内对 Canon 与 Sony 相机的传感器噪声模型进行估计,拟合不同 ISO 下的高斯与泊松噪声分布。此外,之前的研究指出极低照度条件下的噪声模型不应被视为纯泊松+高斯(P+G)模型。因此,我们加入用于标高高斯噪声的暗帧( dark frame )数据库,以补充难以显式建模的噪声类型,从而更好地满足真实噪声分布特性,最终标定噪声模型由高斯、泊松与暗帧分布共同组成。最终,我们采用的 ISO 噪声添加策略,对于照度为0.01--0.1 lux和0.001--0.01 lux的合成图像,添加相当于ISO 100到20,000范围内的噪声;而对于最黑暗的0.0001--0.001 lux图像,ISO范围扩展到100到40,000,以注入更强噪声。

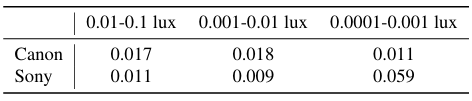

Table1:我们合成图像与实验室图像之间照度直方图分布的 KL 散度(↓)。

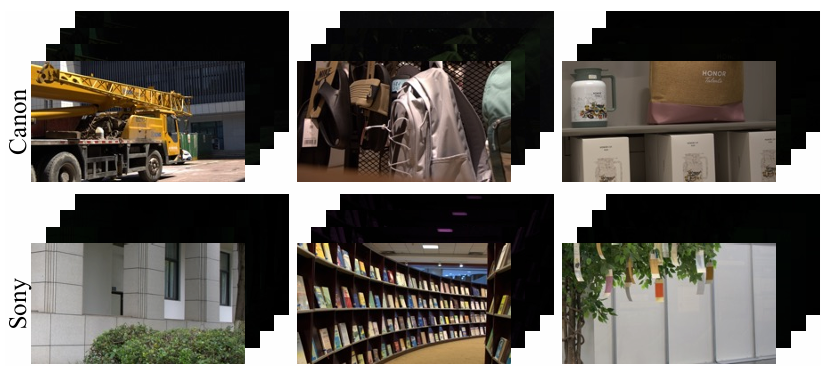

上述照度调整和噪声添加后,我们进一步通过一个固定的ISP管线将生成的RAW图像 和实验室标准参考图像 都转换到YUV颜色空间,并手动微调,使两图像在代表照度信息的 Y 通道直方图相匹配。如表 1 所示,我们生成图像与实验室标准图像在三个照度级别下的直方图分布平均 KL 散度均小于 0.06。总体而言,具有三个相对精确照度区间的合成低照度含噪 RAW 图像及对应的正常光照 sRGB 图像共同构成我们 See-in-the-Extremely-Dark (SIED) 数据集的每个样本,Sony 与 Canon 子集的每个照度级别均包含 1 680 对图像,其中 1 500 对用于训练,180 对用于评估。在图 4 展示了若干样本。

Figure4:来自我们SIED数据集中Canon和Sony子集的示例,前面显示参考sRGB图像,后面显示三种光照水平下的低光RAW图像。

4 方法论

4.1 概述

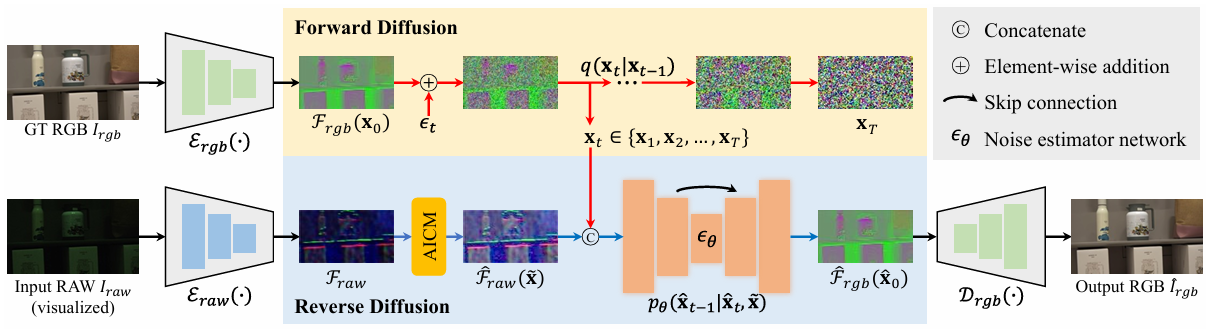

Figure3:我们提出的框架的整体流程。我们首先使用一个 RAW 编码器 和一个 sRGB 编码器

和一个 sRGB 编码器 将输入的带噪 RAW 图像 Iraw 和参考的 GT 图像

将输入的带噪 RAW 图像 Iraw 和参考的 GT 图像 转换到表示为

转换到表示为 和

和 的潜空间。然后,将编码后的 sRGB 特征作为扩散模型的输入以执行前向扩散过程,同时将编码后的 RAW 特征送入提出的自适应照明校正模块(AICM)以生成对比度增强特征

的潜空间。然后,将编码后的 sRGB 特征作为扩散模型的输入以执行前向扩散过程,同时将编码后的 RAW 特征送入提出的自适应照明校正模块(AICM)以生成对比度增强特征 ,旨在避免扩散过程中的曝光偏差。在反向扩散过程中,优化后的 RAW 特征

,旨在避免扩散过程中的曝光偏差。在反向扩散过程中,优化后的 RAW 特征 用作指导,从噪声张量

用作指导,从噪声张量  (推理过程中由随机采样的高斯噪声

(推理过程中由随机采样的高斯噪声 替代)生成重建的 sRGB 特征

替代)生成重建的 sRGB 特征 。最后,重建的 sRGB 特征被送入 sRGB 解码器

。最后,重建的 sRGB 特征被送入 sRGB 解码器 以生成最终修复结果

以生成最终修复结果 。

。

极低光照RAW图像增强需要解决多个关键问题:对比度增强 、噪声抑制 、细节重建 以及全局颜色映射 。为应对这些挑战,我们设计了一个基于扩散模型的框架 (如图3所示)。给定一对低光照RAW图像 及其对应参考正常光照sRGB图像

及其对应参考正常光照sRGB图像 ,我们首先分别通过RAW编码器

,我们首先分别通过RAW编码器  和sRGB编码器

和sRGB编码器  将输入映射到潜空间,分别记为

将输入映射到潜空间,分别记为 和

和 。接下来,我们设计自适应照明校正模块( AICM ) 对编码后的 RAW 特征进行对比度提升,得到

。接下来,我们设计自适应照明校正模块( AICM ) 对编码后的 RAW 特征进行对比度提升,得到 ,以避免后续扩散过程中的曝光偏差,并为重建提供更好的基础。然后,以参考图像的编码特征

,以避免后续扩散过程中的曝光偏差,并为重建提供更好的基础。然后,以参考图像的编码特征 为输入,结合放大后的RAW特征

为输入,结合放大后的RAW特征 ,引导扩散模型将

,引导扩散模型将 逐步还原/生成出增强后的sRGB特征

逐步还原/生成出增强后的sRGB特征 。最后,重建的sRGB特征通过

。最后,重建的sRGB特征通过 sRGB解码器 解码,得到最终的增强图像

sRGB解码器 解码,得到最终的增强图像 。

。

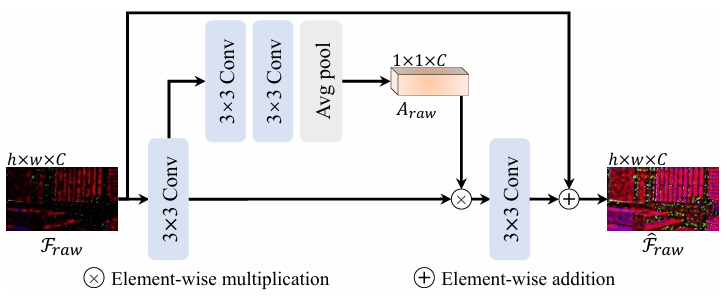

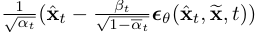

4.2 自适应照度校正模块(AICM)

以往研究表明,预先放大低照度图像有助于改进后续的恢复结果。然而,大多数方法依赖参考正常光照图像的曝光值作为放大先验,这在实际应用中通常不可得。此外,扩散模型虽展现出色生成能力,但会遭遇低频生成偏差,尤其在曝光方面。

Figure5:我们提出的 AICM 的详细架构。

为此,我们提出一个简单却有效的自适应照度校正模块(AICM),该模块仅从低照度 RAW 特征估计放大因子,在潜空间完成照度校正,旨在避免扩散过程中的曝光偏差并获得更佳恢复结果。如图 5 所示,AICM首先对输入特征 经过一个卷积层进行初步特征提取,然后通过级联卷积层和一个自适应平均池化层,预测出每个通道的增益系数

经过一个卷积层进行初步特征提取,然后通过级联卷积层和一个自适应平均池化层,预测出每个通道的增益系数  ,这些系数表示需要放大的强度。最后,通过一个带残差连接的卷积层将调整后的特征重建回原始维度,输出增强后的 RAW特征

,这些系数表示需要放大的强度。最后,通过一个带残差连接的卷积层将调整后的特征重建回原始维度,输出增强后的 RAW特征  。

。

为使AICM进行自适应而准确的曝光校正,并确保放大后的特征与原始输入在内容上保持一致,我们引入了一个基于Retinex理论(Retinex理论将图像分解为照明分量和反射分量(对应光照和固有物体反射特性))的照度校正损失 :

:

其中 为正常光照 RAW 图像的编码特征。L 与 R 分别表示照度图与反射图。

为正常光照 RAW 图像的编码特征。L 与 R 分别表示照度图与反射图。

4.3基于扩散模型的RAW到sRGB重建

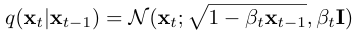

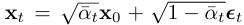

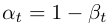

获得放大特征后的主要关切是将其转换为高质量 sRGB 特征。为此,我们提议利用扩散模型的生成能力与内在去噪能力,促进从含噪 RAW 数据到干净 sRGB 表征的重建。我们的方法遵循标准扩散模型,即先定义前向扩散 (forward diffusion)过程,将数据逐步添加噪声直至接近纯噪声;再学习反向扩散(reverse diffusion)过程,从噪声逐步去噪还原出目标分布的样本。

前向扩散: 编码后的 sRGB 特征 作为扩散模型的输入,记为

作为扩散模型的输入,记为 ,执行前向扩散过程;其中采用预定义方差调度

,执行前向扩散过程;其中采用预定义方差调度 ,在 T 步内逐步将

,在 T 步内逐步将 转化为高斯噪声

转化为高斯噪声 ,可表述为:

,可表述为:

其中 表示时间步

表示时间步的受损噪声数据。通过参数重新归一化,我们可以直接从输入

得到

得到 ,从而将公式简化为闭式表达式:

,从而将公式简化为闭式表达式: ,其中

,其中 ,

, ,

, 。

。

反向扩散: 在生成阶段,我们希望从随机噪声 开始 ,逐步去噪还原出清晰的sRGB特征

,逐步去噪还原出清晰的sRGB特征 。为了增强生成过程的可控性,我们引入条件扩散 机制,将AICM输出的增强RAW特征

。为了增强生成过程的可控性,我们引入条件扩散 机制,将AICM输出的增强RAW特征 作为条件,指导反向扩散过程朝期望的图像方向收敛。反向扩散过程可表述为:

作为条件,指导反向扩散过程朝期望的图像方向收敛。反向扩散过程可表述为:

其中 是方差,

是方差,

是均值。

是均值。

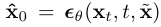

在训练阶段,我们不通过优化网络 的参数以促使估计的噪声向量接近高斯噪声,而是生成干净的 sRGB 特征

的参数以促使估计的噪声向量接近高斯噪声,而是生成干净的 sRGB 特征 ,即

,即

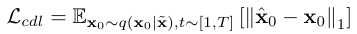

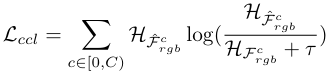

颜色一致性损失: 由于RAW图像的颜色信息以单通道不同位置的马赛克排列形式存在,RAW到sRGB的转换容易出现不稳定的颜色映射,即可能出现偏色或色彩失真。为此,我们进一步提出颜色一致性损失  ,通过优化生成 sRGB 特征的颜色直方图

,通过优化生成 sRGB 特征的颜色直方图 ,使其与编码后的参考 sRGB 特征直方图

,使其与编码后的参考 sRGB 特征直方图 对齐,以促使扩散模型生成颜色鲜艳的重建 sRGB 特征。我们采用 KL 散度量化分布差异,而非直接最小化

对齐,以促使扩散模型生成颜色鲜艳的重建 sRGB 特征。我们采用 KL 散度量化分布差异,而非直接最小化  与

与  之差,因为颜色直方图主要捕捉整幅图像中各种颜色的比例,而不考虑空间排布。因此,

之差,因为颜色直方图主要捕捉整幅图像中各种颜色的比例,而不考虑空间排布。因此, 表述为:

表述为:

其中 为避免分母为零的小常数。

为避免分母为零的小常数。

在推理阶段,我们遵循从学习到的分布通过反向扩散过程得到重建 sRGB 特征 ,随后将其送入 sRGB 解码器

,随后将其送入 sRGB 解码器 以生成最终 sRGB 图像

以生成最终 sRGB 图像 。

。

4.4网络训练

我们采用两阶段训练策略 来训练整个模型。在第一阶段 ,我们使用配对低照度 RAW 图像与参考正常光照 RAW/sRGB 图像,优化 RAW 编解码器( 与

与  )、sRGB 编解码器(

)、sRGB 编解码器( 与

与  )以及 AICM,同时冻结扩散模型参数。编解码器通过内容损失

)以及 AICM,同时冻结扩散模型参数。编解码器通过内容损失 优化:

优化:

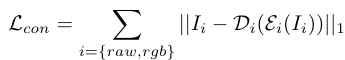

第一阶段的损失函数是 。在第二阶段损失函数是

。在第二阶段损失函数是 ,同时冻结其他模块的参数。

,同时冻结其他模块的参数。

5 实验

5.1 实验设置

**实现细节:**我们在单张 NVIDIA A100 GPU 上使用 PyTorch 实现所提方法,批大小与图像块大小分别设为 1 与 512×512。网络在两阶段训练后收敛,迭代次数分别为 2×10^5 与 4×10^5。我们采用 Adam 优化器,第一阶段初始学习率设为 1×10^{−4} 并按 0.8 衰减;第二阶段将其重新初始化为固定值 8×10^{−5}。超参数 λ 设为 0.1。扩散模型采用 U-Net 作为噪声估计网络,时间步与采样步分别设为 1000 与 20。

数据集与评价指标: 为评估所提方法性能,我们在自建的 SIED 数据集的 Canon 与 Sony 子集上进行实验,该数据集包含三种不同照度条件(0.01--0.1 lux、0.001--0.01 lux、0.0001--0.001 lux)下的低照度 RAW 图像。此外,我们还在 SID 数据集上进行实验,该数据集包含由 Sony 与 Fuji 相机采集的低照度 RAW 图像及对应的正常光照参考图像。评价指标采用两种失真指标 峰值信噪比 (PSNR)和结构相似度 (SSIM),以及感知相似度指标 (LPIPS)。

5.2 与现有方法的比较

**对比方法:**我们将所提方法与现有基于 RAW 的低照度增强方法对比,包括单阶段方法 SID、DID、SGN、LLPackNet、RRT,以及多阶段方法LDC、MCR、DNF与RAWMamba。对于我们的 SIED 数据集,我们在每个子集的训练集上重新训练所有对比方法以保证公平。对于 SID 数据集,我们重新训练所提方法,并采用对比方法已发布的预训练权重进行评估。

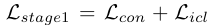

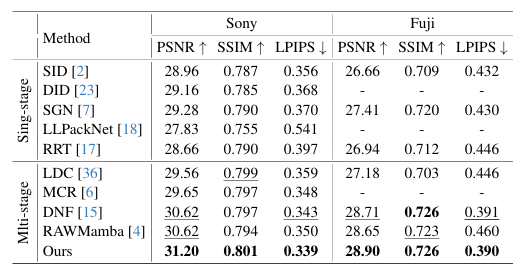

**定量比较:**我们首先在我们提出的 SIED 数据集的 Canon 与 Sony 子集上将所提方法与所有对比方法进行比较。如表 2 所示,多阶段方法整体优于单阶段方法,而我们的方法在各种照度条件下均取得失真指标与感知指标的最优性能。为进一步验证所提方法有效性,我们还在SID数据集的 Sony 与 Fuji 子集上进行对比。

Table2:在Canon和Sony子集上的定量比较,这些子集来自所提出的SIED数据集,低光RAW图像具有三个相对精确的光照范围。最佳结果以粗体显示,次佳结果以下划线显示。为了公平比较,我们使用各方法官方发布的代码在每个子集的训练集上重新训练所有比较方法。

如表 3 所示,我们的方法在所有指标上均优于之前的方法。值得注意的是,在 SID 数据集上,先前方法通常利用 GT 曝光对低照度 RAW 图像进行预放大,而我们的方法在提出的 AICM 内估计放大系数,进一步证明了所提方法的有效性。

Table3:对SID数据集的Sony和Fuji子集进行的定量比较。最佳结果用粗体显示,次佳结果用下划线标出。"-"表示由于预训练模型尚未发布,因此结果不可用。

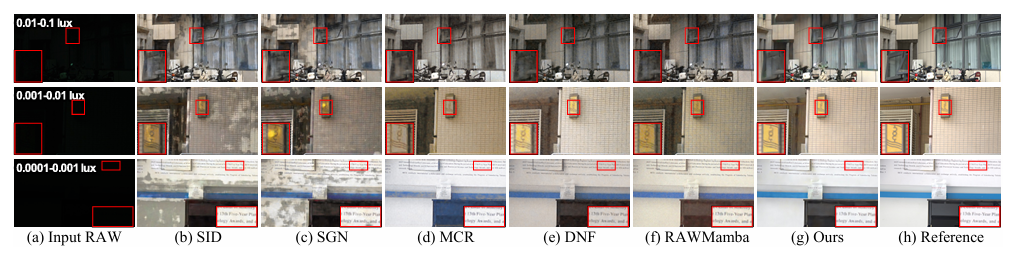

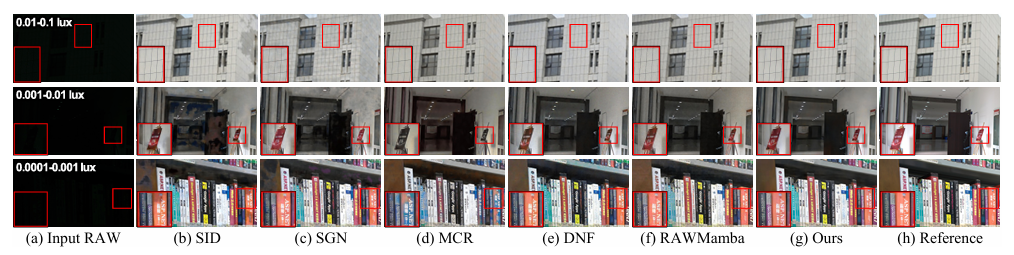

**定性比较:**我们在图 6 与图 7 给出所提方法与之前的方法在我们提出的 SIED 数据集的 Canon 与 Sony 子集上的视觉对比,其中第 1--3 行输入 RAW 图像的照度分别为 0.01--0.1 lux、0.001--0.01 lux、0.0001--0.001 lux。单阶段方法存在颜色失真与意外伪影,而多阶段竞品则出现细节模糊、颜色偏差或噪声放大。相比之下,我们的方法恰当提升对比度,重建更清晰细节,呈现鲜艳颜色并抑制噪声,获得视觉宜人的结果。

Figure6:对我们的方法与之前的方法在提议的SIED数据集的Canon子集上的定性比较。输入的RAW图像通过简单的去马赛克处理进行可视化。建议放大观看效果最佳。

Figure7:对我们的方法与竞争方法在所提SIED数据集的Sony子集上的定性比较。输入的RAW图像通过简单的去马赛克过程进行可视化。建议放大查看以获得最佳效果。

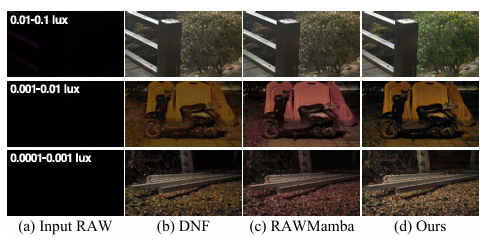

**真实场景泛化:**为验证所提方法的泛化能力,我们使用 Sony 相机在真实极暗场景采集若干图像,并根据其 Y 通道照度直方图与实验室标准图像的匹配确定照度级别。如图 8 所示,我们使用在所提 SIED 数据集 Sony 子集上训练的所提方法与两种基线方法对采集的真实图像进行恢复,所有方法均可将极低照度图像转换为正常光照图像,而我们的方法表现更佳,证明了所提方法的有效性,且我们合成的数据集能够支持方法泛化到真实场景。

Figure8:对我们的方法与竞争方法在所提SIED数据集的Sony子集上的定性比较。输入的RAW图像通过简单的去马赛克过程进行可视化。建议放大查看以获得最佳效果。

5.3 消融实验

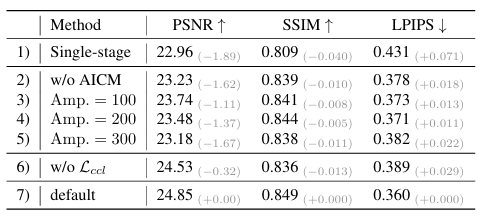

本节通过一系列消融实验验证不同组件选择的影响。在我们 SIED 数据集 Canon 子集 0.01--0.1 lux 照度下的定量结果如表 4 所示。

Table4:消融实验的定量结果,"w/o"表示不包含。

**训练策略:**为验证所提两阶段训练策略的有效性,我们进行同时优化编解码器、AICM 与扩散模型的实验。如表 4 第 1 行所示,该单阶段训练导致性能下降,因为早期训练阶段的编码特征不利于扩散模型学习期望的目标分布。

**模块有效性:**为验证所提 AICM 的有效性,我们进行将 AICM 从整体框架移除以及分别用固定放大因子 100、200、300 替换的实验。如表 4 第 2--5 行所示,凭借 AICM 实现的自适应曝光提升,我们的方法相比固定放大因子在 PSNR 上获得显著提升,因为真实场景的照度退化多样且未知。

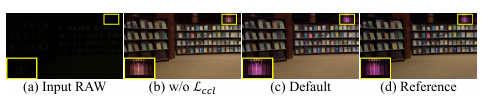

**损失函数:**为验证所提颜色一致性损失的有效性,我们进行将其从优化扩散模型的目标函数中移除的实验。如表 4 第 6--7 行所示,加入颜色一致性损失后在结构相似性与感知质量方面均带来性能优势。如图 9 所示,颜色一致性损失有助于实现准确的颜色映射。

Figure9:关于颜色一致性损失的消融研究的可视化结果。'w/o'表示没有。

6 结论

我们提出了一种配对到配对的数据合成流程,用于制备更具挑战性的数据集 SIED,以服务于极低照度 RAW 图像增强;该数据集包含三个精确校准的照度级别(最低至 0.0001 lux)的低照度 RAW 图像及对应的高质量参考 sRGB 图像。此外,我们提出了一种基于扩散模型的多阶段框架,利用扩散模型的生成能力与去噪特性,从极低照度输入中恢复出视觉宜人的结果。在技术层面,我们提出了一个自适应照度校正模块,在潜空间内执行照度预放大,旨在获得更佳结果并避免扩散过程中的曝光偏差。同时,我们提出了基于颜色直方图的颜色一致性损失,以促使扩散模型生成具有准确颜色映射的重建 sRGB 图像。实验结果证明了所提方法的优越性。

BibTeX

@inproceedings{sied,

author = {Jiang, Hai and Guan, Binhao and Liu, Zhen and Liu, Xiaohong and Yu, Jian and Liu, Zheng and Han, Songchen and Liu, Shuaicheng},

title = {Learning to See in the Extremely Dark},

booktitle = {Proceedings of the IEEE/CVF International Conference on Computer Vision},

year = {2025},

pages = {7676-7685}

}