在自动驾驶和智能交通系统的发展进程中,交通灯的准确检测与状态分类是保障车辆安全导航和实时交通管理的核心技术之一。现有方案大多聚焦于静态交通灯(红、黄、绿)的识别,却忽视了闪烁交通灯(闪红、闪黄)这一关键场景,而这类闪烁信号在警示、紧急场景中起着重要作用。同时,传统方法在复杂光照、遮挡、环境噪声等实际路况下的鲁棒性不足,且难以满足实时性要求。

代码链接:未公开

沐小含持续分享前沿算法论文,欢迎关注...

一、研究背景与意义

1.1 自动驾驶的核心技术瓶颈

自动驾驶车辆(AV)要实现安全可靠的城市道路导航,必须实时、准确地解读道路标志和交通灯信号。其中,交通灯识别不仅需要区分传统的红、黄、绿静态状态,还需处理闪红(表示强制停车观察)、闪黄(表示减速警示)等闪烁状态 ------ 这类信号常出现在交通流量较小的路口、故障路口或紧急车辆优先场景,对驾驶决策的安全性至关重要。

然而,闪烁交通灯的间歇性发光特性带来了独特挑战:

- 传统逐帧分类方法缺乏时间维度感知,难以区分闪烁信号与短暂视觉干扰(如光斑、阴影);

- 现有数据集和模型大多忽略闪烁状态,导致相关场景的泛化能力不足;

- 复杂环境下(如强光、雨雾、遮挡、相机角度变化),闪烁信号的检测精度进一步下降。

1.2 现实需求与研究缺口

从交通安全数据来看,美国约三分之一的路口致命事故发生在信号控制路口,而闪烁信号在减少事故率方面已被证实有效(如北卡罗来纳州和南卡罗来纳州的数据显示,闪烁信号灯可使角度碰撞事故减少 13.3%,致命事故减少 10.2%)。但另一方面,驾驶员对闪烁信号的理解存在显著不足 ------ 仅 52% 的受访者能正确解读闪烁黄箭头信号的含义,这凸显了自动驾驶系统精准识别闪烁信号的必要性。

此外,尽管车辆与基础设施(V2I)通信是未来自动驾驶的理想方案,但现有交通灯基础设施的升级改造成本高、周期长,过渡期内自动驾驶车辆仍需依赖视觉感知技术解读交通灯状态。即使在 V2I 普及后,视觉感知也可作为通信故障、网络攻击时的备用方案,保障系统鲁棒性。

因此,开发一种能够同时处理静态和闪烁交通灯、满足实时性要求且在复杂环境下表现稳定的检测与分类框架,具有重要的理论意义和工程价值。

二、相关工作综述

论文对交通灯检测与分类的相关研究进行了系统梳理,明确了现有方法的局限性,为 FlashLightNet 的设计提供了依据。

2.1 交通灯检测的传统方法

传统交通灯检测方法可分为基于模型 和基于学习两类:

- 基于模型的方法:依赖手工设计的规则,结合颜色、形状、亮度等特征。例如,通过颜色密度阈值分割红、黄、绿区域,利用霍夫变换定位圆形灯体,或通过 BLOB 分析提取候选区域。这类方法在受控环境下表现尚可,但对光照变化、阴影、传感器差异极为敏感,泛化能力差。

- 基于学习的方法:通过提取判别性特征(如 HOG、LBP、Gabor 滤波器)训练分类器(如 SVM、Adaboost)。早期采用级联 Haar 分类器,后期逐渐结合多特征融合(颜色 + 形状 + 上下文)提升精度,但仍需依赖人工设计特征,且对训练数据集的多样性要求较高。

2.2 深度学习 - based 交通灯检测与分类

近年来,深度学习模型(YOLO、Faster R-CNN、SSD 等)在检测精度和实时性上实现了突破:

- Ennahhal 等人使用 YOLOv3 在 Bosch 和 LISA 数据集上提升了识别速度和精度;

- YOLOv4 的扩展版本通过高斯边界框不确定性模型融合深浅层特征,优化小目标检测;

- 部分框架结合多相机和 GPS 数据,缩小感兴趣区域(ROI),提升检测效率。

但现有深度学习方法仍存在明显缺口:

- 大多仅支持静态交通灯分类,忽略闪烁状态;

- 逐帧处理缺乏时间上下文,无法建模闪烁信号的时序特征;

- 分类任务局限于红、黄、绿三分类,难以应对箭头灯、倒计时灯等复杂信号类型。

2.3 时序建模技术在交通领域的应用

闪烁交通灯的识别本质是时序序列分类问题,需通过时序建模捕捉 "亮 - 灭" 交替的模式。相关时序建模技术包括:

- LSTM:通过门控机制(输入门、遗忘门、输出门)缓解梯度消失问题,擅长捕捉长时依赖,已在交通流预测、驾驶行为分析等任务中验证有效性;

- TCN(时序卷积网络):基于膨胀卷积,训练速度快,但在稀疏事件序列(如闪烁灯)中的表现尚未充分验证;

- 贝叶斯网络 / 马尔可夫模型:基于概率建模时序转移,但假设固定时间间隔,在动态场景中计算成本高;

- 模糊逻辑:处理不确定性决策,但在复杂时序模式识别中精度有限。

综合对比后,论文选择 LSTM 作为时序分类模块,因其在处理不规则闪烁序列、捕捉长时依赖方面的优势,且 ResNet-LSTM 混合架构在跨领域(医疗、结构监测、环境感知)的泛化能力已得到验证。

2.4 现有研究与本文的核心差异

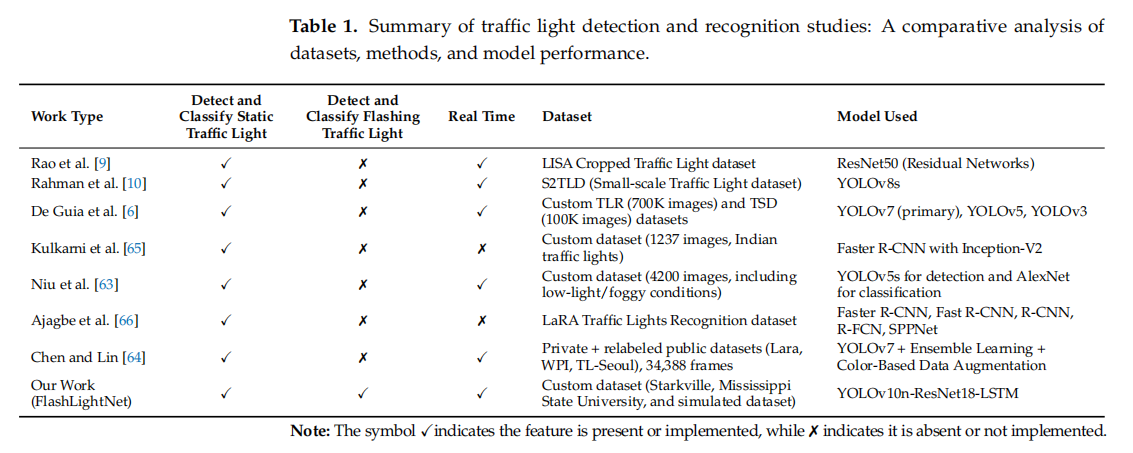

论文通过表格清晰对比了现有主流方法与 FlashLightNet 的差异,突出了本文的创新点:

可见,现有方法均未支持闪烁交通灯的识别,而 FlashLightNet 是首个在统一框架中同时处理静态和闪烁状态、且满足实时性要求的方案。

三、核心方法:FlashLightNet 框架设计

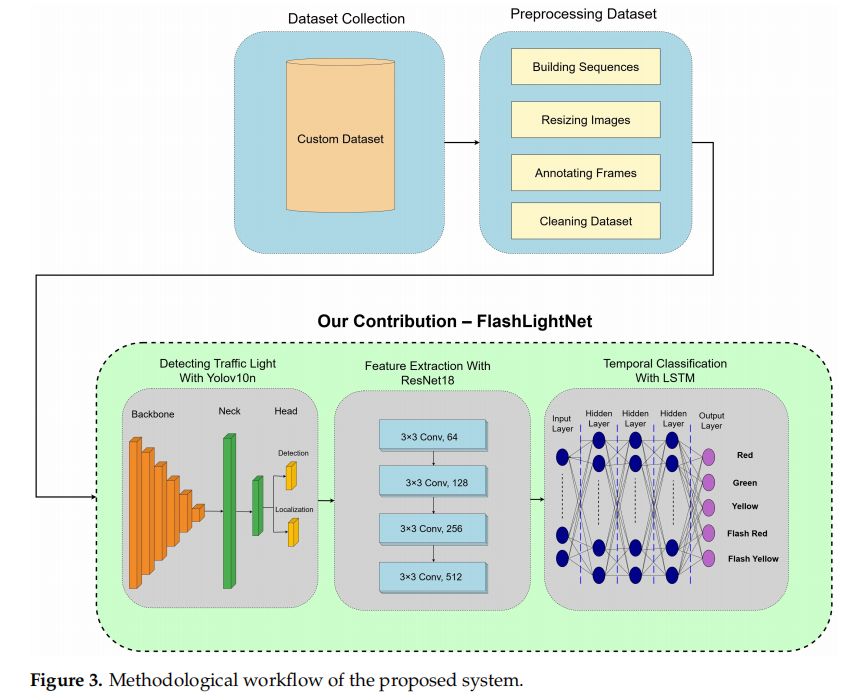

FlashLightNet 是一种端到端的深度学习框架,集成了目标检测、特征提取和时序分类三大模块,实现从交通灯检测到状态分类的一体化流程。其核心架构如图 3 所示:

3.1 框架整体流程

- 数据预处理:对真实和模拟视频数据进行帧提取、分类、标注、尺寸标准化和时序序列构建;

- 交通灯检测:使用 YOLOv10n 定位帧中的交通灯,输出精确边界框(ROI);

- 空间特征提取:通过 ResNet-18 对 ROI 区域进行特征提取,生成高维空间特征向量;

- 时序分类:将序列帧的特征向量输入 LSTM 网络,捕捉 "亮 - 灭" 时序模式,分类为红、绿、黄、闪红、闪黄五种状态。

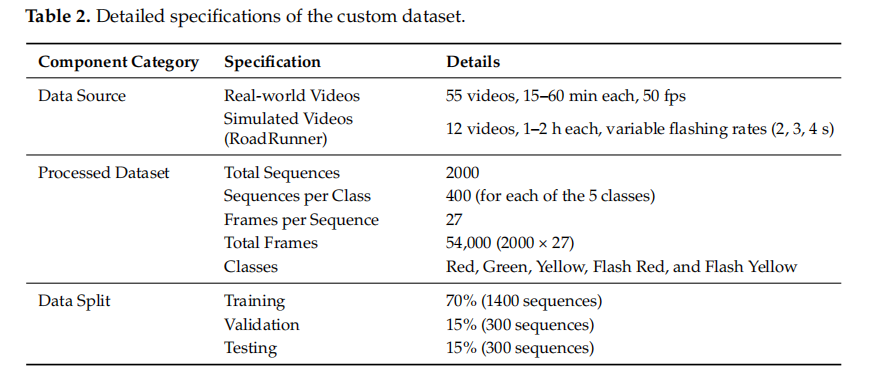

3.2 数据集构建(关键支撑)

为解决现有数据集缺乏闪烁交通灯样本的问题,论文构建了包含真实数据 和模拟数据的综合数据集,确保模型的泛化能力。

3.2.1 数据集构成

3.2.2 数据预处理关键步骤

- 帧标注:使用 Roboflow 自动标注 YOLOv10 格式的边界框(x_center、y_center、width、height),并手动校验标注准确性;

- 尺寸标准化:所有图像 resize 至 680×680 像素,平衡计算效率与数据完整性;

- 时序序列构建:静态灯序列由连续 "亮" 帧组成,闪烁灯序列由 "亮 - 灭" 交替帧组成(均标注为对应闪烁类别),确保 LSTM 能捕捉时序依赖。

3.3 三大核心模块详解

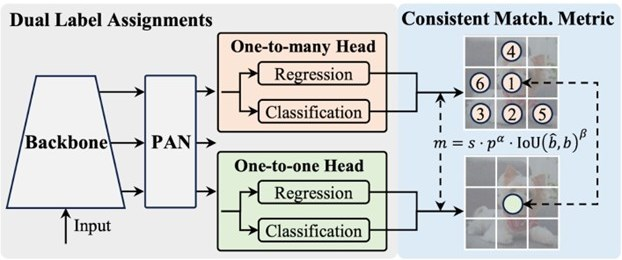

3.3.1 交通灯检测:YOLOv10n

YOLOv10 是单阶段目标检测算法,具有速度快、精度高的特点,其架构包含 Backbone(特征提取)、Neck(特征融合)、One-to-Many Head 和 One-to-One Head(检测输出)四大组件,如图 1 所示:

论文选择 YOLOv10 的 nano 版本(YOLOv10n),原因如下:

- 模型参数仅 230 万,计算量小,适合实时部署;

- 在检测精度与速度之间达到最优平衡(后续实验验证其 mAP 达 99.2%,训练时间仅 7.45 小时,远低于中大型版本)。

YOLOv10n 的核心优势是双标签分配策略,通过空间先验和分类 / 回归任务的权重平衡,提升边界框定位精度,确保交通灯 ROI 的准确提取。

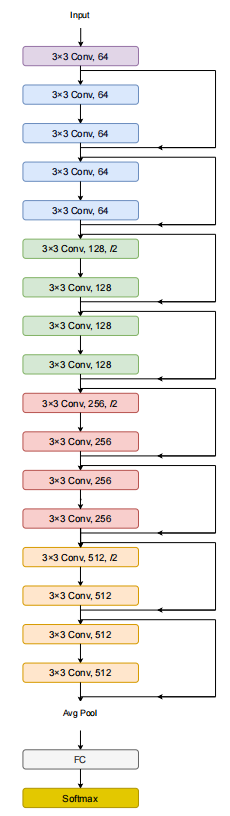

3.3.2 空间特征提取:ResNet-18

ResNet(残差网络)通过残差连接解决深层网络的梯度消失问题,ResNet-18 包含 18 层网络,分为 5 个阶段,架构如图 2 所示:

选择 ResNet-18 作为特征提取器的原因:

- 轻量化设计:参数数量适中,计算效率高,适合实时系统;

- 残差连接:有效提取深层空间特征,捕捉交通灯的颜色、形状等关键信息;

- 泛化能力强:在图像分类任务中经充分验证,适配交通灯特征提取场景。

具体流程:对 YOLOv10n 检测到的 ROI 进行裁剪,resize 至 224×224 像素,经 ImageNet 均值和标准差归一化后输入 ResNet-18,移除全连接层,输出高维特征向量。

3.3.3 时序分类:LSTM 网络

LSTM 网络擅长处理时序序列数据,通过门控机制记忆 "亮 - 灭" 交替的模式,区分闪烁与静态状态。论文设计的 LSTM 架构如下:

- 网络结构:3 层隐藏层,每层 128 个神经元;

- 输入:每个序列 27 帧的特征向量(ResNet-18 输出);

- 输出:5 类概率分布(红、绿、黄、闪红、闪黄)。

LSTM 的核心作用是建模时序依赖:例如,闪红序列的 "亮 - 灭" 交替帧经 LSTM 处理后,会被识别为统一的 "闪黄" 类别,而非逐帧分类为 "红" 和 "无",避免传统方法的误判。

3.4 模型训练与优化策略

- 优化器:选择 Adam 优化器,自适应调整学习率,收敛速度快;

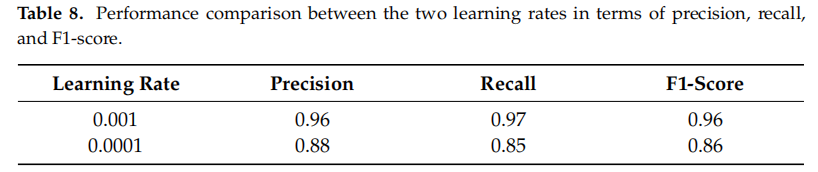

- 学习率:经调优确定为 0.001(过高导致震荡,过低收敛缓慢);

- 损失函数:交叉熵损失(适用于多分类任务);

- 早停策略:验证损失连续 5 个 epoch 无提升则停止训练,避免过拟合;

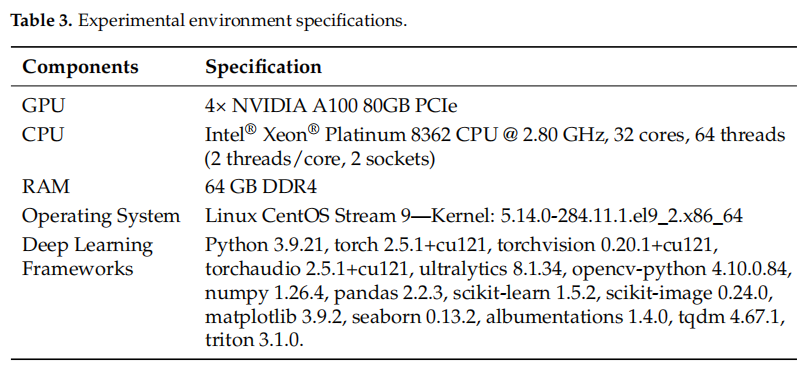

- 训练环境:4×NVIDIA A100 GPU,Intel Xeon Platinum 8362 CPU,64GB DDR4,确保大规模数据的训练效率。

四、实验设计与结果分析

论文通过多组对比实验验证了 FlashLightNet 的性能,包括模块选型、超参数调优、分类精度、实时性和鲁棒性测试。

4.1 实验环境配置

4.2 核心性能指标

- 检测指标:平均精度均值(mAP)------ 衡量交通灯检测的准确性;

- 分类指标:精确率(Precision)、召回率(Recall)、F1-score------ 衡量状态分类的综合性能;

- 实时性指标:帧率(fps)、单帧推理延迟、总决策延迟 ------ 验证实时部署可行性。

4.3 模块选型实验

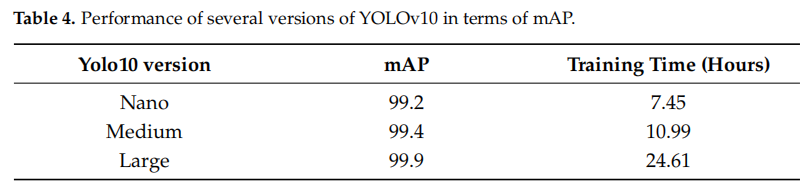

4.3.1 YOLOv10 版本对比

论文测试了 YOLOv10 的 nano、medium、large 三个版本,权衡检测精度与计算效率:

尽管 Large 版本精度最高,但训练时间是 Nano 版本的 3 倍多,且 mAP 提升仅 0.7%。考虑到实时部署需求,选择 YOLOv10n。

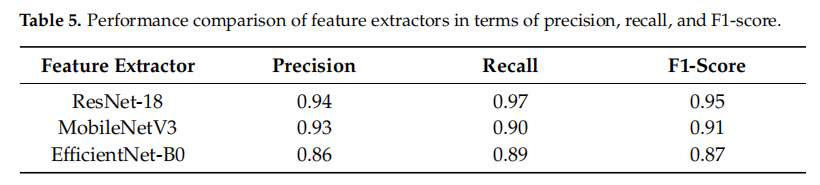

4.3.2 特征提取器对比

对比 ResNet-18、MobileNetV3、EfficientNetB0 的特征提取效果:

ResNet-18 在三项指标中均最优,且轻量化特性适配实时系统,因此确定为特征提取模块。

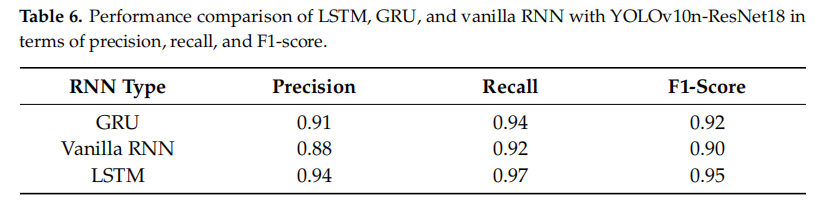

4.3.3 时序模型对比

对比 LSTM、GRU、Vanilla RNN 在时序分类中的表现:

LSTM 凭借门控机制有效捕捉长时依赖,性能最优;GRU 参数更少但精度略低;Vanilla RNN 因梯度消失问题表现最差。

4.4 超参数调优实验

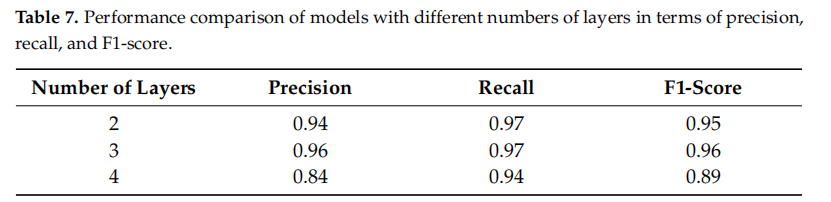

4.4.1 LSTM 层数调优

3 层 LSTM 达到精度饱和点,继续增加层数会导致过拟合和计算量上升,因此选择 3 层结构。

4.4.2 学习率调优

0.001 的学习率平衡了收敛速度和稳定性,是最优选择。

4.5 最终模型性能

4.5.1 分类性能(按类别)

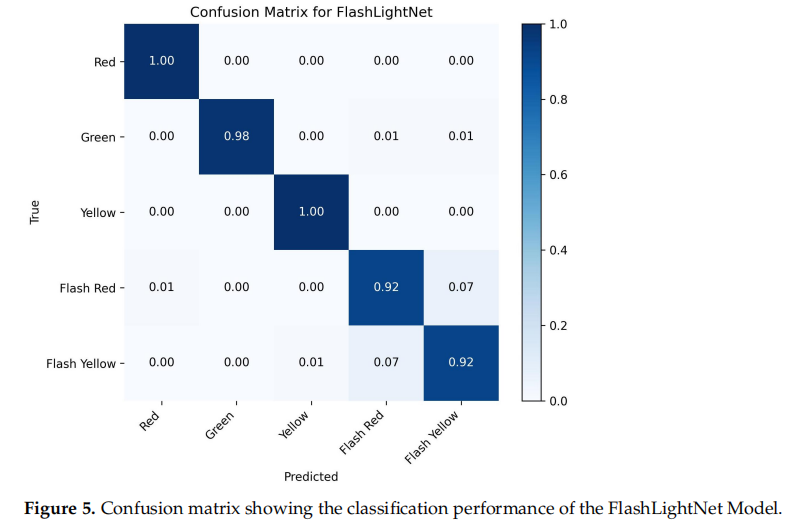

静态灯(红、黄)分类精度达到 100%,绿灯仅 1% 误判;闪烁灯分类精度均为 92%,主要误判源于 "闪红" 与 "闪黄" 的混淆(约 7%),原因是两者的 "亮 - 灭" 时序模式相似,且受环境噪声影响。

4.5.2 混淆矩阵分析

混淆矩阵进一步展示了模型的分类效果(图 5):

- 静态灯:红、黄 100% 正确分类,绿灯 98% 正确,2% 误判为闪烁状态;

- 闪烁灯:闪红 92% 正确,7% 误判为闪黄;闪黄 92% 正确,7% 误判为闪红;

- 无跨静态 - 闪烁类别的误判,说明 LSTM 的时序建模有效区分了静态和动态模式。

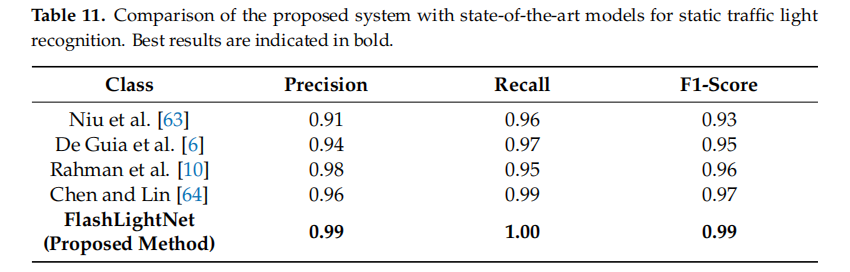

4.5.3 与现有方法的对比(静态灯分类)

FlashLightNet 在静态灯分类上超越所有现有方法,验证了其空间特征提取与时序建模结合的有效性。

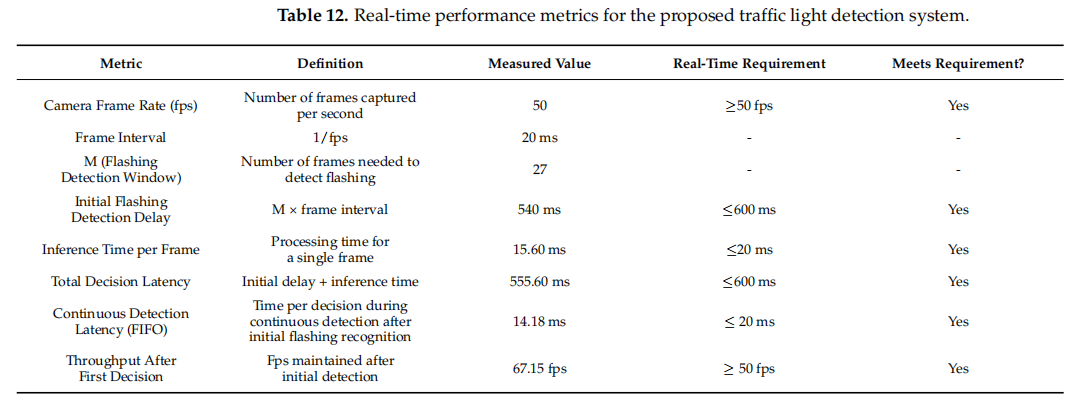

4.6 实时性验证

论文定义实时性标准:帧率≥50fps、单帧推理延迟≤20ms、总决策延迟≤600ms。实验结果如下:

FlashLightNet 完全满足实时性要求,可无缝集成到自动驾驶系统中。

4.7 鲁棒性测试(遮挡场景)

针对真实路况中的短暂遮挡(如被大型车辆遮挡),FlashLightNet 表现出较强的鲁棒性:

- 单帧遮挡时,LSTM 利用序列上下文(遮挡前的状态)维持正确分类;

- 遮挡解除后,模型迅速确认状态,避免误判;

- 局限性:长时间完全遮挡时,因缺乏视觉输入,性能会下降(后续研究将结合 V2I 和地图数据优化)。

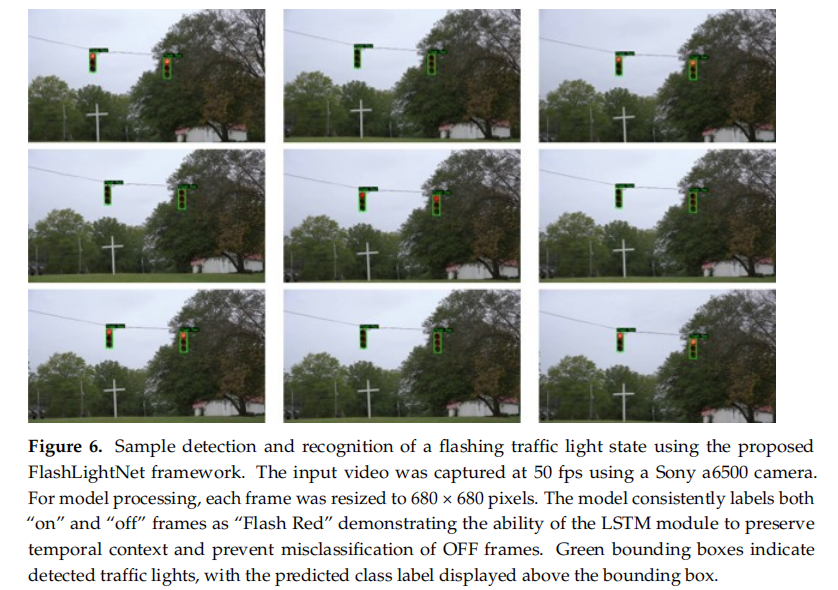

4.8 可视化结果

闪烁灯检测示例(图 6)

模型成功识别 "亮 - 灭" 交替的闪红序列,所有帧均标注为 "Flash Red",未出现逐帧误判。

静态灯检测示例(图 7)

模型准确检测静态灯并分类,边界框定位精准,标签无错误。

五、结论与未来展望

5.1 研究贡献

- 首个统一框架:FlashLightNet 是首个在端到端框架中同时支持静态和闪烁交通灯检测与分类的方案,填补了现有研究空白;

- 综合数据集:构建了包含真实和模拟数据的时序数据集,涵盖 5 类交通灯状态和不同闪烁频率,为相关研究提供基准;

- 卓越性能:检测 mAP 达 99.2%,分类 F1-score 达 96%,且满足实时性要求,超越现有方法;

- 工程价值:轻量化设计适配自动驾驶系统,鲁棒性强,可应对复杂路况。

5.2 未来研究方向

- 扩展信号类型:支持箭头灯、倒计时灯、行人信号灯等更多交通灯类型;

- 融合多源数据:结合 GPS 地图、LiDAR、雷达和 V2I 通信,解决长时间遮挡问题;

- 优化模型效率:进一步轻量化模型,适配边缘设备(如车载嵌入式系统);

- 复杂环境适配:增强雨雾、强光、极端天气下的鲁棒性。

六、总结

FlashLightNet 通过 YOLOv10n、ResNet-18 和 LSTM 的有机结合,构建了一套高效、精准、实时的交通灯检测与分类框架,成功解决了闪烁交通灯识别这一核心技术难题。其创新点在于:

- 时序序列建模:通过 LSTM 捕捉闪烁信号的 "亮 - 灭" 模式,突破传统逐帧分类的局限;

- 模块优化选型:在精度与效率之间达到最优平衡,满足自动驾驶的实时性要求;

- 综合数据集:真实 + 模拟数据确保模型泛化能力,为领域研究提供支撑。

该框架不仅推动了交通灯识别技术的发展,也为自动驾驶系统的安全部署提供了关键技术保障,具有重要的理论意义和工程应用价值。未来通过多源数据融合和模型优化,有望进一步提升其在极端场景下的鲁棒性,助力智能交通系统的升级。