摘要:在 End-to-End 大模型盛行的今天,为什么我们依然离不开传统的点云预处理?本文从底层物理特性出发,深度拆解激光雷达的运动畸变(Motion Distortion)与鬼影(Ghosting)难题,并分享基于 SIMD 指令集的工程化落地代码。

关键词:自动驾驶 / LiDAR / 点云处理 / 运动补偿 / SIMD / C++ / Python

前言:算法的尽头是物理

2025 年,自动驾驶圈最火的词是"端到端(End-to-End)"。仿佛只要模型够大,数据扔进去,车就能自己开。

但作为一名在一线摸爬滚打的架构师,我要泼一盆冷水:Garbage In, Garbage Out(垃圾进,垃圾出)。

激光雷达(LiDAR)并不是完美的上帝之眼。受限于光速、机械扫描结构和物理反射定律,它吐出来的原始数据充满了"谎言":

-

车在跑,墙变歪了(运动畸变);

-

路过玻璃墙,地下冒出了一辆车(鬼影噪声);

-

每秒 150 万个点,CPU 算不过来(算力瓶颈)。

今天我们不谈大模型,专门聊聊这些自动驾驶感知栈里的"脏活",以及如何用硬核工程手段把它们清洗干净。

一、 硬件的谎言:为什么点云会"歪"?

1. 卷帘快门效应

目前主流的机械或半固态雷达(如 Hesai AT128 或 ATX),本质上是"慢速扫描"设备。

-

现象:雷达转一圈(或扫描一帧)大约需要 100ms(10Hz)。

-

问题 :在高速公路场景下(120km/h),车在 0.1 秒内已经窜出去了 3.3 米。

-

后果 :雷达刚开始扫到的"车头"和最后扫到的"车尾",实际上是在两个不同位置采集的。把它们拼在同一帧里,世界就扭曲了。

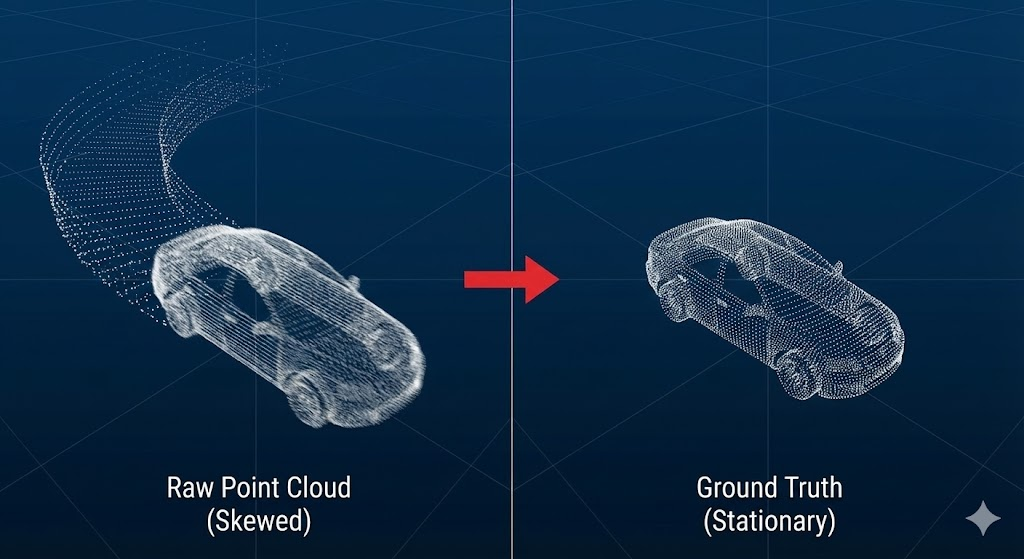

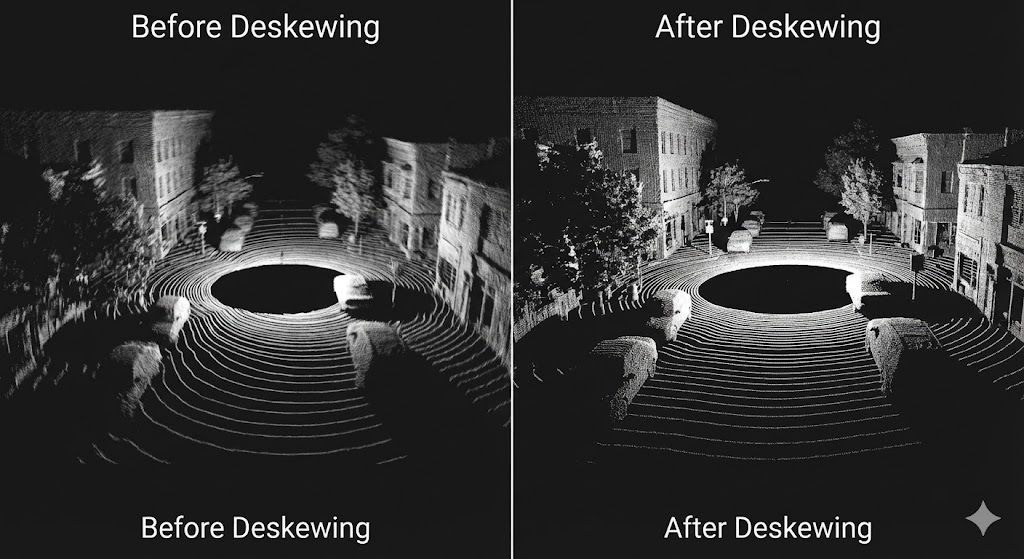

这张图直观地展示了代码所需解决的问题。当激光雷达在移动中扫描时,不同时刻采集的点不再位于同一个坐标系下,导致生成的点云出现拉伸和扭曲,就像左图中的汽车一样。右图展示了我们期望得到的、静止状态下的真实几何形状。

这张图直观地展示了代码所需解决的问题。当激光雷达在移动中扫描时,不同时刻采集的点不再位于同一个坐标系下,导致生成的点云出现拉伸和扭曲,就像左图中的汽车一样。右图展示了我们期望得到的、静止状态下的真实几何形状。

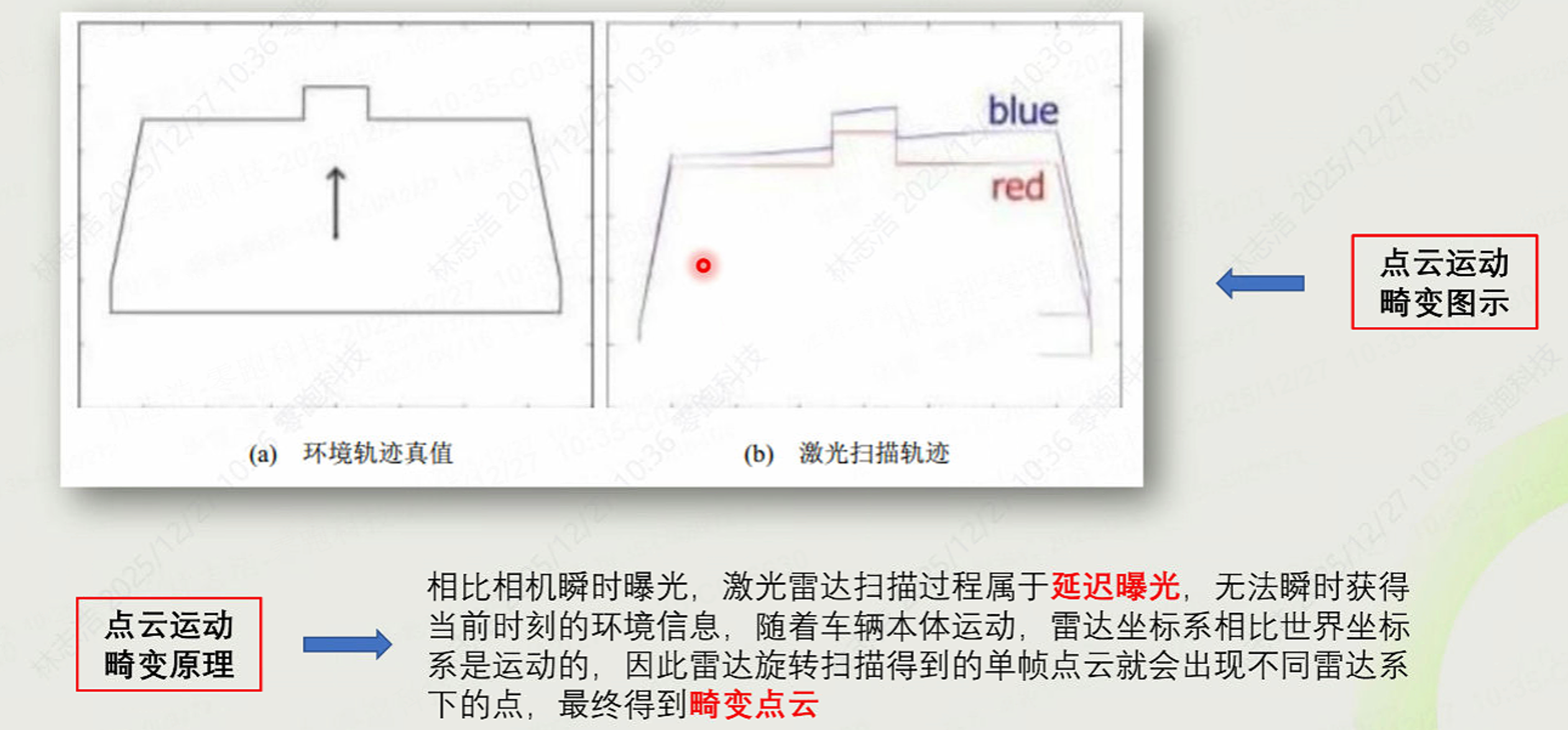

点云运动畸变图示

点云运动畸变图示

2. 解决方案:运动补偿

这一步是所有 SLAM 和感知算法的前置条件。核心思想是"追溯时间"。

我们需要结合高频 IMU(200Hz+)的数据,把每一个激光点,根据它精确的采样时间戳,强行"拉回"到这一帧的起始时刻。

核心数学公式

核心数学公式

Python 核心实现(向量化加速版)

拒绝慢吞吞的 for 循环,我们利用 scipy 的 SLERP 插值:

python

import numpy as np

from scipy.spatial.transform import Slerp, Rotation

def deskew_point_cloud(points, point_times, imu_poses, imu_times, frame_start_time):

"""

点云运动畸变补偿 - 向量化实现

Args:

points: (N, 3) 原始点云

point_times: (N,) 每个点相对帧头的偏移时间

frame_start_time: 本帧对齐的目标时间戳

"""

# 1. 对齐绝对时间

abs_point_times = frame_start_time + point_times

# 2. 构建球面线性插值器 (SLERP) - 处理旋转

# IMU 频率通常远高于雷达,需插值获取每个点时刻的位姿

rot_interpolator = Slerp(imu_times, Rotation.from_quat(imu_poses[:, 3:]))

# 3. 批量计算插值后的旋转矩阵 (N, 3, 3)

interp_rots = rot_interpolator(abs_point_times).as_matrix()

# 4. 位置线性插值 (N, 3)

interp_trans = np.stack([

np.interp(abs_point_times, imu_times, imu_poses[:, :3][:, i])

for i in range(3)

], axis=1)

# 5. 坐标变换:将点转换到统一坐标系

# P_new = R * P_old + T

# 使用 einsum 进行批量矩阵乘法,比 for 循环快 100 倍

points_corrected = np.einsum('nij,nj->ni', interp_rots, points) + interp_trans

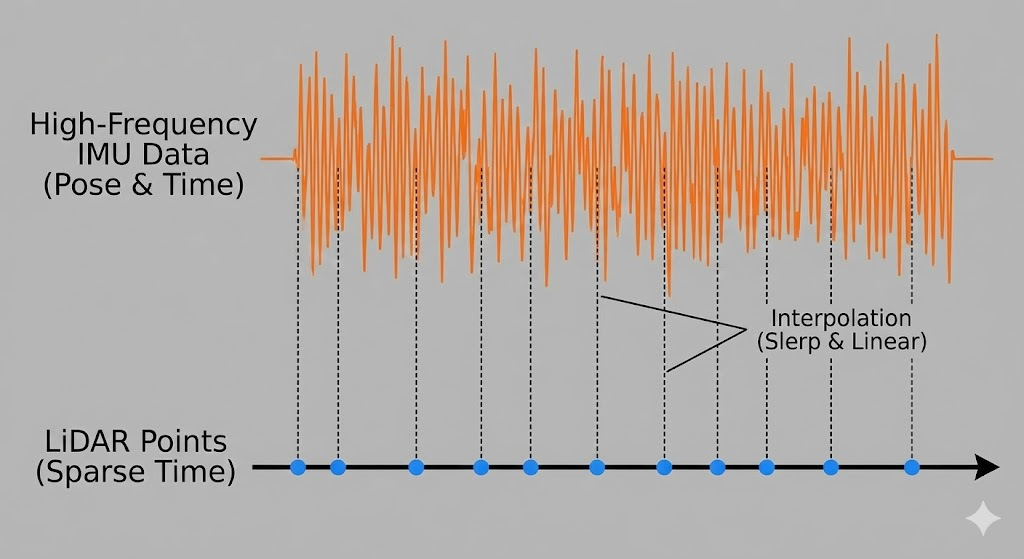

return points_corrected 这张图解释了代码中关键的插值步骤。上方的橙色波形代表高频的 IMU 数据,下方的蓝色点代表低频的激光雷达点。垂直虚线展示了如何利用每个激光点的时间戳,在 IMU 数据曲线上"穿针引线",插值出该时刻精确的位姿(旋转和平移),这对应了代码中的 Slerp 和线性插值。

这张图解释了代码中关键的插值步骤。上方的橙色波形代表高频的 IMU 数据,下方的蓝色点代表低频的激光雷达点。垂直虚线展示了如何利用每个激光点的时间戳,在 IMU 数据曲线上"穿针引线",插值出该时刻精确的位姿(旋转和平移),这对应了代码中的 Slerp 和线性插值。

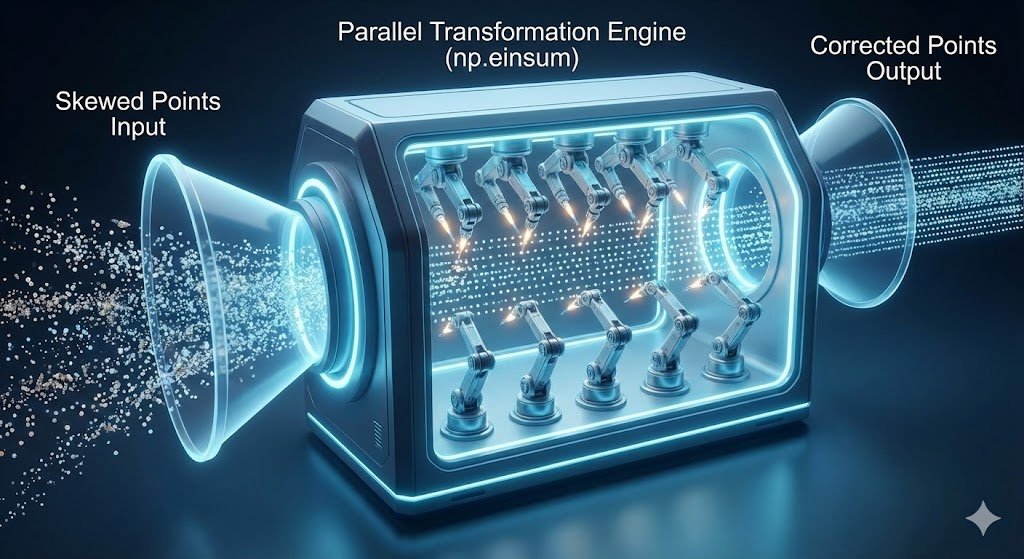

为了形象地解释代码中高效的 np.einsum 操作,这张图使用了一个"并行变换引擎"的隐喻。杂乱的原始点云进入引擎,内部无数的机械臂(代表插值得到的旋转矩阵)同时工作,瞬间将所有点修正到统一的坐标系下,并输出整齐的矫正点云。这生动地展现了向量化计算的威力。

为了形象地解释代码中高效的 np.einsum 操作,这张图使用了一个"并行变换引擎"的隐喻。杂乱的原始点云进入引擎,内部无数的机械臂(代表插值得到的旋转矩阵)同时工作,瞬间将所有点修正到统一的坐标系下,并输出整齐的矫正点云。这生动地展现了向量化计算的威力。

最后的这张图通过一个真实的街道场景,直观地对比了去畸变前后的效果。左侧的点云模糊、扭曲,物体边缘呈波浪状;而右侧经过处理的点云则锐利、清晰,准确还原了建筑物、树木和车辆的几何形态。这有力地证明了代码的实际价值。

最后的这张图通过一个真实的街道场景,直观地对比了去畸变前后的效果。左侧的点云模糊、扭曲,物体边缘呈波浪状;而右侧经过处理的点云则锐利、清晰,准确还原了建筑物、树木和车辆的几何形态。这有力地证明了代码的实际价值。

二、 物理的陷阱:又是"鬼影"?

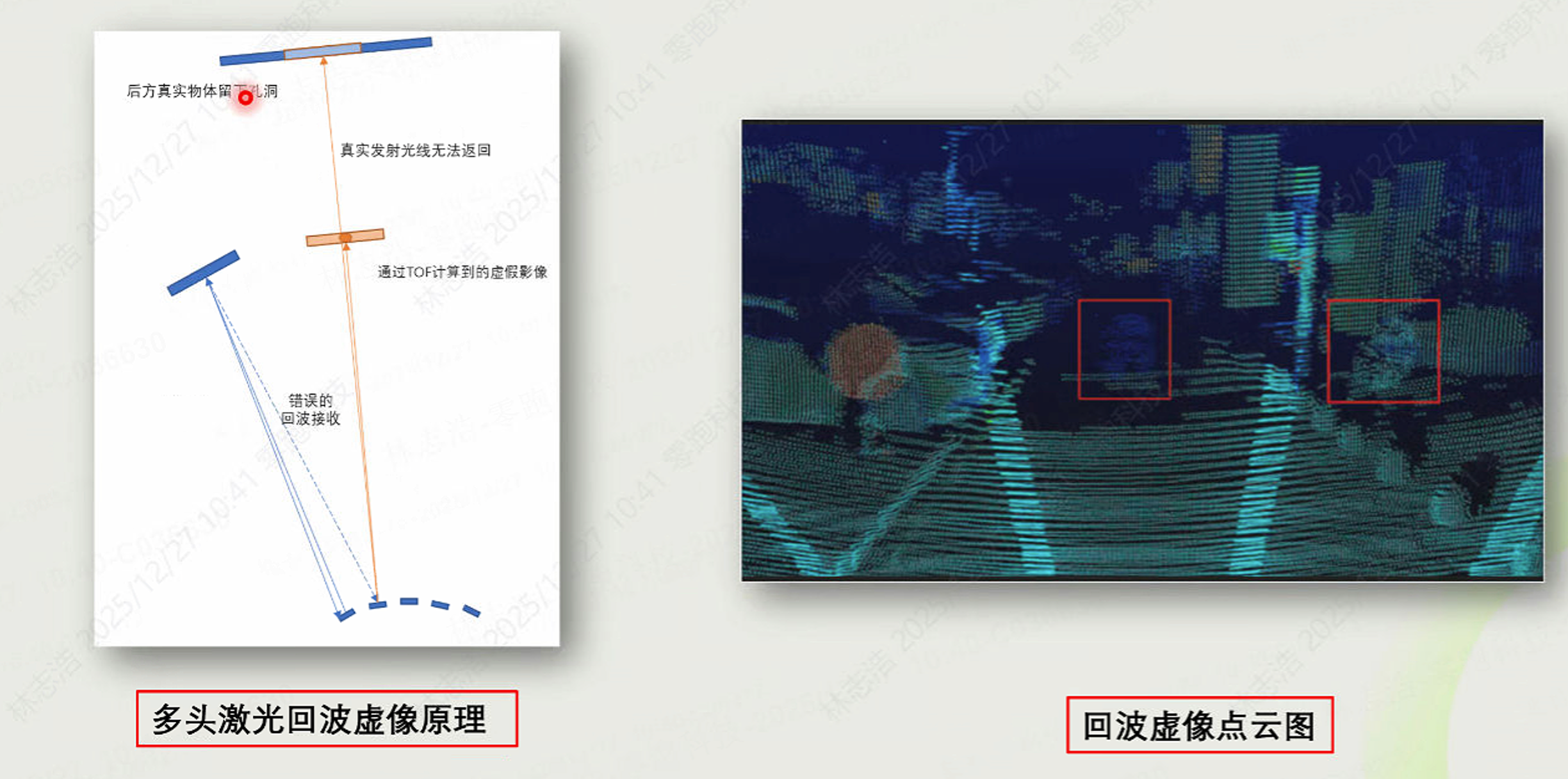

1. 多路径反射

自动驾驶界有一个经典 Corner Case:"对着玻璃幕墙急刹车" 。

这是因为雷达发出的光打在强反射平面(玻璃、大巴车身、路牌)上发生了镜面反射,接收到的回波实际上绕了远路。

多头激光回波虚像原理

多头激光回波虚像原理

雷达不知道光跑了弯路,它只根据飞行时间(ToF)计算距离。结果就是:玻璃墙后面(或地下)出现了一簇虚假的障碍物点云。如果感知算法把这个"鬼影"当成真车,AEB(自动紧急制动)就会误触发。

2. 工程化过滤策略

PPT 中展示了复杂的几何遮挡计算,但在实际高并发系统中,我们通常采用漏斗式过滤:

-

强度初筛(Intensity Check):鬼影往往伴随着极高的反射强度(镜面反射)。先过滤掉 Intensity > Threshold 且距离异常远的点。

-

几何一致性(Geometric Consistency):

-

将 3D 点云投影为 Range Image(深度图)。

-

检查深度跳变:如果相邻像素深度从 5m 突变到 50m,且近处是高反物体,那么远处的点极大概率是鬼影。

-

-

时序跟踪(Tracking):真车是连续运动的,鬼影通常闪烁不定。利用卡尔曼滤波跟踪,如果一个 Cluster 只存活 1-2 帧,直接丢弃。

三、 算力的救星:SIMD 指令集

处理 150 万个点/秒,普通的 CPU 写法是扛不住的。这就需要引入 SIMD (Single Instruction, Multiple Data)。

通俗理解:厨房切土豆

-

普通模式 (Scalar) :你拿着一把刀,切一刀,出一片土豆。切 100 万片手都断了。

-

SIMD 模式 :你换了一个工业切片机,按一下,同时切出 8 片土豆。

工程落地

在自动驾驶的车载芯片上,必须针对硬件架构优化:

-

Apple Silicon (M1/M2/M3) :使用 NEON 指令集。

-

Intel/AMD (x86) :使用 AVX2 / AVX-512 指令集。

C++ 性能优化建议

在做点云预处理(旋转、平移)时,尽量使用 Eigen 库并开启编译器优化,它会自动调用底层的 SIMD 指令。

cpp

// CMakeLists.txt 关键配置

// 开启本地架构最大优化,自动启用 AVX/NEON

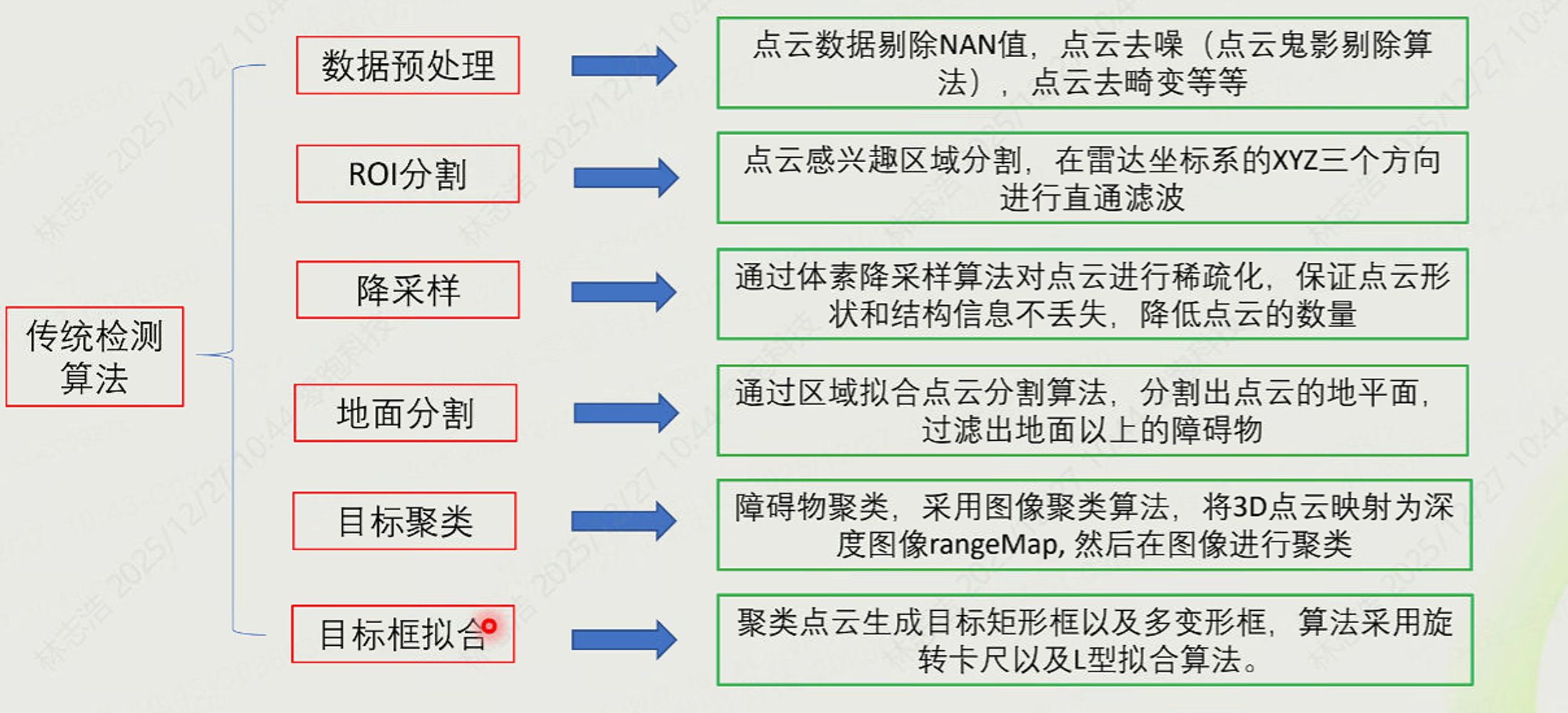

set(CMAKE_CXX_FLAGS "${CMAKE_CXX_FLAGS} -O3 -march=native")四、 最后的防线:传统感知算法流

虽然 Transformer 和 BEV 网络很强,但传统算法流(Rule-based) 依然是所有量产车的安全兜底(Safety Fallback)。

传统感知算法框架

传统感知算法框架

这套流水线是白盒的,可解释的:

-

ROI 分割:切掉天空和过远的背景,只关注路面。

-

地面分割:使用 RANSAC 或 Patchwork 算法把"路"剔除,剩下的就是"障碍物"。

-

聚类 (Clustering):欧式聚类或 DBSCAN,把点云聚成团。

-

BBox 拟合:给每一团点画个框,告诉规划模块:"这里有东西,别撞上去。"

总结与互动

自动驾驶不仅是 AI 模型的狂欢,更是底层数据工程的较量。从解决 3cm 的测量误差,到消除 100ms 的运动畸变,这些看似不起眼的"脏活",决定了车辆在极限场景下是安全通过,还是发生事故。

对于本文提到的"运动补偿"或"鬼影过滤",你在实际项目中遇到过哪些坑?

欢迎在评论区留言讨论:

-

你的雷达选型是 905nm 还是 1550nm?

-

在雨雾天遇到过严重的噪点问题吗?

-

是否尝试过用 CUDA 加速预处理?

关注我,下一期我们聊聊:Occupancy Network(占用网络)如何利用 NeRF 生成离线真值?