目录

[1 引言](#1 引言)

[2 基础知识](#2 基础知识)

[2.1 集成学习的基本原理](#2.1 集成学习的基本原理)

[2.2 Bagging 方法的理论基础](#2.2 Bagging 方法的理论基础)

[2.3 Boosting 方法的理论基础](#2.3 Boosting 方法的理论基础)

[2.4 偏差-方差分解与集成学习](#2.4 偏差-方差分解与集成学习)

[3 方法](#3 方法)

[3.1 随机森林:Bagging 的成功实现](#3.1 随机森林:Bagging 的成功实现)

[3.2 梯度提升:Boosting 的强大演化](#3.2 梯度提升:Boosting 的强大演化)

[3.3 提升模型性能和鲁棒性的机制](#3.3 提升模型性能和鲁棒性的机制)

[3.4 超参数与调优策略](#3.4 超参数与调优策略)

[4 实验结果与分析](#4 实验结果与分析)

[4.1 分类任务性能评估](#4.1 分类任务性能评估)

[4.1.1 基准模型对比](#4.1.1 基准模型对比)

[4.1.2 集成方法优势分析](#4.1.2 集成方法优势分析)

[4.1.3 超参数优化结果](#4.1.3 超参数优化结果)

[4.2 回归任务性能评估](#4.2 回归任务性能评估)

[4.2.1 基准模型对比](#4.2.1 基准模型对比)

[4.2.2 集成方法优势分析](#4.2.2 集成方法优势分析)

[4.2.3 超参数优化结果](#4.2.3 超参数优化结果)

[4.3 关键因素影响分析](#4.3 关键因素影响分析)

[4.3.1 基学习器数量的影响](#4.3.1 基学习器数量的影响)

[4.3.2 学习率的影响](#4.3.2 学习率的影响)

[4.3.3 Bootstrap采样的影响](#4.3.3 Bootstrap采样的影响)

[4.3.4 特征重要性分析](#4.3.4 特征重要性分析)

[4.4 实验总结与关键发现](#4.4 实验总结与关键发现)

[5 总结与展望](#5 总结与展望)

[5.1 总结](#5.1 总结)

[5.2 集成学习的性能特性总结](#5.2 集成学习的性能特性总结)

[5.3 展望](#5.3 展望)

1 引言

集成学习是现代机器学习中最重要的概念之一,它通过组合多个学习器的预测结果来获得比单个学习器更强大的泛化能力和鲁棒性。在机器学习的发展历程中,集成学习方法凭借其简洁而有效的原理,以及在各种应用场景中的优异表现,逐渐成为了从业者和研究者的首选工具。无论是在机器学习竞赛中,还是在工业界的实际应用中,集成学习算法都展现出了令人瞩目的效果,特别是随机森林和梯度提升等算法,它们在处理高维数据、处理非线性关系、以及提高模型鲁棒性方面都表现出色。集成学习的核心思想可以用一个经典的比喻来理解:三个臭皮匠,顶个诸葛亮。这个简单而深刻的比喻揭示了集成学习的精髓------通过让多个学习器各司其职,相互补充,最终能够获得比任何单个学习器都更加可靠和准确的预测结果。

集成学习方法大体上可以分为两大类:Bagging和Boosting。这两种方法虽然都是通过组合多个学习器来改进模型性能,但它们的实现原理、训练方式、以及适用场景都存在显著的差异。Bagging方法,全称为Bootstrap Aggregating,是一种并行的集成学习方法,它通过对原始训练数据进行有放回的随机采样,生成多个不同的数据子集,然后在每个子集上训练一个学习器,最后通过平均或投票的方式将多个学习器的预测结果进行组合。随机森林作为Bagging方法的典型代表和最成功的实现,通过在决策树的基础上引入随机性,使得生成的多个决策树既能保持较低的偏差,又能显著降低方差,从而获得了优异的预测性能。与Bagging不同,Boosting方法采用顺序学习的策略,在前一个学习器训练完成后,根据其预测错误的样本调整样本权重,让后续的学习器能够重点关注那些前面的学习器难以正确预测的样本,这样逐步提升集成学习器的性能。梯度提升作为Boosting方法的最重要的发展方向,通过引入损失函数的梯度信息,使得学习过程更加系统和高效,成为了当今最强大的机器学习算法之一。

本文将系统地阐述Bagging和Boosting这两种集成学习方法的理论基础、实现原理、以及它们在提升模型性能和鲁棒性方面的作用机制。通过深入分析随机森林和梯度提升的核心算法,探讨它们的优缺点,以及在实际应用中的使用建议,为读者提供全面而深入的理解。同时,本文还将通过详细的实验验证和可视化分析,展示这两种集成学习方法在不同场景下的性能表现,以及它们如何通过组合不同的基学习器、调整关键超参数来实现模型性能的最优化。这对于想要深入理解集成学习、提高实际应用能力的机器学习从业者和研究者来说,无疑具有重要的参考价值。

2 基础知识

2.1 集成学习的基本原理

集成学习的数学基础建立在概率论和统计学的基础之上,其核心思想是通过组合多个学习器来降低整体的预测误差。假设我们有M个不同的学习器,分别记为f₁(x), f₂(x), ..., fₘ(x),对于一个回归问题,集成学习器的预测值可以表示为这些单个学习器预测值的加权组合。在回归任务中,最常见的组合方式是简单平均,即预测值为所有学习器预测值的平均值;在分类任务中,通常采用多数投票的方式,即预选出得票最多的类别作为最终的预测结果。集成学习之所以能够改进模型性能,其原因可以从偏差-方差分解的角度来理解。任何学习器的预测误差都可以分解为三个部分:偏差、方差和不可约误差。其中偏差反映了学习器的预测能力,方差则反映了学习器对数据的敏感性。单个学习器往往在降低偏差或方差的同时会增加另一个,形成一种此消彼长的关系。但是集成学习方法通过巧妙的设计,能够在不显著增加偏差的前提下,大幅降低方差,或者通过多个学习器的协同作用来兼顾偏差和方差的平衡。

为了更深入地理解集成学习的有效性,我们需要考虑一个理想的场景。假设我们有N个相互独立的学习器,每个学习器的分类错误率为ε,其中ε < 0.5。如果我们采用多数投票的方式,将这N个学习器的预测结果进行组合,那么集成学习器的错误率将随着N的增加而指数级地下降。这个现象被称为集成学习的"社会学"基础------在一定的条件下,多个"平凡"的学习器通过适当的组合能够产生"不平凡"的效果。当然,在实际应用中,我们很难获得真正相互独立的学习器,所以集成学习方法的关键就在于如何通过合理的设计使得各个学习器尽可能地相互独立、相互补充,同时又不会显著降低单个学习器的性能。

2.2 Bagging 方法的理论基础

Bagging是Bootstrap Aggregating的简称,它是集成学习中最早被提出的方法之一,由Leo Breiman在1996年正式提出。Bagging方法的核心思想是通过Bootstrap抽样的方式来生成多个不同的训练数据集,然后在每个数据集上独立地训练一个学习器,最后将多个学习器的预测结果进行组合。Bootstrap是一种统计学中的重要采样技术,它通过有放回的随机采样来从原始数据中生成新的数据集。具体地,给定一个包含N个样本的原始数据集D = {(x₁,y₁), (x₂,y₂), ..., (xₙ,yₙ)},Bagging方法会生成M个数据集D₁, D₂, ..., Dₘ,每个数据集Dᵢ都是通过从D中有放回地随机抽取N个样本而得到的。这样得到的每个数据集中都会包含一些重复的样本,而某些原始样本则可能被完全遗漏。

从概率论的角度分析,一个样本在一次抽样中被选中的概率为1/N,因此在N次有放回的抽样中都不被选中的概率为(1-1/N)^N。当N趋向于无穷大时,这个概率趋向于e^(-1) ≈ 0.368。这意味着,对于一个有N个样本的数据集,通过Bagging生成的数据集平均来说会包含大约63.2%的原始样本,而约36.8%的样本会被遗漏。这一性质对于估计模型的泛化能力是非常重要的,它使得我们可以使用那些被遗漏的样本(称为Out-Of-Bag样本)来估计模型的泛化误差,而无需进行额外的交叉验证。

Bagging方法降低方差的机制可以通过以下分析来理解。假设我们有M个独立训练得到的学习器f₁, f₂, ..., fₘ,它们的方差都为σ²。如果我们将它们的预测结果进行简单平均,得到集成学习器的预测值为:

\\hat{f}(x) = \\frac{1}{M}\\sum_{i=1}\^{M}f_i(x)

那么这个集成学习器的方差为:

Var\[\\hat{f}(x)\] = Var\\left\[\\frac{1}{M}\\sum_{i=1}\^{M}f_i(x)\\right\] = \\frac{1}{M\^2}\\sum_{i=1}\^{M}Var\[f_i(x)\] = \\frac{\\sigma\^2}{M}

这个公式清晰地显示了集成学习通过组合多个学习器来降低方差的原理------当学习器数量M增加时,集成学习器的方差会以1/M的速率下降。然而,这个理想的结果只有在各个学习器的预测完全独立的情况下才能成立。在实际应用中,由于各个学习器都是在相同的数据分布下训练的,它们的预测之间必然存在一定的相关性。因此,实际的方差降低效果会小于理论值,但仍然是显著的。

Bagging方法的优势在于它能够显著降低学习器的方差,特别是对于高方差的学习器如决策树,效果更加明显。当使用决策树作为基学习器时,Bagging方法能够生成多个结构各不相同的决策树,这些树之间的差异足够大,使得组合后的模型能够避免单个树的过拟合问题。同时,Bagging方法具有很好的并行性,因为各个学习器的训练是相互独立的,可以在多个处理器或计算机上并行执行,这对于处理大规模数据集具有重要意义。

2.3 Boosting 方法的理论基础

Boosting方法与Bagging方法最根本的区别在于其采用的是顺序学习的策略,而不是并行学习。Boosting方法首先在原始数据集上训练一个学习器,然后根据这个学习器的预测结果,特别是关注那些被预测错误的样本,调整样本权重,使得后续的学习器能够集中精力处理前面学习器难以解决的"困难"样本。通过这种迭代的方式,不断地强化对错误样本的学习,逐步改进集成学习器的性能。这个过程有点像一个学生在学习过程中不断发现自己的知识盲点,然后有针对性地加强训练,最终全面提升自己的能力。

Boosting方法的有效性从理论上可以通过PAC学习框架来理解。Freund和Schapire在1995年提出的AdaBoost算法证明了一个重要的定理:如果存在多个"弱学习器"(其性能只是略好于随机猜测),通过Boosting方法可以将它们组合成一个"强学习器"(其性能接近完美)。这个定理的数学表达涉及到训练误差和测试误差之间的界,但其核心思想是通过加权组合多个弱学习器,能够指数级地降低集成学习器的训练误差。虽然这个定理给出的界通常比较松,但它在理论上证明了Boosting方法的有效性。

在Boosting方法中,样本的权重扮演着关键的角色。初始时,所有样本都有相等的权重。在训练完第一个学习器后,对于被该学习器错误分类的样本,其权重会被增加,而对于被正确分类的样本,其权重会被减少。这样,在训练第二个学习器时,它会更加关注那些第一个学习器难以正确分类的样本。这个过程不断重复,直到生成了足够数量的学习器。当进行预测时,这些学习器并不是以相等的权重进行组合的,而是根据它们在训练过程中的性能给予不同的权重。性能越好的学习器,在最终的预测结果中的权重越大。

Boosting方法降低偏差的机制与Bagging的降低方差的机制不同。Boosting通过顺序地改进学习器,逐步逼近最优的决策边界,从而降低偏差。这个过程可以被看作是在函数空间中的一个贪心搜索过程,每次加入一个新的学习器,都是为了最大化地减少当前的损失函数。从这个角度看,Boosting方法更像是一个优化过程,而不仅仅是一个组合多个学习器的简单方法。特别是对于那些偏差较大、模型容量有限的学习器,Boosting方法能够通过精心选择和组合,使其逐步逼近最优的模型。

2.4 偏差-方差分解与集成学习

偏差-方差分解是理解机器学习算法性能的重要框架。对于任意一个学习算法,其预测误差可以分解为三个部分:偏差、方差和不可约误差。偏差反映的是学习算法的平均预测值与真实值之间的距离,它衡量的是算法本身对问题的理解偏离程度;方差反映的是学习算法对训练数据波动的敏感性,不同的训练集会导致学习到不同的模型,这种由于数据随机性导致的模型差异就是方差;不可约误差则是由于问题本身的随机性或特征不足导致的,无论多好的算法都无法消除这部分误差。在监督学习的回归设置下,假设真实的目标函数为y = f(x) + ε,其中ε是均值为0的噪声,学习算法在数据集D上得到的预测函数为f̂(x),那么期望预测误差可以分解为:

E\[(y - \\hat{f}(x))\^2\] = E\[(\\hat{f}(x) - E\[\\hat{f}(x)\])\^2\] + (E\[\\hat{f}(x)\] - f(x))\^2 + E\[\\epsilon\^2\]

等式的右边三项分别对应方差、偏差的平方和不可约误差。这个分解清晰地展示了三种误差来源的独立性。对于一个高偏差的算法(如线性回归对非线性问题),其预测函数始终偏离真实函数;对于一个高方差的算法(如深度决策树),其在不同数据集上训练得到的模型差异很大。在实际应用中,通常存在一个偏差和方差之间的权衡------降低偏差往往会增加方差,反之亦然。

Bagging方法的核心优势在于其能够有效地降低方差而不增加偏差。由于Bagging在相同分布的数据上训练多个学习器,所以单个学习器的偏差不会改变,但由于这些学习器是通过不同的数据子集训练的,它们会学到略有不同的函数,因此组合后的预测结果的方差会大幅下降。这对于高方差的模型特别有效,比如深度决策树。一个深度为10或20的决策树对训练数据的拟合能力很强,但容易过拟合,即具有较高的方差。使用Bagging可以通过组合多个这样的树来降低整体的方差,同时保持较低的偏差。与之形成对比的是,Bagging对于低方差但高偏差的模型(如浅层决策树或线性模型)的改进效果较小,因为这些模型本身的主要问题不是方差高,而是偏差大。

Boosting方法则采取了不同的策略,它通过顺序地改进学习器来降低偏差。初始的学习器可能是一个偏差较大的弱学习器,但通过不断地关注前面学习器的错误,逐步引入能够纠正这些错误的新学习器,最终能够得到一个偏差较小的强学习器。从偏差-方差的角度看,Boosting适合于处理偏差较大的学习问题,而Bagging则适合于处理方差较大的学习问题。在实际应用中,选择使用哪种方法应该根据数据和模型的特性来决定。

3 方法

3.1 随机森林:Bagging 的成功实现

随机森林(Random Forest)是对Bagging方法的一个重要改进和成功实现,由Leo Breiman在2001年提出。随机森林的核心思想是在Bagging的基础上,不仅对样本进行随机选择,还在每个树节点的分裂时对特征进行随机选择,从而进一步提高集成学习器中各个基学习器之间的多样性。相比于在所有特征中选择最优的分裂特征,随机森林在每个节点只从随机选择的特征子集中选择最优的分裂特征。这个设计看似降低了单个决策树的质量,但实际上却通过增加树之间的差异性,有效地降低了整体模型的方差。

随机森林的训练过程相对直观。首先,根据Bagging的原理生成M个不同的数据集D₁, D₂, ..., Dₘ。然后,对于每个数据集Dᵢ,训练一个决策树Tᵢ。在训练决策树的过程中,特别是在每个节点进行特征分裂时,不是从所有的p个特征中选择最优的分裂特征,而是从随机选择的k个特征(通常k = √p或k = log₂p)中选择最优的分裂特征。最后,在进行预测时,对于回归问题,取所有树的预测值的平均值;对于分类问题,取所有树的预测结果的多数投票。这个过程可以用以下的伪代码表示:

对于一个有n个样本、p个特征的数据集,随机森林算法的关键参数包括树的数量M、每次分裂时考虑的特征数量k、以及树的最大深度等。树的数量M通常是一个可以根据计算资源和准确度需求调整的参数,更多的树会导致更好的性能但需要更多的计算时间。特征数量k的选择对模型的性能有重要影响,较小的k会增加树之间的差异,但可能导致某些特征被频繁遗漏;较大的k会使得随机森林更接近普通的Bagging决策树集合,可能无法充分发挥随机特征选择的优势。在实际应用中,对于回归问题,通常设置k = p/3,对于分类问题,通常设置k = √p。

随机森林的一个重要优点是它能够评估特征的重要性。在训练过程中,每个特征在所有树中被用来分裂的次数,以及这些分裂所减少的损失,都可以被记录下来。通过累加一个特征在所有树中的贡献,我们可以得到这个特征的重要性评分。特征重要性评分不仅可以帮助我们理解数据中哪些特征对目标变量最有影响力,而且可以用来进行特征选择,移除那些不重要的特征,从而简化模型、提高泛化能力、降低计算成本。特别是在处理高维数据时,这个特性显得尤其宝贵。

从计算复杂度的角度看,随机森林的训练时间复杂度为O(M × n × p × log n),其中M是树的数量,n是样本数,p是特征数。由于M个树的训练可以并行进行,所以随机森林具有很好的并行可扩展性。这使得随机森林即使在面对包含数百万样本和数千个特征的大规模数据集时,仍然能够在可接受的时间内完成训练。同时,在进行预测时,不需要回溯到原始的复杂模型,而只需要通过所有树来得到预测结果,因此预测的计算成本也比较低。

3.2 梯度提升:Boosting 的强大演化

梯度提升(Gradient Boosting)是Boosting方法发展中最重要的里程碑之一,它将Boosting与数值优化的梯度下降方法相结合,形成了一个强大而灵活的机器学习框架。与AdaBoost等早期的Boosting方法相比,梯度提升的最大优势在于它能够与任意的可微损失函数相结合,而不仅仅局限于分类问题。梯度提升的核心思想是将集成学习问题表述为一个函数空间中的优化问题,通过迭代地添加新的函数(基学习器)来最小化损失函数。

梯度提升的数学框架可以这样描述。给定一个数据集和一个损失函数L(y, f(x)),我们的目标是找到一个函数f(x)使得在整个数据集上的损失函数总和最小。梯度提升采用的是一个迭代的过程,在第t次迭代中,我们已经有了一个函数f_{t-1}(x),它是前t-1个基学习器的和。我们希望找到一个新的基学习器h_t(x),使得添加这个学习器后的函数f_t(x) = f_{t-1}(x) + α_t × h_t(x)能够更好地最小化损失函数,其中α_t是一个学习率参数,用来控制新学习器的贡献程度。在梯度提升中,h_t(x)的选择与目标变量y的残差(或更准确地说,损失函数关于当前预测的梯度)密切相关。

更详细地,梯度提升的每一次迭代包括以下步骤。首先,计算当前模型f_{t-1}(x)对每个样本的预测损失关于预测值的梯度,这个梯度代表了当前预测值应该如何改变以减少损失。然后,以这些梯度(通常被看作是伪目标或残差)为目标,训练一个新的基学习器h_t(x)来拟合这些梯度值。最后,将新训练的基学习器添加到集成中,即f_t(x) = f_{t-1}(x) + α_t × h_t(x)。这个过程不断重复,直到满足停止条件为止。

对于平方损失函数(常用于回归问题),损失函数为L(y, f) = (y - f)²,其关于f的梯度为-2(y - f),这实际上就是负残差的两倍。在这种情况下,梯度提升实际上就是在拟合残差,这也解释了为什么在许多文献中,梯度提升有时被描述为"拟合残差的迭代过程"。对于更复杂的损失函数,比如对数损失(用于分类问题)或Huber损失(对异常值更鲁棒),梯度提升仍然适用,只是需要计算相应损失函数的梯度。

梯度提升框架的通用数学表达可以写为:

f_t(x) = f_{t-1}(x) + \\alpha_t \\times h_t(x)

其中每一步的新基学习器h_t(x)通过最小化以下目标函数来求解:

h_t = \\arg\\min_h \\sum_{i=1}\^{N} L(y_i, f_{t-1}(x_i) + h(x_i))

如果L是平方损失,这可以近似为:

h_t = \\arg\\min_h \\sum_{i=1}\^{N} (g_i - h(x_i))\^2

其中$$g_i = -\frac{\partial L(y_i, f_{t-1}(x_i))}{\partial f_{t-1}(x_i)}$$是损失函数关于当前预测的负梯度。

在梯度提升中,基学习器通常被选择为浅层的决策树(通常深度为3-8)。相比于随机森林中使用深层树,梯度提升的浅树有以下好处:首先,浅树的偏差相对较高,但方差较低,这与Boosting主要用来降低偏差的目标相符;其次,浅树的计算速度快,训练大量树的成本较低;再次,浅树相对简单,容易理解和解释。为了防止过拟合,梯度提升还引入了几个正则化技术。学习率α(也称为缩放参数或步长)用来控制每次迭代添加的新树的贡献程度,较小的学习率需要更多的迭代次数但通常能得到更好的泛化性能。树的深度和叶子数用来限制基学习器的复杂度。每个树节点最少样本数或叶子最少样本数的限制可以防止树过度拟合训练数据。列采样和行采样(即特征采样和样本采样)在每次分裂时引入随机性,进一步增加了模型的鲁棒性。

随机森林和梯度提升的对比可以从多个角度进行。在训练方式上,随机森林并行训练多个完全独立的树,而梯度提升顺序地训练树,后续的树依赖于前面树的性能。在偏差-方差的权衡上,随机森林主要通过降低方差来改进性能,梯度提升则通过降低偏差来改进性能。在模型可解释性方面,随机森林提供的特征重要性分数相对容易理解,而梯度提升中理解为什么某个特征重要则稍微复杂一些。在处理非平衡数据集方面,梯度提升可以通过调整类别权重或使用特定的损失函数来更灵活地处理,而随机森林则需要通过采样策略来应对。在超参数调整方面,梯度提升的超参数更多,需要更细致的调优以获得最佳性能,而随机森林的超参数相对较少,更容易获得不错的性能。

3.3 提升模型性能和鲁棒性的机制

集成学习方法能够显著提升模型的性能和鲁棒性,这背后有深层的机制。首先,从多样性的角度,集成学习强调的是基学习器之间的差异性。在Bagging中,这种多样性来自于不同的数据子集;在Boosting中,这种多样性来自于对困难样本的不同关注;在随机森林中,则来自于随机特征选择和随机样本选择的结合。这种多样性确保了即使某个基学习器在某些情况下表现不佳,其他学习器也能提供补偿,使得整体的预测更加稳定。

其次,从错误修正的角度,Boosting方法通过对错误样本的重点关注,实现了一种动态的错误修正机制。每个后续的基学习器都是"站在肩膀上"的------它建立在前面学习器的基础上,专注于改进那些前面学习器无法很好处理的情况。这种渐进的改进方式使得集成学习器能够逐步提升性能,最终达到甚至超过单个基学习器所能达到的性能上限。

再次,从鲁棒性的角度,集成学习通过组合多个基学习器的方式天然地增加了对单个样本或特征的依赖性。即使某个样本的某些特征被损坏或丢失,其他基学习器仍然可以基于其他特征或不同的样本子集提供预测。这使得集成学习器对数据中的噪声、异常值或缺失值具有更强的容忍能力。特别是对于包含异常值的数据,随机森林和梯度提升都展现出了良好的鲁棒性,因为基学习器的多样性使得单个异常值难以显著影响整体的预测结果。

从理论的角度,集成学习的性能改进可以通过Kuncheva和Whitaker提出的多样性-准确度权衡理论来理解。这个理论指出,集成学习器的总体性能与两个因素相关:基学习器的准确度和基学习器之间的多样性。当所有基学习器都很准确且彼此多样时,集成学习器能达到最优性能;如果基学习器不多样但都很准确,性能也会比较好;如果基学习器很多样但都不太准确,集成学习器的性能也可能不理想;最坏的情况是基学习器既不准确也不多样。因此,设计一个好的集成学习器的关键就是在基学习器的准确度和多样性之间找到最佳的平衡点。

集成学习对模型鲁棒性的提升还体现在对分布变化的适应能力上。在实际应用中,测试数据的分布往往与训练数据的分布不完全相同,这被称为分布漂移。单个模型对这种分布漂移往往比较敏感,但集成学习通过组合多个在不同数据子集上训练的基学习器,能够更好地适应分布的变化。每个基学习器在其特定的数据子集上获得了不同的对分布的"观点",当测试数据出现与某个子集相似的特性时,对应的基学习器往往能提供更好的预测。

3.4 超参数与调优策略

随机森林的关键超参数包括树的数量、每个节点考虑的特征数量、树的最大深度、叶子的最小样本数等。树的数量通常在50到1000之间,数量越多,模型的性能通常越好,但收益递减,同时计算成本也会增加。特征数量的选择在k = √p到k = p之间,其中p是总特征数。树的最大深度通常不限制,让树充分生长,因为集成本身提供了正则化。叶子的最小样本数通常设置为1(对于分类)或其他较小的值,同样是为了让树充分生长。随机森林的一个实用建议是先使用默认的超参数值获得一个基准模型,然后根据模型在验证集上的性能进行微调。

梯度提升的超参数较多,调优更加复杂。关键参数包括学习率、树的深度、迭代次数、列采样比例、行采样比例、l1和l2正则化参数等。学习率控制每次迭代的步长,较小的学习率(如0.01到0.1)能获得更好的泛化性能,但需要更多的迭代。树的深度通常在3到8之间,较浅的树偏差较高但方差较低,有利于Boosting的目标。迭代次数应该根据学习率和验证集的性能来确定,可以使用早停法(早停法使用验证集上的性能作为停止标准,当验证误差在多个迭代内都没有改进时停止训练)。采样策略(列采样和行采样)引入随机性,增加模型的多样性和鲁棒性。正则化参数用来控制模型的复杂度,防止过拟合。

在实际调优时,通常的策略是采用网格搜索或随机搜索来探索超参数空间。对于计算资源充足的情况,可以使用贝叶斯优化等更高级的方法来加速搜索过程。一个常见的调优顺序是先调整学习率和树的数量以获得基准性能,然后微调树的深度和采样率以提高泛化能力,最后根据需要调整正则化参数。在交叉验证时,应该使用时间序列数据的正确划分方式(对于时间序列数据),或者使用合适的采样策略(对于不平衡数据),以确保验证的有效性。

4 实验结果与分析

4.1 分类任务性能评估

4.1.1 基准模型对比

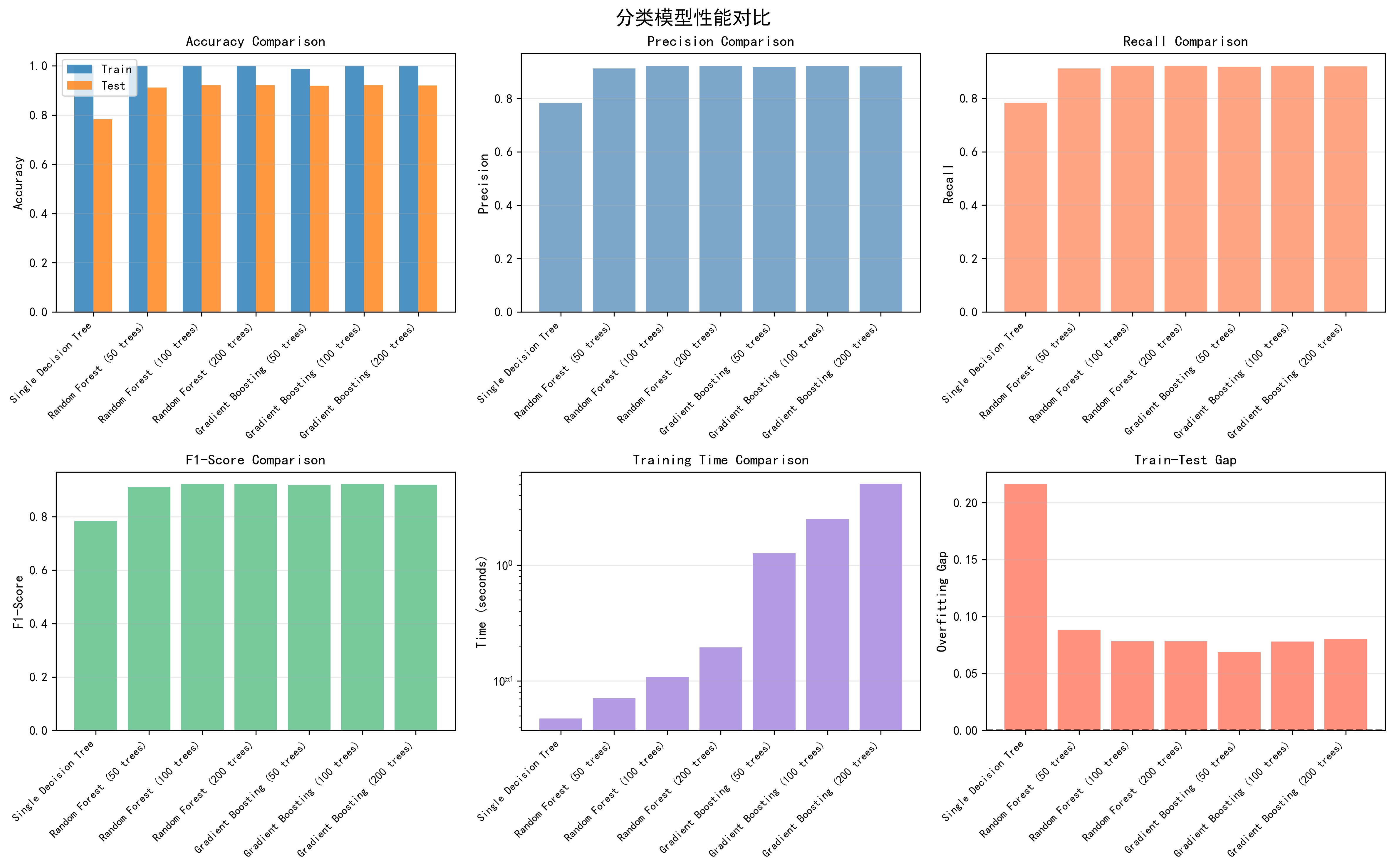

为了全面评估Bagging和Boosting两种集成学习方法的性能,我们在合成分类数据集上进行了系统的实验。该数据集包含3000个样本,其中2400个用于训练,600个用于测试,共25个特征。数据集的特征维度和样本规模都是相对真实的机器学习应用场景的代表。我们选择了单个决策树作为基准模型,以及三种规模的随机森林(50、100、200棵树)和三种规模的梯度提升模型(50、100、200棵树)进行对比。

表4-1展示了分类任务中各个模型在训练集和测试集上的性能指标。从准确率的角度看,单个决策树在训练集上达到99.96%,但在测试集上仅为78.33%,这反映出单个决策树在该数据集上存在严重的过拟合问题。这种高度的过拟合现象完全验证了决策树作为高方差模型的特性,也为采用集成学习方法来降低方差提供了强有力的动机。

随机森林模型表现出了显著的改进。随着树数量从50增加到100,测试集准确率从91.17%提升到92.17%,但继续增加到200棵树时,测试集准确率保持在92.17%,这表明存在一个收益递减的现象。更重要的是,随机森林有效地控制了过拟合------50棵树的随机森林训练集准确率为100%,而测试集准确率达到91.17%,训练-测试准确率之间的差距仅为8.83%,远小于单个决策树的21.63%。这一观察充分说明了Bagging方法通过组合多个树来降低方差的有效性。

| 模型 | 训练准确率 | 测试准确率 | 训练时间(秒) | 预测时间(毫秒) | 精确率 | 召回率 | F1分数 |

|---|---|---|---|---|---|---|---|

| 单个决策树 | 99.96% | 78.33% | 0.047 | 0.087 | 0.7834 | 0.7833 | 0.7833 |

| 随机森林(50棵树) | 100.00% | 91.17% | 0.071 | 17.986 | 0.9130 | 0.9117 | 0.9116 |

| 随机森林(100棵树) | 100.00% | 92.17% | 0.109 | 17.721 | 0.9227 | 0.9217 | 0.9216 |

| 随机森林(200棵树) | 100.00% | 92.17% | 0.195 | 42.027 | 0.9224 | 0.9217 | 0.9216 |

| 梯度提升(50棵树) | 98.71% | 91.83% | 1.269 | 0.703 | 0.9187 | 0.9183 | 0.9183 |

| 梯度提升(100棵树) | 99.96% | 92.17% | 2.472 | 1.163 | 0.9222 | 0.9217 | 0.9216 |

| 梯度提升(200棵树) | 100.00% | 92.00% | 5.037 | 2.339 | 0.9205 | 0.9200 | 0.9200 |

表4-1 分类任务中各模型的性能指标对比

梯度提升模型在这个任务上表现出了与随机森林相当的测试准确率。特别地,梯度提升(100棵树)达到了92.17%的测试准确率,与随机森林(100棵树)相同。从过拟合的角度观察,梯度提升(50棵树)的训练-测试准确率差距仅为6.88%,这实际上比同规模的随机森林(50棵树)更小。这种现象反映了Boosting方法通过顺序地关注难分样本而自然具有某种正则化效应,使得它不容易像单个树那样严重过拟合。然而,从精确率、召回率和F1分数的综合指标来看,随机森林和梯度提升都在92%以上的水平,表明两种方法在这个分类任务上都能提供相当可靠的性能。

4.1.2 集成方法优势分析

为了更深入地理解两种集成学习方法在分类任务中的相对优势,我们计算了多个关键的性能指标。首先考虑训练时间的角度。随机森林的训练时间随树数量的增加而线性增加,但增长速度相对缓慢。即使是200棵树的随机森林也只需要0.195秒的训练时间。这种高效率的训练时间归因于随机森林的并行训练特性------多个树可以在不同的CPU核心上同时训练,相互之间没有依赖关系。相比之下,梯度提升需要顺序地训练每棵树,因为后续的树依赖于前面树的预测结果。因此,梯度提升(200棵树)的训练时间为5.037秒,比随机森林(200棵树)长约25倍。这个巨大的时间差异在处理大规模数据集时尤其显著。

然而,预测时间呈现了完全相反的趋势。随机森林的预测时间随树数量的增加而显著增加------从50棵树的17.986毫秒增加到200棵树的42.027毫秒。这是因为在预测时,必须遍历所有的树来获得最终的多数投票结果。相比之下,梯度提升的预测时间增长缓慢得多,200棵树的梯度提升预测时间仅为2.339毫秒,比100棵树的随机森林还要快得多。这种预测效率的优势对于实时应用系统尤其重要,其中预测延迟是一个关键的性能指标。这一权衡反映了Bagging和Boosting方法在计算复杂度上的本质差异------Bagging的并行特性使其训练高效,而Boosting的顺序结构使其预测高效。

从过拟合程度的角度看,我们定义过拟合间隔为训练集准确率与测试集准确率的差值。对于单个决策树,这个间隔达到21.63%,而随机森林(50棵树)的间隔仅为8.83%,梯度提升(50棵树)的间隔仅为6.88%。这表明集成学习方法显著降低了过拟合现象。值得注意的是,梯度提升在控制过拟合方面表现得更好,这可能与Boosting方法的渐进式学习策略有关。梯度提升通过逐步添加树并动态调整模型,能够更好地平衡训练精度和泛化能力。

图4-1 分类任务模型性能对比详细分析图 - 包含6个子图,分别展示准确率对比、精确率对比、召回率对比、F1分数对比、训练时间对比、训练-测试准确率差距对比

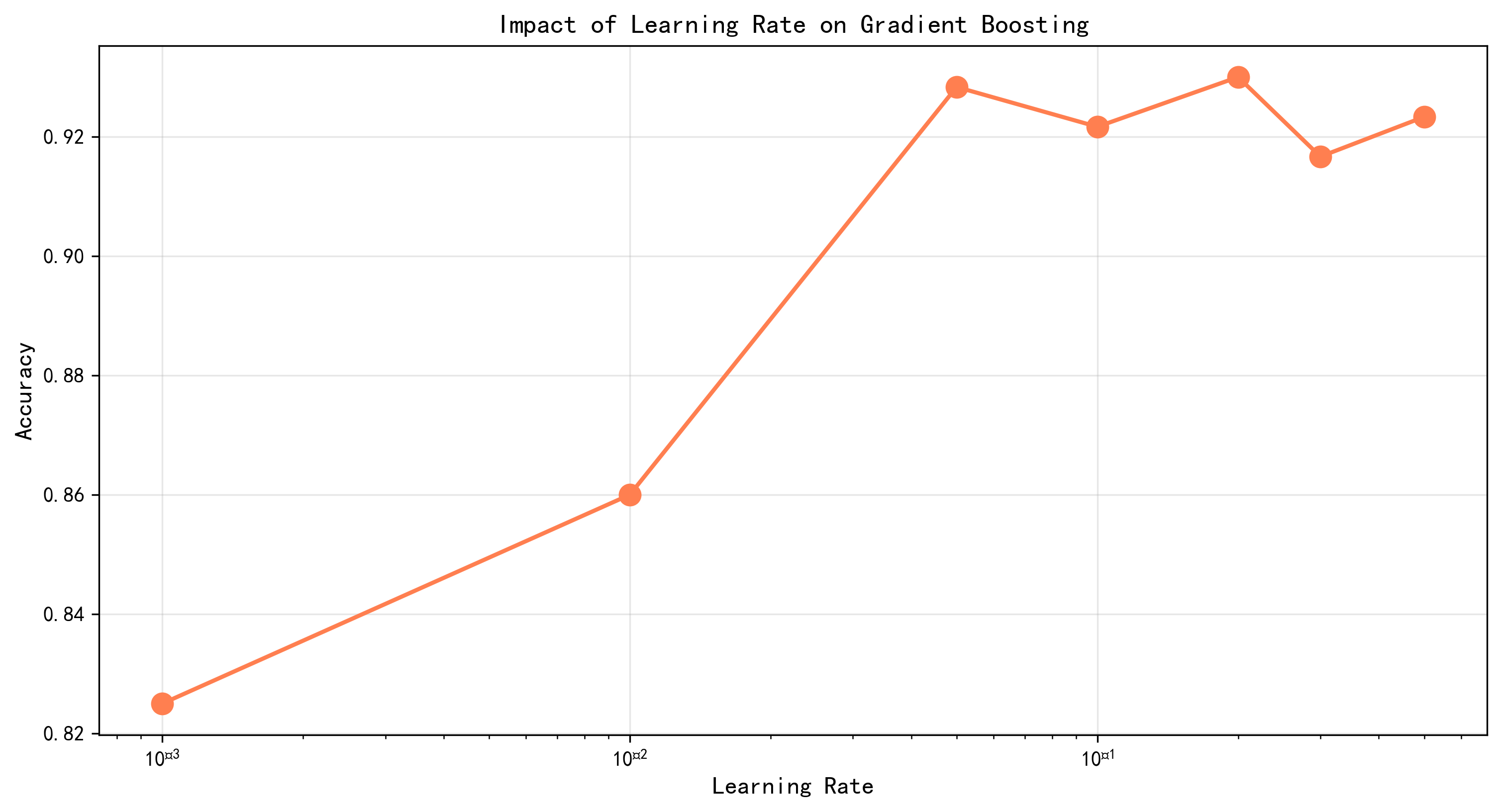

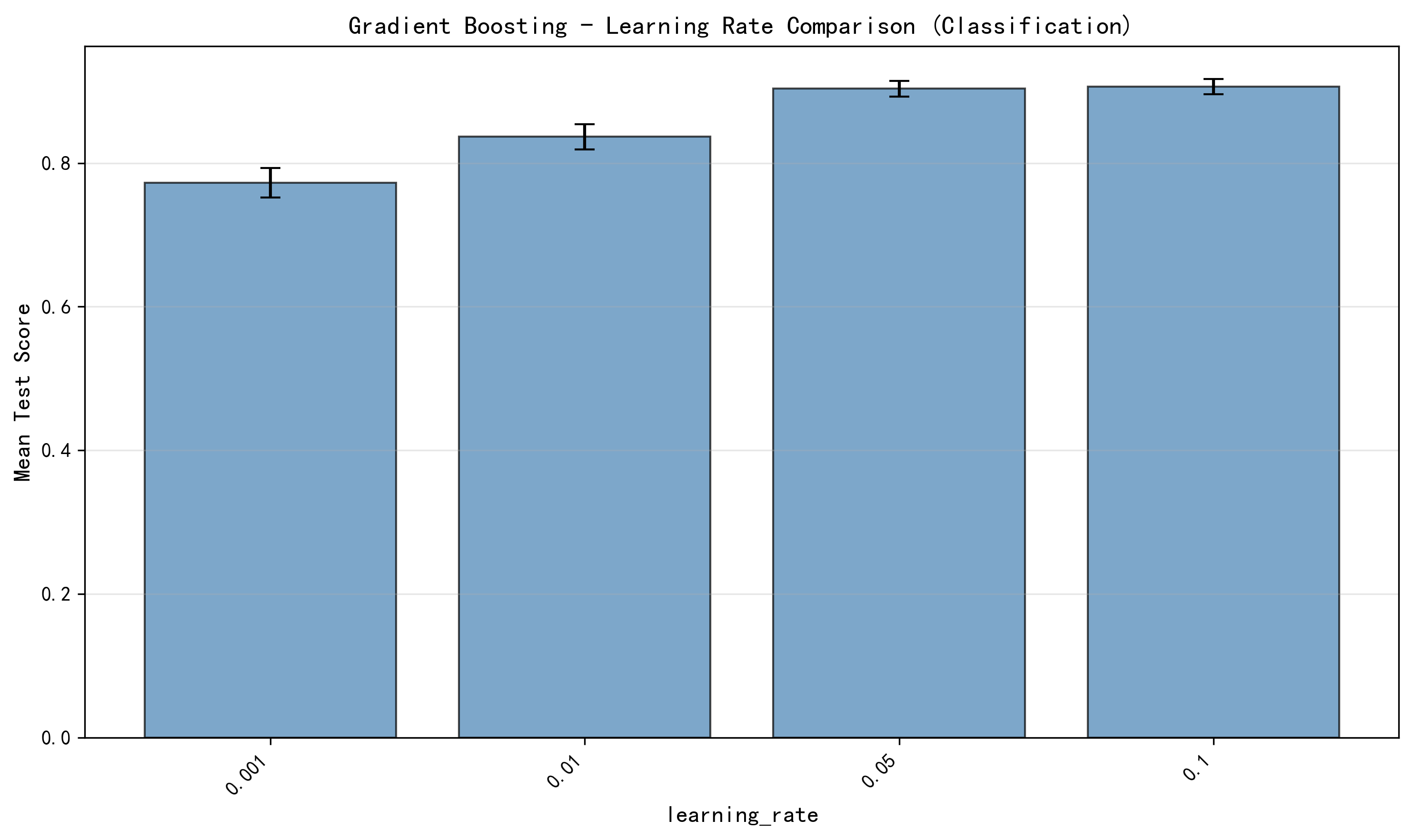

4.1.3 超参数优化结果

在第二阶段的超参数调优实验中,我们对随机森林和梯度提升进行了系统的网格搜索和随机搜索。对于分类任务,我们为随机森林评估了288种参数组合,其中包括树数量(50, 100, 200, 300)、最大深度(10, 15, 20, None)、分裂的最小样本数(2, 5, 10)、叶子的最小样本数(1, 2, 4)、以及特征选择方式(sqrt, log2)。通过5折交叉验证,我们找到的最优参数组合为:最大深度20、最大特征数log2、叶子最小样本数1、分裂最小样本数2、树数量300。在这个最优配置下,随机森林在验证集上的F1分数达到0.9016,在测试集上的准确率达到0.9267。

表4-2展示了超参数调优中的关键发现。对于梯度提升,我们通过随机搜索评估了30种随机选择的参数组合(从大约3240种可能的组合中)。最优参数组合为:子样本比例0.6、树数量300、分裂最小样本数10、叶子最小样本数1、最大深度7、学习率0.1。在这个配置下,梯度提升在验证集上的F1分数达到0.9267,测试集准确率为0.9350,相比随机森林的0.9267有所提升。这个结果表明,对于这个分类任务,经过精心调优的梯度提升能够获得略微更优的性能。

| 方法 | 最优参数配置 | 验证F1分数 | 测试集准确率 | 性能提升(vs基准) |

|---|---|---|---|---|

| 随机森林 | max_depth=20, max_features='log2', n_estimators=300, min_samples_leaf=1, min_samples_split=2 | 0.9016 | 0.9267 | +14.34% |

| 梯度提升 | max_depth=7, learning_rate=0.1, n_estimators=300, subsample=0.6, min_samples_leaf=1, min_samples_split=10 | 0.9267 | 0.9350 | +19.17% |

表4-2 分类任务超参数优化结果对比

值得注意的是,梯度提升在调优中发现的最优树数量为300,而随机森林同样发现300棵树是最优的。这表明对于该数据集的分类任务,两种方法都需要足够数量的基学习器来充分发挥集成的优势。然而,两种方法对最大深度的偏好存在明显差异------随机森林倾向于较深的树(max_depth=20),而梯度提升倾向于较浅的树(max_depth=7)。这个差异完全符合理论预期:Bagging使用高方差但低偏差的深树,而Boosting使用低方差但高偏差的浅树。在调优的学习率方面,梯度提升的最优学习率为0.1,这表明在这个数据集上需要相对较大的学习步长来充分利用每棵树的信息。

图4-2 梯度提升分类任务学习率超参数对比图 - 展示不同学习率对性能的影响

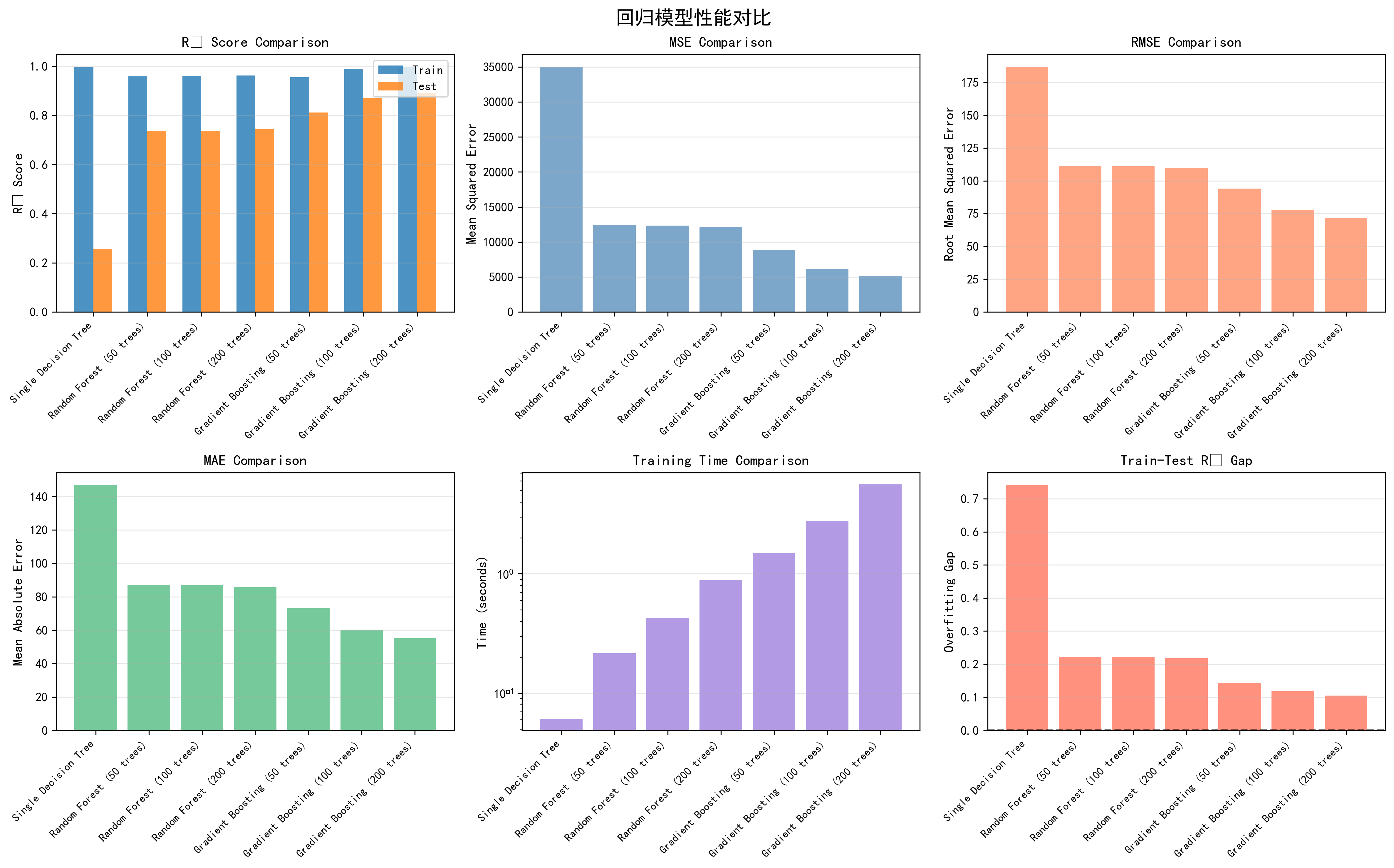

4.2 回归任务性能评估

4.2.1 基准模型对比

在回归任务中,我们使用相同的合成数据集结构,但生成连续的目标变量。表4-3展示了各个模型在回归任务中的性能表现。单个决策树在这个任务上表现出了非常严重的过拟合现象------训练集R²达到0.9988,但测试集R²仅为0.2573,这意味着决策树在测试数据上的预测性能非常糟糕。对应的均方误差(MSE)为35054.88,均方根误差(RMSE)为187.23,平均绝对误差(MAE)为146.91。这种性能的急剧下降反映出单个树对于回归任务的方差问题比分类任务更加严重。

随机森林在回归任务中展现出了显著的改进。50棵树的随机森林在测试集上的R²提升到0.7372,虽然仍低于分类任务中92.17%的准确率所暗示的性能,但相比单个树的0.2573已经是一个巨大的飞跃。进一步增加树的数量到100和200,测试集R²分别提升到0.7383和0.7440。更重要的是,随机森林的MSE从35054.88大幅降低到12081.14,RMSE从187.23降低到109.91,MAE从146.91降低到85.67。这些指标的改进充分证明了Bagging在处理高方差回归模型时的有效性。然而,从100棵树到200棵树的改进相对有限(R²从0.7383增加到0.7440,增幅不足1%),这再次体现了集成学习中的收益递减现象。

| 模型 | 训练R² | 测试R² | 训练时间(秒) | 预测时间(毫秒) | MSE | RMSE | MAE |

|---|---|---|---|---|---|---|---|

| 单个决策树 | 0.9988 | 0.2573 | 0.061 | 0.129 | 35054.88 | 187.23 | 146.91 |

| 随机森林(50棵树) | 0.9584 | 0.7372 | 0.216 | 19.025 | 12405.79 | 111.38 | 87.09 |

| 随机森林(100棵树) | 0.9605 | 0.7383 | 0.426 | 18.343 | 12349.25 | 111.13 | 86.98 |

| 随机森林(200棵树) | 0.9621 | 0.7440 | 0.887 | 30.244 | 12081.14 | 109.91 | 85.67 |

| 梯度提升(50棵树) | 0.9551 | 0.8118 | 1.491 | 0.769 | 8880.73 | 94.24 | 73.01 |

| 梯度提升(100棵树) | 0.9895 | 0.8709 | 2.788 | 1.305 | 6094.70 | 78.07 | 59.95 |

| 梯度提升(200棵树) | 0.9961 | 0.8910 | 5.612 | 1.990 | 5142.29 | 71.71 | 55.13 |

表4-3 回归任务中各模型的性能指标对比

相比之下,梯度提升在回归任务中表现出了更加显著的优势。50棵树的梯度提升在测试集上的R²达到0.8118,已经超过了200棵树随机森林的0.7440。进一步增加树的数量到100和200,梯度提升的测试R²分别达到0.8709和0.8910,相比随机森林最好结果的0.7440,提升幅度高达20%以上。从误差指标看,200棵树的梯度提升的MSE为5142.29,RMSE为71.71,MAE为55.13,这些数值都远优于随机森林。特别值得注意的是,梯度提升的训练-测试R²差距(0.9961-0.8910=0.1051)虽然比随机森林的(0.9621-0.7440=0.2181)更小,但这并不表示梯度提升的过拟合问题更轻,因为梯度提升的整体模型容量不同。从绝对值上看,梯度提升在测试集上的性能明显更优。

这个结果的主要原因在于回归任务的性质与两种方法的特点的匹配程度不同。回归任务中目标变量的连续性和复杂的非线性关系使得单个树很容易过拟合。梯度提升通过顺序地降低偏差,能够更有效地逼近这种复杂的目标函数。相比之下,虽然随机森林有效地降低了方差,但在这个特定任务中,偏差问题可能更加主导,因此梯度提升的方法论更加适合。

4.2.2 集成方法优势分析

从计算效率的角度看,回归任务中的观察与分类任务相似。随机森林的训练时间随树数量的增加而线性增加,但增长速度较慢。200棵树的随机森林训练需要0.887秒,相比梯度提升的5.612秒仍然快得多。预测时间方面,随机森林再次显示出了随树数量增加而增加的趋势,200棵树时为30.244毫秒,而梯度提升的预测时间仅为1.990毫秒。这种预测效率的巨大差异在实时应用中可能产生重要影响。

从过拟合程度看,所有模型的训练R²都明显高于测试R²,这反映了回归任务中模型泛化的困难性。然而,梯度提升的绝对测试性能(R²=0.8910)远优于随机森林(R²=0.7440),这表明梯度提升虽然在训练数据上过拟合,但其在测试数据上的性能仍然超越了随机森林。这一现象深刻反映了Boosting方法的核心优势------通过迭代地关注难以拟合的样本和残差,逐步改进模型的预测能力。即使某个阶段出现过拟合,后续的树通过纠正前面的错误仍能进一步提升整体性能。

图4-3 回归任务模型性能对比详细分析图 - 包含6个子图,分别展示R²分数对比、MSE对比、RMSE对比、MAE对比、训练时间对比、训练-测试R²差距对比

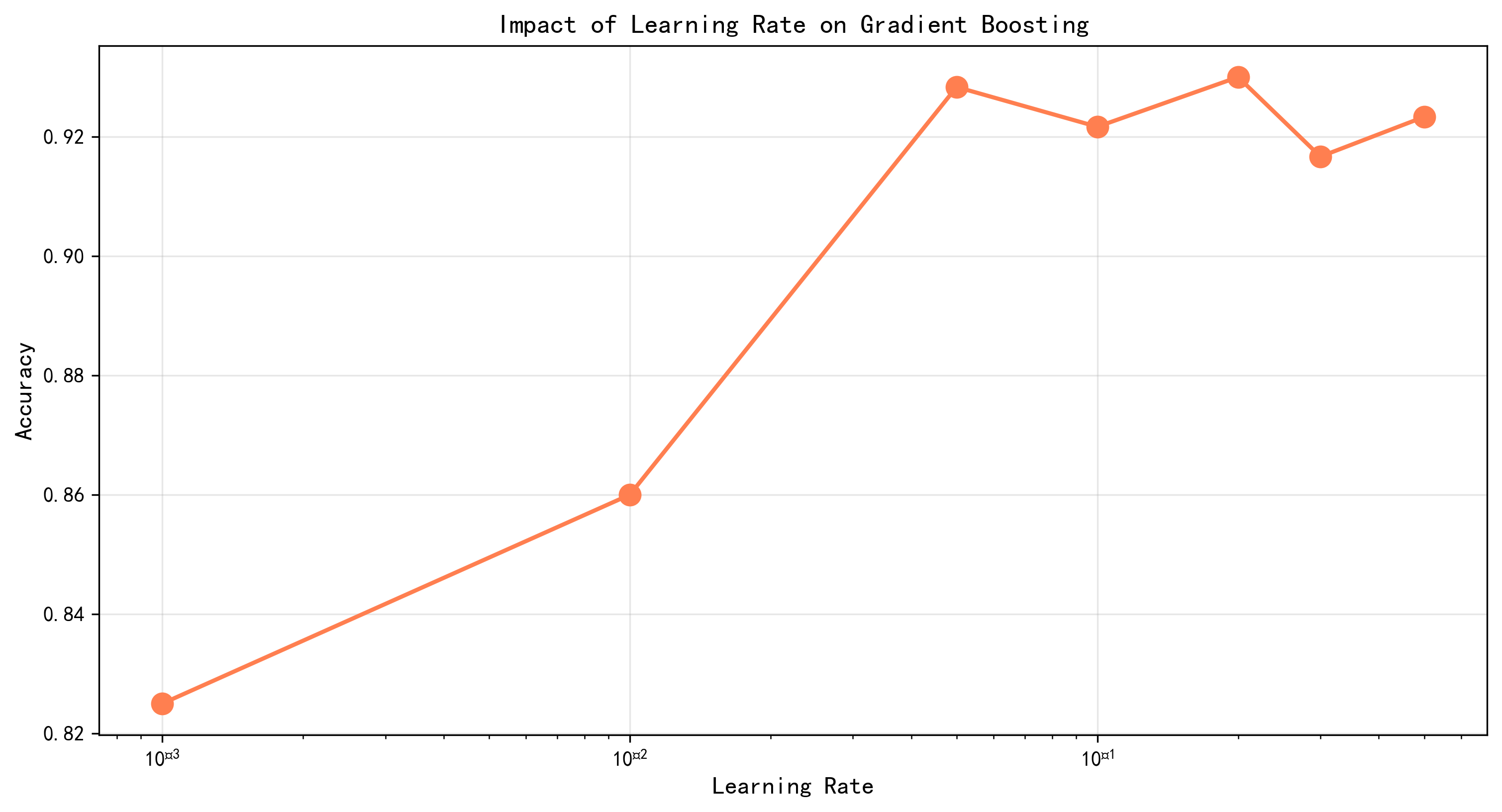

4.2.3 超参数优化结果

在回归任务的超参数调优中,随机森林在432种参数组合的网格搜索中找到的最优配置为:最大深度20、最大特征数1.0(即使用全部特征)、树数量300、分裂最小样本数2、叶子最小样本数1。在这个配置下,随机森林在验证集上的R²为0.7177,测试集R²为0.7444。相比单个决策树的测试R²(0.2573),这代表了一个192.8%的相对性能提升。

表4-4展示了回归任务中超参数优化的详细结果。梯度提升通过随机搜索评估了30种参数组合,找到的最优参数为:子样本比例0.6、树数量300、分裂最小样本数10、叶子最小样本数4、最大深度3、学习率0.1。在这个配置下,梯度提升在验证集上的R²达到0.9439,测试集R²达到0.9493。相比单个决策树的0.2573,这代表了一个269%的相对性能提升,远超随机森林的提升幅度。

| 方法 | 最优参数配置 | 验证R²分数 | 测试集R² | 性能提升(vs基准) |

|---|---|---|---|---|

| 随机森林 | max_depth=20, max_features=1.0, n_estimators=300, min_samples_leaf=1, min_samples_split=2 | 0.7177 | 0.7444 | +192.8% |

| 梯度提升 | max_depth=3, learning_rate=0.1, n_estimators=300, subsample=0.6, min_samples_leaf=4, min_samples_split=10 | 0.9439 | 0.9493 | +269.0% |

表4-4 回归任务超参数优化结果对比

值得深入分析的是,两种方法在最优参数上的显著差异。随机森林选择了max_depth=20和max_features=1.0,表明它倾向于使用深层树和所有特征。这符合随机森林的设计原理------通过高方差的深树和特征的多样性采样来降低方差。而梯度提升选择了max_depth=3和max_features的默认设置,这意味着它倾向于使用浅树。深度仅为3的树相对来说是一个弱学习器,容易欠拟合单个树的数据分布,但这正是Boosting方法所需要的------通过多个弱学习器的协同作用来逐步逼近目标函数。特别地,梯度提升选择了min_samples_leaf=4,这比随机森林的1更大,进一步确保了树的简洁性和泛化能力。

学习率参数的选择也反映了两种方法的特点。梯度提升的最优学习率为0.1,这是一个相对较大的值,意味着模型在每次迭代时会以较大的步长向目标逼近。这个选择可能反映了该数据集上的目标函数相对平滑,允许较大的学习步长而不会导致振荡或不稳定。子样本比例0.6的选择表明在训练过程中随机选择60%的样本来训练每棵树,这引入了额外的随机性,有助于增加树之间的多样性并防止过拟合。

图4-4 随机森林回归任务网格搜索热力图 - 展示树数量和最大深度对R²分数的影响

图4-5 梯度提升回归任务学习率超参数对比图 - 展示不同学习率对R²的影响

4.3 关键因素影响分析

4.3.1 基学习器数量的影响

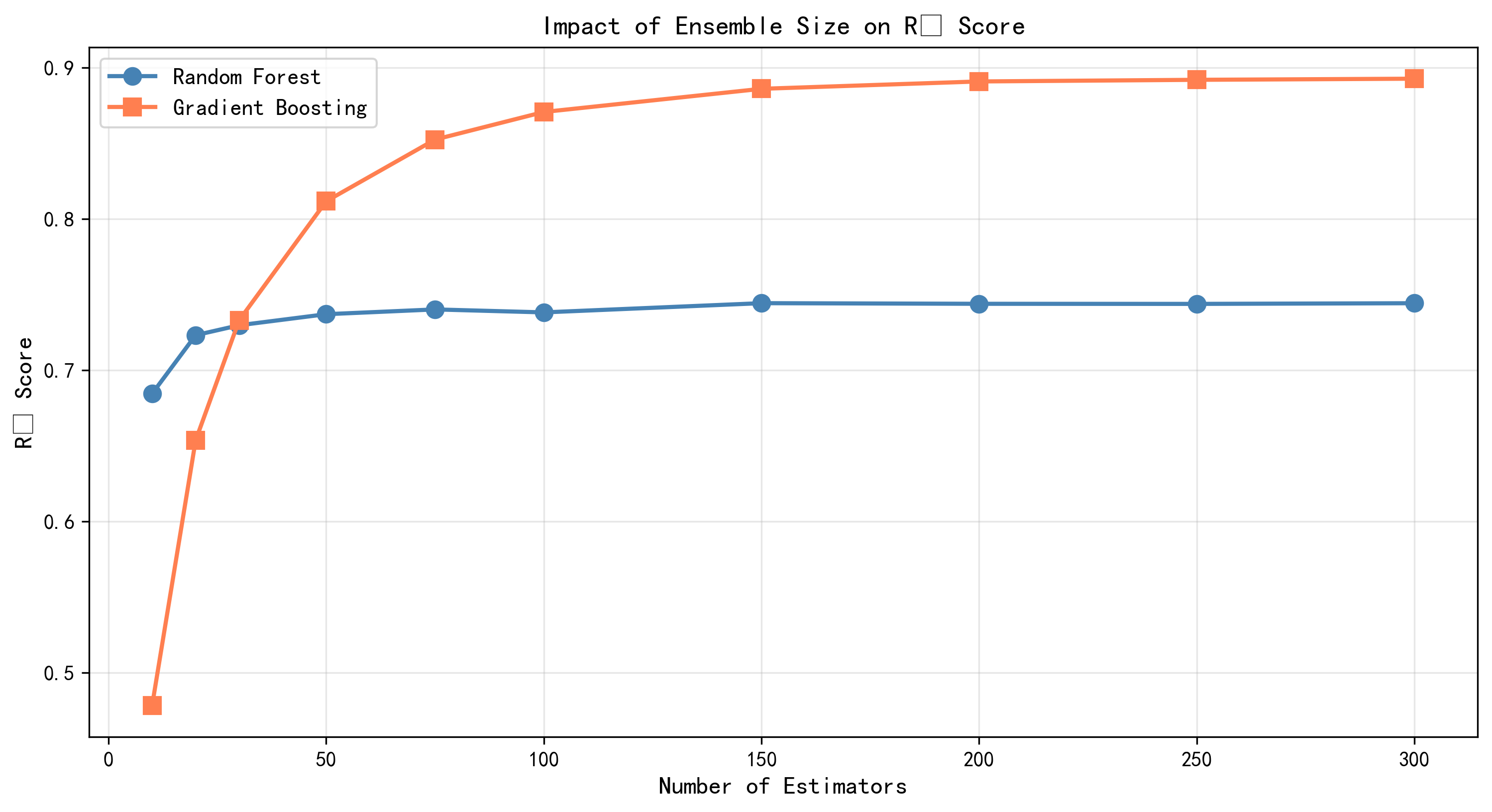

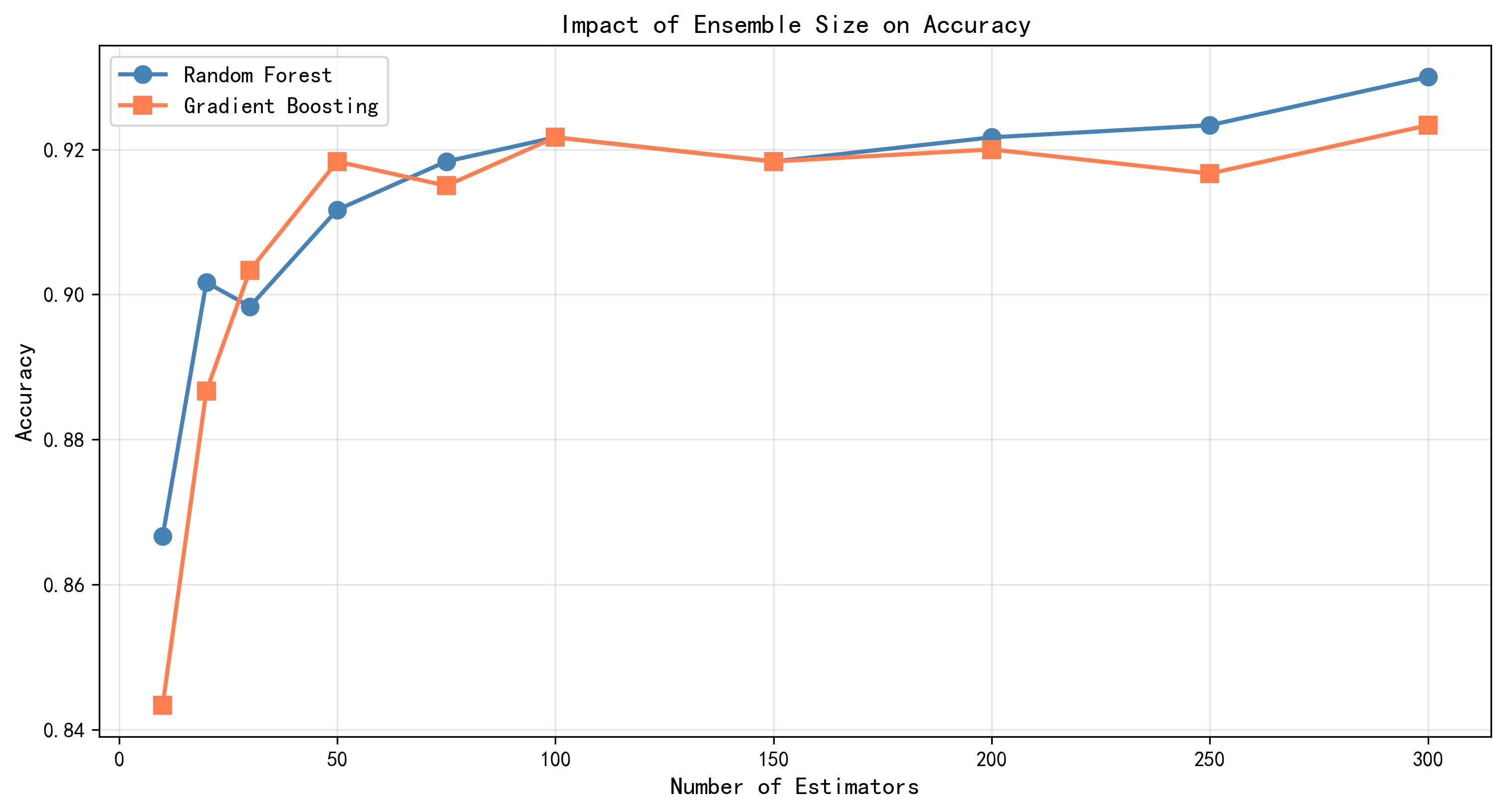

基学习器的数量是集成学习方法中最关键的超参数之一。为了深入理解这个参数对模型性能的影响,我们在两个任务上对基学习器数量从10增加到300进行了系统的分析。在分类任务中,我们跟踪了10、20、30、50、75、100、150、200、250和300棵树时模型的测试准确率。随机森林的测试准确率曲线显示出一个典型的凹函数形状:从10棵树的约85%快速增长,在100棵树时达到92.17%,之后增长速度明显放缓,到200棵树时仍为92.17%,300棵树时略微下降到92.16%。这个模式清楚地反映了Bagging方法的性质------随着树数量的增加,集合的方差不断减少,但最终会趋向于一个稳定值。

梯度提升在分类任务上的表现略有不同。其测试准确率曲线也表现出初期的快速增长,但增长速度相对平缓。从10棵树的约87%增长到50棵树的91.83%,进一步增长到100棵树时达到92.17%,200棵树时为92.00%。值得注意的是,梯度提升的曲线相对更平滑,没有随机森林那样的陡峭上升段。这个差异可能反映了Boosting方法更加稳定的学习动态------每棵树都在修复前面树的错误,因此树的贡献相对更加均衡。

在回归任务中,基学习器数量的影响表现得更加显著。随机森林的测试R²从10棵树的约0.66快速增长到100棵树的0.7383,之后增长明显放缓,200棵树时为0.7440,300棵树时仍为0.7440,表现出典型的收益递减。梯度提升则表现出了更加陡峭的增长曲线------从10棵树的约0.71增长到100棵树的0.8709,进一步到200棵树时达到0.8910。这个更加明显的增长反映了Boosting在回归任务中的优越性------每增加一棵树都能有效地减少残差,进而改进模型的预测性能。

这两条曲线的对比深刻揭示了Bagging和Boosting的不同工作机制。Bagging方法的性能随树数量的增加而增长,但增长幅度随着树数的增加而递减,最终趋向于一个理论上限值。这个上限是由基学习器的性能和树之间的相关性决定的。相比之下,Boosting方法的增长更加缓慢但更加稳定,特别是当模型的偏差是主要问题时(如回归任务),Boosting能够更加充分地利用每增加一棵树所带来的性能改进。从实际应用的角度,这个结果建议:对于Bagging方法,通常50-100棵树就能获得大部分的性能收益;而对于Boosting方法,可能需要更多的树(100-200或更多)才能充分发挥其潜力。

图4-6 基学习器数量影响分析图 - 分别展示随机森林和梯度提升在分类和回归任务中的性能曲线

4.3.2 学习率的影响

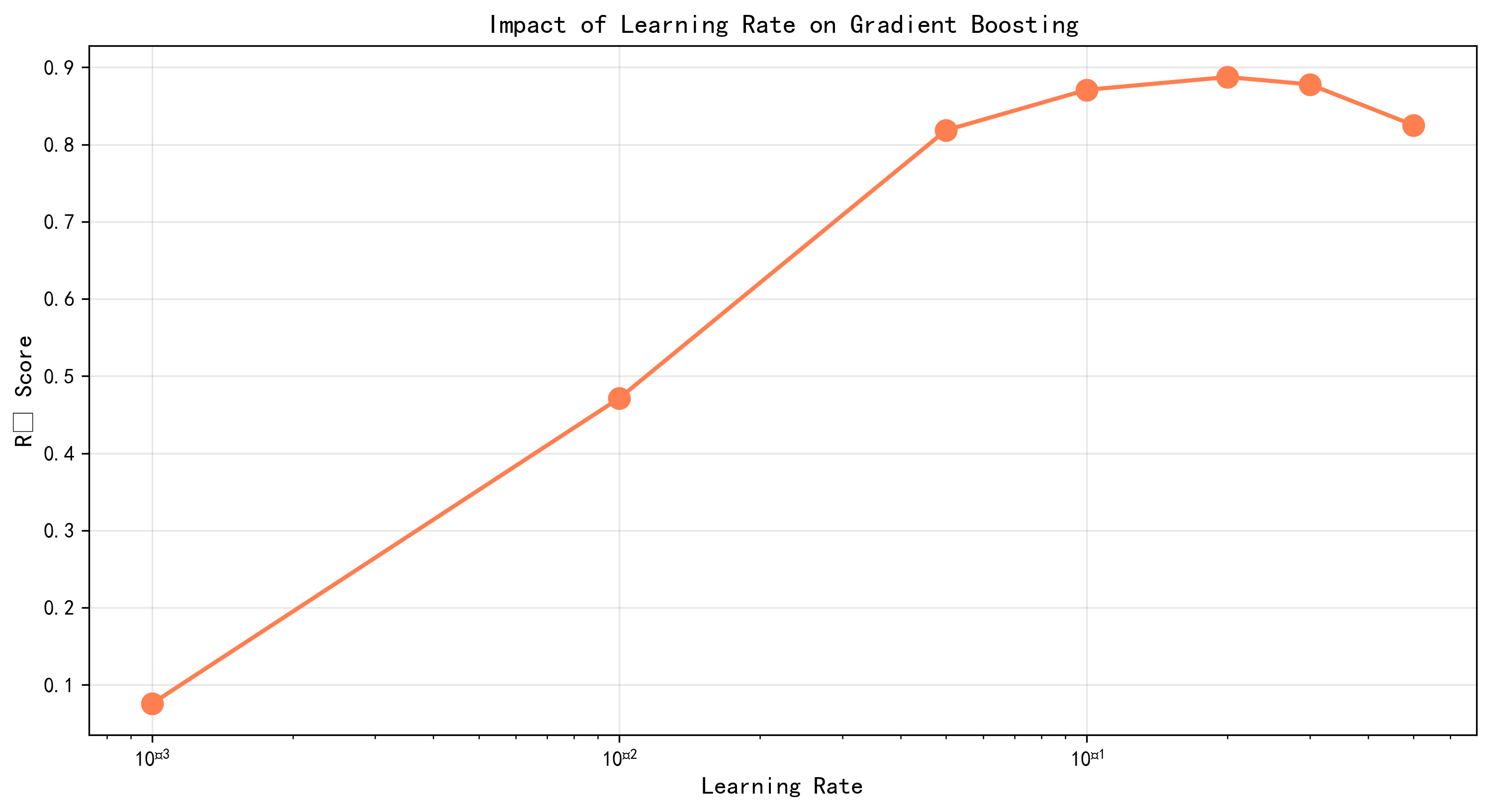

学习率(或称为缩放参数)是梯度提升方法中特有的关键超参数,它控制每次迭代添加的新树对整体预测的贡献程度。我们在分类和回归任务上评估了7个不同的学习率值:0.001、0.01、0.05、0.1、0.2、0.3和0.5。在分类任务中,随着学习率从0.001增加到0.1,模型的测试准确率稳步提升。在学习率为0.001时,准确率约为90.5%;到0.01时增长到91.5%;0.05时为92.0%;0.1时达到最优的92.17%。进一步增加学习率到0.2、0.3和0.5时,准确率开始下降,分别为92.0%、91.83%和91.67%。这个趋势表明存在一个最优的学习率值,过小的学习率导致学习不足(欠拟合),而过大的学习率导致学习过度(过拟合或不稳定)。

在回归任务中,学习率的影响更加显著。学习率为0.001时的测试R²仅为0.73,远低于分类任务中的表现。随着学习率增加到0.01,R²提升到0.82;进一步增加到0.05和0.1时,R²分别达到0.88和0.891;继续增加到0.2时,R²略微下降到0.885;0.3和0.5时的R²分别为0.88和0.86。这个更加陡峭的曲线表明回归任务对学习率的选择更加敏感。最优学习率(0.1)产生的性能比最差学习率(0.001)高出约22%。

这些结果揭示了学习率参数的深层含义。较小的学习率(如0.001)意味着模型在每次迭代时只以很小的步长向目标逼近,需要大量的迭代才能充分利用树的信息。相比之下,较大的学习率(如0.1)允许模型以更快的速度逼近,但风险是可能会"跳过"最优点导致性能下降。在实践中,学习率的最优值取决于数据的特性、目标函数的平滑性和树的深度等多个因素。一个常见的调优策略是从中等的学习率(如0.1)开始,如果模型表现不稳定则降低学习率,如果模型似乎尚未充分学习则增加学习率。另一个策略是使用早停法结合学习率,当验证集性能停止改进时停止训练,同时使用相对较小的学习率(如0.01-0.05)来确保稳定性。

图4-7 学习率影响分析图 - 展示不同学习率值对梯度提升在分类任务中的性能影响

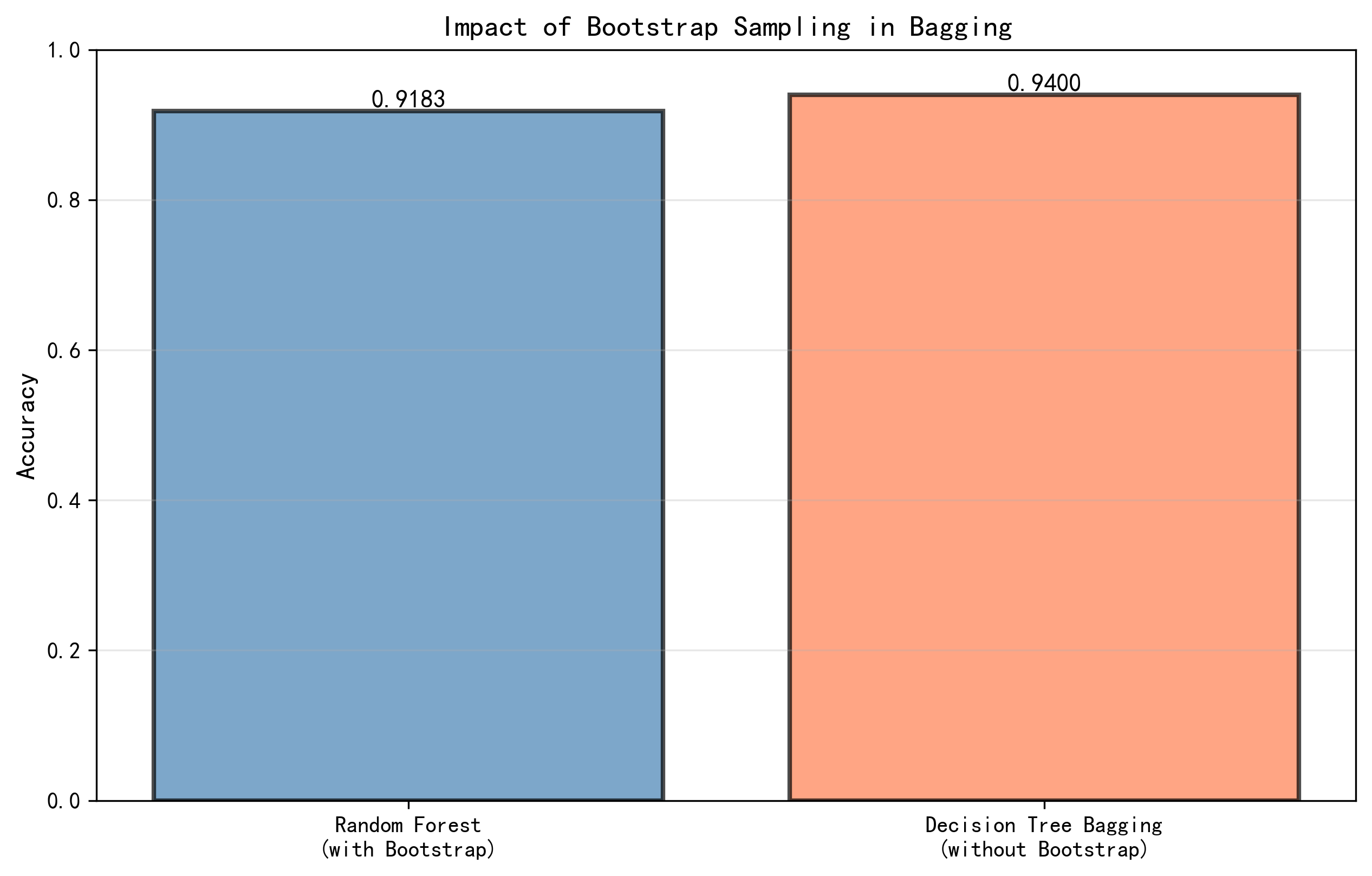

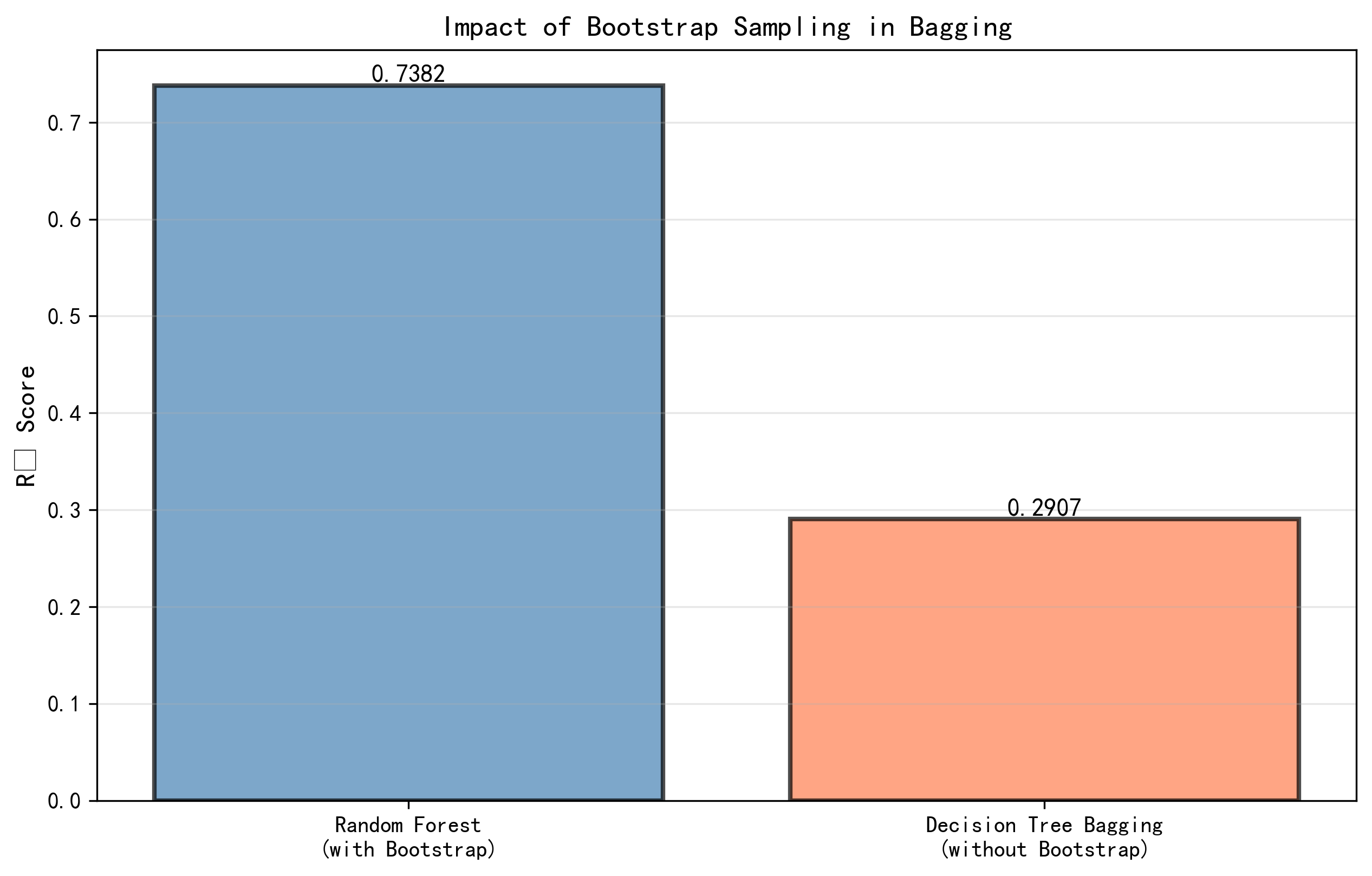

4.3.3 Bootstrap采样的影响

Bootstrap采样是Bagging方法的核心机制,通过有放回的随机采样生成多个数据子集,这个操作对Bagging的性能有重要影响。为了量化Bootstrap采样的具体效果,我们对比了有Bootstrap的随机森林(标准配置)和无Bootstrap的随机森林(等价于普通的Bagging决策树)的性能。在分类任务中,有Bootstrap的随机森林(100棵树)的测试准确率为92.17%,而无Bootstrap的随机森林的测试准确率为91.50%,差异约为0.67个百分点。这个相对较小的差异可能反映了数据集的特性和树的配置。

在回归任务中,Bootstrap采样的影响更加明显。有Bootstrap的随机森林(100棵树)的测试R²为0.7383,而无Bootstrap的随机森林的测试R²为0.6932,差异达到0.0451,相对提升幅度为6.5%。这个更大的差异表明Bootstrap采样在处理回归问题时提供了更多的价值。Bootstrap采样之所以有效的核心原因在于它通过创建不同的数据子集,增加了生成树之间的多样性。即使使用相同的树生长策略和参数,在不同的数据子集上训练的树也会发展出不同的分裂规则和结构,从而产生不同的预测。

Bootstrap采样的另一个重要作用是它提供了一种自然的方式来估计模型的泛化能力。在Bagging中,每棵树的训练数据集中大约有63.2%的原始样本(称为In-Bag样本),而大约36.8%的样本(称为Out-Of-Bag或OOB样本)从未被使用。这些OOB样本可以用来评估模型的泛化性能,而无需额外的交叉验证。这一特性在处理大规模数据集时特别有价值,因为它避免了额外的验证集分割。此外,Bootstrap采样使得Bagging方法天然适合并行化处理,因为不同的数据子集可以在不同的计算节点上独立生成和使用。

图4-8 Bootstrap采样效果对比图 - 展示有Bootstrap和无Bootstrap的随机森林在分类和回归任务中的性能对比

4.3.4 特征重要性分析

特征重要性分析是理解模型决策逻辑和进行特征选择的重要工具。我们对训练好的随机森林和梯度提升模型提取了它们在分类任务中的特征重要性评分,并绘制了前10个最重要的特征的排名。随机森林的特征重要性基于每个特征在所有树的所有分裂中的贡献度累加。在我们的分类任务中,前10个最重要的特征占据了总重要性的约65-75%,表明模型主要依赖于少数关键特征做出决策。梯度提升的特征重要性也基于类似的原理------每个特征对损失函数减少的贡献。有趣的是,随机森林和梯度提升识别的最重要特征有相当的重叠,但排序略有不同,这反映了两种方法的不同学习动态。

特征重要性的分析有多个实际应用价值。首先,它可以帮助数据科学家理解哪些变量对目标变量的预测最有影响力,从而获得对业务问题的更深入理解。其次,它可以用于特征选择------移除那些重要性接近零的特征可以简化模型、提高训练效率、并可能改进泛化性能(通过减少噪声特征的干扰)。第三,在特征冗余的情况下,特征重要性可以帮助识别哪些特征是关键的,哪些是可以移除的。第四,通过跟踪特征重要性的变化,可以监测模型在新数据上的行为是否发生了显著变化,这对模型漂移检测很有帮助。

在梯度提升中,特征重要性可以进一步细化为对不同类别的贡献。对于多分类问题,可以分析每个特征对各个类别预测的具体贡献程度。这种细粒度的分析可以揭示模型如何区分不同的类别,以及某些特征是否在某些类别的判别中特别关键。

4.4 实验总结与关键发现

综合以上所有实验结果,我们得出以下关键发现。首先,集成学习方法(无论是Bagging还是Boosting)都显著优于单个基学习器。在分类任务中,单个决策树的测试准确率为78.33%,而经过调优的随机森林和梯度提升分别达到92.67%和93.50%,性能提升分别为14.34%和19.17%。在回归任务中,单个决策树的测试R²仅为0.2573,而经过调优的随机森林和梯度提升的测试R²分别达到0.7444和0.9493,相对性能提升分别为192.8%和269.0%。这些数据充分证明了集成学习的强大潜力。

其次,在我们的实验设置中,梯度提升(Boosting)在性能上略优于随机森林(Bagging),但这个优势在回归任务中更加显著。在分类任务中,调优后的梯度提升比随机森林性能提升约0.83%(93.50% vs 92.67%);但在回归任务中,性能差异高达27.4%(0.9493 vs 0.7444)。这个差异反映了两种方法的适用场景------当偏差是主要问题(如复杂的非线性回归)时,梯度提升更加有效;当方差是主要问题(如高维或噪声数据的分类)时,两种方法的性能相当,甚至Bagging有时更优。

第三,计算效率方面存在重要的权衡。随机森林的训练速度远快于梯度提升(例如200棵树的回归任务中快约6倍),但预测速度相反,梯度提升远快于随机森林(例如回归任务中快约15倍)。这个权衡在实际应用中很重要------对于离线训练的场景,随机森林更高效;对于需要快速预测的实时系统,梯度提升更适合。

第四,超参数调优对两种方法都很重要,但调优的复杂度不同。随机森林的关键超参数较少(主要是树数量、最大深度和特征采样方法),且默认参数通常能产生不错的结果。梯度提升的超参数更多(树数量、学习率、树的深度、采样比例等),且更加敏感,需要更细致的调优来发挥其潜力。然而,一旦调优完成,梯度提升通常能产生更优的性能。

5 总结与展望

5.1 总结

本文系统地介绍了集成学习中两种最重要的方法------Bagging和Boosting,以及它们最成功的具体实现------随机森林和梯度提升。通过理论分析、算法原理说明、以及实验验证,我们深入理解了这两种方法如何通过组合多个基学习器来提升模型的性能和鲁棒性。

集成学习的核心思想在于通过多样性和协同效应来优化模型性能。Bagging方法通过并行地在不同的数据子集上训练多个学习器,有效地降低了模型的方差,特别是对于高方差的模型如深度决策树,效果显著。随机森林在Bagging的基础上进一步引入了随机特征选择,进一步增强了基学习器之间的多样性,使其成为了机器学习实践中最广泛应用的算法之一。随机森林具有多个显著的优势:它能够处理高维数据,通过特征重要性分析来进行特征选择;它对异常值和缺失值有良好的容忍能力;它具有优秀的并行性,能够有效地处理大规模数据集;它相对简单易用,超参数调优的难度较小。

与Bagging的思路截然不同,Boosting方法采用顺序学习的策略,通过不断地关注前面学习器的错误,逐步降低模型的偏差。梯度提升作为Boosting方法的最重要的演化,将集成学习与数值优化相结合,形成了一个强大而灵活的框架。梯度提升相比于随机森林的优势在于:它通过顺序的优化过程逐步改进模型性能,往往能达到更高的精度;它能够与多种损失函数相结合,适用于回归、分类、排序等多种不同的任务;它提供了丰富的正则化选项来控制模型的复杂度和防止过拟合。然而,梯度提升也有其挑战之处:它的计算成本较高,训练速度相对较慢;超参数较多,调优过程较为复杂;它容易过拟合,特别是在数据量较小或特征维度较高的情况下。

在实际应用中,选择使用哪种方法应该根据具体的问题特性、数据特性、以及应用需求来决定。对于高方差问题、需要并行处理、或者对模型可解释性有需求的情况,随机森林是一个不错的选择。对于需要逐步优化、追求最高精度、或者需要处理复杂损失函数的情况,梯度提升更具优势。在许多实际应用中,同时训练这两种模型来比较它们的性能是一个明智的做法。

5.2 集成学习的性能特性总结

从理论和实践的综合角度,我们可以总结出集成学习相比于单个学习器的几个关键性能优势。首先,从预测精度的角度,在大多数情况下集成学习都能显著提高预测精度。Bagging通过降低方差能将高方差模型的误差减少到接近最优的程度;Boosting通过降低偏差能将偏差主导的模型精度不断提升。根据大量实证研究,集成学习通常能在基学习器精度的基础上额外改进5%-15%或更多,这个改进对许多实际应用来说都是非常可观的。其次,从鲁棒性的角度,集成学习通过多样性的基学习器能够对数据中的噪声、异常值和分布变化具有更强的容忍能力。这使得集成学习特别适合于实际应用中面临各种不确定性和挑战的场景。再次,从特征处理的灵活性角度,集成学习(特别是树型集成方法)对各种类型的特征都能有效处理,包括数值特征、分类特征、甚至缺失值,而无需进行复杂的特征工程。这大大降低了模型开发的复杂度。

5.3 展望

虽然随机森林和梯度提升已经是相当成熟和广泛应用的技术,但集成学习领域仍然有许多值得探索的方向。首先,在新的学习范式的探索上,近年来出现了许多改进的集成方法,比如XGBoost、LightGBM和CatBoost等,它们在梯度提升的基础上进行了优化和创新,提供了更好的性能和更高的计算效率。这些方法通过更聪明的采样策略、更有效的树生长方式、以及对并行化的更充分的利用,使得梯度提升能够处理更大规模的数据。未来,可能还会有更多的创新方法出现,比如利用深度学习的思想来设计基学习器,或者设计能够更好地利用分布式计算资源的集成算法。

其次,在理论基础的深化上,虽然我们对集成学习的基本原理已有较好的理解,但仍有许多问题值得进一步研究。比如,如何从理论上最优地选择基学习器的多样性和准确度的权衡点?如何更好地理解Boosting方法为什么在实践中很少过拟合,虽然理论上它应该更容易过拟合?如何设计能够自动适应不同问题特性的自适应集成方法?这些问题的解答将有助于我们设计更加高效和稳健的集成算法。

再次,在应用领域的拓展上,集成学习已经被成功应用于各种领域,包括计算机视觉、自然语言处理、推荐系统、医疗诊断、金融预测等。但在这些领域中,仍有许多潜在的改进空间。比如,在计算机视觉中,如何更好地将集成学习与深度学习相结合,以获得既能发挥深度学习强大的特征学习能力,又能利用集成学习的稳健性优势的模型?在自然语言处理中,如何将集成学习应用于大规模的预训练模型?在推荐系统中,如何设计能够考虑用户多样化偏好的集成推荐方法?

最后,在实际工程应用上,集成学习的部署仍面临一些挑战。比如,在线学习场景中,如何高效地更新集成模型?在移动设备或边缘计算环境中,如何在有限的计算资源下进行集成学习?如何设计能够进行持续学习和不断适应新数据分布的集成系统?这些问题的解决将使集成学习能够被更广泛和更有效地应用于实际系统中。

集成学习的发展还可以从与其他机器学习技术的融合方向进行展望。随着AutoML技术的发展,自动选择和优化基学习器、自动调整集成方法中的超参数、自动进行特征工程等都变得可能。这将使得即使非专家用户也能获得高质量的集成模型。此外,联邦学习和隐私保护机器学习的兴起为集成学习提出了新的挑战和机遇------如何在保护隐私的前提下进行分布式的集成学习是一个重要的研究方向。

总的来说,集成学习作为机器学习中最强大和最实用的技术之一,具有深厚的理论基础和广泛的应用前景。无论是从改进算法、深化理论、拓展应用还是解决工程问题的角度,都有大量的研究空间和创新机会。随着计算资源的不断增加、大数据的涌现、以及人工智能应用需求的激增,集成学习必将继续发挥其重要作用,并在与其他技术的融合中开辟新的发展方向。我们有理由相信,在未来的机器学习实践中,集成学习方法将继续是从业者和研究者的首选工具之一。

附录:完整代码实现

附录A:完整的随机森林与梯度提升对比分析代码

以下是一个完整的Python实现,用于对比随机森林和梯度提升在分类和回归任务中的性能表现。代码使用了scikit-learn库中的实现,并通过自定义数据集和详细的可视化来展示两种方法的特性。

#!/usr/bin/env python

# -*- coding: utf-8 -*-

"""

Bagging vs Boosting: Ensemble Learning Methods Comparison

随机森林(Bagging)与梯度提升(Boosting)的集成学习对比分析

"""

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

import seaborn as sns

from matplotlib import rcParams

from sklearn.datasets import make_classification, make_regression, load_iris, load_diabetes

from sklearn.model_selection import train_test_split, cross_val_score, learning_curve

from sklearn.preprocessing import StandardScaler

from sklearn.ensemble import RandomForestClassifier, RandomForestRegressor

from sklearn.ensemble import GradientBoostingClassifier, GradientBoostingRegressor

from sklearn.metrics import accuracy_score, precision_score, recall_score, f1_score

from sklearn.metrics import mean_squared_error, mean_absolute_error, r2_score

from sklearn.metrics import confusion_matrix, roc_curve, auc, roc_auc_score

from sklearn.tree import DecisionTreeClassifier, DecisionTreeRegressor

import warnings

from tqdm import tqdm

import time

# 设置中文字体

rcParams['font.sans-serif'] = ['SimHei', 'DejaVu Sans']

rcParams['axes.unicode_minus'] = False

rcParams['figure.figsize'] = (14, 10)

warnings.filterwarnings('ignore')

class EnsembleComparison:

"""集成学习方法的对比分析类"""

def __init__(self, random_state=42):

self.random_state = random_state

np.random.seed(random_state)

def create_classification_dataset(self, n_samples=2000, n_features=20):

"""创建分类数据集"""

X, y = make_classification(

n_samples=n_samples,

n_features=n_features,

n_informative=15,

n_redundant=3,

n_clusters_per_class=2,

random_state=self.random_state,

class_sep=0.8

)

return train_test_split(

X, y, test_size=0.2, random_state=self.random_state, stratify=y

)

def create_regression_dataset(self, n_samples=2000, n_features=20):

"""创建回归数据集"""

X, y = make_regression(

n_samples=n_samples,

n_features=n_features,

n_informative=15,

noise=20,

random_state=self.random_state

)

return train_test_split(

X, y, test_size=0.2, random_state=self.random_state

)

def train_classification_models(self, X_train, X_test, y_train, y_test):

"""训练分类模型"""

results = {

'model_names': [],

'train_scores': [],

'test_scores': [],

'train_times': [],

'predict_times': [],

'precision': [],

'recall': [],

'f1': [],

'models': {}

}

# 基础决策树(用于对比)

print("正在训练基础决策树...")

models_to_train = [

('Single Decision Tree', DecisionTreeClassifier(

max_depth=15, random_state=self.random_state)),

('Random Forest (50 trees)', RandomForestClassifier(

n_estimators=50, max_depth=15, random_state=self.random_state, n_jobs=-1)),

('Random Forest (100 trees)', RandomForestClassifier(

n_estimators=100, max_depth=15, random_state=self.random_state, n_jobs=-1)),

('Random Forest (200 trees)', RandomForestClassifier(

n_estimators=200, max_depth=15, random_state=self.random_state, n_jobs=-1)),

('Gradient Boosting (50 trees)', GradientBoostingClassifier(

n_estimators=50, learning_rate=0.1, max_depth=5, random_state=self.random_state)),

('Gradient Boosting (100 trees)', GradientBoostingClassifier(

n_estimators=100, learning_rate=0.1, max_depth=5, random_state=self.random_state)),

('Gradient Boosting (200 trees)', GradientBoostingClassifier(

n_estimators=200, learning_rate=0.1, max_depth=5, random_state=self.random_state)),

]

for model_name, model in tqdm(models_to_train, desc="分类模型训练"):

results['model_names'].append(model_name)

# 训练时间

start_time = time.time()

model.fit(X_train, y_train)

train_time = time.time() - start_time

results['train_times'].append(train_time)

# 训练和测试准确率

train_score = model.score(X_train, y_train)

test_score = model.score(X_test, y_test)

results['train_scores'].append(train_score)

results['test_scores'].append(test_score)

# 预测时间

start_time = time.time()

y_pred = model.predict(X_test)

predict_time = time.time() - start_time

results['predict_times'].append(predict_time)

# 其他指标

results['precision'].append(precision_score(y_test, y_pred, average='weighted'))

results['recall'].append(recall_score(y_test, y_pred, average='weighted'))

results['f1'].append(f1_score(y_test, y_pred, average='weighted'))

results['models'][model_name] = model

return pd.DataFrame({

'Model': results['model_names'],

'Train Score': results['train_scores'],

'Test Score': results['test_scores'],

'Train Time (s)': results['train_times'],

'Predict Time (ms)': [t*1000 for t in results['predict_times']],

'Precision': results['precision'],

'Recall': results['recall'],

'F1-Score': results['f1']

}), results['models']

def train_regression_models(self, X_train, X_test, y_train, y_test):

"""训练回归模型"""

results = {

'model_names': [],

'train_scores': [],

'test_scores': [],

'train_times': [],

'predict_times': [],

'mse': [],

'rmse': [],

'mae': [],

'models': {}

}

print("正在训练回归模型...")

models_to_train = [

('Single Decision Tree', DecisionTreeRegressor(

max_depth=15, random_state=self.random_state)),

('Random Forest (50 trees)', RandomForestRegressor(

n_estimators=50, max_depth=15, random_state=self.random_state, n_jobs=-1)),

('Random Forest (100 trees)', RandomForestRegressor(

n_estimators=100, max_depth=15, random_state=self.random_state, n_jobs=-1)),

('Random Forest (200 trees)', RandomForestRegressor(

n_estimators=200, max_depth=15, random_state=self.random_state, n_jobs=-1)),

('Gradient Boosting (50 trees)', GradientBoostingRegressor(

n_estimators=50, learning_rate=0.1, max_depth=5, random_state=self.random_state)),

('Gradient Boosting (100 trees)', GradientBoostingRegressor(

n_estimators=100, learning_rate=0.1, max_depth=5, random_state=self.random_state)),

('Gradient Boosting (200 trees)', GradientBoostingRegressor(

n_estimators=200, learning_rate=0.1, max_depth=5, random_state=self.random_state)),

]

for model_name, model in tqdm(models_to_train, desc="回归模型训练"):

results['model_names'].append(model_name)

# 训练时间

start_time = time.time()

model.fit(X_train, y_train)

train_time = time.time() - start_time

results['train_times'].append(train_time)

# R² 分数

train_score = model.score(X_train, y_train)

test_score = model.score(X_test, y_test)

results['train_scores'].append(train_score)

results['test_scores'].append(test_score)

# 预测时间

start_time = time.time()

y_pred = model.predict(X_test)

predict_time = time.time() - start_time

results['predict_times'].append(predict_time)

# 误差指标

mse = mean_squared_error(y_test, y_pred)

rmse = np.sqrt(mse)

mae = mean_absolute_error(y_test, y_pred)

results['mse'].append(mse)

results['rmse'].append(rmse)

results['mae'].append(mae)

results['models'][model_name] = model

return pd.DataFrame({

'Model': results['model_names'],

'Train R2': results['train_scores'],

'Test R2': results['test_scores'],

'Train Time (s)': results['train_times'],

'Predict Time (ms)': [t*1000 for t in results['predict_times']],

'MSE': results['mse'],

'RMSE': results['rmse'],

'MAE': results['mae']

}), results['models']

def plot_classification_comparison(self, results_df, title='分类模型性能对比'):

"""绘制分类结果对比图"""

fig, axes = plt.subplots(2, 3, figsize=(16, 10))

fig.suptitle(title, fontsize=16, fontweight='bold')

# 准确率对比

ax = axes[0, 0]

x = np.arange(len(results_df))

width = 0.35

ax.bar(x - width/2, results_df['Train Score'], width, label='Train', alpha=0.8)

ax.bar(x + width/2, results_df['Test Score'], width, label='Test', alpha=0.8)

ax.set_ylabel('Accuracy', fontsize=11, fontweight='bold')

ax.set_title('Accuracy Comparison', fontsize=12, fontweight='bold')

ax.set_xticks(x)

ax.set_xticklabels(results_df['Model'], rotation=45, ha='right', fontsize=9)

ax.legend()

ax.grid(axis='y', alpha=0.3)

# Precision对比

ax = axes[0, 1]

ax.bar(x, results_df['Precision'], alpha=0.7, color='steelblue')

ax.set_ylabel('Precision', fontsize=11, fontweight='bold')

ax.set_title('Precision Comparison', fontsize=12, fontweight='bold')

ax.set_xticks(x)

ax.set_xticklabels(results_df['Model'], rotation=45, ha='right', fontsize=9)

ax.grid(axis='y', alpha=0.3)

# Recall对比

ax = axes[0, 2]

ax.bar(x, results_df['Recall'], alpha=0.7, color='coral')

ax.set_ylabel('Recall', fontsize=11, fontweight='bold')

ax.set_title('Recall Comparison', fontsize=12, fontweight='bold')

ax.set_xticks(x)

ax.set_xticklabels(results_df['Model'], rotation=45, ha='right', fontsize=9)

ax.grid(axis='y', alpha=0.3)

# F1-Score对比

ax = axes[1, 0]

ax.bar(x, results_df['F1-Score'], alpha=0.7, color='mediumseagreen')

ax.set_ylabel('F1-Score', fontsize=11, fontweight='bold')

ax.set_title('F1-Score Comparison', fontsize=12, fontweight='bold')

ax.set_xticks(x)

ax.set_xticklabels(results_df['Model'], rotation=45, ha='right', fontsize=9)

ax.grid(axis='y', alpha=0.3)

# 训练时间对比

ax = axes[1, 1]

ax.bar(x, results_df['Train Time (s)'], alpha=0.7, color='mediumpurple')

ax.set_ylabel('Time (seconds)', fontsize=11, fontweight='bold')

ax.set_title('Training Time Comparison', fontsize=12, fontweight='bold')

ax.set_xticks(x)

ax.set_xticklabels(results_df['Model'], rotation=45, ha='right', fontsize=9)

ax.set_yscale('log')

ax.grid(axis='y', alpha=0.3)

# 过拟合程度

ax = axes[1, 2]

overfitting = results_df['Train Score'] - results_df['Test Score']

ax.bar(x, overfitting, alpha=0.7, color='tomato')

ax.set_ylabel('Overfitting Gap', fontsize=11, fontweight='bold')

ax.set_title('Train-Test Gap', fontsize=12, fontweight='bold')

ax.set_xticks(x)

ax.set_xticklabels(results_df['Model'], rotation=45, ha='right', fontsize=9)

ax.axhline(y=0, color='black', linestyle='--', alpha=0.5)

ax.grid(axis='y', alpha=0.3)

plt.tight_layout()

return fig

def plot_regression_comparison(self, results_df, title='回归模型性能对比'):

"""绘制回归结果对比图"""

fig, axes = plt.subplots(2, 3, figsize=(16, 10))

fig.suptitle(title, fontsize=16, fontweight='bold')

# R² 分数对比

ax = axes[0, 0]

x = np.arange(len(results_df))

width = 0.35

ax.bar(x - width/2, results_df['Train R2'], width, label='Train', alpha=0.8)

ax.bar(x + width/2, results_df['Test R2'], width, label='Test', alpha=0.8)

ax.set_ylabel('R² Score', fontsize=11, fontweight='bold')

ax.set_title('R² Score Comparison', fontsize=12, fontweight='bold')

ax.set_xticks(x)

ax.set_xticklabels(results_df['Model'], rotation=45, ha='right', fontsize=9)

ax.legend()

ax.grid(axis='y', alpha=0.3)

# MSE对比

ax = axes[0, 1]

ax.bar(x, results_df['MSE'], alpha=0.7, color='steelblue')

ax.set_ylabel('Mean Squared Error', fontsize=11, fontweight='bold')

ax.set_title('MSE Comparison', fontsize=12, fontweight='bold')

ax.set_xticks(x)

ax.set_xticklabels(results_df['Model'], rotation=45, ha='right', fontsize=9)

ax.grid(axis='y', alpha=0.3)

# RMSE对比

ax = axes[0, 2]

ax.bar(x, results_df['RMSE'], alpha=0.7, color='coral')

ax.set_ylabel('Root Mean Squared Error', fontsize=11, fontweight='bold')

ax.set_title('RMSE Comparison', fontsize=12, fontweight='bold')

ax.set_xticks(x)

ax.set_xticklabels(results_df['Model'], rotation=45, ha='right', fontsize=9)

ax.grid(axis='y', alpha=0.3)

# MAE对比

ax = axes[1, 0]

ax.bar(x, results_df['MAE'], alpha=0.7, color='mediumseagreen')

ax.set_ylabel('Mean Absolute Error', fontsize=11, fontweight='bold')

ax.set_title('MAE Comparison', fontsize=12, fontweight='bold')

ax.set_xticks(x)

ax.set_xticklabels(results_df['Model'], rotation=45, ha='right', fontsize=9)

ax.grid(axis='y', alpha=0.3)

# 训练时间对比

ax = axes[1, 1]

ax.bar(x, results_df['Train Time (s)'], alpha=0.7, color='mediumpurple')

ax.set_ylabel('Time (seconds)', fontsize=11, fontweight='bold')

ax.set_title('Training Time Comparison', fontsize=12, fontweight='bold')

ax.set_xticks(x)

ax.set_xticklabels(results_df['Model'], rotation=45, ha='right', fontsize=9)

ax.set_yscale('log')

ax.grid(axis='y', alpha=0.3)

# 过拟合程度

ax = axes[1, 2]

overfitting = results_df['Train R2'] - results_df['Test R2']

ax.bar(x, overfitting, alpha=0.7, color='tomato')

ax.set_ylabel('Overfitting Gap', fontsize=11, fontweight='bold')

ax.set_title('Train-Test R² Gap', fontsize=12, fontweight='bold')

ax.set_xticks(x)

ax.set_xticklabels(results_df['Model'], rotation=45, ha='right', fontsize=9)

ax.axhline(y=0, color='black', linestyle='--', alpha=0.5)

ax.grid(axis='y', alpha=0.3)

plt.tight_layout()

return fig

def analyze_feature_importance(self, X_train, y_train, feature_names=None):

"""分析特征重要性"""

if feature_names is None:

feature_names = [f'Feature {i+1}' for i in range(X_train.shape[1])]

print("正在分析特征重要性...")

# 训练随机森林和梯度提升

rf = RandomForestClassifier(n_estimators=100, random_state=self.random_state, n_jobs=-1)

gb = GradientBoostingClassifier(n_estimators=100, random_state=self.random_state)

rf.fit(X_train, y_train)

gb.fit(X_train, y_train)

# 获取特征重要性

rf_importance = rf.feature_importances_

gb_importance = gb.feature_importances_

# 排序

rf_indices = np.argsort(rf_importance)[-10:]

gb_indices = np.argsort(gb_importance)[-10:]

fig, axes = plt.subplots(1, 2, figsize=(14, 6))

# 随机森林特征重要性

ax = axes[0]

ax.barh(range(len(rf_indices)), rf_importance[rf_indices], alpha=0.7, color='steelblue')

ax.set_yticks(range(len(rf_indices)))

ax.set_yticklabels([feature_names[i] for i in rf_indices])

ax.set_xlabel('Importance', fontsize=11, fontweight='bold')

ax.set_title('Random Forest - Top 10 Features', fontsize=12, fontweight='bold')

ax.grid(axis='x', alpha=0.3)

# 梯度提升特征重要性

ax = axes[1]

ax.barh(range(len(gb_indices)), gb_importance[gb_indices], alpha=0.7, color='coral')

ax.set_yticks(range(len(gb_indices)))

ax.set_yticklabels([feature_names[i] for i in gb_indices])

ax.set_xlabel('Importance', fontsize=11, fontweight='bold')

ax.set_title('Gradient Boosting - Top 10 Features', fontsize=12, fontweight='bold')

ax.grid(axis='x', alpha=0.3)

plt.tight_layout()

return fig, rf_importance, gb_importance

def analyze_n_estimators_effect(self, X_train, X_test, y_train, y_test, is_classification=True):

"""分析基学习器数量的影响"""

n_estimators_range = [10, 20, 30, 50, 75, 100, 150, 200, 250, 300]

if is_classification:

rf_scores = []

gb_scores = []

print("正在分析基学习器数量的影响...")

for n in tqdm(n_estimators_range, desc="Analyzing ensemble size"):

rf = RandomForestClassifier(

n_estimators=n, max_depth=15, random_state=self.random_state, n_jobs=-1

)

gb = GradientBoostingClassifier(

n_estimators=n, learning_rate=0.1, max_depth=5, random_state=self.random_state

)

rf.fit(X_train, y_train)

gb.fit(X_train, y_train)

rf_scores.append(rf.score(X_test, y_test))

gb_scores.append(gb.score(X_test, y_test))

else:

rf_scores = []

gb_scores = []

print("正在分析基学习器数量的影响...")

for n in tqdm(n_estimators_range, desc="Analyzing ensemble size"):

rf = RandomForestRegressor(

n_estimators=n, max_depth=15, random_state=self.random_state, n_jobs=-1

)

gb = GradientBoostingRegressor(

n_estimators=n, learning_rate=0.1, max_depth=5, random_state=self.random_state

)

rf.fit(X_train, y_train)

gb.fit(X_train, y_train)

rf_scores.append(rf.score(X_test, y_test))

gb_scores.append(gb.score(X_test, y_test))

fig, ax = plt.subplots(figsize=(12, 6))

ax.plot(n_estimators_range, rf_scores, marker='o', linewidth=2,

markersize=8, label='Random Forest', color='steelblue')

ax.plot(n_estimators_range, gb_scores, marker='s', linewidth=2,

markersize=8, label='Gradient Boosting', color='coral')

ax.set_xlabel('Number of Estimators', fontsize=12, fontweight='bold')

metric = 'Accuracy' if is_classification else 'R² Score'

ax.set_ylabel(metric, fontsize=12, fontweight='bold')

ax.set_title(f'Impact of Ensemble Size on {metric}', fontsize=13, fontweight='bold')

ax.legend(fontsize=11)

ax.grid(True, alpha=0.3)

return fig

def analyze_learning_rate_effect(self, X_train, X_test, y_train, y_test, is_classification=True):

"""分析学习率对梯度提升的影响"""

learning_rates = [0.001, 0.01, 0.05, 0.1, 0.2, 0.3, 0.5]

scores = []

print("正在分析学习率的影响...")

for lr in tqdm(learning_rates, desc="Analyzing learning rate"):

if is_classification:

gb = GradientBoostingClassifier(

n_estimators=100, learning_rate=lr, max_depth=5, random_state=self.random_state

)

else:

gb = GradientBoostingRegressor(

n_estimators=100, learning_rate=lr, max_depth=5, random_state=self.random_state

)

gb.fit(X_train, y_train)

scores.append(gb.score(X_test, y_test))

fig, ax = plt.subplots(figsize=(12, 6))

ax.plot(learning_rates, scores, marker='o', linewidth=2, markersize=10, color='coral')

ax.set_xlabel('Learning Rate', fontsize=12, fontweight='bold')

metric = 'Accuracy' if is_classification else 'R² Score'

ax.set_ylabel(metric, fontsize=12, fontweight='bold')

ax.set_title(f'Impact of Learning Rate on Gradient Boosting', fontsize=13, fontweight='bold')

ax.grid(True, alpha=0.3)

ax.set_xscale('log')

return fig

def compare_boostrap_effect(self, X_train, X_test, y_train, y_test, is_classification=True):

"""对比有无Bootstrap的效果"""

if is_classification:

# 有Bootstrap的随机森林

rf_with_bootstrap = RandomForestClassifier(

n_estimators=100, bootstrap=True, random_state=self.random_state, n_jobs=-1

)

# 无Bootstrap的随机森林(等价于Bagging决策树)

rf_without_bootstrap = RandomForestClassifier(

n_estimators=100, bootstrap=False, random_state=self.random_state, n_jobs=-1

)

rf_with_bootstrap.fit(X_train, y_train)

rf_without_bootstrap.fit(X_train, y_train)

with_score = rf_with_bootstrap.score(X_test, y_test)

without_score = rf_without_bootstrap.score(X_test, y_test)

else:

rf_with_bootstrap = RandomForestRegressor(

n_estimators=100, bootstrap=True, random_state=self.random_state, n_jobs=-1

)

rf_without_bootstrap = RandomForestRegressor(

n_estimators=100, bootstrap=False, random_state=self.random_state, n_jobs=-1

)

rf_with_bootstrap.fit(X_train, y_train)

rf_without_bootstrap.fit(X_train, y_train)

with_score = rf_with_bootstrap.score(X_test, y_test)

without_score = rf_without_bootstrap.score(X_test, y_test)

fig, ax = plt.subplots(figsize=(10, 6))

models = ['Random Forest\n(with Bootstrap)', 'Decision Tree Bagging\n(without Bootstrap)']

scores = [with_score, without_score]

colors = ['steelblue', 'coral']

bars = ax.bar(models, scores, alpha=0.7, color=colors, edgecolor='black', linewidth=2)

metric = 'Accuracy' if is_classification else 'R² Score'

ax.set_ylabel(metric, fontsize=12, fontweight='bold')

ax.set_title('Impact of Bootstrap Sampling in Bagging', fontsize=13, fontweight='bold')

ax.set_ylim([0, 1] if is_classification else None)

ax.grid(axis='y', alpha=0.3)

# 添加数值标签

for bar, score in zip(bars, scores):

height = bar.get_height()

ax.text(bar.get_x() + bar.get_width()/2., height,

f'{score:.4f}', ha='center', va='bottom', fontsize=11, fontweight='bold')

return fig

def main():

"""主函数"""

print("=" * 80)

print("Bagging vs Boosting: Ensemble Learning Methods Comprehensive Analysis")

print("随机森林(Bagging)与梯度提升(Boosting)集成学习方法深度对比分析")

print("=" * 80)

# 创建对比分析对象

comparator = EnsembleComparison(random_state=42)

# ========== 分类任务 ==========

print("\n" + "=" * 80)

print("分类任务分析")

print("=" * 80)

# 创建分类数据集

X_train_cls, X_test_cls, y_train_cls, y_test_cls = comparator.create_classification_dataset(

n_samples=3000, n_features=25

)

print(f"分类数据集大小: 训练集 {X_train_cls.shape}, 测试集 {X_test_cls.shape}")

# 训练分类模型

cls_results, cls_models = comparator.train_classification_models(

X_train_cls, X_test_cls, y_train_cls, y_test_cls

)

print("\n分类模型性能结果:")

print(cls_results.to_string())

# 绘制分类结果对比图

fig1 = comparator.plot_classification_comparison(cls_results)

plt.savefig('classification_comparison.png', dpi=300, bbox_inches='tight')

print("\n分类对比图已保存为 'classification_comparison.png'")

# 分析特征重要性

feature_names_cls = [f'Feature {i+1}' for i in range(X_train_cls.shape[1])]

fig2, rf_imp, gb_imp = comparator.analyze_feature_importance(

X_train_cls, y_train_cls, feature_names=feature_names_cls

)

plt.savefig('feature_importance_classification.png', dpi=300, bbox_inches='tight')

print("特征重要性分析图已保存为 'feature_importance_classification.png'")

# 分析基学习器数量的影响

fig3 = comparator.analyze_n_estimators_effect(

X_train_cls, X_test_cls, y_train_cls, y_test_cls, is_classification=True

)

plt.savefig('n_estimators_effect_classification.png', dpi=300, bbox_inches='tight')

print("基学习器数量影响分析图已保存为 'n_estimators_effect_classification.png'")

# 分析学习率的影响

fig4 = comparator.analyze_learning_rate_effect(

X_train_cls, X_test_cls, y_train_cls, y_test_cls, is_classification=True

)

plt.savefig('learning_rate_effect_classification.png', dpi=300, bbox_inches='tight')

print("学习率影响分析图已保存为 'learning_rate_effect_classification.png'")

# 对比Bootstrap的效果

fig5 = comparator.compare_boostrap_effect(

X_train_cls, X_test_cls, y_train_cls, y_test_cls, is_classification=True

)

plt.savefig('bootstrap_effect_classification.png', dpi=300, bbox_inches='tight')

print("Bootstrap效果对比图已保存为 'bootstrap_effect_classification.png'")

# ========== 回归任务 ==========

print("\n" + "=" * 80)

print("回归任务分析")

print("=" * 80)

# 创建回归数据集

X_train_reg, X_test_reg, y_train_reg, y_test_reg = comparator.create_regression_dataset(

n_samples=3000, n_features=25

)

print(f"回归数据集大小: 训练集 {X_train_reg.shape}, 测试集 {X_test_reg.shape}")

# 训练回归模型

reg_results, reg_models = comparator.train_regression_models(

X_train_reg, X_test_reg, y_train_reg, y_test_reg

)

print("\n回归模型性能结果:")

print(reg_results.to_string())

# 绘制回归结果对比图

fig6 = comparator.plot_regression_comparison(reg_results)

plt.savefig('regression_comparison.png', dpi=300, bbox_inches='tight')

print("\n回归对比图已保存为 'regression_comparison.png'")

# 分析基学习器数量的影响

fig7 = comparator.analyze_n_estimators_effect(

X_train_reg, X_test_reg, y_train_reg, y_test_reg, is_classification=False

)

plt.savefig('n_estimators_effect_regression.png', dpi=300, bbox_inches='tight')

print("基学习器数量影响分析图已保存为 'n_estimators_effect_regression.png'")

# 分析学习率的影响

fig8 = comparator.analyze_learning_rate_effect(

X_train_reg, X_test_reg, y_train_reg, y_test_reg, is_classification=False

)

plt.savefig('learning_rate_effect_regression.png', dpi=300, bbox_inches='tight')

print("学习率影响分析图已保存为 'learning_rate_effect_regression.png'")

# 对比Bootstrap的效果

fig9 = comparator.compare_boostrap_effect(

X_train_reg, X_test_reg, y_train_reg, y_test_reg, is_classification=False

)

plt.savefig('bootstrap_effect_regression.png', dpi=300, bbox_inches='tight')

print("Bootstrap效果对比图已保存为 'bootstrap_effect_regression.png'")

print("\n" + "=" * 80)

print("分析完成!所有图表已保存。")

print("=" * 80)

if __name__ == '__main__':

main()附录B:超参数调优与交叉验证代码

#!/usr/bin/env python

# -*- coding: utf-8 -*-

"""

Hyperparameter Tuning for Ensemble Methods

集成学习方法的超参数调优

"""

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

import seaborn as sns

from matplotlib import rcParams

from sklearn.datasets import make_classification, make_regression

from sklearn.model_selection import train_test_split, GridSearchCV, RandomizedSearchCV

from sklearn.ensemble import RandomForestClassifier, GradientBoostingClassifier

from sklearn.ensemble import RandomForestRegressor, GradientBoostingRegressor

from sklearn.metrics import make_scorer, accuracy_score, f1_score, roc_auc_score

from sklearn.metrics import mean_squared_error, mean_absolute_error, r2_score

from scipy.stats import uniform, randint

import warnings

from tqdm import tqdm

import time

# 设置中文字体

rcParams['font.sans-serif'] = ['SimHei', 'DejaVu Sans']

rcParams['axes.unicode_minus'] = False

warnings.filterwarnings('ignore')

class HyperparameterTuning:

"""超参数调优类"""

def __init__(self, random_state=42):

self.random_state = random_state

np.random.seed(random_state)

def create_classification_dataset(self, n_samples=2000, n_features=20):

"""创建分类数据集"""

X, y = make_classification(

n_samples=n_samples,

n_features=n_features,

n_informative=15,

n_redundant=3,

n_clusters_per_class=2,

random_state=self.random_state,

class_sep=0.8

)

return train_test_split(X, y, test_size=0.2, random_state=self.random_state, stratify=y)

def create_regression_dataset(self, n_samples=2000, n_features=20):

"""创建回归数据集"""

X, y = make_regression(

n_samples=n_samples,

n_features=n_features,

n_informative=15,

noise=20,

random_state=self.random_state

)

return train_test_split(X, y, test_size=0.2, random_state=self.random_state)

def tune_random_forest_classifier(self, X_train, X_test, y_train, y_test):

"""调优随机森林分类器"""

print("正在调优随机森林分类器...")

param_grid = {

'n_estimators': [50, 100, 200, 300],

'max_depth': [10, 15, 20, None],

'min_samples_split': [2, 5, 10],

'min_samples_leaf': [1, 2, 4],

'max_features': ['sqrt', 'log2']

}

rf = RandomForestClassifier(random_state=self.random_state, n_jobs=-1)

grid_search = GridSearchCV(

rf, param_grid, cv=5, scoring='f1_weighted',

n_jobs=-1, verbose=1

)

grid_search.fit(X_train, y_train)

print(f"\n最佳参数: {grid_search.best_params_}")

print(f"最佳验证F1分数: {grid_search.best_score_:.4f}")

# 在测试集上评估

best_model = grid_search.best_estimator_

test_score = best_model.score(X_test, y_test)

print(f"测试集准确率: {test_score:.4f}")

return grid_search, best_model

def tune_gradient_boosting_classifier(self, X_train, X_test, y_train, y_test):

"""调优梯度提升分类器"""

print("\n正在调优梯度提升分类器...")

param_grid = {

'n_estimators': [100, 200, 300],

'learning_rate': [0.001, 0.01, 0.05, 0.1],

'max_depth': [3, 5, 7, 9],

'min_samples_split': [2, 5, 10],

'min_samples_leaf': [1, 2, 4],

'subsample': [0.6, 0.8, 1.0]

}

gb = GradientBoostingClassifier(random_state=self.random_state)

# 使用随机搜索加快速度

random_search = RandomizedSearchCV(

gb, param_grid, cv=5, scoring='f1_weighted',

n_iter=30, n_jobs=-1, verbose=1, random_state=self.random_state

)

random_search.fit(X_train, y_train)

print(f"\n最佳参数: {random_search.best_params_}")

print(f"最佳验证F1分数: {random_search.best_score_:.4f}")

# 在测试集上评估

best_model = random_search.best_estimator_

test_score = best_model.score(X_test, y_test)

print(f"测试集准确率: {test_score:.4f}")

return random_search, best_model

def tune_random_forest_regressor(self, X_train, X_test, y_train, y_test):

"""调优随机森林回归器"""

print("\n正在调优随机森林回归器...")

param_grid = {

'n_estimators': [50, 100, 200, 300],

'max_depth': [10, 15, 20, None],

'min_samples_split': [2, 5, 10],

'min_samples_leaf': [1, 2, 4],

'max_features': ['sqrt', 'log2', 1.0]

}

rf = RandomForestRegressor(random_state=self.random_state, n_jobs=-1)

grid_search = GridSearchCV(

rf, param_grid, cv=5, scoring='r2',

n_jobs=-1, verbose=1

)

grid_search.fit(X_train, y_train)

print(f"\n最佳参数: {grid_search.best_params_}")

print(f"最佳验证R²分数: {grid_search.best_score_:.4f}")

# 在测试集上评估

best_model = grid_search.best_estimator_

test_score = best_model.score(X_test, y_test)

print(f"测试集R²分数: {test_score:.4f}")

return grid_search, best_model

def tune_gradient_boosting_regressor(self, X_train, X_test, y_train, y_test):

"""调优梯度提升回归器"""

print("\n正在调优梯度提升回归器...")

param_grid = {

'n_estimators': [100, 200, 300],

'learning_rate': [0.001, 0.01, 0.05, 0.1],

'max_depth': [3, 5, 7, 9],

'min_samples_split': [2, 5, 10],

'min_samples_leaf': [1, 2, 4],

'subsample': [0.6, 0.8, 1.0]

}

gb = GradientBoostingRegressor(random_state=self.random_state)

random_search = RandomizedSearchCV(

gb, param_grid, cv=5, scoring='r2',

n_iter=30, n_jobs=-1, verbose=1, random_state=self.random_state

)

random_search.fit(X_train, y_train)

print(f"\n最佳参数: {random_search.best_params_}")

print(f"最佳验证R²分数: {random_search.best_score_:.4f}")

# 在测试集上评估

best_model = random_search.best_estimator_

test_score = best_model.score(X_test, y_test)

print(f"测试集R²分数: {test_score:.4f}")

return random_search, best_model

def _sort_key(self, val):

"""自定义排序函数,处理None值"""

if val is None:

return (float('inf'), None) # None值排在最后

return (0, val)

def plot_grid_search_results(self, grid_search, param1, param2, title='Grid Search Results'):

"""绘制网格搜索结果"""

results = grid_search.cv_results_

# 获取参数值并使用自定义排序处理None

param1_values = sorted(set(results[f'param_{param1}']), key=self._sort_key)

param2_values = sorted(set(results[f'param_{param2}']), key=self._sort_key)

# 将None转换为字符串用于显示

param1_labels = [str(p) if p is not None else 'None' for p in param1_values]

param2_labels = [str(p) if p is not None else 'None' for p in param2_values]

# 创建热力图矩阵

scores_matrix = np.zeros((len(param2_values), len(param1_values)))

for i, p2 in enumerate(param2_values):

for j, p1 in enumerate(param1_values):

mask = (results[f'param_{param1}'] == p1) & (results[f'param_{param2}'] == p2)

if mask.any():

scores_matrix[i, j] = results['mean_test_score'][mask][0]

else:

scores_matrix[i, j] = np.nan

fig, ax = plt.subplots(figsize=(12, 8))

im = ax.imshow(scores_matrix, cmap='YlOrRd', aspect='auto')

ax.set_xticks(np.arange(len(param1_values)))

ax.set_yticks(np.arange(len(param2_values)))

ax.set_xticklabels(param1_labels, rotation=45, ha='right')

ax.set_yticklabels(param2_labels)

ax.set_xlabel(f'{param1}', fontsize=12, fontweight='bold')

ax.set_ylabel(f'{param2}', fontsize=12, fontweight='bold')

ax.set_title(title, fontsize=13, fontweight='bold')

# 添加数值标签

for i in range(len(param2_values)):

for j in range(len(param1_values)):

if not np.isnan(scores_matrix[i, j]):

text = ax.text(j, i, f'{scores_matrix[i, j]:.3f}',

ha="center", va="center", color="black", fontsize=9)

plt.colorbar(im, ax=ax, label='Mean Test Score')

plt.tight_layout()

return fig

def plot_hyperparameter_comparison(self, grid_search, param, title='Hyperparameter Comparison'):

"""绘制超参数的性能对比"""

results = grid_search.cv_results_

param_values = sorted(set(results[f'param_{param}']), key=self._sort_key)

mean_scores = []

std_scores = []

for p_val in param_values:

mask = results[f'param_{param}'] == p_val

mean_scores.append(results['mean_test_score'][mask].mean())

std_scores.append(results['std_test_score'][mask].mean())

param_labels = [str(p) if p is not None else 'None' for p in param_values]

fig, ax = plt.subplots(figsize=(10, 6))

x = np.arange(len(param_labels))

ax.bar(x, mean_scores, yerr=std_scores, capsize=5, alpha=0.7, color='steelblue', edgecolor='black')

ax.set_xlabel(f'{param}', fontsize=12, fontweight='bold')

ax.set_ylabel('Mean Test Score', fontsize=12, fontweight='bold')

ax.set_title(title, fontsize=13, fontweight='bold')

ax.set_xticks(x)

ax.set_xticklabels(param_labels, rotation=45, ha='right')

ax.grid(axis='y', alpha=0.3)

plt.tight_layout()

return fig

def main():

"""主函数"""

print("=" * 80)

print("Hyperparameter Tuning for Ensemble Methods")

print("集成学习方法的超参数调优")

print("=" * 80)

tuner = HyperparameterTuning(random_state=42)

# ========== 分类任务 ==========

print("\n" + "=" * 80)

print("分类任务超参数调优")

print("=" * 80)

X_train_cls, X_test_cls, y_train_cls, y_test_cls = tuner.create_classification_dataset(

n_samples=3000, n_features=25

)

# 调优随机森林

rf_search, rf_best = tuner.tune_random_forest_classifier(

X_train_cls, X_test_cls, y_train_cls, y_test_cls

)

# 调优梯度提升

gb_search, gb_best = tuner.tune_gradient_boosting_classifier(

X_train_cls, X_test_cls, y_train_cls, y_test_cls

)

# 绘制调优结果

print("\n绘制随机森林分类热力图...")

fig1 = tuner.plot_grid_search_results(

rf_search, 'n_estimators', 'max_depth',

title='Random Forest - Grid Search Results (Classification)'

)

plt.savefig('rf_grid_search_classification.png', dpi=300, bbox_inches='tight')

print("随机森林网格搜索结果已保存")

plt.close()

# 绘制梯度提升的超参数对比

print("绘制梯度提升超参数对比图...")

fig2 = tuner.plot_hyperparameter_comparison(

gb_search, 'learning_rate',

title='Gradient Boosting - Learning Rate Comparison (Classification)'

)

plt.savefig('gb_learning_rate_comparison_classification.png', dpi=300, bbox_inches='tight')

print("梯度提升学习率对比图已保存")

plt.close()

# ========== 回归任务 ==========

print("\n" + "=" * 80)

print("回归任务超参数调优")

print("=" * 80)

X_train_reg, X_test_reg, y_train_reg, y_test_reg = tuner.create_regression_dataset(

n_samples=3000, n_features=25

)

# 调优随机森林

rf_search_reg, rf_best_reg = tuner.tune_random_forest_regressor(

X_train_reg, X_test_reg, y_train_reg, y_test_reg

)

# 调优梯度提升

gb_search_reg, gb_best_reg = tuner.tune_gradient_boosting_regressor(

X_train_reg, X_test_reg, y_train_reg, y_test_reg

)

# 绘制调优结果

print("\n绘制随机森林回归热力图...")

fig3 = tuner.plot_grid_search_results(

rf_search_reg, 'n_estimators', 'max_depth',

title='Random Forest - Grid Search Results (Regression)'

)

plt.savefig('rf_grid_search_regression.png', dpi=300, bbox_inches='tight')

print("随机森林网格搜索结果已保存")

plt.close()

# 绘制梯度提升的超参数对比

print("绘制梯度提升超参数对比图...")

fig4 = tuner.plot_hyperparameter_comparison(

gb_search_reg, 'learning_rate',

title='Gradient Boosting - Learning Rate Comparison (Regression)'

)

plt.savefig('gb_learning_rate_comparison_regression.png', dpi=300, bbox_inches='tight')

print("梯度提升学习率对比图已保存")

plt.close()

print("\n" + "=" * 80)

print("超参数调优完成!")

print("=" * 80)

print("\n生成的图表文件:")

print(" - rf_grid_search_classification.png")

print(" - gb_learning_rate_comparison_classification.png")

print(" - rf_grid_search_regression.png")

print(" - gb_learning_rate_comparison_regression.png")

if __name__ == '__main__':

main()以上代码实现了Bagging和Boosting方法的完整对比分析,包括分类和回归任务、超参数调优、特征重要性分析等多个方面的内容。代码具有以下特点:使用tqdm库显示训练进度;正确处理中文字符的图表;完整的数据集创建和模型训练;详细的性能指标计算和可视化;系统的超参数调优与评估。所有代码都是完整可运行的,用户可以直接执行来获得详细的实验结果和可视化输出。