文章目录

- 背景

- 目标

- Pre准备

- [1,Introduction and coding our first neuron 编写第一个神经元](#1,Introduction and coding our first neuron 编写第一个神经元)

-

- 张量运算

- [NumPy 乘法及深度学习常用矩阵运算](#NumPy 乘法及深度学习常用矩阵运算)

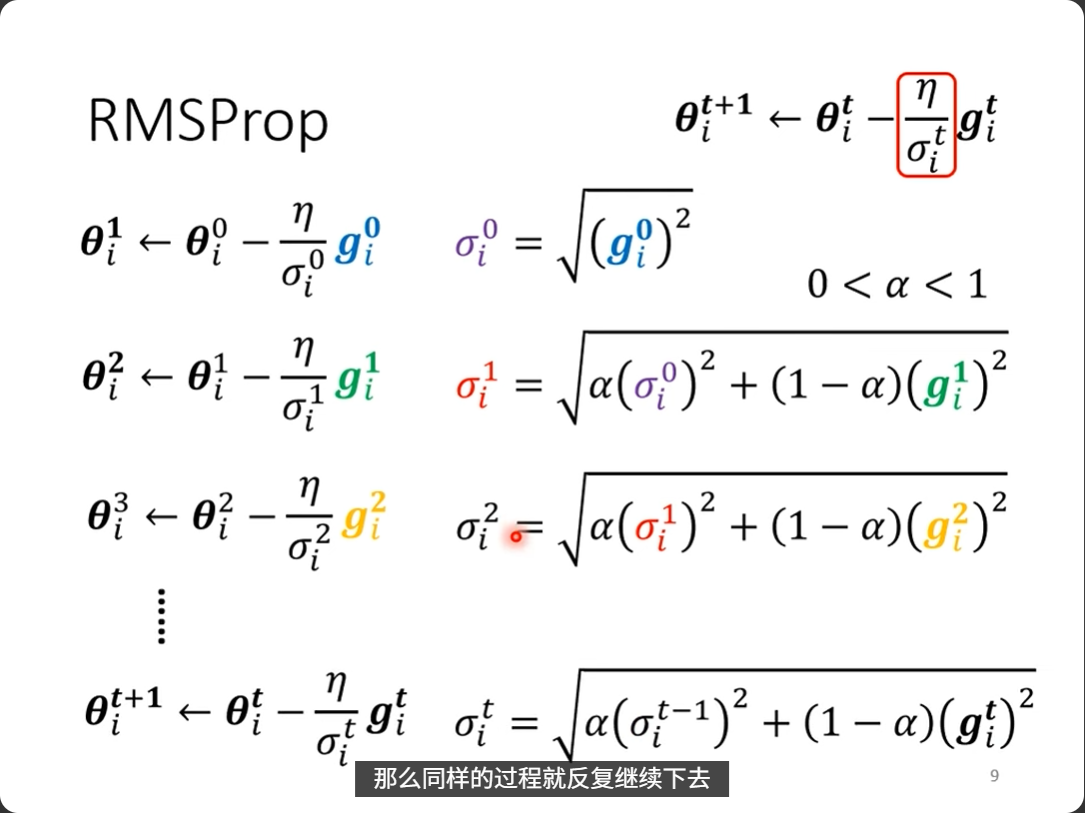

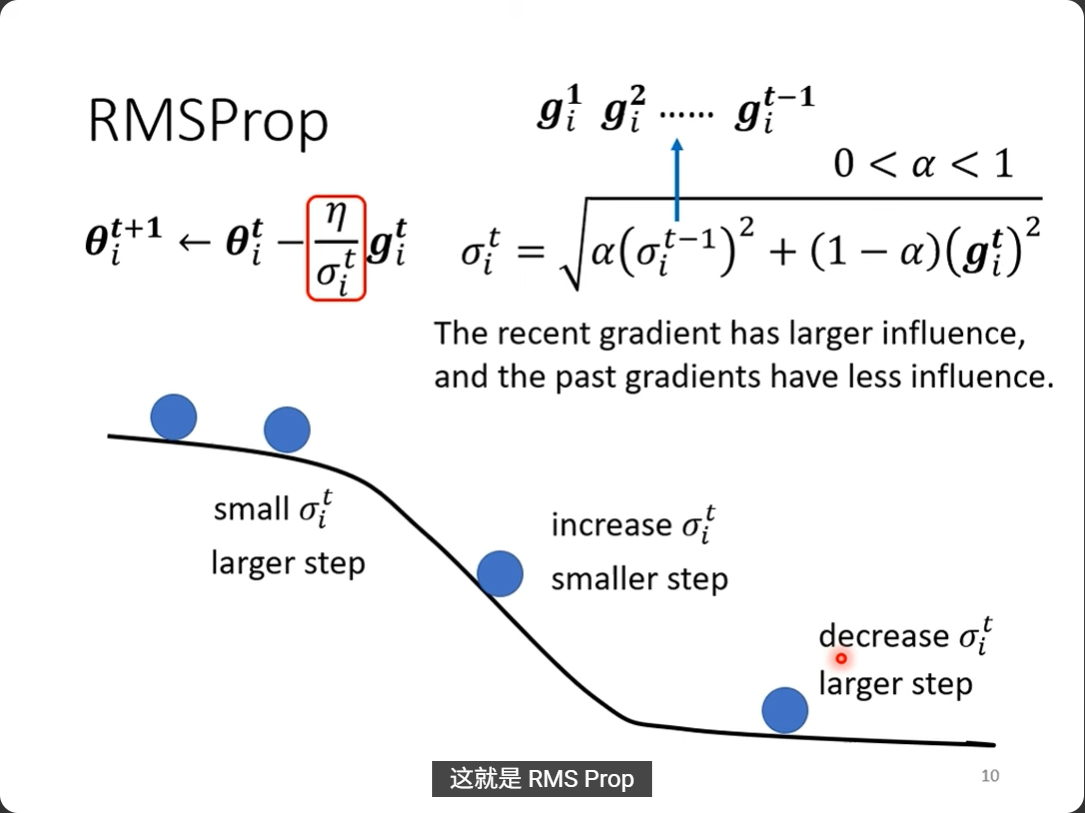

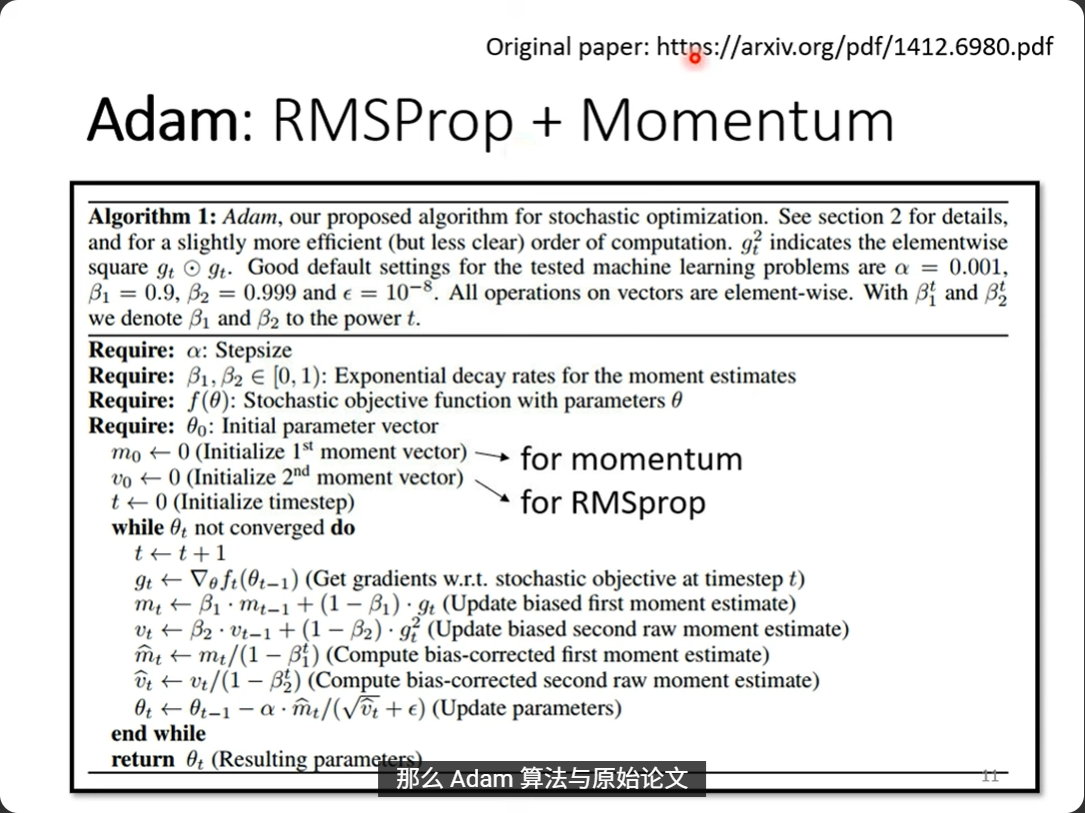

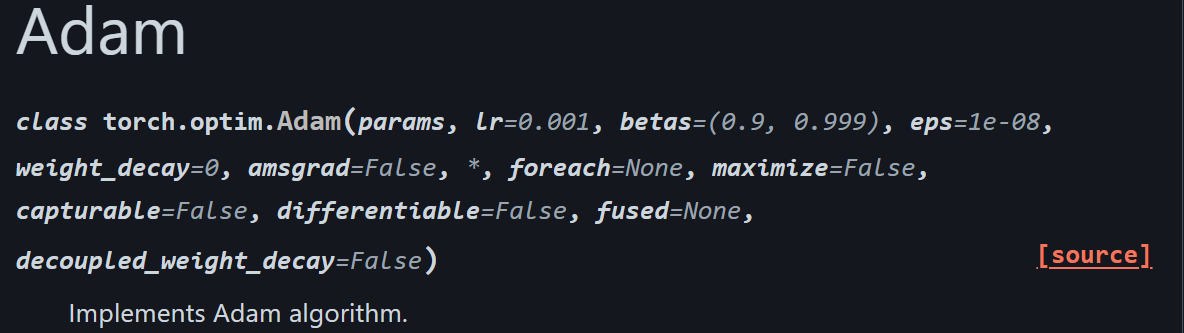

- [2,Coding a layer of neurons 编写神经元层](#2,Coding a layer of neurons 编写神经元层)

- [3,Hidden layer activation functions 隐藏层激活函数](#3,Hidden layer activation functions 隐藏层激活函数)

- [4,Output layer activation function 输出层激活函数](#4,Output layer activation function 输出层激活函数)

-

- softmax

- [overflow prevention 溢出预防](#overflow prevention 溢出预防)

- [5,Calculating and implementing loss 计算并实现损失](#5,Calculating and implementing loss 计算并实现损失)

-

- 计算三张图像批次的损失

-

- step1:先明确「维度结构」

- step2:按「索引类型」分类记忆

- 明确两个完全不同的索引逻辑

- [什么时候是 zip,什么时候是笛卡尔积?](#什么时候是 zip,什么时候是笛卡尔积?)

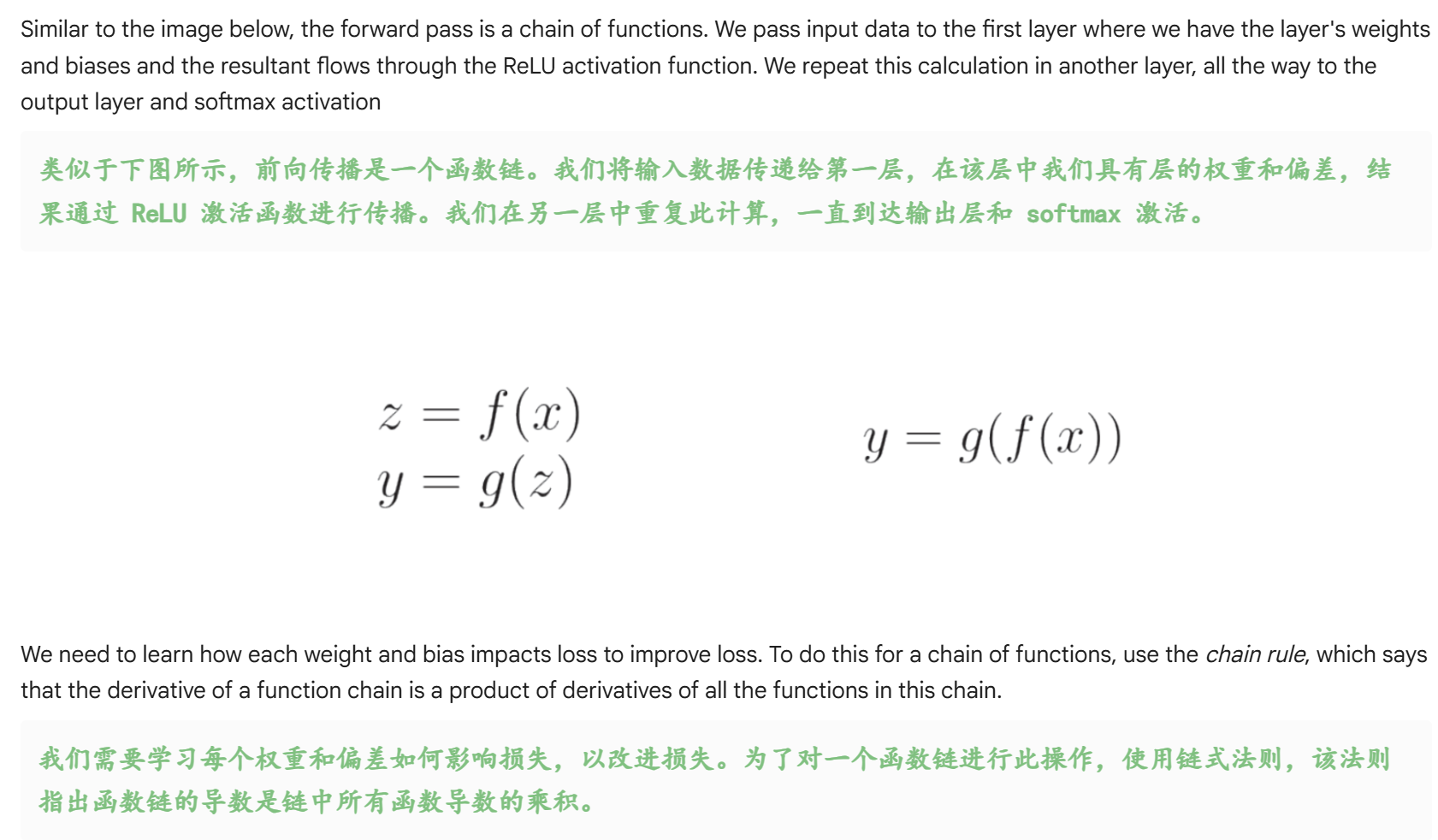

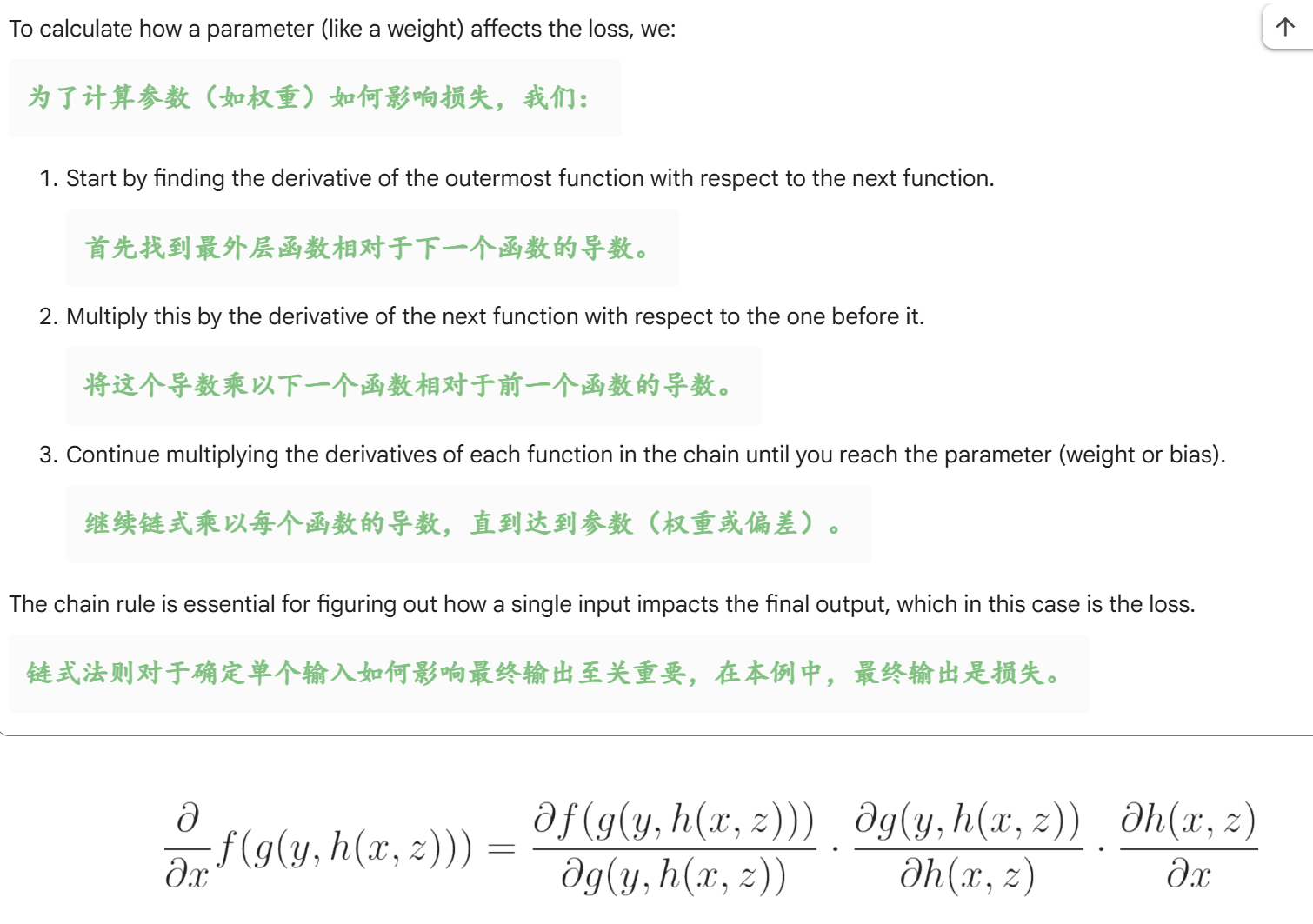

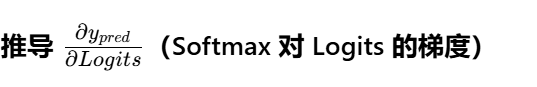

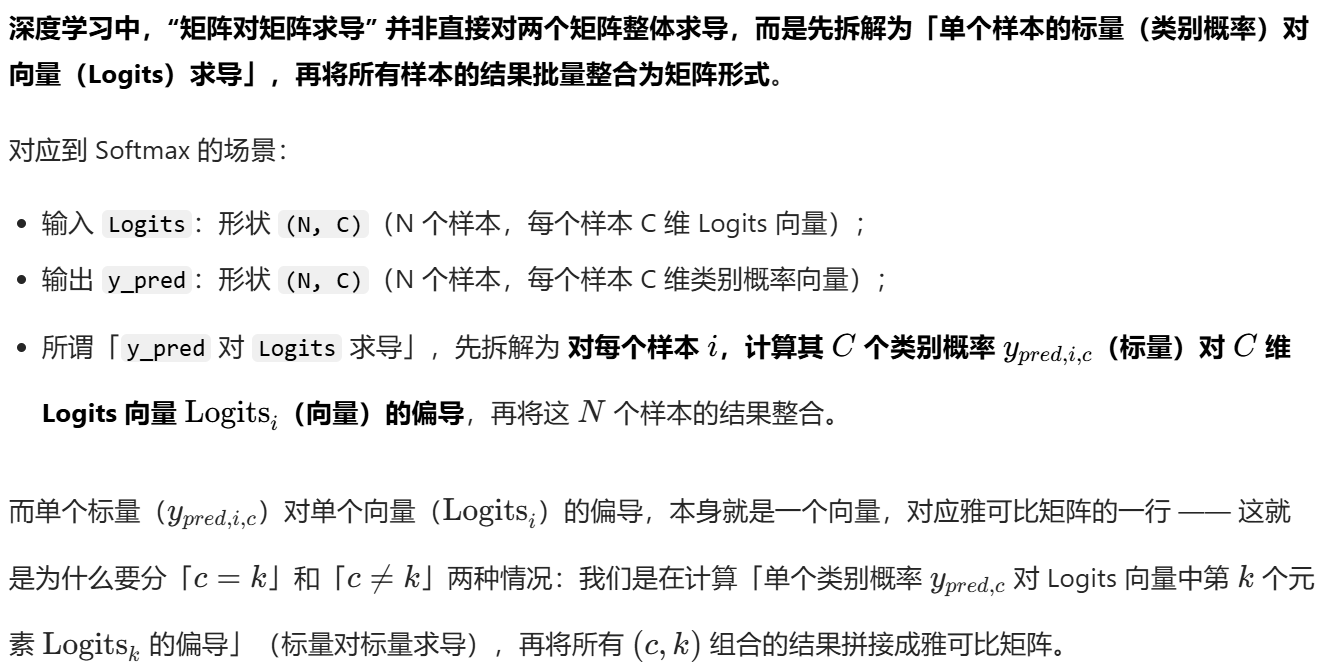

- [6,Backpropogation 反向传播](#6,Backpropogation 反向传播)

-

-

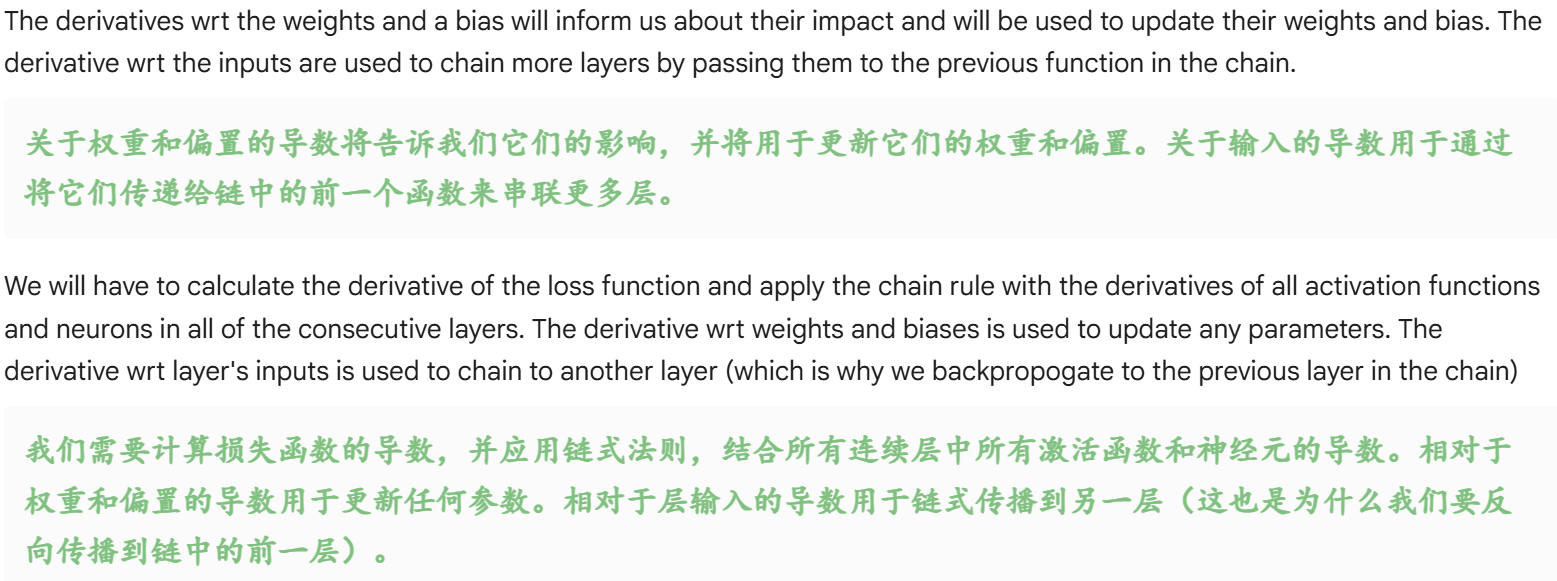

- [1. 导数的两种核心用途:针对"参数" vs 针对"输入"](#1. 导数的两种核心用途:针对“参数” vs 针对“输入”)

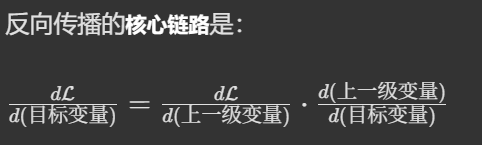

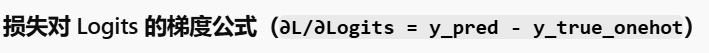

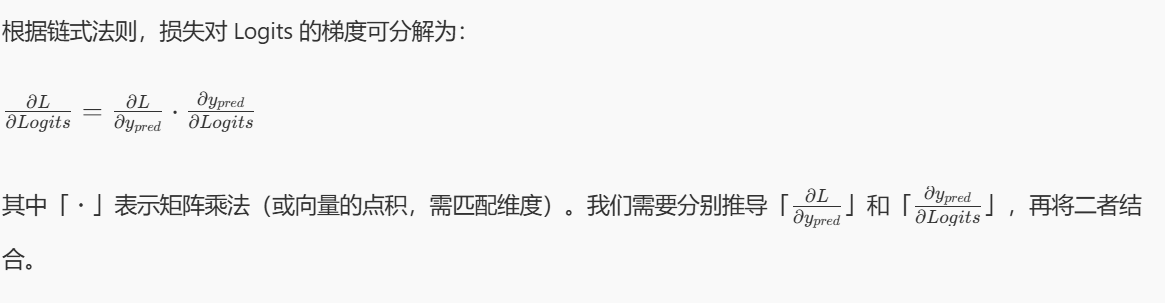

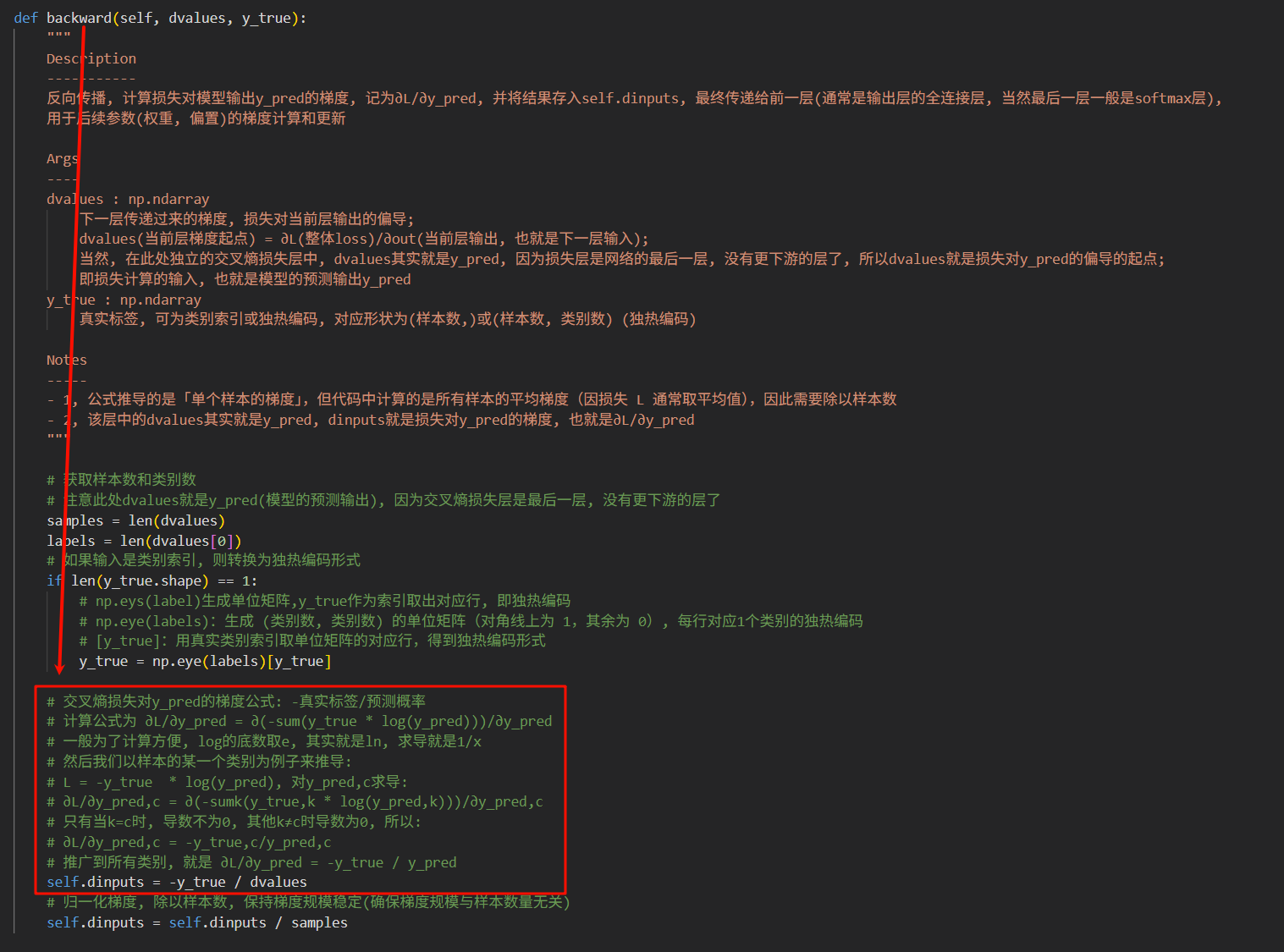

- [2. 反向传播的核心操作:损失函数导数 + 链式法则](#2. 反向传播的核心操作:损失函数导数 + 链式法则)

- [3. 反向传播的本质:"反向递推"的逻辑](#3. 反向传播的本质:“反向递推”的逻辑)

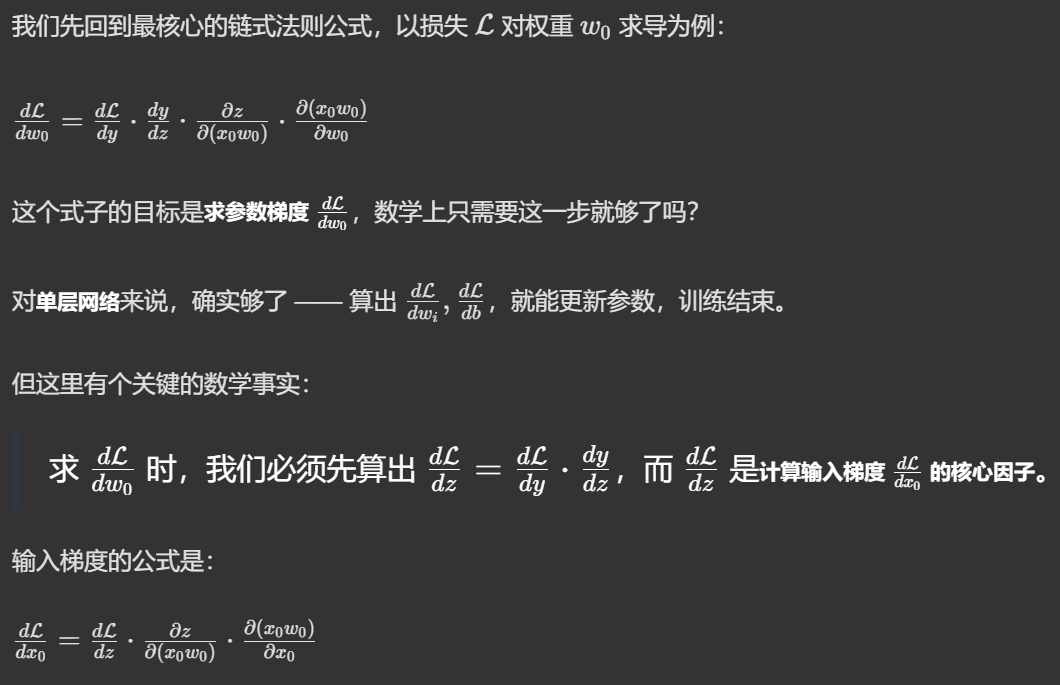

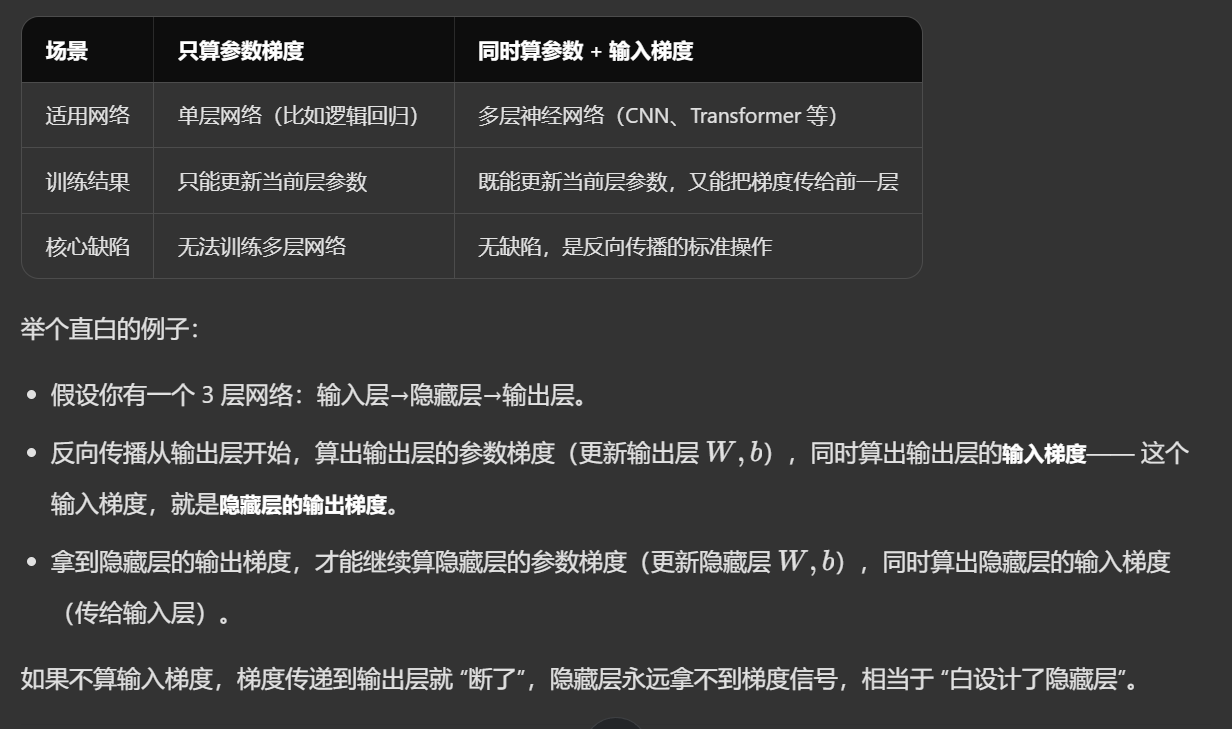

- 两个梯度:参数梯度与输入梯度

-

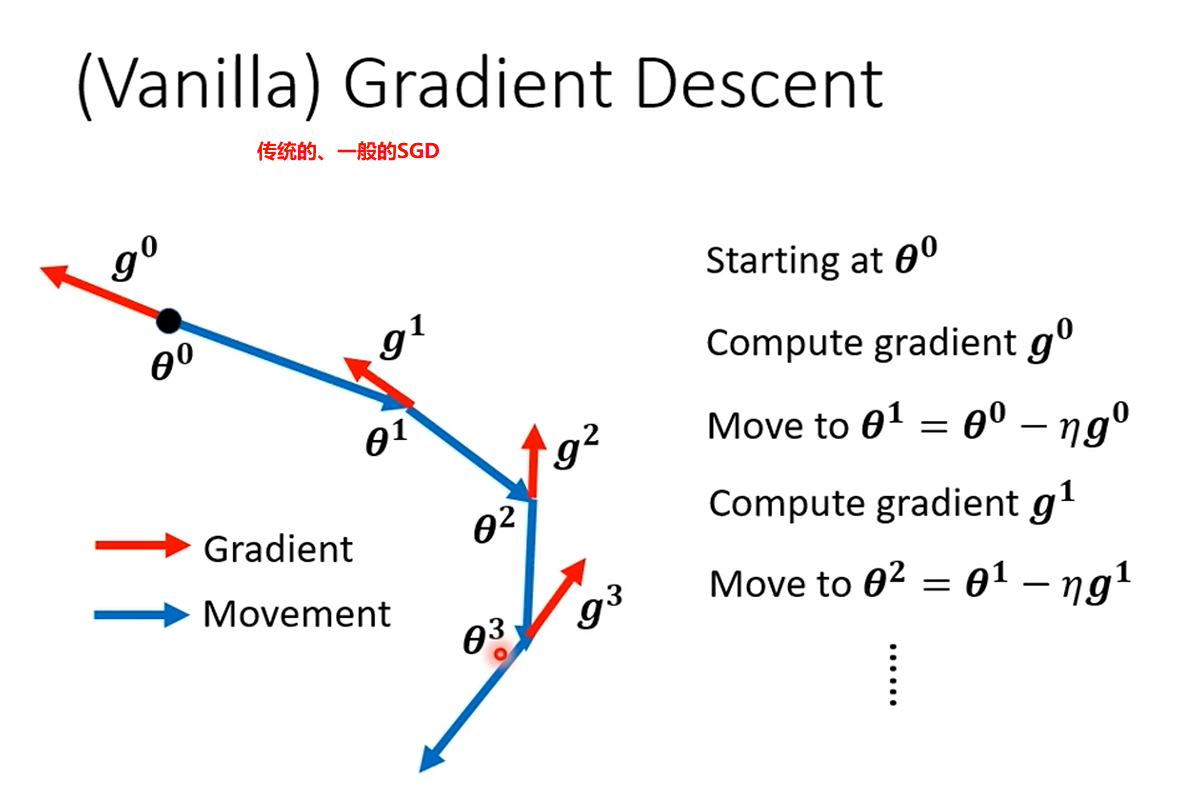

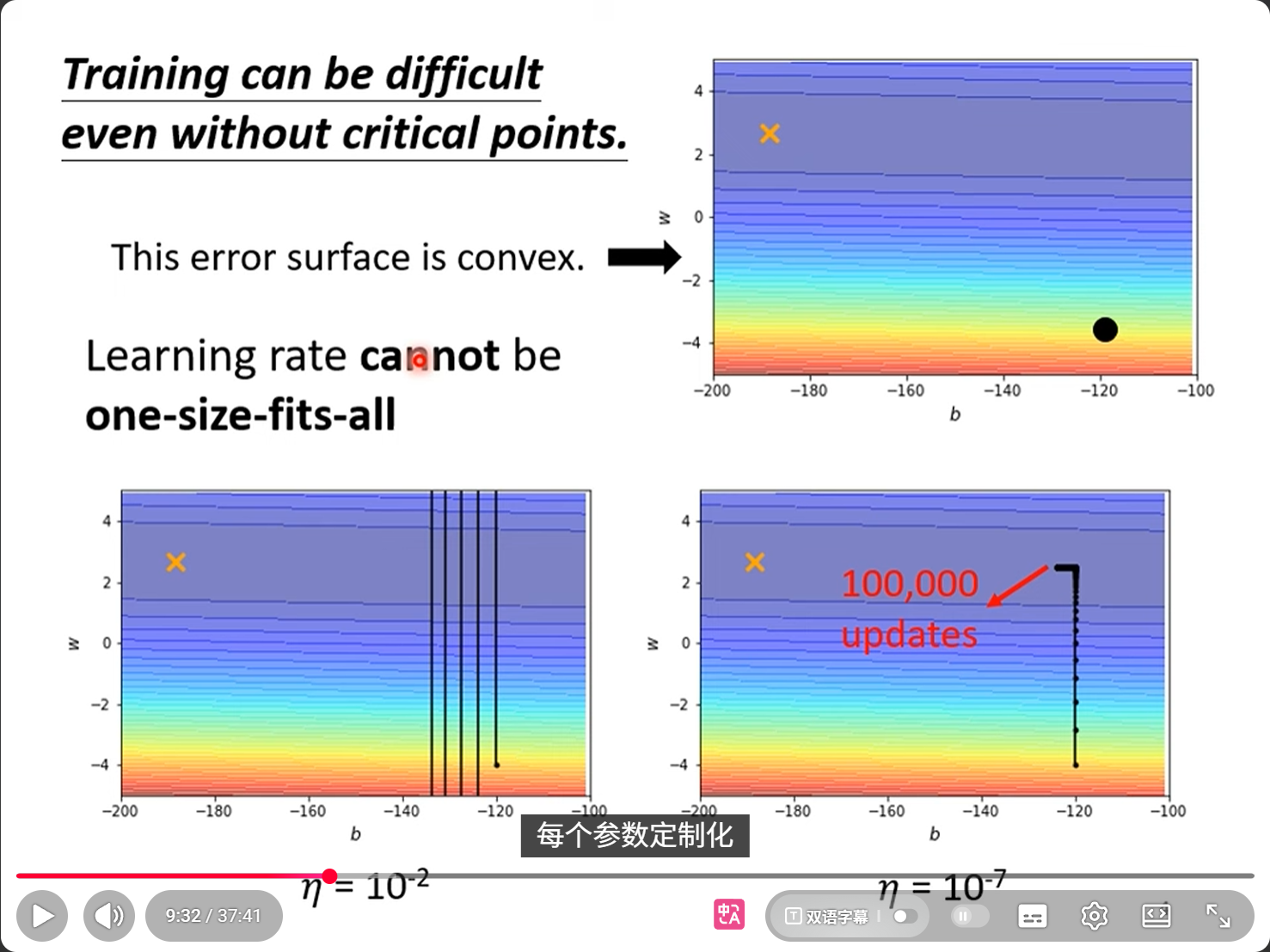

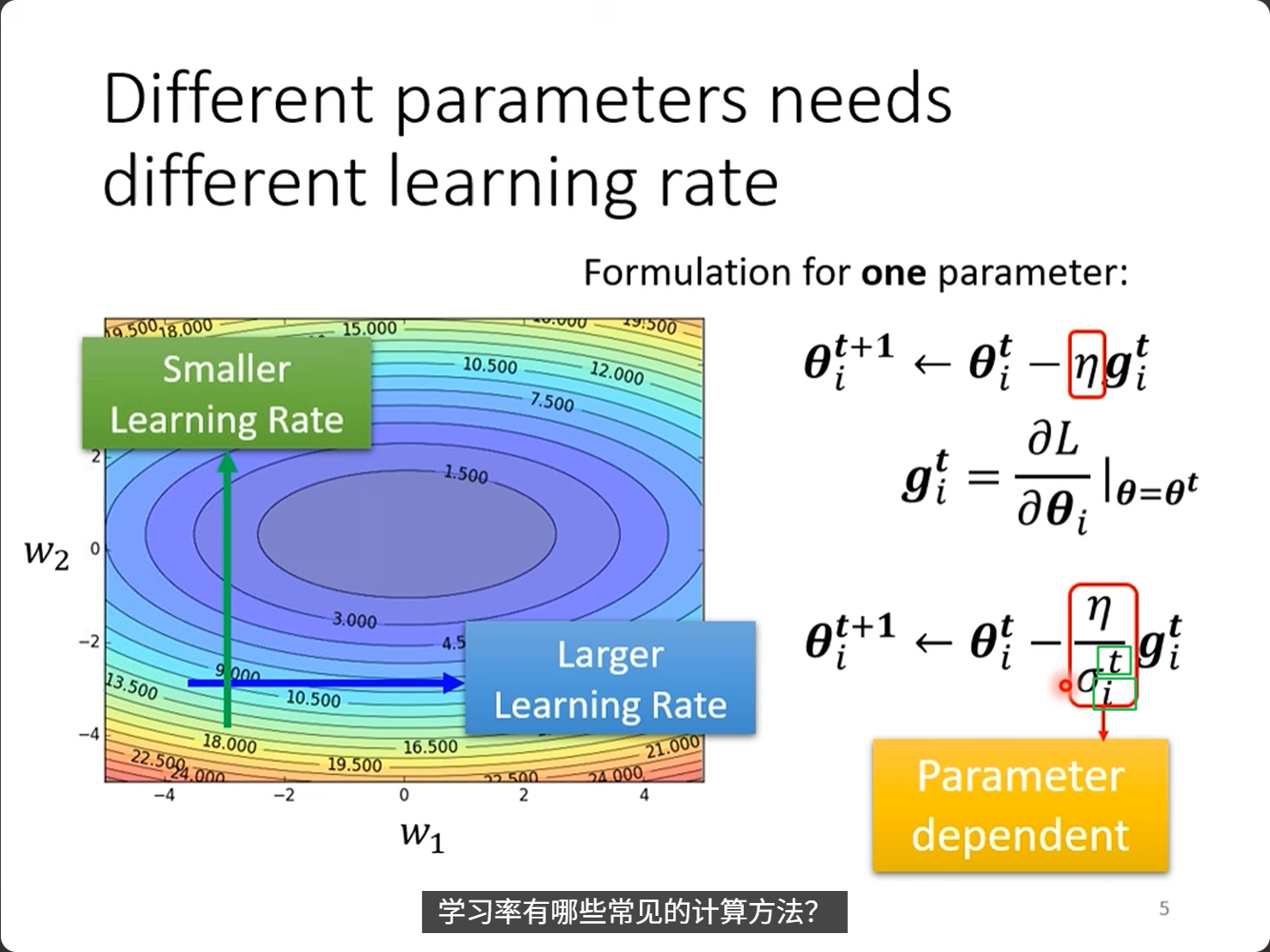

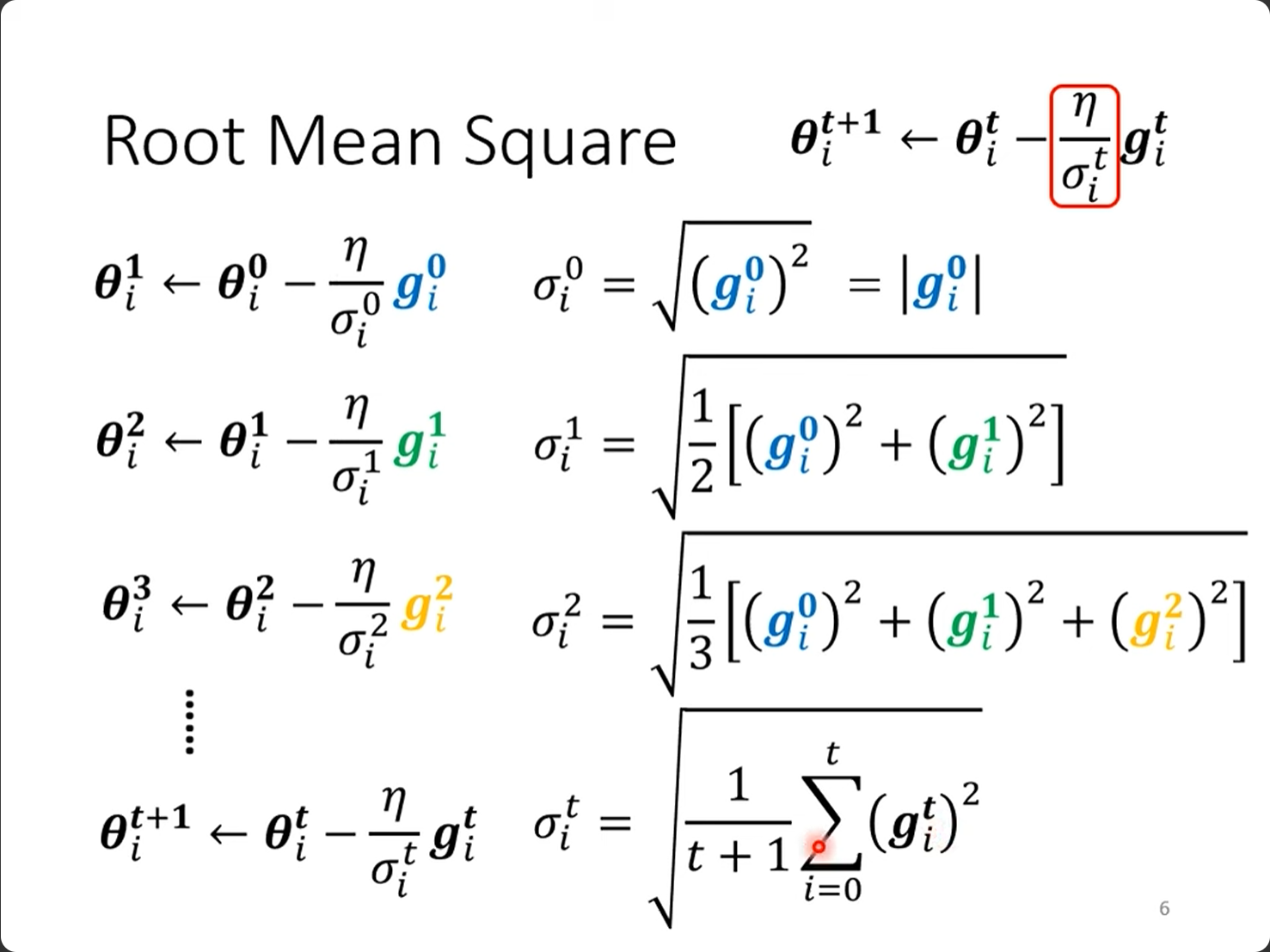

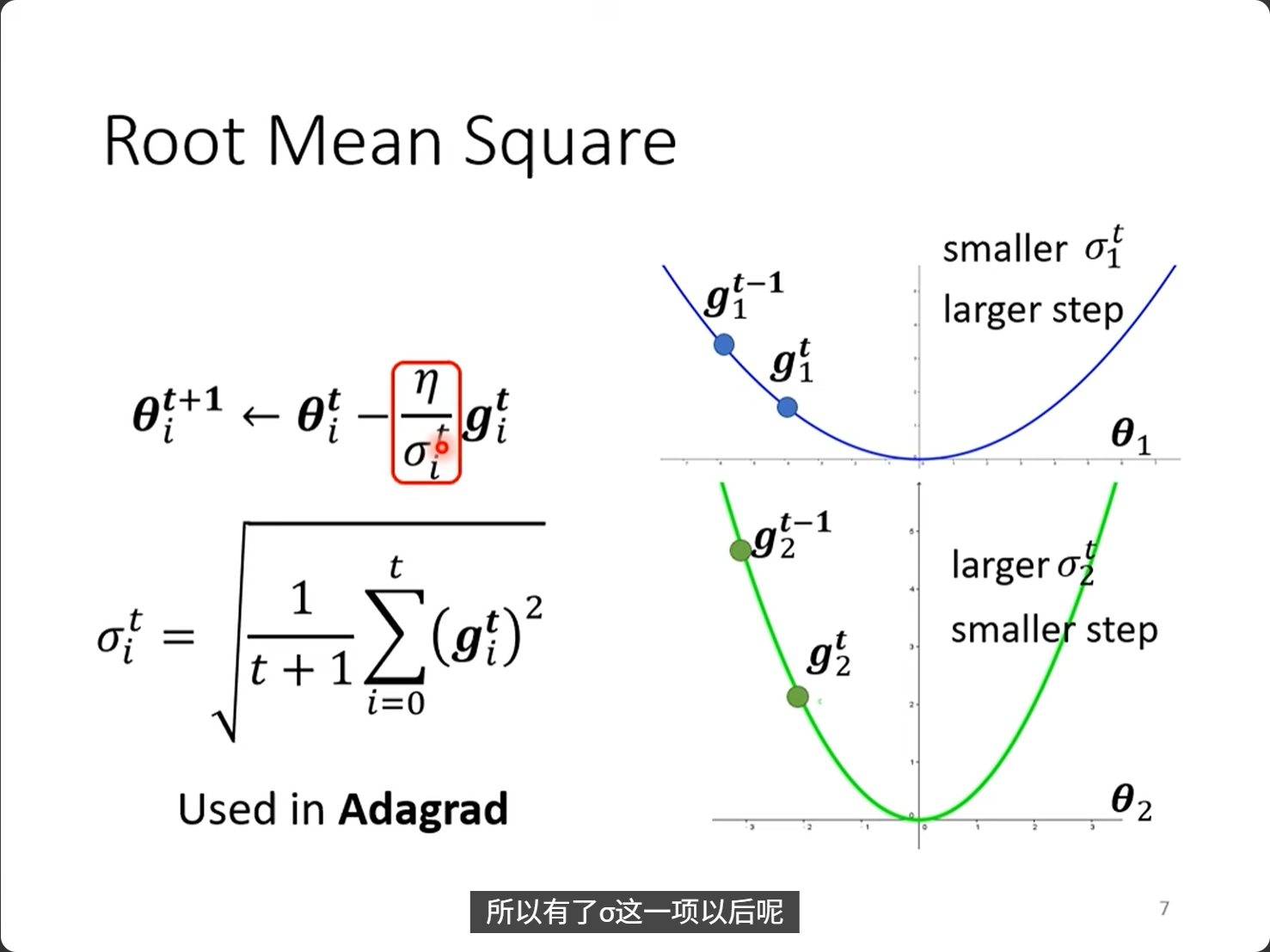

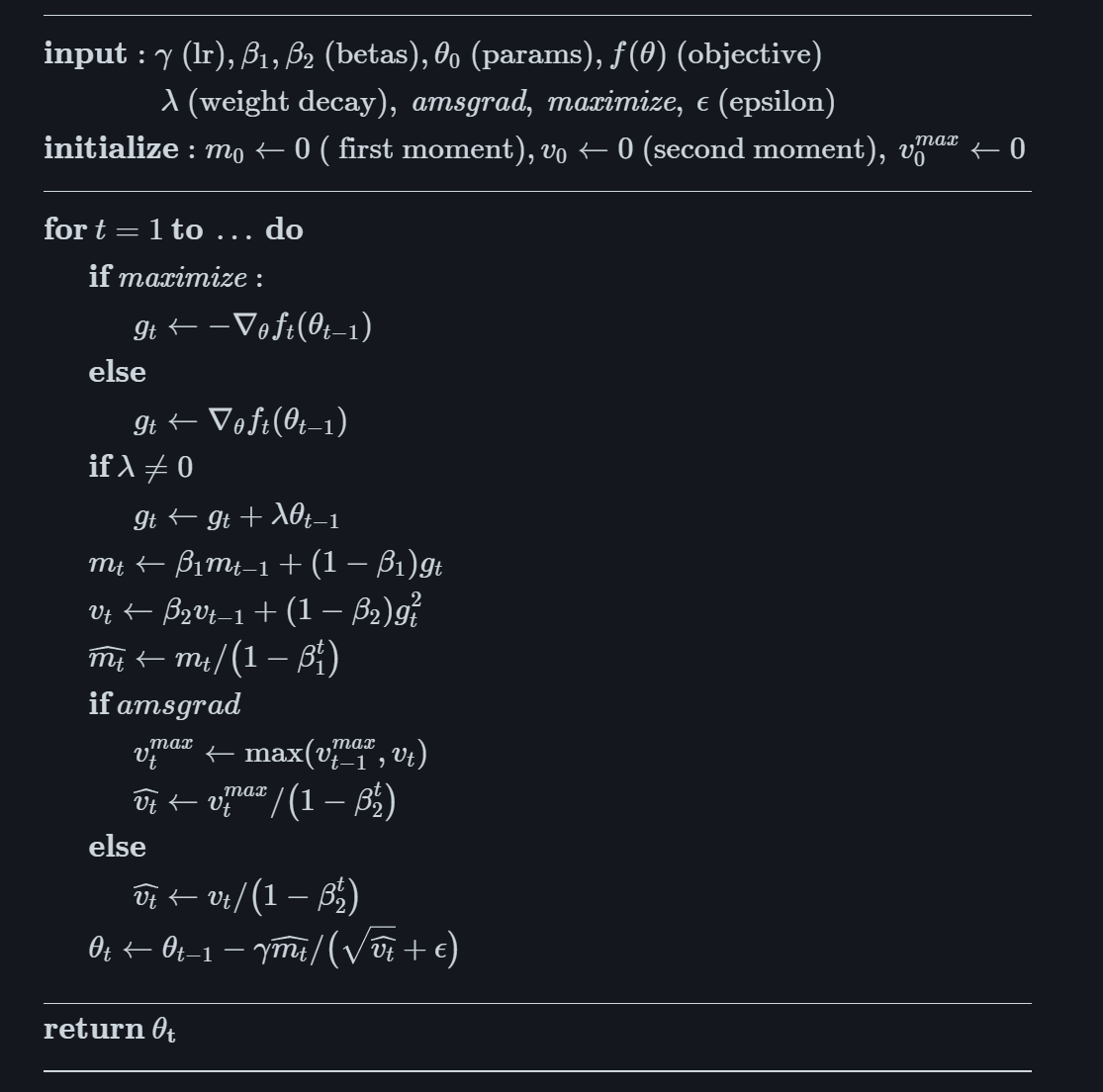

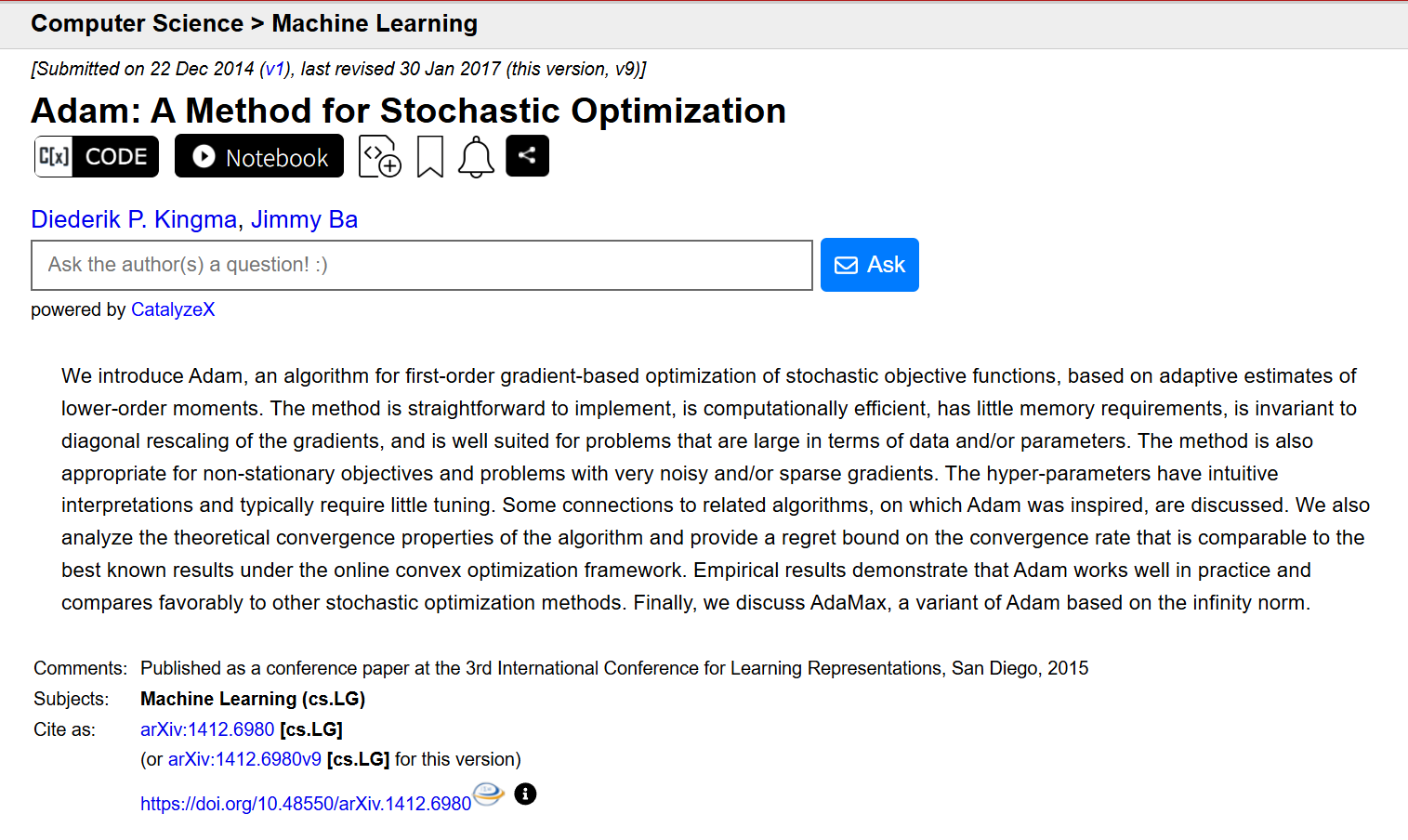

- [7,Optimizers 优化器](#7,Optimizers 优化器)

- [8,Learning rate and momentum 学习率和动量](#8,Learning rate and momentum 学习率和动量)

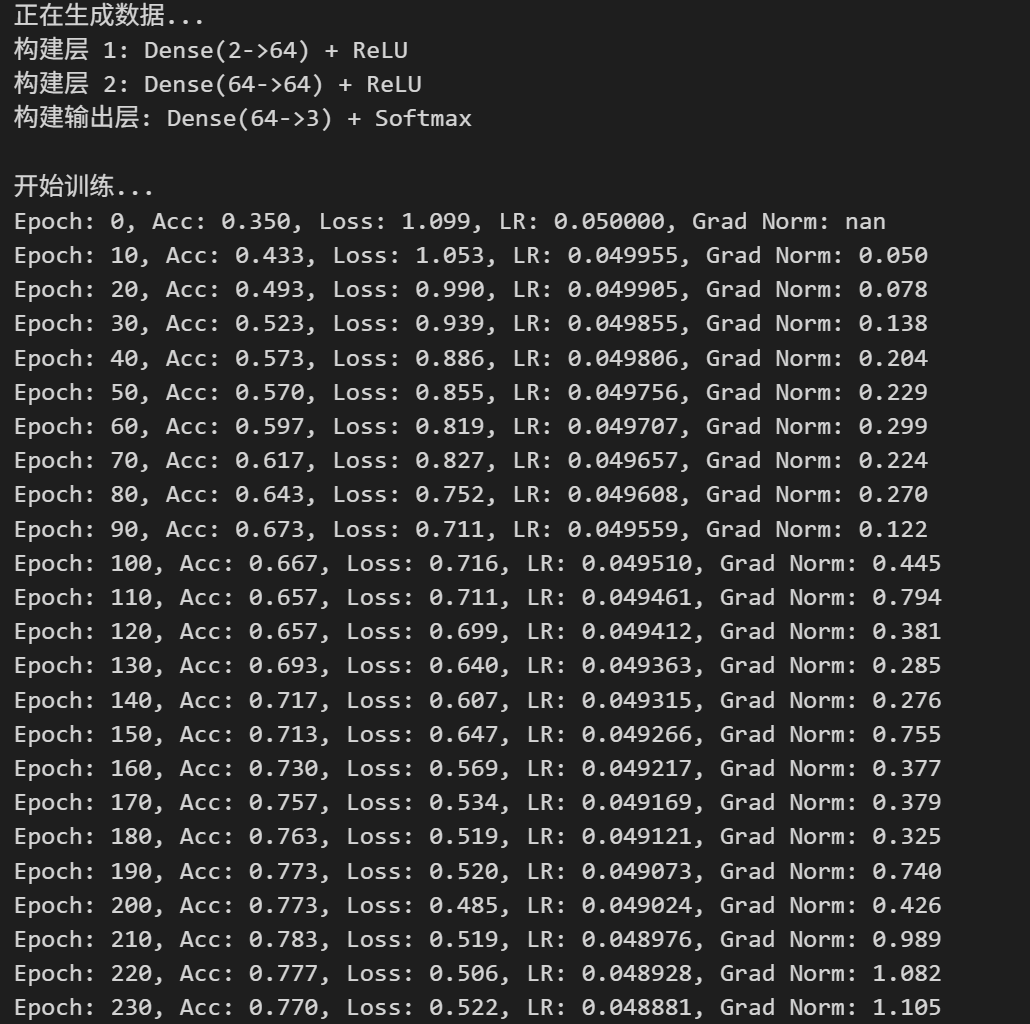

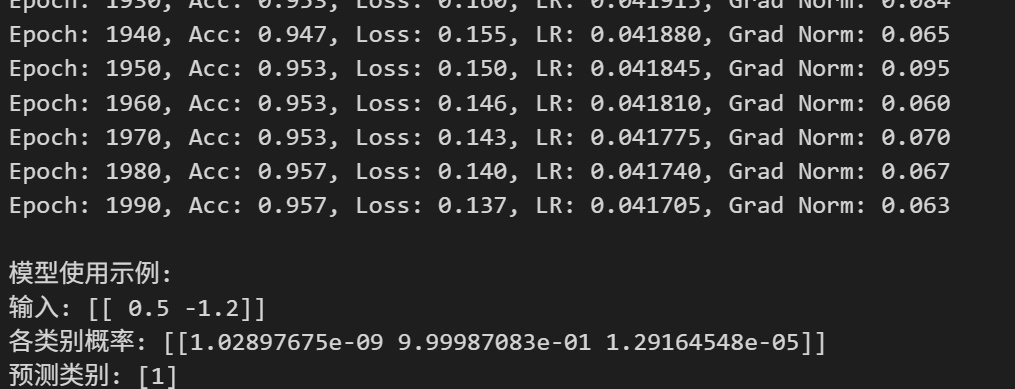

- [9,Complete Neural Network from scratch 从头开始构建完整的神经网络](#9,Complete Neural Network from scratch 从头开始构建完整的神经网络)

- 10,只使用Numpy构建的1个简单全连接网络全代码

-

- 真纯Numpy手搓1个简单的神经网络

- 一些推导中需要注意的地方

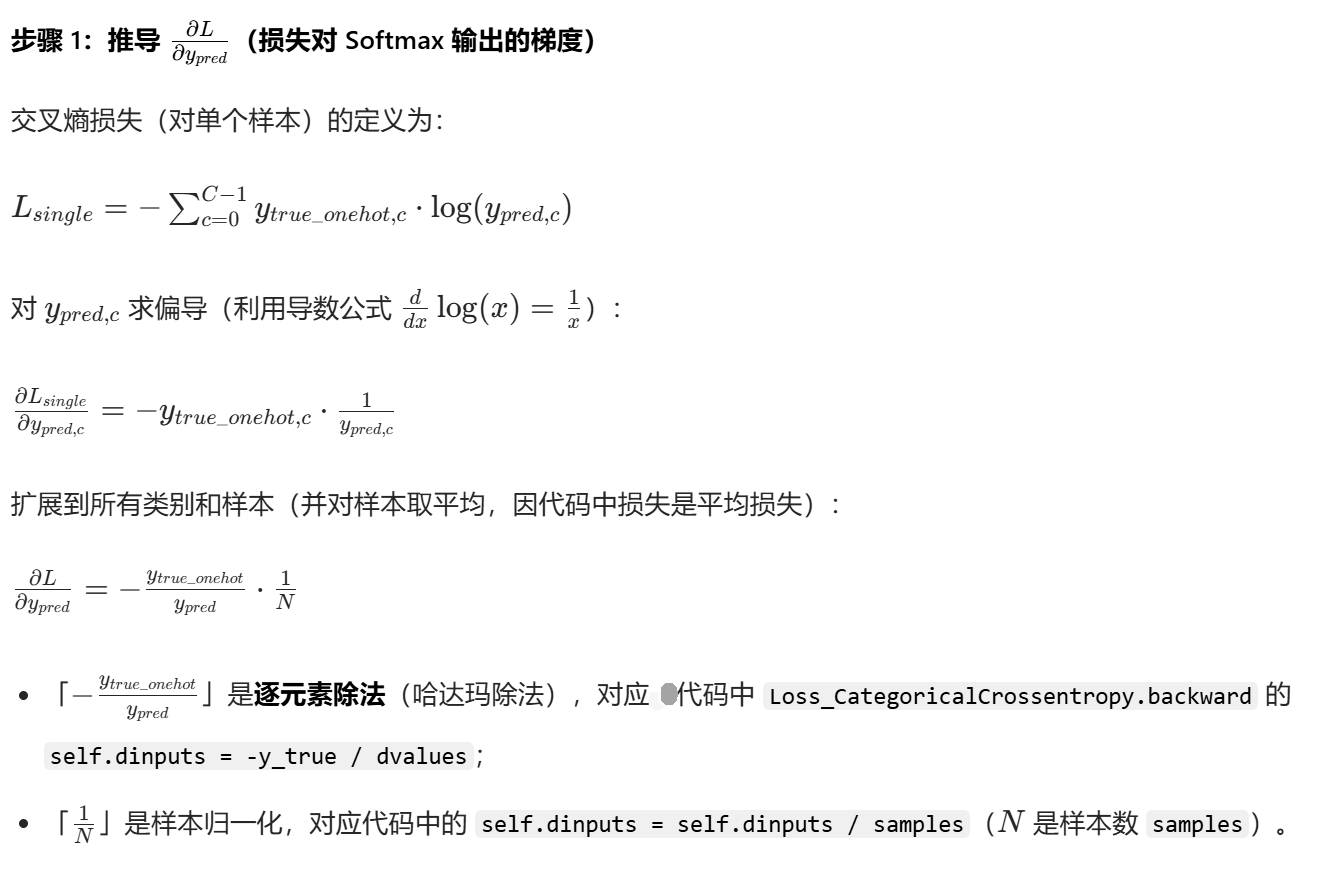

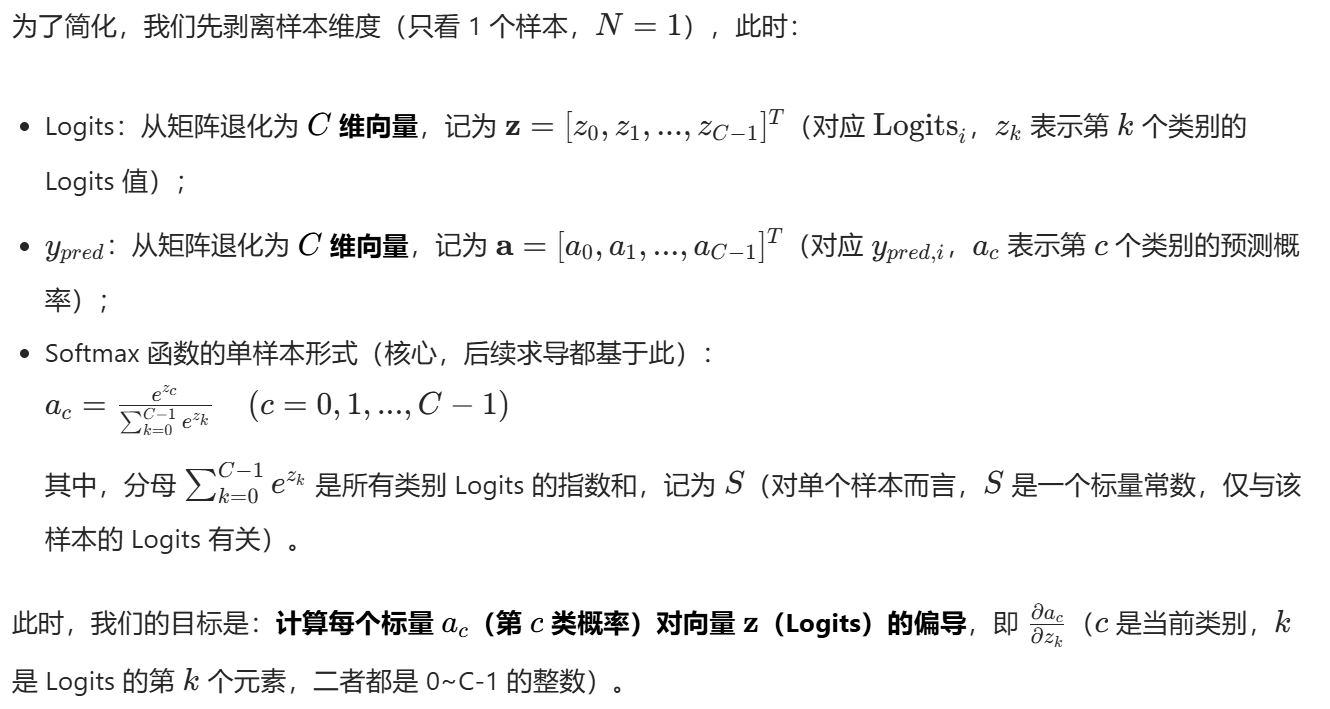

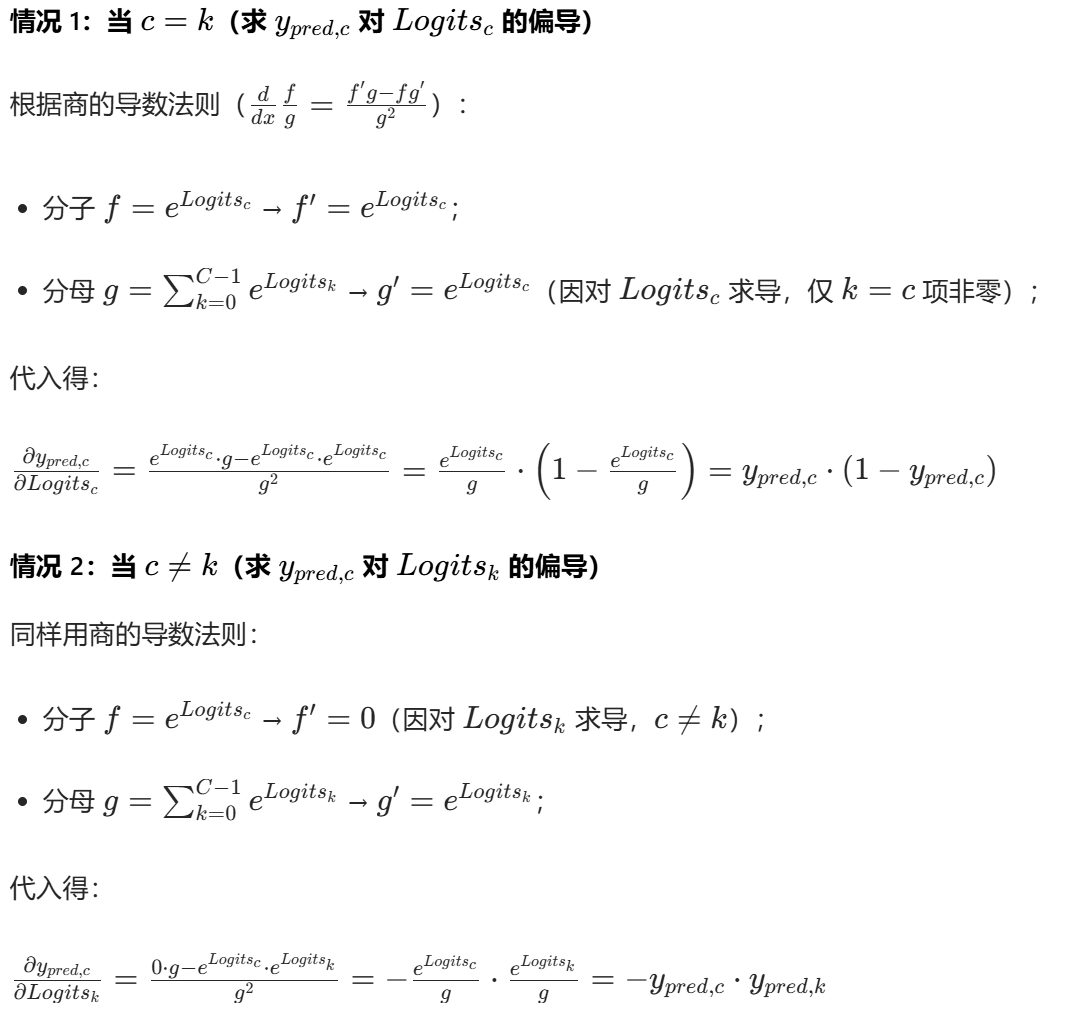

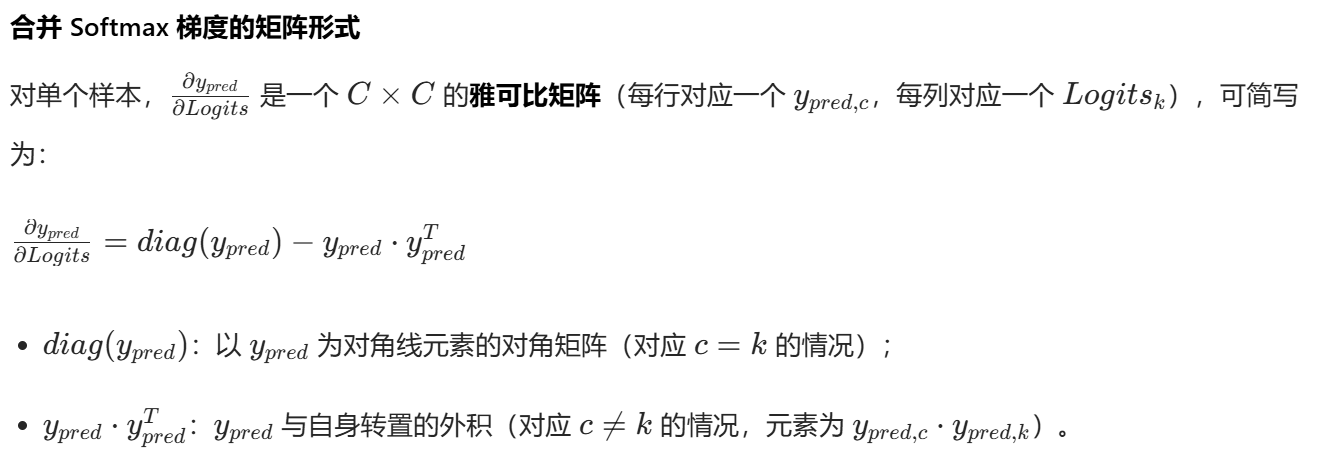

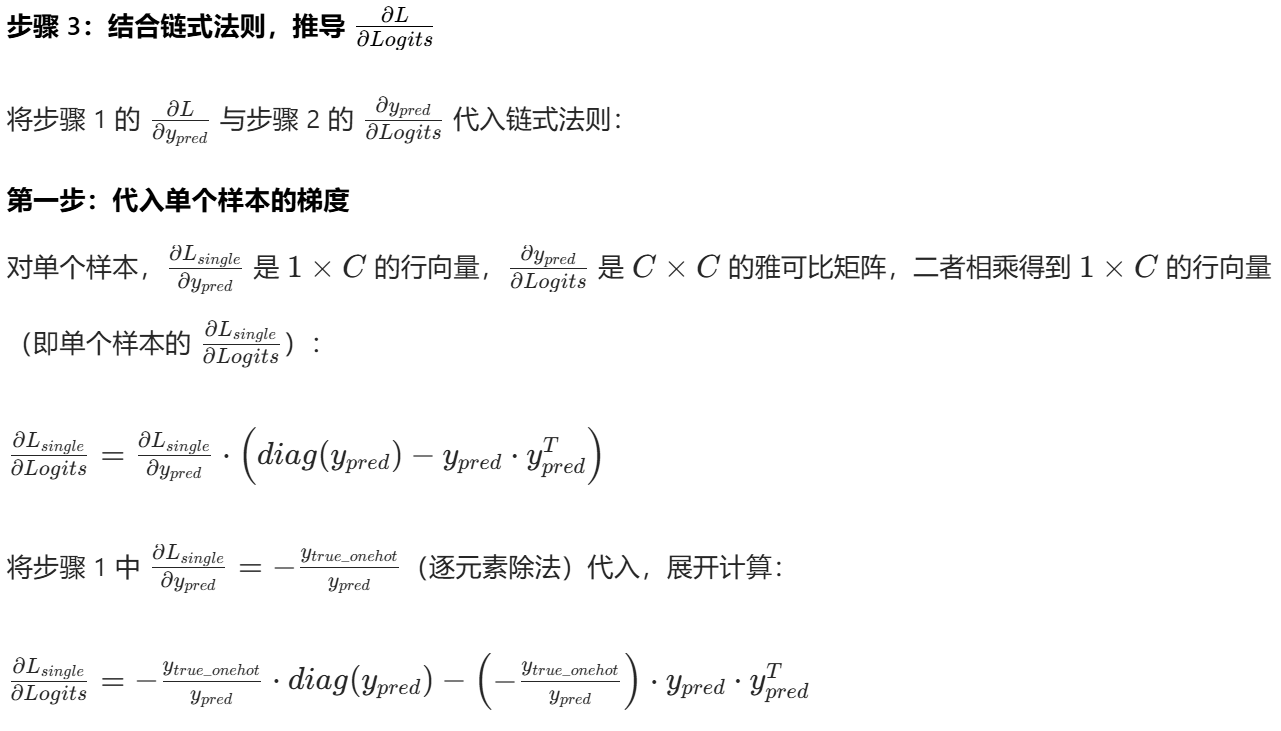

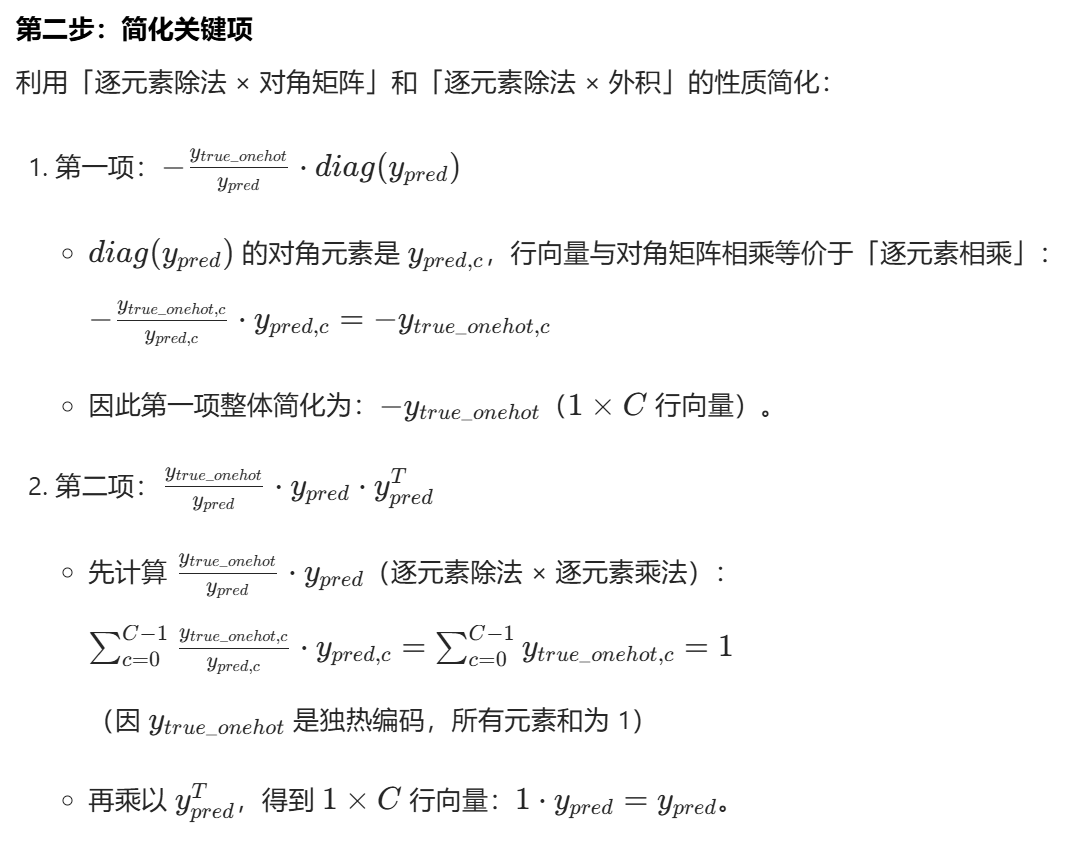

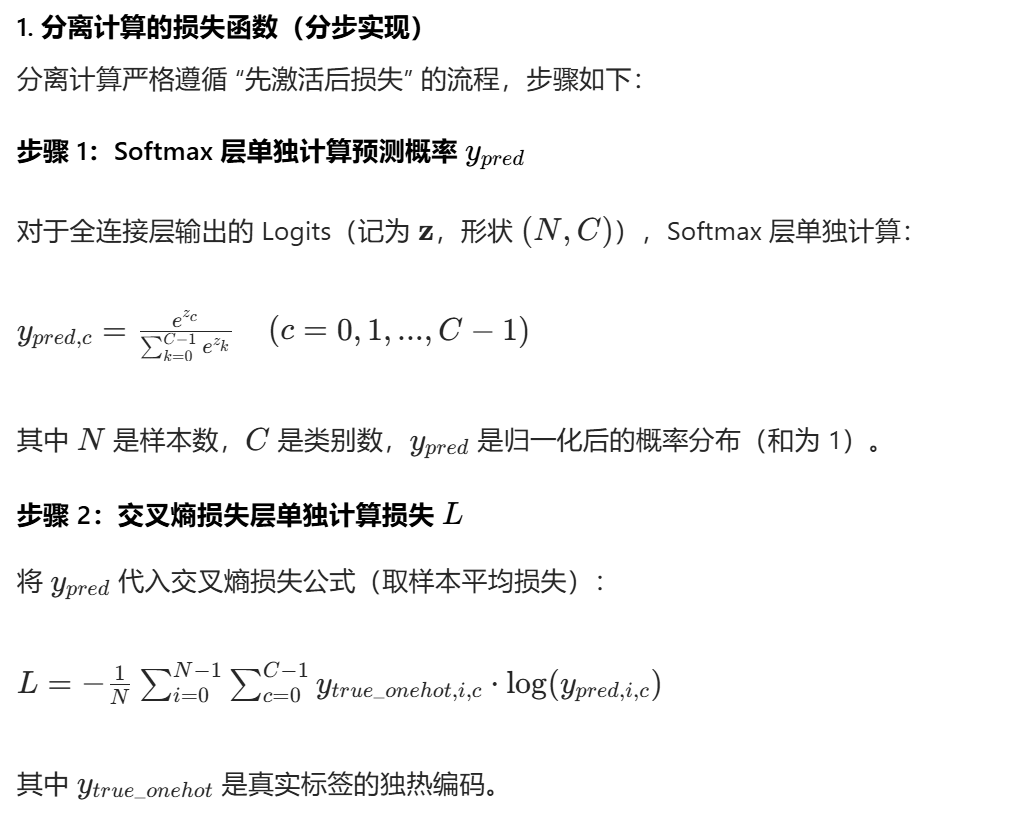

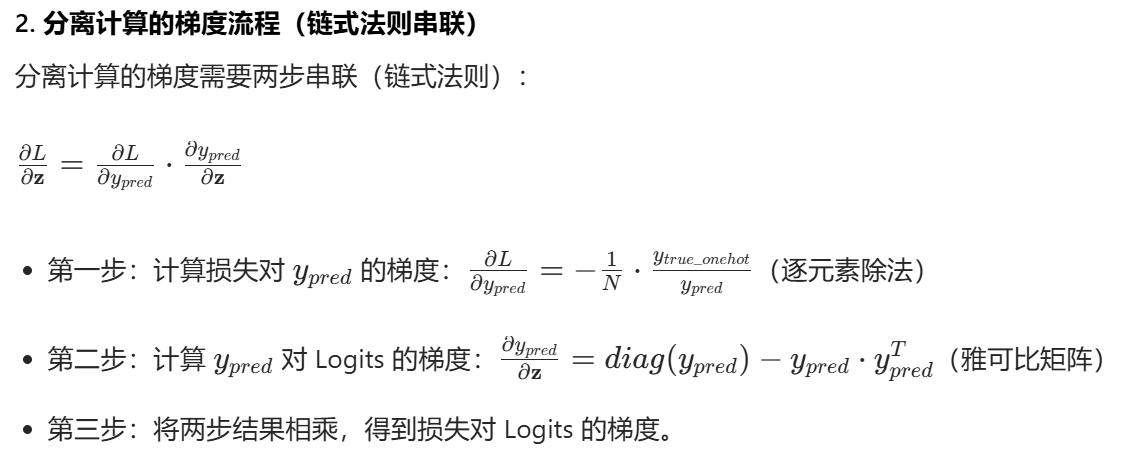

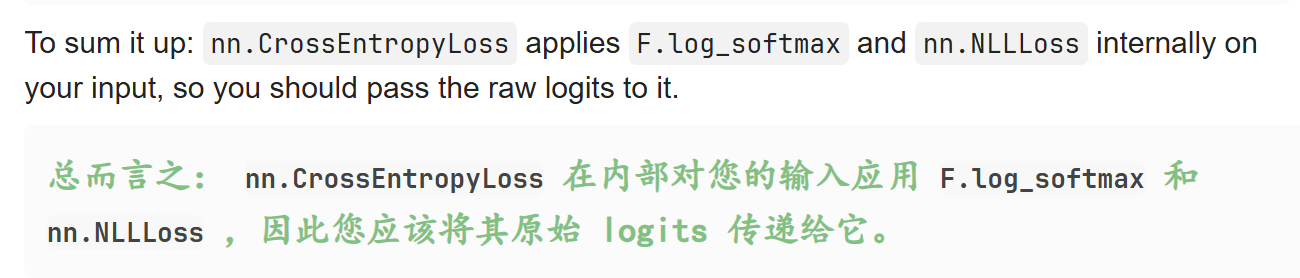

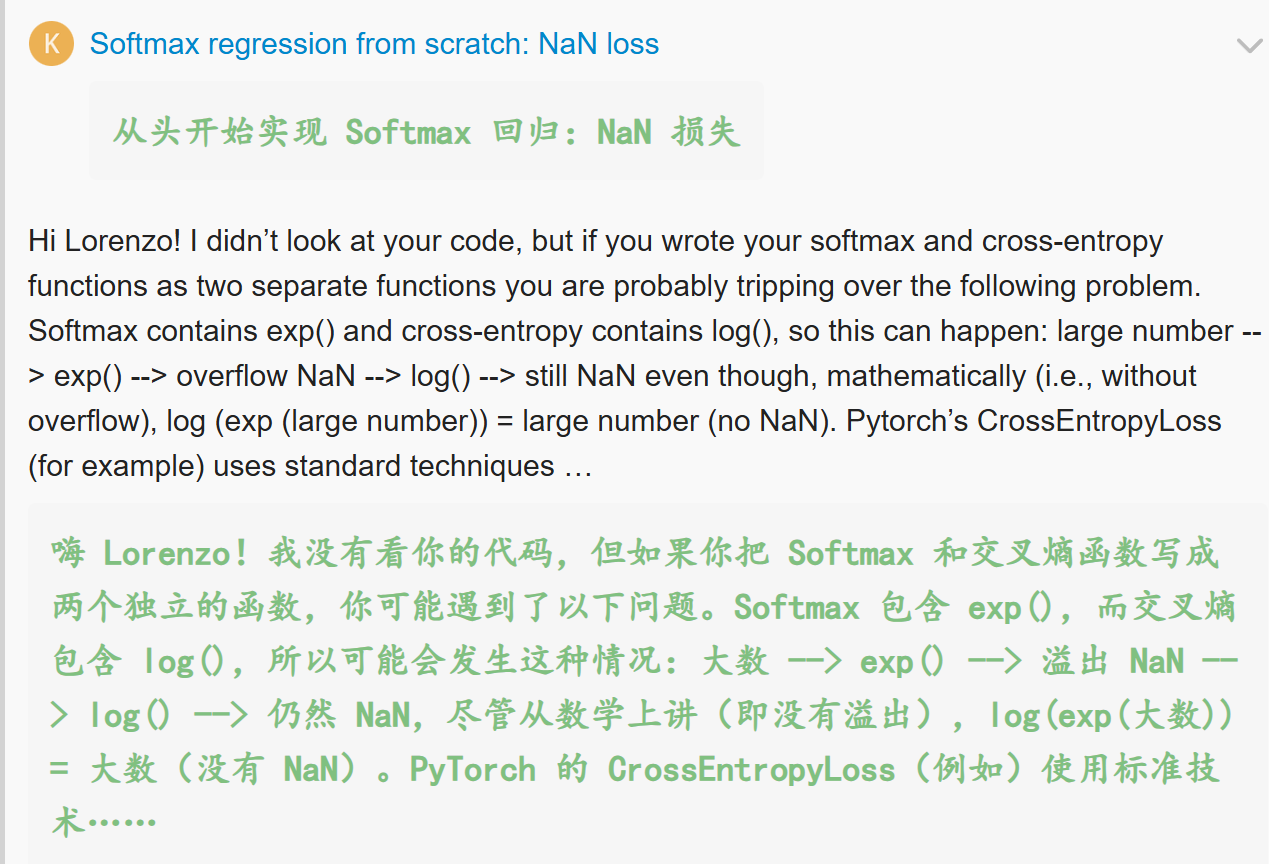

- 为什么要合并softmax和多分类交叉熵损失?

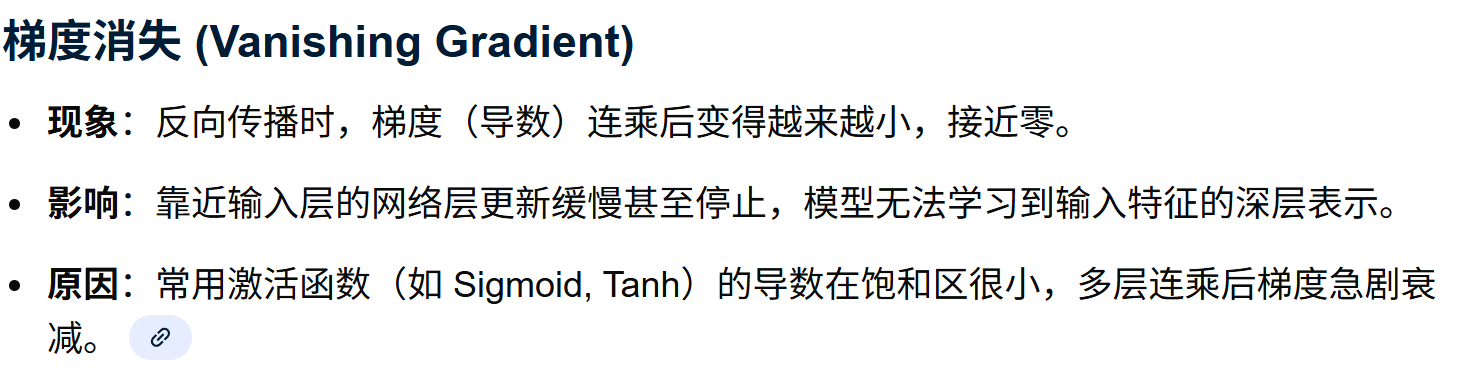

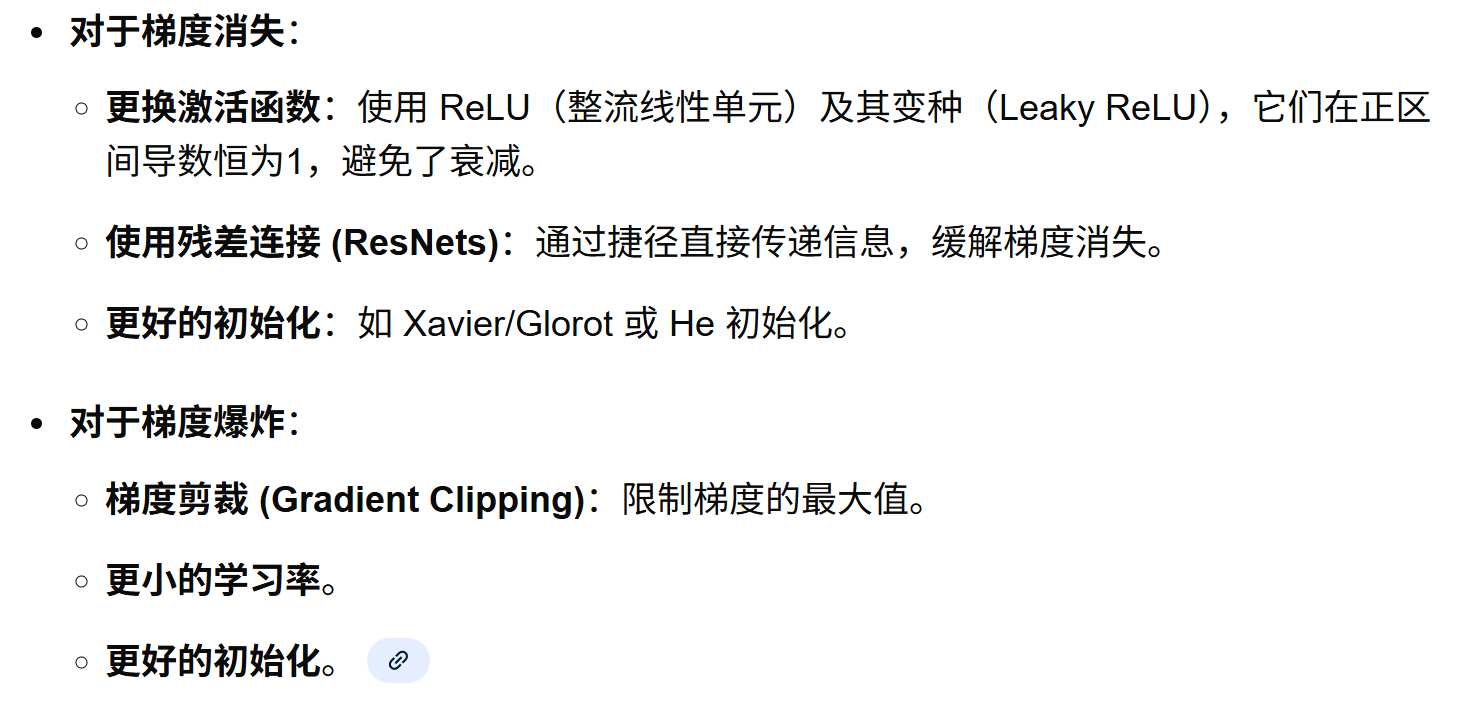

- 梯度爆炸与梯度消失

-

- 梯度消失(vanishing)

- 梯度爆炸(exploding)

- 解决方法

- 一些题外话

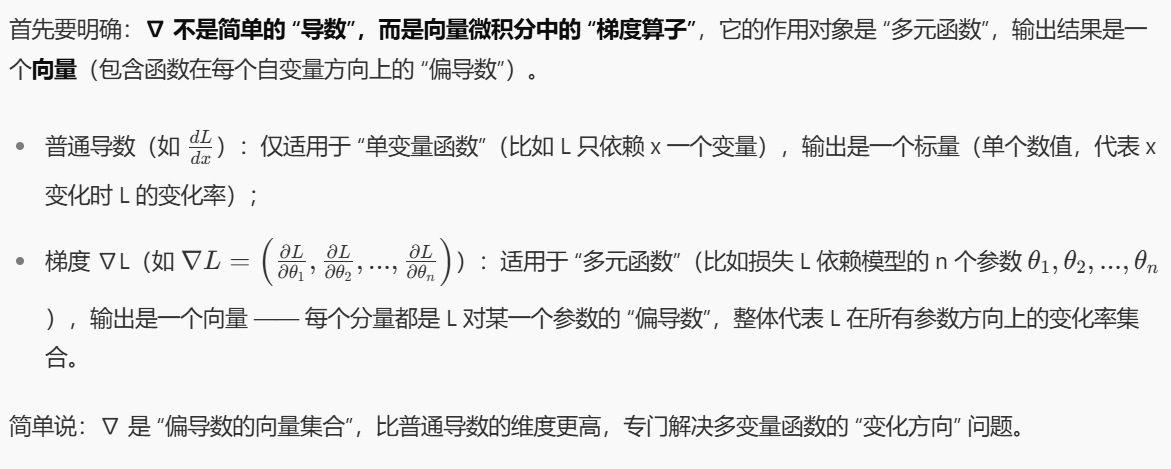

-

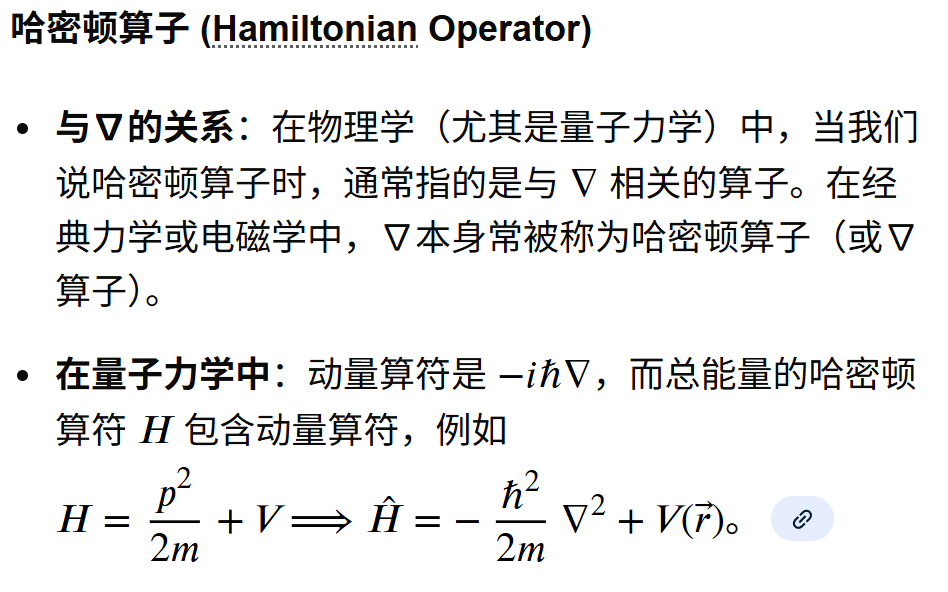

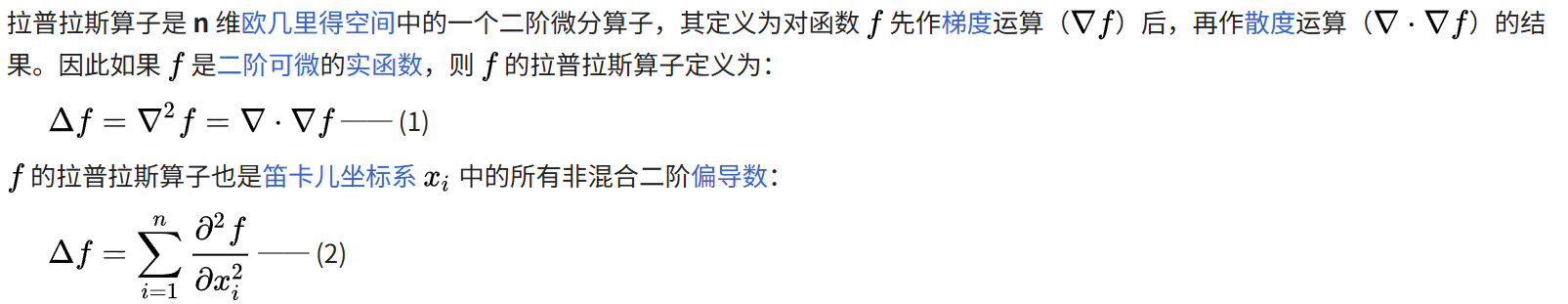

- 首先是数学符号说明,都是一些微积分中简单的符号

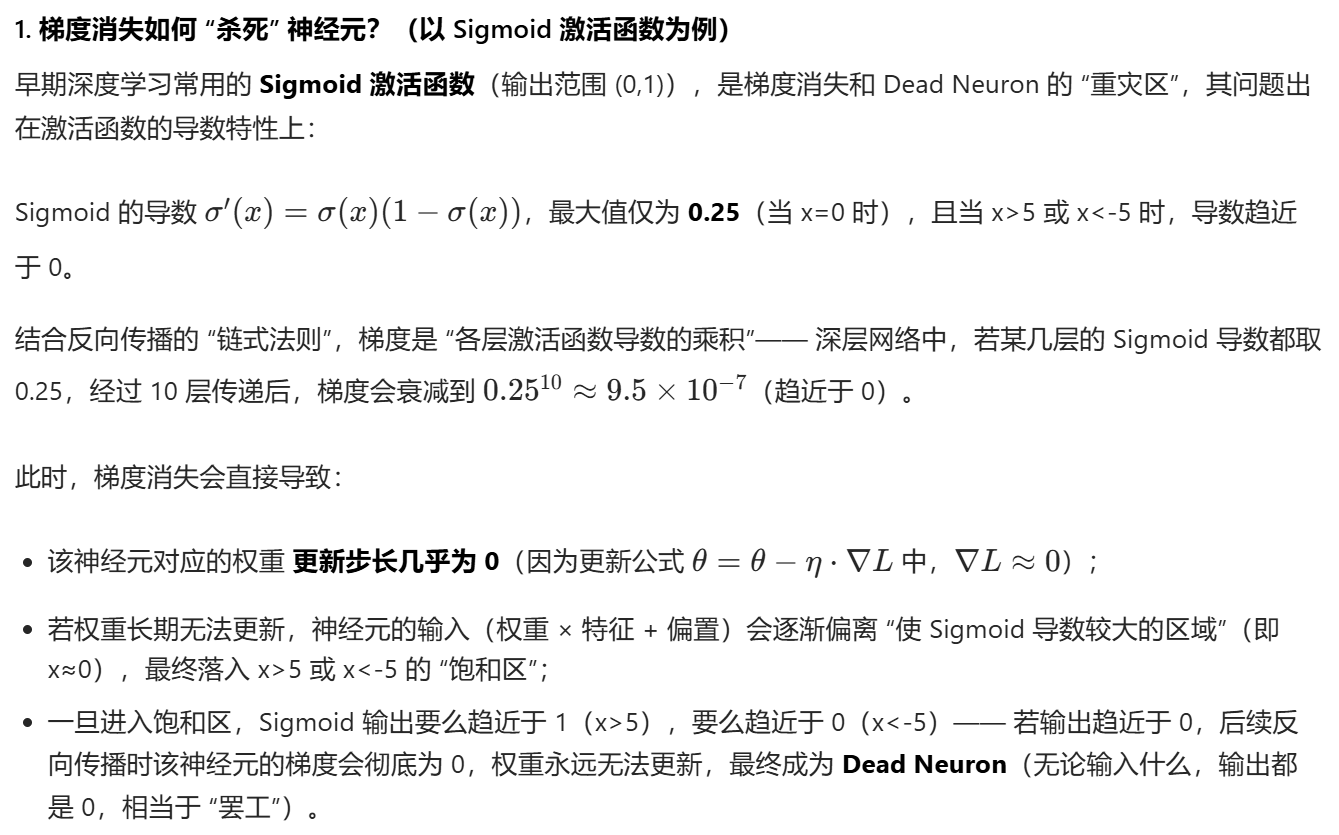

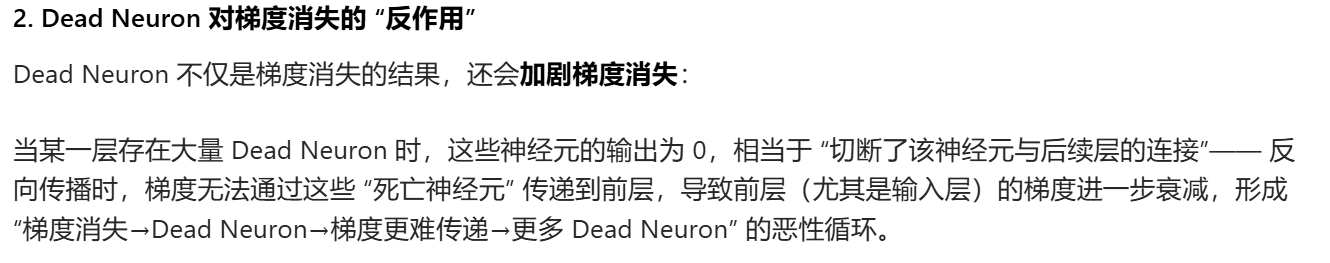

- [梯度消失与Dead Neuron、Dropout等](#梯度消失与Dead Neuron、Dropout等)

-

- [梯度消失 ↔ Dead Neuron:"因" 与 "果" 的关系](#梯度消失 ↔ Dead Neuron:“因” 与 “果” 的关系)

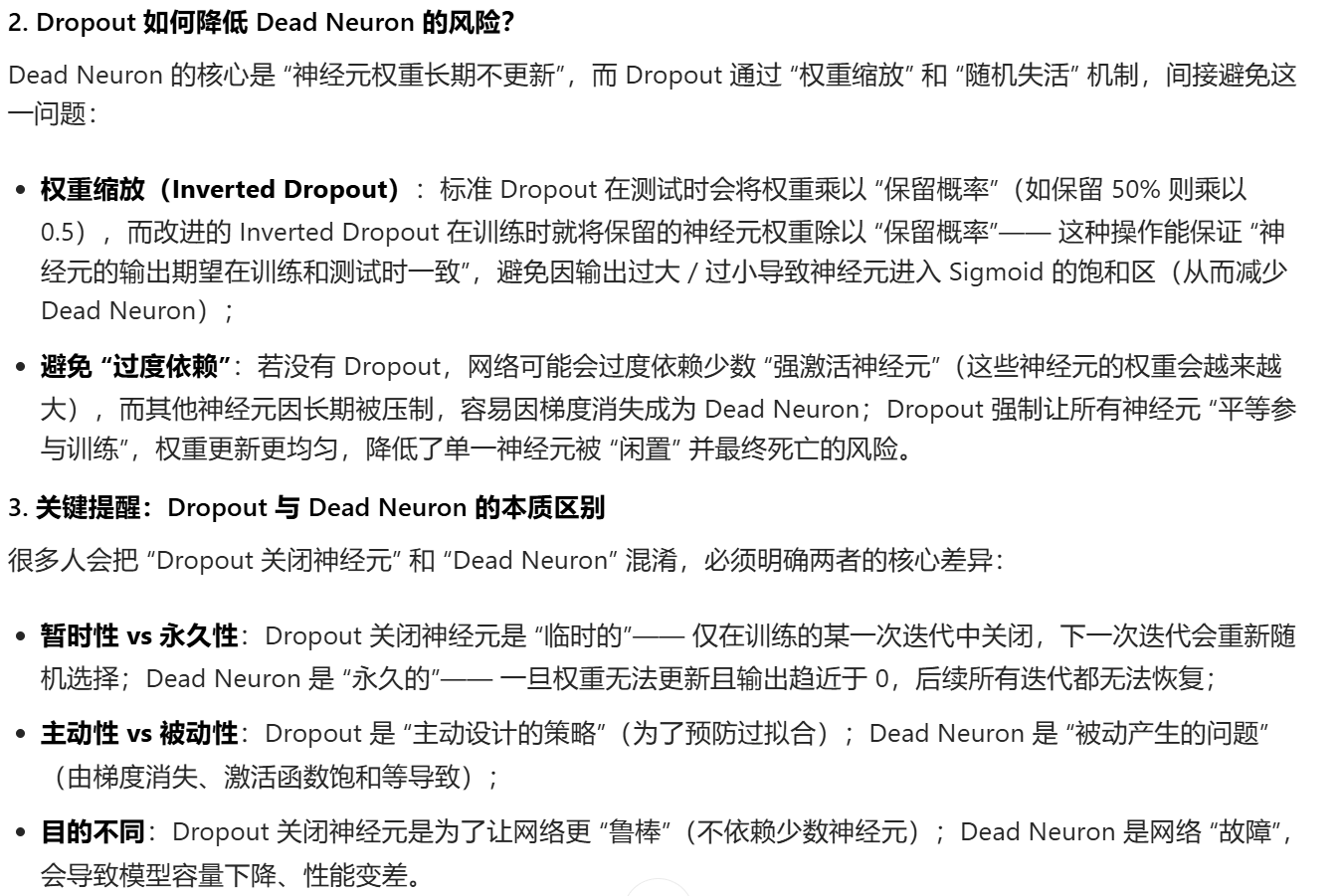

- [Dropout ↔ 梯度消失 / Dead Neuron:"缓解工具" 与 "问题" 的关系](#Dropout ↔ 梯度消失 / Dead Neuron:“缓解工具” 与 “问题” 的关系)

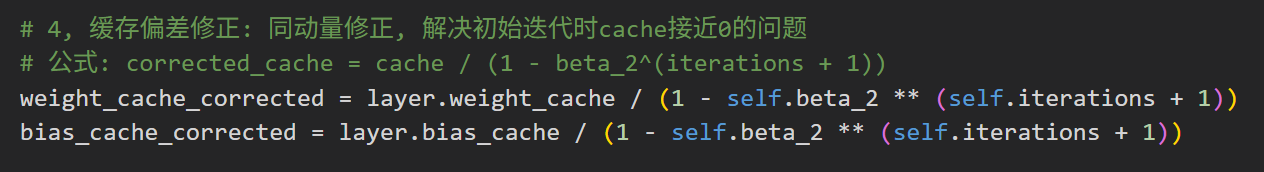

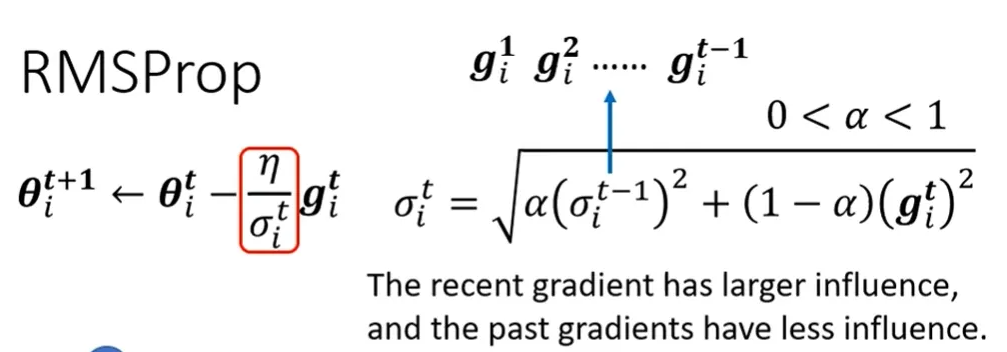

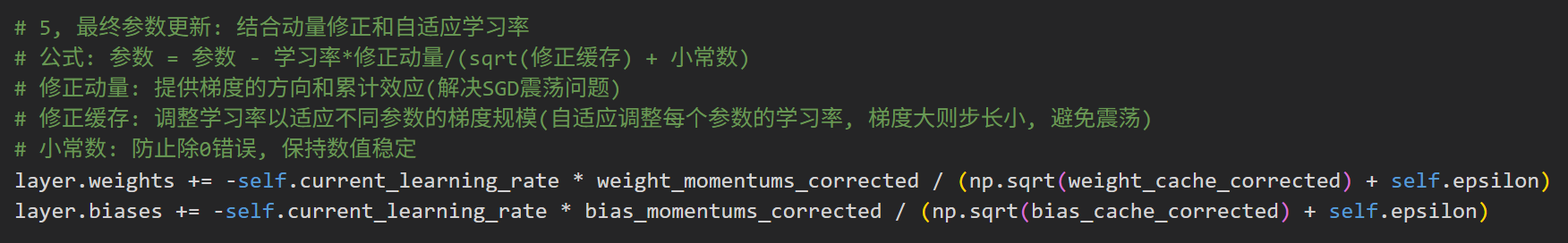

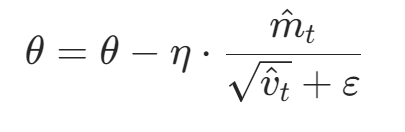

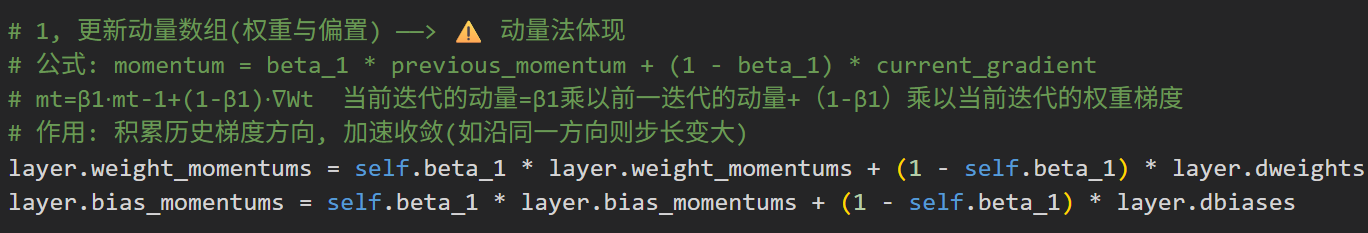

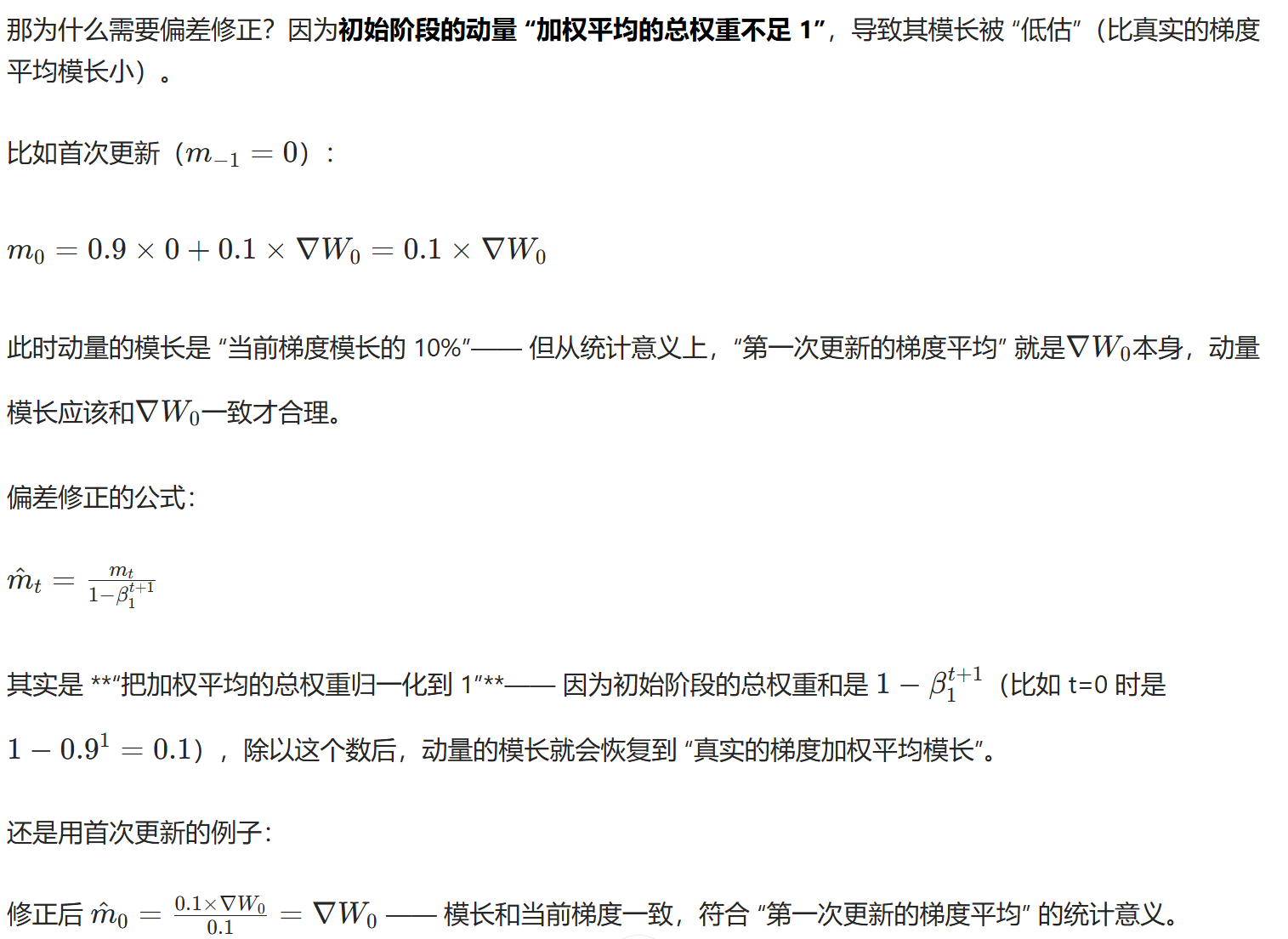

- 为什么要修正动量偏差?

-

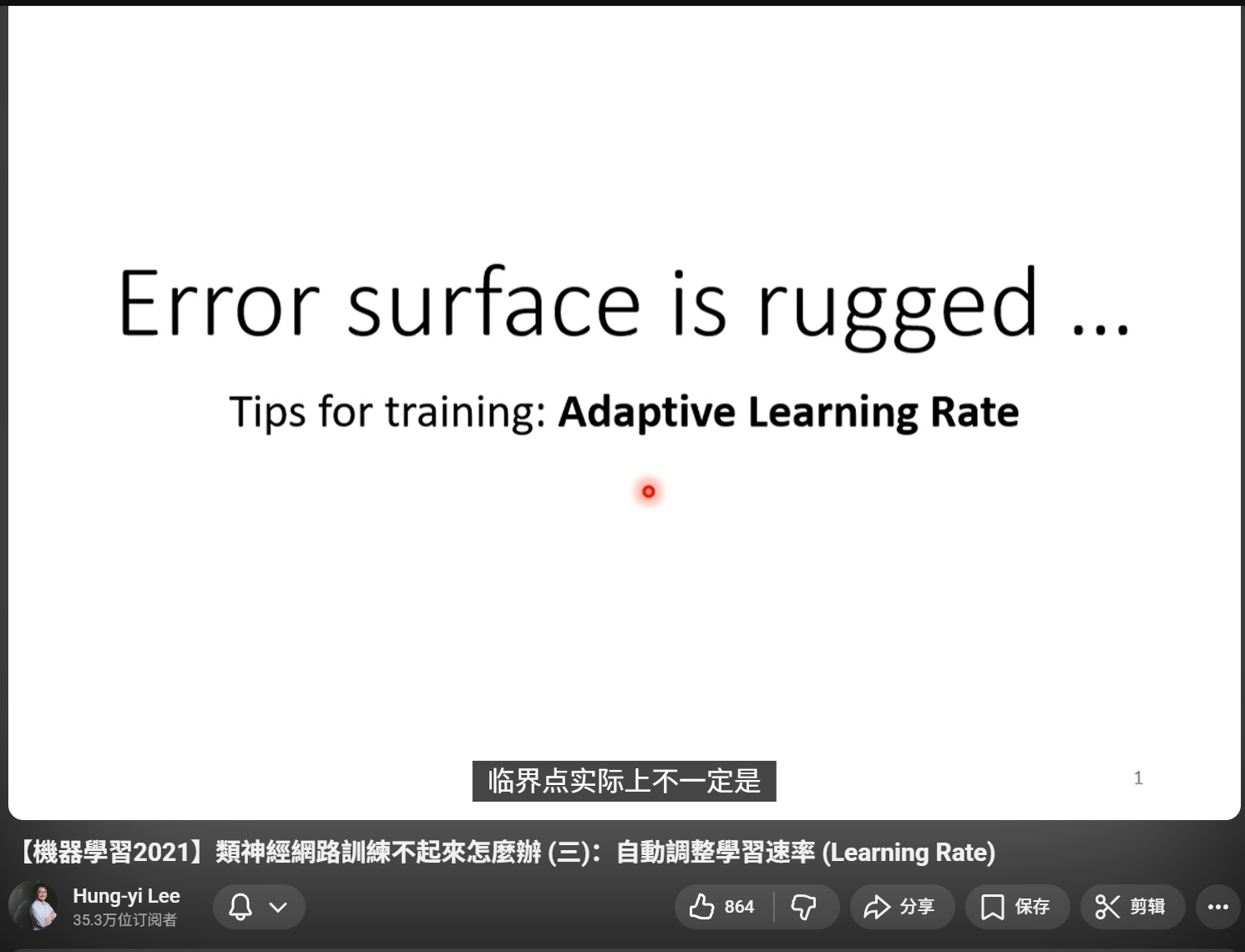

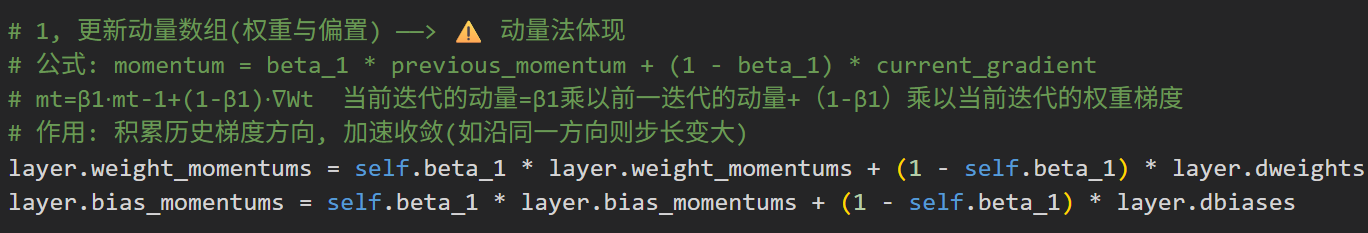

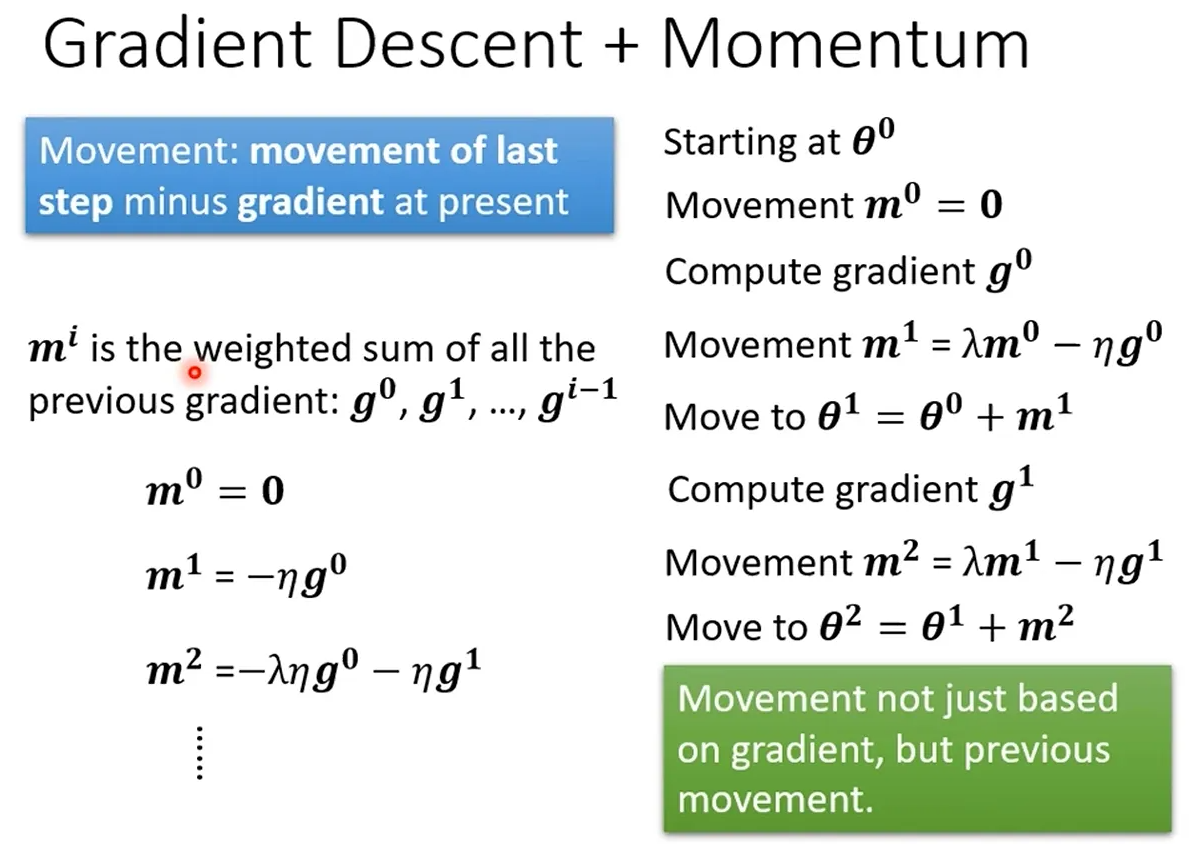

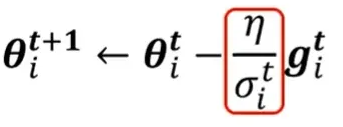

- [1. 原始公式(θ=θ−η⋅∇L):"只看脚下,步长固定"](#1. 原始公式(θ=θ−η⋅∇L):“只看脚下,步长固定”)

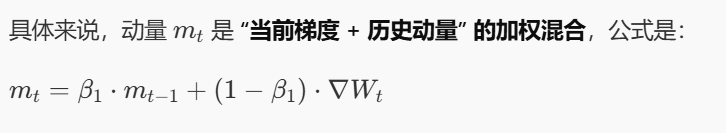

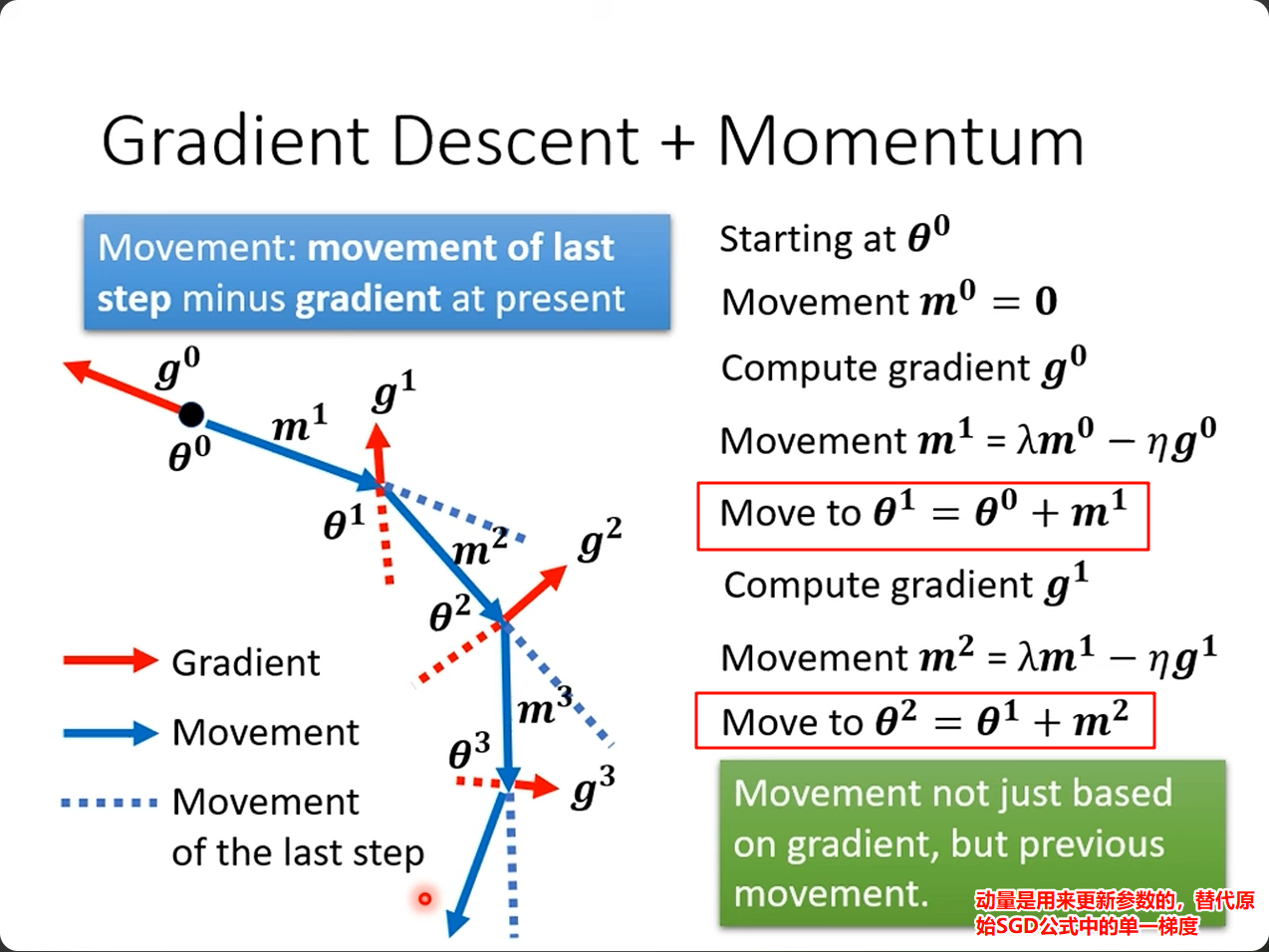

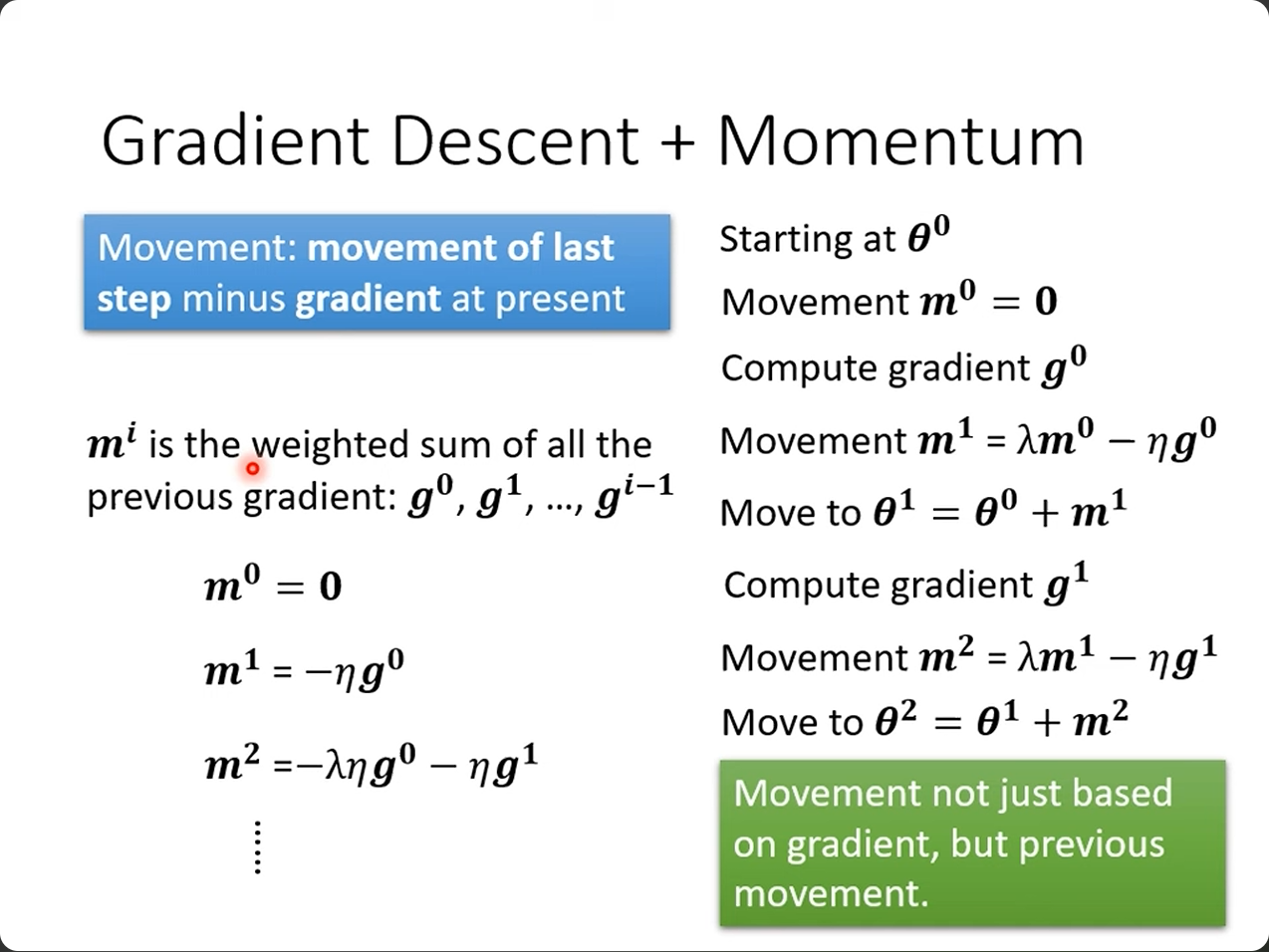

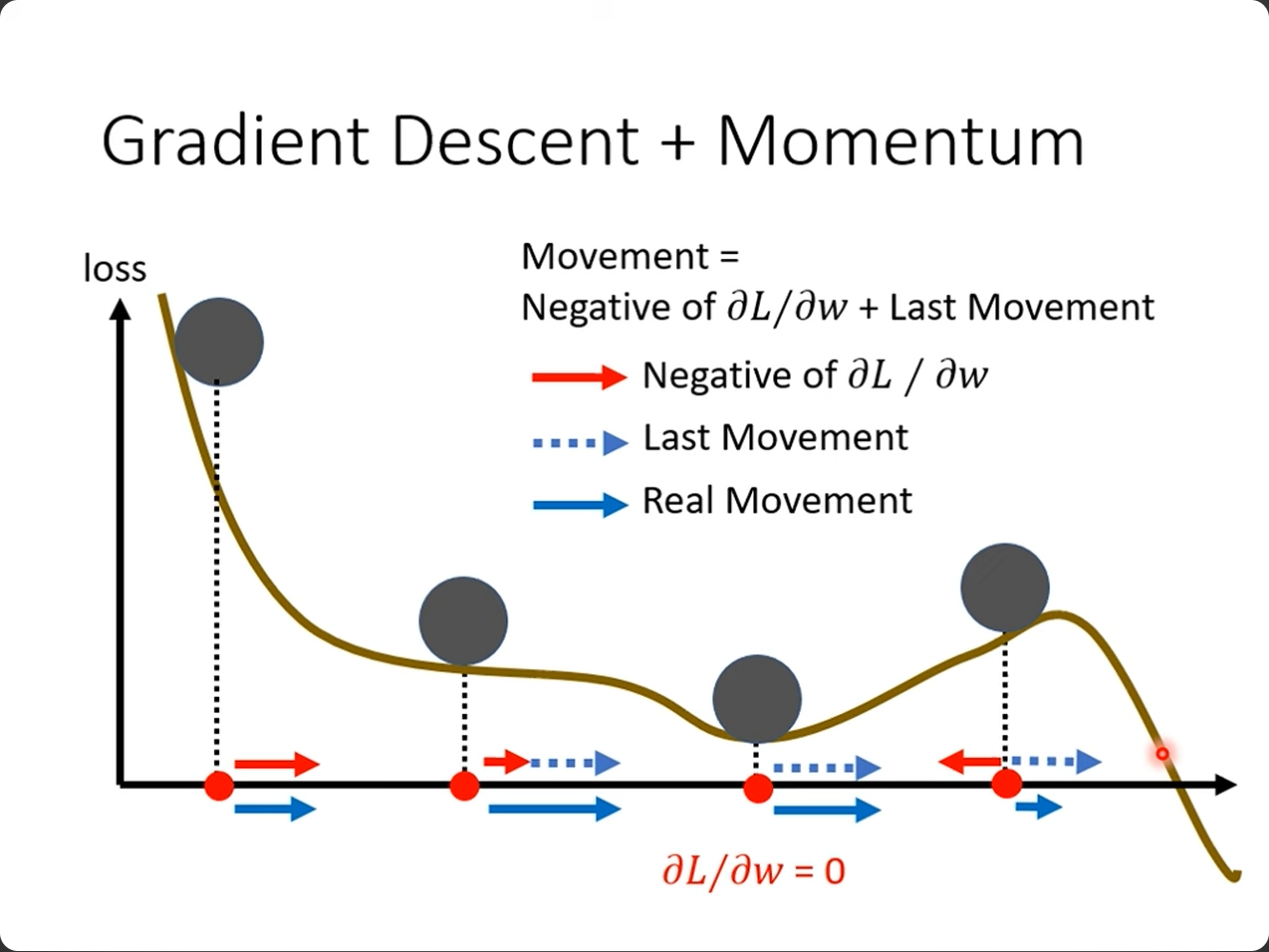

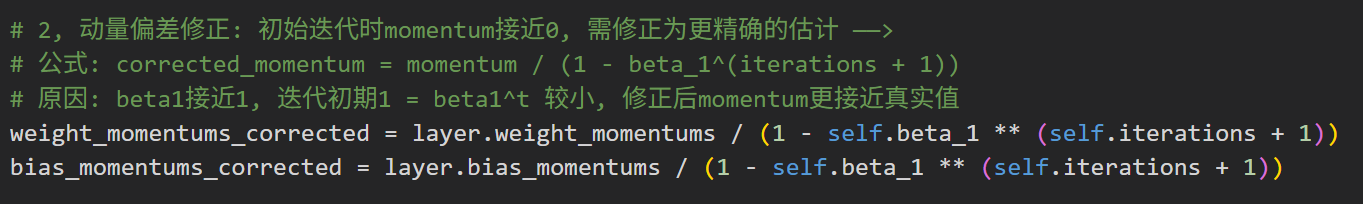

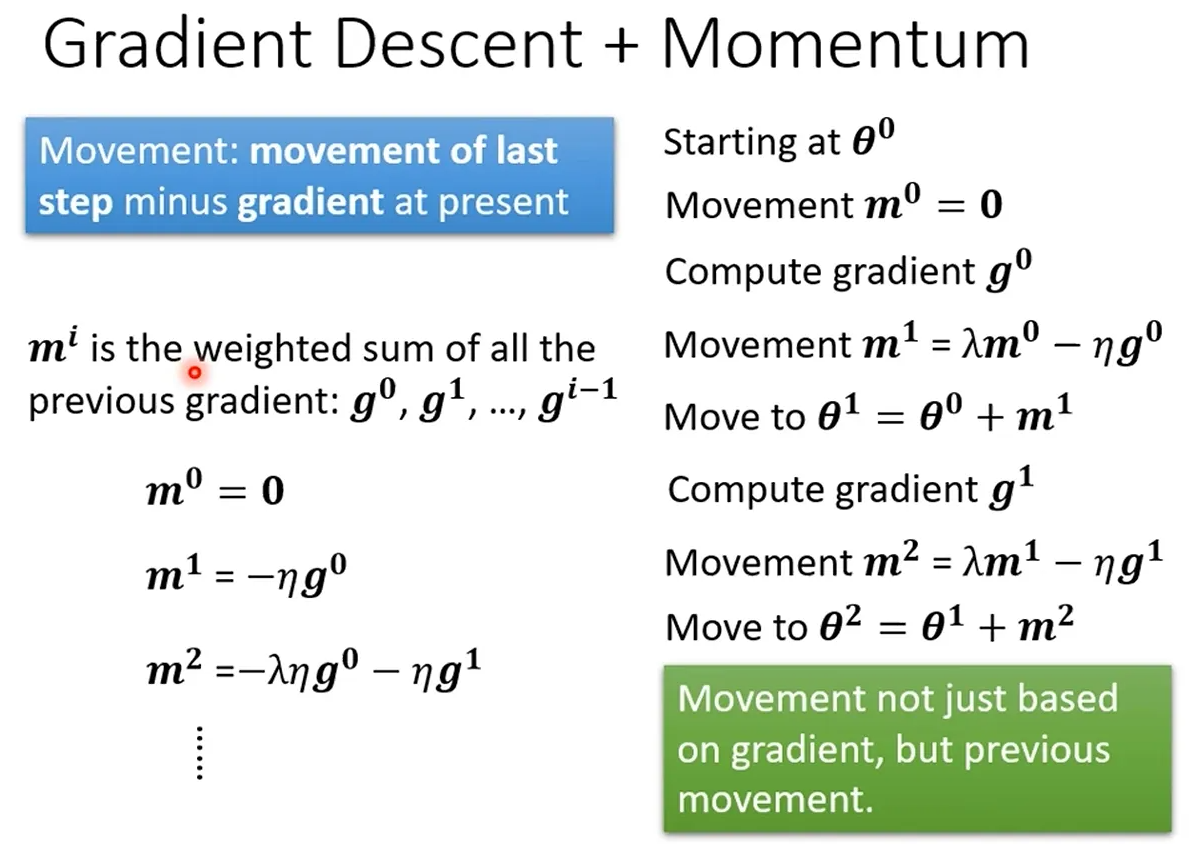

- [2. 动量(对应代码里的weight_momentums):"加上惯性,走得更稳更快"](#2. 动量(对应代码里的weight_momentums):“加上惯性,走得更稳更快”)

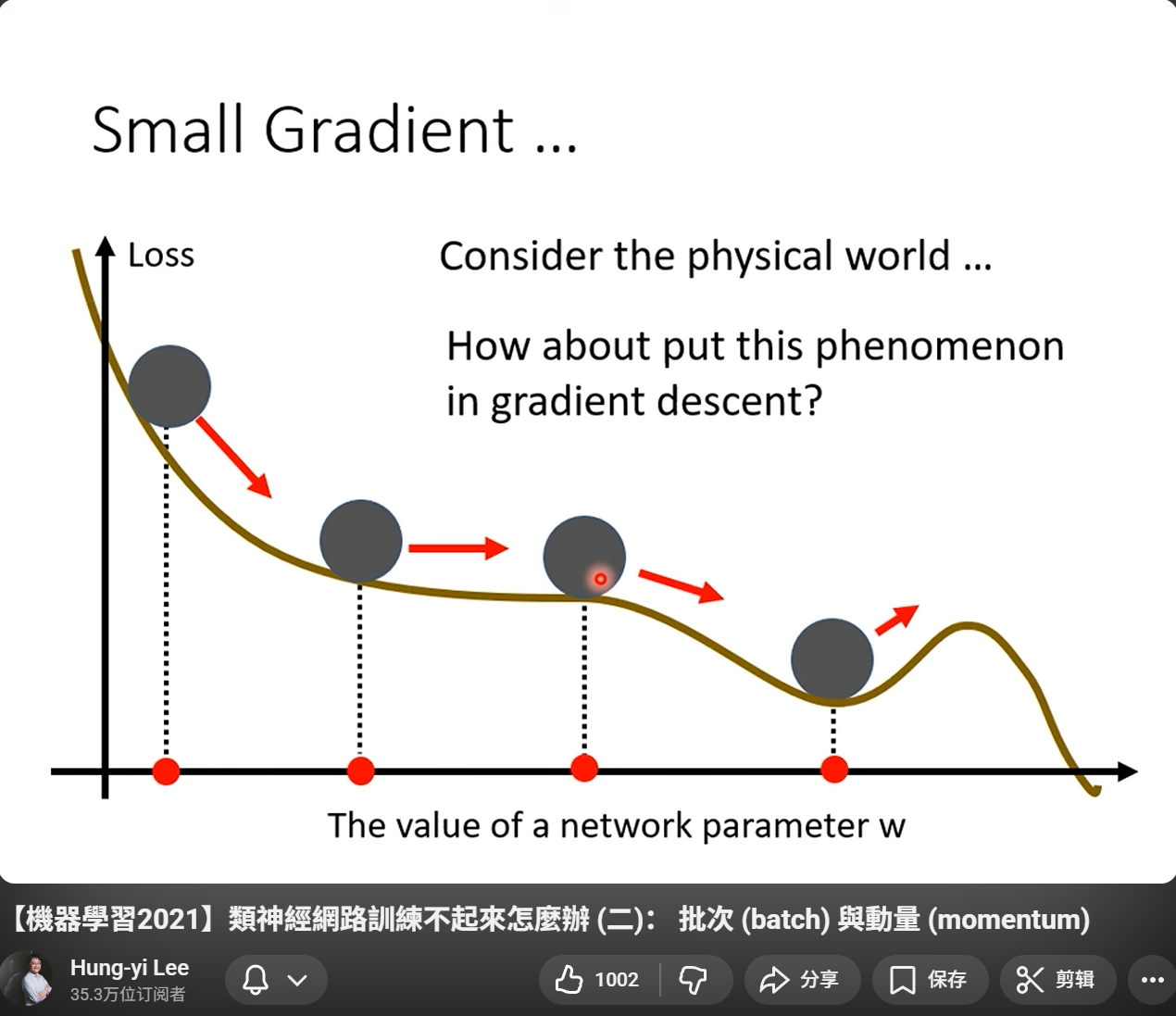

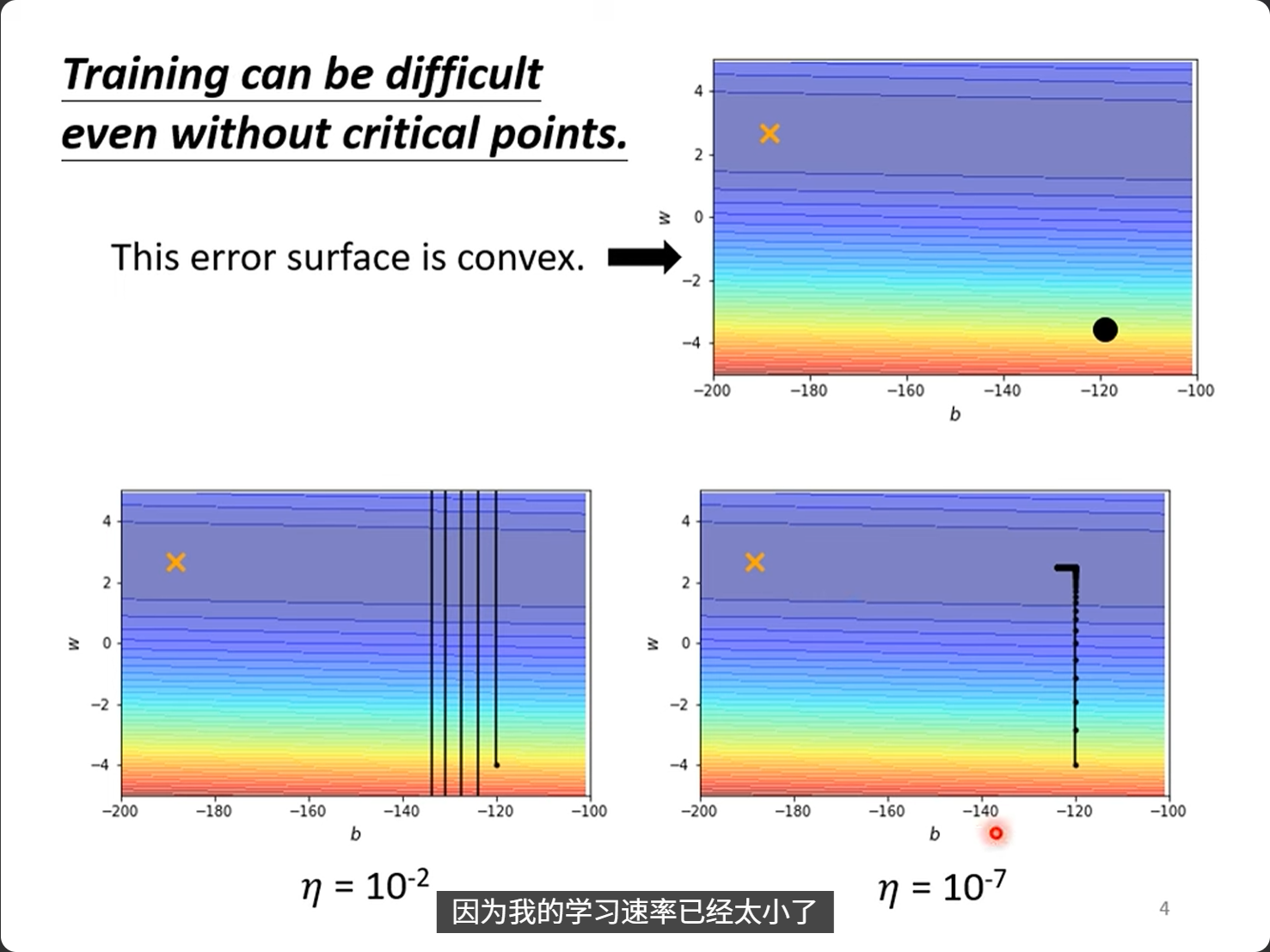

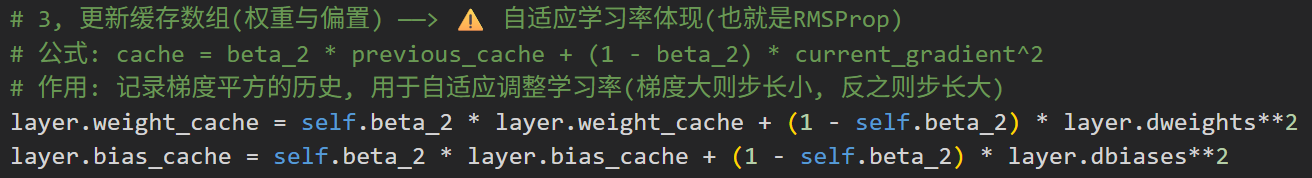

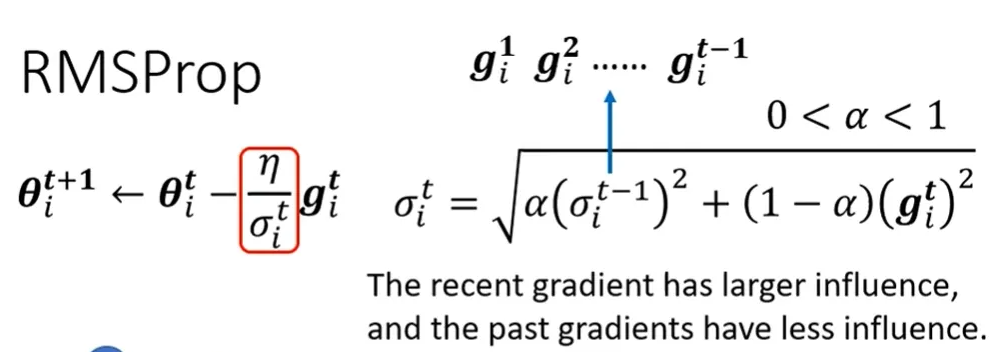

- 3,自适应学习率的问题

- [4. 缓存(对应代码里的weight_cache):"看之前的步长,灵活调整迈腿大小"](#4. 缓存(对应代码里的weight_cache):“看之前的步长,灵活调整迈腿大小”)

- 三者的逻辑关系(对比表)

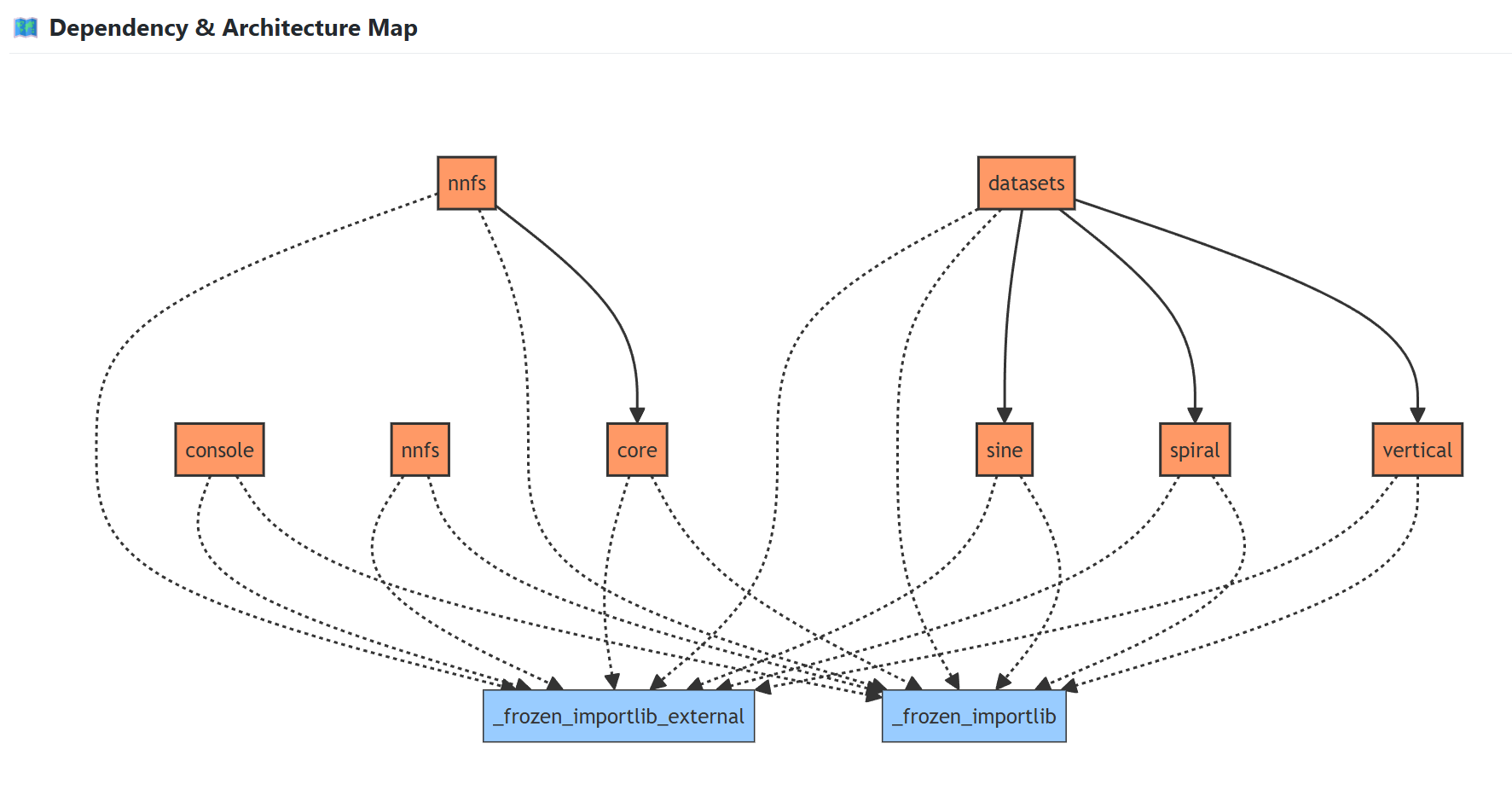

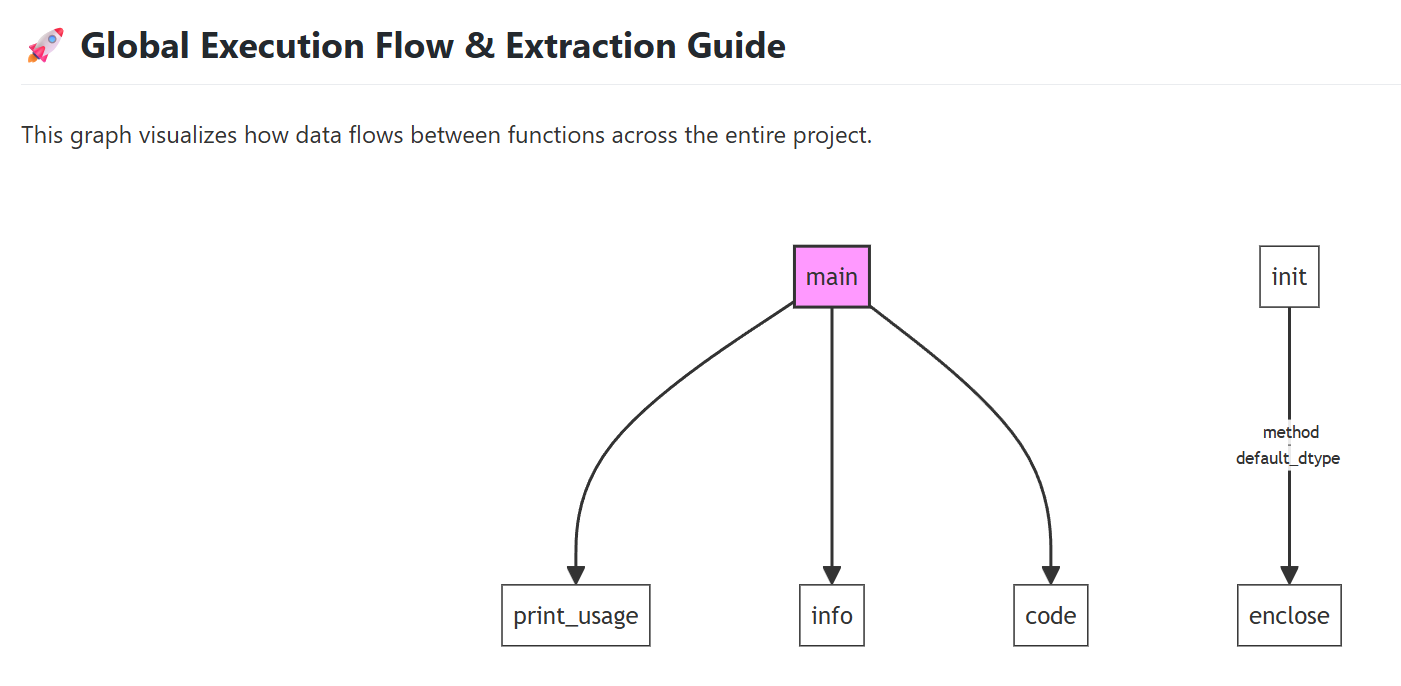

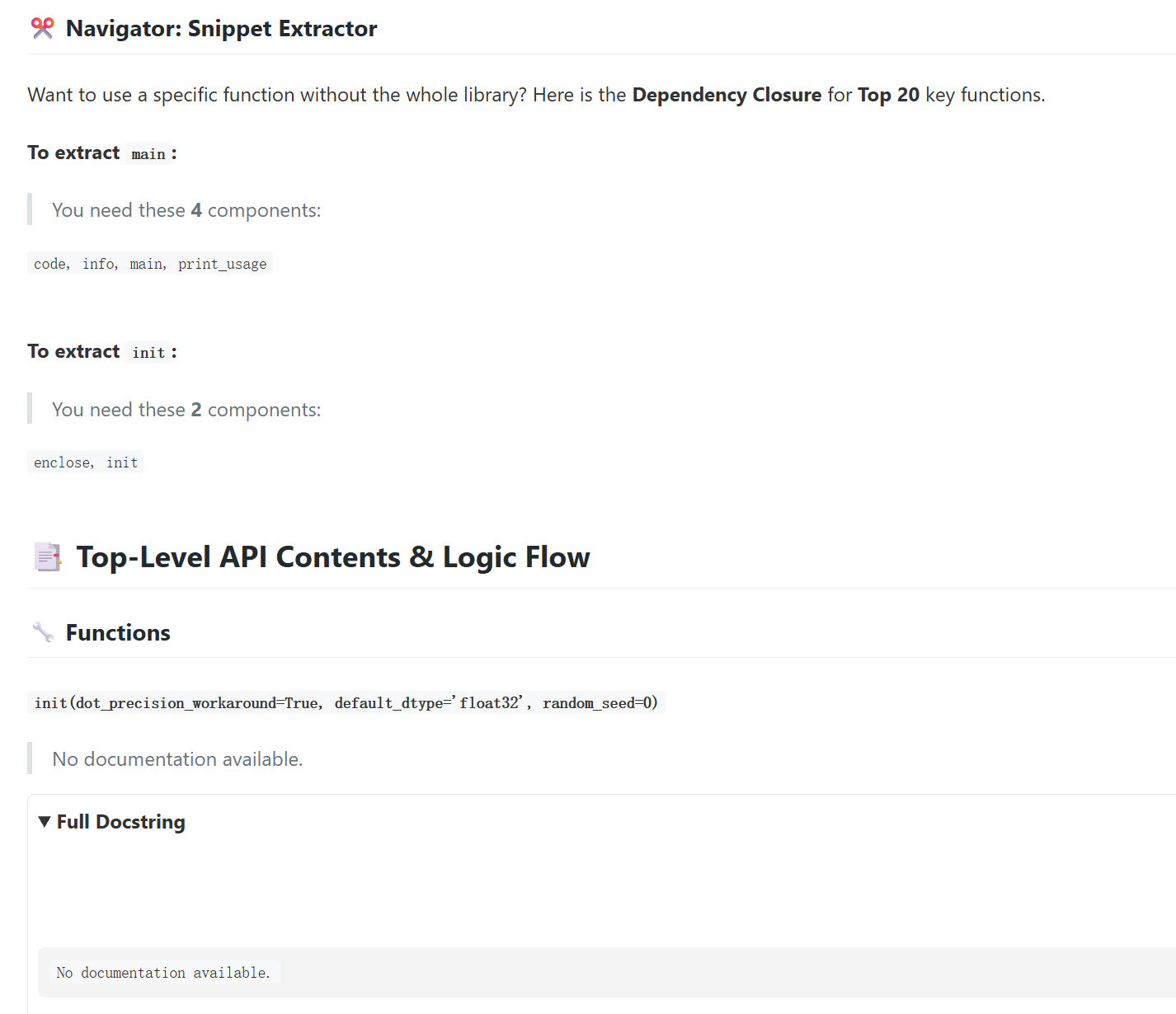

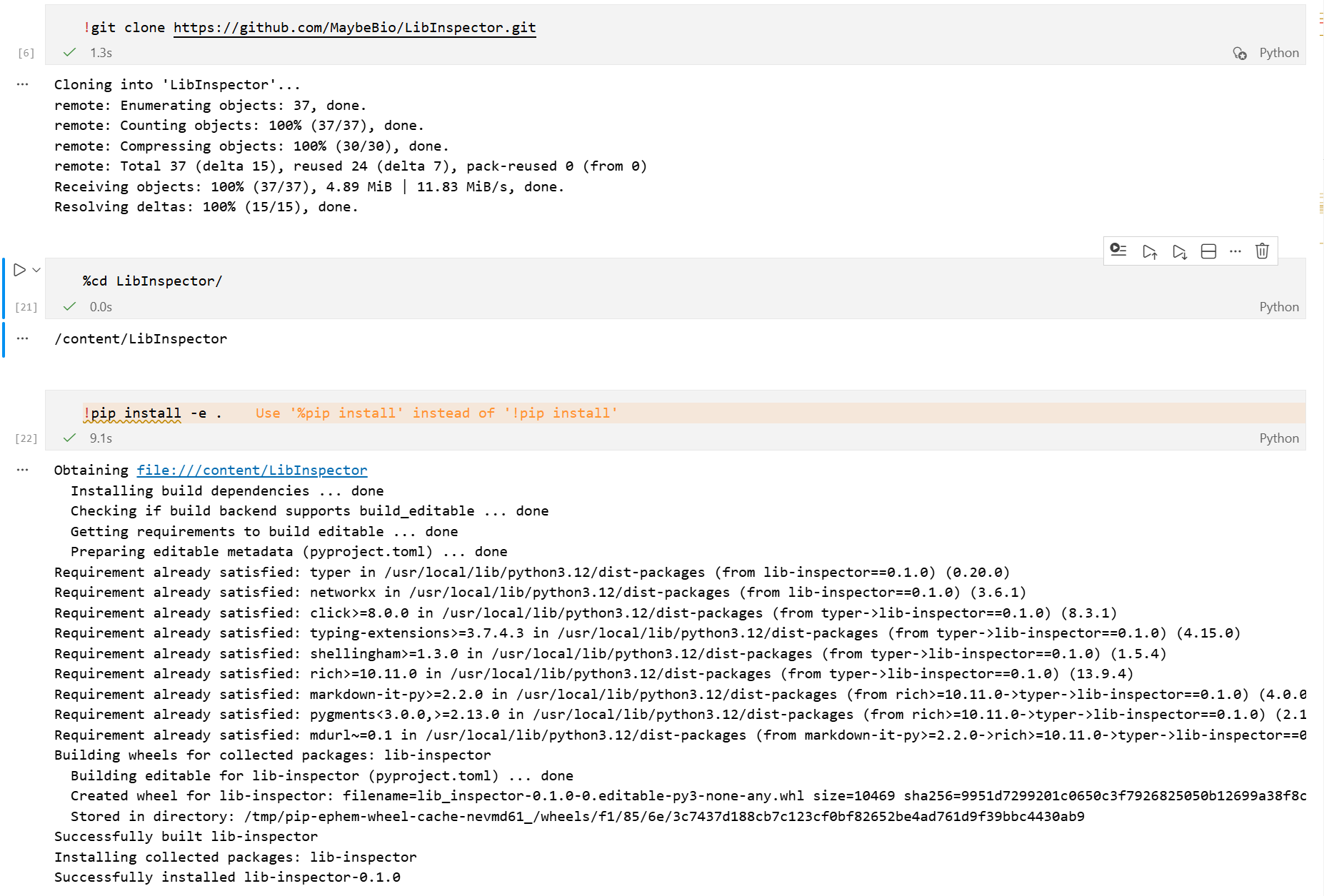

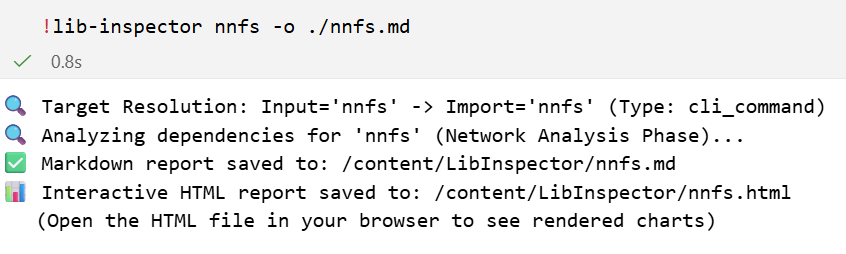

- 11,检查一下nnfs

背景

这个系列其实是当初和鱼书一起刷的,但是鱼书我很早就停了更新推文。

考虑到这个系列其实是AI4S非常典型的教程系列,而且是正经的为所有研究蛋白质、蛋白质组学、蛋白质模型的新手准备的一个AI4S的教程,所以开这个新坑。

最最最最最重要的是,最近才发现Colab在Vscode出了extension,是官方的拓展!不是之前开源社区的各种工具。

Google 在微软官方 Jupyter Extension 基础上开发了 Colab VS Code Extension 扩展,Colab Extension 通过 Kernel 选项将 Notebook 的执行交给 Colab Server。

详情可以参考我之前的博客:在vscode中使用colab的GPU算力

另外文件系统挂载的问题其实已经解决了,参考https://github.com/googlecolab/colab-vscode/issues/300#issuecomment-3689252902

目标

Pre准备

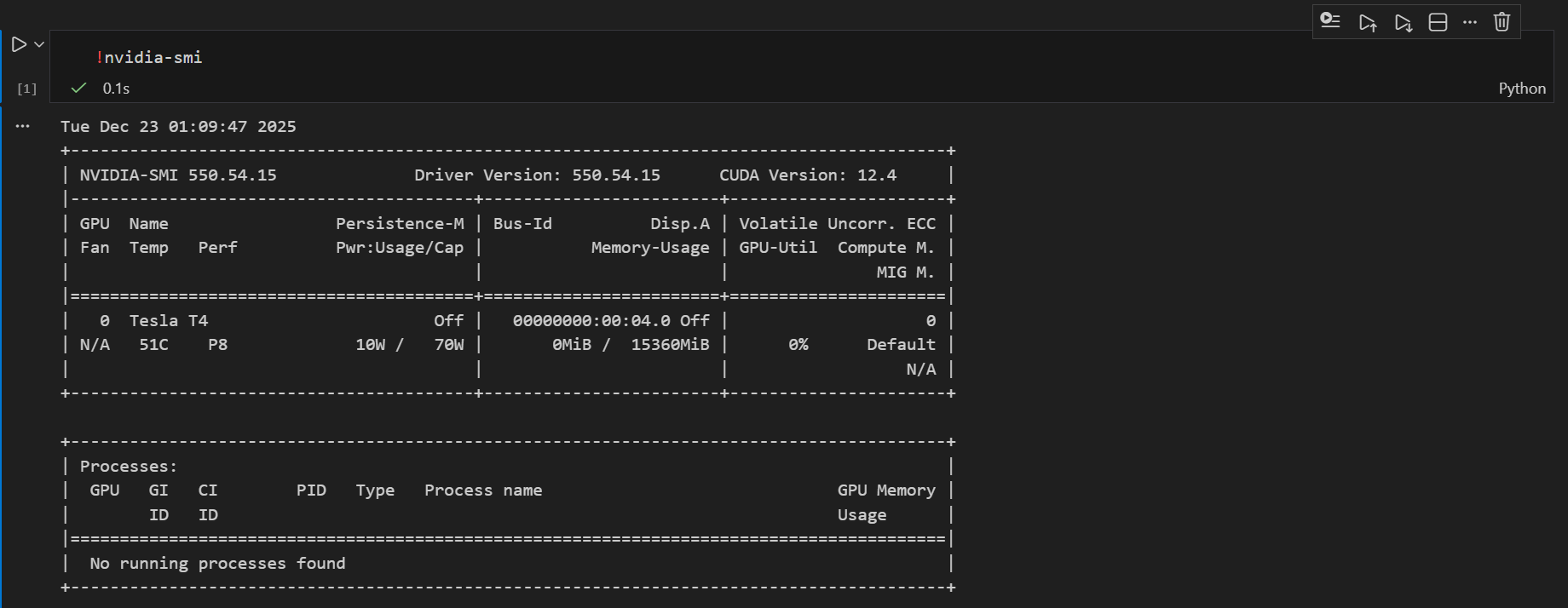

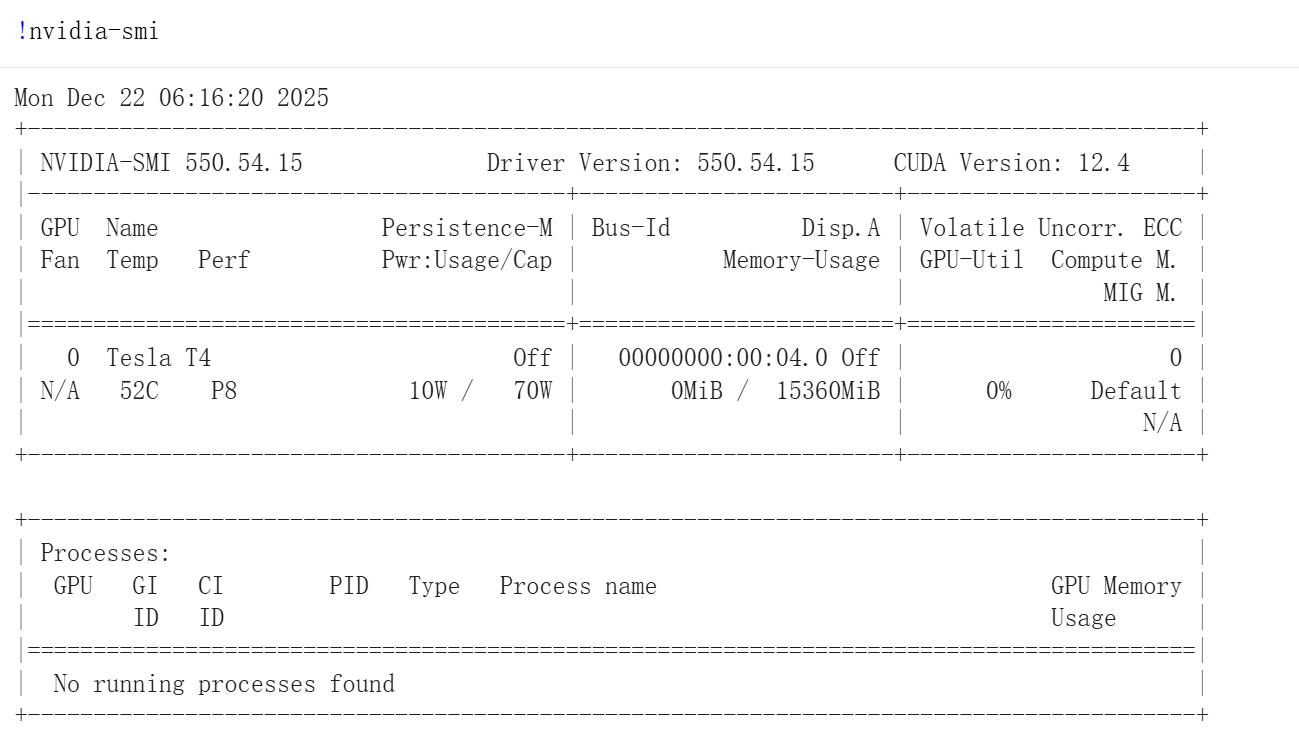

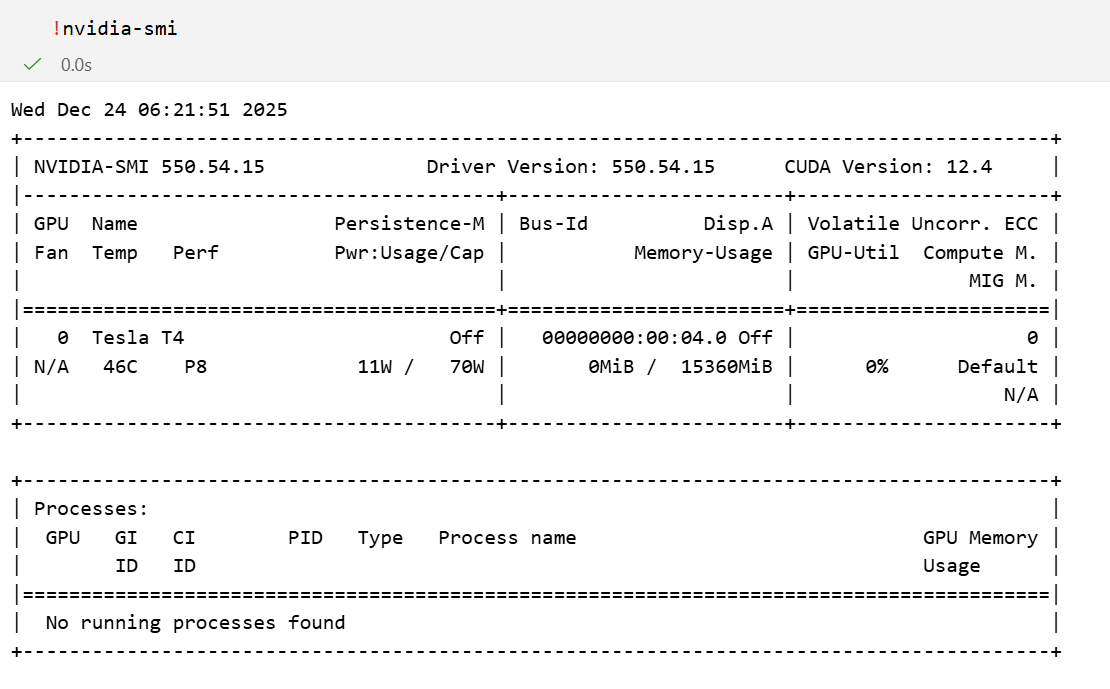

因为是在colab上实验的

python

!nvidia-smi

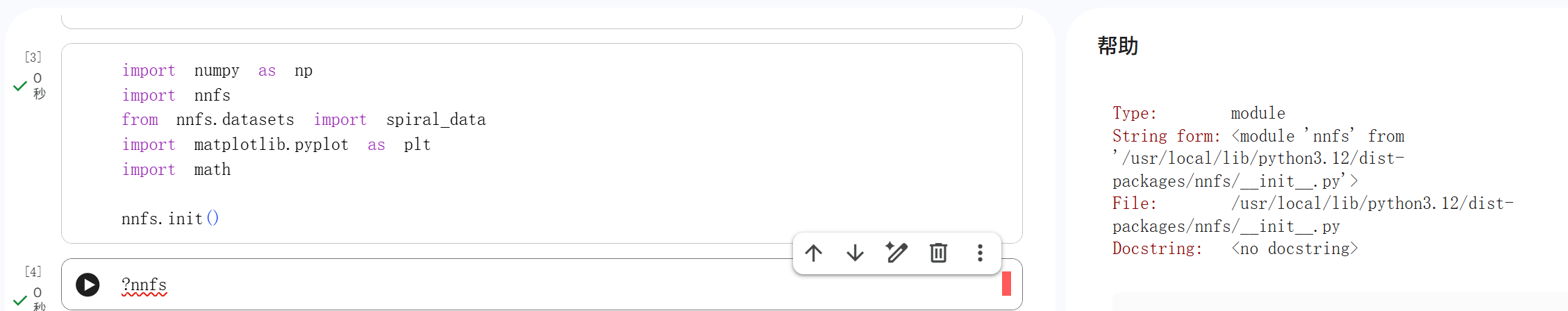

导入该库的一些数据、一些函数,都封装在了一个库中:nnfs

python

# package for creating our dataset

!pip install nnfs

python

import numpy as np

import nnfs

from nnfs.datasets import spiral_data

import matplotlib.pyplot as plt

import math

nnfs.init()这里的nnfs就是我们后续处理的一切数据基础,是一个module

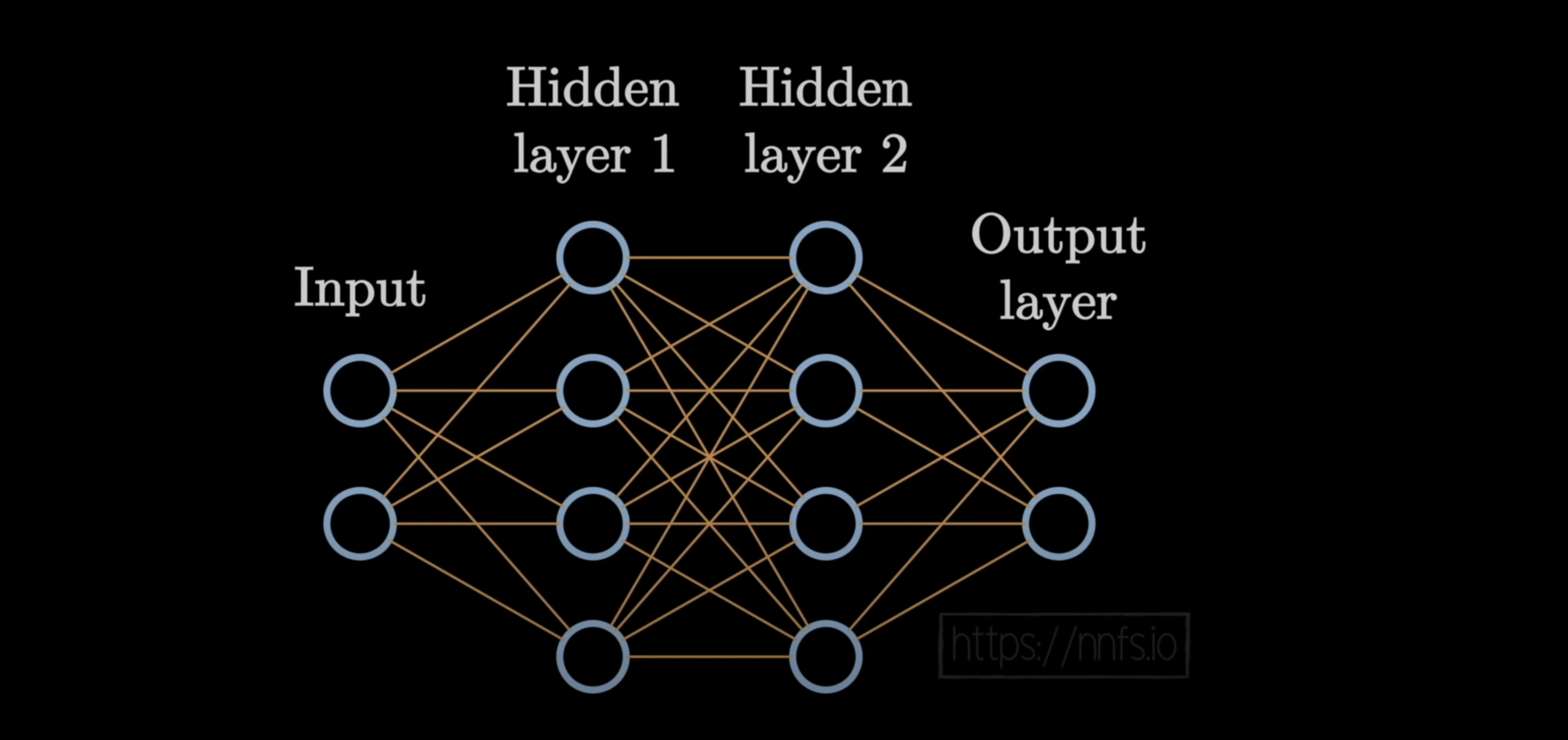

1,Introduction and coding our first neuron 编写第一个神经元

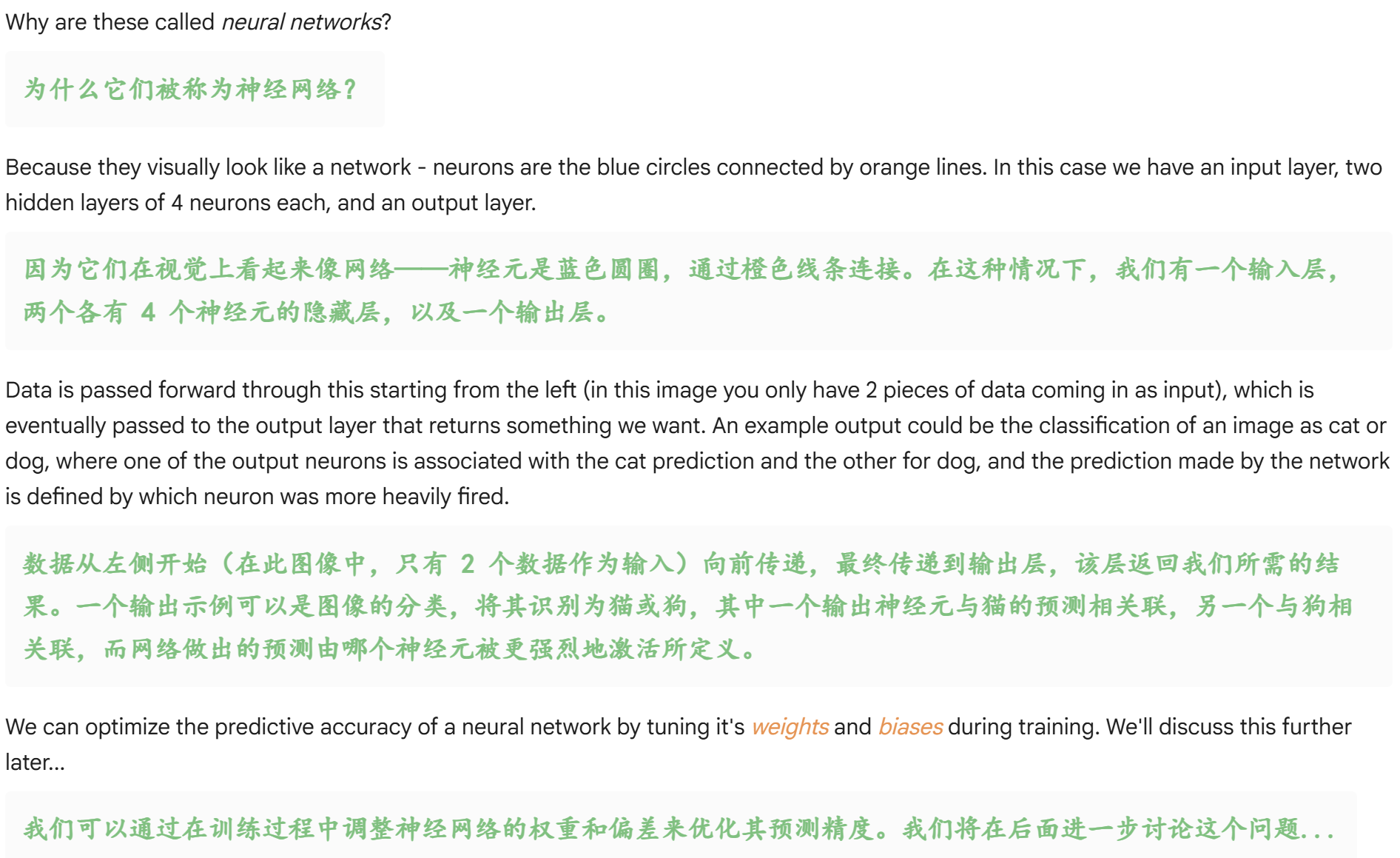

让我们计算前一层(有 3 个神经元)的输出:

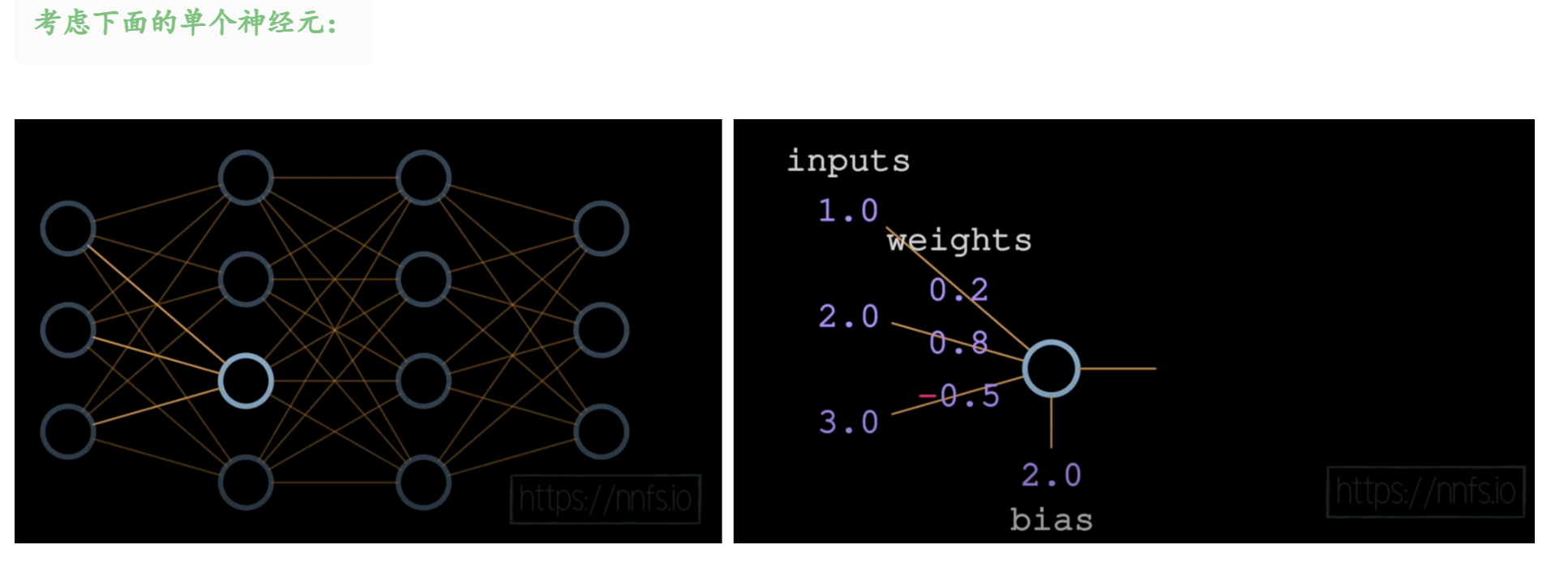

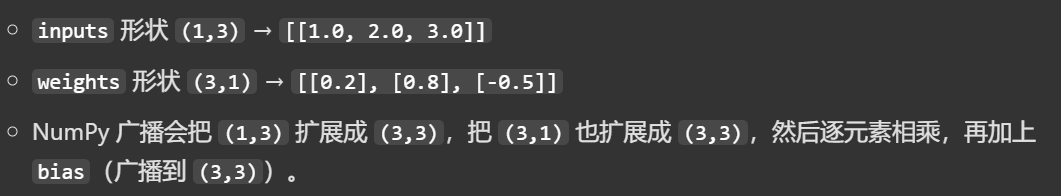

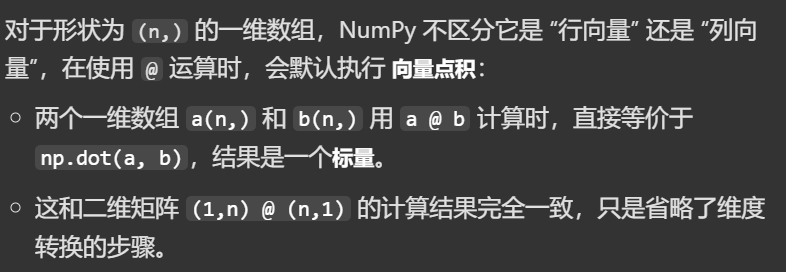

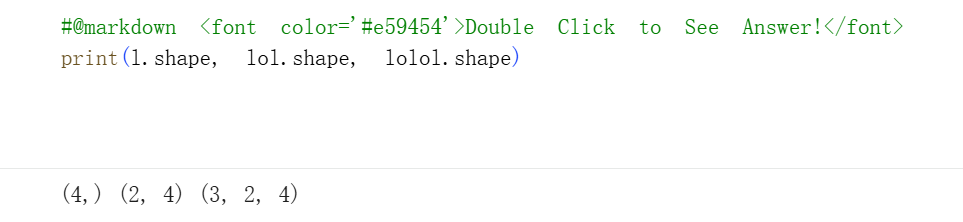

但是这两个神经元都是(3,),也就是说明 inputs 和 weights 都是一维数组,不是严格的二维矩阵。

张量运算

这里提一下深度学习里的张量运算:

张量维度是运算的前提:

深度学习框架(如 TensorFlow/PyTorch)和 NumPy 的矩阵乘法,都要求维度匹配(前一个矩阵的列数 = 后一个矩阵的行数)。

先总结一些深度学习常用矩阵运算,比如说画成1个列表,需要牢记:

| 运算类型 | 符号 / 函数 | 作用 | 代码示例 | 输出结果 | 深度学习场景 |

|---|---|---|---|---|---|

| 矩阵乘法 | @ / np.matmul() |

线性变换核心,满足 前阵列数 = 后阵行数 | inputs @ weights |

[[0.3]] |

全连接层 z = X @ W + b |

| 点积 | np.dot() |

一维向量内积;二维等价于 np.matmul |

np.dot(inputs, weights) |

[[0.3]] |

向量相似度、注意力得分 |

| 逐元素乘法 | * |

对应位置相乘,触发广播 | inputs * weights |

[[0.2, 0.4, 0.6], [0.8, 1.6, 2.4], [-0.5, -1.0, -1.5]] |

注意力权重加权、元素级更新 |

| 广播加法 | + |

标量 / 向量与矩阵自动扩展相加 | (inputs @ weights) + bias |

[[2.3]] |

偏置项添加(z = X@W + b ) |

| 矩阵转置 | .T |

行列互换,调整维度顺序 | weights.T |

[[0.2, 0.8, -0.5]] |

维度适配、矩阵逆运算前置 |

| 元素级激活(ReLU) | np.maximum(x, 0) |

引入非线性,过滤负值 | np.maximum(inputs @ weights, 0) |

[[0.3]] |

隐藏层激活函数 |

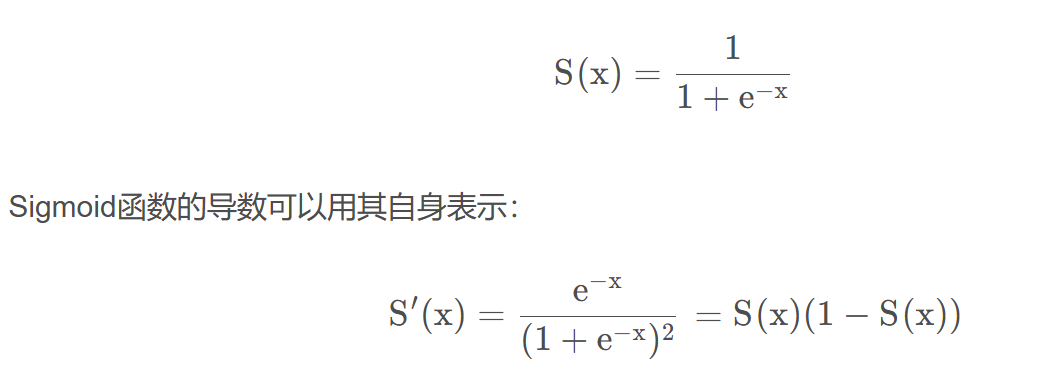

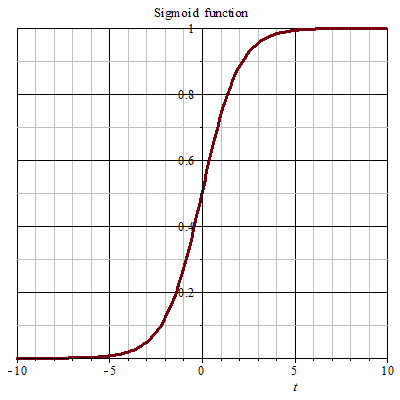

| 元素级激活(Sigmoid) | 1/(1+np.exp(-x)) |

输出映射到 (0,1) | 1/(1+np.exp(-(inputs @ weights + bias))) |

[[0.9102]] |

二分类输出层 |

| 矩阵求和 | np.sum() |

降维,计算元素总和 | np.sum(inputs) |

6.0 |

损失函数计算、池化简化 |

| 矩阵求均值 | np.mean() |

降维,计算元素均值 | np.mean(inputs) |

2.0 |

数据归一化、批归一化 |

| 批量矩阵乘法 | np.matmul() |

多组样本同时运算 | inputs_batch = np.array([[1,2,3], [4,5,6]]) inputs_batch @ weights |

[[0.3], [1.1]]</font> |

批量处理样本(batch_size × in_dim ) |

NumPy 乘法及深度学习常用矩阵运算

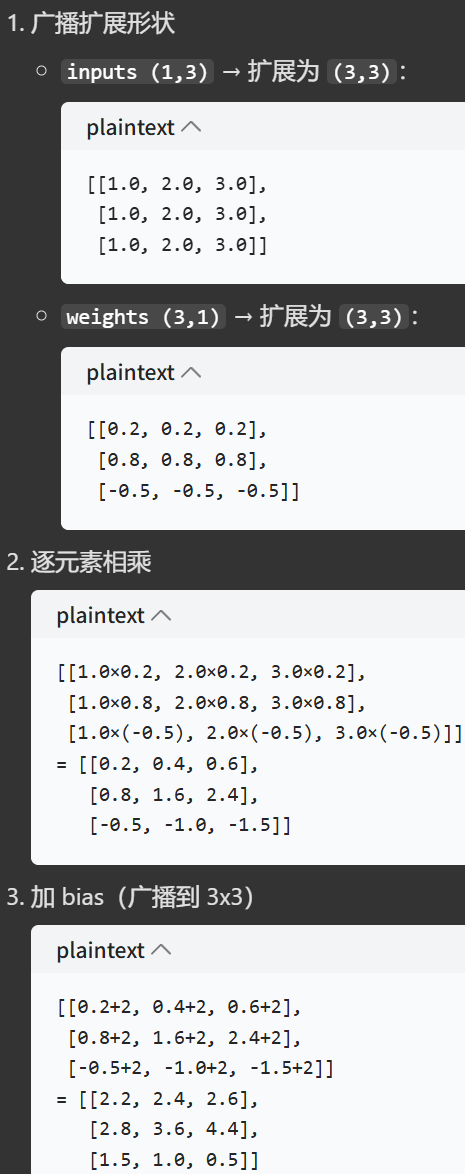

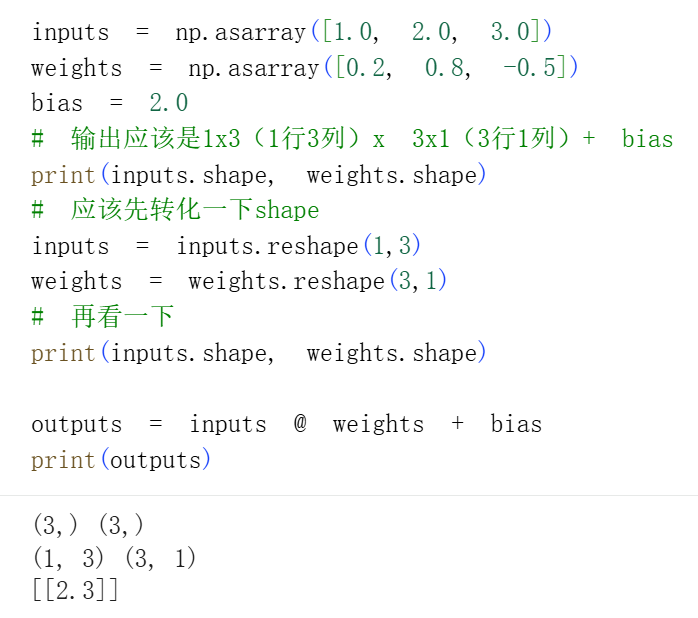

假设我们完全没有深度学习的基础,只有线性代数的直觉+一点numpy运算基础,我们会reshape

python

inputs = np.asarray([1.0, 2.0, 3.0])

weights = np.asarray([0.2, 0.8, -0.5])

bias = 2.0

# 输出应该是1x3(1行3列)x 3x1(3行1列)+ bias

print(inputs.shape, weights.shape)

# 应该先转化一下shape

inputs = inputs.reshape(1,3)

weights = weights.reshape(3,1)

# 再看一下

print(inputs.shape, weights.shape)

outputs = inputs * weights + bias

print(outputs)

但是符号不能想当然!我们标量运算中的符号确实是乘法,但在数组也就是张量运算中却是逐元素乘法。

所以上面其实是做的一个最基础的逐元素乘法,也是numpy中基础知识:

规则是 两个数组的形状能通过广播匹配,它不会做矩阵乘法,而是把两个数组的元素逐个相乘。

在我们的代码里:

简单的算一下就知道了:

1个核心乘法类型对照表(逐元素 / 矩阵 / 点积):

| 运算类型 | 运算符 / 函数 | 语法示例 | 形状变化 | 计算逻辑 | 输出结果(示例) | 适用场景 |

|---|---|---|---|---|---|---|

| 逐元素乘法 | * |

inputs_1x3 * weights_3x1 |

(1,3) × (3,1) → (3,3) |

触发广播,两个数组都扩展为(3,3) 后对应位置相乘 |

[[0.2, 0.4, 0.6], [0.8, 1.6, 2.4], [-0.5, -1.0, -1.5]] |

同形状数组元素级操作,深度学习中权重元素级更新 |

| 矩阵乘法 | @ 或 np.matmul() |

inputs_1x3 @ weights_3x1 np.matmul(inputs_1x3, weights_3x1) |

(1,3) × (3,1) → (1,1) |

严格遵循矩阵乘法规则:前阵列数 = 后阵行数 | [[0.3]] |

深度学习全连接层、线性变换的核心运算 |

| 点积 | np.dot() |

np.dot(inputs_1x3, weights_3x1) |

(1,3) × (3,1) → (1,1) |

一维数组返回标量;二维数组等价于np.matmul |

[[0.3]] |

向量内积计算、相似度度量 |

所以我们这里应该改成@符号

plain

inputs = np.asarray([1.0, 2.0, 3.0])

weights = np.asarray([0.2, 0.8, -0.5])

bias = 2.0

# 输出应该是1x3(1行3列)x 3x1(3行1列)+ bias

print(inputs.shape, weights.shape)

# 应该先转化一下shape

inputs = inputs.reshape(1,3)

weights = weights.reshape(3,1)

# 再看一下

print(inputs.shape, weights.shape)

outputs = inputs @ weights + bias

print(outputs)

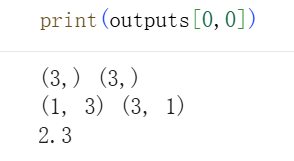

当然现在shape是1x1,变成了二维数组,我们只需要取标量

细节就是:

python

# this will be the input to our current neuron

inputs = np.array([1, 2, 3])

# every unique input will have a unique weight associated with it

# since we have three inputs, we have 3 weights

weights = np.array([0.2, 0.8, -0.5])

# every unique neuron has a unique bias

bias = 2

# output from our neuron is the input*weight + bias

output = inputs[0]*weights[0] + inputs[1]*weights[1] + inputs[2]*weights[2] + bias

print(output)其他的一些深度学习矩阵运算符的对照表:

| 运算名称 | 运算符 / 函数 | 作用 | 深度学习应用场景 | 示例(基于本文数据) |

|---|---|---|---|---|

| 矩阵转置 | .T |

行列互换,改变维度顺序 | 维度适配、注意力机制中的矩阵变换 | weights_3x1.T → 形状 (1,3) |

| 广播加法 | + |

标量 / 向量与矩阵自动扩展相加 | 偏置项添加(核心操作) | (inputs_1x3 @ weights_3x1) + bias |

| 元素级激活 | np.maximum() |

ReLU 激活函数实现 | 隐藏层激活,引入非线性 | np.maximum(matmul_result, 0) → [[0.3]] |

| 批量矩阵乘法 | np.matmul() |

多组矩阵同时相乘 | 批量处理样本((batch, in_dim) × (in_dim, out_dim) ) |

若 inputs_batch 形状 (2,3) ,可直接乘 weights_3x1 |

返回到我们前面的计算:

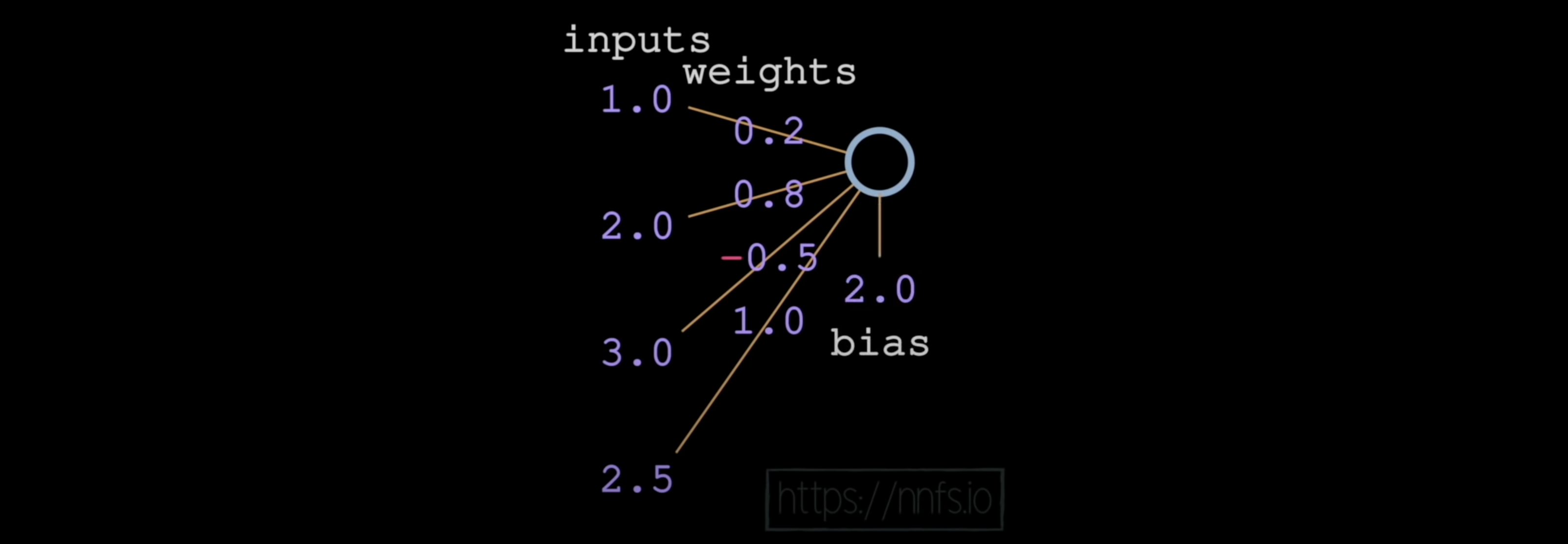

现在让我们来模拟输出层的一个神经元(第 4 层,最顶层的神经元)

这个和前面的有区别吗?

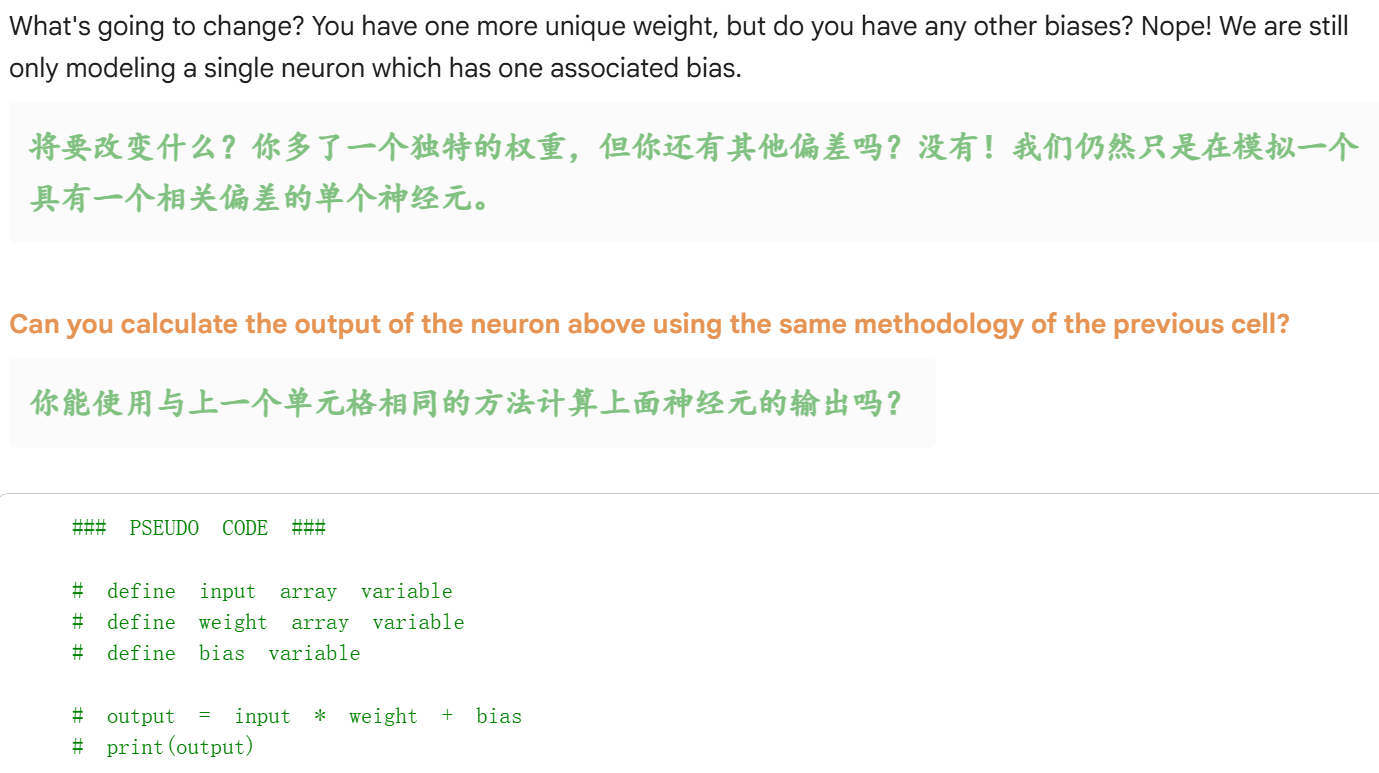

其实没有,先自己手动写一下简单的矩阵运算:

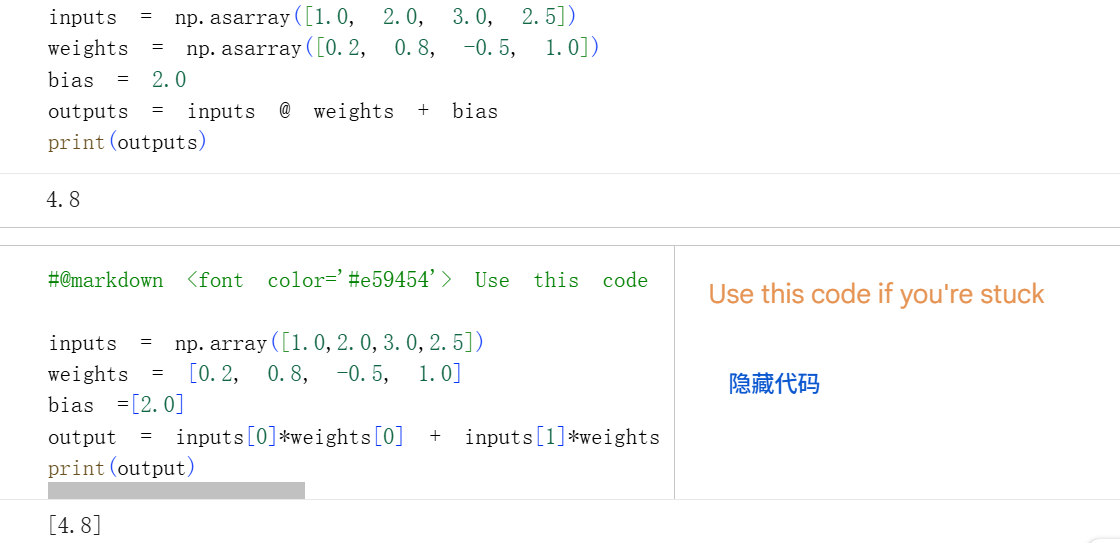

plain

inputs = np.asarray([1.0, 2.0, 3.0, 2.5])

weights = np.asarray([0.2, 0.8, -0.5, 1.0])

bias = 2.0

outputs = inputs @ weights + bias

print(outputs)这里我们并没有reshape,而是直接按照一维数组的乘法

这是因为 NumPy 对一维数组的 @ 运算符做了特殊处理,它会自动将一维数组的矩阵乘法等价为点积运算,无需手动 reshape 成二维矩阵。

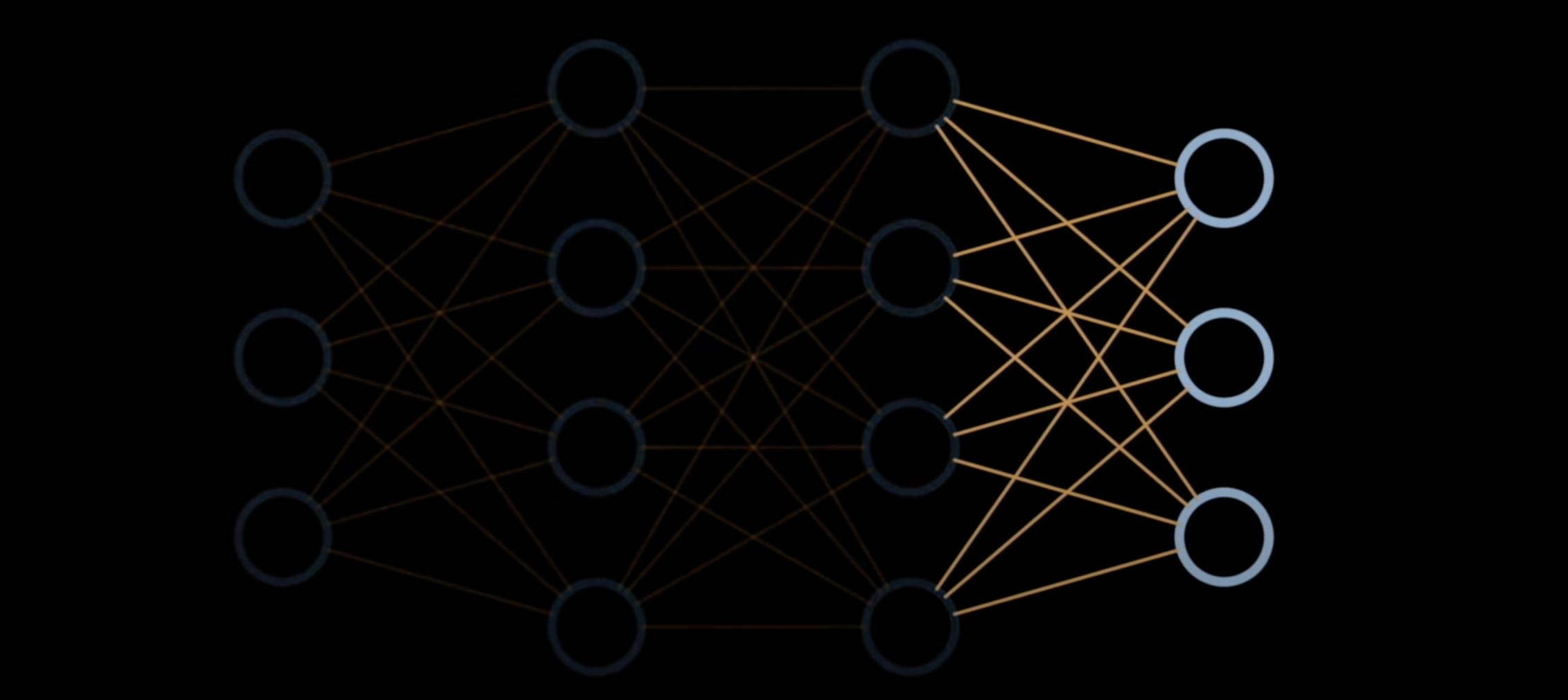

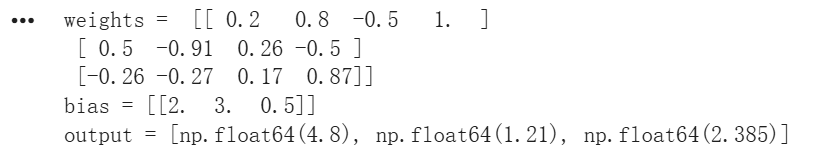

2,Coding a layer of neurons 编写神经元层

使用列表的列表(多维数组构建)来计算输出

如何构建一个包含 3 个神经元、每个神经元有 3 个输入的模型?

就拿上面这一个输出层为例来看,因为输出有3个神经元,倒数第2层是输入有4个神经元,

所以情况就是:

有4个输入,对应输出的3个神经元也就需要3个独特的权重集,每一个权重集有4个值(对应4个输入),另外每一个输出的神经元需要1个独特的bias

------》也就是4个输入,3个权重,3个bias(权重和bias维度与输出对齐)

python

# inputs are from hidden layer

inputs = np.array([1, 2, 3, 2.5])

# neuron 1 (top)

weights1 = np.array([0.2, 0.8, -0.5, 1.0])

bias1 = 2

# neuron 2 (middle)

weights2 = np.array([0.5, -0.91, 0.26, -0.5])

bias2 = 3

# neuron 3 (bottom)

weights3 = np.array([-0.26, -0.27, 0.17, 0.87])

bias3 = 0.5

# 3 neurons, with 4 inputs each

# each neuron has unique set of weights and a separate bias

# since our layer has 3 neurons, the layer output should be 3 values (one value for each of the neurons)

output = [inputs[0]*weights1[0] + inputs[1]*weights1[1] + inputs[2]*weights1[2] + inputs[3]*weights1[3]+ bias1,

inputs[0]*weights2[0] + inputs[1]*weights2[1] + inputs[2]*weights2[2] + inputs[3]*weights2[3]+ bias2,

inputs[0]*weights3[0] + inputs[1]*weights3[1] + inputs[2]*weights3[2] + inputs[3]*weights3[3]+ bias3]

print(output)简单来说就是输入是1x4,1行4列,输出是1x3,1行3列,

所以中间系数矩阵是4x3,bias是系数x输入之后的1x3,1行3列。

按照我们正常的习惯:

python

# inputs are from hidden layer

inputs = np.array([1, 2, 3, 2.5])

# neuron 1 (top)

weights1 = np.array([0.2, 0.8, -0.5, 1.0])

bias1 = 2

# neuron 2 (middle)

weights2 = np.array([0.5, -0.91, 0.26, -0.5])

bias2 = 3

# neuron 3 (bottom)

weights3 = np.array([-0.26, -0.27, 0.17, 0.87])

bias3 = 0.5

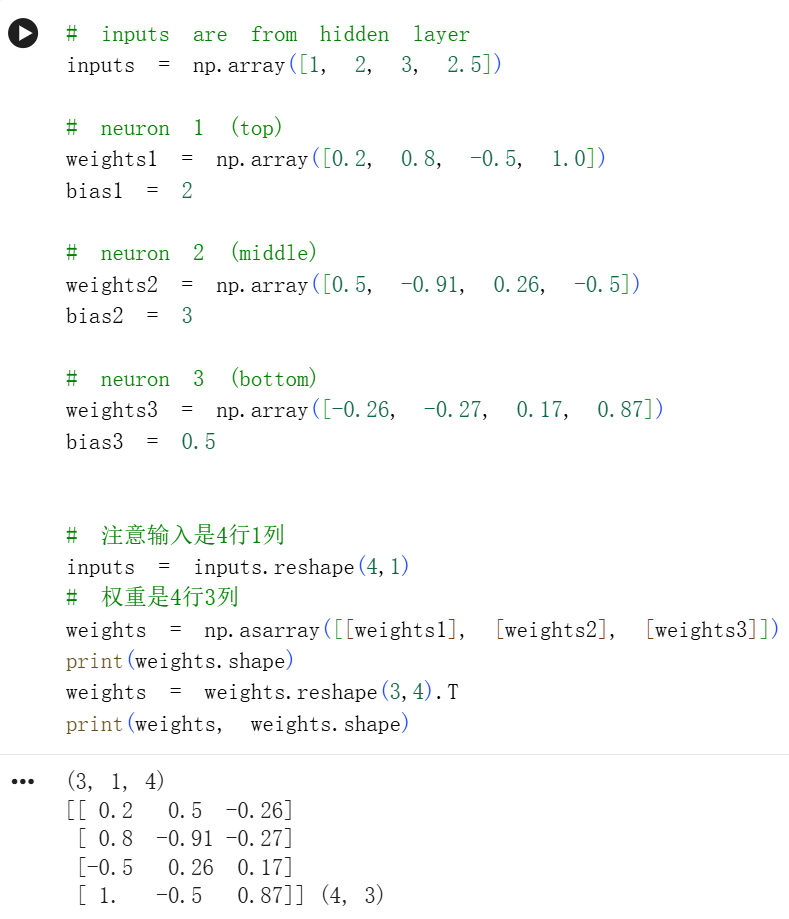

# 注意输入是4行1列

inputs = inputs.reshape(4,1)

# 权重是4行3列

weights = np.asarray([[weights1], [weights2], [weights3]])

print(weights.shape)

weights = weights.reshape(3,4).T

print(weights, weights.shape)

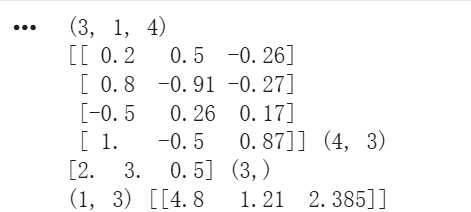

完整的就是:

python

# inputs are from hidden layer

inputs = np.array([1, 2, 3, 2.5])

# neuron 1 (top)

weights1 = np.array([0.2, 0.8, -0.5, 1.0])

bias1 = 2

# neuron 2 (middle)

weights2 = np.array([0.5, -0.91, 0.26, -0.5])

bias2 = 3

# neuron 3 (bottom)

weights3 = np.array([-0.26, -0.27, 0.17, 0.87])

bias3 = 0.5

# 注意输入是1行4列

inputs = inputs.reshape(1,4)

# 权重是4行3列

weights = np.asarray([[weights1], [weights2], [weights3]])

print(weights.shape)

weights = weights.reshape(3,4).T

print(weights, weights.shape)

# 偏置bias是1行3列

bias = np.asarray([bias1, bias2, bias3])

print(bias,bias.shape)

# 再reshape一下

bias = bias.reshape(1,3)

outputs = inputs @ weights + bias

print(outputs.shape, outputs)

python

inputs = np.array([1, 2, 3, 2.5])

# lets format the weights as a list of lists

weights = np.array([[0.2, 0.8, -0.5, 1.0],

[0.5, -0.91, 0.26, -0.5],

[-0.26, -0.27, 0.17, 0.87]])

print("weights = ", weights)

# and a list for the biases

biases = np.array([2,

3,

0.5])

print("bias =", bias)

# output of current layer

layer_outputs = []

# zip together weights and biases (combines 2 lists into list of lists element-wise)

for neuron_weights, neuron_bias in zip(weights, biases):

# output of given neuron

neuron_output = 0

for n_input, weight in zip(inputs, neuron_weights):

# sum the inputs * weights

# 注意inputs只有1个值np.array([1, 2, 3, 2.5]),weight其实是3行4列

# 这里逐元素乘法实际上就是将仅有的1个inputs和3行中的任意一个weights进行逐元素乘法,获取1个标量

neuron_output += n_input*weight

# add the bias term

neuron_output += neuron_bias

# output from neurons

layer_outputs.append(neuron_output)

print("output =", layer_outputs)

总的来说,对于有些许数学直觉的人来说,数组之间的维度其实会更加敏感。

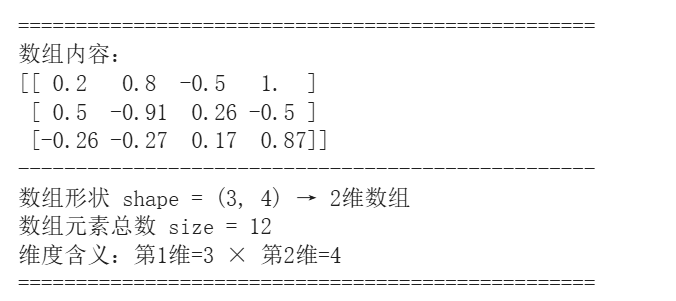

所以我们最好是写一个可以直接可视化数组张量维度的函数:

一个简单的可视化函数

python

import numpy as np

def visualize_numpy_array(arr):

"""

可视化NumPy数组的形状和结构

"""

print("=" * 50)

print(f"数组内容:\n{arr}")

print("-" * 50)

# 打印核心形状信息

shape = arr.shape

dim = arr.ndim

size = arr.size

print(f"数组形状 shape = {shape} → {dim}维数组")

print(f"数组元素总数 size = {size}")

print(f"维度含义:{' × '.join([f'第{i+1}维={s}' for i, s in enumerate(shape)])}")

print("=" * 50)

# 示例

weights = np.array([[0.2, 0.8, -0.5, 1.0],

[0.5, -0.91, 0.26, -0.5],

[-0.26, -0.27, 0.17, 0.87]])

visualize_numpy_array(weights)

我们可以写得再详细一点:

python

def visualize_numpy_array(arr):

"""

可视化NumPy数组的形状和结构(层次化输出格式)

"""

# 确保输入是numpy数组

if not isinstance(arr, np.ndarray):

arr = np.asarray(arr)

# 定义分隔线样式,区分不同层级

LINE_TOP = "=" * 60

LINE_MID = "-" * 60

LINE_SUB = "~" * 60

print(LINE_TOP)

print(f"【1. 数组基础信息】")

print(LINE_SUB)

# 打印数组内容,根据维度调整显示缩进

if arr.ndim <= 2:

print(f"数组内容:\n{arr}")

else:

print(f"高维数组内容(前3个维度切片):\n{arr[:2] if arr.shape[0]>2 else arr}")

print(LINE_MID)

# 核心形状信息(层次化排版)

shape = arr.shape

dim = arr.ndim

size = arr.size

dtype = arr.dtype

print(f"【2. 核心维度参数】")

print(LINE_SUB)

print(f" ✅ 数组维度数 → {dim} 维")

print(f" ✅ 数组形状 → shape = {shape}")

print(f" ✅ 维度含义 → {' × '.join([f'第{i+1}维={s}' for i, s in enumerate(shape)])}")

print(f" ✅ 总元素数量 → size = {size}")

print(f" ✅ 数据类型 → dtype = {dtype}")

print(LINE_TOP)

python

inputs = np.array([1, 2, 3, 2.5])

# lets format the weights as a list of lists

weights = np.array([[0.2, 0.8, -0.5, 1.0],

[0.5, -0.91, 0.26, -0.5],

[-0.26, -0.27, 0.17, 0.87]])

print("weights = ", weights)

visualize_numpy_array(weights)

# and a list for the biases

biases = np.array([2,

3,

0.5])

print("bias =", biases)

visualize_numpy_array(biases)

# output of current layer

layer_outputs = []

print("\n\n\n\n\n\n\n\n\n","*"*50,"\n","In Loop Now")

# zip together weights and biases (combines 2 lists into list of lists element-wise)

for neuron_weights, neuron_bias in zip(weights, biases):

# output of given neuron

neuron_output = 0

print(f"neuron_weights here is {neuron_weights}")

visualize_numpy_array(neuron_weights)

for n_input, weight in zip(inputs, neuron_weights):

# sum the inputs * weights

# 注意inputs只有1个值np.array([1, 2, 3, 2.5]),weight其实是3行4列

# 这里逐元素乘法实际上就是将仅有的1个inputs和3行中的任意一个weights进行逐元素乘法,获取1个标量

print(f"n_input here is {n_input}")

visualize_numpy_array(n_input)

print(f"weight here is {weight}")

visualize_numpy_array(weight)

neuron_output += n_input*weight

print(f"neuron_output now is {neuron_output}")

visualize_numpy_array(neuron_output)

# add the bias term

print(f"neuron_bias now is {neuron_bias}")

visualize_numpy_array(neuron_bias)

neuron_output += neuron_bias

print(f"neuron_output now is {neuron_output}")

visualize_numpy_array(neuron_output)

# output from neurons

layer_outputs.append(neuron_output)

print(f"layer_outputs now is {layer_outputs}")

visualize_numpy_array(layer_outputs)

print("output =", layer_outputs)

python

weights = [[ 0.2 0.8 -0.5 1. ]

[ 0.5 -0.91 0.26 -0.5 ]

[-0.26 -0.27 0.17 0.87]]

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

[[ 0.2 0.8 -0.5 1. ]

[ 0.5 -0.91 0.26 -0.5 ]

[-0.26 -0.27 0.17 0.87]]

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 2 维

✅ 数组形状 → shape = (3, 4)

✅ 维度含义 → 第1维=3 × 第2维=4

✅ 总元素数量 → size = 12

✅ 数据类型 → dtype = float64

============================================================

bias = [2. 3. 0.5]

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

[2. 3. 0.5]

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 1 维

✅ 数组形状 → shape = (3,)

✅ 维度含义 → 第1维=3

✅ 总元素数量 → size = 3

✅ 数据类型 → dtype = float64

============================================================

**************************************************

In Loop Now

neuron_weights here is [ 0.2 0.8 -0.5 1. ]

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

[ 0.2 0.8 -0.5 1. ]

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 1 维

✅ 数组形状 → shape = (4,)

✅ 维度含义 → 第1维=4

✅ 总元素数量 → size = 4

✅ 数据类型 → dtype = float64

============================================================

n_input here is 1.0

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

1.0

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

weight here is 0.2

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

0.2

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

neuron_output now is 0.2

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

0.2

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

n_input here is 2.0

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

2.0

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

weight here is 0.8

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

0.8

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

neuron_output now is 1.8

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

1.8

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

n_input here is 3.0

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

3.0

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

weight here is -0.5

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

-0.5

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

neuron_output now is 0.30000000000000004

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

0.30000000000000004

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

n_input here is 2.5

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

2.5

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

weight here is 1.0

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

1.0

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

neuron_output now is 2.8

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

2.8

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

neuron_bias now is 2.0

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

2.0

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

neuron_output now is 4.8

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

4.8

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

layer_outputs now is [np.float64(4.8)]

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

[4.8]

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 1 维

✅ 数组形状 → shape = (1,)

✅ 维度含义 → 第1维=1

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

neuron_weights here is [ 0.5 -0.91 0.26 -0.5 ]

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

[ 0.5 -0.91 0.26 -0.5 ]

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 1 维

✅ 数组形状 → shape = (4,)

✅ 维度含义 → 第1维=4

✅ 总元素数量 → size = 4

✅ 数据类型 → dtype = float64

============================================================

n_input here is 1.0

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

1.0

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

weight here is 0.5

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

0.5

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

neuron_output now is 0.5

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

0.5

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

n_input here is 2.0

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

2.0

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

weight here is -0.91

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

-0.91

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

neuron_output now is -1.32

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

-1.32

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

n_input here is 3.0

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

3.0

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

weight here is 0.26

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

0.26

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

neuron_output now is -0.54

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

-0.54

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

n_input here is 2.5

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

2.5

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

weight here is -0.5

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

-0.5

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

neuron_output now is -1.79

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

-1.79

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

neuron_bias now is 3.0

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

3.0

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

neuron_output now is 1.21

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

1.21

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

layer_outputs now is [np.float64(4.8), np.float64(1.21)]

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

[4.8 1.21]

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 1 维

✅ 数组形状 → shape = (2,)

✅ 维度含义 → 第1维=2

✅ 总元素数量 → size = 2

✅ 数据类型 → dtype = float64

============================================================

neuron_weights here is [-0.26 -0.27 0.17 0.87]

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

[-0.26 -0.27 0.17 0.87]

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 1 维

✅ 数组形状 → shape = (4,)

✅ 维度含义 → 第1维=4

✅ 总元素数量 → size = 4

✅ 数据类型 → dtype = float64

============================================================

n_input here is 1.0

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

1.0

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

weight here is -0.26

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

-0.26

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

neuron_output now is -0.26

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

-0.26

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

n_input here is 2.0

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

2.0

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

weight here is -0.27

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

-0.27

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

neuron_output now is -0.8

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

-0.8

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

n_input here is 3.0

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

3.0

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

weight here is 0.17

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

0.17

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

neuron_output now is -0.29000000000000004

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

-0.29000000000000004

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

n_input here is 2.5

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

2.5

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

weight here is 0.87

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

0.87

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

neuron_output now is 1.8849999999999998

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

1.8849999999999998

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

neuron_bias now is 0.5

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

0.5

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

neuron_output now is 2.385

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

2.385

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 0 维

✅ 数组形状 → shape = ()

✅ 维度含义 →

✅ 总元素数量 → size = 1

✅ 数据类型 → dtype = float64

============================================================

layer_outputs now is [np.float64(4.8), np.float64(1.21), np.float64(2.385)]

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

[4.8 1.21 2.385]

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 1 维

✅ 数组形状 → shape = (3,)

✅ 维度含义 → 第1维=3

✅ 总元素数量 → size = 3

✅ 数据类型 → dtype = float64

============================================================

output = [np.float64(4.8), np.float64(1.21), np.float64(2.385)]

我们将处理形状和大小各异的数组。以下是其中的三个:

python

# type: list, 1D array, vector

l = np.array([1, 5, 6, 2])

# type: list of lists, 2D array, matrix

lol = np.array([[1, 5, 6, 2],

[3, 2, 1, 3]])

# type: list of list of lists, 3D array

lolol = np.array([[[1, 5, 6, 2],

[3, 2, 1, 3]],

[[5, 2, 1, 2],

[6, 4, 8, 4]],

[[2, 8, 5, 3],

[1, 1, 9, 4]]])我们可以使用 .shape numpy 方法打印上面每个tensor的形状

python

for i in [l,lol,lolol]:

visualize_numpy_array(i)

print("\n\n\n")

python

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

[1 5 6 2]

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 1 维

✅ 数组形状 → shape = (4,)

✅ 维度含义 → 第1维=4

✅ 总元素数量 → size = 4

✅ 数据类型 → dtype = int64

============================================================

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

数组内容:

[[1 5 6 2]

[3 2 1 3]]

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 2 维

✅ 数组形状 → shape = (2, 4)

✅ 维度含义 → 第1维=2 × 第2维=4

✅ 总元素数量 → size = 8

✅ 数据类型 → dtype = int64

============================================================

============================================================

【1. 数组基础信息】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

高维数组内容(前3个维度切片):

[[[1 5 6 2]

[3 2 1 3]]

[[5 2 1 2]

[6 4 8 4]]]

------------------------------------------------------------

【2. 核心维度参数】

~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

✅ 数组维度数 → 3 维

✅ 数组形状 → shape = (3, 2, 4)

✅ 维度含义 → 第1维=3 × 第2维=2 × 第3维=4

✅ 总元素数量 → size = 24

✅ 数据类型 → dtype = int64

============================================================

请注意数组必须是同构的:在每个维度上,它们需要具有相同的大小!

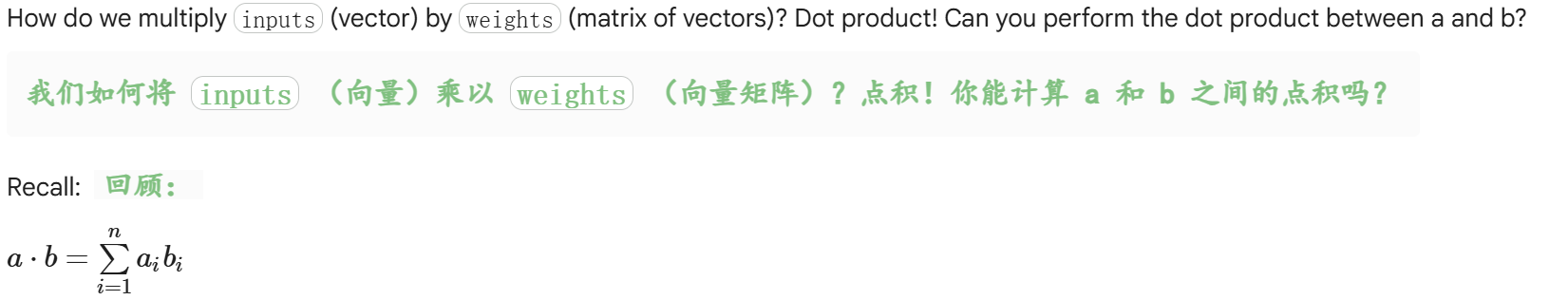

点积的概念

对于一维数组而言,点积就是逐元素乘法,

python

# dot product in numpy for a layer of neurons

inputs = np.array([1, 2, 3, 2.5])

weights = np.array([[0.2, 0.8, -0.5, 1.0],

[0.5, -0.91, 0.26, -0.5],

[-0.26, -0.27, 0.17, 0.87]])

biases = np.array([2, 3, 0.5])

output = np.dot(weights, inputs) + biases # now order DOES matter

# here we perform the dot product 3 times:

# [np.dot(weights[0], inputs),

# np.dot(weights[1], inputs),

# np.dot(weights[2], inputs)] = [2.8, -1.79, 1.885]

# then add biases:

# np.dot(weights, inputs) + biases = [2.8, -1.79, 1.885] + [2.0, 3.0, 0.5] = [4.8, 1.21, 2.385]

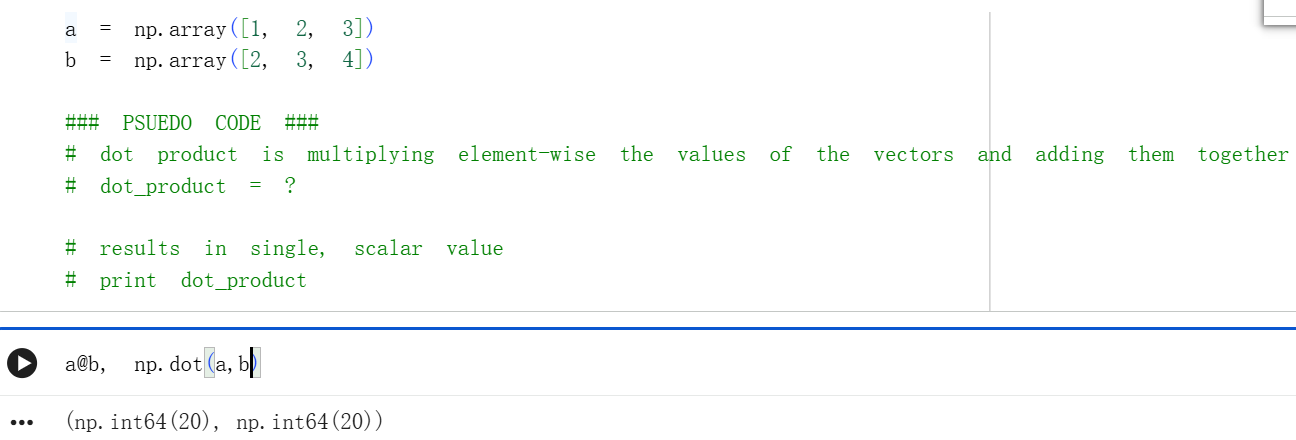

print(output)关于批次batch的解释

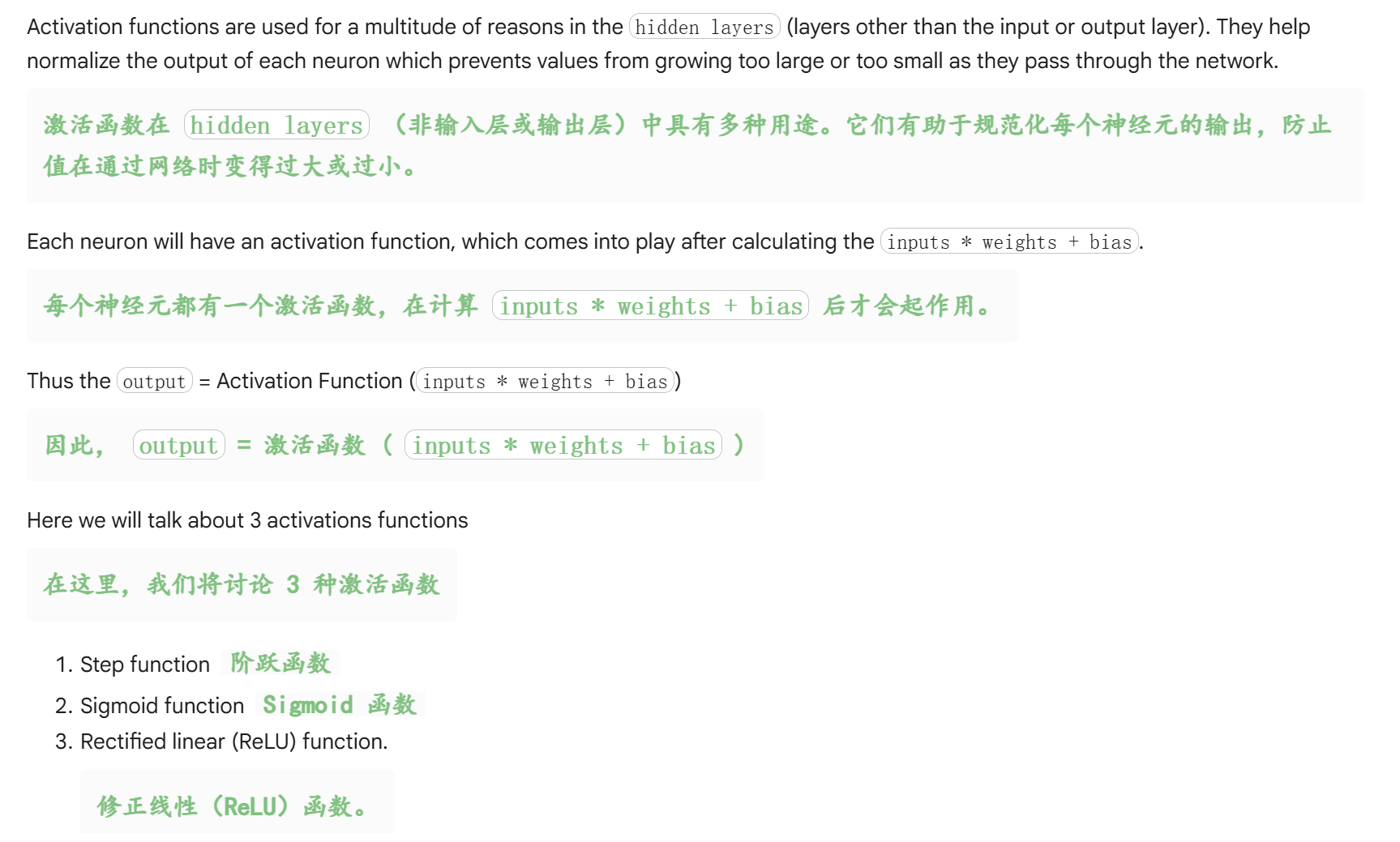

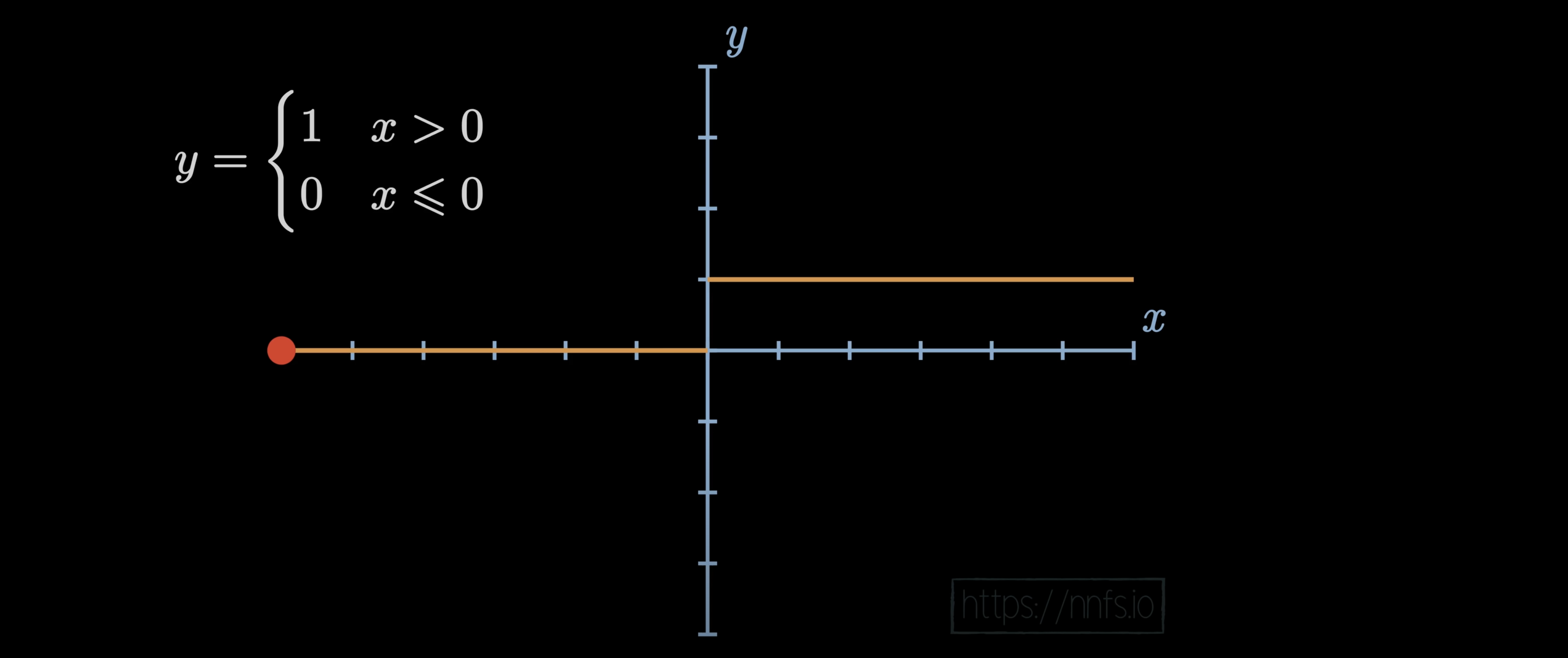

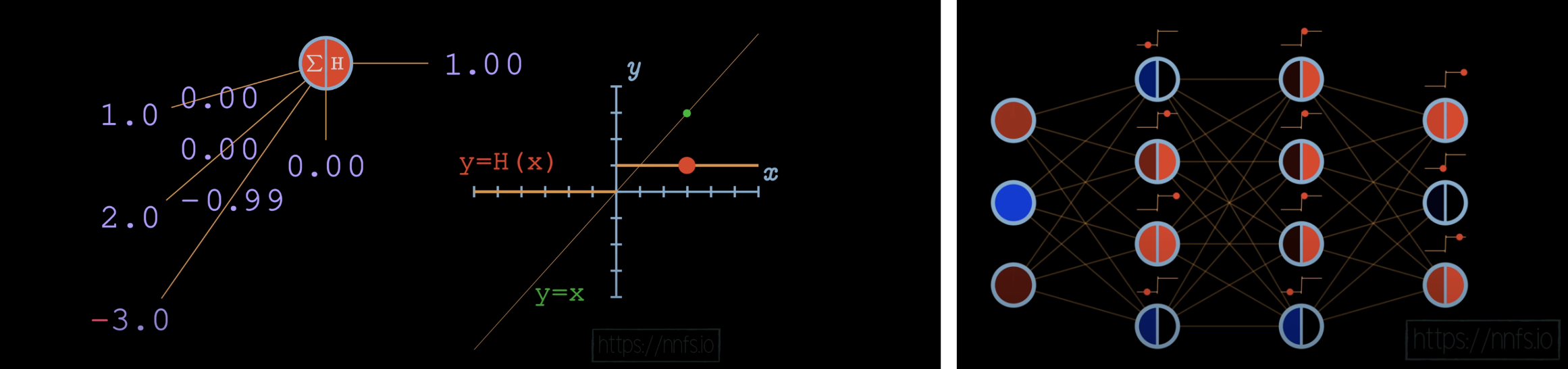

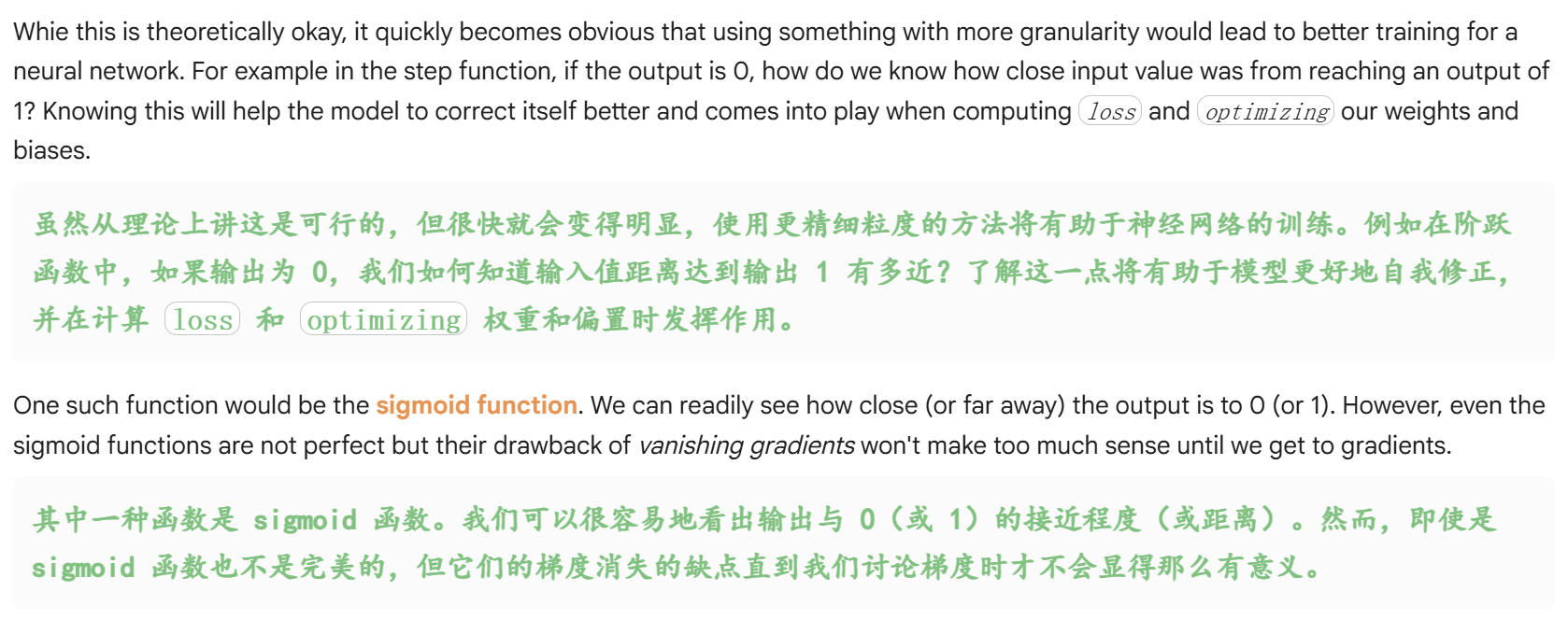

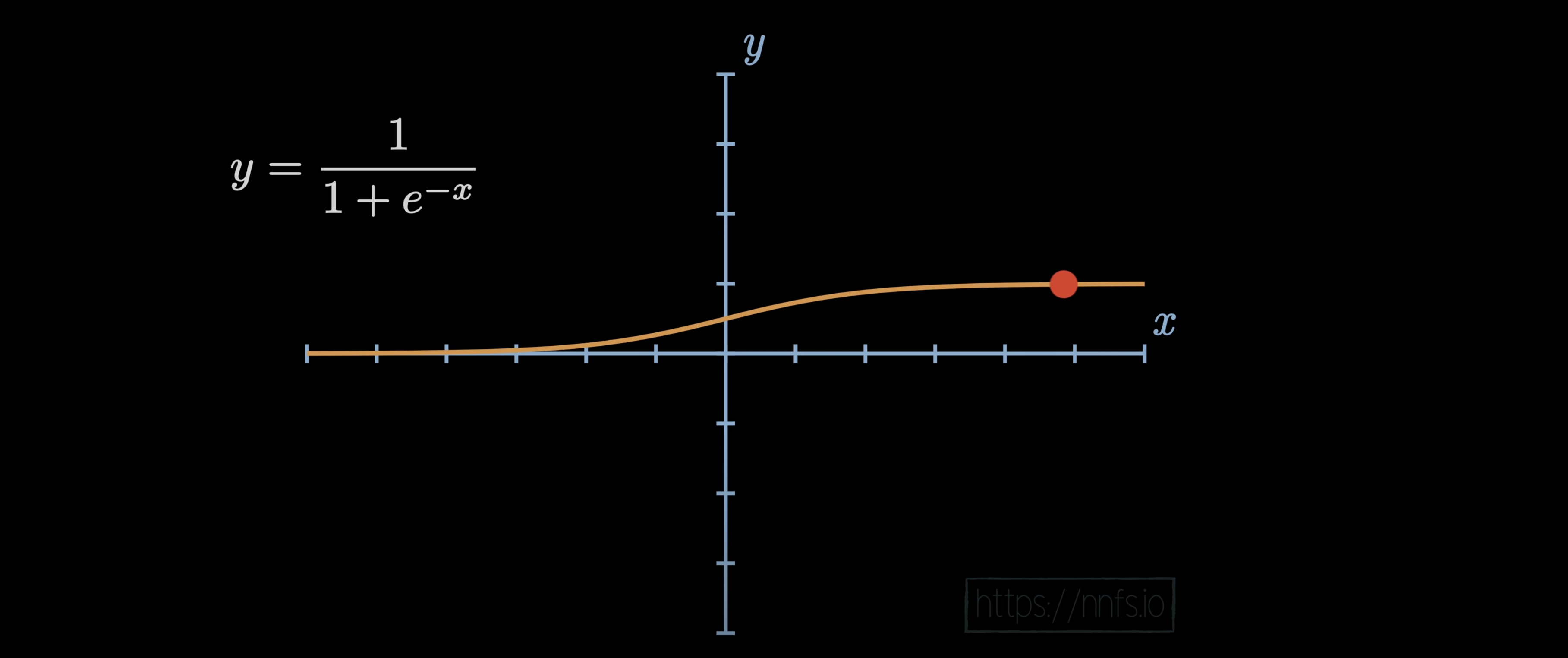

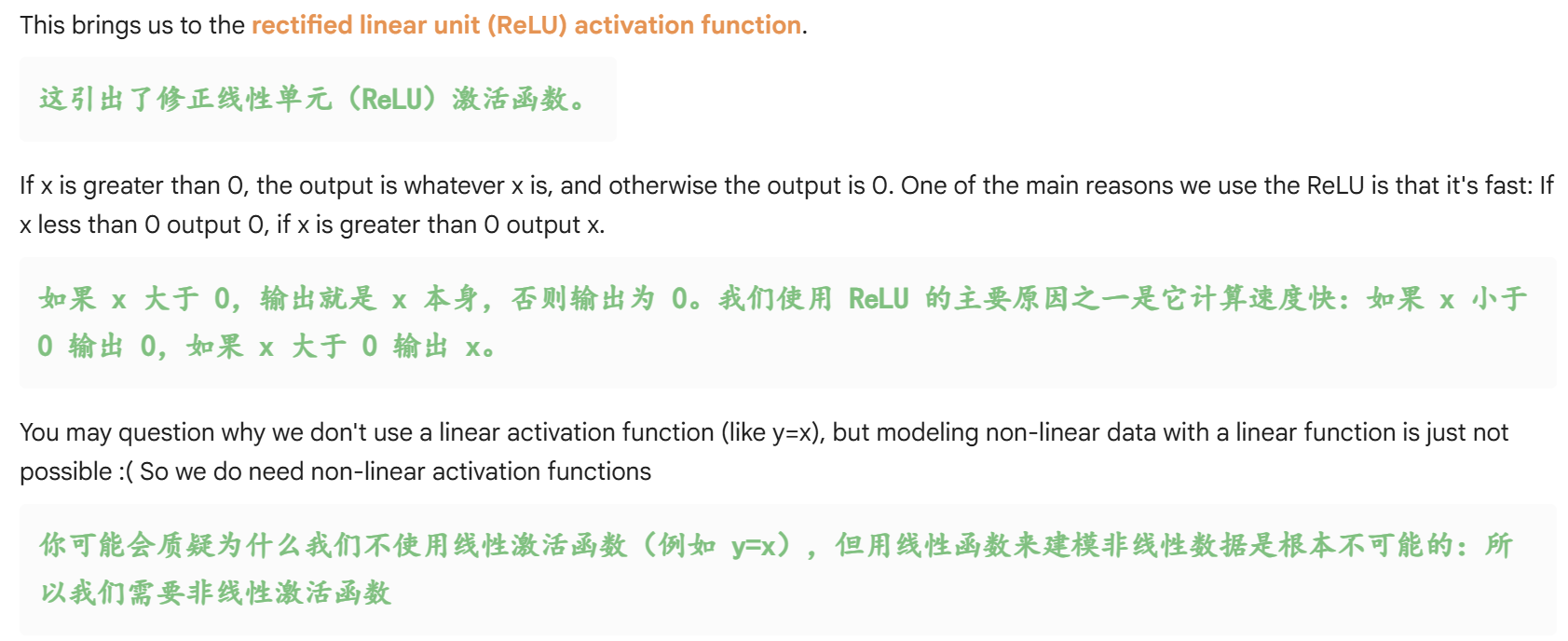

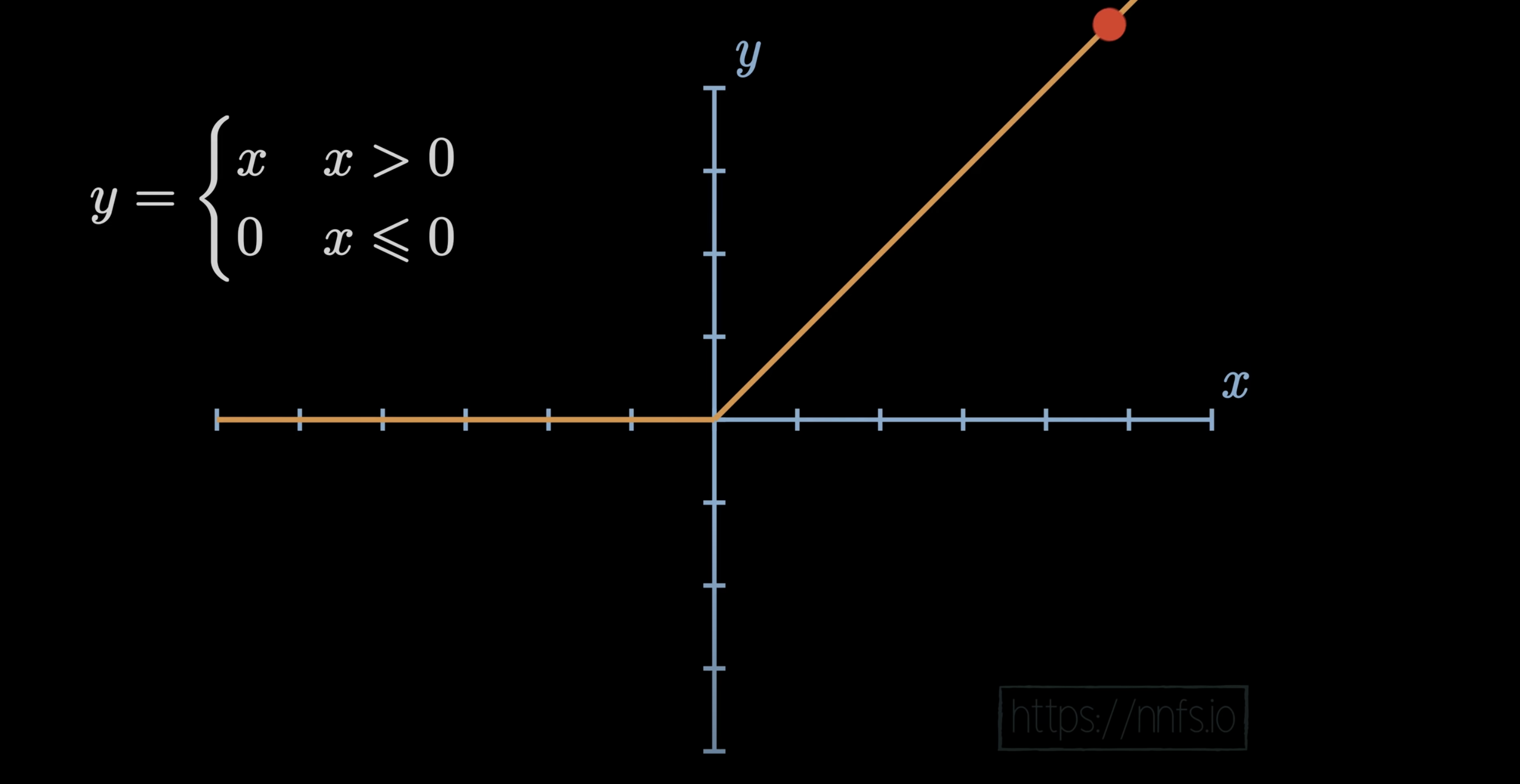

3,Hidden layer activation functions 隐藏层激活函数

在阶跃函数中,如果输入大于 0,输出为 1,否则输出为 0。

因此,在阶跃函数的情况下,您的神经元的输出字面值上是 0 或 1。

对应解释就是:

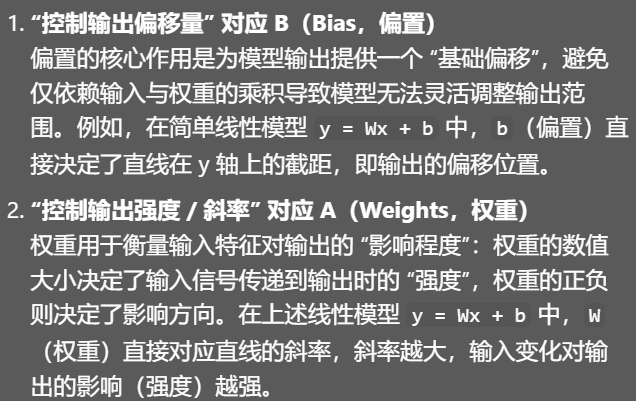

4,Output layer activation function 输出层激活函数

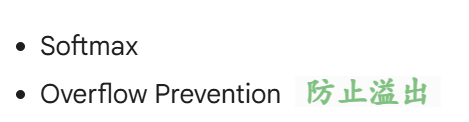

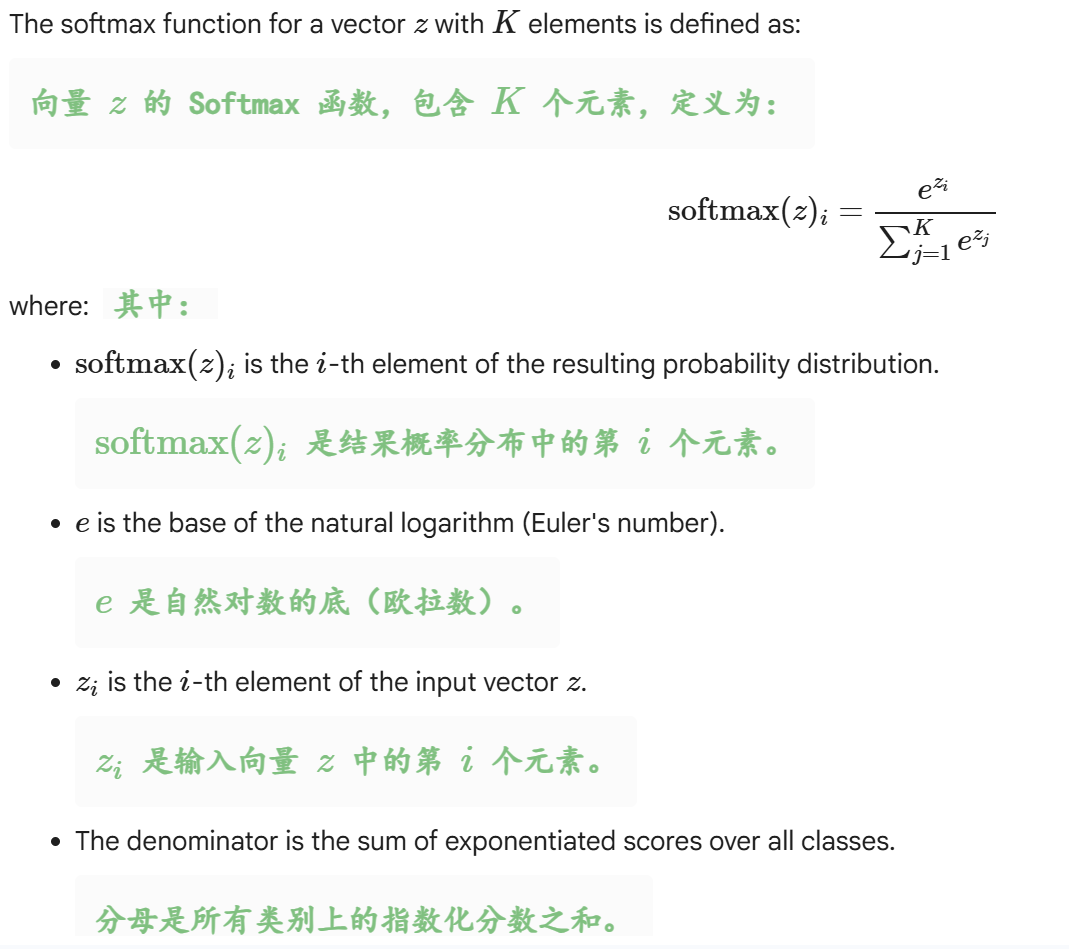

softmax

python

from math import exp

def softmax(x):

sum1 = sum([exp(i) for i in x])

return [exp(i)/sum1 for i in x]

softmax(layer_outputs1), softmax(layer_outputs2)或者直接使用numpy中的函数,接受numpy.ndarray作为输入:

python

#since we want to calculate the softmax for 2 outputs, instead of writing the code twice we can write a function instead

def calculate_softmax(layer_output):

softmax = np.exp(layer_output)/ np.sum(np.exp(layer_output))

return softmax

s1 = calculate_softmax(layer_outputs1)

sum1 = np.sum(s1)

s2 = calculate_softmax(layer_outputs2)

sum2 = np.sum(s2)

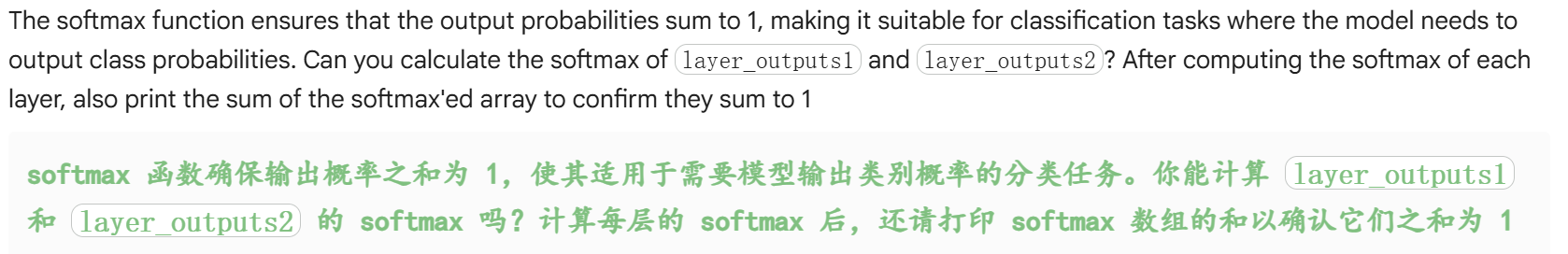

print(s1, sum1, s2, sum2)上面我们只是考虑一层输出,事实上我们会有一批batch输出:

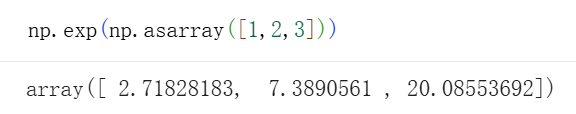

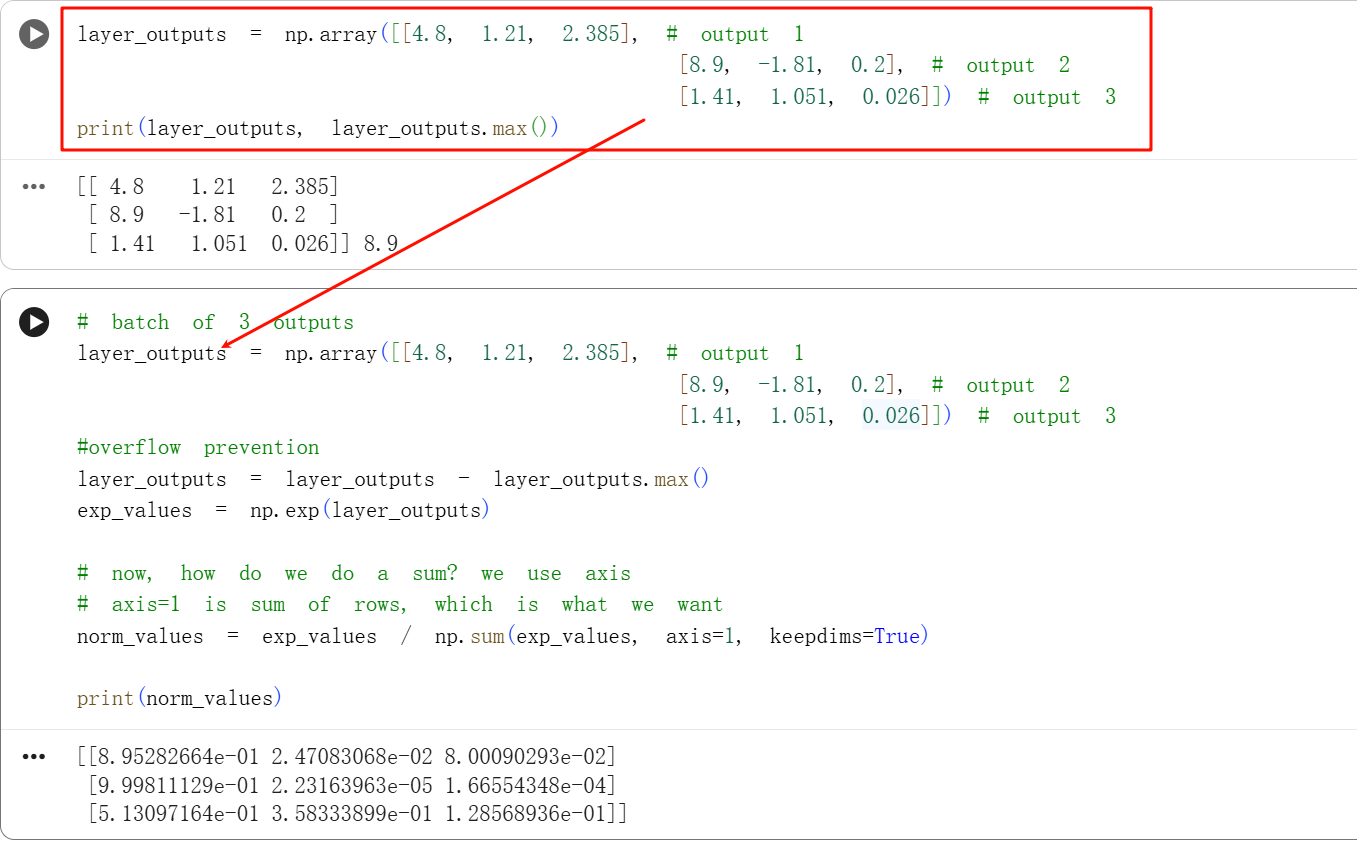

python

# batch of 3 outputs

layer_outputs = np.array([[4.8, 1.21, 2.385], # output 1

[8.9, -1.81, 0.2], # output 2

[1.41, 1.051, 0.026]]) # output 3

#overflow prevention

layer_outputs = layer_outputs - layer_outputs.max()

exp_values = np.exp(layer_outputs)

# now, how do we do a sum? we use axis

# axis=1 is sum of rows, which is what we want

norm_values = exp_values / np.sum(exp_values, axis=1, keepdims=True)

print(norm_values)

行0行,列1列,------》axis=0或者1,就按照行或者列的方向进行操作

比如说下面的求和,axis=1,也就是列1列,按照列的方向进行求和,(人是怎么数列的呢,就是横着数的,比如说第1列、第2列、第3列之类等),所以就是按照横的进行求和,也就是一行1个求和,所以行数也就是行的维度不会变,还是3行

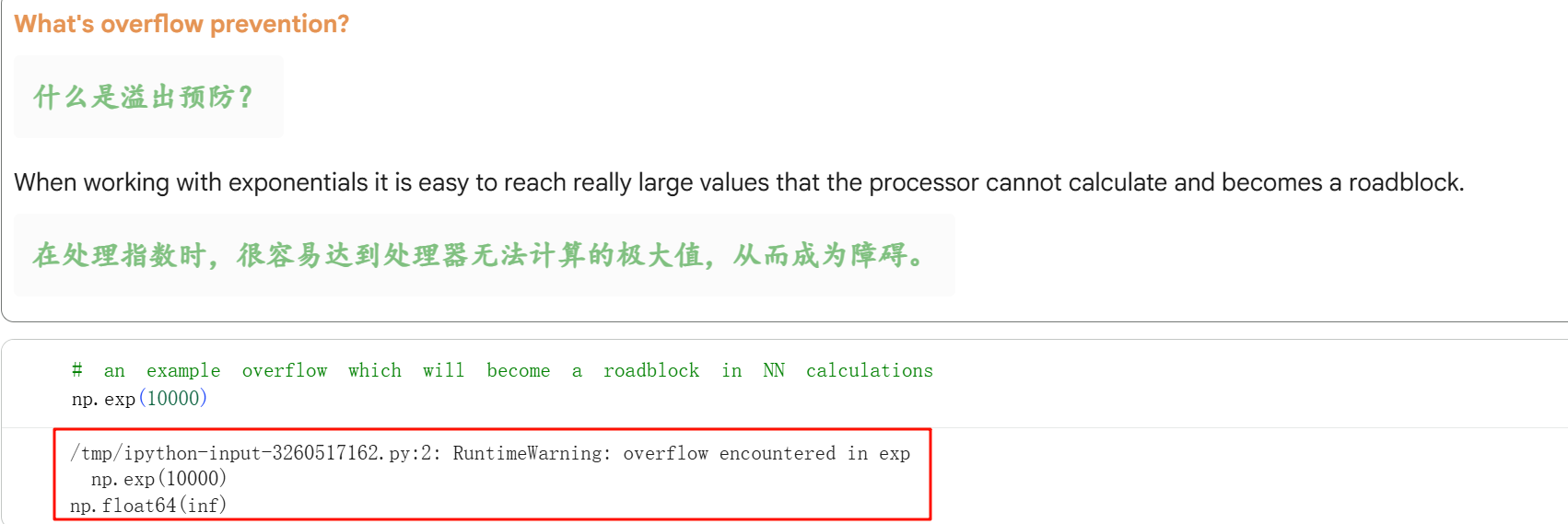

overflow prevention 溢出预防

简单来说,就是指数运算容易爆表爆上限

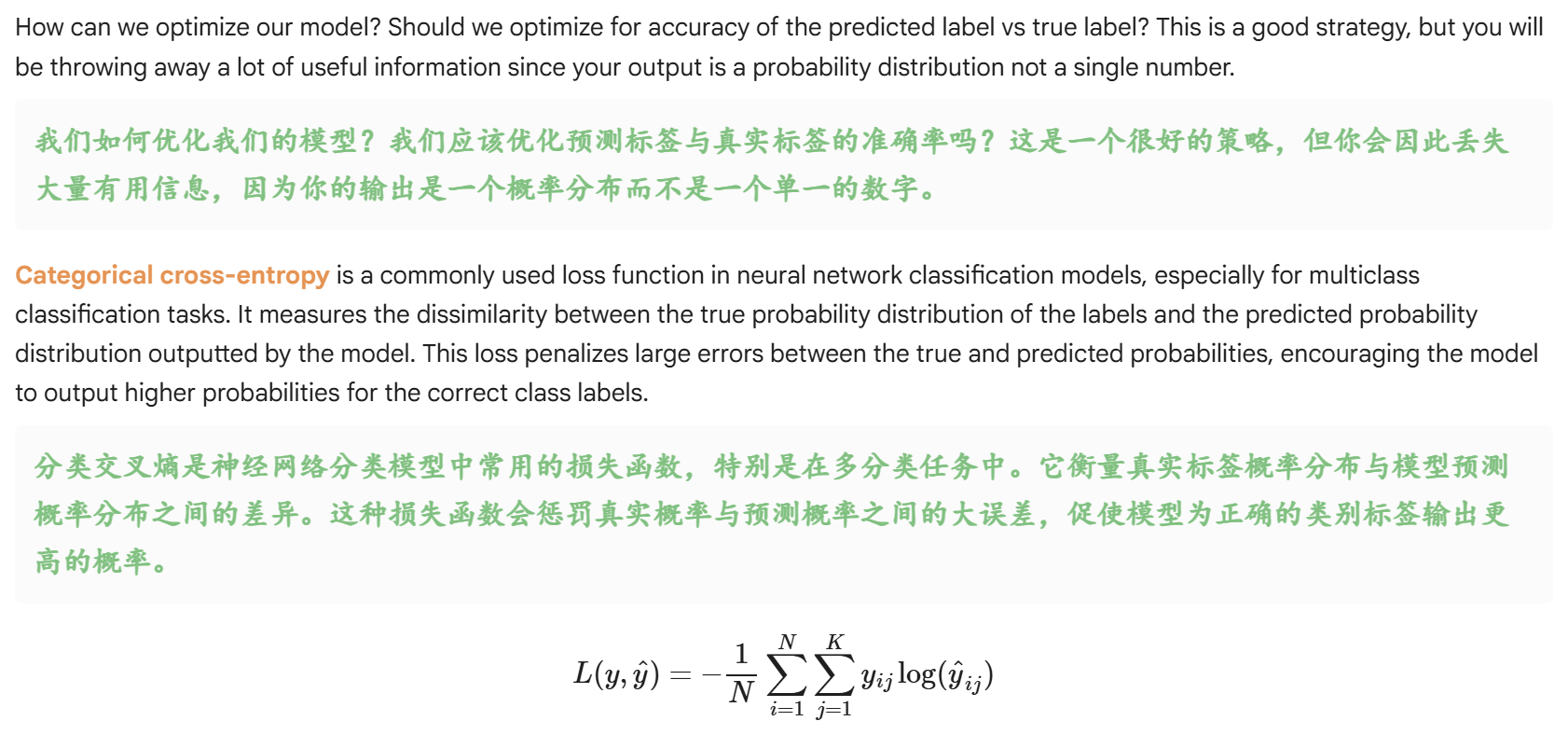

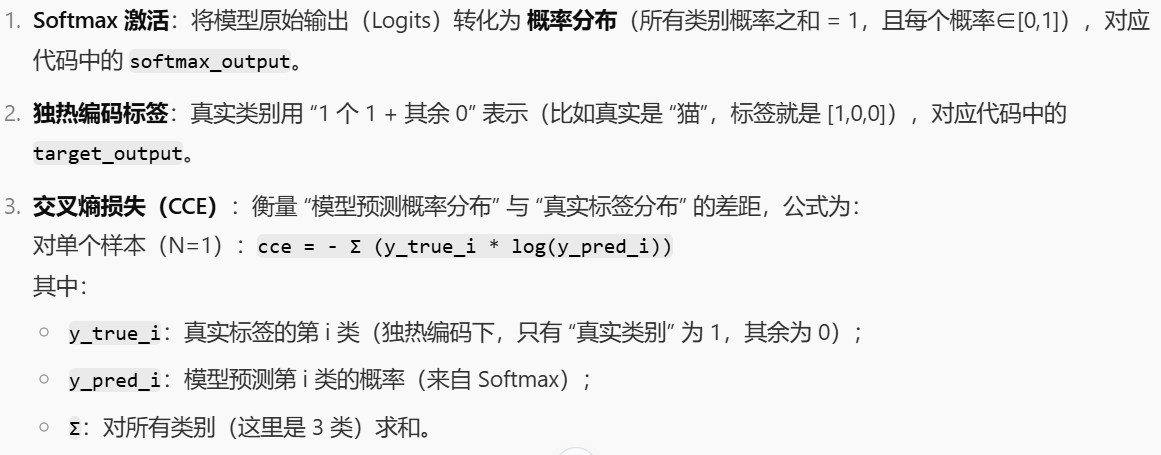

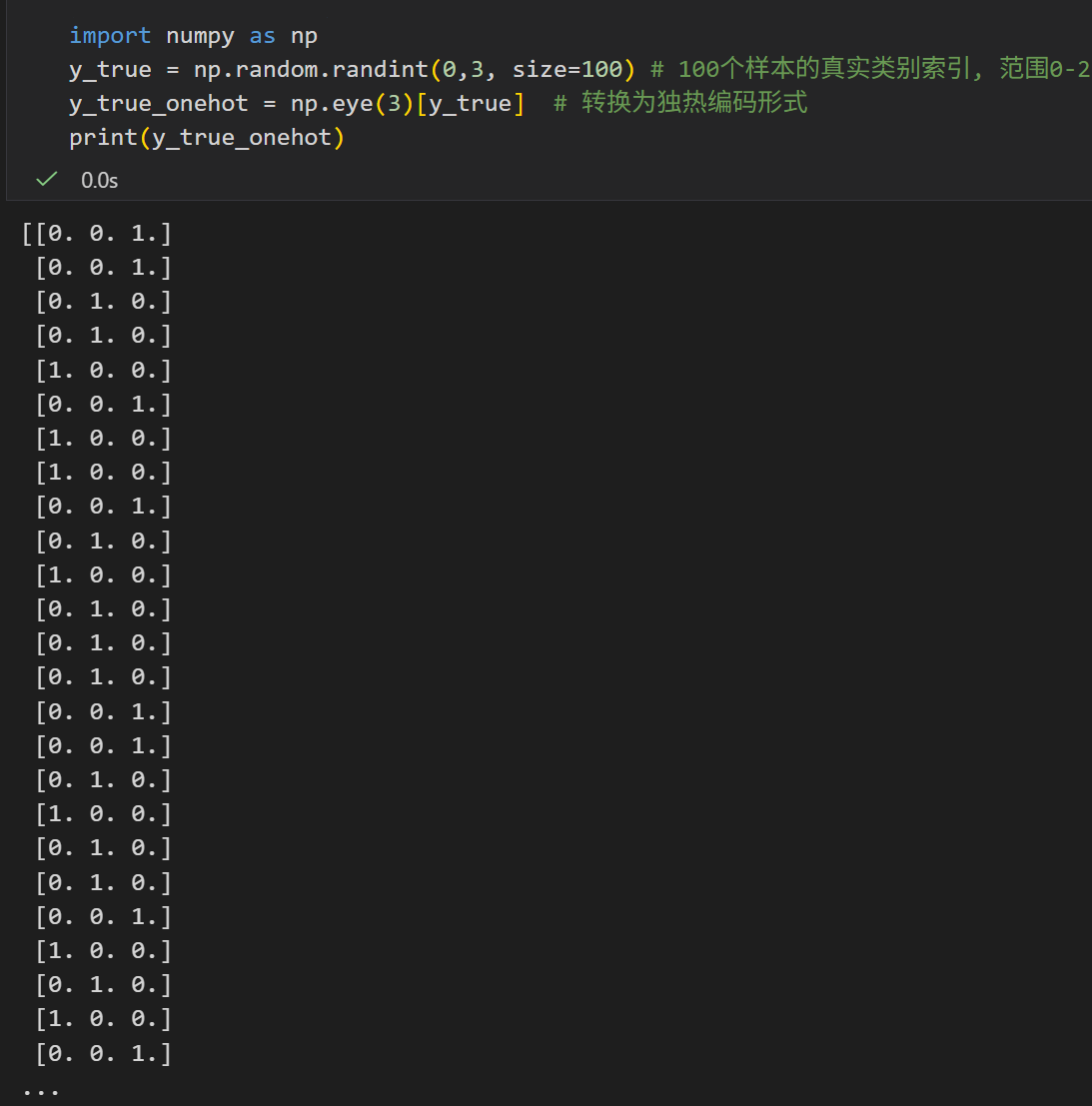

5,Calculating and implementing loss 计算并实现损失

详细数学细节可以参考维基百科:

https://zh.wikipedia.org/wiki/交叉熵

http://en.wikipedia.org/wiki/Cross-entropy

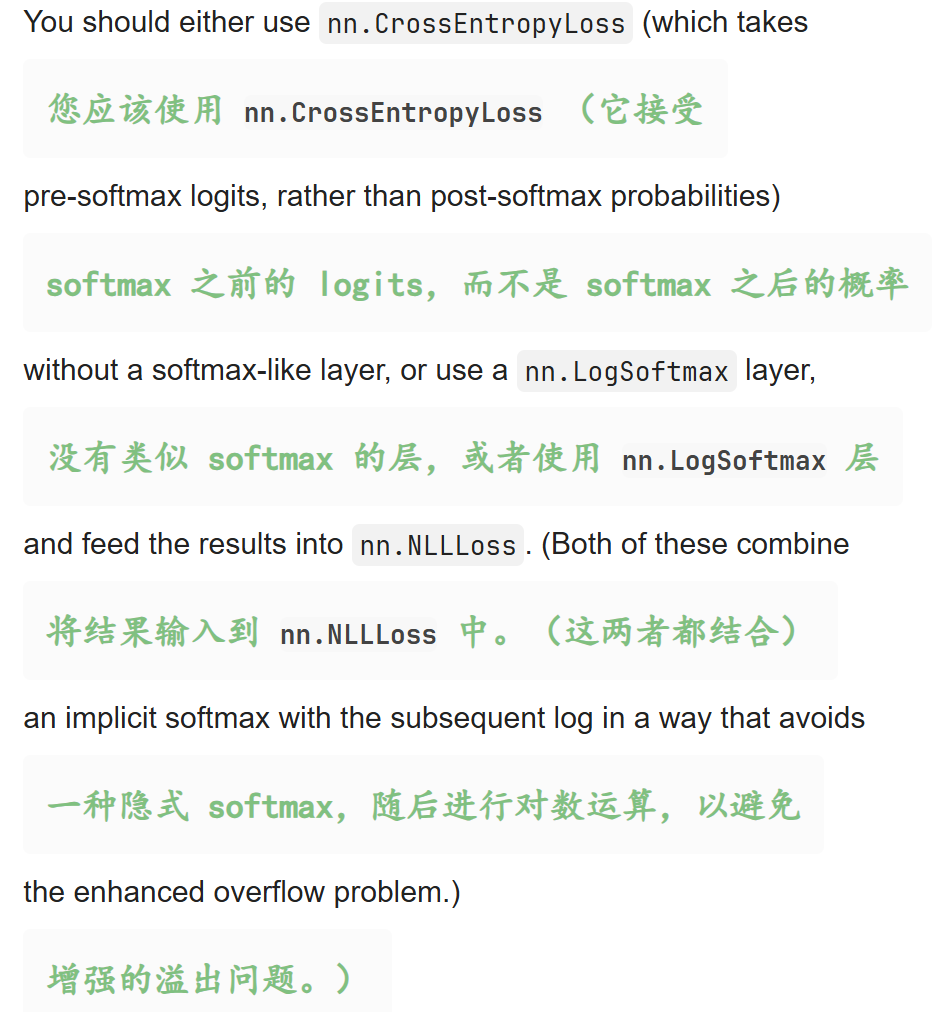

pyTorch中的实现:

https://docs.pytorch.org/docs/stable/generated/torch.nn.CrossEntropyLoss.html

比如说我们softmax输出某个样本的分布,比如说是某一个np.ndarray

python

softmax_output = np.array([0.7, 0.1, 0.2])

target_output = np.array([1, 0, 0]) # means target class is 1

target_class = 0

# 相当于前面讲的交叉熵损失函数, 样本只有1个, 也就是N=1,所以直接取第0个样本的预测概率即可

# 所以我们只需要直接看这个样本的所有类别的预测概率即可, 也就是只有K的数据

# cross-entropy loss for one sample and multiple classes

# cce = - Σ y_true * log( y_pred) # 因为N=1,所以省略了1/N

# cce = - Σ y_true * log( y_pred)

loss = -(math.log(softmax_output[0])*target_output[0] +

math.log(softmax_output[1])*target_output[1] +

math.log(softmax_output[2])*target_output[2])

print(loss)

当然,其实眼尖的人能够立马看出我们的目标分类数据就是一个one-hot独热编码向量。

那么前面的计算逻辑其实能够进一步简化,独热编码下的交叉熵损失的简化逻辑就是:

- 当真实标签是独热编码时,交叉熵损失只与"真实类别对应的预测概率"有关,其余类别的预测概率因为乘0而不贡献。所以实际工程中,比如说是PyTorch/TensorFlow 的交叉熵损失函数,会直接用 "真实类别索引"(如 target_class=0)提取对应预测概率,避免不必要的求和计算,效率更高;

- 核心原因是 独热编码的 "0 项不贡献" 特性。

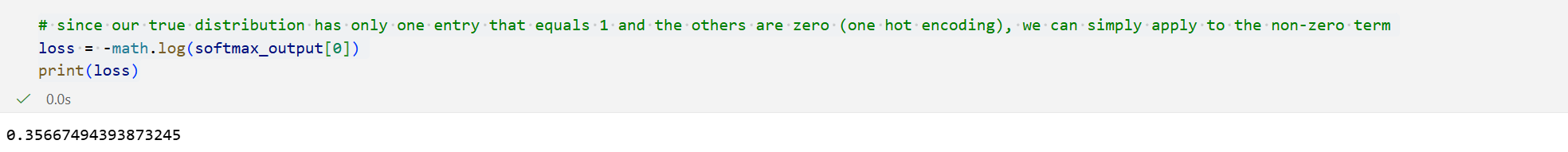

python

# since our true distribution has only one entry that equals 1 and the others are zero (one hot encoding), we can simply apply to the non-zero term

loss = -math.log(softmax_output[0])

print(loss)

如果猜的越不准,那么交叉熵就越大

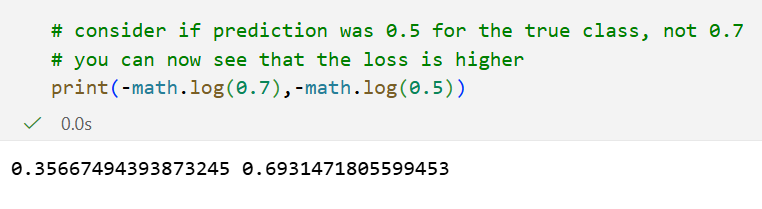

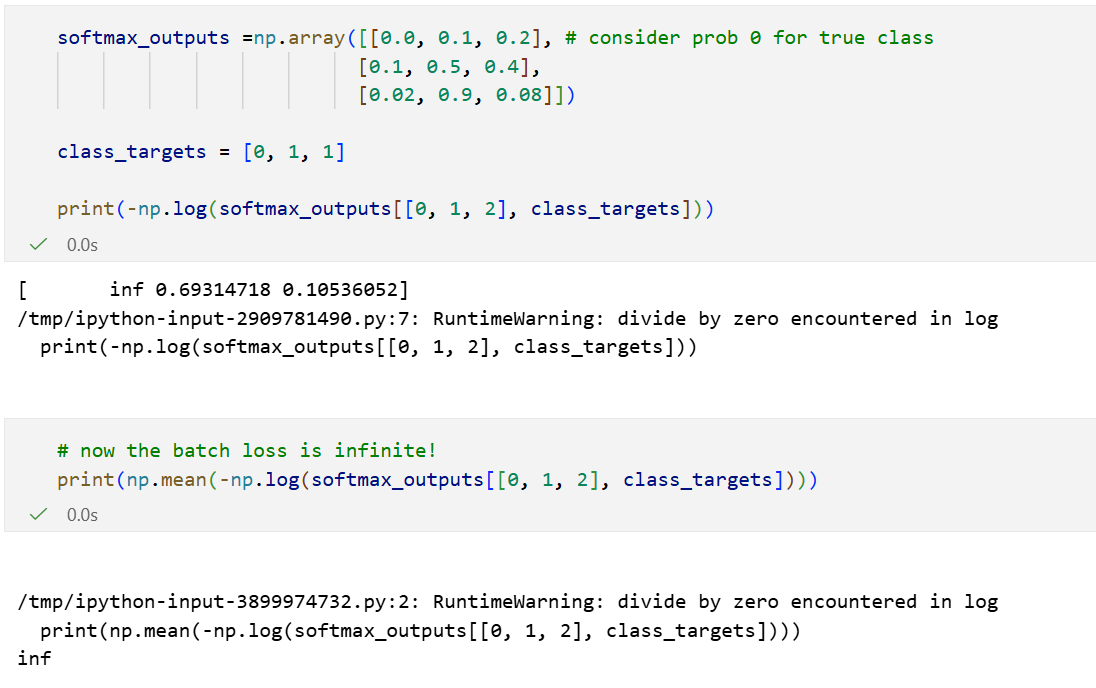

计算三张图像批次的损失

前面的例子是简单的单样本多类别分类,计算损失函数;现在我们来看一下多样本,每个样本多类别的损失函数。

比如说图像识别问题,

我们手头上有多个图片,比如说是3个样本,然后一共3个类别,

也就是我们的softmax激活函数输出是一个shape为3x3的输出矩阵。

python

softmax_outputs =np.array([[0.7, 0.1, 0.2], # prob distribution for image 1 (0.7)

[0.1, 0.5, 0.4], # ...image 2 (0.5)

[0.02, 0.9, 0.08]]) # ... image 3 (0.9)

# 0 = dog, 1 = cat, 2 = human

# image 1 dog, image 2 cat, image 3 cat

class_targets = [0, 1, 1]

print(softmax_outputs[[0, 1, 2], class_targets])

# softmax_outputs[[0,1,2]] 指的是取第0行、第1行、第2行

# 这一段等价于下面的代码

for i, j in enumerate(class_targets):

print(softmax_outputs[i][j])因为按照前面讲的,我们只需要真实label中类别(也就是真实类别)的预测概率,这对于计算交叉熵是有用的。

所以我们需要明确每一个样本对应其真实label中的类别的预测概率,

也就是取出softmax中第i个样本对应其真实label也就是第j列的值,

那么softmax_outputs[[0, 1, 2], class_targets],其实切片逻辑就是上面讲的zip一一取对应的。

python

# Apply loss function to our softmaxed values

# 其实就是每一个样本的交叉熵损失分别算

# 我们还是只要看当样本的逻辑

# 单样本前面演示了, 是 - Σ y_true * log( y_pred), 因为我们只看真实类别的独热贡献, 所以- 1 * log( y_pred ) = - log ( y_pred )

# 下面其实就是按照zip取对应值,然后算每一个y_pred的-log

neg_log = -np.log(softmax_outputs[

range(len(softmax_outputs)), class_targets

])

# 然后样本之间取均值

average_loss = np.mean(neg_log)

print(neg_log) # all cce's

print(average_loss) # average over batch

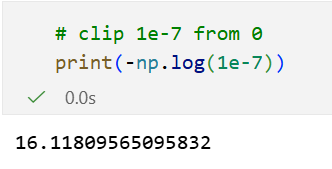

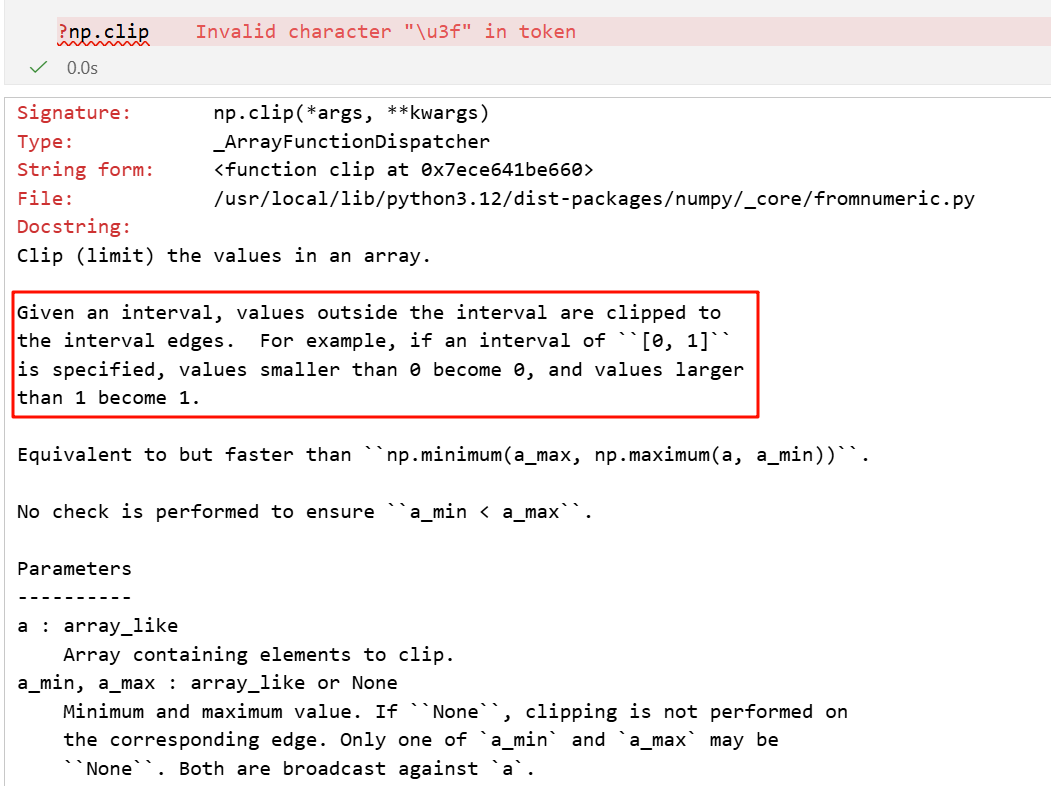

当然,很自然的,我们会遇到一个问题,就是如果在对应label处预测概率为0该怎么办------很常见,比如说预测器就是预测完全错误,会有log(0)。

一种选择是通过一个不显著的数量来裁剪值:

其实就是伪计数,给0值加上一个极小值来避免log0。

裁剪预测值可以确保我们不会遇到这个问题:

python

# y_pred_clipped = np.clip(y_pred, 1e-7, 1 - 1e-7)

就是给定一个裁剪的上下界,然后数组中小于最小值的元素替换为下界,

数组中大于最大值的元素,替换为上界;

界于两者之间的元素保持不变。

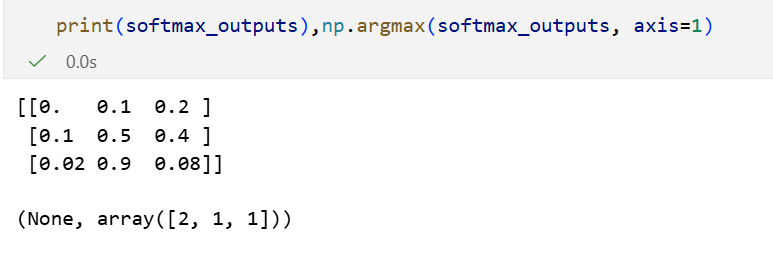

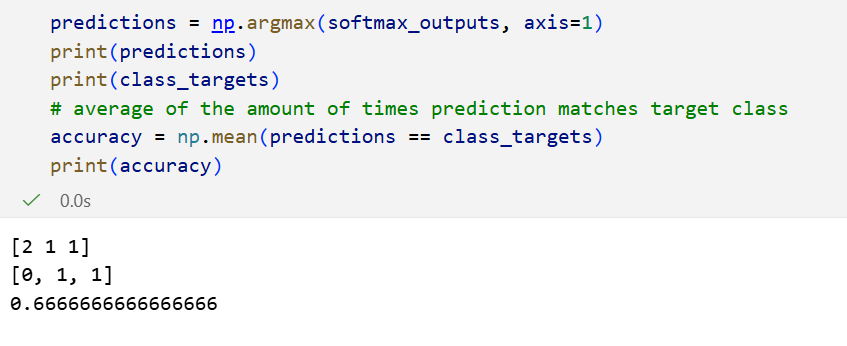

那么我们如何解释准确率(Accuracy)?

其实准确率是针对于每个样本的类别预测问题/任务而定的,

所以其实我们光看softmax的输出,取预测概率最大的那个值/位置,看看位置/值和正确类别的是不是match,其实就是指示函数了。

那按照样本,也就是按照行来取每一行的列max(就是列1列的index,按照行取,也就是axis=1逻辑)。

准确率,也就是位置匹配是2/3:

python

predictions = np.argmax(softmax_outputs, axis=1)

print(predictions)

print(class_targets)

# average of the amount of times prediction matches target class

accuracy = np.mean(predictions == class_targets)

print(accuracy)

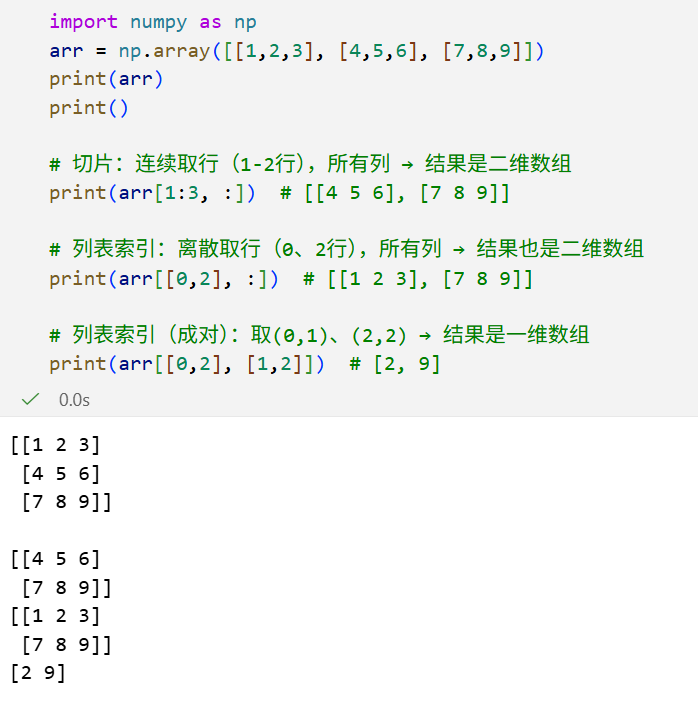

这里还有一个小细节容易搞混,就是矩阵/张量的索引/切片,其实这个也是numpy中的基础,就和前面提到的张量运算一样,但是就是基础不扎实的容易时刻犯迷糊。

step1:先明确「维度结构」

不管是几维张量,先把「维度顺序」和「每个维度的含义」拆清楚:

- 二维张量(矩阵):

(行维度, 列维度)→ 对应[行索引, 列索引] - 三维张量:

(样本维度, 通道维度, 高维度)→ 对应[样本索引, 通道索引, 高索引] - 通用规则:逗号分隔不同维度,每个维度内的索引 / 切片只作用于当前维度。

step2:按「索引类型」分类记忆

所有花式取数都可以归为 5 类,从简单到复杂逐一掌握:

| 索引类型 | 语法示例 | 作用说明 | 适用场景 |

|---|---|---|---|

| 单元素索引 | arr[2, 5] |

取第 2 行、第 5 列的单个元素(维度从 0 开始) | 精准取某个值 |

| 切片索引 | arr[1:4, :] |

取 1-3 行(左闭右开)、所有列 | 取连续的行 / 列 |

| 列表索引(花式) | arr[[0,2,4], [1,3,5]] |

取 (0,1)、(2,3)、(4,5) 三个元素 | 取离散的、成对的元素 |

| 列表索引(整行) | arr[[0,2,4], :] |

取 0、2、4 行的所有列 | 取离散的行 / 列 |

| 布尔索引 | arr[arr>0.5, :] |

取所有行中值 > 0.5 的行、所有列 | 按条件筛选元素 |

最容易搞混的其实就是列表索引 vs 切片索引

python

import numpy as np

arr = np.array([[1,2,3], [4,5,6], [7,8,9]])

# 切片:连续取行(1-2行),所有列 → 结果是二维数组

print(arr[1:3, :]) # [[4 5 6], [7 8 9]]

# 列表索引:离散取行(0、2行),所有列 → 结果也是二维数组

print(arr[[0,2], :]) # [[1 2 3], [7 8 9]]

# 列表索引(成对):取(0,1)、(2,2) → 结果是一维数组

print(arr[[0,2], [1,2]]) # [2, 9]

比如说最后一个,最容易搞混,我们很容易认为是取第0、2行,然后再取第1、2列,那么结果不应该是2x2 shape的tensor吗?

其实不是的,

其实我们可以发现,没有对切片套list的表达方式,

所以我们其实可以光看索引,[0,1]是list形式,0:2是切片形式。

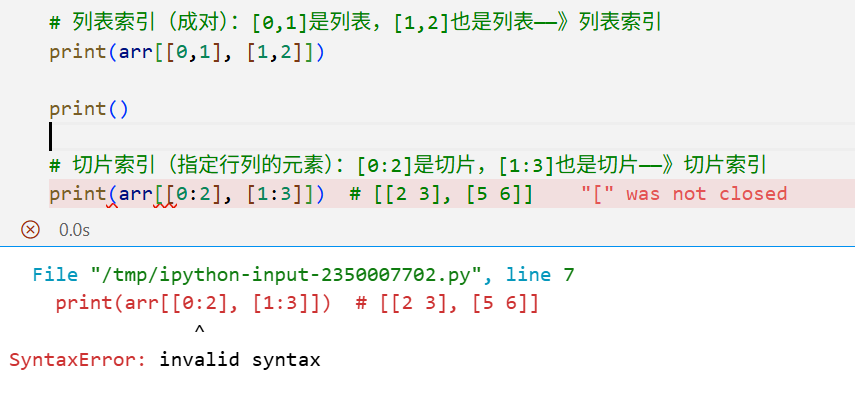

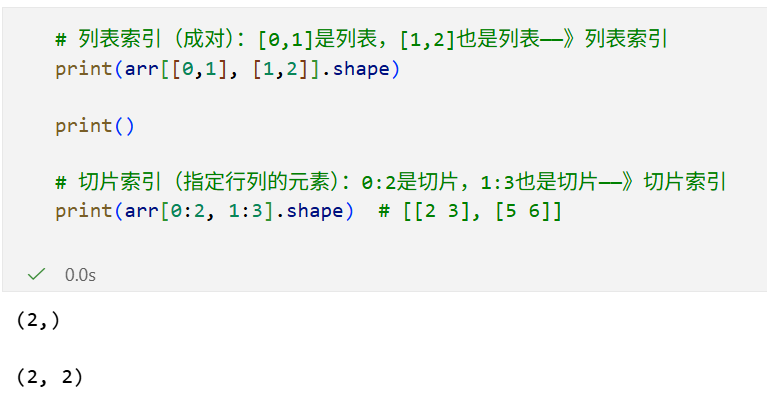

python

# 列表索引(成对):[0,1]是列表,[1,2]也是列表------》列表索引

print(arr[[0,1], [1,2]])

print()

# 切片索引(指定行列的元素):0:2是切片,1:3也是切片------》切片索引

print(arr[0:2, 1:3]) # [[2 3], [5 6]]

# ✅ 关键:列表索引如果是「多维度成对」(如[行列表, 列表表]),是按位置一一对应取元素;如果是「单维度列表 + 其他维度切片」,是取「指定行 / 列的所有元素」。

✅ 关键:列表索引如果是「多维度成对」(如[行列表, 列表表]),是按位置一一对应取元素;如果是「单维度列表 + 其他维度切片」,是取「指定行 / 列的所有元素」。

列表索引在多维度同时使用时,不是「取行 + 取列」的笛卡尔积,而是「按位置配对取元素」。

明确两个完全不同的索引逻辑

| 需求描述 | 索引写法(正确) | 逻辑本质 | 结果形状 |

|---|---|---|---|

| 取 0、2 行 + 1、2 列(4 个元素) | arr[[0,2], :][:, [1,2]] 或 arr[np.ix_([0,2], [1,2])] |

先取行、再取列(笛卡尔积) | (2,2) |

| 取 (0,1)、(2,2) 两个元素 | arr[[0,2], [1,2]] |

按位置配对取元素(zip 逻辑) | (2,) |

Numpy/PyTorch 设计「多维度列表索引」时,核心规则是:

当多个维度同时传入等长的列表时,索引会按「位置一一配对」,而非「遍历所有组合」****。

所以,arr[[0,2], [1,2]] 其实等价于:

python

indices = list(zip([0,2], [1,2])) # 配对成[(0,1), (2,2)]

result = [arr[i,j] for i,j in indices] # 取arr[0,1]和arr[2,2]索引规则要求:第 k 个行索引 配 第 k 个列索引,最终只取「配对后的元素」,而非所有行 × 列的组合。

就是很符合zip的感觉。

这个规则不是 "反直觉",而是为了满足「按样本取对应类别」 这类高频场景:

- 比如 softmax 输出

(N,C),每个样本(行)要取对应的目标类别(列); - 如果用笛卡尔积,会取出

N×C个元素,完全不符合需求; - 而 zip 逻辑能精准实现「第 i 个样本取第 i 个类别」,这是深度学习、数据分析中最常用的花式索引场景。

什么时候是 zip,什么时候是笛卡尔积?

| 索引特征 | 执行逻辑 | 示例 | 结果 |

|---|---|---|---|

| 多维度都传等长列表 | zip 配对 | arr[[0,2], [1,2]] |

[2,9] |

只有一个维度传列表,其他用: |

笛卡尔积 | arr[[0,2], :] |

[[1,2,3],[7,8,9]] |

用np.ix_(行列表, 列表表) |

笛卡尔积 | arr[np.ix_([0,2],[1,2])] |

[[2,3],[8,9]] |

总之简单记忆:

多维度列表索引 = 按位置配对,单维度列表 + 切片 = 笛卡尔积

(行列列表取zip)。

多维度等长可迭代索引 = 按位置配对,和 "是不是列表" 无关

6,Backpropogation 反向传播

参考维基百科:https://en.wikipedia.org/wiki/Backpropagation

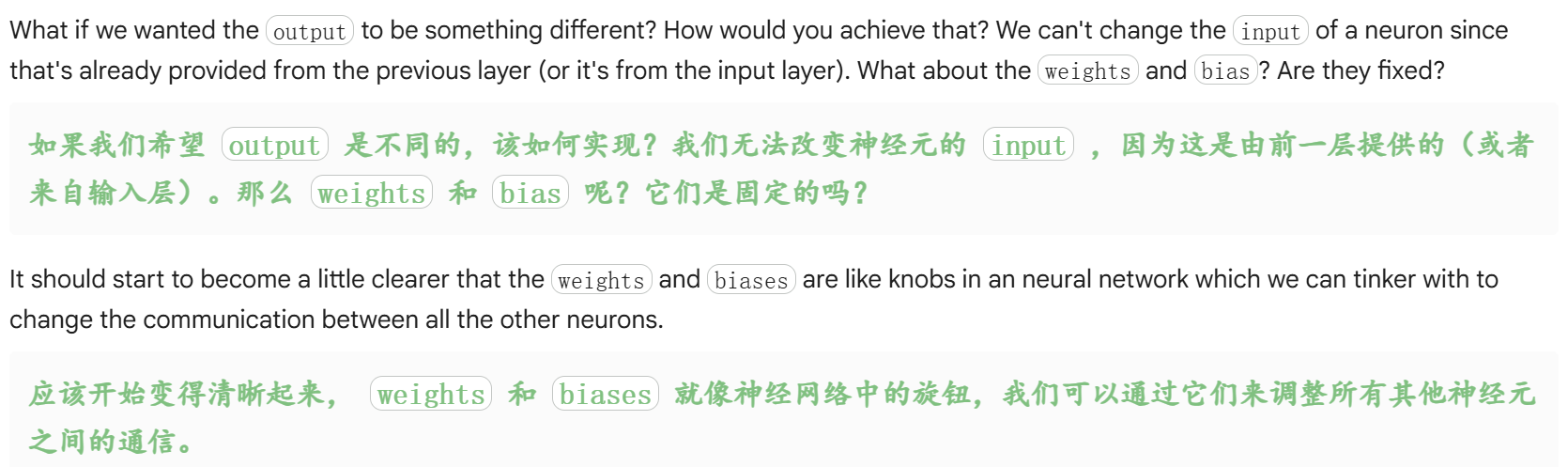

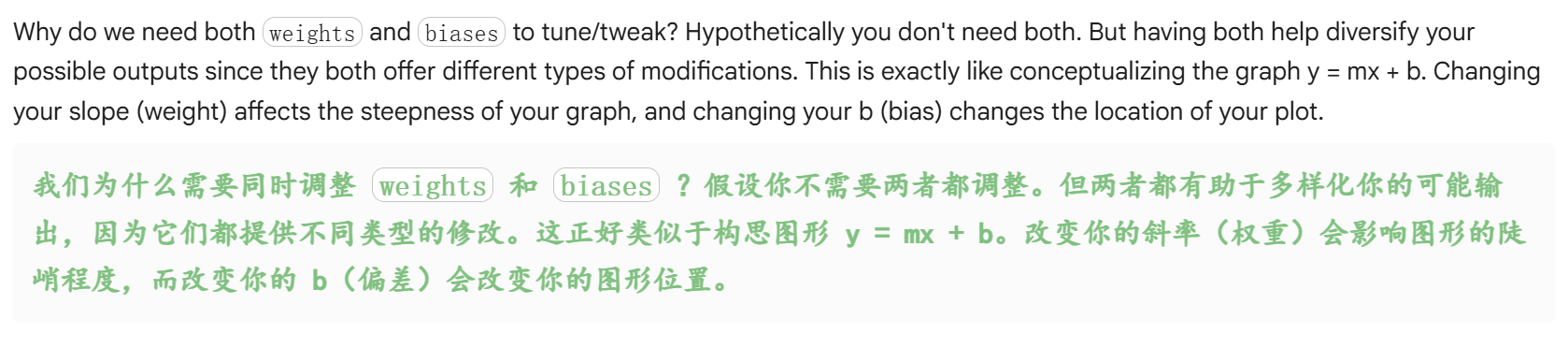

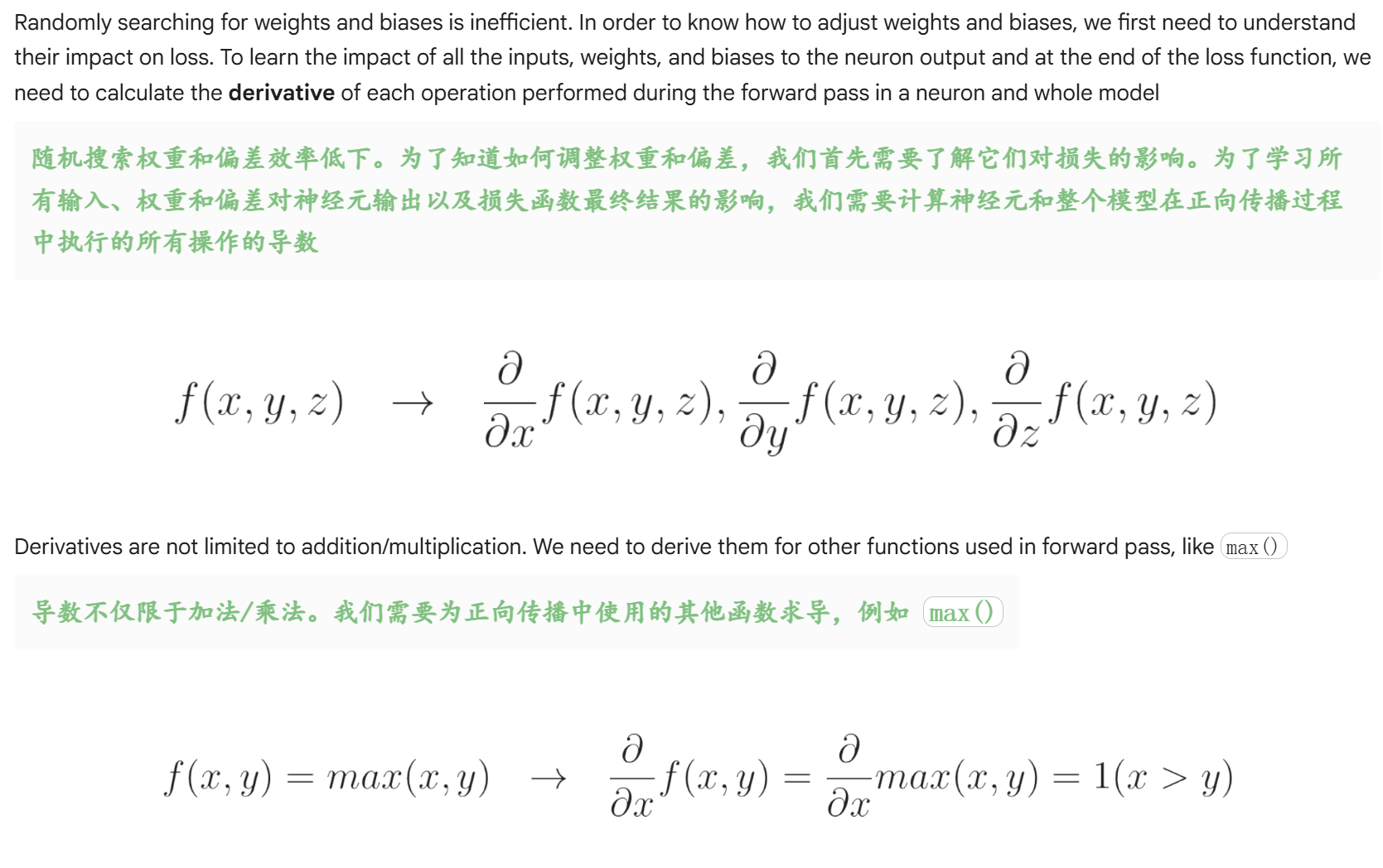

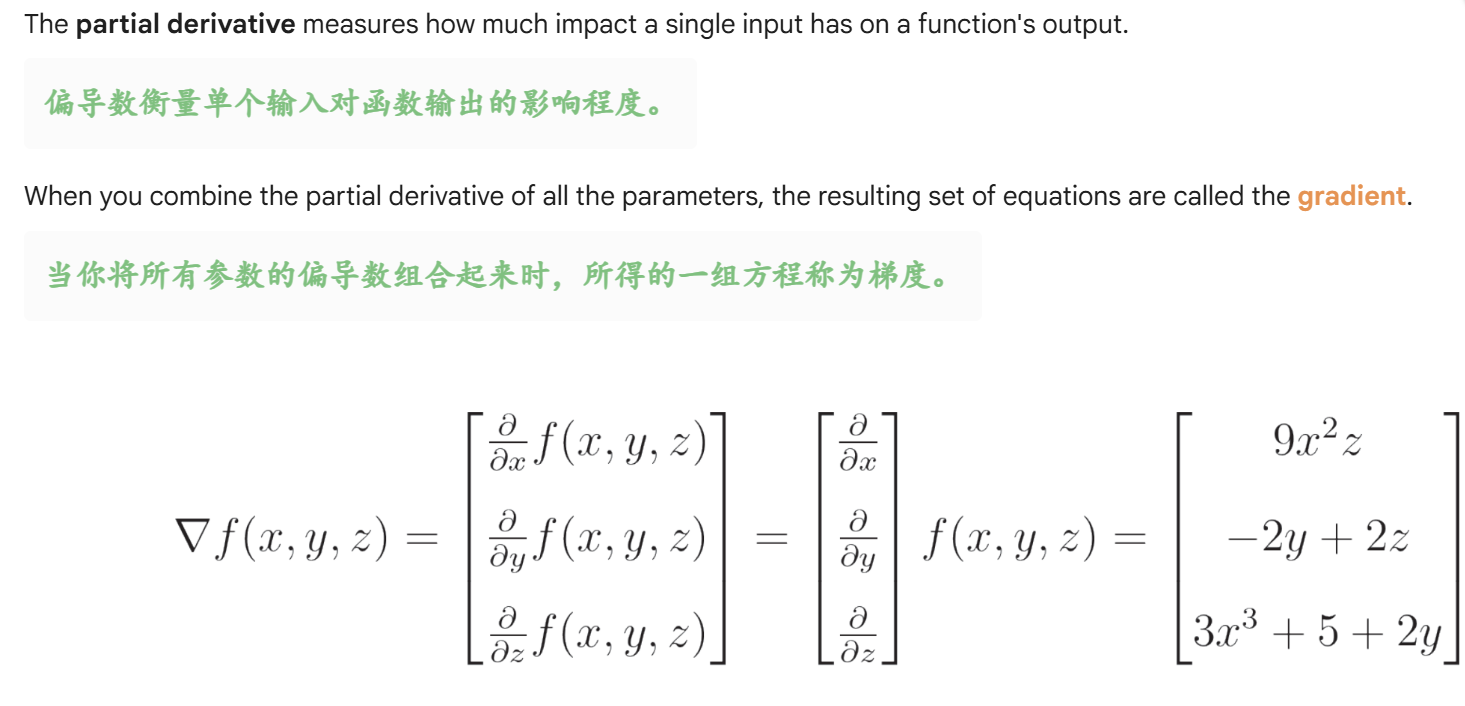

我们为什么需要导数和偏导数?

换句话说,为什么在深度学习中,我们会频繁地用到数学分析中这一部分的知识?

简单来说,了解各种操作的导数,是为了高效地优化模型的权重和偏差,从而最小化损失函数,这是机器学习(尤其是深度学习)中梯度下降算法的核心基础。

最直接地,loss是我们要优化的目标,参数(weights、bias等)是我们能够修改的。

我们想当然地希望知道输入如何变化,输出会如何变化,知道了规律之后我们才能够通过调整输入去影响输出、调整输出。

把某个参数调大一点,损失会变大还是变小?变化的幅度是多少?这就是微分/导数的基本概念。

- 随机调整参数行不通模型的权重和偏差是决定预测结果的关键参数。如果靠 "随机搜索" 去试不同的参数组合,不仅效率极低,还几乎不可能找到最优解 ------ 尤其是当模型有上万甚至上亿个参数时,这种方法完全不具备可行性。

- 参数调整的依据是 "对损失的影响"我们的目标是让模型的预测值尽可能接近真实值,也就是让损失函数的值变得最小。而要调整权重和偏差,首先得知道:把某个参数调大一点,损失会变大还是变小?变化的幅度是多少?这个 "参数对损失的影响程度",在数学上的量化指标就是导数(梯度)。导数的正负号告诉我们参数该往哪个方向调(正号表示调大参数会让损失增加,所以要调小;负号则相反),导数的绝对值告诉我们调整的幅度该多大。

- 正向传播的操作导数,是链式求导的前提神经网络的预测过程是正向传播:输入数据经过神经元的加权求和、激活函数等一系列操作,最终输出预测值并计算损失。而损失函数是关于所有权重、偏差和输入的复合函数,要计算参数对损失的导数,需要用到链式法则。这就要求我们必须先算出正向传播中每一个操作(比如加权运算 y=wx+b、激活函数 σ(y) 等)的导数,再通过链式法则把这些导数串联起来,最终得到参数对损失的梯度。

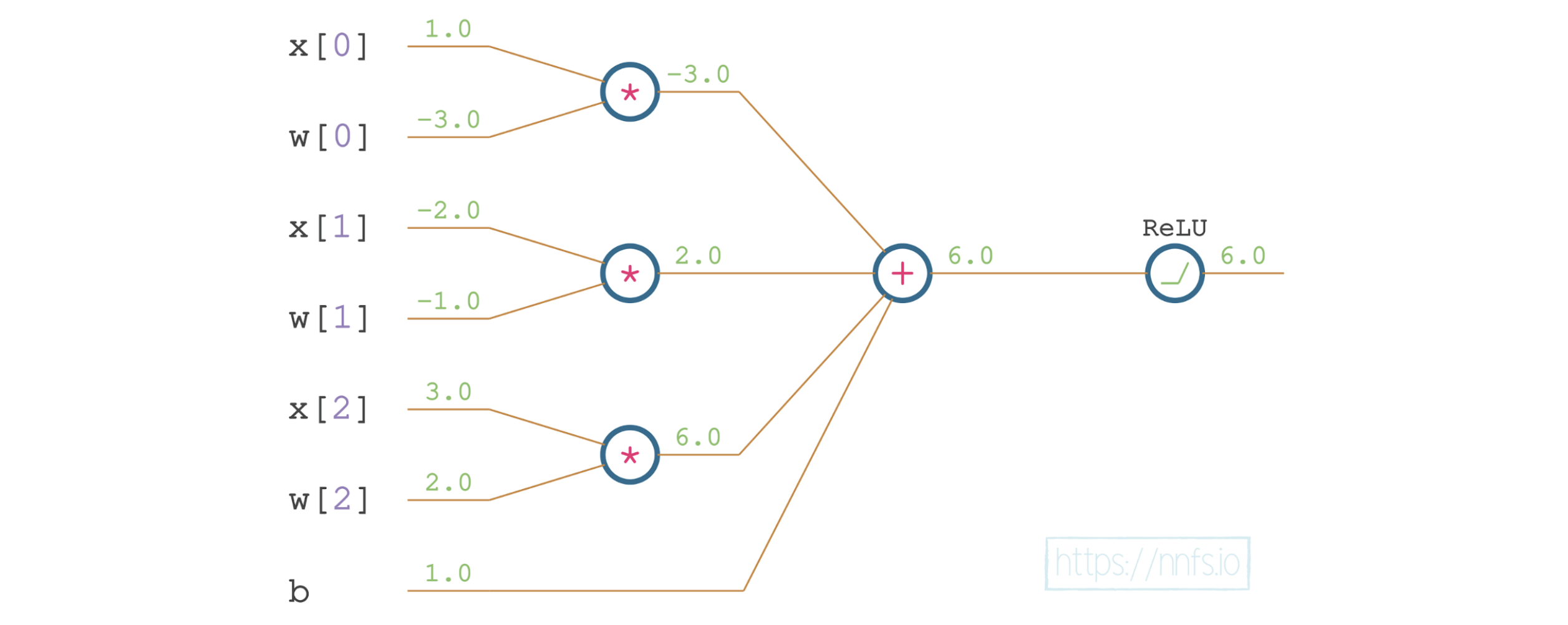

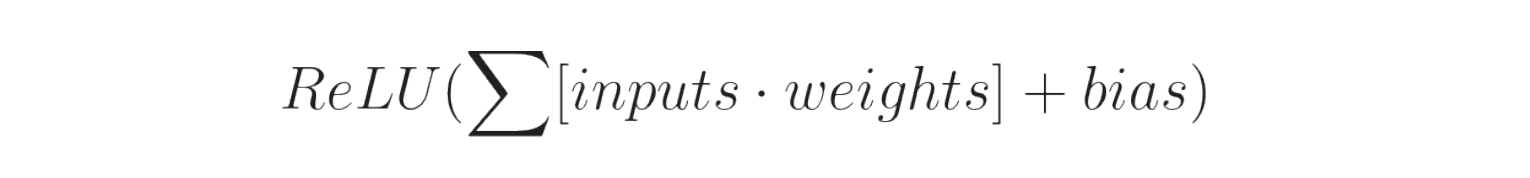

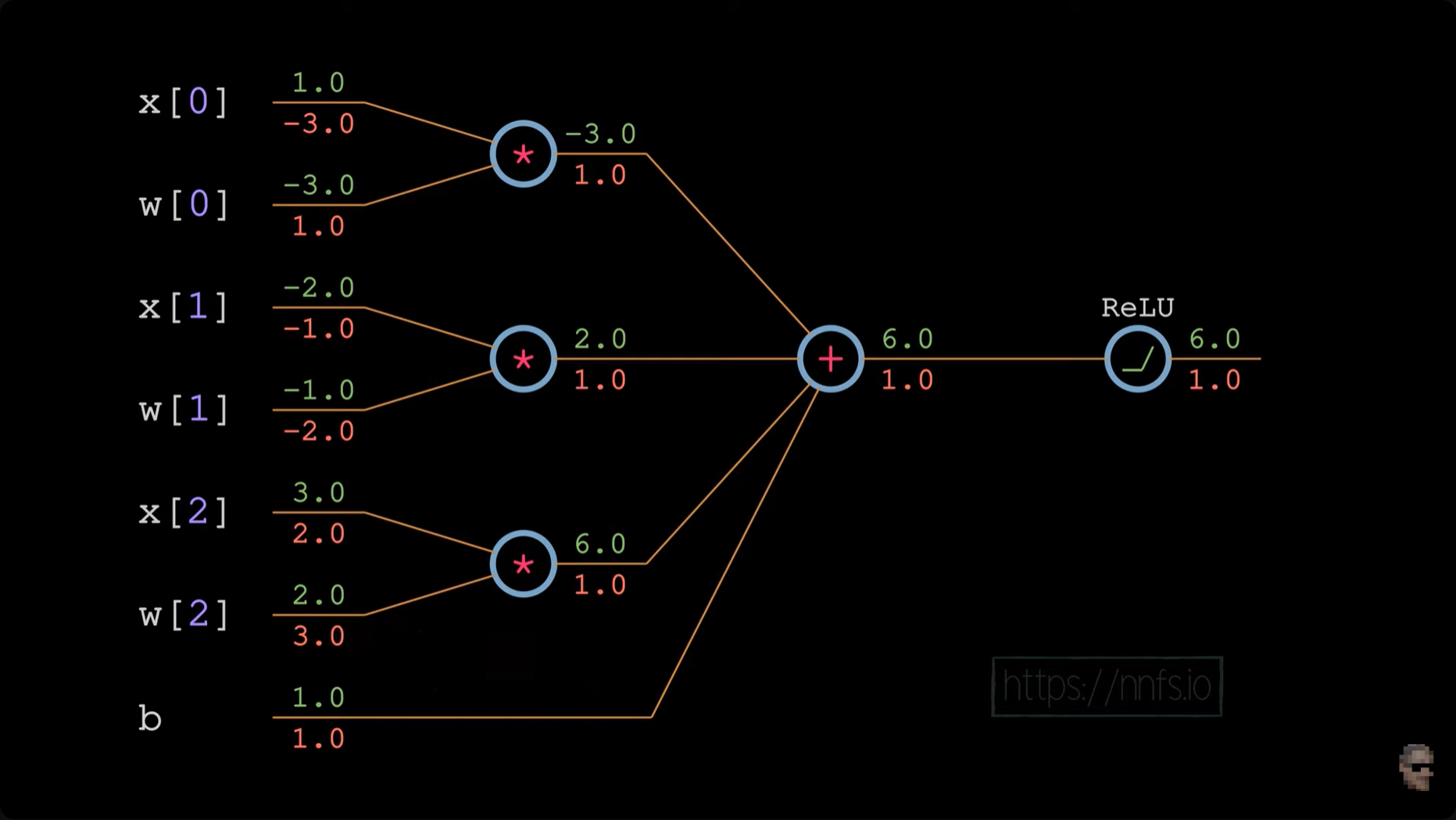

让我们反向传播单个神经元的 ReLU 函数,并假设我们打算最小化该单个神经元的输出。我们将利用链式法则和导数以及偏导数来计算每个变量对 ReLU 激活输出的影响。

python

# neuron with 3 inputs

x = np.array([1.0, -2.0, 3.0]) # inputs

w = np.array([-3.0, -1.0, 2.0]) # weights

b = 1.0 # bias

## forward pass

# input*weights

xw0 = x[0] * w[0]

xw1 = x[1] * w[1]

xw2 = x[2] * w[2]

# add bias

z = xw0 + xw1 + xw2 + b

# ReLU activation function

y = max(z, 0)

print(y)

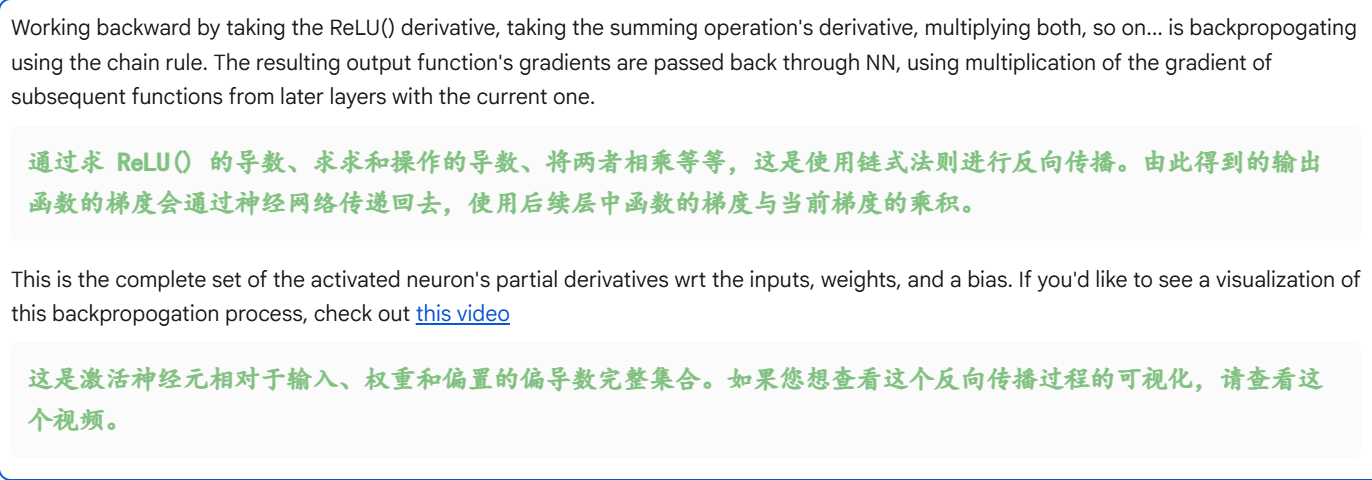

第一步是通过链式法则计算每个参数和输入的导数和偏导数,从而反向传播我们的梯度。我们面临的嵌套函数可以写成如下形式。

(在机器学习和数学语境中,wrt 是 with respect to 的缩写,意思是 "关于......")

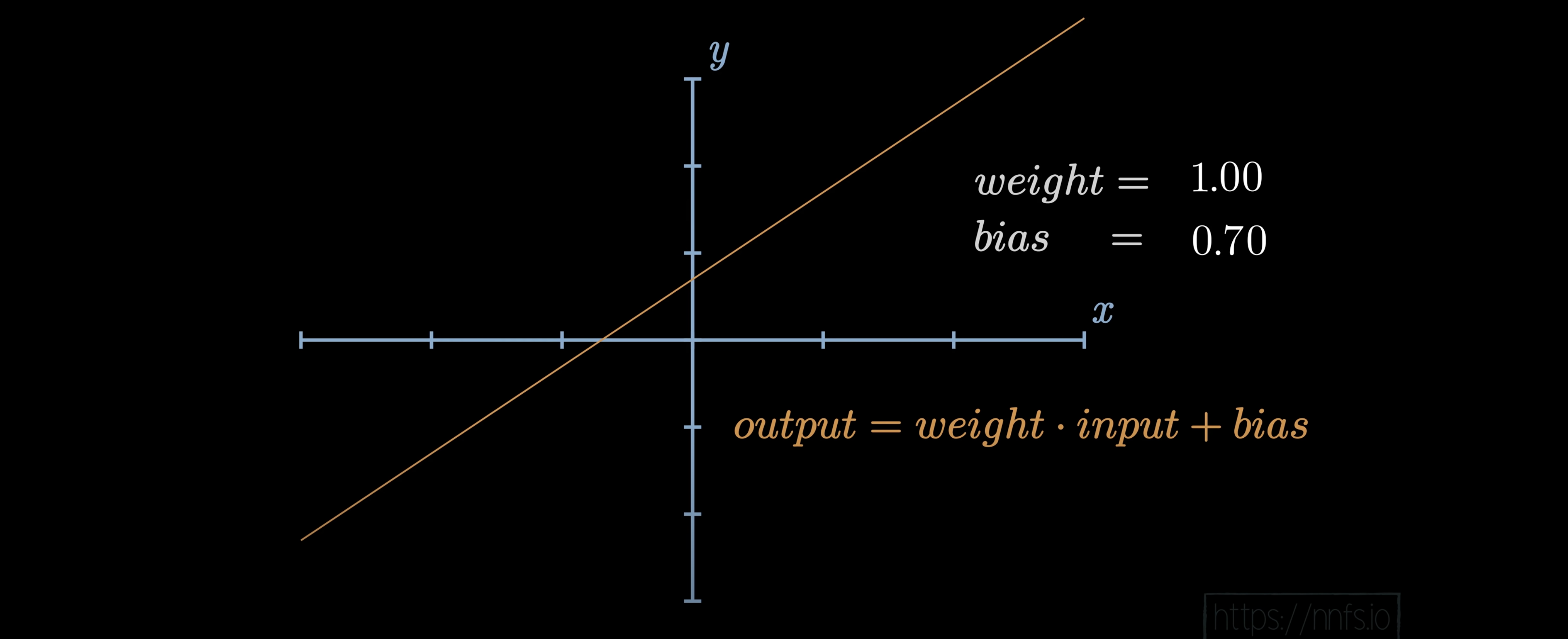

1. 导数的两种核心用途:针对"参数" vs 针对"输入"

在反向传播中,会计算两类导数,它们的作用完全不同:

- 针对权重(weights)和偏置(bias)的导数

权重和偏置是神经网络的"可学习参数",其导数直接反映了"该参数的微小变化会如何影响最终的损失函数(Loss)"------导数绝对值越大,说明该参数对模型误差的影响越强。

这些导数最终会用于更新参数 (比如通过梯度下降:新参数 = 旧参数 - 学习率×导数),从而让模型逐步降低误差、提升性能。 - 针对层输入(layer inputs)的导数

层输入的导数不直接用于更新参数,而是为了串联多层网络。因为深层神经网络由"输入层→隐藏层→输出层"的链式结构组成,要计算前一层(更靠近输入层)参数的导数,必须先知道当前层输入的导数------通过将当前层输入的导数"传递给链中的前一个函数",才能反向推导前一层参数对损失的影响,实现"从输出层往输入层"的反向传播。

2. 反向传播的核心操作:损失函数导数 + 链式法则

要实现上述两种导数的计算,核心逻辑是两步:

- 计算损失函数的导数:损失函数(如交叉熵、MSE)衡量模型预测值与真实值的差距,其导数是反向传播的"起点"------告诉我们"当前模型误差的整体方向"。

- 应用链式法则:神经网络的每一层都由"线性变换(权重×输入+偏置)+ 激活函数(如ReLU、Sigmoid)"组成,多层叠加后相当于"函数的函数"。根据链式法则,需要将"损失函数的导数"与"所有连续层中激活函数的导数、神经元线性变换的导数"依次相乘,才能逐步推导到"权重/偏置的导数"和"前一层输入的导数"。

3. 反向传播的本质:"反向递推"的逻辑

为什么要"反向传播到前一层"?

因为模型的误差是在输出层产生的(预测值与真实值对比),但误差的根源可能来自前层参数的不合理(比如某隐藏层权重设置不当,导致后续层输入失真)。通过"层输入导数"的传递,能将输出层的误差"回溯"到前层,进而计算前层参数的导数并更新------这正是"反向传播"名字的由来,也是深层网络能有效学习的关键。

神经网络的计算是分层的正向流程:输入层 → 隐藏层 → 输出层,数据是从前往后 "流" 的,这叫正向传播。

而计算梯度的时候,必须反过来算:

梯度的起点是 输出层的损失函数(因为误差是在输出层才和真实标签对比出来的)。

然后从输出层往隐藏层、再往输入层倒着算 ------ 先算靠近输出层的参数梯度,再把梯度信息传递给前一层,算出前一层参数的梯度。

整个梯度的计算和传递方向,和数据正向流动的方向完全相反。

所以 "反向" 这个词,是精准描述了梯度的传递方向,不是随便起的。

从本质上讲,反向传播的概念本来就没有什么神奇的,就是我们正常理工科在大一学的数学分析中的链式法则的简单工程应用。

原理是万变不离其宗,应用场景可以很高大上,起个高大上的名字不影响我们看本质。

简单来说:反向传播是针对多层神经网络的 "定制版链式法则应用"------ 它明确了 "从损失出发、从后往前逐层算梯度" 的执行步骤,还规定了 "层与层之间梯度怎么传递"。

没有这个名字,工程师之间没法精准沟通 "怎么给神经网络算梯度",总不能每次都讲 "用链式法则从输出层倒着算权重梯度" 吧?

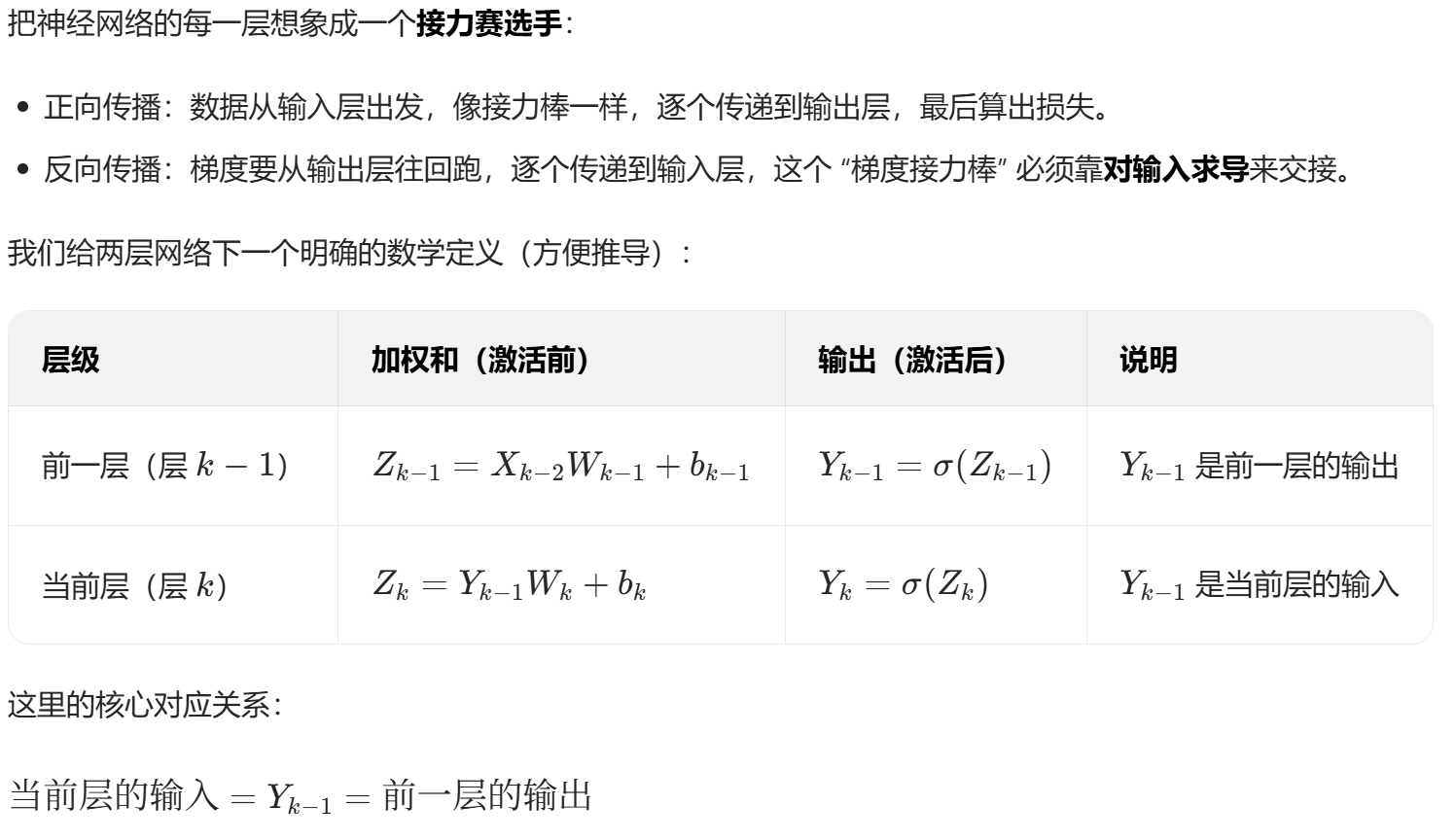

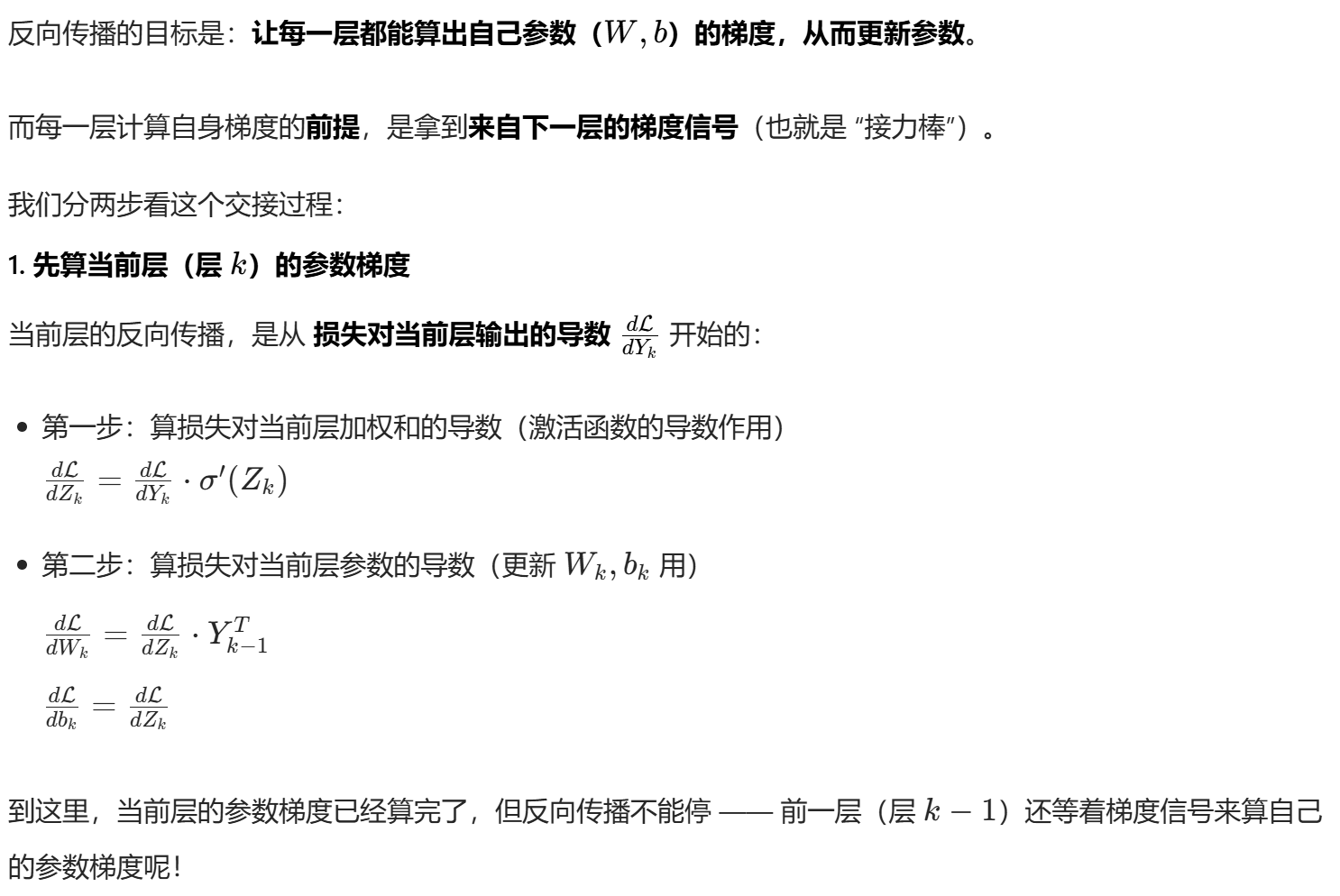

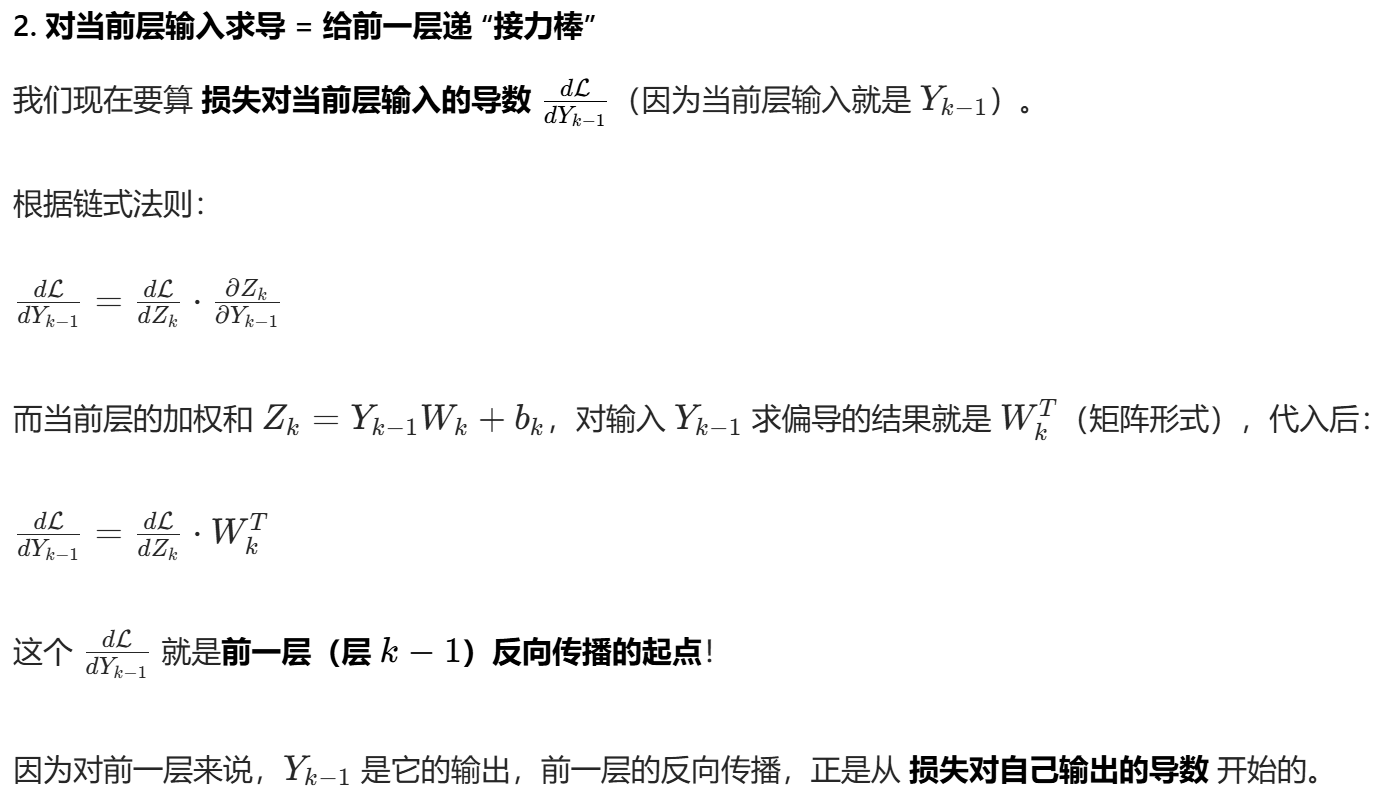

两个梯度:参数梯度与输入梯度

比如说算一个网络的的梯度信息的反向传播,

我们一定要明确,反向传播的梯度信息,是要计算两个梯度:

- 参数梯度:这个是毋庸置疑的,因为我们本身就是需要更新参数来调整loss,所以每一层对参数的求导也就是梯度是必要的

- 输入梯度:对输入层的求导,这个也是必要的,因为我们要更新的不是某一层的参数梯度,我们要更新的是所有层的参数梯度。举例来说,当前层的参数梯度更新完了,只能说当前层能够学习,如何把这个更新信息传递给上一层,让上一层也进行梯度更新?关键就是对当前层的输入进行求导,因为当前层的输入就是上一层的输出,这样我们就拿到了这一层与上一层的连接信息,那么这一层的输入梯度其实就相当于是上一层的输出梯度。我们可以把这个输出的梯度作为起点,那么我们此时的关注对象就自然迁移到了上一层,那么接着对参数求导,然后对上一层的输入求导(将梯度信息传递下去,这个是关键)

这段公式的写法逻辑,就是把每一个中间项都当成 "待传递的梯度节点",故意不把导数 "求尽",而是拆成一步步的链式传递。

而且也明写了既要求参数梯度(x0w0对w0求导),也要求输入梯度(x0w0对x0求导)。

公式里单独对x0w0求偏导,相当于把加权和

单独拆分成了求和--->乘积两个子步骤,反向传播时,梯度要先穿过"求和",再穿过"乘积",这两步都要单独算。

单独拆分成了求和--->乘积两个子步骤,反向传播时,梯度要先穿过"求和",再穿过"乘积",这两步都要单独算。

我以前刚入门的时候,对这里的步骤也很困惑,数学上能够理解,就是全微分与偏导数,很简单。

但是不明白为什么要每一步拆成这样写,

- 从数学上,全微分 / 链式法则是否要求必须同时对输入和参数求导?

- 为什么反向传播的公式里,非要把这两种导数都算出来,而不是只算参数导数?

答案很明确:从数学本质上,链式法则本身不强制要求同时算,但反向传播的工程目标(多层网络训练),决定了必须同时算这两类导数。

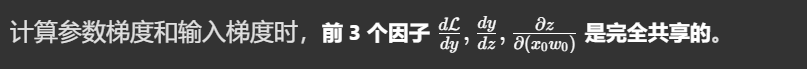

其实我们可以发现:

所以数学上,不是链式法则 "强制" 要算输入梯度,而是算参数梯度的中间产物,刚好可以 "顺便" 算出输入梯度------ 相当于买一送一,完全没必要浪费这个中间结果。

从工程目标上:多层网络训练,必须要输入梯度才能 "链式串联"。

这才是反向传播必须算输入梯度的根本原因,也是前面英文文档里反复强调的点:chain more layers

python

The derivative wrt the inputs are used to chain more layers by passing them to the previous function in the chain关键在于MLP多层网络,我们必须把梯度信息传给前一层,如果只算参数梯度那只能更新当前层,只有对输入也求梯度,才能将梯度传给前一层。

层与层之间的连接关系是本质需求

对当前层输入求导,本质是把当前层的梯度信号,转化为前一层的梯度起点,没有这个转化,梯度就无法 "回传" 到前一层,前一层也就没法计算自己的参数梯度。

回到我们前面的梯度反向传播的过程,代码细拆如下

python

## backward pass

# derivative from the next layer

dvalue = 1.0 # ∂y / ∂y = 1

print(dvalue)

# derivative of ReLU and chain rule

# (∂y / ∂y) * (∂ ReLU(z) / ∂

drelu_dz = dvalue * (1.0 if z > 0 else 0.)

print(drelu_dz)

# partial derivatives of summation, the chain rule

dsum_dxw0 = 1

dsum_dxw1 = 1

dsum_dxw2 = 1

dsum_db = 1

drelu_dxw0 = drelu_dz * dsum_dxw0

drelu_dxw1 = drelu_dz * dsum_dxw1

drelu_dxw2 = drelu_dz * dsum_dxw2

drelu_db = drelu_dz * dsum_db

print(drelu_dxw0, drelu_dxw1, drelu_dxw2, drelu_db)

# Partial derivatives of the multiplication and chain rule

dmul_dx0 = w[0]

dmul_dx1 = w[1]

dmul_dx2 = w[2]

dmul_dw0 = x[0]

dmul_dw1 = x[1]

dmul_dw2 = x[2]

drelu_dx0 = drelu_dxw0 * dmul_dx0

drelu_dw0 = drelu_dxw0 * dmul_dw0

drelu_dx1 = drelu_dxw1 * dmul_dx1

drelu_dw1 = drelu_dxw1 * dmul_dw1

drelu_dx2 = drelu_dxw2 * dmul_dx2

drelu_dw2 = drelu_dxw2 * dmul_dw2

print(drelu_dx0, drelu_dw0, drelu_dx1, drelu_dw1, drelu_dx2, drelu_dw2)

示例视频参考https://www.youtube.com/watch?v=_9qHQA30hys&t=2s

7,Optimizers 优化器

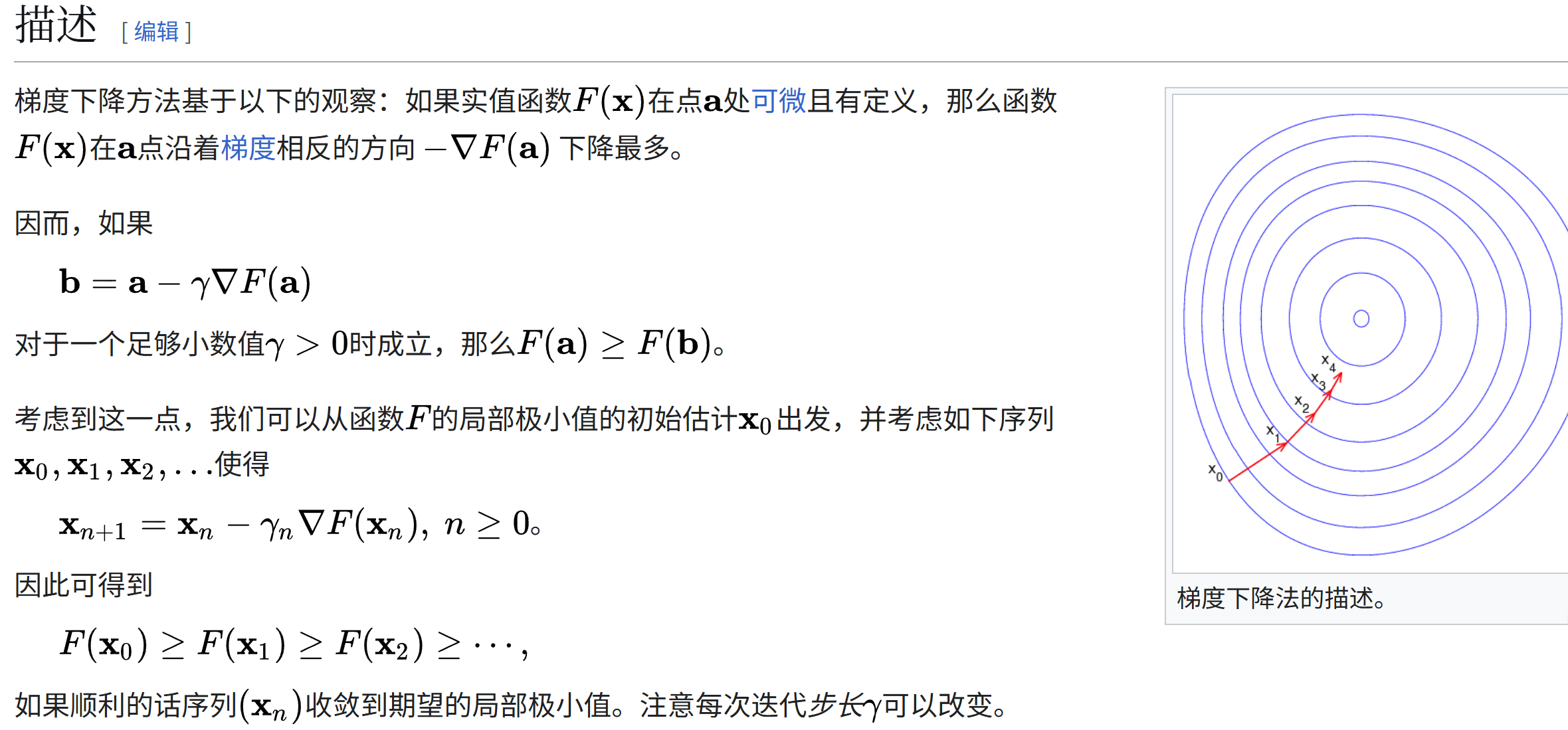

关于随机梯度下降,可以参考维基百科:

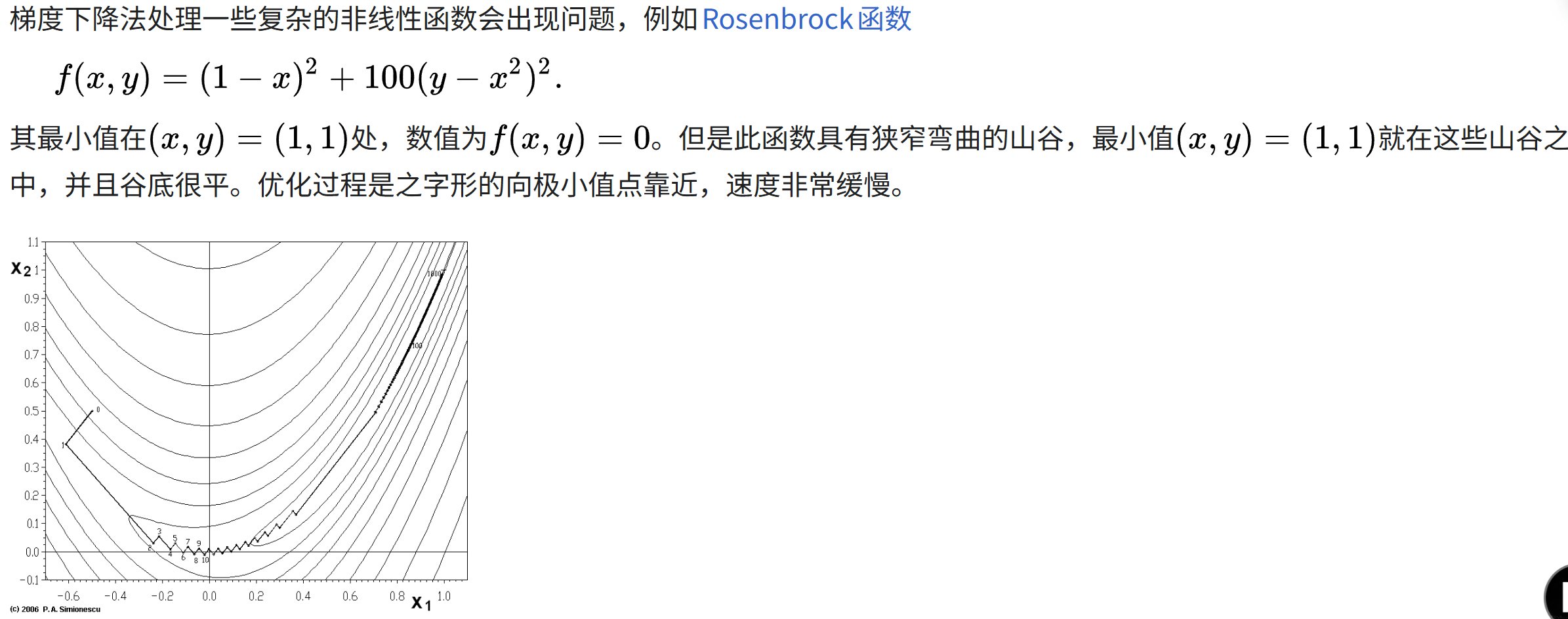

https://en.wikipedia.org/wiki/Stochastic_gradient_descent

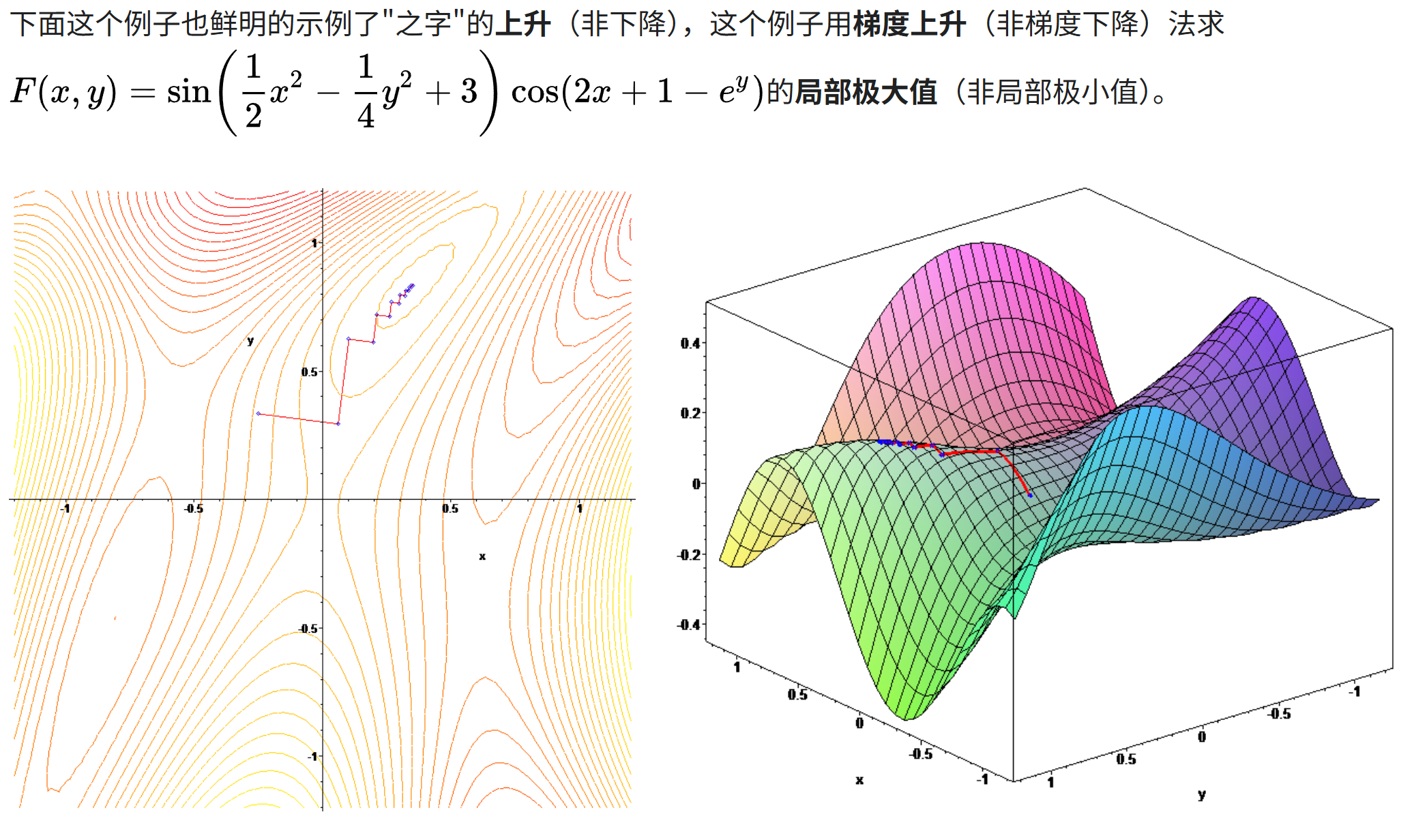

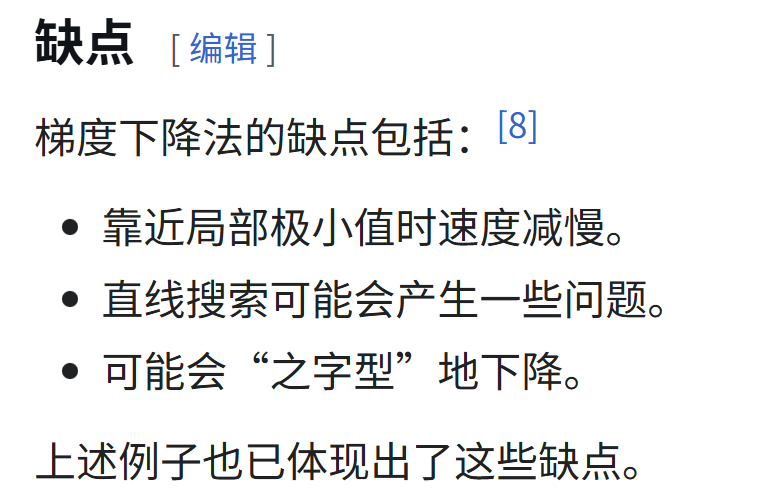

随机梯度下降(通常缩写为 SGD)是一种优化具有适当平滑性质的目标函数的迭代方法(例如可微或次可微)。它可以被视为梯度下降优化的随机近似,因为它用从随机选择的数据子集计算出的估计梯度来代替从整个数据集计算出的实际梯度。特别是在高维优化问题中,这减少了非常高的计算负担,以牺牲较低的收敛速度为代价,实现了更快的迭代。

一些数学严谨性的背后论证:

历史

SGD是一种基础的优化算法(概念很直观),动量和Adam等是在SGD的基础上进行改进和扩展的优化方法。SGD本身也是一种算法,而不是单纯的技巧,动量和Adam等方法通过引入特定的技巧来改进SGD的性能。

简单来说,SGD是基础优化算法(是算法),而动量、Adam等是技巧(trick),一般指通过技巧在SGD基础上进行改进和扩展的优化算法(简单理解就是SGD+技巧优化)。

更一般地说:SGD是一种基础优化算法,而动量和Adam等是在SGD的基础上引入了特定机制或策略来改进性能的优化算法。这些机制或策略可以被看作是"技巧",但它们本身构成了完整的优化算法。

8,Learning rate and momentum 学习率和动量

网上教材很多,总之要看通俗一点的解释,可以参考李宏毅老师油管的网课:

2021年网课版,这5节课1个系列,对于训练的一些常识解释得比较通俗易懂。

9,Complete Neural Network from scratch 从头开始构建完整的神经网络

定义模型:1个Workshop的示例

直接上代码

python

# Dense layer

class Layer_Dense:

"""

Dense layer of a neural network

Facilitates:

- Forward propogation of data throught layer

- Backward propogation of gradients during training

"""

# Layer initialization

def __init__(self, n_inputs, n_neurons):

# Initialize weights and biases

self.weights = 0.01 * np.random.randn(n_inputs, n_neurons)

self.biases = np.zeros((1, n_neurons))

# Forward pass

def forward(self, inputs):

# Remember input values

self.inputs = inputs

# Calculate output values from inputs, weights and biases

self.output = np.dot(inputs, self.weights) + self.biases

# Backward pass

def backward(self, dvalues):

# Gradients on parameters

self.dweights = np.dot(self.inputs.T, dvalues)

self.dbiases = np.sum(dvalues, axis=0, keepdims=True)

# Gradient on values

self.dinputs = np.dot(dvalues, self.weights.T)

# ReLU activation

class Activation_ReLU:

"""

Rectified linear unit activation function

Applied to input of neural network layer

Introduces non-linearity into the network

"""

# Forward pass

def forward(self, inputs):

# Remember input values

self.inputs = inputs

# Calculate output values from inputs

self.output = np.maximum(0, inputs)

# Backward pass

def backward(self, dvalues):

# Since we need to modify original variable,

# let's make a copy of values first

self.dinputs = dvalues.copy()

# Zero gradient where input values were negative

self.dinputs[self.inputs <= 0] = 0

# Softmax classifier - combined Softmax activation

# and cross-entropy loss for faster backward step

class Activation_Softmax_Loss_CategoricalCrossentropy():

"""

Combination of softmax activation function and categorical cross entropy loss function

Commonly used in classification tasks

We minimize loss by adjustng model parameters to improve performance

"""

# create activation and loss function objectives

def __init__(self):

self.activation = Activation_Softmax()

self.loss = Loss_CategoricalCrossentropy()

# forward pass

def forward(self, inputs, y_true):

# output layer's activation function

self.activation.forward(inputs)

# set the output

self.output = self.activation.output

# calculate and return loss value

return self.loss.calculate(self.output, y_true)

# backward pass

def backward(self, dvalues, y_true):

# number of samples

samples = len(dvalues)

# if labels one-hot encoded, turn into discrete values

if len(y_true.shape) == 2:

y_true = np.argmax(y_true, axis=1)

# copy so we can safely modify

self.dinputs = dvalues.copy()

# Calculate gradient

self.dinputs[range(samples), y_true] -= 1

# Normalize gradient

self.dinputs = self.dinputs / samples

# Adam optimizer

class Optimizer_Adam:

"""

Adam optimization algorithm to optimize parameters of neural network

Initalize with learning rate, decay, epsilon, momentum

Pre-update params: Adjust learning rate based on decay

Update params: Update params using momentum and cache corrections

Post-update params: Track number of optimization steps performed

"""

# Initialize optimizer - set settings

def __init__(self, learning_rate=0.001, decay=0., epsilon=1e-7, beta_1=0.9, beta_2=0.999):

self.learning_rate = learning_rate

self.current_learning_rate = learning_rate

self.decay = decay

self.iterations = 0

self.epsilon = epsilon

self.beta_1 = beta_1

self.beta_2 = beta_2

# Call once before any parameter updates

def pre_update_params(self):

if self.decay:

self.current_learning_rate = self.learning_rate * (1. / (1. + self.decay * self.iterations))

# Update parameters

def update_params(self, layer):

# If layer does not contain cache arrays, create them filled with zeros

if not hasattr(layer, 'weight_cache'):

layer.weight_momentums = np.zeros_like(layer.weights)

layer.weight_cache = np.zeros_like(layer.weights)

layer.bias_momentums = np.zeros_like(layer.biases)

layer.bias_cache = np.zeros_like(layer.biases)

# Update momentum with current gradients

layer.weight_momentums = self.beta_1 * layer.weight_momentums + (1 - self.beta_1) * layer.dweights

layer.bias_momentums = self.beta_1 * layer.bias_momentums + (1 - self.beta_1) * layer.dbiases

# Get corrected momentum

# self.iteration is 0 at first pass

# and we need to start with 1 here

weight_momentums_corrected = layer.weight_momentums / (1 - self.beta_1 ** (self.iterations + 1))

bias_momentums_corrected = layer.bias_momentums / (1 - self.beta_1 ** (self.iterations + 1))

# update cache with squared current gradients

layer.weight_cache = self.beta_2 * layer.weight_cache + (1 - self.beta_2) * layer.dweights**2

layer.bias_cache = self.beta_2 * layer.bias_cache + (1 - self.beta_2) * layer.dbiases**2

# get corrected cache

weight_cache_corrected = layer.weight_cache / (1 - self.beta_2 ** (self.iterations + 1))

bias_cache_corrected = layer.bias_cache / (1 - self.beta_2 ** (self.iterations + 1))

# Vanilla SGD parameter update + normalization with square root cache

layer.weights += -self.current_learning_rate * weight_momentums_corrected / (np.sqrt(weight_cache_corrected) + self.epsilon)

layer.biases += -self.current_learning_rate * bias_momentums_corrected / (np.sqrt(bias_cache_corrected) + self.epsilon)

# call once after any parameter updates

def post_update_params(self):

self.iterations += 1

# Softmax activation

class Activation_Softmax:

"""

Softmax activation function for multi-class classification

Compute probabilities for each class

"""

# Forward pass

def forward(self, inputs):

# Remember input values

self.inputs = inputs

# Get unnormalized probabilities

exp_values = np.exp(inputs - np.max(inputs, axis=1, keepdims=True))

# Normalize them for each sample

probabilities = exp_values / np.sum(exp_values, axis=1, keepdims=True)

self.output = probabilities

# Backward pass

def backward(self, dvalues):

# Create uninitialized array

self.dinputs = np.empty_like(dvalues)

# Enumerate outputs and gradients

for index, (single_output, single_dvalues) in enumerate(zip(self.output, dvalues)):

# Flatten output array

single_output = single_output.reshape(-1, 1)

# Calculate Jacobian matrix of the output

jacobian_matrix = np.diagflat(single_output) - np.dot(single_output, single_output.T)

# Calculate sample-wise gradient and add it to the array of sample gradients

self.dinputs[index] = np.dot(jacobian_matrix, single_dvalues)

# Common loss class

class Loss:

# calculates data and regularization losses, given model output and ground truth values

def calculate(self, output, y):

# calculate sample losses

sample_losses = self.forward(output, y)

# calculate mean losses

data_loss = np.mean(sample_losses)

# return loss

return data_loss

# cross entropy loss

class Loss_CategoricalCrossentropy(Loss):

"""

Computes categorical cross entropy

Quantifies discrepency between predicted and true class probabilities

"""

# forward pass

def forward(self, y_pred, y_true):

# number samples in batch

samples = len(y_pred)

# clip data to prevent division by 0

# clip both sides to not drag mean towards any value

y_pred_clipped = np.clip(y_pred, 1e-7, 1 - 1e-7)

# probabilities for target values (only if categorical labels)

if len(y_true.shape) == 1:

correct_confidences = y_pred_clipped[ range(samples), y_true ]

# mask values (only for one-hot encoded labels)

elif len(y_true.shape) == 2:

correct_confidences = np.sum( y_pred_clipped * y_true, axis=1 )

# losses

negative_log_likelihoods = -np.log(correct_confidences)

return negative_log_likelihoods

# backward pass

def backward(self, dvalues, y_true):

# number of samples

samples = len(dvalues)

# Number of labels in every sample

# We'll use the first sample to count them

labels = len(dvalues[0])

if len(y_true.shape) == 1:

y_true = np.eye(labels)[y_true]

# calculate gradient

self.dinputs = -y_true / dvalues

# Normalize gradient

self.dinputs = self.dinputs / samples然后这一块因为我们要上gpu了,所以一些基础的东西也再提一下:

下面是一个标准的 nvidia-smi (NVIDIA System Management Interface) 输出界面。它展示了当前 GPU 的状态、驱动版本以及运行的进程。

具体查看,可以参考我上一篇博客:nvidia-smi输出界面

创建数据集

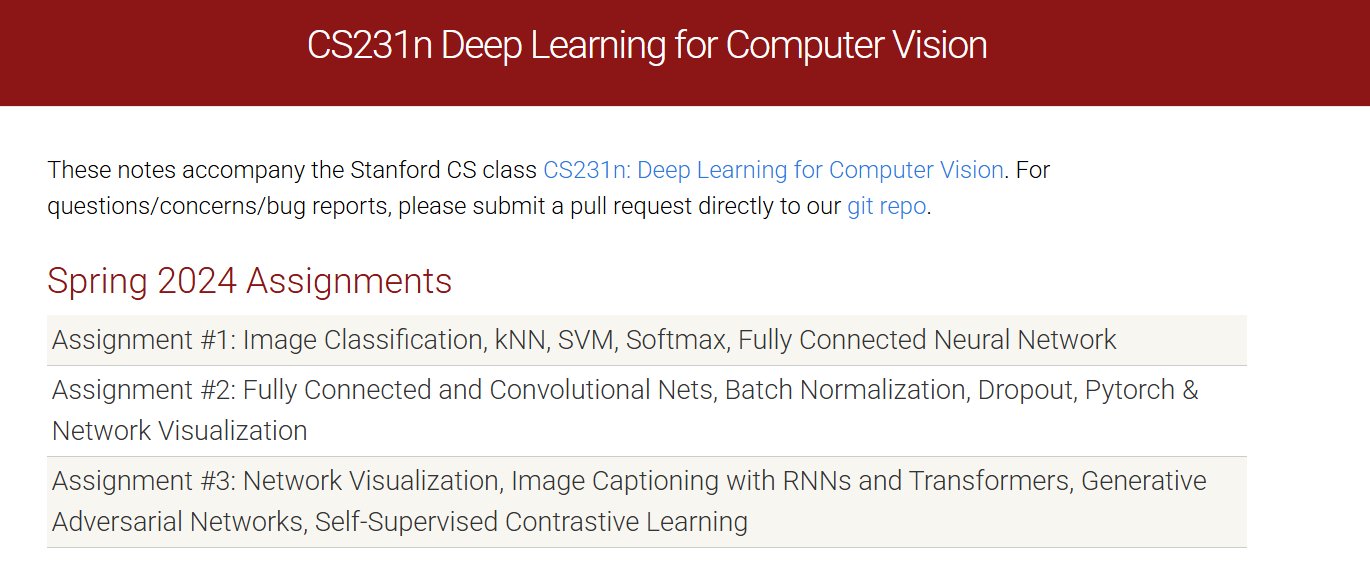

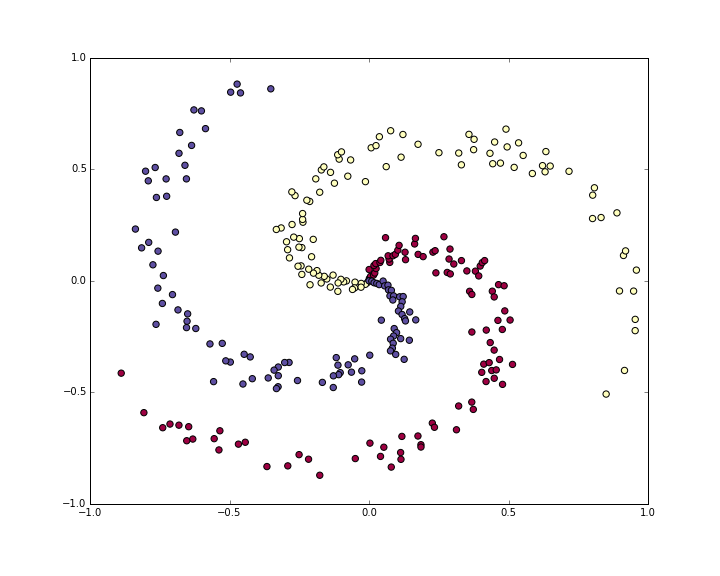

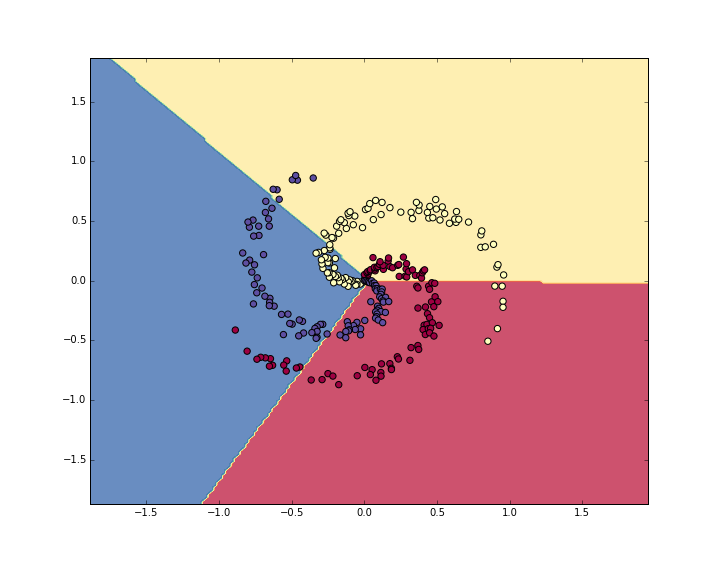

然后这里需要用到一个模拟的螺旋数据集,正好用到我们前面在前言中提到的nnfs库。

nnfs库中的一个数据集,对应函数是spiral_data

这个函数的来源是斯坦福计算机视觉课CS231n的一个case-study,

https://cs231n.github.io/neural-networks-case-study/

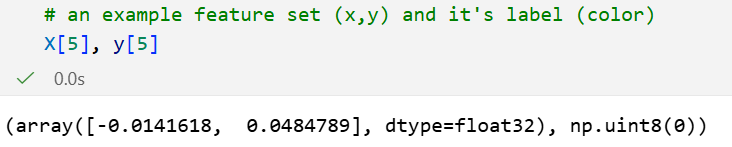

总的来说就是3个螺旋,每一个螺旋100个样本点。总共300个样本,x是训练数据,y是label。

然后X总共就两个feature,X[:, 0], X[:, 1]分别作为二维坐标。

这个问题其实是一个很经典的机器学习的分类问题,

如果是用传统机器学习,我们可以从训练一个线性分类器出发,再拓展到非线性分类器。

比如说LDA、QDA、朴素贝叶斯,SVM,决策树等等等等。

当然,我们这里讲的是深度学习,当然用的也就是神经网络的方法了。

看一下第5个样本点,以及其label(class 0)

实例化模型

softmax这里,做的功能一般是归一化,严格来说softmax是输出层的归一化函数而非典型激活函数。

毕竟只是归一化概率,并没有抑制什么信息。

但学界常将其归类为"输出层激活函数"有两大原因,在多分类网络中替代了sigmoid/tanh的末端角色,将线性输出转化为概率分布;与交叉熵损失结合时能构建有效的梯度传播路径。实际应用中需明确其定位,当问题涉及"隐藏层用什么激活函数"时(如ReLU/GELU),softmax不在讨论范围内;但若泛指"模型末端映射函数",可将其视为激活函数。

简单来说就是,很多不是很严谨的论文中会在模型模块将softmax和激活函数字眼联系在一起。

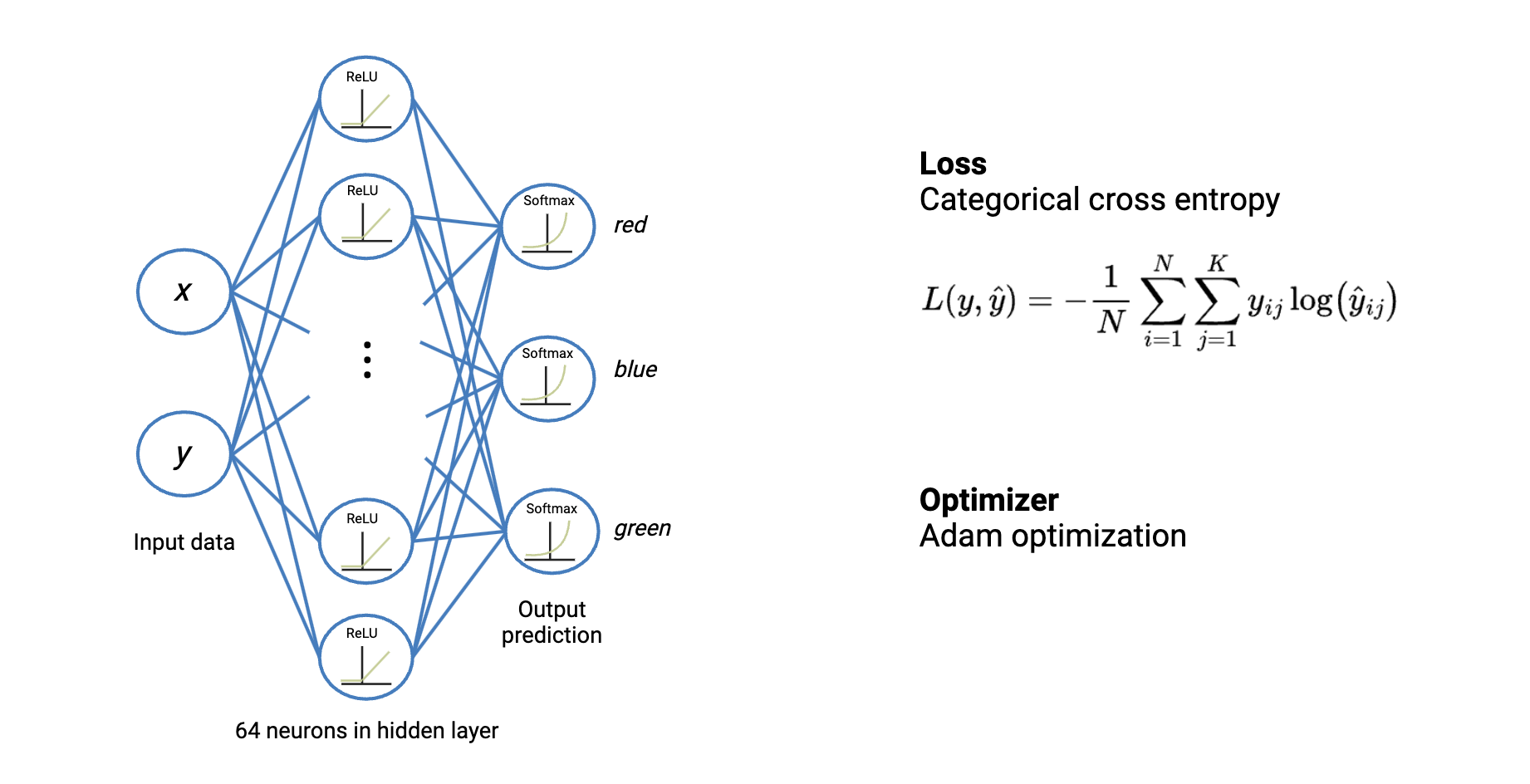

上面的这个图绘制的有点视觉误导,我觉得应该按照下面的视觉效果:

上面的这个图绘制的有点视觉误导,我觉得应该按照下面的视觉效果:

画成这样才不容易被误导:

前面我们的数据x是(300,2)二维tensor,y是(300,)一维tensor;

300个样本点,我们以1个样本点为例,比如说xi,yi,

那就是(1,2)的数据和(1,)的label。

那么数据流可以这么理解:

样本点xi,形状shape是(1,2)。

- 输入层:(1,2),也就是样本点

- Dense1(隐藏层1/全连接层1):

- 权重矩阵是(2,64)

- 运算:(1,2)dot (2,64)------》(1,64)

- ReLU激活函数:将这64个数里面小于0的变成0,也就是未激活,shape依然是(1,64)

- Dense2(隐藏层2/全连接层2):

- 权重矩阵是(64,3),因为输出层是3个神经元,对应3个类别的输出预测,有3套不同的权重+bias的参数集

- 运算:(1,64)dot (64,3)------》(1,3)

- softmax层

- 输入是(1,3)的得分

- 输出是(1,3)的概率分布(和为1)

- Loss计算

- 拿这3个概率(也就是(1,3)输出的3个分量)去和真实的标签做对比,计算误差

10,只使用Numpy构建的1个简单全连接网络全代码

真纯Numpy手搓1个简单的神经网络

不借助pytorch、tensorflow等现代框架,

纯靠numpy,我们就能够手搓一个简单的神经网络;

逻辑很简单,我们将神经网络(此处指MLP)当做是一个算法问题,

从数学角度我们能够理解流程逻辑,从代码角度我们能够规划好数据输入输出流,

所以我们绝对能够纯手工搓1个简单的神经网络出来。

这里强调一下,手搓神经网络,并不是为了自找苦吃,而是为了让我们能够更加深入地理解神经网络的数学、代码逻辑,只有吃透了最简单、最原始的模块,我们之后遇到再复杂的网络、再复杂的结构,

都不会再吓到。

因为我们已经能够手搓1个最简单的系统(还原论的本质),再复杂也只是模块封装的表象。

下面就是一个多分类的神经网络model,去掉注释,其实核心也就500行以内。

具体衍生,我会在下一篇博客中展开。

python

import numpy as np

# =============================================================================

# 第一部分:底层核心类库

# =============================================================================

# 1. 全连接层

class Layer_Dense:

def __init__(self, n_inputs, n_neurons):

"""

Description

-----------

初始化全连接层的权重和偏置, 注意这是一个抽象的全连接层类, 不是输入层!

Args

----

n_inputs : int

当前层输入特征的数量(例, 输入28x28图像, 则n_inputs=784, 就是feature维度)

n_neurons : int

当前层输入神经元的数量

Notes

-----

- 1, 解释: 输入层数据格式是「样本 x 特征(n_samples, n_features), 隐藏层核心是「神经元数量(n_neurons), 权重矩阵用「特征 x 神经元(n_features, n_neurons)」的维度设计,正是为了通过矩阵乘法让两者高效衔接;

输入数据形状是 (n_samples, n_features)(比如 100 个样本, 每个样本 784 个特征 → (100, 784)),权重矩阵是 (n_features, n_neurons)(784 个特征 x 10 个神经元 → (784, 10));

(n_samples, n_features) @ (n_features, n_neurons) = (n_samples, n_neurons)

- 2, 当前全连接层单层的构建未涉及激活函数, 只是单纯的线性变换(矩阵乘法+偏置), 激活函数会在后续单独实现, 所以所有的output都是线性变换的结果, 我们直接考虑loss计算和反向传播即可, 不需要考虑激活函数的非线性影响, 就是将output作为当前层的最终输出(类比激活函数之后的输出)

"""

# 初始化(n_inputs, n_neurons)形状的权重矩阵, 采用随机的标准正态分布

# 缩放0.01以防止权重过大, 避免前向传播时输出过大导致梯度消失/爆炸

self.weights = 0.01 * np.random.randn(n_inputs, n_neurons)

# 初始为(1, n_neurons)形状的全0偏置向量, 每个神经元对应一个偏置值

# 每个神经元只有 1 个偏置(管 "神经元的偏移");所有样本共享这组偏置(管 "规则通用")

# 偏置的本质是 "与样本无关的神经元偏移",所有样本共享同一组偏置(1 个神经元 1 个偏置)

# 偏置的第 2 维(神经元数)必须和「输入 × 权重」结果的第 2 维(神经元数)完全一致(比如都是 10)------ 因为要给每个神经元加专属偏移,维度不匹配就加错了;

# 偏置的第 1 维(样本数)用 1,是因为广播机制会自动把 1 扩展成实际样本数(比如 100)------ 既满足 "所有样本共享偏置",又避免存储冗余(不用存 100 份重复的偏置)。

# 所以这里偏置形状是 (1, n_neurons), 而不是反过来(n_neurons, 1)

self.biases = np.zeros((1, n_neurons))

def forward(self, inputs):

"""

Description

-----------

前向传播, 计算当前层的输出(输入的线性变换)

Args

----

inputs : np.ndarray

输入数据, 上一层的输出, 形状为(上一层输出样本数, 上一层输出特征数), 也就是(n_samples, n_inputs/features)

Notes

-----

- 1, forward方法依然是在前面整体抽象的全连接层中定义的,不特指输入层到第一层隐藏层, 而是可以作为任意两层之间的全连接层;

只能说是当前层, 无论是哪一层, 全连接层的输出形状都是 (n_samples, 上一层神经元数);

不管是输入层后的第一层,还是隐藏层之间,只要传入符合维度的 inputs(上一层输出/上一层神经元数/当前层输入feature数), 并提前定义好对应维度的 weights(n_in_features x 当前层神经元数)和 biases(1 x 当前层神经元数),就能自动完成前向传播计算。

- 2, 理解抽象全连接层中inputs的维度:

- 通用维度: inputs.shape = (样本数, 当前层输入特征数),与层位置无关;

- 样本数不变:所有层的 inputs 第一维度都是同一批样本数,贯穿网络;------》从矩阵乘法角度来看, 任意中间层的行数=第1个矩阵的行数

- 输入特征数来源:当前层的 "输入特征数" = 上一层的输出特征数 = 上一层的神经元数量;

- 抽象复用性:正因为维度规则通用,这个 forward 方法才能作为任意全连接层使用,只需匹配上一层输出和自身权重维度即可

- 3, 此处的全连接层不包括激活函数, 只是单纯的线性变换(矩阵乘法+偏置), 激活函数会在后续单独实现, 所以所有的output都是线性变换的结果, 我们直接考虑loss计算和反向传播即可, 不需要考虑激活函数的非线性影响, 就是将output作为当前层的最终输出(类比激活函数之后的输出)

"""

# 保存当前层的输入, 用于后续反向传播计算梯度

self.inputs = inputs

# 计算当前层的输出: output = inputs @ weights + biases (矩阵乘法+广播机制)

# 输入数据 X:100 个样本,每个样本 784 个特征 → 形状 (100, 784);

# 权重 weights:784 个特征 × 10 个神经元 → 形状 (784, 10);------》X @ weights → 形状 (100, 784) @ (784, 10) = (100, 10)

# 偏置 biases:1 行 × 10 个神经元 → 形状 (1, 10)(全 0 初始化,即 [[0,0,0,...,0]])。------》NumPy 的广播机制会自动把 (1,10) 的偏置 "复制扩展" 成 (100,10)

# 刚好实现了 "给每个神经元的所有样本输出,都加同一个偏移量"------ 这正是 "与样本无关、每个神经元 1 个偏置"

self.output = np.dot(inputs, self.weights) + self.biases

def backward(self, dvalues):

"""

Description

-----------

反向传播, 计算当前层的梯度 (更新梯度值用于优化器更新参数)

Args

----

dvalues : np.ndarray

下一层传递过来的梯度, 损失对当前层输出的偏导, 作为当前层需要计算梯度的起点;

dvalues(当前层梯度起点) = ∂L(整体loss)/∂out(当前层输出, 也就是下一层输入)

Notes

-----

- 1, 我们这里的表述是下一层(靠近output)传到上一层(靠近input), 从loss传到输入的反向顺序说法, 所谓的上下是按照正常正向数据传递的说法表述

- 2, 对于矩阵微积分求导部分的数学符号以及规则说明, 可以参考: https://blog.csdn.net/weixin_62528784/article/details/156519242?spm=1001.2014.3001.5501

"""

# 计算权重的梯度:损失对权重的偏导 = 输入的转置 @ 下一层梯度

# 原理: 依据链式法则, ∂L/∂W = ∂L/∂out * ∂out/∂W

# 其中 ∂out/∂W = inputs.T, 因为 out = inputs @ weights + biases------》这一点可以从矩阵求导的分母布局法理解(输入的转置的形状正好和权重形状匹配)

# 而 ∂L/∂out 就是 dvalues, 因为 dvalues = ∂L/∂out, dvalues就是定义为loss对这一层输出的梯度, 所以dvalues是我们计算的起点

self.dweights = np.dot(self.inputs.T, dvalues)

# 计算偏置的梯度:损失对偏置的偏导 = 下一层梯度的求和(下一层沿样本轴求和)

# 原理: 依据链式法则, ∂L/∂b = ∂L/∂out * ∂out/∂b

# 其中 ∂out/∂b = 1 (因为偏置是加法项, 对每个样本都一样), 因为 out = inputs @ weights + biases

# 所以 ∂L/∂b = sum(∂L/∂out) = sum(dvalues)

# keepdims=True保持维度为(1, n_neurons),与偏置形状一致

self.dbiases = np.sum(dvalues, axis=0, keepdims=True)

# 计算输入的梯度:损失对输入的偏导 = 下一层梯度 @ 权重的转置

# 原理: 依据链式法则, ∂L/∂inputs = ∂L/∂out * ∂out/∂inputs

# 其中 ∂out/∂inputs = weights.T, 因为 out = inputs @ weights + biases ------》和前面一样可以从矩阵求导的分母布局法理解(权重的转置的形状正好和输入形状匹配)

# 而 ∂L/∂out 就是 dvalues, 因为 dvalues = ∂L/∂out

# 所以 ∂L/∂inputs = dvalues @ weights.T

# 原理: 将梯度反向传给上一层, 用于前一层的参数更新

self.dinputs = np.dot(dvalues, self.weights.T)

# 2. ReLU 激活函数

class Activation_ReLU:

"""

Description

-----------

ReLU(Rectified Linear Unit) 激活函数

用于引入非线性, 解决线性模型无法拟合复杂数据的问题

Notes

-----

- 1, 此处单独实现ReLU激活函数类, 作为独立的激活层使用, 不考虑与全连接层耦合

"""

def forward(self, inputs):

"""

Description

-----------

前向传播, 计算ReLU激活函数的输出(out_relu)

Args

----

inputs : np.ndarray

in_relu, 输入数据, 上一层的输出, 全连接层的线性输出, 形状与全连接层输出一致, 也就是不考虑与激活函数耦合时的全连接层输出;

Notes

-----

- 1, 理论上全连接层输出inputs+本层激活函数之后的输出才是当前层的最终输出, 但由于此处不考虑耦合, 此处只是独立的1个激活层, 所以直接将ReLU的输出作为当前层的最终输出

"""

# 保存当前层的输入(in_relu), 用于后续反向传播判断梯度是否为0

self.inputs = inputs

# 计算ReLU激活函数的输出(out_relu): output = max(0, inputs), ReLU函数将负值置0, 保持正值不变

self.output = np.maximum(0, inputs)

def backward(self, dvalues):

"""

Description

-----------

反向传播, 计算ReLU激活函数的梯度, 用于更新前一层的梯度(ReLU层链式法则传递),

计算公式: ∂L/∂in_relu = ∂L/∂out_relu * ∂out_relu/∂in_relu

Args

----

dvalues : np.ndarray

out_relu, 下一层传递过来的梯度, 损失对当前层输出的偏导, 也就是损失对ReLU层输出的偏导, 作为当前层需要计算梯度的起点;

dvalues(当前层梯度起点) = ∂L(整体loss)/∂out(当前层输出, 也就是下一层输入)

Notes

-----

- 1, ReLU层在反向传播时的核心任务:

- 接收下一层传递过来的梯度 dvalues = ∂L/∂out_relu (损失对ReLU层输出的偏导);

- 计算当前层的梯度 dinputs = ∂L/∂in_relu (损失对ReLU层输入的偏导), 传递给前一层用于更新梯度;

- 将调整后的梯度传递给上一层(通常是全连接层), 供上一层计算参数(权重/偏置)的梯度;

- 依据ReLU的梯度规则调整梯度值(输入<=0位置的梯度置0, 输入>0位置的梯度保持不变);

- 2, 激活函数层都是剥离开来, 单独实现的, 上一个全连接层的输出作为当前ReLU层的输入, 当前ReLU层的输出作为下一个全连接层的输入;

"""

# 复制下一层传递过来的梯度, 作为当前层的梯度初始值

# 若ReLU层后接全连接层, 则dvalues就是全连接层backward方法计算出的self.dinputs(全连接层的输入梯度, 对应ReLU层的输出梯度)

# 为什么复制? 因为我们需要修改梯度值, 不能直接修改传入的dvalues, 因为下一层的梯度结果dvalues可能还会被其他层使用

# 这样可以避免影响到其他层的梯度计算

# ReLU的梯度计算需要根据输入值是否大于0来决定(也就是需要基于自身输入调整)

self.dinputs = dvalues.copy()

# ReLU的梯度规则: 当输入值<=0时, 梯度为0; 当输入值>0时, 梯度保持不变, 为1

# 此处self.inputs就是ReLU层的输入值(in_relu), 要计算其梯度, ∂L/∂in_relu = ∂L/∂out_relu * ∂out_relu/∂in_relu

# - 当in_relu <= 0, 也就是 self.inputs <= 0, 则 ∂out_relu/∂in_relu = 0, 因为ReLU函数在该区间的梯度为0 ------> 整体梯度 ∂L/∂in_relu = ∂L/∂out_relu * 0 = 0, 即把self.dinputs对应位置置0

# - 当in_relu > 0, 也就是 self.inputs > 0, 则 ∂out_relu/∂in_relu = 1, 因为ReLU函数在该区间的梯度为1 ------> 整体梯度 ∂L/∂in_relu = ∂L/∂out_relu * 1 = ∂L/∂out_relu, 即self.dinputs保持不变

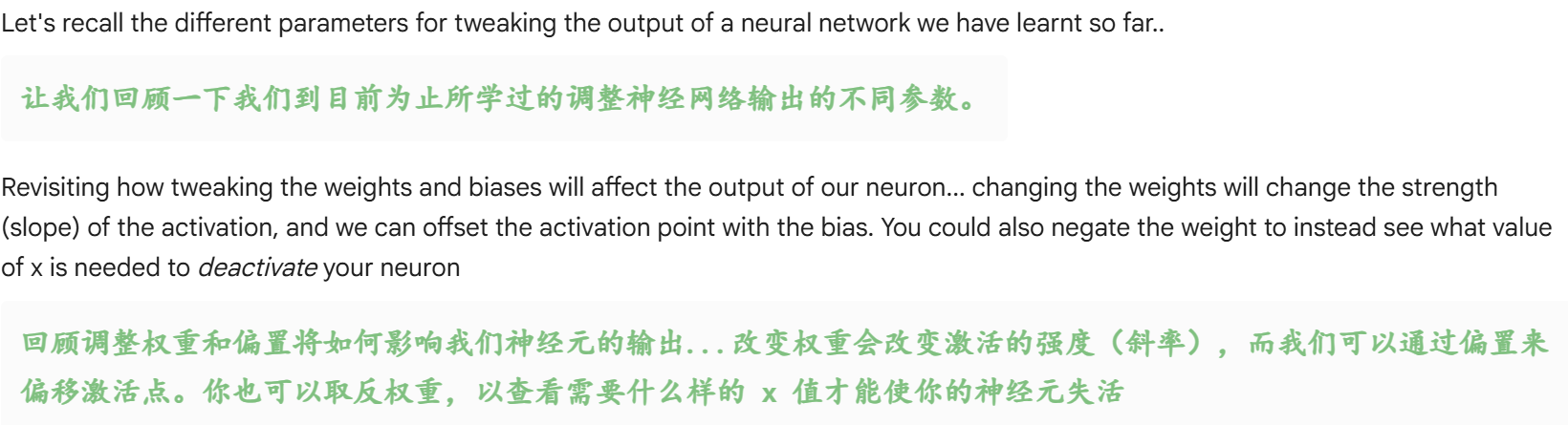

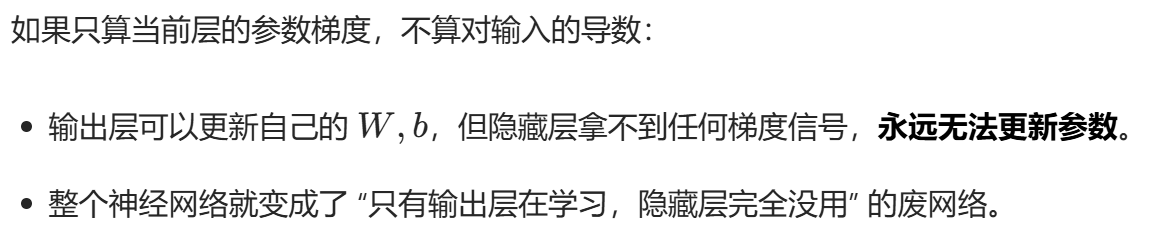

# 因此我们需要将输入值<=0的位置的梯度置0, 不传递该位置的梯度