效果一览

一、研究背景

- TCN(Temporal Convolutional Network) 是一种用于序列建模的卷积神经网络结构,结合了因果卷积、扩张卷积和残差连接,适用于时间序列分类、预测等任务。

- 本代码实现了TCN在分类任务中的应用,并引入了SHAP(SHapley Additive exPlanations)进行模型可解释性分析,适用于特征重要性评估与模型理解。

二、主要功能

- 数据预处理:包括数据导入、打乱、划分训练集与测试集、归一化。

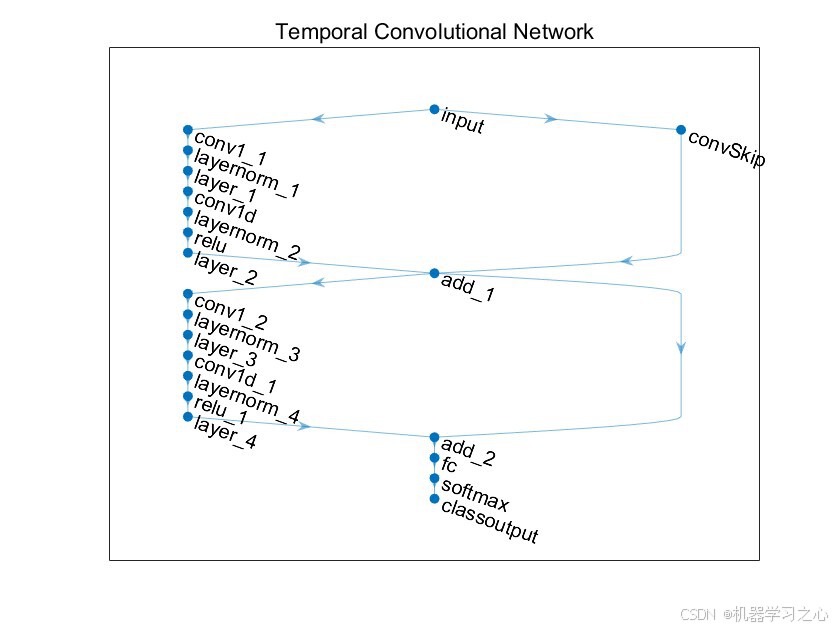

- TCN模型构建:构建具有残差块、层归一化、空间丢弃层的TCN网络。

- 模型训练与预测:使用Adam优化器进行训练,并在训练集和测试集上进行预测。

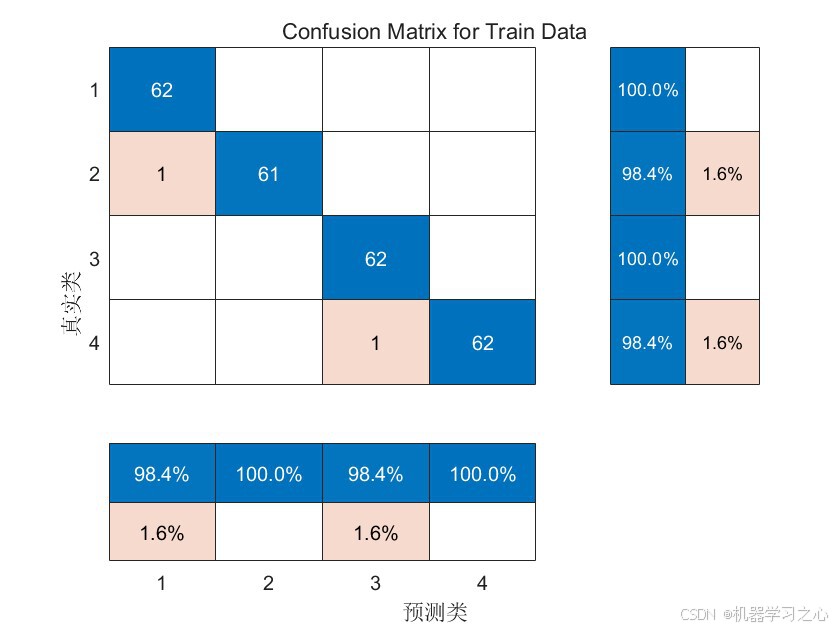

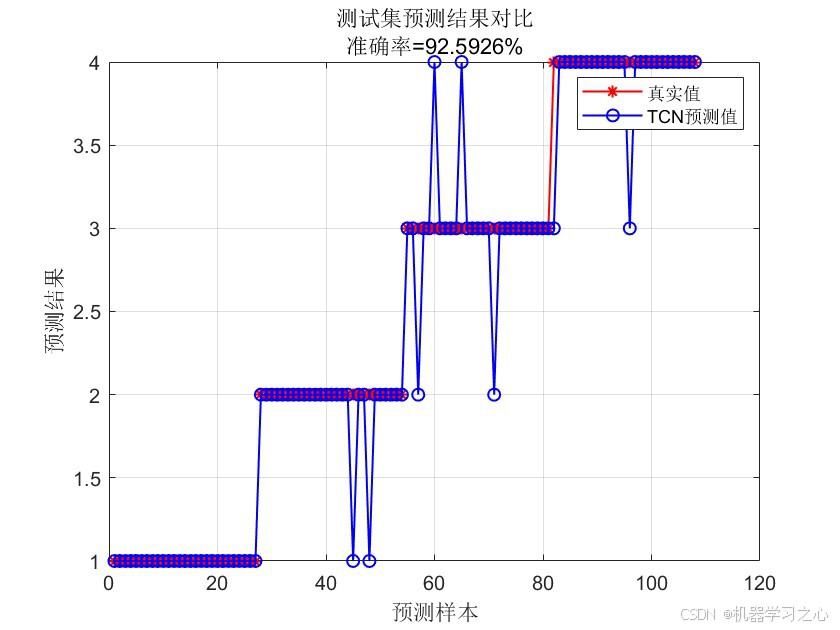

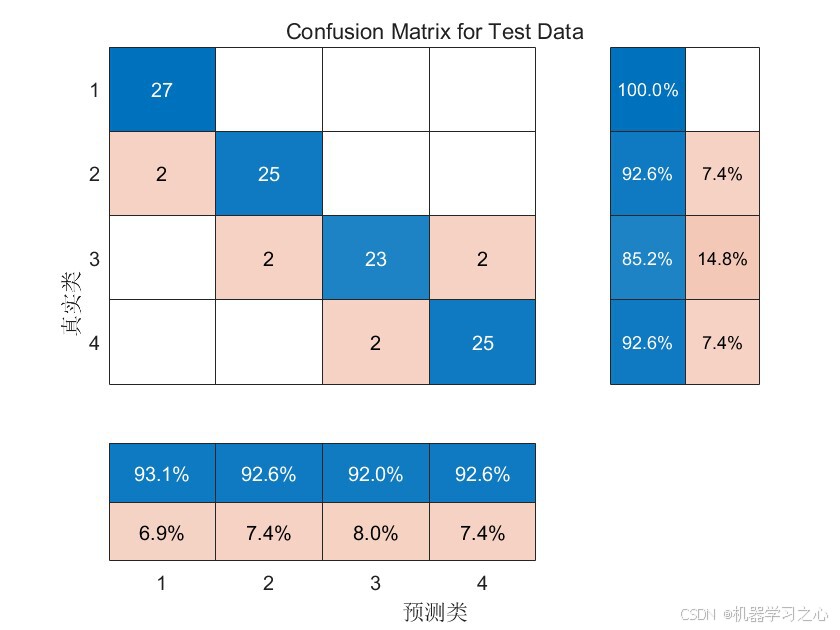

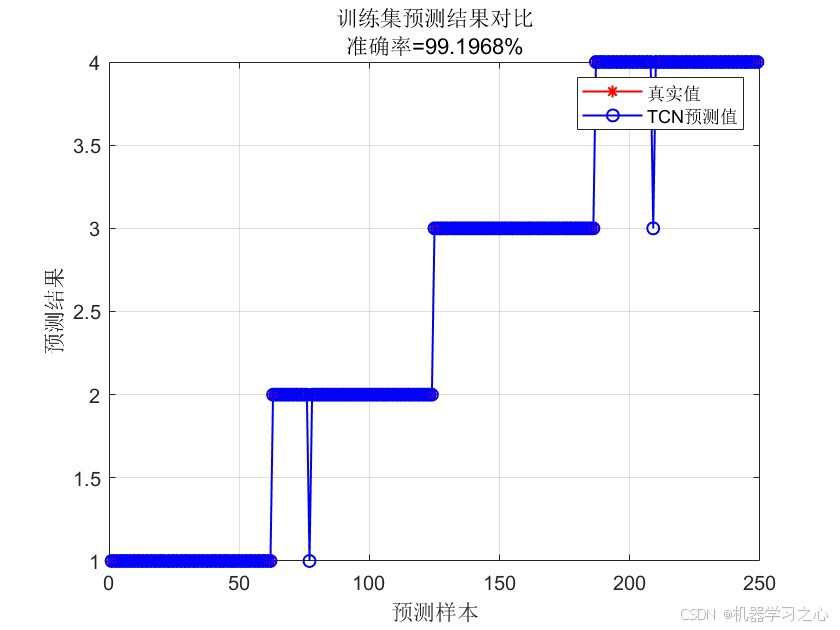

- 性能评估:计算分类准确率,绘制预测对比图与混淆矩阵。

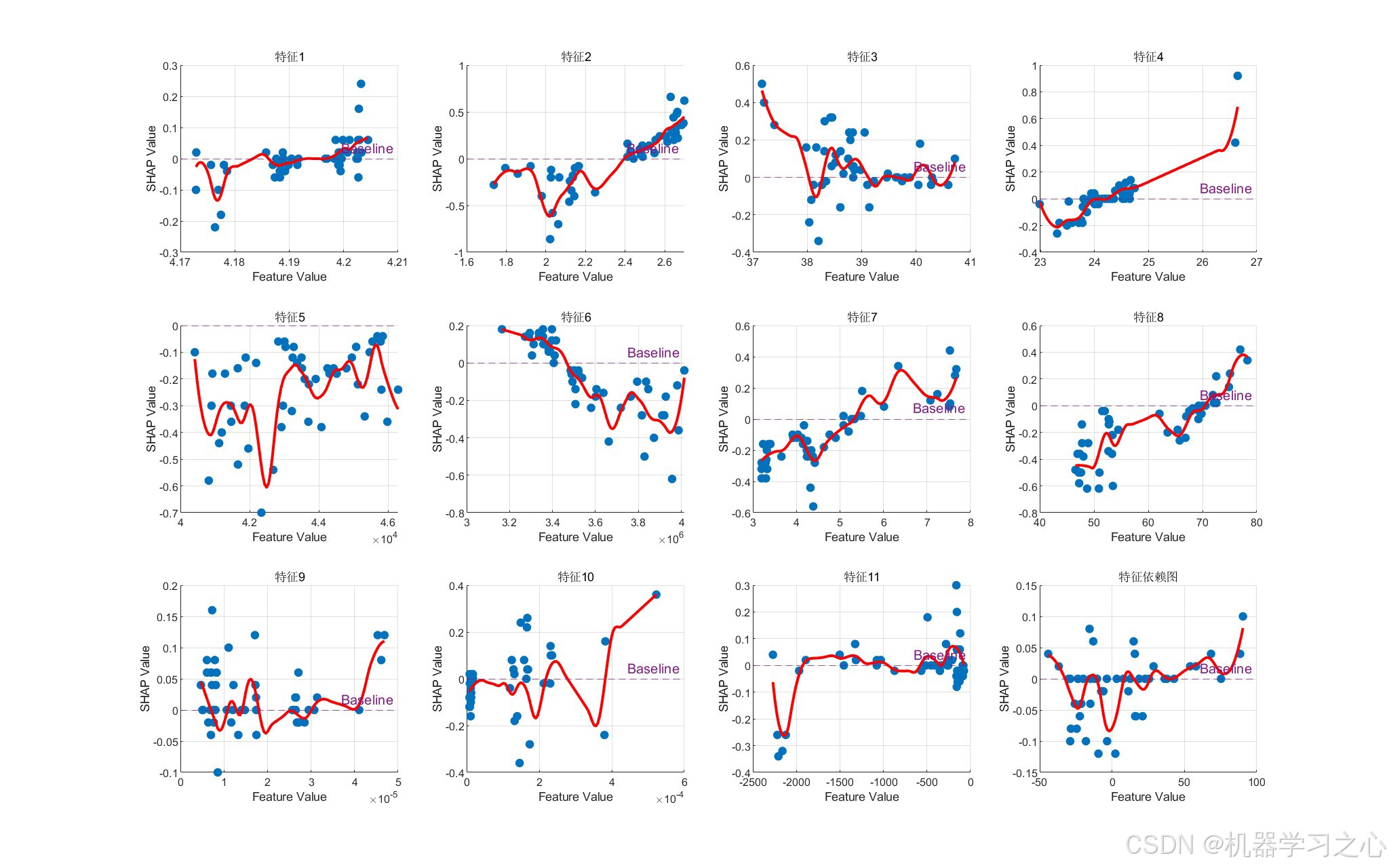

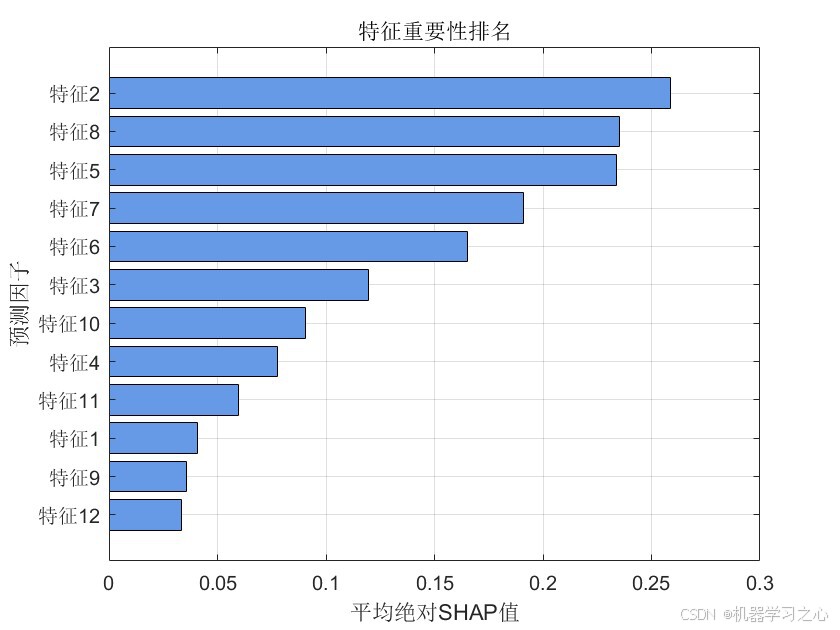

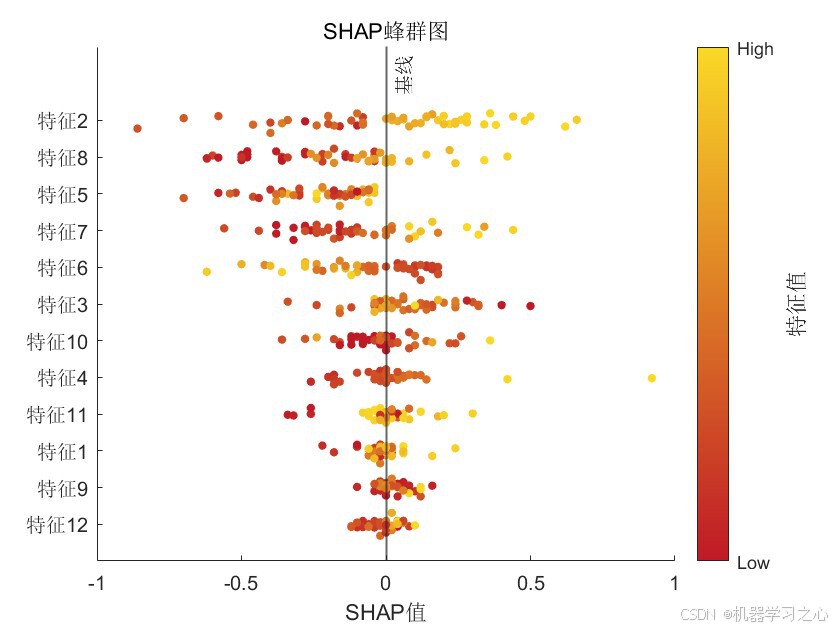

- SHAP分析:对模型进行可解释性分析,计算特征重要性并可视化。

三、算法步骤

- 导入数据集,统计类别数、特征维度、样本数。

- 按类别比例划分训练集和测试集。

- 数据归一化并转换为TCN所需的cell格式。

- 构建TCN网络结构(输入层、卷积层、残差块、全连接层等)。

- 设置训练参数并训练模型。

- 对训练集和测试集进行预测,评估准确率。

- 进行SHAP分析,计算特征重要性并绘制相关图表。

四、技术路线

- 开发平台:MATLAB(需支持深度学习工具箱)

- 网络结构:TCN(因果卷积 + 扩张卷积 + 残差连接 + 层归一化 + Dropout)

- 优化器:Adam(带学习率衰减)

- 可解释性方法:SHAP值计算(基于合作博弈理论)

- 可视化工具 :

- 训练过程图

- 预测结果对比图

- 混淆矩阵

- SHAP摘要图、条形图、依赖图

五、公式原理(简要)

1. TCN核心公式(扩张因果卷积):

yt=∑k=0K−1wk⋅xt−d⋅k y_t = \sum_{k=0}^{K-1} w_k \cdot x_{t - d \cdot k} yt=k=0∑K−1wk⋅xt−d⋅k

其中 (d) 是扩张因子,(K) 是卷积核大小。

2. 残差连接:

输出=激活(F(x)+x) \text{输出} = \text{激活}(F(x) + x) 输出=激活(F(x)+x)

3. SHAP值(基于Shapley值):

ϕi=∑S⊆N∖{i}∣S∣!(∣N∣−∣S∣−1)!∣N∣![f(S∪{i})−f(S)] \phi_i = \sum_{S \subseteq N \setminus \{i\}} \frac{|S|!(|N|-|S|-1)!}{|N|!} [f(S \cup \{i\}) - f(S)] ϕi=S⊆N∖{i}∑∣N∣!∣S∣!(∣N∣−∣S∣−1)![f(S∪{i})−f(S)]

其中 (N) 是所有特征集合,(S) 是特征子集。

六、参数设定

| 参数 | 说明 | 默认值 |

|---|---|---|

num_class |

类别数 | 自动计算 |

num_size |

训练集比例 | 0.7 |

numFilters |

卷积核数量 | 16 |

filterSize |

卷积核大小 | 3 |

dropoutFactor |

空间丢弃率 | 0.05 |

numBlocks |

残差块数 | 2 |

MaxEpochs |

最大训练轮数 | 120 |

miniBatchSize |

批大小 | 30 |

InitialLearnRate |

初始学习率 | 0.005 |

LearnRateDropFactor |

学习率衰减因子 | 0.8 |

LearnRateDropPeriod |

学习率衰减周期 | 50 |

七、运行环境

- 软件环境:MATLAB R2020b 及以上(支持深度学习工具箱、混淆矩阵、分类层

八、应用场景

该代码适用于以下任务:

- 数据分类(如EEG/ECG信号分类)

- 特征重要性分析(通过SHAP值理解模型决策依据)

- 模型可解释性研究(适用于需要对深度学习模型进行解释的场景)