近年来,随着大语言模型(LLM)、多模态模型和生成式 AI 技术的快速演进,AI 工程体系正经历从"单点模型"向"端到端智能系统"的深刻转型。这一转型不仅带来了算法层面的突破,更对底层软件基础设施提出了前所未有的挑战:如何在保障高吞吐、低延迟的同时,支持快速迭代、弹性伸缩与多租户共享?如何让算法工程师专注于模型创新,而无需深陷资源调度与运维泥潭?

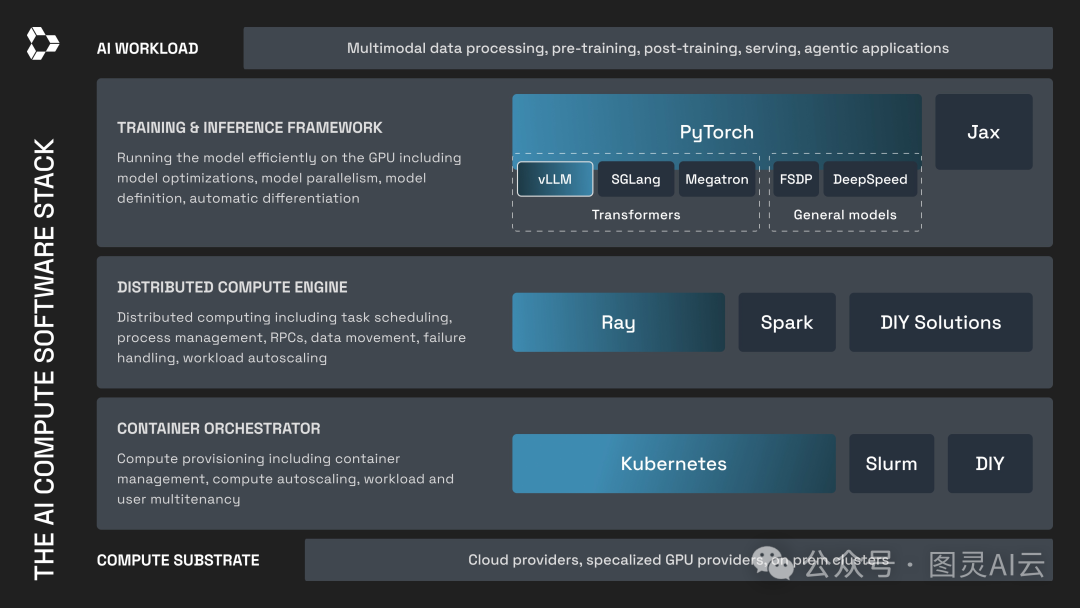

在大量生产实践与开源社区演进中,一个清晰、分层、职责分明的开放技术栈逐渐浮现:Kubernetes(容器编排) + Ray(分布式计算引擎) + PyTorch(训练框架) + vLLM(推理引擎)。这一组合并非偶然堆砌,而是对"模型效率---任务编排---资源治理"三层核心问题的系统性回应。本文将从工程视角出发,逐层剖析其设计思想、技术内涵与落地路径。

Kubernetes + Ray + PyTorch + vLLM: AI主流架构

(图片来源:https://www.anyscale.com/blog/ai-compute-open-source-stack-kubernetes-ray-pytorch-vllm)

)

如上图,将该栈划分为三个层次,每一层解决一类核心问题:

| 层级 | 职责 | 代表技术 | 用户角色 |

|---|---|---|---|

| 训练与推理框架层 | 高效运行模型(GPU 利用、并行策略、自动微分) | PyTorch, vLLM | ML 工程师、算法研究员 |

| 分布式计算引擎层 | 任务调度、数据流转、弹性扩缩、故障恢复 | Ray | 平台工程师、ML 工程师 |

| 容器编排层 | 节点分配、多租户隔离、容器生命周期管理 | Kubernetes | 平台/运维工程师 |

这种分层设计,本质上是对 "计算效率"、"任务编排"与"资源治理" 三大维度的解耦。即:"Kubernetes 面向平台工程师,而 Ray/PyTorch/vLLM 面向 ML 开发者"------两者协同,方能兼顾开发敏捷性与运维稳定性。

为何需要这一软件栈?------生成式 AI 带来的四大挑战

传统机器学习时代,模型规模小、训练周期短、服务模式简单,单机或简单集群即可满足需求。但生成式 AI 的兴起彻底改变了这一格局,带来四大关键挑战:

1. 工作负载复杂化

生成式 AI 不再局限于"训练 → 部署"两阶段,而是演化为多阶段、异构、交互式流水线。典型场景如:

-

• 多模态内容理解:视频解码(CPU)→ 图像/语音特征提取(GPU)→ LLM 语义推理(GPU);

-

• 后训练(Post-training):利用 LLM 生成数据 → 奖励模型打分 → 强化学习更新策略 → 再次生成,形成闭环;

-

• RAG(检索增强生成):向量检索(CPU/GPU)→ 上下文拼接 → LLM 推理。

这些任务混合 CPU/GPU、I/O 密集与计算密集型操作,传统批处理框架难以高效调度。

2. 资源规模指数级增长

百亿参数模型动辄需数十甚至上百张 A100/H100 GPU,显存需求达 TB 级。同时,推理请求具有突发性与长尾分布,要求系统既能支撑峰值 QPS,又能在低谷期自动缩容以控制成本。

3. 迭代速度成为核心竞争力

头部团队已将"单个开发者每月实验次数"作为关键指标。若每次模型变更都需数天部署、调参、压测,创新将被严重拖慢。因此,基础设施必须支持"小时级"甚至"分钟级"实验闭环。

4. 未来兼容性压力

新硬件(如 H100、B200)、新模型结构(如 MoE、Mamba)、新训练范式(如在线微调)层出不穷。系统若与特定框架或硬件强耦合,将面临频繁重构风险。

面对这些挑战,单一技术已无法胜任。必须构建一个分层解耦、开放可插拔的软件栈。

三层架构:职责分离与协同机制

该栈(Kubernetes + Ray + PyTorch + vLLM)可清晰划分为三个逻辑层,每层聚焦一类问题,彼此通过标准接口协同:

▶ 第一层:训练与推理框架层 ------ "让模型跑得更快"

核心目标:最大化 GPU 利用率,实现高效前向/反向传播。

-

• PyTorch 作为当前主流深度学习框架,提供灵活的动态图机制、自动微分、分布式训练(如 FSDP、DDP)支持,是模型研发的"通用语言"。其与 Hugging Face Transformers、DeepSpeed 等生态深度集成,可支撑从 7B 到 70B+ 参数模型的训练。

-

• vLLM 则专为 Transformer 推理优化,其核心创新 PagedAttention 借鉴操作系统虚拟内存分页思想:

-

• 将注意力机制中的 Key/Value 缓存划分为固定大小"页";

-

• 支持非连续显存分配,显著减少碎片;

-

• 实现 连续批处理(Continuous Batching):动态合并不同长度请求,避免 GPU 空转。

-

实测表明(可参见文末参考文献),在 Llama-2-7B 上,vLLM 相比 Hugging Face Transformers 可提升吞吐 8--12 倍,显存利用率提高 2--4 倍。

此外,SGLang、TensorRT-LLM 等也属于此类专用推理引擎,但 vLLM 因其开源性、Python 接口友好性及对 Hugging Face 模型的无缝支持,成为社区首选。

▶ 第二层:分布式计算引擎层 ------ "让任务跑得更顺"

核心目标:在单个作业(Job)内部,调度任务、流转数据、处理故障、弹性扩缩。

-

• Ray 是一个 Python 原生、GPU 感知的分布式计算框架。其核心抽象包括:

-

• Task:无状态函数,适合数据预处理、批推理;

-

• Actor:有状态对象,适合托管 vLLM 实例、维护模型状态;

-

• Ray Serve:专为模型服务设计的高层 API,支持 A/B 测试、多模型路由;

-

• Ray Train:统一训练接口,集成 PyTorch、XGBoost 等后端。

-

在复杂流水线中,Ray 能:

-

• 自动将 CPU 任务调度到 CPU 节点,GPU 任务调度到 GPU 节点;

-

• 在 vLLM 实例崩溃时自动重建 Actor;

-

• 根据请求队列长度动态增减推理实例数量;

-

• 在后训练场景中,协调训练器与 rollout 生成器之间的权重同步与数据回传。

值得注意的是,Ray 并不替代 Kubernetes,而是运行在其之上,专注于"作业内部"的细粒度调度。

▶ 第三层:容器编排层 ------ "让资源用得更稳"

核心目标:在集群层面,分配节点、隔离租户、管理容器生命周期。

-

• Kubernetes 作为云原生事实标准,提供:

-

• Pod 调度:通过 nodeSelector、affinity 等机制将 vLLM Pod 绑定到 GPU 节点;

-

• 资源隔离:通过 Namespace + ResourceQuota 实现多团队共享集群;

-

• 服务暴露:通过 Service + Ingress 对外提供 REST/gRPC 接口;

-

• 自动扩缩:HPA(基于 CPU/GPU 指标)或 KEDA(基于 QPS、队列长度)驱动 Pod 扩缩;

-

• 故障恢复:Pod 崩溃后自动重建,节点失联后迁移工作负载。

-

虽然 SLURM 在科研训练中仍有优势,但 Kubernetes 因其对在线服务、微服务架构的天然支持,正成为企业统一 AI 基础设施的首选。

关键分工:K8s 负责"作业间"调度(Job-level),Ray 负责"作业内"调度(Task-level)。

典型使用场景与代码示例

场景:多模态内容审核系统

-

- 输入:用户上传视频;

-

- 处理流水线:

-

• Stage 1(CPU):视频解码为帧序列;

-

• Stage 2(GPU):使用 CLIP 模型提取图像/文本嵌入;

-

• Stage 3(GPU):将嵌入送入 Llama 模型,判断是否含违规内容;

-

- 输出:审核结果 + 置信度。

代码实现(Ray 编排)

import ray

from vllm import LLM, SamplingParams

import cv2

import torch

# Stage 1: 视频解码(CPU)

@ray.remote(num_cpus=1)

defdecode_video(video_path):

cap = cv2.VideoCapture(video_path)

frames = []

while cap.isOpened():

ret, frame = cap.read()

ifnot ret: break

frames.append(frame)

cap.release()

return frames

# Stage 2: CLIP 特征提取(GPU)

@ray.remote(num_gpus=0.5)

defextract_features(frames):

# 假设已加载 CLIP 模型

model = torch.load("clip_model.pth")

features = model.encode(frames)

return features

# Stage 3: LLM 推理(GPU)

@ray.remote(num_gpus=1)

classLLMActor:

def__init__(self, model_path):

self.llm = LLM(model=model_path)

self.sampling_params = SamplingParams(temperature=0.0, max_tokens=64)

defpredict(self, prompts):

outputs = self.llm.generate(prompts, self.sampling_params)

return [o.outputs[0].text for o in outputs]

# 主流程

ray.init(address="ray://k8s-ray-head:10001") # 连接 K8s 中的 Ray 集群

frames_ref = decode_video.remote("video.mp4")

features_ref = extract_features.remote(frames_ref)

llm_actor = LLMActor.remote("meta-llama/Llama-2-7b-hf")

result = llm_actor.predict.remote([f"Is this content safe? {feat}"for feat in features_ref])

print(ray.get(result))Kubernetes 部署 Ray 集群(简化)

# ray-cluster.yaml

apiVersion:apps/v1

kind:StatefulSet

meta

name:ray-head

spec:

template:

spec:

containers:

-name:ray-head

image:rayproject/ray:latest

command: ["ray", "start", "--head", "--port=6379", "--dashboard-host=0.0.0.0"]

resources:

limits:

nvidia.com/gpu:0# Head 节点通常无 GPU

---

apiVersion:apps/v1

kind:Deployment

meta

name:ray-worker

spec:

template:

spec:

containers:

-name:ray-worker

image:your-custom-image-with-vllm# 包含 vLLM/PyTorch

command: ["ray", "start", "--address=ray-head:6379"]

resources:

limits:

nvidia.com/gpu: 1通过此架构,整个流水线可在 K8s 集群上弹性运行,Ray 自动调度各阶段任务到合适节点。

企业落地的关键实践与经验

在真实生产环境中,成功落地该栈需关注以下维度:

1. 资源隔离与配额管理

-

• 为不同业务线创建独立 Namespace;

-

• 设置 GPU 配额(如

limits.nvidia.com/gpu: 10); -

• 使用 K8s PriorityClass 保障核心服务资源。

2. 监控与可观测性

-

• 采集 vLLM 指标:

num_requests_running,gpu_cache_usage,tokens_per_second; -

• 监控 Ray:

num_actors,task_queue_length,node_cpu_utilization; -

• 集成 Prometheus + Grafana + Loki,构建统一视图。

3. 冷启动与预热优化

-

• vLLM 加载 70B 模型可能耗时 5--10 分钟;

-

• 解决方案:使用 Init Container 预加载模型,或部署常驻服务 + HPA 缩容至 1 副本(非 0)。

4. 安全与合规

-

• 在 Ingress 层增加 JWT 认证;

-

• 对输入做长度/内容过滤,防止 prompt injection;

-

• 输出结果经脱敏网关后再返回。

5. 成本控制策略

-

• 结合 Spot 实例 + K8s Cluster Autoscaler 降低 GPU 成本;

-

• 利用 vLLM 的高吞吐特性,减少所需 GPU 数量;

-

• 夜间自动缩容至最小副本,白天按需扩容。

实践中,许多团队(可参见文末参考文献中的Pinterest、Uber、Roblox 等企业的实践案例)通过该栈实现了 GPU 利用率从 30% 提升至 85%+ ,推理成本下降 50%--70%,同时将新模型上线周期从"周级"压缩至"小时级"。

总结与展望

Kubernetes + Ray + PyTorch + vLLM 的组合,代表了当前生成式 AI 基础设施的成熟范式。它通过分层解耦的设计哲学,既满足了算法团队对灵活性与性能的需求,又兼顾了平台团队对稳定性与可运维性的要求。

未来,该栈将持续演进:

-

• 训练-推理一体化:Ray Train 与 Ray Serve 深度联动,支持在线微调与实时推理;

-

• 更智能的调度:基于请求特征(如 prompt 长度、模型大小)动态分配资源;

-

• 硬件抽象增强:无缝切换 A100/H100/B200,甚至支持 NPU、TPU;

-

• 绿色 AI:通过精细化调度与模型压缩,降低碳足迹。

技术没有终点,但方向日益清晰。构建一个开放、分层、面向未来的 AI 软件栈,不仅是工程选择,更是组织能力的体现。在大模型走向"基础设施化"的今天,谁掌握了高效、敏捷、可靠的工程体系,谁就握住了智能时代的主动权。

参考文献: