一、引言

1.1 研究背景与核心问题

自动驾驶(AD)需在动态复杂环境中完成感知、决策与动作执行的闭环流程。传统端到端框架虽整合了感知、预测与规划模块,但缺乏常识推理和因果推断能力,难以应对真实交通场景的不确定性。随着视觉语言模型(VLM)在理解与推理能力上的突破,视觉 - 语言 - 动作(VLA)范式逐渐成为端到端自动驾驶的研究热点,其核心目标是将复杂交通场景理解转化为自车的行驶轨迹。

当前 VLA 模型主要依赖模仿学习(IL)进行训练,通过拟合专家驾驶数据学习行为模式。但该范式存在两大固有缺陷:

- 分布偏移(Distribution Shift):训练数据与真实驾驶场景的分布差异导致模型泛化能力不足;

- 因果混淆(Causal Confusion):仅学习输入输出的关联关系,无法理解行为背后的因果逻辑,在闭环驾驶中易出现不可逆的错误累积。

强化学习(RL)通过试错学习机制为解决上述问题提供了新思路,已在增强 VLM 的因果推理能力方面取得显著成效。但将强化学习应用于自动驾驶 VLA 模型面临关键挑战:自动驾驶的动作空间是连续轨迹空间,直接在该空间进行强化学习会导致探索效率极低,难以实现有效训练。

原文链接:MindDrive: A Vision-Language-Action Model for Autonomous Driving via Online Reinforcement Learning

代码链接:MindDrive: A Vision-Language-Action Model for Autonomous Driving via Online Reinforcement Learning

沐小含持续分享前沿算法论文,欢迎关注...

1.2 现有方案的局限性

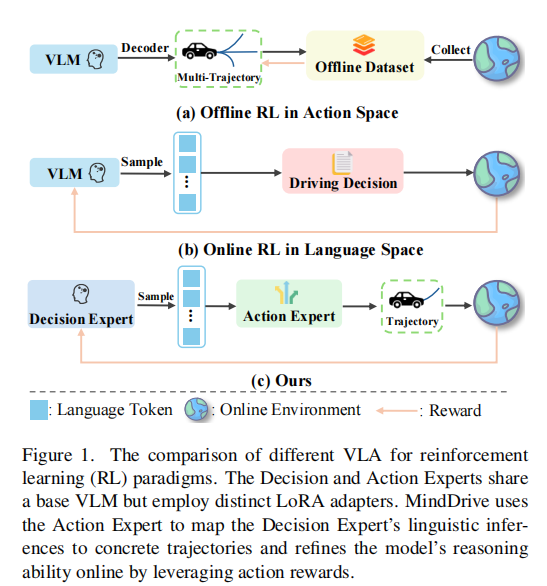

现有自动驾驶 VLA 模型的强化学习应用主要分为两类范式,均存在明显不足:

- 动作空间离线强化学习(图 1 (a)):基于固定的专家演示数据集训练,虽能通过设计奖励函数生成可行轨迹,但缺乏与环境的交互探索能力,且无法优化 VLM 的高层推理能力;

- 语言空间在线强化学习(图 1 (b)):将驾驶决策视为动作,通过在线交互增强因果推理,但难以将抽象的语言决策有效映射为具体、符合人类驾驶习惯的连续轨迹。

1.3 研究目标与核心贡献

本文提出MindDrive框架,首次将在线强化学习应用于自动驾驶 VLA 模型,通过语言 - 动作动态映射机制,在离散语言决策空间中实现高效探索,同时利用轨迹级奖励优化高层推理。其核心贡献包括:

- 提出新型 VLA 架构,通过双专家设计(决策专家 + 动作专家)将连续动作空间转化为离散语言决策空间,提升探索效率并实现轨迹奖励对推理的优化;

- 构建了计算高效的在线强化学习方案,基于 CARLA 模拟器实现自动驾驶 VLA 模型的在线闭环训练,为领域提供新的技术思路;

- 在 Bench2Drive 基准测试中取得优异性能,使用轻量型 0.5B LLM 实现 78.04 的驾驶分数(DS)和 55.09% 的成功率(SR),显著优于同规模的最先进 IL 基线模型。

二、相关工作

2.1 端到端自动驾驶

传统端到端自动驾驶模型基于模仿学习,将传感器输入直接映射为轨迹或控制指令:

- 代表性模型如 UniAD、VAD 采用鸟瞰图(BEV)表示统一多任务;

- GenAD、DiffusionDrive 等生成式方法利用扩散模型实现多模态轨迹生成;

- SparseAD、DriveTransformer 通过稀疏查询提升模型效率。

但此类模型在闭环场景中易因分布偏移和因果混淆失效。近年来,研究者开始将 VLM 融入自动驾驶,如 HERMES 整合 3D 场景理解与未来生成,DriveGPT4、ORION 等通过语言引导提升推理与泛化能力,但仍受限于模仿学习,无法将轨迹级监督有效传递到 VLM 的高层推理空间。

2.2 自动驾驶中的强化学习

强化学习在自动驾驶中的应用逐渐增多:

- CarPlanner 利用专家引导奖励实现稳定学习;

- RAD、R2SE 增强闭环训练并避免遗忘;

- AlphaDrive、AutoVLA 采用 GRPO-based RL 优化规划。

但多数方法依赖离线专家数据集和手工设计奖励,缺乏真实环境交互;在线强化学习虽能实现自适应决策,但存在收敛慢、探索效率低的问题。MindDrive 通过自适应在线强化学习方案,有效提升了闭环鲁棒性和决策质量。

三、方法细节

3.1 整体架构设计

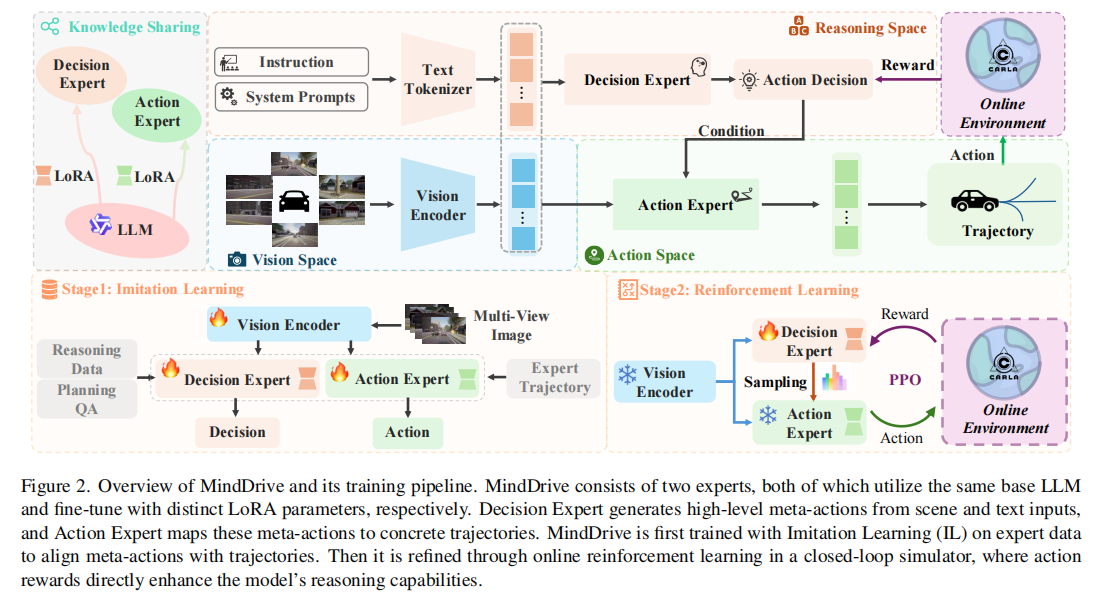

MindDrive 的核心思想是通过语言 - 动作映射将强化学习的探索空间从连续轨迹空间转化为离散语言决策空间,其架构包含两大核心组件(图 2):决策专家(Decision Expert) 和动作专家(Action Expert)。两者共享视觉编码器(Vision Encoder)和文本分词器(Text Tokenizer),但通过不同的 LoRA(Low-Rank Adaptation)适配器实现功能分化,确保在共享世界知识基础上完成各自专属任务。

注:决策专家和动作专家共享基础 LLM,通过不同 LoRA 参数微调。训练分为两阶段:首先通过模仿学习建立语言 - 动作映射,再通过在线强化学习优化决策能力。

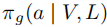

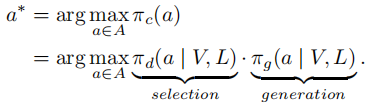

3.2 问题建模

在端到端自动驾驶任务中,目标是基于周围视觉信息 和语言指令

,生成多模态轨迹集

并选择最优轨迹

。传统方法通过生成策略

生成轨迹,再通过评分策略

生成轨迹,再通过评分策略  选择最优轨迹。MindDrive 将该过程建模为决策 - 生成联合优化问题,最优轨迹的选择满足:

选择最优轨迹。MindDrive 将该过程建模为决策 - 生成联合优化问题,最优轨迹的选择满足:

其中 为决策策略(由决策专家实现),

为生成策略(由动作专家实现)。为实现在线强化学习,将轨迹决策过程建模为马尔可夫决策过程(MDP)

:

:

- 状态

:包含智能体决策所需的所有信息;

:包含智能体决策所需的所有信息; - 动作空间

:由决策 - 生成联合策略

定义;

定义; - 状态转移

:由闭环仿真环境隐式定义;

- 奖励

:评估状态

:评估状态 下执行动作的质量;

- 目标:学习决策策略

,该策略在折扣因子

的引导,使收集数据

中预期累积折扣奖励最大化。目标公式如下:

3.3 语言 - 动作映射(模仿学习阶段)

模仿学习阶段的核心目标是建立决策专家与动作专家之间的映射关系,为后续强化学习提供高质量轨迹候选,降低探索空间。

3.3.1 元动作设计

为提升规划灵活性,将控制分解为纵向(速度)和横向(路径)控制,并设计对应的元动作(Meta-Actions):

- 速度元动作(7 种):加速(Speed Up)、减速(Slow Down)、快速减速(Slowdown Rapidly)、保持低速(Maintain Slow Speed)、保持中速(Maintain Moderate Speed)、保持高速(Maintain Fast Speed)、停止(Stop);

- 路径元动作(6 种):左转(Turn Left)、右转(Turn Right)、左变道(Change Lane Left)、右变道(Change Lane Right)、直行(Straight)、车道保持(Lanefollow)。

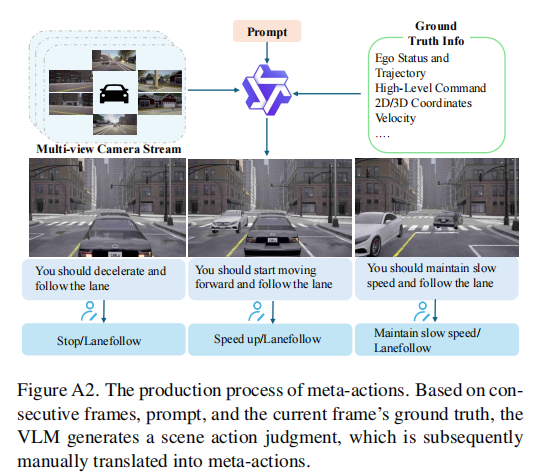

3.3.2 规划 QA 对生成

通过 LLM 生成规划 QA 对,并经人工筛选确保语言与动作的一一对应。具体流程为:

-

基于多视角图像、导航指令和场景信息,利用 Qwen2VL-72B 生成场景决策;

-

将生成的动作语义手动映射为标准化元动作,构建 234,769 条规划 QA 样本(图 A2)。

3.3.3 映射模型训练

- 决策专家:基于视觉 - 语言输入生成抽象元动作(语言决策),训练损失采用交叉熵损失:

- 动作专家:将元动作映射为具体轨迹,利用自回归特性编码视觉 - 语言信息,通过特殊令牌(<speed waypoints>、<path waypoints>)提取输出 logits,并采用变分自编码器(VAE)+GRU 解码器实现语言 - 动作空间对齐:

- 总损失函数:整合行为克隆损失(

)、交叉熵损失(

)、交叉熵损失( )、VAE 损失(

)、VAE 损失( )和检测损失(

)和检测损失( ):

):

3.4 在线强化学习(动作 - 推理优化阶段)

模仿学习虽能生成类人轨迹,但仍存在因果混淆问题。在线强化学习阶段通过 CARLA 模拟器中的闭环交互,利用试错学习优化决策专家的推理能力。

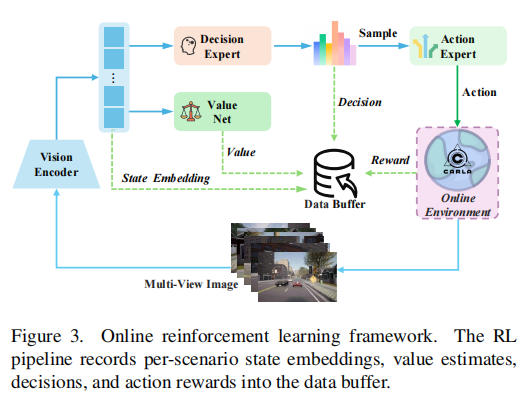

3.4.1 强化学习框架

如图 3 所示,框架包含以下关键组件:

- 并行数据采集:部署 24 个 CARLA 模拟器实例,针对模仿学习阶段未完成的路线进行数据采集,提升数据多样性;

- 状态表示:通过视觉编码器处理每帧图像,生成紧凑的状态嵌入(State Embedding),减少内存开销并支持大批量训练;

- 价值网络:与 LLM 共享权重,仅替换最后一层为多层感知机(MLP),用于预测状态价值;

- 数据缓冲区:存储状态嵌入、价值估计、决策、动作和奖励信息,用于后续 Policy 更新。

注:RL 流程将每个场景的状态嵌入、价值估计、决策和动作奖励记录到数据缓冲区,用于 Policy 优化。

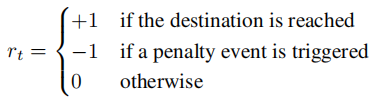

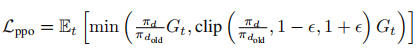

3.4.2 奖励函数设计

采用稀疏奖励函数,聚焦高层推理优化:

- 成功到达目的地:+1;

- 触发惩罚事件(碰撞、闯红灯、偏离路线 > 30 米、未遵守停车标志):-1;

- 其他正常场景:0。

惩罚事件基于 CARLA 官方排行榜指标定义,确保奖励信号与真实驾驶安全要求一致。

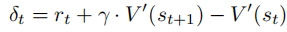

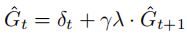

3.4.3 策略优化

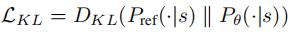

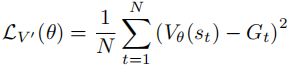

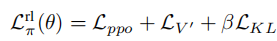

采用近端策略优化(PPO)算法更新决策专家的策略,同时引入正则化缓解灾难性遗忘:

-

时序差分(TD)误差计算:

-

广义优势估计(GAE):

-

PPO 损失:

-

KL 散度正则化(缓解灾难性遗忘):

-

价值网络损失(MSE):

-

总强化学习损失:

其中 β 为 KL 正则化系数,平衡探索与稳定性。

四、实验设置

4.1 数据集与基准测试

- 数据集:采用 Bench2Drive 数据集,基于 CARLA 模拟器构建的闭环自动驾驶基准;

- 模仿学习:使用 1000 个片段(950 个训练,50 个开环验证);

- 闭环评估:220 条短路线,覆盖 44 个交互场景;

- 在线强化学习:选择 44 条模型可通过动作采样完成的路线。

4.2 评估指标

- 核心指标:驾驶分数(DS)、成功率(SR);

- 多能力指标(Multi-Ability):评估 5 项城市驾驶高级技能 ------ 并道(Merging)、超车(Overtaking)、紧急制动(Emergency Brake)、让行(Give Way)、交通标志识别(Traffic Sign)。

4.3 模型配置

- 视觉编码器:EVA-02-L;

- 基础 LLM:Qwen2-0.5B(轻量型);

- LoRA 配置:秩维度 = 16,alpha=16;

- 轨迹参数:速度航点(

=6,3 秒轨迹,2Hz 采样)、路径航点(

=20,20 米路径,1 米间隔);

- 训练资源:32 张 NVIDIA A800 GPU(80GB 显存);

- RL 训练:10 个 epoch,24 个并行 CARLA 模拟器。

五、实验结果与分析

5.1 主要结果对比

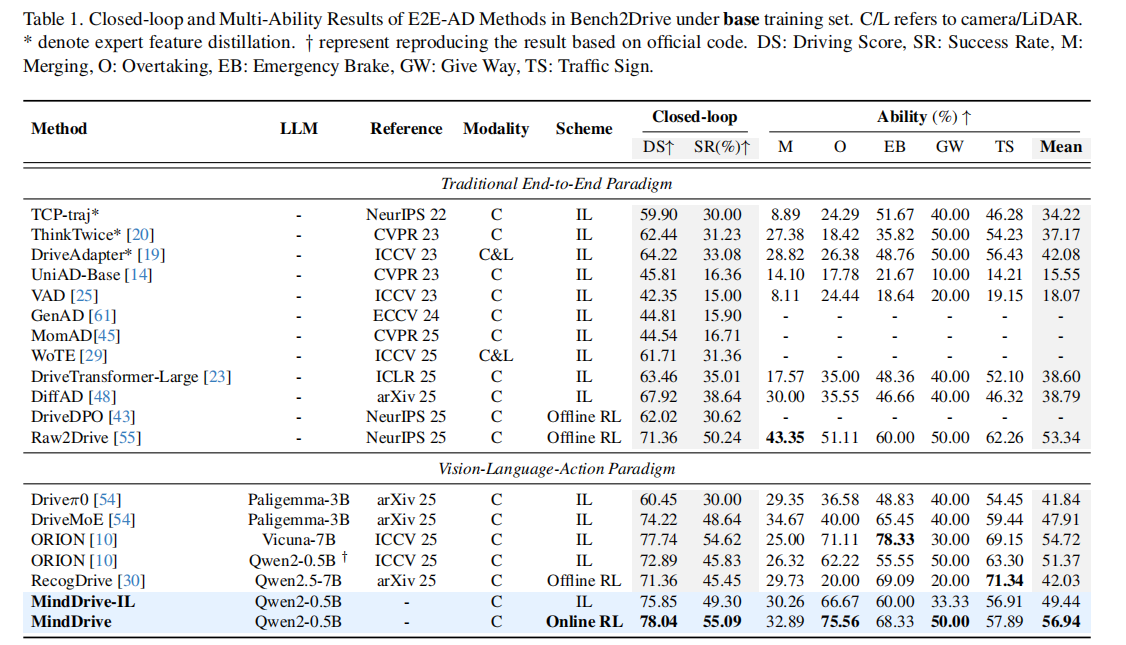

表 1 展示了 MindDrive 与传统端到端模型和 VLA 模型在 Bench2Drive 基准上的对比结果,核心发现如下:

- 轻量模型实现高性能:使用 0.5B 参数的 Qwen2-LLM,MindDrive 的 DS(78.04)和 SR(55.09%)显著优于同规模 IL 基线(ORION Qwen2-0.5B:72.89 DS,45.83% SR),甚至超过采用更大模型(Vicuna-7B、Paligemma-3B)的方法;

- 在线 RL 的显著优势:相较于离线 RL 方法(如 RecogDrive),DS 提升 6.68,SR 提升 9.64%;相较于自身 IL 版本(MindDrive-IL),DS 提升 2.19,SR 提升 5.79%;

- 多能力全面提升:在超车(+55.56%)和让行(+30%)能力上实现大幅提升,紧急制动和交通标志识别能力也优于 IL 版本,验证了在线 RL 对因果推理和决策鲁棒性的增强作用。

5.2 消融实验分析

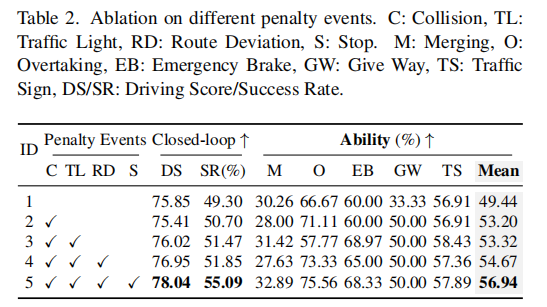

5.2.1 惩罚事件的影响(表 2)

逐步引入 4 类惩罚事件(碰撞、闯红灯、路线偏离、停车标志),模型性能持续提升:

- 仅引入碰撞惩罚:SR 提升 1.4%,均值能力提升 3.76%,超车能力显著增强(+4.44%);

- 加入交通灯惩罚:紧急制动(+8.97%)和交通标志识别(+1.52%)能力提升;

- 完整惩罚设置(ID-5):实现最优性能(78.04 DS,55.09% SR),验证了稀疏奖励函数设计的有效性。

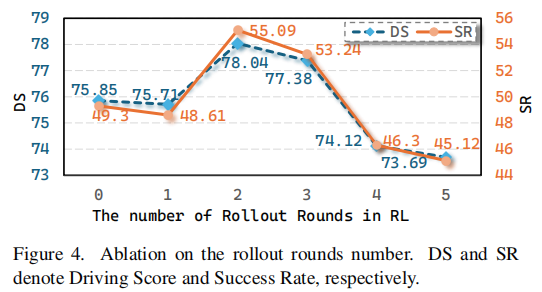

5.2.2 滚动轮次的影响(图 4)

- 1 轮滚动:价值网络估计不准确,导致性能下降;

- 2 轮滚动:达到最优性能(DS+2.19,SR+5.79%);

- 超过 2 轮:过度滚动导致灾难性遗忘,模型忘记之前学习的场景理解能力,性能显著下降(DS 降至 73.69,SR 降至 45.12%)。

注:滚动轮次为 2 时性能最优,过多轮次导致灾难性遗忘。

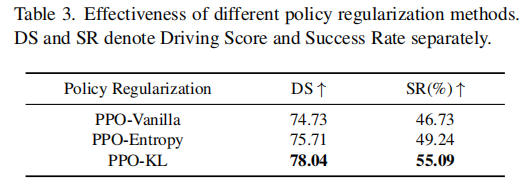

5.2.3 策略正则化的影响(表 3)

- KL 散度正则化(PPO-KL)优于 vanilla PPO(+3.31 DS,+8.36% SR)和熵正则化(PPO-Entropy)(+2.33 DS,+5.85% SR);

- 验证了 KL 正则化在稳定 Policy 更新、缓解灾难性遗忘方面的有效性。

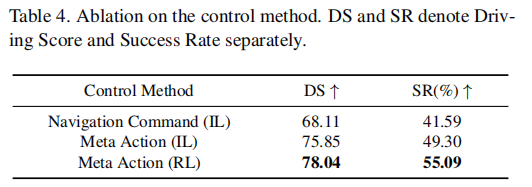

5.2.4 控制方法的影响(表 4)

- VLM 引导的元动作(IL)相较于导航指令(IL),DS 提升 7.74,SR 提升 7.71%,验证了元动作设计更利于复杂场景推理;

- 在线 RL 进一步提升元动作选择能力,实现额外性能增益。

5.3 定性结果分析

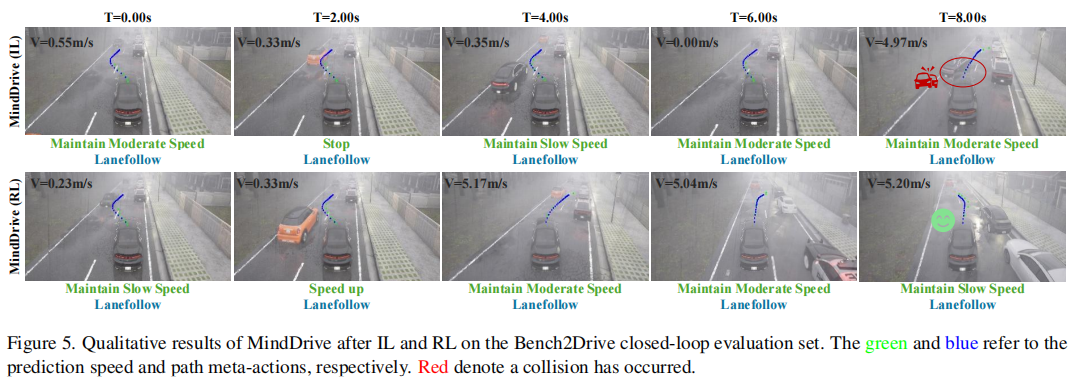

图 5 展示了 MindDrive 在 IL 和 RL 阶段的驾驶行为对比:

- IL 阶段:虽能完成基础任务(如及时刹车),但在动态交互场景(如车道变更时机选择)中决策保守;

- RL 阶段:选择更稳健的元动作,车道变更更果断安全,体现了高层推理能力的提升。

注:绿色表示预测速度,蓝色表示路径元动作,红色表示碰撞。RL 阶段实现更安全果断的驾驶行为。

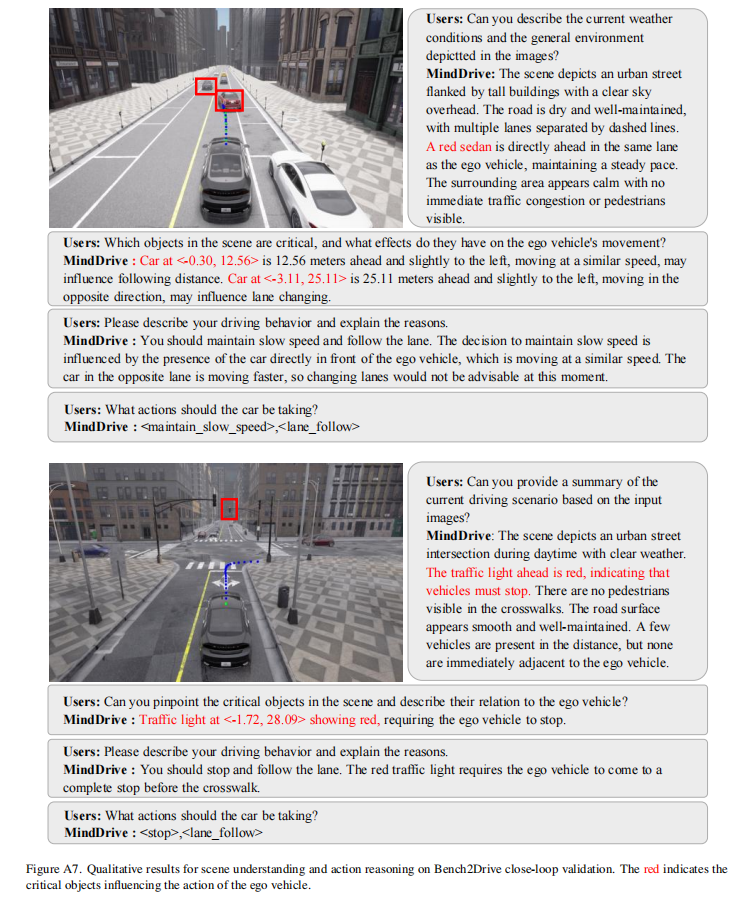

图 A7 展示了模型的场景理解与动作推理能力,模型能准确识别关键目标(前车、交通灯),并基于场景逻辑生成合理的驾驶决策和元动作,验证了语言 - 动作映射的有效性。

5.4 泛化能力分析

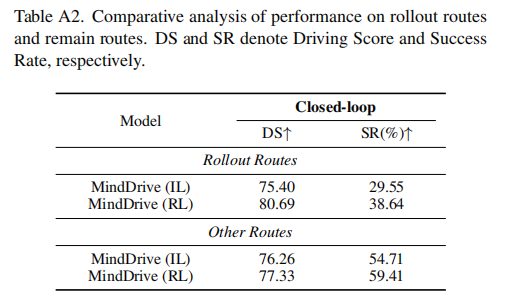

表 A2 对比了模型在强化学习训练路线(Rollout Routes)和未训练路线(Other Routes)上的性能:

- 训练路线:DS 提升 5.29,SR 提升 9.09%,体现试错学习对特定场景决策的优化;

- 未训练路线:DS 提升 1.06,SR 提升 4.7%,验证了模型具有良好的泛化能力,能将学习到的推理能力迁移到新场景。

六、局限性与未来展望

6.1 局限性

- 评估局限于 CARLA 模拟器,缺乏真实世界交互场景的验证;

- 多 CARLA 模拟器同步困难,无法在相同初始状态下评估不同动作,限制了 GRPO 算法的应用;

- 在紧急制动和交通标志识别能力上仍落后于部分先进 VLA 模型,需进一步优化奖励设计和元动作映射。

6.2 未来方向

- 扩展至真实世界数据集和模拟器,提升模型的实际应用价值;

- 优化多模拟器同步机制,引入更先进的强化学习算法(如 GRPO);

- 增强元动作的细粒度,设计更精准的奖励函数,进一步提升复杂场景的决策能力;

- 探索更大规模 LLM 与在线强化学习的结合,平衡模型能力与训练效率。

七、总结

MindDrive 通过创新的双专家架构和语言 - 动作映射机制,首次实现了自动驾驶 VLA 模型的在线强化学习训练。其核心突破在于将连续动作空间转化为离散语言决策空间,解决了强化学习探索效率低的关键问题,同时利用轨迹级奖励优化高层推理能力。实验表明,即使采用轻量型 LLM,MindDrive 仍能在闭环驾驶中实现优异性能,显著提升了决策鲁棒性和泛化能力。该工作为自动驾驶 VLA 模型的训练提供了新范式,为解决模仿学习的固有缺陷提供了有效途径,对推动端到端自动驾驶的实用化具有重要意义。