在自动驾驶技术的飞速发展进程中,高质量、可控且带标注的训练数据起着至关重要的作用。然而,现实世界中数据收集和标注不仅耗费大量资源,还难以覆盖各种复杂场景。现有的驾驶场景生成方法大多存在局限性,要么只能生成单一数据形式,无法满足多样化下游任务的需求;要么直接从粗糙的场景布局生成数据,难以精准捕捉真实驾驶场景的复杂分布。

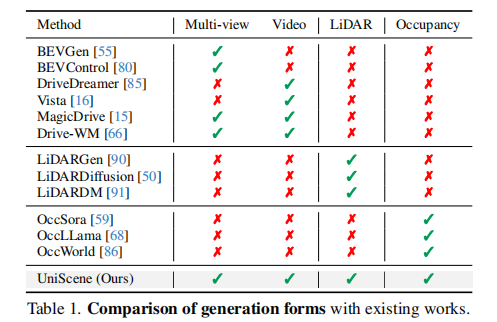

为此,来自上海交通大学、清华大学、旷视科技等多家单位的研究团队提出了 UniScene,这是首个能够统一生成语义占用率、多视角视频和激光雷达点云三种关键数据形式的框架。

原文链接:https://arxiv.org/pdf/2412.05435

项目主页:UniScene: Unified Occupancy-centric Driving Scene Generation

代码链接:github.com

沐小含持续分享前沿算法论文,欢迎关注...

一、研究背景与动机

1.1 自动驾驶数据生成的挑战

自动驾驶系统的训练依赖海量高质量数据,涵盖不同天气、路况、光照等多种场景。但真实数据存在以下问题:

- 数据收集成本高:需要部署大量传感器车辆在不同区域长时间采集;

- 标注难度大:3D 目标检测、语义分割等任务的标注工作繁琐且易出错;

- 场景覆盖不全:极端天气、罕见事故等边缘场景难以收集。

生成式模型(尤其是扩散模型)的发展为合成数据提供了可能,但现有方法存在明显缺陷:

- 单一数据形式生成:多数方法仅能生成 RGB 视频或激光雷达点云等单一数据,无法满足多传感器融合训练需求;

- 直接布局到数据的建模局限:从粗糙的 BEV 布局或 3D 边界框直接生成数据,难以捕捉场景的精细语义和几何信息,导致生成质量不佳。

1.2 语义占用率的优势

语义占用率(Semantic Occupancy)作为自动驾驶感知任务中的重要 3D 场景表示形式,兼具丰富的语义信息(如车辆、行人、道路等类别)和几何信息(3D 空间位置),相比传统的 2D BEV 地图具有显著优势:

- 更全面的场景描述:能够完整表征 3D 空间中物体的分布和形态;

- 多模态数据生成桥梁:可作为中间表示,为视频和激光雷达点云的生成提供统一的语义和几何指导。

基于此,研究团队提出以语义占用率为核心的分层生成范式,将复杂的驾驶场景生成任务分解为两个可管理的步骤,从而降低生成难度并提升数据质量。

二、UniScene 框架整体设计

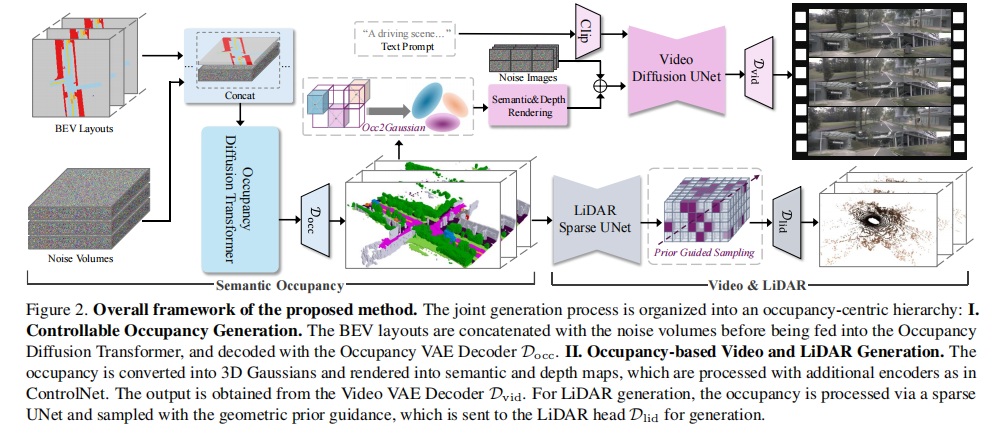

UniScene 的核心思想是通过分层生成策略,先从 BEV 布局生成语义占用率作为中间表示,再基于该中间表示分别生成视频和激光雷达数据。框架整体分为三个关键模块:可控语义占用率生成、基于占用率的视频生成和基于占用率的激光雷达生成。

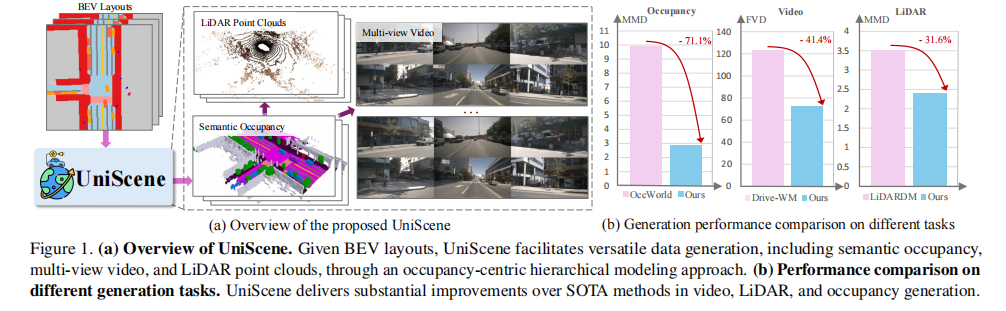

图 1(a)展示了 UniScene 的整体流程:给定 BEV 布局,通过占用率中心的分层建模方法,实现语义占用率、多视角视频和激光雷达点云的多任务生成;图 1(b)显示,在视频、激光雷达和占用率生成任务中,UniScene 相比现有 SOTA 方法均实现了显著性能提升。

2.1 框架整体流程

- 输入:多帧 BEV 布局序列(可由用户编辑以实现可控生成);

- 第一步生成:通过占用率扩散 Transformer(Occupancy Diffusion Transformer)生成具有时空一致性的 3D 语义占用率序列;

- 第二步生成:

- 视频生成:将语义占用率转换为 3D 高斯基元,通过高斯联合渲染得到多视角语义图和深度图,指导视频扩散 UNet 生成多视角视频;

- 激光雷达生成:利用基于占用率先验的稀疏建模方法,通过稀疏 UNet 和射线采样策略生成激光雷达点云。

图 2 详细展示了框架的技术细节,包括各模块的输入输出、核心组件及数据流向。

三、核心技术模块详解

3.1 可控语义占用率生成

生成可控且时空一致的语义占用率是 UniScene 的基础,后续视频和激光雷达生成均依赖该中间表示。该模块包含两个关键组件:时空感知占用率 VAE 和潜在占用率 Diffusion Transformer(DiT)。

3.1.1 时空感知占用率 VAE

为了高效处理 3D 语义占用率数据,研究团队设计了时空感知的 VAE,将 3D 占用率序列压缩到连续的潜在空间,同时保留精细的空间和时间信息。

-

编码器:将 3D 语义占用率

转换为 BEV 表示

转换为 BEV 表示  (其中

(其中 为可学习的类别嵌入维度),通过 2D 卷积层和 2D 轴向注意力层提取下采样的连续潜在特征;

-

解码器:利用 3D 卷积层和 3D 轴向注意力层,将时序潜在特征

重建为占用率序列

重建为占用率序列  ,重点捕捉时序特征;

,重点捕捉时序特征; -

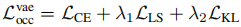

损失函数:结合交叉熵损失(

)、Lovász-softmax 损失(

)和 KL 散度损失(

),公式如下:

其中 λ1 和 λ2 为损失权重。

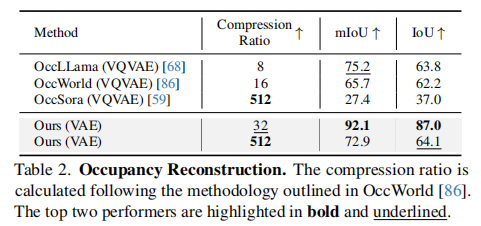

与现有基于 VQVAE 的离散压缩方法不同,该 VAE 采用连续压缩方式,在高压缩比下仍能保持优异的重建性能,为后续生成任务提供高质量的中间表示。

3.1.2 潜在占用率 DiT

潜在占用率 DiT 以 BEV 布局序列为条件,从噪声体积中生成占用率潜在序列,实现可控生成。

-

输入处理:将 BEV 布局与噪声体积拼接后进行分块(patchify),使模型能高效学习空间关系;

-

网络结构:通过堆叠空间和时间 Transformer 块,聚合时空信息,实现对生成序列的精准控制;

-

损失函数:采用 MSE 损失,公式如下:

其中 为模型输出,

为模型输出, 为第

为第 帧的带噪声潜在特征,

为标准正态分布采样的噪声。

为标准正态分布采样的噪声。

通过引入时序信息和 BEV 布局条件,该模块能够生成长时间序列且时空一致的语义占用率,支持用户通过编辑 BEV 布局实现可控生成。

3.2 基于占用率的视频生成

视频生成模块以预训练的 Stable Video Diffusion(SVD)为基础,引入基于占用率的条件指导,解决多视角一致性和生成质量问题。核心创新包括高斯联合渲染和几何感知噪声先验。

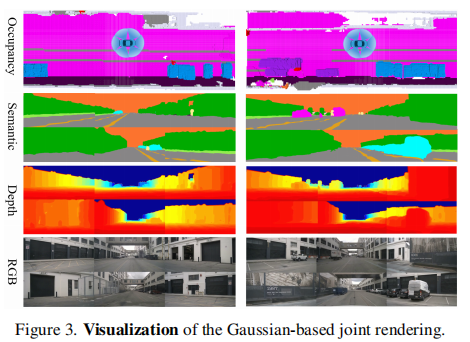

3.2.1 高斯基于联合渲染(Gaussian-based Joint Rendering)

为了弥合 3D 占用率与 2D 视频之间的表示鸿沟,研究团队将语义占用率转换为 3D 高斯基元,并渲染得到多视角语义图和深度图,为视频生成提供精细的语义和几何指导。

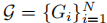

-

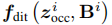

高斯基元转换:将 3D 语义占用率网格转换为 3D 高斯基元集合

,每个高斯基元包含位置

,每个高斯基元包含位置 、语义标签

、透明度

和协方差

;

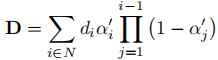

-

多视角渲染:采用基于瓦片的光栅化方法,渲染得到深度图 D 和语义图 S,公式如下:

其中为深度值,α′ 由投影的 2D 高斯和 3D 透明度计算得到;

-

条件融合:借鉴 ControlNet 的设计,将渲染得到的语义图和深度图输入编码器分支(含残差连接和零卷积),与视频扩散 UNet 结合,在保留预训练模型生成能力的同时,引入占用率条件约束。

图 3 展示了高斯联合渲染得到的语义图和深度图,能够清晰呈现场景的语义类别和几何结构,为视频生成提供精准指导。

3.2.2 几何感知噪声先验(Geometric-aware Noise Prior)

为提升视频的帧间一致性和几何准确性,研究团队在采样过程中引入几何感知噪声先验,结合渲染的深度图实现跨帧几何对齐。

-

噪声先验注入:在视频扩散模型的采样过程中,注入密集的外观先验,并通过深度图引入几何感知,建模区域相关性;

-

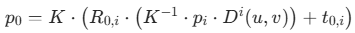

深度基于重投影:利用深度图将参考图像的外观先验重投影到其他帧,解决动态区域的帧间对应问题,公式如下:

其中为相机内参,[

∣

] 为目标帧到参考帧的变换矩阵,

为第

帧的渲染深度图。

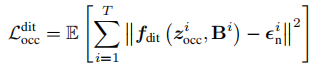

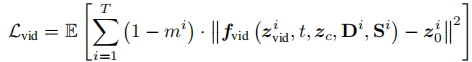

3.2.3 视频训练损失

视频生成模块的损失函数定义如下:

其中 为视频生成模型输出,

和

分别为第

帧的渲染深度图和语义图,

为文本提示,

和

分别为真实潜在特征和带噪声潜在特征,

为用于选择条件帧的 one-hot 掩码。

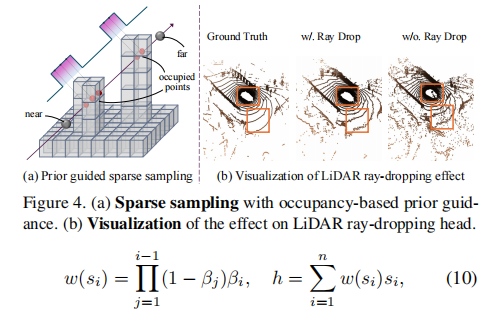

3.3 基于占用率的激光雷达生成

激光雷达生成模块针对激光雷达点云的稀疏性和几何精细性特点,提出基于占用率先验的稀疏建模方法,实现高效且高质量的激光雷达点云生成。

3.3.1 先验基于稀疏建模(Prior-guided Sparse Modeling)

- 稀疏特征提取:利用稀疏 UNet 处理输入的语义占用率网格,聚合上下文特征,避免对未占用体素的无效计算,提升效率;

- 基于占用率的采样:沿激光雷达射线进行均匀采样,基于占用率定义概率分布函数(PDF),对占用体素内的点分配概率 1,其他点分配概率 0,根据 PDF 重采样得到

个点

(

(为射线原点,

为归一化射线方向)。

图 4(a)展示了基于占用率先验的稀疏采样过程,图 4(b)显示射线丢弃头(ray-dropping head)能有效去除噪声点,提升生成质量。

3.3.2 激光雷达头与训练损失

-

激光雷达头:包含三个关键组件:

- 深度估计:通过多层感知器(MLP)预测采样点的符号距离函数(SDF),计算权重并通过体渲染估计射线深度;

- 反射强度预测:根据射线上点特征的加权和,预测激光雷达光束的反射强度;

- 射线丢弃预测:模拟激光雷达因未检测到反射光而丢弃射线的现象,去除噪声点;

-

损失函数:结合深度损失(

)、强度损失(

)和射线丢弃损失(

),公式如下:

其中和

为平衡系数。

四、实验设置与结果分析

4.1 实验数据集与评估指标

- 数据集:采用 NuScenes 基准数据集,结合 NuScenes-Occupancy 数据集的语义占用率标注,将 2Hz 的关键帧插值到 12Hz,用于模型训练和评估;

- 评估指标:

- 占用率生成:mIoU(平均交并比)、F3D(3D Fréchet 距离)、MMD(最大均值差异);

- 视频生成:FID(Fréchet inception 距离)、FVD(Fréchet 视频距离);

- 激光雷达生成:MMD、JSD(Jensen-Shannon 散度)、推理时间;

- 下游任务:语义占用率预测(mIoU、IoU)、BEV 分割(mIoU)、3D 目标检测(mAP、NDS)。

4.2 主要实验结果

4.2.1 占用率重建、生成与预测

- 占用率重建:表 2 对比了 UniScene 的 VAE 与现有 VQVAE 方法的重建性能。在 512 的高压缩比下,UniScene 的 mIoU 达到 72.9%,超过 OccWorld 10.96%,验证了连续压缩方式的优越性。

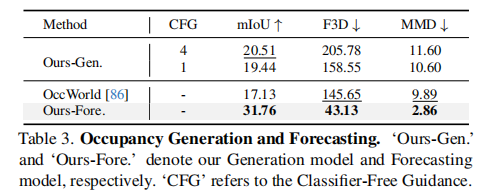

- 占用率生成与预测:表 3 显示,UniScene 的生成模型(Ours-Gen.)在 mIoU 上达到 20.51%,预测模型(Ours-Fore.)仅使用 2 帧参考帧,在 F3D 和 MMD 上分别超过 OccWorld 70.39% 和 71.08%,验证了时序建模和占用率中间表示的有效性。

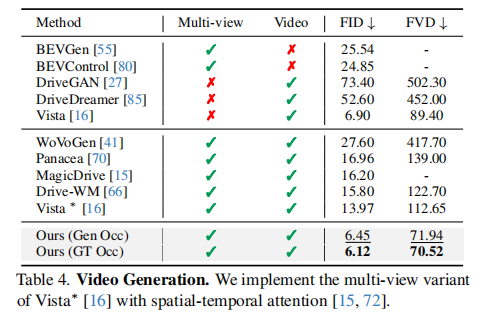

4.2.2 视频生成

表 4 对比了 UniScene 与现有 SOTA 方法的视频生成性能。UniScene(Gen Occ)的 FID 达到 6.45,FVD 达到 71.94,显著优于所有对比方法,且支持多视角视频生成(现有方法如 Vista 仅支持单视角)。

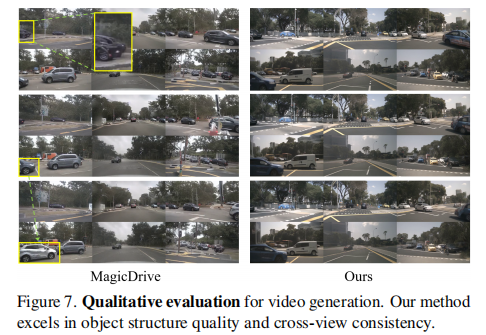

图 7 显示,与 MagicDrive 相比,UniScene 生成的视频在物体结构质量和跨视角一致性上均有明显提升。

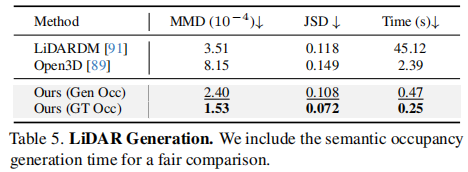

4.2.3 激光雷达生成

表 5 对比了 UniScene 与 Open3D、LiDARDM 的激光雷达生成性能。UniScene(Gen Occ)的 MMD(2.40×10⁻⁴)比 LiDARDM 低 31.62%,推理时间仅为 0.47 秒,远快于其他方法,验证了稀疏建模的高效性。

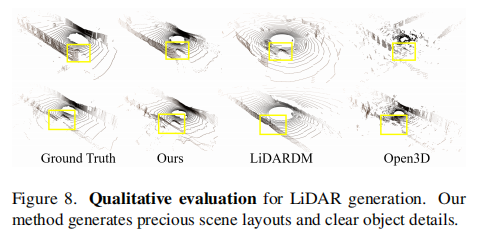

图 8 显示,UniScene 生成的激光雷达点云在场景布局准确性和物体细节清晰度上显著优于对比方法。

4.2.4 下游任务性能提升

UniScene 生成的数据可有效提升下游自动驾驶感知任务的性能:

-

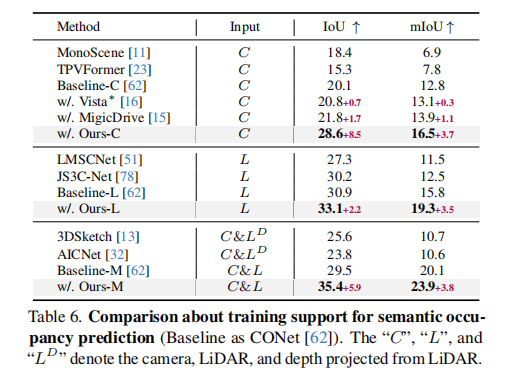

语义占用率预测:表 6 显示,在相机、激光雷达及多模态输入下,使用 UniScene 生成的数据进行增强后,模型的 IoU 和 mIoU 均显著提升,其中相机输入下 IoU 提升 8.5%;

-

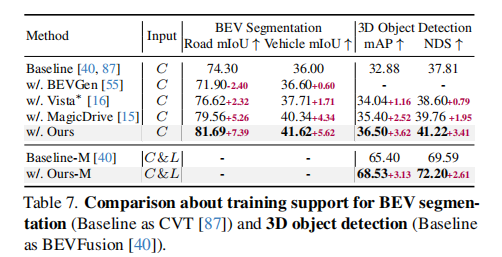

BEV 分割与 3D 目标检测:表 7 显示,使用 UniScene 生成的数据增强后,BEV 分割的道路 mIoU 提升 7.39%,车辆 mIoU 提升 5.62%;3D 目标检测的 mAP 提升 3.62%,NDS 提升 3.41%。

4.3 消融实验

4.3.1 占用率生成模块消融

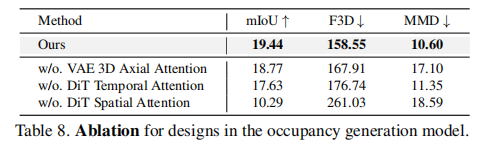

表 8 验证了占用率生成模块各组件的有效性:

-

VAE 的 3D 轴向注意力:减少 MMD 38.01%,提升时序一致性;

-

DiT 的时间注意力:提升 F3D 10.29%;

-

DiT 的空间注意力:减少 F3D 39.26%,显著提升生成保真度。

4.3.2 视频生成模块消融

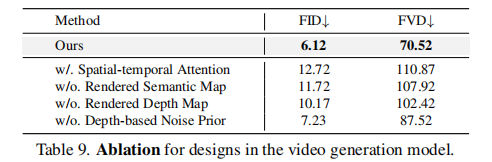

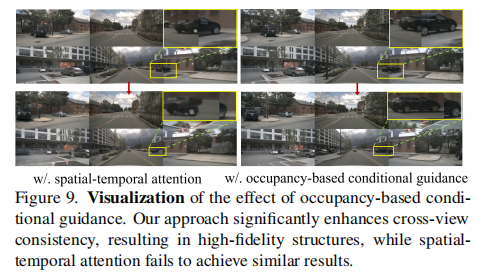

表 9 和图 9 验证了视频生成模块各组件的有效性:

- 占用率基于语义和深度图:相比时空注意力,FVD 降低 34.95%,显著提升跨视角一致性;

- 几何感知噪声先验:将 FVD 从 87.52 降至 70.52,提升帧间一致性。

图 9 显示,占用率基于条件指导相比时空注意力,能显著提升跨视角一致性和结构保真度。

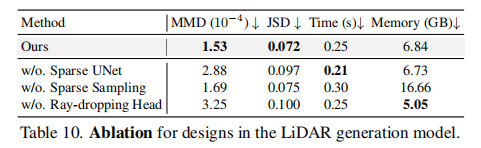

4.3.3 激光雷达生成模块消融

表 10 验证了激光雷达生成模块各组件的有效性:

- 稀疏 UNet:减少 JSD 25.77%,提升生成性能;

- 稀疏采样:减少计算量 58.94%,同时提升性能;

- 射线丢弃头:减少 MMD 25.92%,减少 JSD 25.00%,有效去除噪声。

4.4 泛化性与可控性实验

4.4.1 多场景泛化

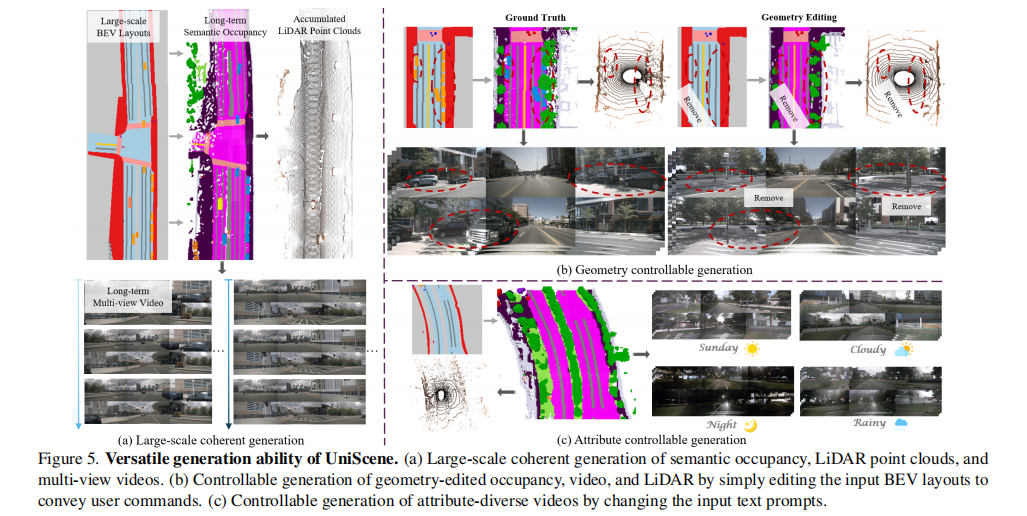

UniScene 能够处理大规模连贯场景生成、几何编辑可控生成和属性定制生成:

- 大规模连贯生成:生成长时间序列的语义占用率、激光雷达点云和多视角视频,保持时空一致性(图 5(a));

- 几何编辑可控:通过编辑 BEV 布局(如移除车辆),生成对应的修改后数据(图 5(b));

- 属性定制:通过文本提示控制视频的天气(晴天、雨天)和时间(白天、夜晚)(图 5(c))。

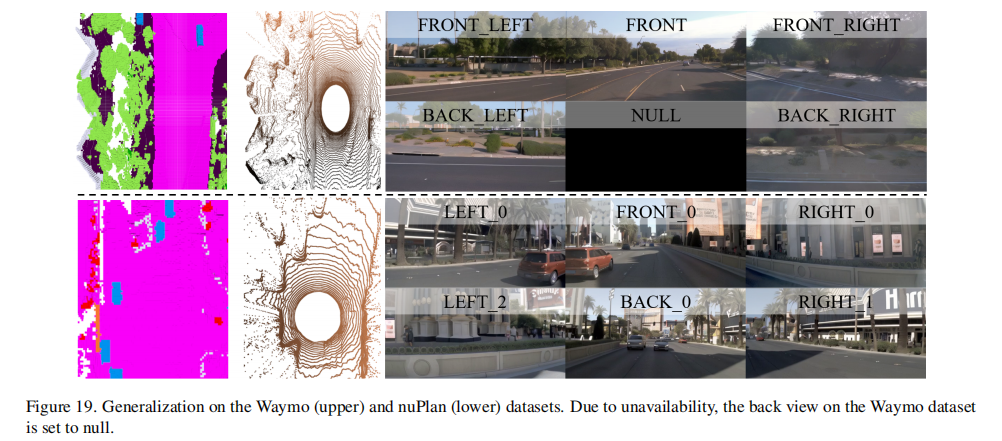

4.4.2 跨数据集泛化

UniScene 能够直接迁移到 Waymo 和 nuPlan 数据集,在给定场景布局和条件参考图像的情况下,生成高质量数据(图 19)。

五、相关工作对比

5.1 语义占用率表示与生成

现有工作如 MonoScene、TPVFormer 聚焦于语义占用率预测,OccWorld、OccLlama 关注占用率预测,但缺乏可控的时序占用率生成能力。OccSora 虽能生成时序占用率,但基于 VQVAE 的离散压缩导致重建质量不佳。UniScene 提出可控的时序语义占用率生成,采用 VAE 连续压缩,在重建和生成质量上显著超越现有方法。

5.2 自动驾驶生成模型

- 视频生成:BEVGen、MagicDrive 等仅支持单模态或单视角生成,Vista 缺乏多视角一致性。UniScene 基于占用率的多视角条件指导,实现高质量多视角视频生成;

- 激光雷达生成:LiDARGen、LiDARDM 等直接从布局生成点云,忽略中间语义和几何信息。UniScene 利用占用率先验,提升生成点云的几何准确性和效率;

- 多模态生成:现有方法多为单一模态生成,UniScene 首次实现语义占用率、视频和激光雷达的统一生成,满足多传感器融合训练需求。

六、局限性与未来工作

6.1 局限性

- 系统复杂性:整合多生成任务导致模型结构复杂,资源消耗较大;

- 轻量化部署:当前模型难以满足自动驾驶边缘设备的轻量化需求;

- 场景覆盖:极端边缘场景(如极端天气、复杂交通流)的生成能力仍需提升。

6.2 未来工作

- 轻量化优化:探索模型压缩和高效推理方法,适应边缘部署;

- 跨领域扩展:将框架扩展到具身智能、机器人等相关领域;

- 场景增强:提升极端场景的生成能力,进一步丰富训练数据多样性;

- 交互性提升:增强用户与生成过程的交互,支持更精细的场景定制。

七、总结

UniScene 作为首个统一生成语义占用率、多视角视频和激光雷达点云的框架,通过占用率中心的分层生成范式,有效降低了复杂驾驶场景的生成难度。其核心创新包括:

- 提出可控语义占用率生成模块,采用 VAE 连续压缩和 Diffusion Transformer,生成高质量时序语义占用率;

- 引入高斯联合渲染和几何感知噪声先验,实现高保真多视角视频生成;

- 设计基于占用率先验的稀疏建模方法,高效生成高质量激光雷达点云;

- 生成的数据能有效提升下游自动驾驶感知任务性能。

大量实验验证了 UniScene 在生成质量、效率和泛化性上的优越性,为自动驾驶训练数据生成提供了新的解决方案,推动了生成式模型在自动驾驶领域的应用。未来,随着轻量化和跨领域扩展的推进,UniScene 有望在实际自动驾驶系统中发挥更大作用。